AI:你總要高清視頻,它來了

Magnific 圖像超分 & 增強工具還正在火熱體驗中,它強大的圖像升頻與再創能力收獲一致好評。現在,視頻領域也有了自己的 Magnific。

拍攝的街道視頻一片模糊,仿佛高度近視沒戴眼鏡一樣:

與之相比,下面的視頻清晰度高了很多:

視頻畫面兩邊形成鮮明的對比:左邊視頻已經模糊的看不清人臉,而右邊視頻建筑物的紋理也看得清清楚楚:

行駛的汽車仿佛從一個模糊的世界穿越到高清世界:

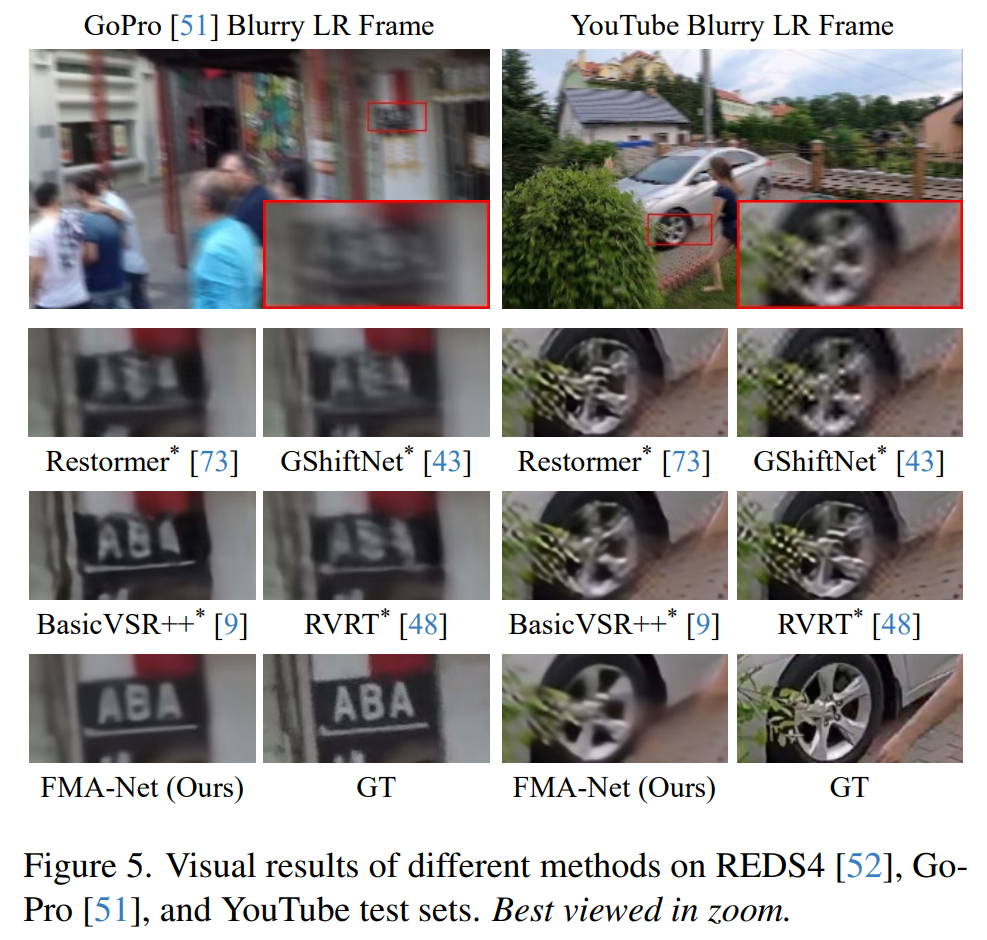

不同的方法進行比較,明顯看到右下角的視頻在微小的細節恢復方面更加清晰:

通過上述展示,我們可以看出,視頻超分辨率(VSR)就像是給模糊的老電影穿上了高清新衣。比如上面展示的一段道路監控錄像,由于畫質太低,細節看起來像是被涂抹過一樣。這時候就需要 VSR 技術出場了,它能夠把這些低分辨率的視頻變得更加清晰。

不過,這個過程并不簡單。常常因為攝像機晃動或拍攝物體的移動,視頻就像是被風吹過的湖面,波紋模糊。這時,我們不僅需要提升視頻的清晰度,還得「擺平」這些模糊的干擾。這就需要視頻超分辨率和去模糊的聯合修復(VSRDB),它要在保持視頻清晰度的同時,還得處理模糊,確保最后呈現出來的視頻既清晰又流暢。

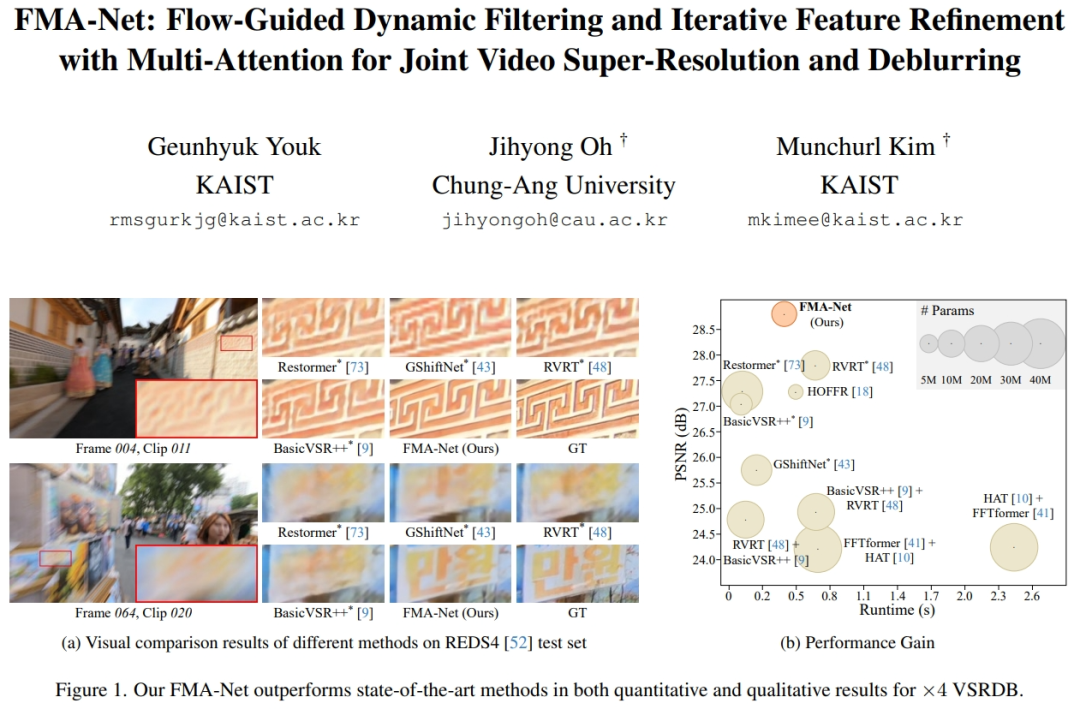

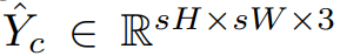

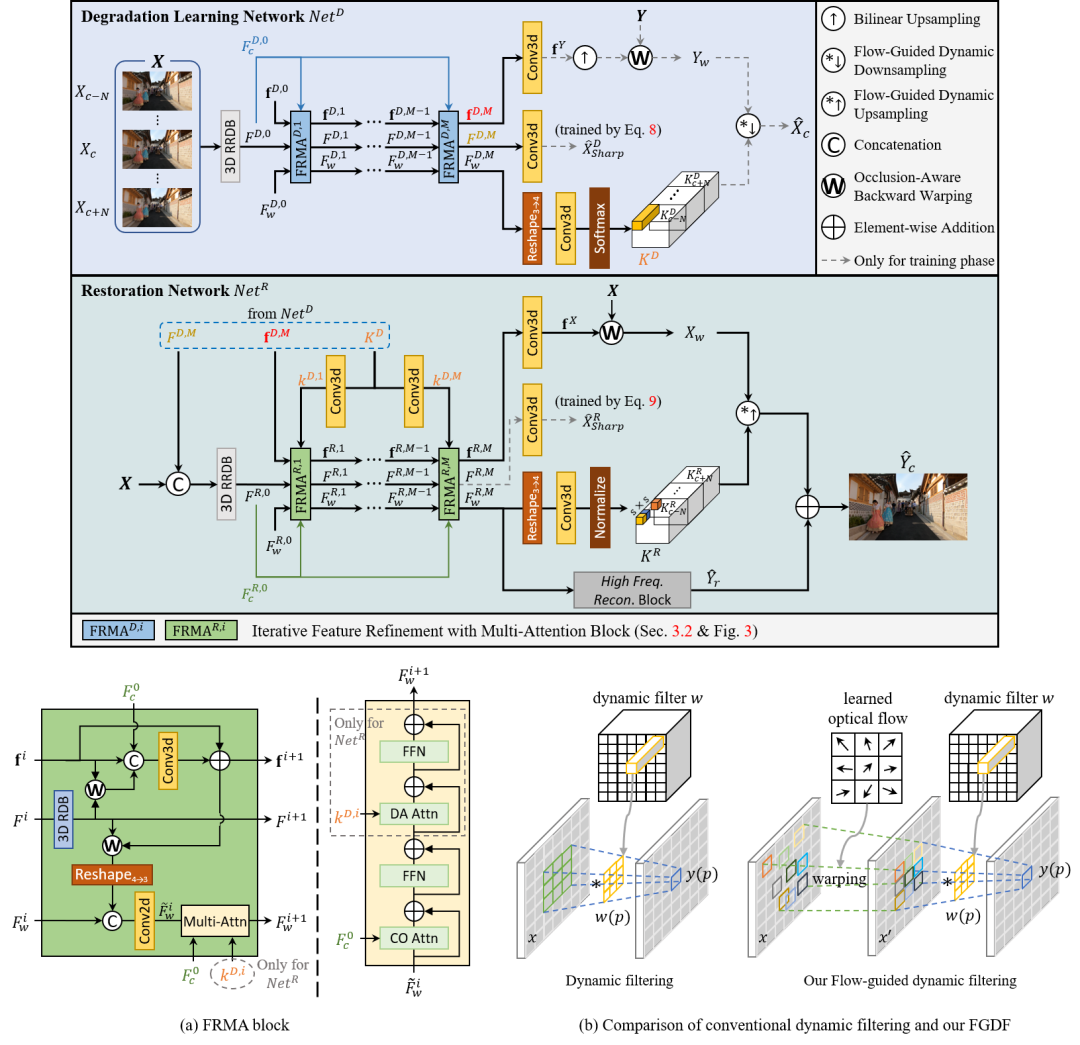

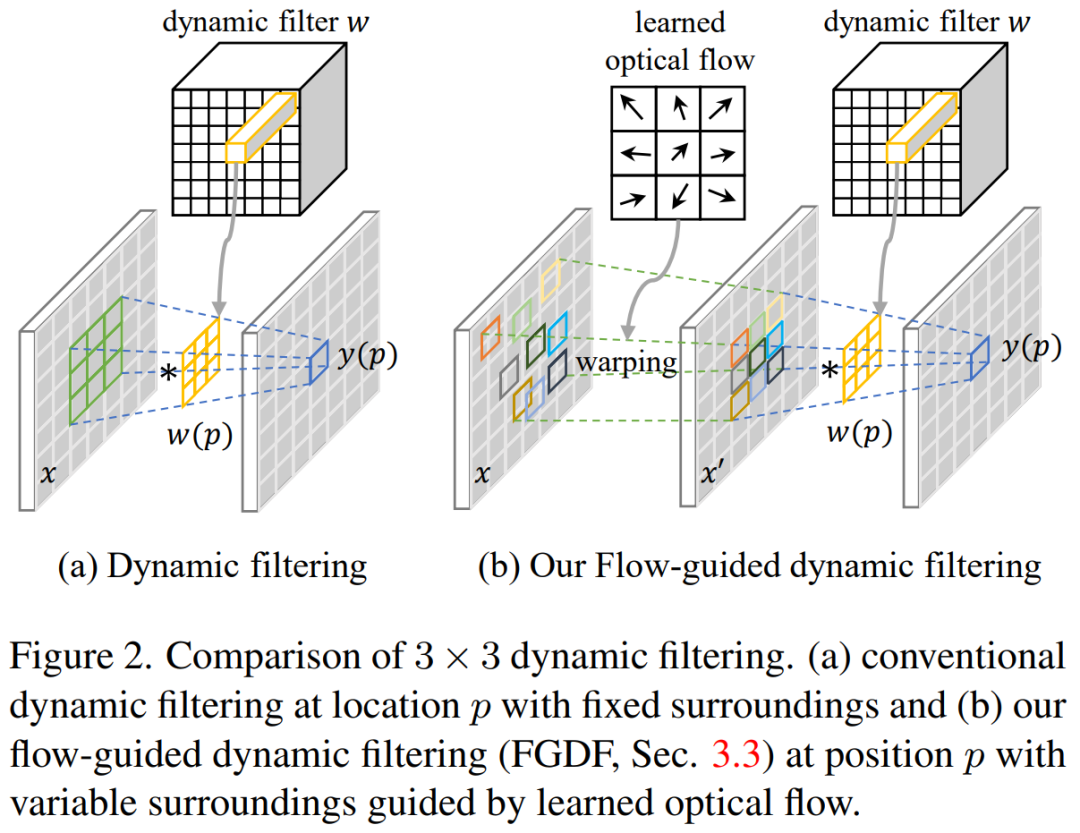

為了實現上述效果,來自韓國科學技術院(KAIST)與中央大學的研究者們提出了 FMA-Net 框架。這個框架基于流引導的動態濾波(Flow-Guided Dynamic Filtering, FGDF)和迭代特征細化的多重注意力機制(Iterative Feature Refinement with Multi-Attention, FRMA),旨在實現從小到大的運動表示學習,并具有良好的聯合恢復性能(見圖 1)。FGDF 的關鍵之處在于執行濾波時要注意運動軌跡,而不是拘泥于固定位置,這樣就能用較小的核有效處理較大的運動。

- 論文地址:https://arxiv.org/abs/2401.03707

- 項目主頁:http://kaist-viclab.github.io/fmanet-site/

- 論文標題:FMA-Net: Flow-Guided Dynamic Filtering and Iterative Feature Refinement with Multi-Attention for Joint Video Super-Resolution and Deblurring

方法介紹

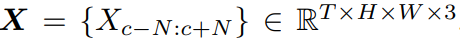

該研究的目標是同時實現視頻超分辨率和去模糊(VSRDB)。對于一個模糊的 LR(低分辨率, low-resolution )輸入序列 ,式中 T = 2N + 1、c 分別表示輸入幀數和中心幀索引。VSRDB 的目標是預測一個清晰的 HR( 高分辨率,high-resolution )中心框架

,式中 T = 2N + 1、c 分別表示輸入幀數和中心幀索引。VSRDB 的目標是預測一個清晰的 HR( 高分辨率,high-resolution )中心框架 。如下圖展示了 VSRDB 框架 FMA-Net。

。如下圖展示了 VSRDB 框架 FMA-Net。

FMA-Net 包括兩部分:退化學習網絡 Net^D ;修復網絡 Net^R 。退化學習網絡用于估計感知運動的時空變化退化核;修復網絡利用這些預測出的退化核來恢復模糊的低分辨率視頻。

其中,退化學習網絡 Net^D 用來預測運動感知的時空變化退化,而 Net^R 以全局自適應的方式利用 Net^D 預測的退化來恢復中心幀 X_c。

Net^D 和 Net^R 具有相似的結構,它們由 FRMA( feature refinement with multiattention )塊和 FGDF( flow-guided dynamic filtering )塊組成。

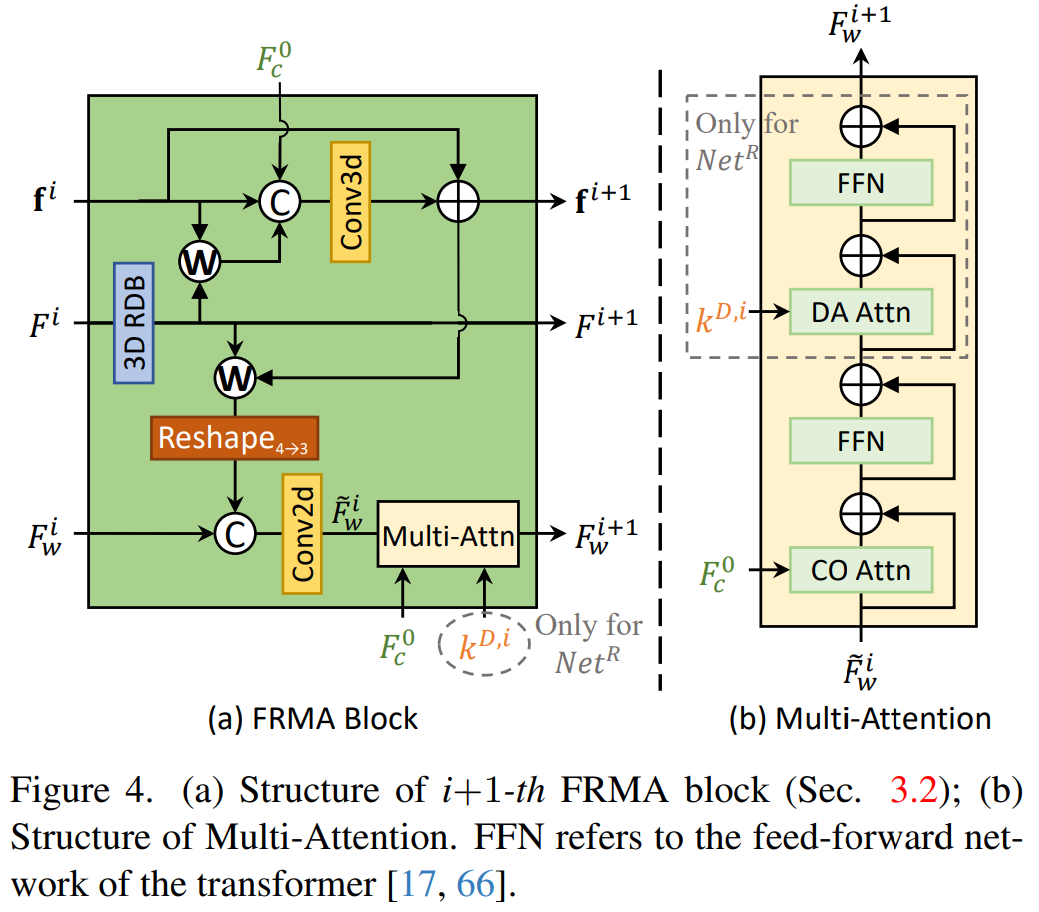

下圖 4 (a) 顯示了第 (i+1) 步更新時 FRMA 塊的結構,圖 4 (b) 為多注意力結構。

下圖 2 展示了 FGDF 概念。FGDF 看起來類似于可變形卷積(DCN),但不同之處在于 FGDF 學習的是位置相關的 n×n 動態濾波器系數,而 DCN 學習的是位置不變的 n×n 濾波器系數。

此外,新提出的多注意力機制,包括以中心為導向的注意力和退化感知注意力,使得 FMA-Net 能夠專注于目標幀,并以全局適應的方式使用退化核進行視頻超分辨率和去模糊。

訓練策略

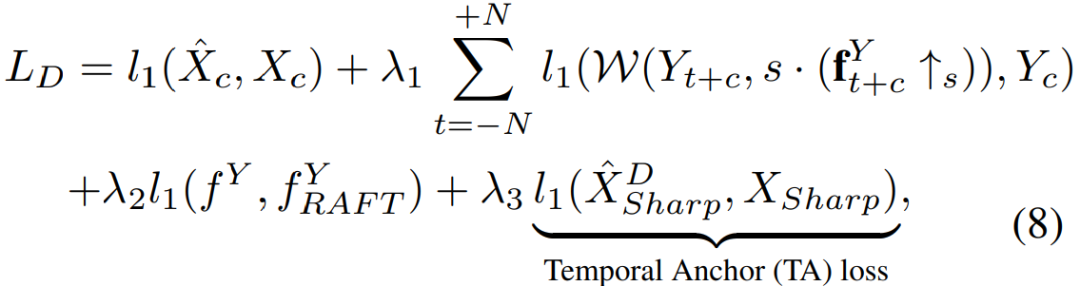

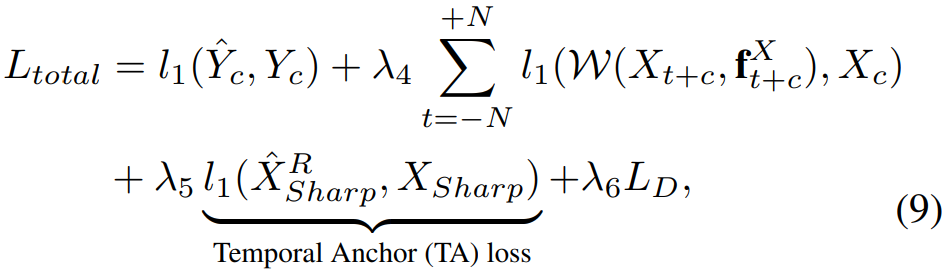

該研究采用兩階段的訓練策略來訓練 FMA-Net。首先對 Net^D 進行預訓練,損失 L_D 為:

然后,為了提高性能,本文還提出了 TA 損失,即等式右側的最后一項。

總的訓練損失為:

實驗結果

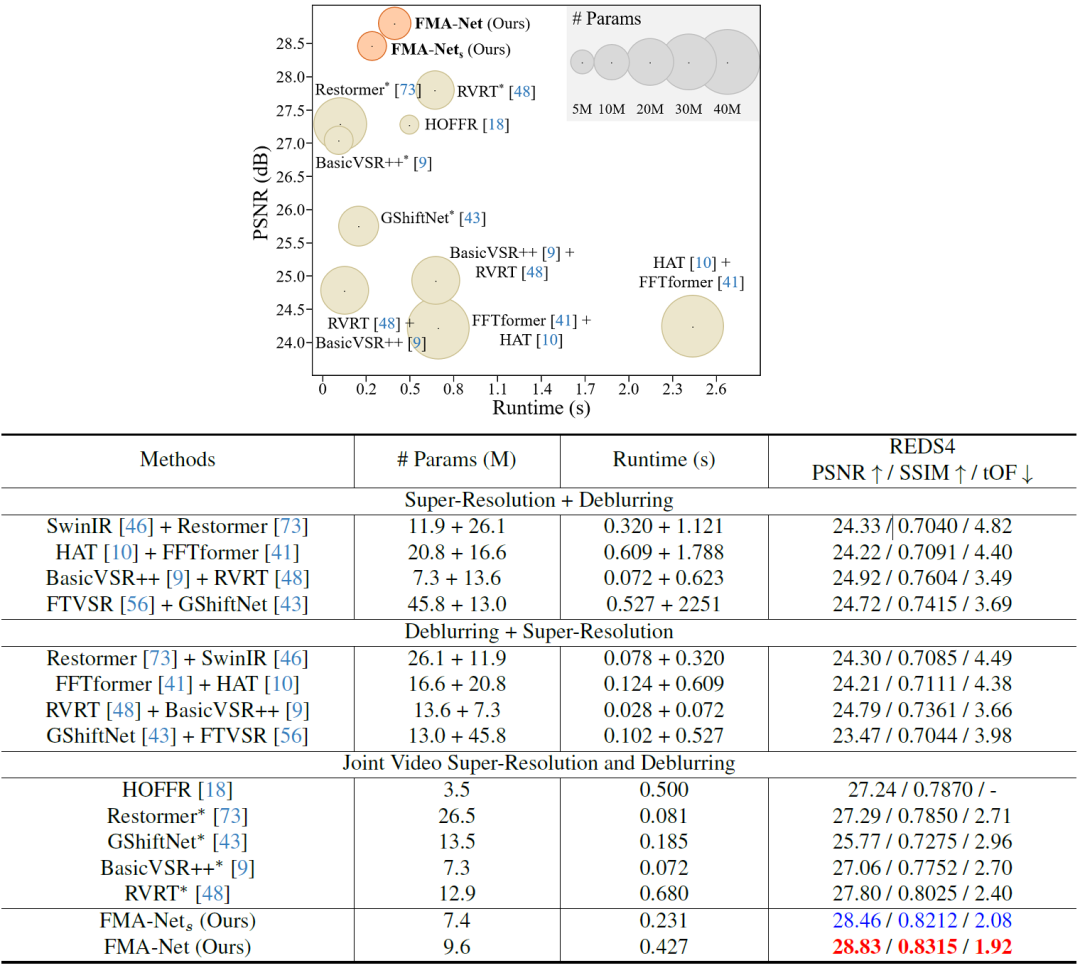

表 1 顯示了在測試集 REDS4 上的定量比較結果。從表 1 可以看出:

- 級聯 SR 和去模糊的序列方法會導致先前模型的錯誤傳播,導致性能顯著下降,并且使用兩個模型還會增加內存和運行時成本;

- 與序列級聯方法相比,VSRDB 方法始終表現出優越的整體性能,表明這兩個任務高度相關;

- FMA-Net 在 PSNR、SSIM 和 tOF 方面顯著優于所有 SOTA 方法,具體來說,FMA-Net 比 SOTA 算法 RVRT * 和 BasicVSR++* 分別提高了 1.03 dB 和 1.77 dB。

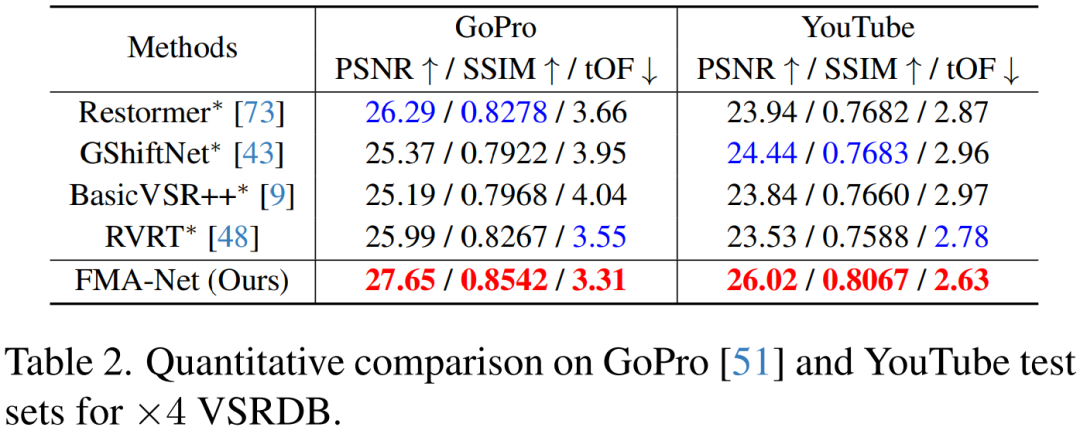

表 2 為定量比較結果。當對兩個測試集進行平均時,FMA-Net 的性能分別比 RVRT * 和 GShiftNet * 提高了 2.08 dB 和 1.93 dB。

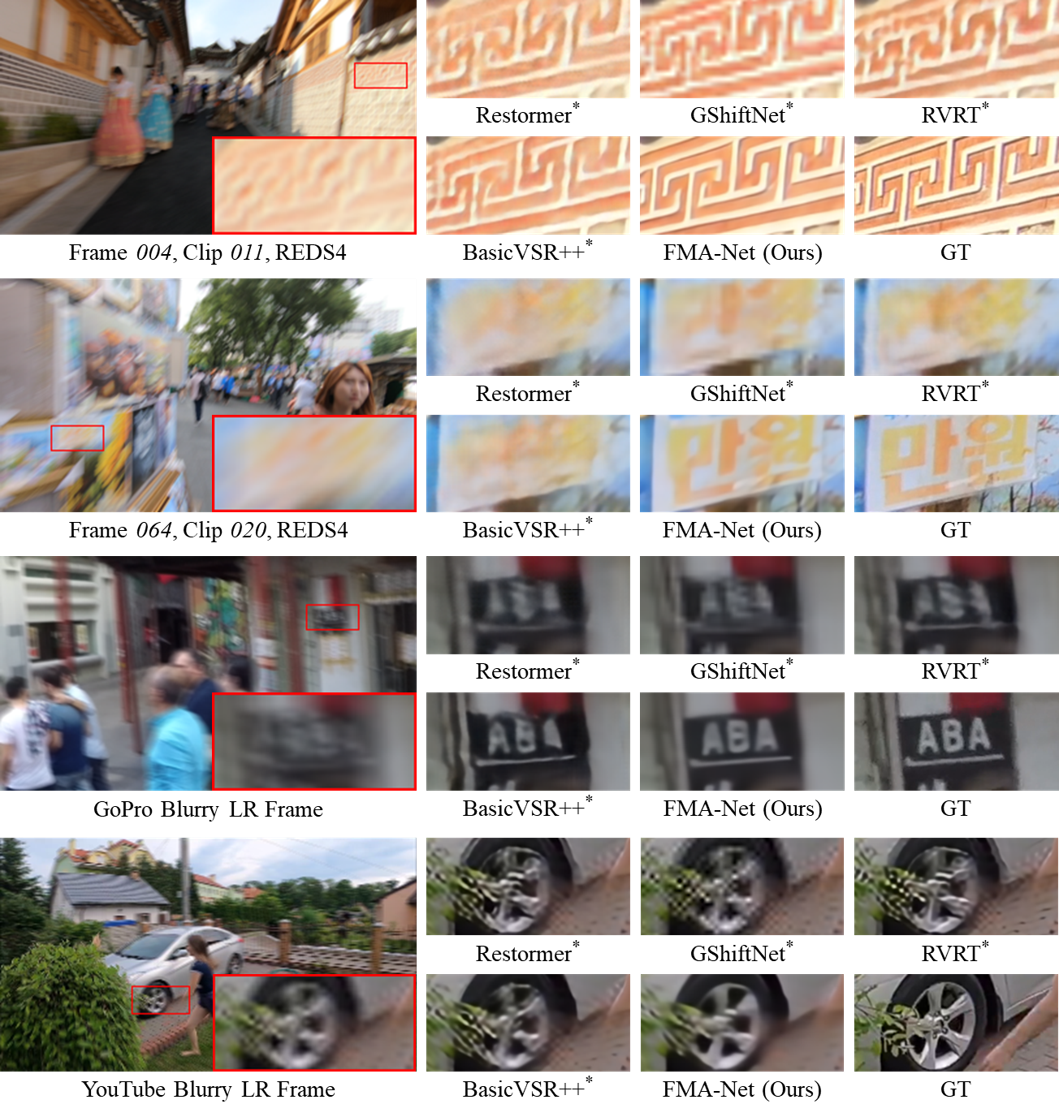

下圖為不同方法對 ×4 VSRDB 的可視化比較結果,表明 FMA-Net 生成的圖像比其他方法生成的圖像在視覺上更清晰。

不同方法在 REDS4、GoPro 和 YouTube 測試集上的可視化結果。放大觀看效果最好。

了解更多技術細節,請閱讀原文。