多智能體系統的合作之道:對MAS不確定性、社會機制與強化學習的探索

多智能體系統(MAS)是由多個自主智能體組成的系統,它們可以相互交互和協作,以完成一些共同或個人的目標。多智能體系統在許多領域都有廣泛的應用,如機器人、交通、電力、社交網絡等。但是如何促進智能體之間的合作行為一直是這一領域的難題,特別是在激勵機制不確定的情況下。激勵機制不確定是指智能體對于與其他智能體交互的收益和風險的認知存在不確定性,這可能導致智能體的行為偏離最優或最合理的選擇,從而影響系統的整體效率和穩定性。

為了探索多智能體系統在激勵機制不確定下的新興合作,荷蘭格羅寧根大學、阿姆斯特丹大學和布魯塞爾自由大學的四位研究者在2024年的AAMAS會議上發表了一篇論文,題為《Emergent Cooperation under Uncertain Incentive Alignment》。這篇論文的創新點和價值在于:

1)提出一種基于擴展的公共物品游戲(EPGG)的實驗框架,用來模擬多智能體系統在不同類型的游戲環境中的交互和學習,包括完全合作、完全競爭、混合動機和閾值四種情況。這種框架可以通過調節一個連續的乘法因子??來表示不同的激勵對齊程度,從而覆蓋了多智能體系統可能面臨的各種場景。

2)引入一種高斯噪聲的模型,用來模擬智能體對于乘法因子??的不確定性,即智能體觀察到的??值是真實??值加上一個隨機誤差。這種模型可以反映智能體在真實世界中的信息不完全和不準確的情況,從而增加了實驗的逼真度和復雜度。

3)探討三種社會機制對于智能體合作行為的影響,分別是聲譽機制、引導代理和內在獎勵機制。聲譽機制是指智能體根據自己和對手的行為和聲譽來更新自己的聲譽,從而影響自己的策略選擇。引導代理是指一些固定的智能體,它們總是選擇合作行為,并且對其他智能體的聲譽有更大的影響。內在獎勵機制是指智能體除了從環境中獲得的獎勵外,還會根據自己的行為和聲譽獲得一些額外的獎勵,從而激勵自己更加合作。

4)他們使用兩種強化學習的算法,分別是Q-learning和DQN,來訓練一組10個智能體在不同的游戲環境中進行多輪的EPGG游戲,并且分析了不同的社會機制對于智能體的平均合作率的影響。平均合作率是指智能體選擇合作行為的平均相對頻率,可以反映智能體的合作水平和傾向。

本文將對這篇論文的主要內容和結論進行解讀和分析,幫助讀者更好地理解多智能體系統在激勵機制不確定下的新興合作的問題和方法。

模型規則與特點

首先,我們來介紹一下擴展的公共物品游戲(EPGG)的基本規則和特點。EPGG是一種經典的博弈論模型,用來研究多個參與者之間的合作與背叛的問題。在EPGG中,每個參與者都有一個固定的財富??,他們可以選擇將一部分或全部的財富投入到一個公共池中,或者保留自己的財富不投入。然后公共池中的財富會被乘以一個乘法因子??,再平均分配給所有的參與者。乘法因子??可以反映公共物品的生產效率和價值,它的大小決定了游戲的性質。如果??大于參與者的人數??,那么游戲是合作的,即所有人都投入全部財富是最優的策略。如果??小于1,那么游戲是競爭的,即所有人都不投入任何財富是最優的策略。如果??在1和??之間,那么游戲是混合動機的,即存在多個均衡,而且每個人的最優策略取決于其他人的策略。如果??等于1或??,那么游戲是閾值的,即任何策略都是均衡,而且每個人的收益都相同。

圖1:配置文件的條目??和??(????) 是指標函數,如果代理的動作,則等于1??是合作的,否則為0,并且????表示???第個條目共??. 因為我們假設1<?? < ??, 很容易檢驗,在PGG中,所有代理叛逃的配置文件是一個主導策略平衡,而Pareto最優配置文件是所有代理合作的配置文件。這反映了PGG的社會困境本質。特別是對于?? = 2 PGG定義了一類囚犯困境游戲。

在論文中作者使用了擴展的EPGG模型,它有以下幾個特點:

使用一個連續的乘法因子??,而不是離散的幾個值,這樣可以覆蓋更多的游戲環境,也可以增加游戲的難度和復雜度。

使用高斯噪聲的模型,來模擬智能體對于乘法因子??的不確定性,即智能體觀察到的??值是真實??值加上一個隨機誤差。這種模型可以反映智能體在真實世界中的信息不完全和不準確的情況,也可以考察智能體如何在不確定的環境中做出決策。

使用一個聲譽機制來模擬智能體之間的信任和評價,即智能體根據自己和對手的行為和聲譽來更新自己的聲譽,從而影響自己的策略選擇。聲譽機制可以反映智能體之間的社會規范和影響,也可以激勵智能體更加合作。

使用了一個內在獎勵機制來模擬智能體的自我激勵和滿足,即智能體除了從環境中獲得的獎勵外,還會根據自己的行為和聲譽獲得一些額外的獎勵,從而激勵自己更加合作。內在獎勵機制的具體實現是這樣的,智能體會維護一個自己的聲譽值,初始為0,每次與其他智能體交互后,根據自己和對方的行為,更新自己的聲譽值。如果自己選擇合作,聲譽值增加1;如果自己選擇背叛,聲譽值減少1;如果對方選擇合作,聲譽值不變;如果對方選擇背叛,聲譽值減少2。聲譽值的范圍是[-10, 10],如果超過這個范圍,就截斷為邊界值。智能體的內在獎勵就是自己的聲譽值乘以一個系數??,??是一個正的超參數,用來控制內在獎勵的強度。智能體的總獎勵就是外在獎勵和內在獎勵的和。

訓練過程

接下來我們來看一下作者使用Q-learning和DQN算法訓練智能體的具體過程和結果。Q-learning是一種基于表格的強化學習算法,它可以讓智能體通過不斷地嘗試和反饋,學習到一個動作值函數,即每個狀態和動作對應的期望收益。DQN是一種基于神經網絡的強化學習算法,它可以讓智能體通過不斷地觀察和學習,近似地擬合一個動作值函數,從而適應更復雜和高維的狀態空間。作者使用了這兩種算法,來比較它們在不同的游戲環境和社會機制下的表現和差異。

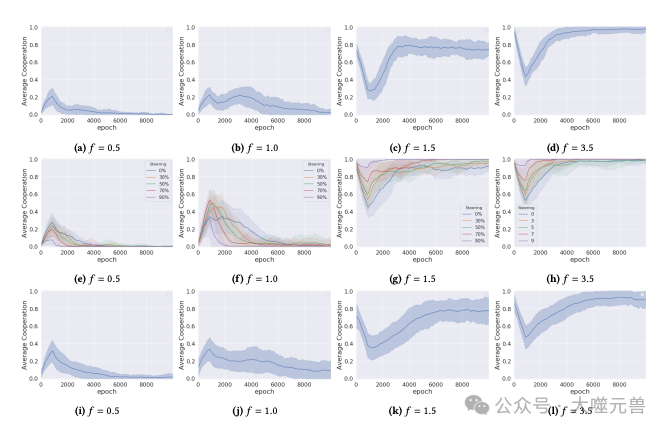

圖2:在不同倍增因子的環境中訓練的DQN代理的平均合作。最上面一行(a-d)顯示了在沒有合作輔助機制的情況下的結果,中間一行(e-h)顯示了存在聲譽機制和有助于合作的社會規范的情況,最下面一行(i-l)顯示了有內在獎勵的情況。

作者首先在沒有不確定性的情況下,使用Q-learning算法訓練智能體,觀察它們在不同的乘法因子??下的平均合作率。作者發現,當?? = 0.5時,智能體的平均合作率接近于0,即智能體幾乎都選擇背叛行為,這與理論上的最優策略一致。當?? = 1.0時,智能體的平均合作率略高于0,即智能體偶爾會選擇合作行為,這可能是由于智能體的探索行為或者學習的不完全導致的。當?? = 1.5時,智能體的平均合作率達到了0.78,即智能體大部分時候會選擇合作行為,這表明智能體能夠在混合動機的游戲中實現合作的均衡。當?? = 3.5時,智能體的平均合作率接近于1,即智能體幾乎都選擇合作行為,這也與理論上的最優策略一致。

作者在引入不確定性的情況下,使用DQN算法訓練智能體,觀察它們在不同的乘法因子??下的平均合作率。作者發現,當?? = 0.5時,智能體的平均合作率略高于0.1,即智能體偶爾會選擇合作行為,這可能是由于不確定性的影響,使得智能體對于背叛的收益不太確定。當?? = 1.0時,智能體的平均合作率略高于0.1,即智能體偶爾會選擇合作行為,這與Q-learning的結果相似。當?? = 1.5時,智能體的平均合作率降低到了0.16,即智能體大部分時候會選擇背叛行為,這表明不確定性對于混合動機的游戲有很大的負面影響,使得智能體無法達成合作的均衡。當?? = 3.5時,智能體的平均合作率降低到了0.4,即智能體只有一半的概率會選擇合作行為,這表明不確定性也對于合作的游戲有一定的負面影響,使得智能體無法達到最優的策略。

作者在引入聲譽機制的情況下,使用DQN算法訓練智能體,觀察它們在不同的乘法因子??下的平均合作率。作者發現,當?? = 0.5時,智能體的平均合作率略高于0.2,即智能體偶爾會選擇合作行為,這與沒有聲譽機制的情況相似。當?? = 1.0時,智能體的平均合作率略高于0.2,即智能體偶爾會選擇合作行為,這與沒有聲譽機制的情況相似。當?? = 1.5時,智能體的平均合作率提高到了0.33,即智能體有一定的概率會選擇合作行為,這表明聲譽機制對于混合動機的游戲有一定的正面影響,使得智能體能夠識別和合作有利的伙伴。當?? = 3.5時,智能體的平均合作率提高到了0.65,即智能體大部分時候會選擇合作行為,這表明聲譽機制對于合作的游戲有很大的正面影響,使得智能體能夠達到接近最優的策略。

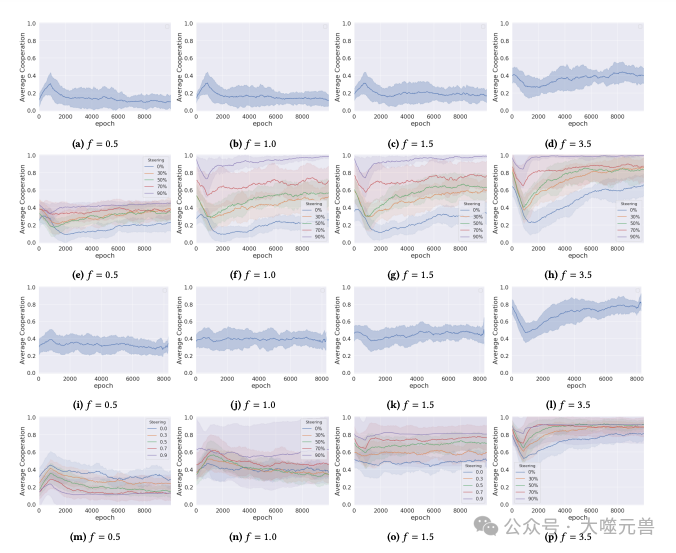

圖3:在不確定性條件下,在具有不同倍增因子的環境中訓練的DQN代理的平均合作(???? = 2 ??? ∈ ??). 結果顯示在四行中:第一行沒有聲譽或內在獎勵,第二行有聲譽和有助于合作的社會規范,第三行有內在獎勵公式,第四行有聲譽、有助于協作的社會規范和內在獎勵公式。

最后作者在引入內在獎勵機制的情況下,使用DQN算法訓練智能體,觀察它們在不同的乘法因子??下的平均合作率。作者發現,當?? = 0.5時,智能體的平均合作率提高到了0.31,即智能體有一定的概率會選擇合作行為,這表明內在獎勵機制對于競爭的游戲有一定的正面影響,使得智能體能夠獲得更多的滿足感。當?? = 1.0時,智能體的平均合作率提高到了0.36,即智能體有一定的概率會選擇合作行為,這表明內在獎勵機制對于閾值的游戲有一定的正面影響,使得智能體能夠獲得更多的滿足感。當?? = 1.5時,智能體的平均合作率降低到了0.45,即智能體只有一半的概率會選擇合作行為,這表明內在獎勵機制對于混合動機的游戲有一定的負面影響,使得智能體更傾向于自我博弈而不是與其他智能體合作。當?? = 3.5時,智能體的平均合作率提高到了0.78,即智能體大部分時候會選擇合作行為,這表明內在獎勵機制對于合作的游戲有一定的正面影響,使得智能體能夠獲得更多的滿足感。

實驗結論

通過上述的實驗結果,我們可以得出以下的結論和觀點。

不確定性對于智能體的合作行為有很大的負面影響,特別是在混合動機和合作的游戲中,使得智能體無法達成合作的均衡或最優的策略。這可能是因為不確定性增加了智能體的風險和不信任,使得智能體更難以判斷其他智能體的行為和意圖,從而更傾向于選擇保守或自私的行為。

聲譽機制對于智能體的合作行為有很大的正面影響,特別是在混合動機和合作的游戲中,使得智能體能夠識別和合作有利的伙伴。這可能是因為聲譽機制增加了智能體的信任和評價,使得智能體更容易判斷其他智能體的行為和意圖,從而更傾向于選擇合作或互惠的行為。

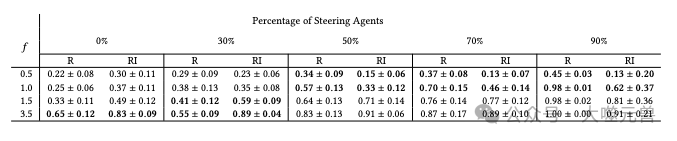

圖4:每場比賽的合作平均值和標準差,是過去 50 個訓練周期的平均值具有不確定性的實驗。這些措施針對兩種情況分別報告:一種情況是只有聲譽啟用機制(R)以及同時采用聲譽機制和內在獎勵的機制(RI)。價值觀表現出統計顯著性的內容以粗體顯示。

內在獎勵機制對于智能體的合作行為有不同的影響,取決于游戲的性質和其他社會機制的存在。在競爭和閾值的游戲中,內在獎勵機制可以提高智能體的合作行為,因為智能體可以從合作中獲得更多的滿足感,而不用擔心損失太多的收益。在混合動機的游戲中,內在獎勵機制可以降低智能體的合作行為,因為智能體可能會過分地追求自我滿足,而忽視了其他智能體的利益和反饋。在合作的游戲中,內在獎勵機制可以提高智能體的合作行為,因為智能體可以從合作中獲得更多的滿足感,而且與其他智能體的利益和反饋是一致的。當聲譽機制和引導代理也存在時,內在獎勵機制可以與之相互補充,使得智能體在不同的游戲環境中更容易達成合作或背叛。

Q-learning和DQN算法在不同的游戲環境和社會機制下的表現和差異不是本文的重點,但是可以從實驗結果中觀察到一些有趣的現象。例如,Q-learning算法在沒有不確定性的情況下,可以更好地學習到最優的策略,而DQN算法在有不確定性的情況下,可以更好地適應更復雜和高維的狀態空間。另外,Q-learning算法在混合動機的游戲中,可以達到更高的平均合作率,而DQN算法在合作的游戲中,可以達到更高的平均合作率。這些現象可能與算法的特性和參數的選擇有關,也可能與實驗的設置和隨機性有關,需要進一步的研究和驗證。

總結與展望

論文的主要貢獻是提出了一種基于擴展的公共物品游戲(EPGG)的實驗框架,用來模擬多智能體系統在不同類型的游戲環境中的交互和學習,以及探討了三種社會機制(聲譽機制、引導代理和內在獎勵機制)對于智能體合作行為的影響,特別是在激勵機制不確定的情況下。本文的實驗結果表明,不確定性對于智能體的合作行為有很大的負面影響,而社會機制可以在不同的游戲環境中產生不同的效果,有時可以相互補充,有時可以相互抵消。作者的研究為多智能體系統的合作問題提供了一種新的視角和方法,也為未來的研究提供了一些啟示和方向。

未來的研究可以從環境、算法、機制等方面進行拓展和深入。在更多的游戲環境中進行實驗,例如考慮更多的參與者、更復雜的動作空間、更多的信息維度等,以檢驗本文的實驗框架和社會機制的普適性和有效性。在更多的強化學習的算法中進行實驗,例如考慮更先進的算法、更多的超參數、更多的網絡結構等,以比較不同的算法在不同的游戲環境和社會機制下的表現和差異。在更多的社會機制中進行實驗,例如考慮更多的聲譽更新規則、更多的引導代理的比例和策略、更多的內在獎勵的形式等,以探索不同的社會機制對于智能體合作行為的影響和機理。在更多的通信和協調機制中進行實驗,例如考慮智能體之間的語言交流、信號傳遞、合作協議等,以研究通信和協調機制如何與社會機制相互作用,以及如何促進智能體之間的合作和信任。

論文的研究為多智能體系統的合作問題提供了一種新的視角和方法,也為未來的研究提供了一些啟示和方向。我們希望該論文能夠引起讀者的興趣和關注,也期待更多的研究者和實踐者能夠參與到這一有趣和有意義的領域中來,共同探索多智能體系統在激勵機制不確定下的新興合作的奧秘和可能。(END)

參考資料:https://arxiv.org/abs/2401.12646