推翻Transformer奠基之作疑被拒收,ICLR評審遭質疑!網友大呼黑幕,LeCun自曝類似經歷

去年12月,CMU和普林斯頓的2位研究者發布了Mamba架構,瞬間引起AI社區震動!

結果,這篇被眾人看好有望「顛覆Transformer霸權」的論文,今天竟曝出疑似被頂會拒收?!

今早,康奈爾大學副教授Sasha Rush最先發現,這篇有望成為奠基之作的論文似乎要被ICLR 2024拒之門外。

并表示,「說實話,我不理解。如果它被拒絕了,我們還有什么機會」。

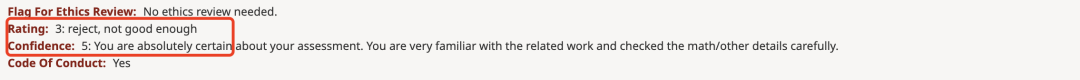

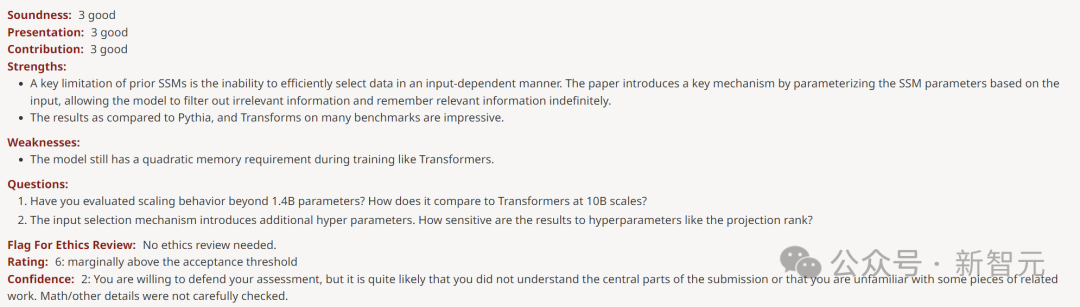

在OpenReview上可以看到,四位審稿人給出的分數是3、6、8、8。

雖然這個分數未必會讓論文被拒收,但是3分這樣的低分,也是很離譜了。

牛文得3分,LeCun都出來喊冤

這篇由CMU、普林斯頓大學的2位研究人員發表的論文,提出了一種全新的架構Mamba。

這種SSM架構在語言建模上與Transformers不相上下,而且還能線性擴展,同時具有5倍的推理吞吐量!

論文地址:https://arxiv.org/pdf/2312.00752.pdf

當時論文一出,直接炸翻了AI社區,許多人紛紛表示推翻Transformer的架構終于誕生了。

而現在,Mamba論文有被拒可能性,讓許多人無法理解。

就連圖靈巨頭LeCun也下場參與了這波討論,表示遭遇過類似的「冤屈」。

「想當年,我被引數最多,僅在Arxiv提交的論文被引超過了1880次的論文,從未被接收」。

LeCun正是以使用卷積神經網絡(CNN)在光學字符識別和計算機視覺方面的工作而聞名的,也因此在2019年獲得了圖靈獎。

不過他的這篇發表于2015年的《基于圖結構數據的深度卷積網絡》的論文,卻從未被頂會接收。

論文地址:https://arxiv.org/pdf/1506.05163.pdf

深度學習AI研究員Sebastian Raschka稱,盡管如此,Mamba在AI社區帶來了深刻的影響。

近來一大波研究,都是基于Mamba架構衍生出來的,比如MoE-Mamba、Vision Mamba。

有趣的是,爆料Mamba被打低分的Sasha Rush,也在今天發表了一篇基于這樣研究的新論文——MambaByte。

事實上,Mamba架構已經有了「星星之火可以燎原」的架勢,在學術圈的影響力越來越廣。

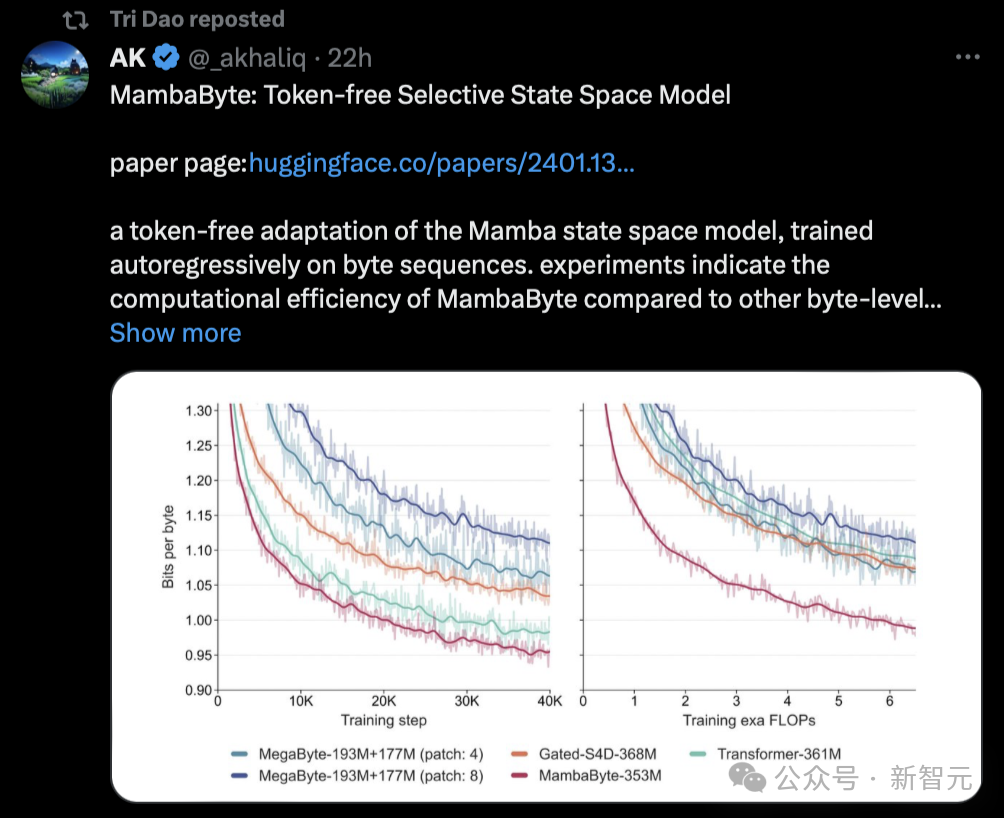

有網友表示,Mamba論文將開始占領arXiv。

「舉個例子,我剛看到這篇論文提出了MambaByte,一種無token的選擇性狀態空間模型。基本上,它調整了Mamba SSM,直接從原始token中學習。」

Mamba論文的Tri Dao今天也轉發了這篇研究。

如此大火的論文卻被打出低分,有人表示,看來同行評審是真不關注營銷的聲音有多大啊。

Mamba論文被打3分的理由

給Mamba論文打低分的原因究竟是什么呢?

可以看到給打3分的審稿人,置信度還是5,說明自己對這個評分也是非常肯定。

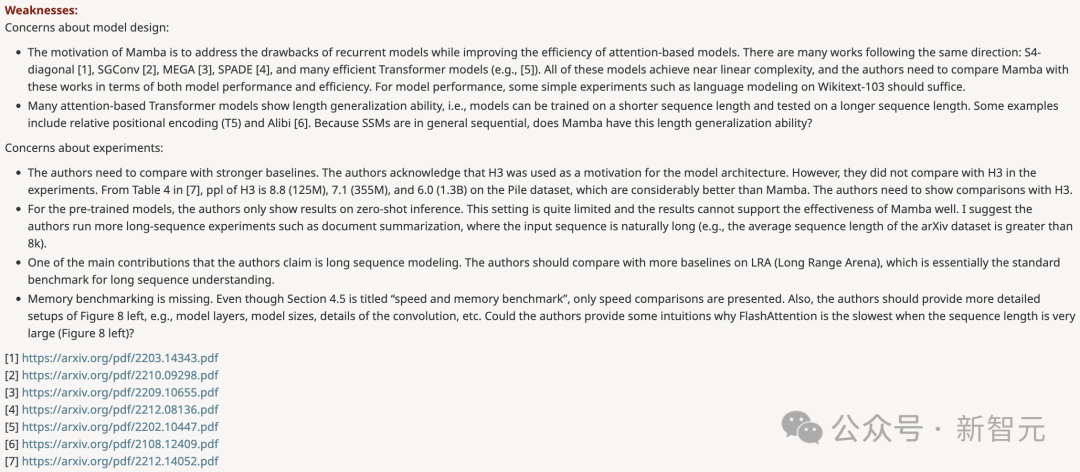

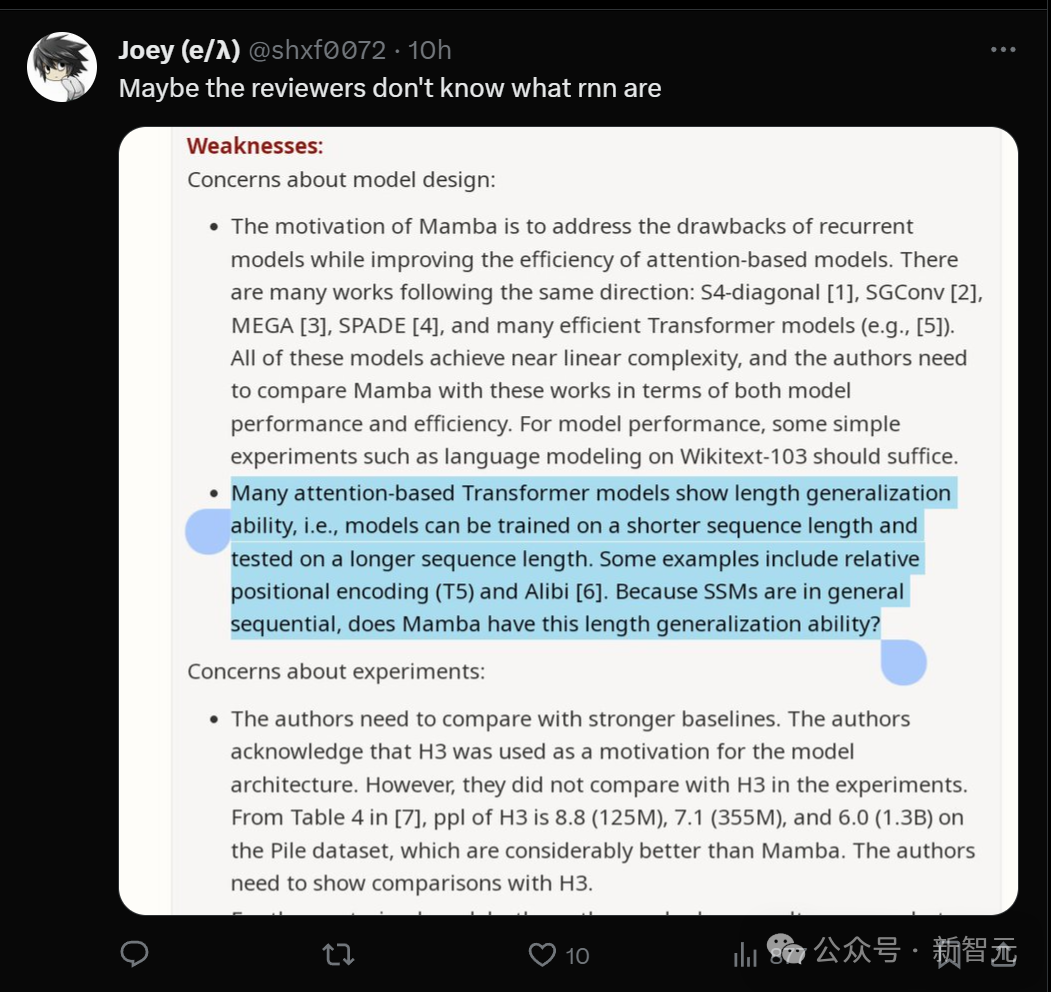

在review中,他提出的問題分為兩個部分:一是對模型設計的質疑,另一個是對實驗提出疑問。

模型設計

- Mamba的設計動機是解決循環模型的缺點,同時提高基于Transformer模型的效率。有很多研究都是沿著這個方向進行的:S4-diagonal [1]、SGConv [2]、MEGA [3]、SPADE [4],以及許多高效的Transformer 模型(如[5])。這些模型都達到了接近線性的復雜度,作者需要在模型性能和效率方面將Mamba與這些作品進行比較。關于模型性能,一些簡單的實驗(如在Wikitext-103上進行語言建模)就足夠了。

- 許多基于注意力的Transformer模型都展現出長度泛化的能力,即模型可以在較短的序列長度上進行訓練,然后在較長的序列長度上進行測試。一些例子包括相對位置編碼(T5)和 Alibi [6]。由于SSM一般都是連續的,那么Mamba是否具有這種長度泛化能力呢?

實驗

- 作者需要與更強的基線進行比較。作者承認H3被用作模型架構的動機。然而,他們并沒有在實驗中與H3進行比較。從 [7] 的表4中可以看出,在Pile數據集上,H3的ppl分別為8.8(125M)、7.1(355M)和 6.0(1.3B),大大優于 Mamba。作者需要展示與H3的比較。

- 對于預訓練模型,作者只展示了零樣本推理的結果。這種設置相當有限,結果不能很好地證明Mamba的有效性。我建議作者進行更多的長序列實驗,比如文檔摘要,在這種情況下,輸入序列自然會很長(例如,arXiv數據集的平均序列長度大于8k)。

- 作者聲稱其主要貢獻之一是長序列建模。作者應該在LRA(Long Range Arena)上與更多基線進行比較,這基本上是長序列理解的標準基準。

- 缺少內存基準。盡管第4.5節的標題是「速度和內存基準」,但只介紹了速度比較。此外,作者應提供圖8左側更詳細的設置,如模型層、模型大小、卷積細節等。作者能否提供一些直觀的解釋,說明為什么當序列長度非常大時FlashAttention的速度最慢(圖8左)?

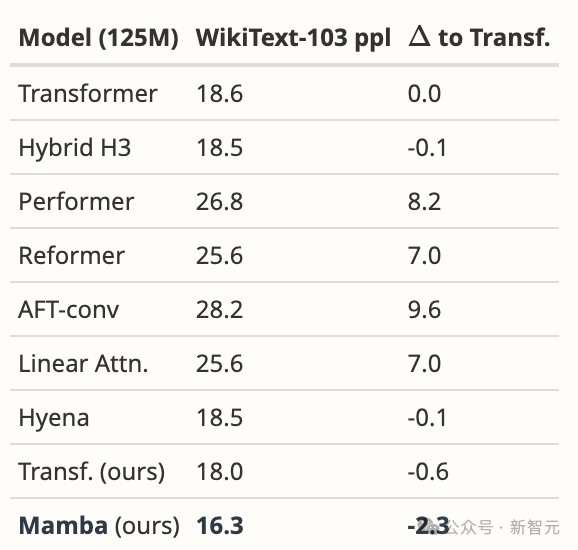

對于審稿人的質疑,作者也是回去做了功課,拿出了一些實驗數據去rebuttal。

比如,針對模型設計第一點疑問,作者表示團隊有意將重點放在大規模預訓練的復雜性上,而不是小規模基準上。

盡管如此,Mamba在WikiText-103上的表現還是大大優于所有建議的模型和更多模型,這也是我們在語言方面的一般結果所能預料到的。

首先,我們在與Hyena論文 [Poli, 表 4.3] 完全相同的環境下對Mamba進行了比較。除了他們報告的數據外,我們還調整了自己的強Transformer基線。

然后,我們將模型換成Mamba,它比我們的Transformer提高了1.7 ppl,比原始基線Transformer提高了2.3 ppl。

針對「缺少內存基準」這一點,作者表示:

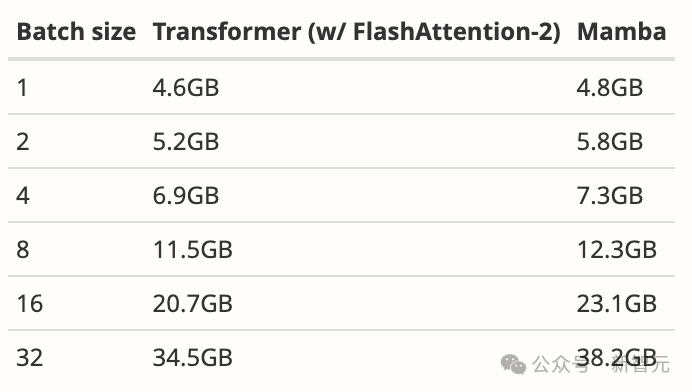

與大多數深度序列模型(包括FlashAttention)一樣,內存使用量只是激活張量的大小。事實上,Mamba的內存效率非常高;我們還額外測量了125M模型在一張A100 80GB GPU上的訓練內存需求。每個批由長度為2048的序列組成。我們將其與我們所知的內存效率最高的Transformer實現(使用torch.compile的內核融合和FlashAttention-2)進行了比較。

更多rebuttal細節,請查看https://openreview.net/forum?id=AL1fq05o7H

總的看下來,審稿人的意見,作者都已解決,然而這些rebuttal卻被審稿人全部忽略了。

有人從這位審稿人的意見中找出了「華點」:或許他根本不懂什么是rnn?

全程圍觀網友表示,整個過程讀起來太令人痛心了,論文作者給出了如此徹底的回應,但審稿人絲毫沒有動搖,不再重新評估。

打出一個置信度為5的3分,還不理會作者有理有據的rebuttal,這種審稿人也太煩人了吧。

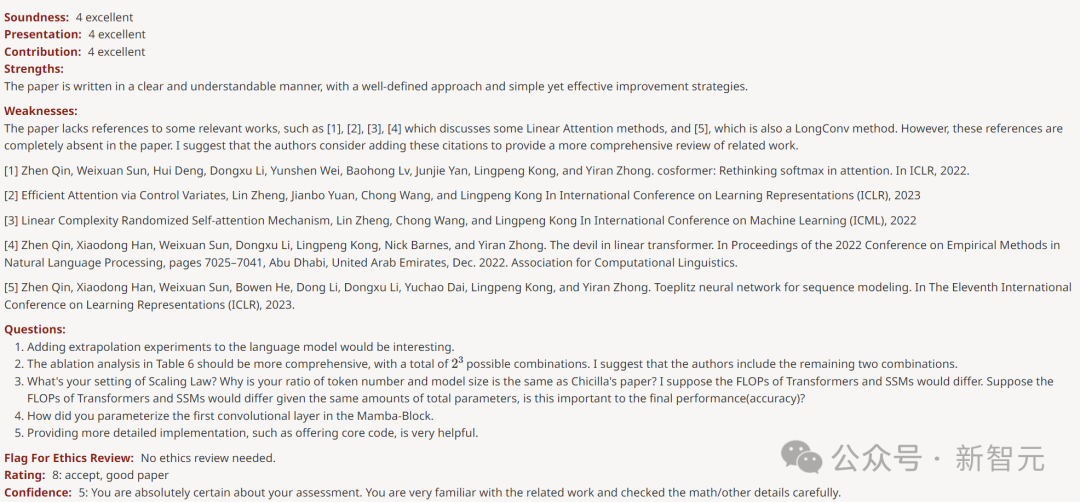

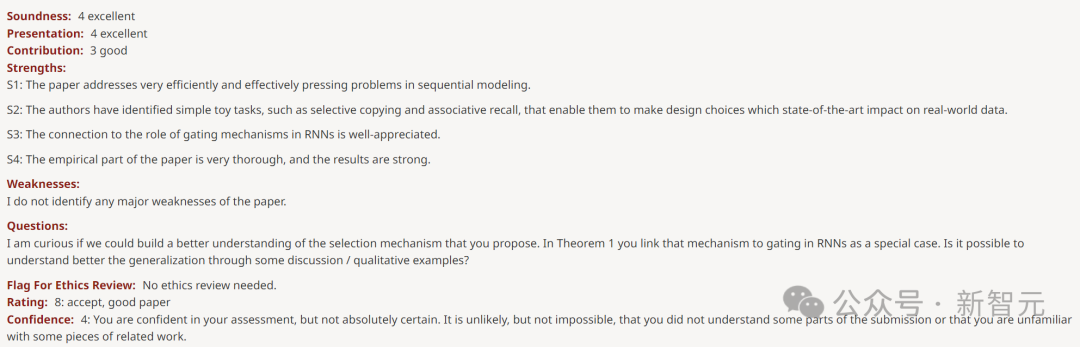

而其他三位審稿人,則給出了6、8、8這樣的高分。

打6分的審稿人指出,weakness是「該模型在訓練期間仍然像Transformer一樣需要二次內存」。

打出8分的審稿人表示,文章的weakness只是「缺乏對一些相關著作的引用」。

另一位給8分的審稿人對論文大加贊賞,稱「實證部分非常透徹,結果很強」。

甚至沒發現任何Weakness。

分歧如此大的分型,應該有一個解釋的。但目前還未有meta-reviewer評論。

網友大呼:學術界也衰落了!

在評論區,有人發出了靈魂拷問,究竟是誰打出了3這樣的低分??

顯然,這篇論文用很低的參數獲得了更好的結果,并且GitHub代碼也很清晰,每個人都可以測試,因此已經贏得了坊間公認的贊譽,所以大家才都覺得離譜。

有人干脆大呼WTF,即使Mamba架構不能改變LLM的格局,它也是一個在長序列上有多種用途的可靠模型。竟然得到這個分數,是不是意味著如今的學術界已經衰落了?

大家紛紛感慨道,好在這只是四條評論中的一個,其他審稿人給出的都是高分,目前最終決定尚未做出。

有人猜測,可能是審稿人太累了,失去了判斷力。

另外還有一種原因,就是State Space模型這樣的全新研究方向,或許會威脅到某些在Transformer領域很有建樹的審稿人專家,情況很復雜。

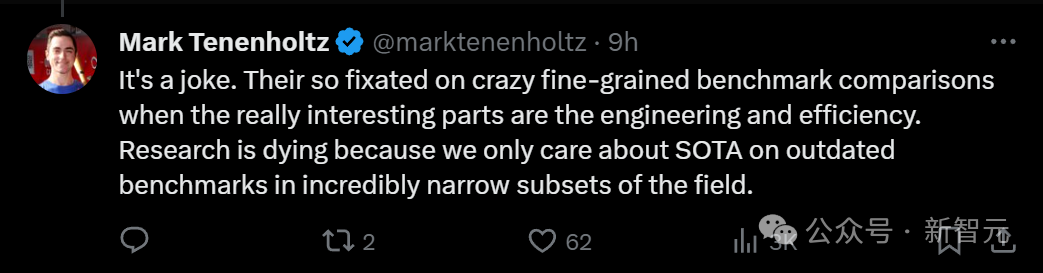

有人說,Mamba論文獲得3分,簡直就是業界的笑話。

他們如此專注于瘋狂比較細顆粒度基準,但其實論文真正有趣的部分,是工程和效率。研究正在消亡,因為我們只關心SOTA,盡管它是在該領域極其狹窄子集的過時基準上。

「理論不夠,工程太多。」

目前,這樁「謎案」還未水落石出,全體AI社區都在等一個結果。