頂流Mamba竟遭ICLR拒稿,學(xué)者集體破防變小丑,LeCun都看不下去了

一項(xiàng)ICLR拒稿結(jié)果讓AI研究者集體破防,紛紛刷起小丑符號(hào) 。

。

爭(zhēng)議論文為Transformer架構(gòu)挑戰(zhàn)者M(jìn)amba,開(kāi)創(chuàng)了大模型的一個(gè)新流派。發(fā)布兩個(gè)月不到,后續(xù)研究MoE版本、多模態(tài)版本等都已跟上。

但面對(duì)ICRL給出的結(jié)果,康奈爾副教授Alexander Rush都表示看不懂怎么回事了,“如果這都被拒了,那我們小丑們還有什么機(jī)會(huì)”。

在評(píng)論區(qū)和轉(zhuǎn)發(fā)區(qū),不少研究者帶上小丑面具前來(lái)報(bào)道。

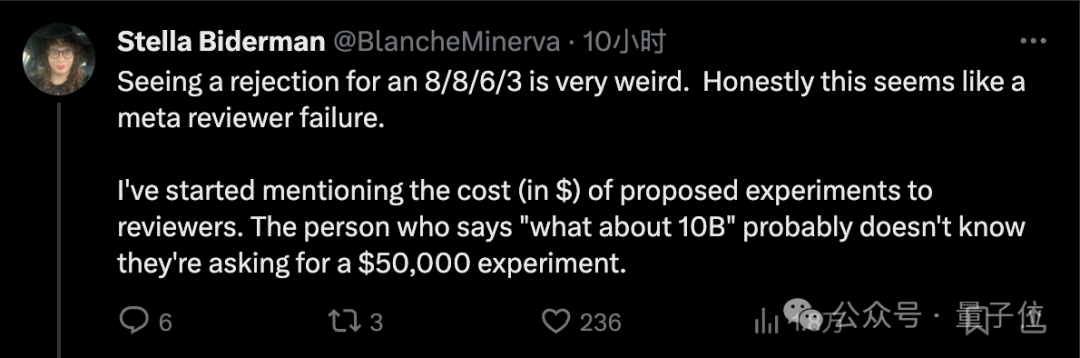

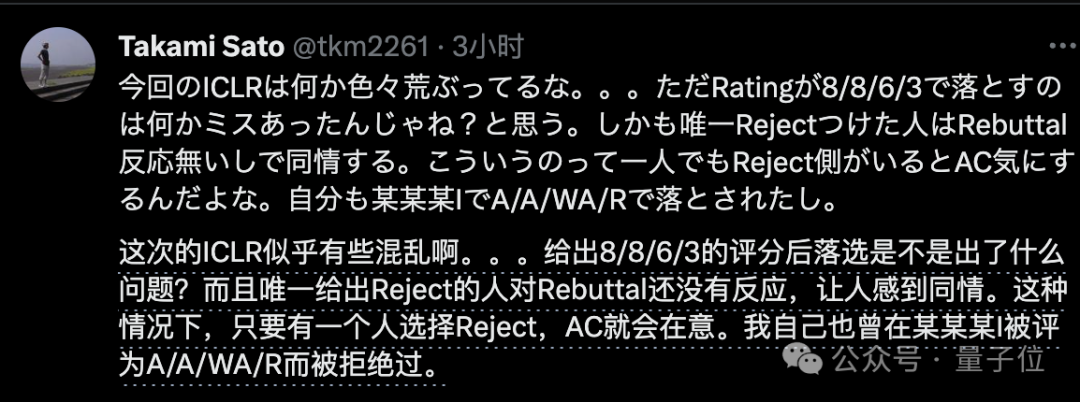

具體來(lái)說(shuō),四位審稿人打出8/8/6/3的分?jǐn)?shù),這樣被拒很多人就已經(jīng)覺(jué)得不正常。

其中一位審稿人提的問(wèn)題是“有沒(méi)有訓(xùn)練更大的模型,和10b參數(shù)的Transformer比較如何?”。

對(duì)此,有人表示已經(jīng)開(kāi)始向?qū)徃迦颂峒皩?shí)驗(yàn)成本了。

審稿人可能不知道他們要求的實(shí)驗(yàn)會(huì)花費(fèi)50000美元。

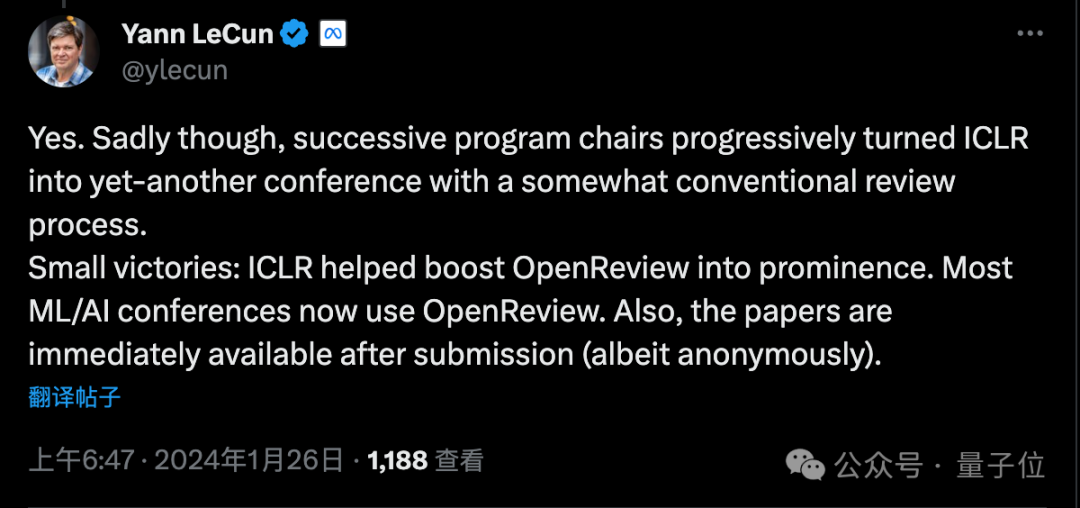

ICLR會(huì)議創(chuàng)辦的初衷正是優(yōu)化同行評(píng)審過(guò)程,LeCun作為會(huì)議創(chuàng)始人之一,也表達(dá)了不滿:

很遺憾,歷屆程序委員會(huì)主席慢慢把它變成了一個(gè)與傳統(tǒng)評(píng)審流程差不多的會(huì)議。

只有一些小勝利:OpenReview平臺(tái)現(xiàn)在被大多數(shù)ML/AI會(huì)議使用,以及論文提交后立刻就能被所有人閱讀(盡管匿名)。

LeCun還舉例自己也有一篇從未被接受、ArXiv獨(dú)占的論文,現(xiàn)在被引用次數(shù)已超過(guò)1880次。

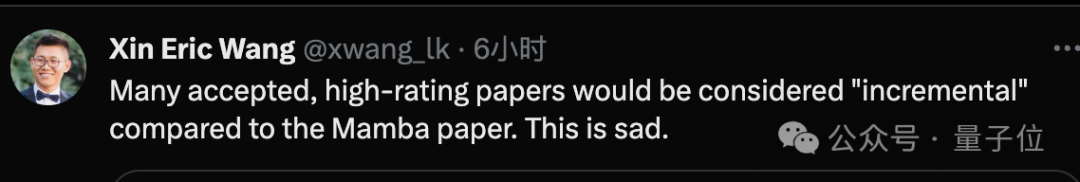

也有研究者認(rèn)為,這次很多高分被接受論文與Mamba比起來(lái)充其量只能算增量研究,更令人遺憾了。

這屆ICLR混亂重重

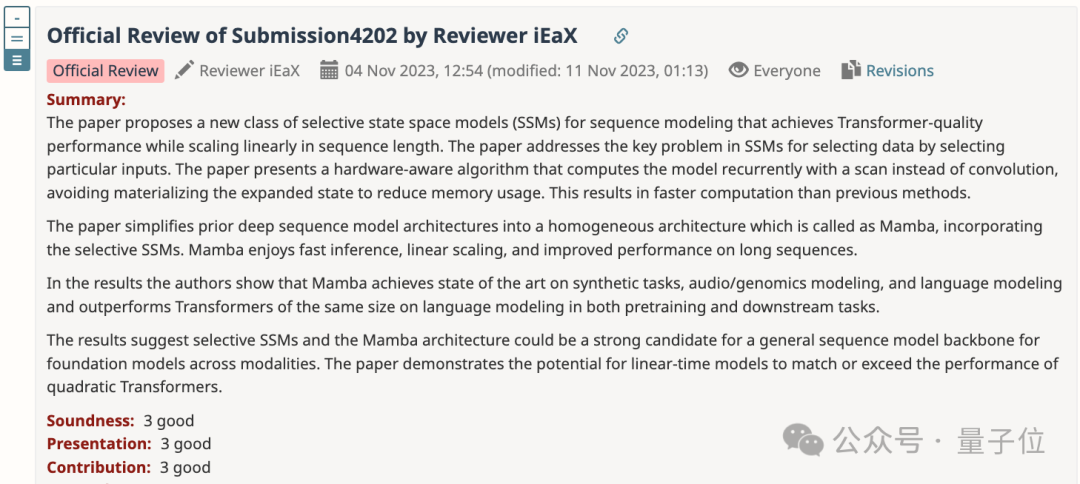

先來(lái)借用給6分審稿人的意見(jiàn),簡(jiǎn)單介紹一下Mamba論文的主要貢獻(xiàn)。

- 提出了基于SSM狀態(tài)空間模型的新架構(gòu),可實(shí)現(xiàn)Transformer質(zhì)量的性能,同時(shí)線性縮放序列長(zhǎng)度。

- 提出了一種硬件感知算法,通過(guò)掃描而不是卷積來(lái)循環(huán)計(jì)算模型,避免具體化擴(kuò)展?fàn)顟B(tài)以減少內(nèi)存使用。

- 將先前的深度序列模型架構(gòu)簡(jiǎn)化為同構(gòu)架構(gòu),具有快速推理、線性縮放和改進(jìn)的長(zhǎng)序列性能。

- 在多種模態(tài)(語(yǔ)言、音頻和基因組學(xué))上都取得SOTA性能,成為跨模態(tài)通用序列模型主干的有力候選者。

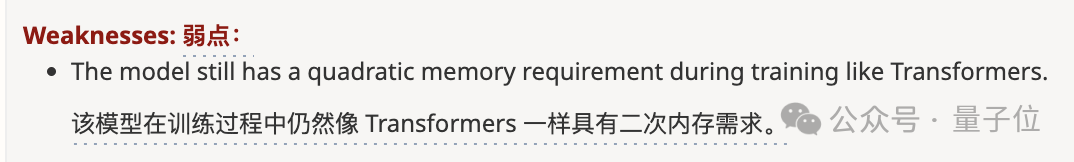

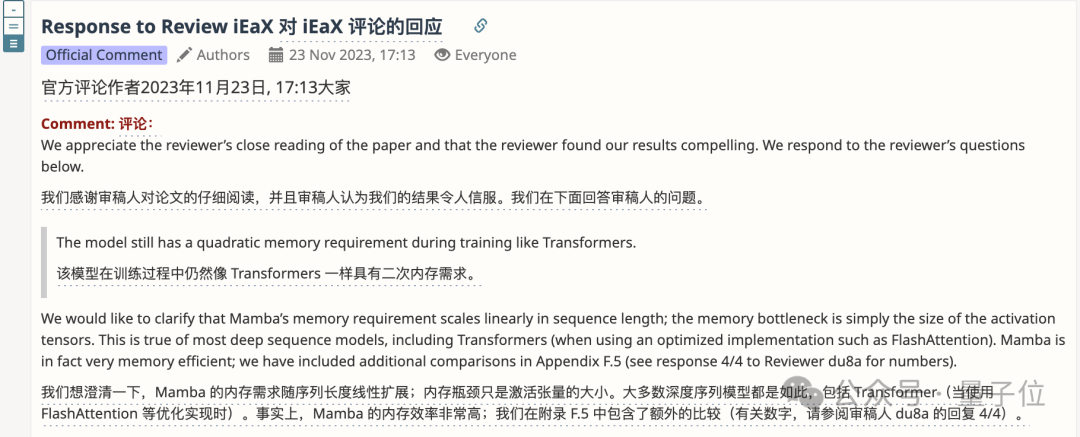

但這位審稿人提出的二次內(nèi)存需求問(wèn)題,不少熟悉這篇論文的人都表示不認(rèn)可。

對(duì)此,作者也在Rebuttal中給出了解釋,內(nèi)存需求實(shí)際上是隨序列長(zhǎng)度線性增長(zhǎng)的。

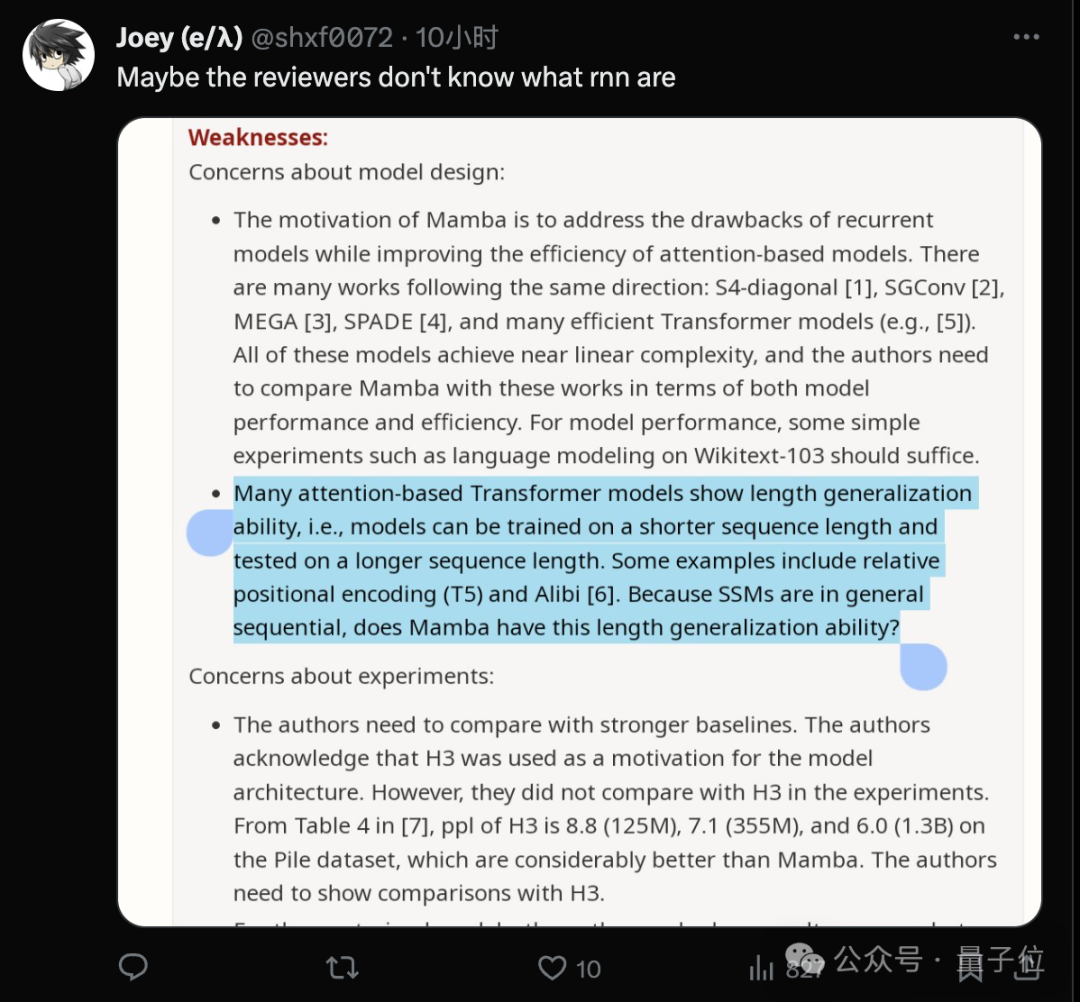

另外一位打3分的審稿人,還被吃瓜群眾指出可能根本不熟悉什么是RNN。

作者針對(duì)這位審稿人的Rebuttal太長(zhǎng),足足分了4條才發(fā)完。

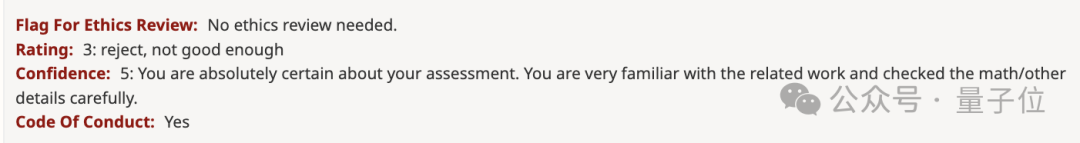

然鵝,這位對(duì)自己評(píng)分給出5級(jí)置信度的審稿人,根本沒(méi)有回復(fù)。

這就讓人更擔(dān)心會(huì)不會(huì)影響領(lǐng)域主席的判斷了。

正如這位研究者所說(shuō),這屆ICLR出現(xiàn)的爭(zhēng)議還不止一例。

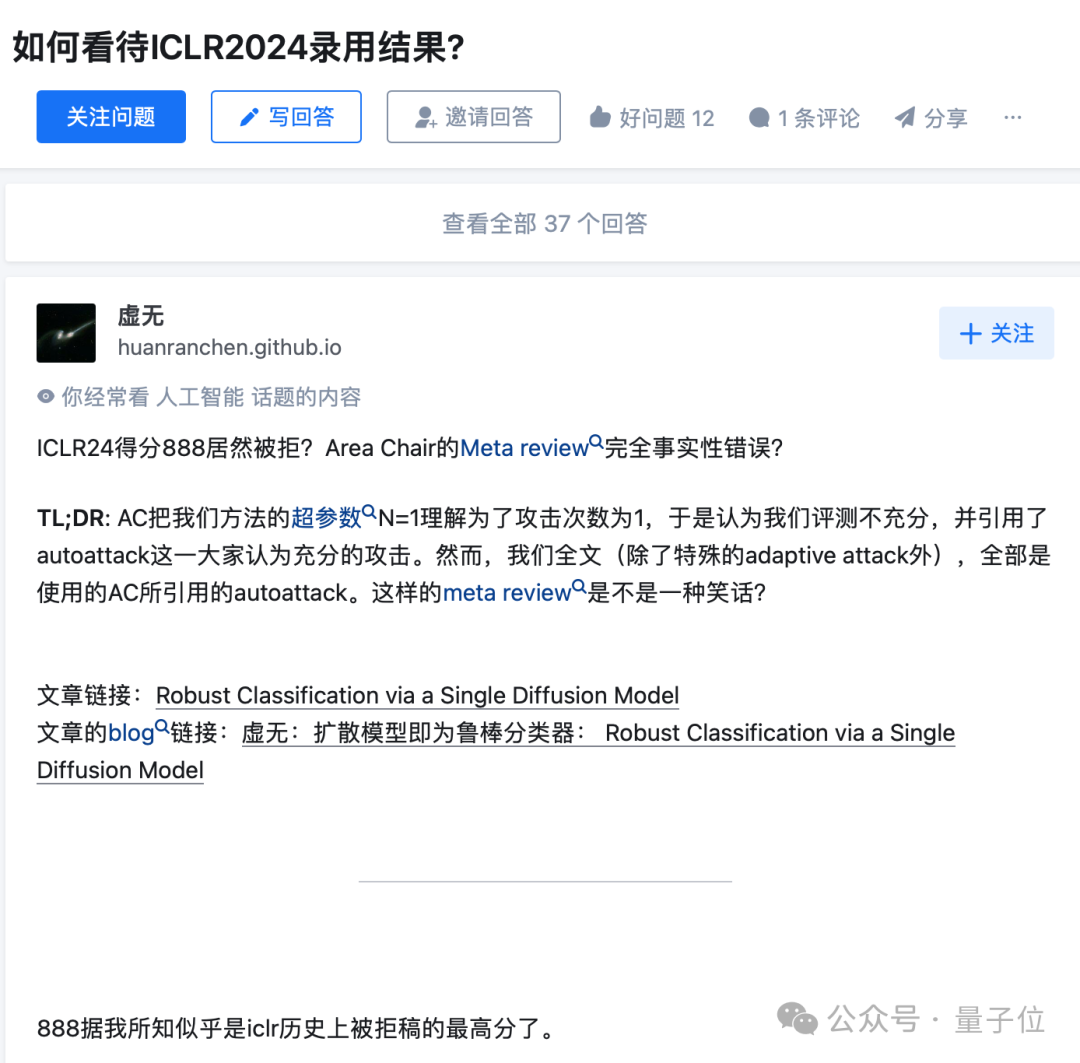

8/8/6/3如果被拒還算事出有因,知乎相關(guān)討論上還有得分8/8/8被AC拒,就更離譜了。

還有作者和審稿人吵起來(lái),以至于要討論禮貌問(wèn)題的。

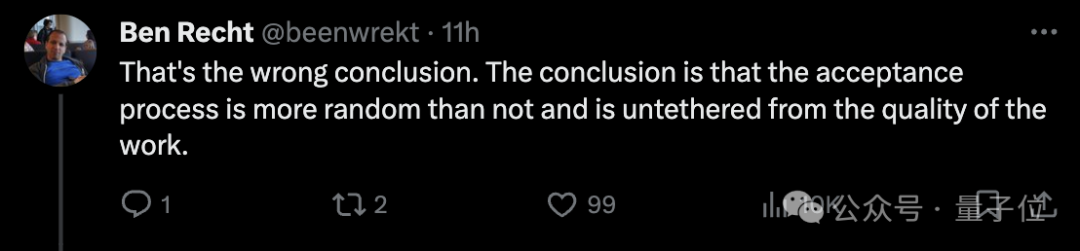

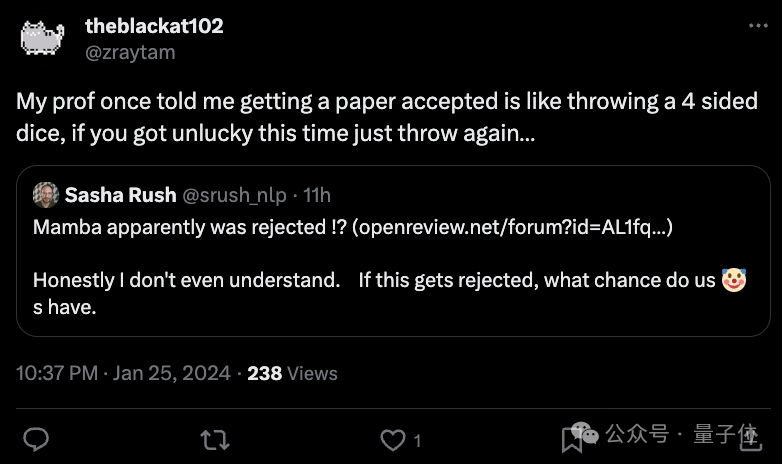

投稿接不接收全靠隨機(jī)?

這也引發(fā)了網(wǎng)友們對(duì)整體學(xué)術(shù)評(píng)審現(xiàn)狀的討論。其中一個(gè)主要討論點(diǎn)是評(píng)審過(guò)程有缺陷“接不接受真的很隨機(jī),和論文本身的質(zhì)量關(guān)系不大”:

網(wǎng)友也是緩緩打出一個(gè)問(wèn)號(hào):

既然評(píng)審流程存在問(wèn)題,那解決方案是什么?就靠運(yùn)氣?

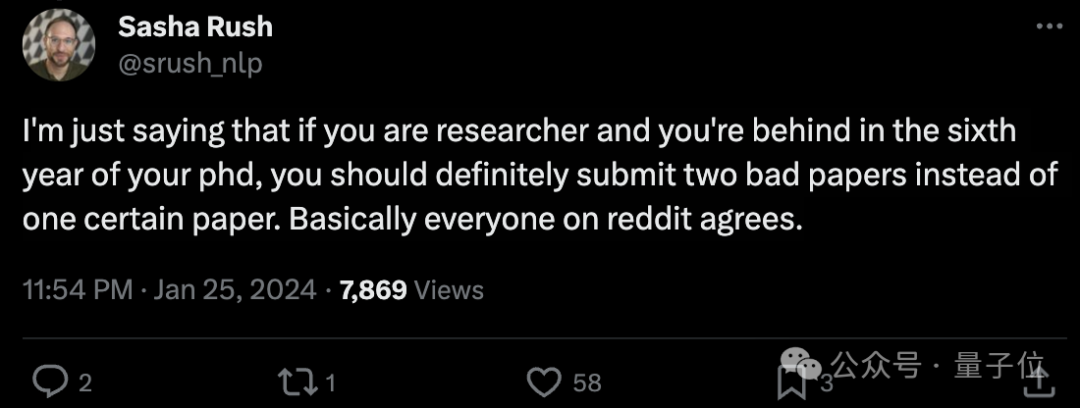

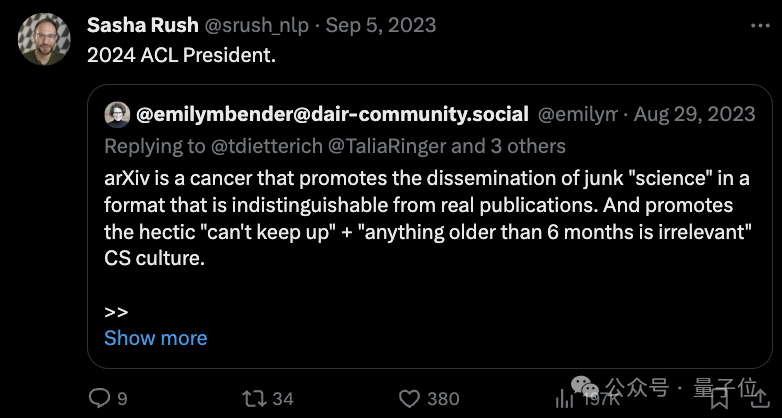

對(duì)此,康奈爾副教授Alexander Rush甚至還提出了這樣的建議(手動(dòng)狗頭):

如果你讀博已經(jīng)讀到了第六年的那種,應(yīng)該提交兩篇糟糕的論文,而不是一篇好的。

不只一位學(xué)者分享了類似的建議:

我的教授曾說(shuō),論文被接受的過(guò)程就像擲一個(gè)四面骰子,如果這次運(yùn)氣不好,就再擲一次……

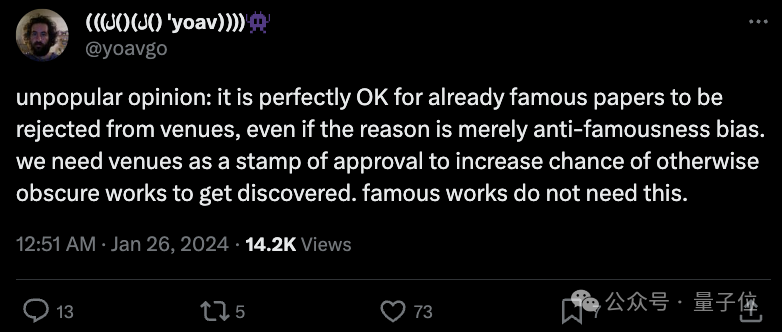

當(dāng)然,也有人抱有不同的觀點(diǎn),認(rèn)為會(huì)議作為一種認(rèn)可,已出名的作品其實(shí)已經(jīng)不需要了,可以給其他未被發(fā)掘的論文更多機(jī)會(huì),所以已經(jīng)出名的論文被學(xué)術(shù)會(huì)議拒絕也是完全可以接受的。

值得一提的是,還有不少人建議大家轉(zhuǎn)投新生代會(huì)議CoLM,Alexander Rush自己也參與了這個(gè)會(huì)議的創(chuàng)辦:

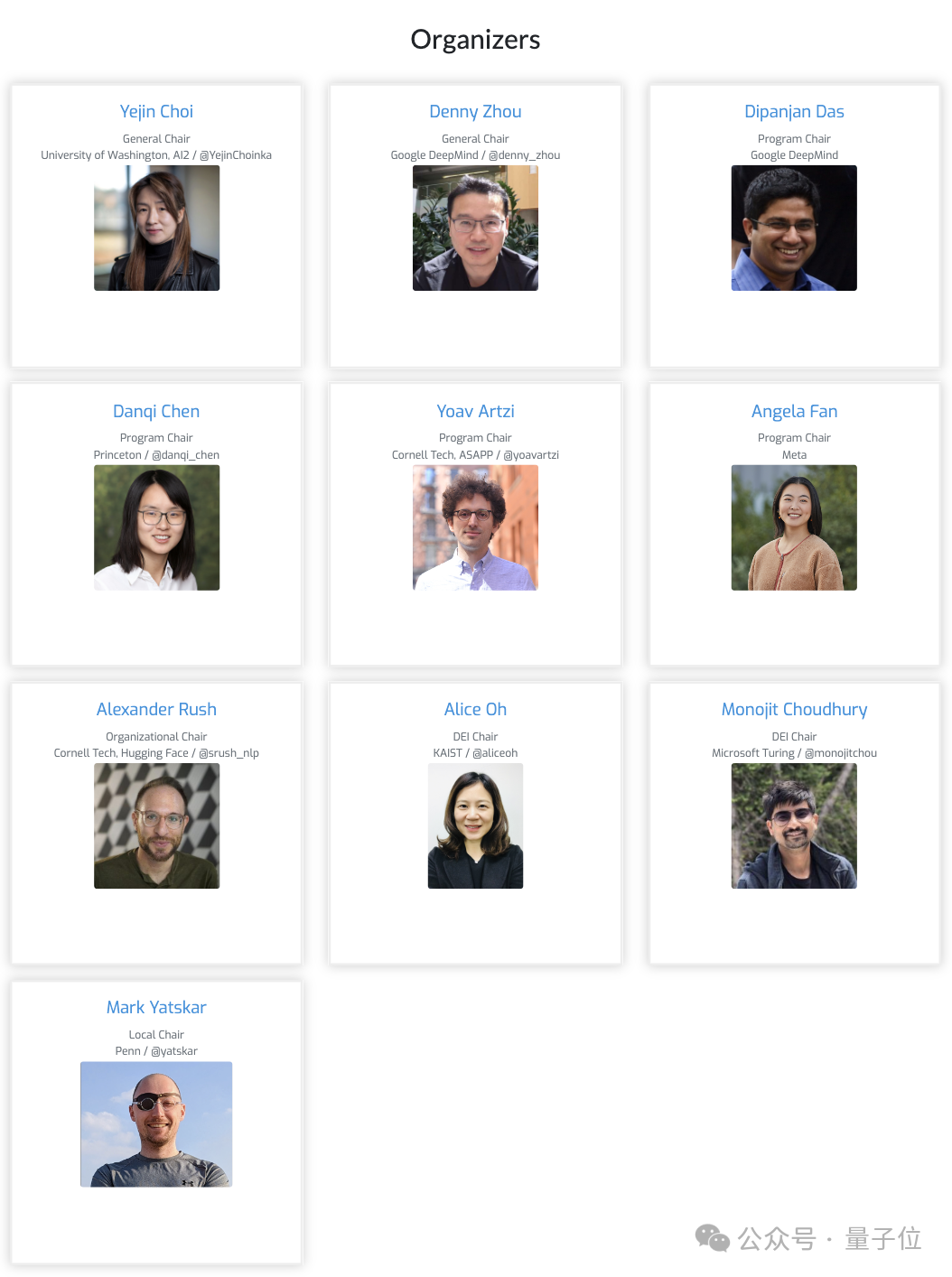

而大家提到的CoLM會(huì)議,全稱Conference On Language Modeling,專注于語(yǔ)言模型領(lǐng)域。CoLM剛創(chuàng)立不久,第一屆大會(huì)將在今年10月份舉辦。

其中七位組織者均是來(lái)自業(yè)界學(xué)界的大佬,其中有三位是華人學(xué)者谷歌周登勇、普林斯頓陳丹琦、Meta的Angela Fan。

與ICLR類似,COLM將采用雙盲審核,并使用OpenReview管理投稿。

會(huì)議征稿主題包括但不限于語(yǔ)言建模及大模型語(yǔ)境下的對(duì)齊、數(shù)據(jù)、評(píng)估、社會(huì)影響、安全、科學(xué)、高效計(jì)算、工程、學(xué)習(xí)和推理算法等17個(gè)方向。

據(jù)說(shuō),COLM還是在ACL 2024主席公開(kāi)抨擊稱“arXiv是科研的毒瘤”而后引發(fā)爭(zhēng)論的背景下,催生出來(lái)的。

參考鏈接:

[1]https://twitter.com/srush_nlp/status/1750526956452577486。

[2]https://x.com/ylecun/status/1750594387141369891。

[3]https://openreview.net/forum?id=AL1fq05o7H。