準確率不足20%,GPT-4V/Gemini竟看不懂漫畫!首個圖像序列基準測試開源

OpenAI的GPT-4V和谷歌最新的Gemini多模態(tài)大語言模型一經(jīng)推出就得到業(yè)界和學界的熱切關(guān)注: 一系列工作都從多角度展示了這些多模態(tài)大語言模型對視頻的理解能力。人們似乎相信我們離通用人工智能artificial general intelligence (AGI) 又邁進了一大步!

可如果告訴你,GPT-4V連漫畫中的人物行為都會看錯, 試問:元芳,你怎么看?

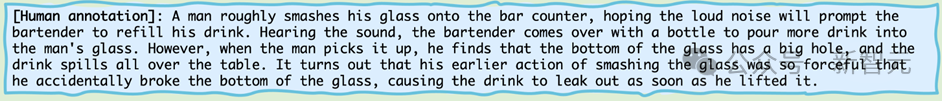

我們來看看這幅迷你漫畫系列:

圖片

圖片

如果讓生物界最高智能體——人類,也就是讀者朋友來描述, 你大概率會說:

圖片

圖片

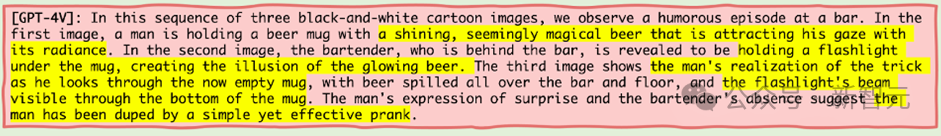

那我們來看看當機器界最高智能體——也就是GPT-4V來看這幅迷你漫畫系列的時候,它會這么描述呢?

圖片

圖片

GPT-4V作為公認的站在鄙視鏈頂端的機器智能體,居然公然睜眼說瞎話。

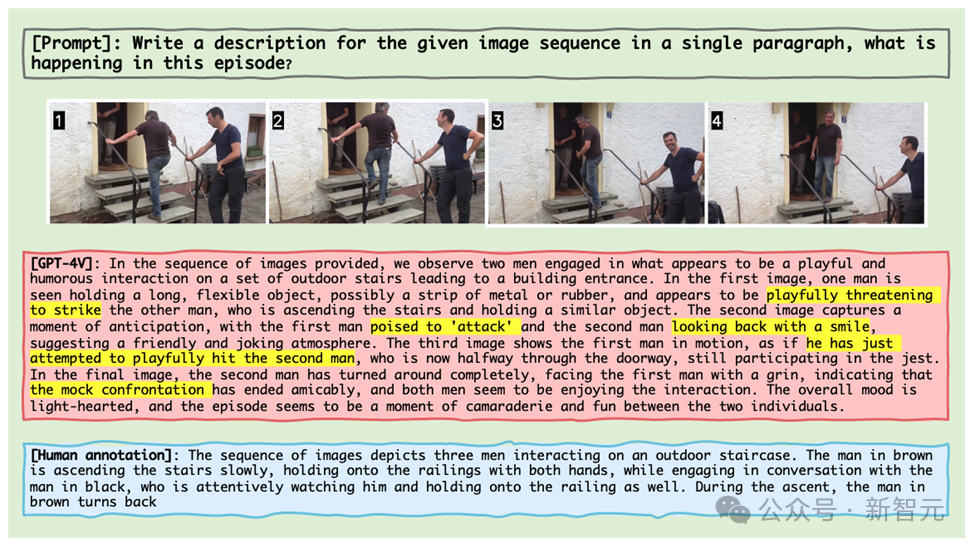

還有更離譜的是,就算給GPT-4V實際的生活圖像片段,它也會把一個人上樓梯過程中與另一個人交談的行為也離譜的識別成兩個人手持「武器」相互打斗嬉鬧 (如下圖所示)。

圖片

圖片

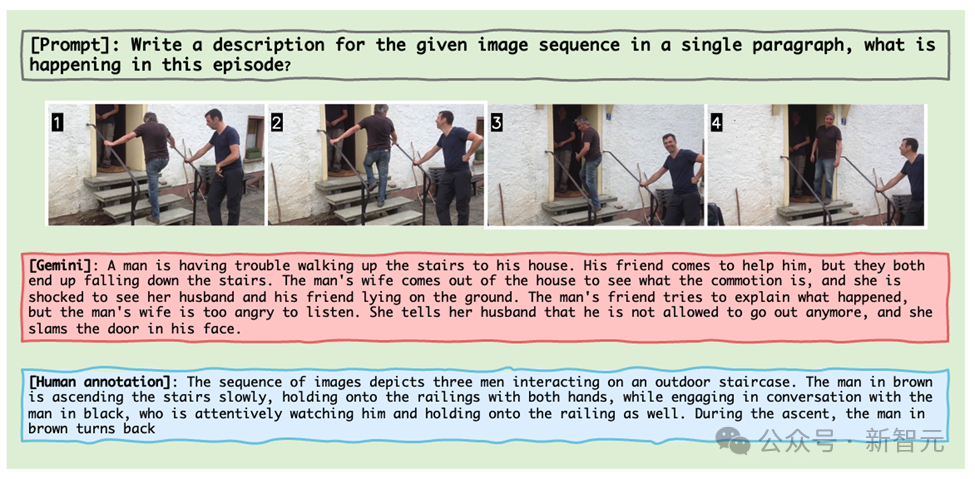

Gemini也不遑多讓,同樣的圖像片段,把這個過程看成了男子艱難上樓并與妻子爭吵被鎖在屋里。

圖片

圖片

這些例子都來自于馬里蘭大學聯(lián)合北卡教堂山的研究團隊的最新成果,他們推出了一個專門為MLLM設(shè)計的圖像序列的推理基準測試——Mementos。

就像諾蘭的電影《Memento記憶碎片》重新定義了敘事方式,Mementos正在重塑測試人工智能的上限。

作為一個全新的基準測試,它挑戰(zhàn)的是人工智能對如記憶碎片般的圖像序列的理解。

圖片

圖片

論文鏈接:https://arxiv.org/abs/2401.10529

項目主頁:https://mementos-bench.github.io

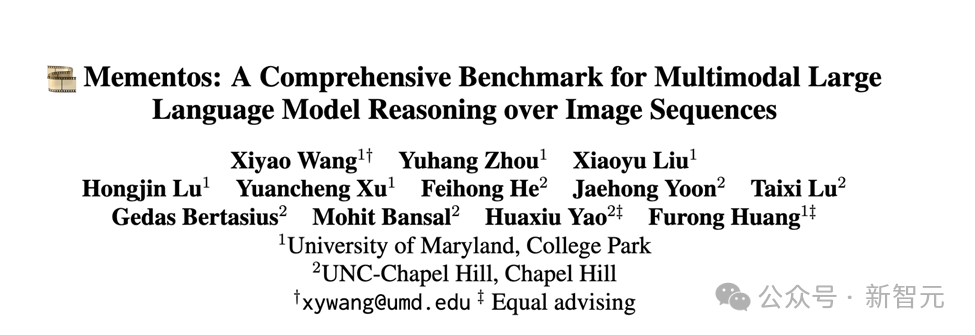

Mementos是第一個專為MLLM設(shè)計的圖像序列推理的基準測試,主要關(guān)注大模型在連續(xù)圖像上的對象幻覺和行為幻覺。

其涉及的圖片類型多樣,涵蓋三大類別:真實世界圖像,機器人圖像,以及動漫圖像。

并且包含了4,761個不同長度的多樣化圖像序列,每個序列都配有人類注釋的主要對象及其在序列中的行為描述。

圖片

圖片

目前數(shù)據(jù)已經(jīng)開源,并且還在更新中。

幻覺類型

作者在論文中闡述了MLLM在Mementos中會產(chǎn)生的兩種幻覺:對象幻覺(object hallucination)和行為幻覺(behavior hallucination)。

顧名思義, 對象幻覺是幻想出不存在的對象(object), 而行為幻覺則是幻想出對象并沒有做出的動作與行為。

測評方式

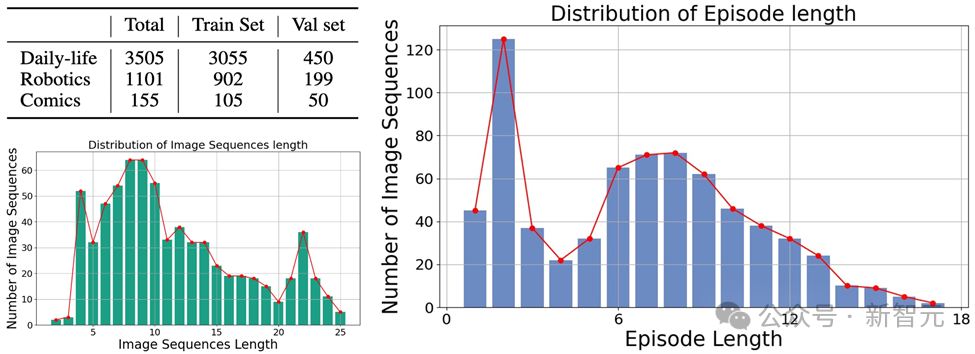

對于如何準確的評估MLLM在Mementos上的行為幻覺和對象幻覺,研究團隊選擇了將MLLM產(chǎn)生的圖像描述和人標注的描述進行關(guān)鍵詞匹配。

為了自動化評測每一個MLLM的表現(xiàn),作者采用了GPT-4輔助測試的方法來進行評估:

圖片

圖片

1. 作者將圖像序列和提示詞作為輸入給MLLM,并生成與相應圖像序列對應的描述;

2. 請求GPT-4提取AI生成描述中的對象和行為關(guān)鍵詞;

3. 獲得兩個關(guān)鍵詞列表:AI生成的對象關(guān)鍵詞列表和AI生成的行為關(guān)鍵詞列表;

4. 計算AI生成的對象關(guān)鍵詞列表和行為關(guān)鍵詞列表和人的標注的關(guān)鍵詞表的召回率、準確率和F1指標。

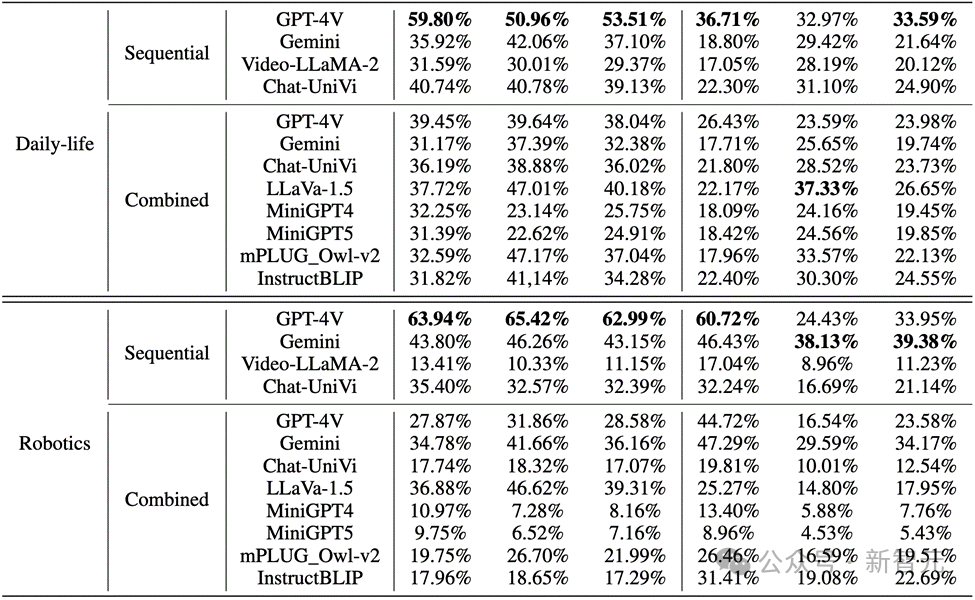

測評結(jié)果

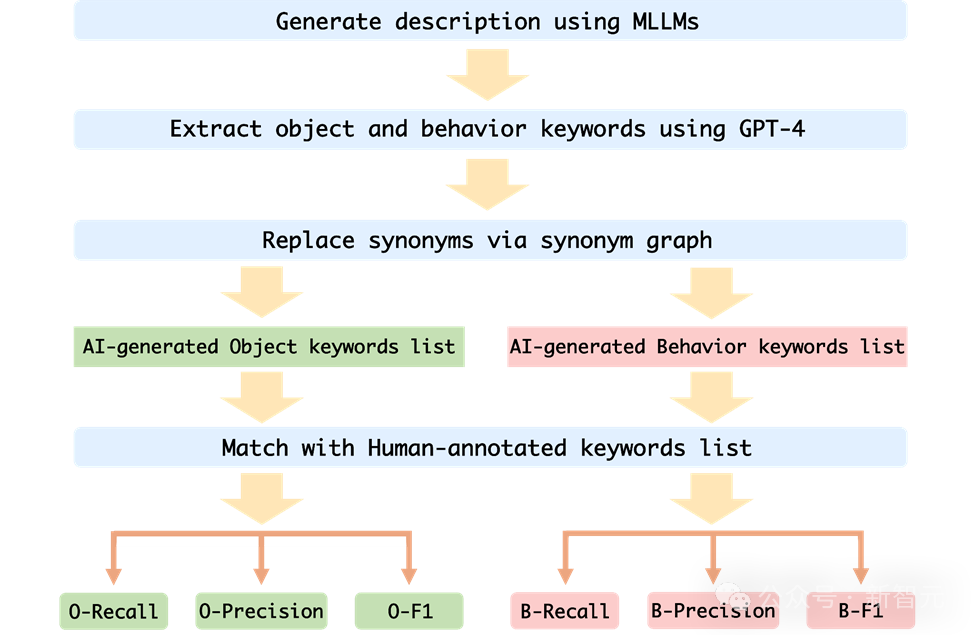

作者在Mementos上評估了MLLMs在序列圖像推理方面的表現(xiàn),對包括GPT4V和Gemini在內(nèi)的九種最新的MLLMs進行了細致的評估。

MLLM被要求來描述圖像序列中正在發(fā)生的事件,從而來測評MLLM對于連續(xù)圖像的推理能力。

結(jié)果發(fā)現(xiàn),如下圖所示,GPT-4V和Gemini對于人物行為在漫畫數(shù)據(jù)集的正確率竟然不到20%。

圖片

圖片

而在真實世界圖像和機器人圖像中,GPT-4V和Gemini的表現(xiàn)也不盡如人意:

圖片

圖片

關(guān)鍵點

1. 在評估多模態(tài)大型語言模型時,GPT-4V和LLaVA-1.5分別是在黑盒和開源MLLMs中表現(xiàn)最好的模型。GPT-4V在理解圖像序列方面的推理能力優(yōu)于其他所有MLLMs,而LLaVA-1.5在對象理解方面幾乎與黑盒模型Gemini相當或甚至超越。

2. 雖然Video-LLaMA-2和Chat-UniVi是為視頻理解設(shè)計的,但它們并沒有顯示出比LLaVA-1.5更好的優(yōu)勢。

3. 所有MLLMs在圖像序列中對象推理的三個指標上表現(xiàn)顯著優(yōu)于行為推理,表明當前MLLMs在從連續(xù)圖像中自主推斷行為的能力不強。

4. 黑盒模型在機器人領(lǐng)域的表現(xiàn)最佳,而開源模型在日常生活領(lǐng)域表現(xiàn)相對較好。這可能與訓練數(shù)據(jù)的分布偏移有關(guān)。

5. 訓練數(shù)據(jù)的局限性導致開源MLLMs的推理能力較弱。這表明了訓練數(shù)據(jù)的重要性以及它對模型性能的直接影響。

錯誤原因

作者對當前多模態(tài)大型語言模型在處理圖像序列推理時失敗的原因的分析,主要識別了三個錯誤原因:

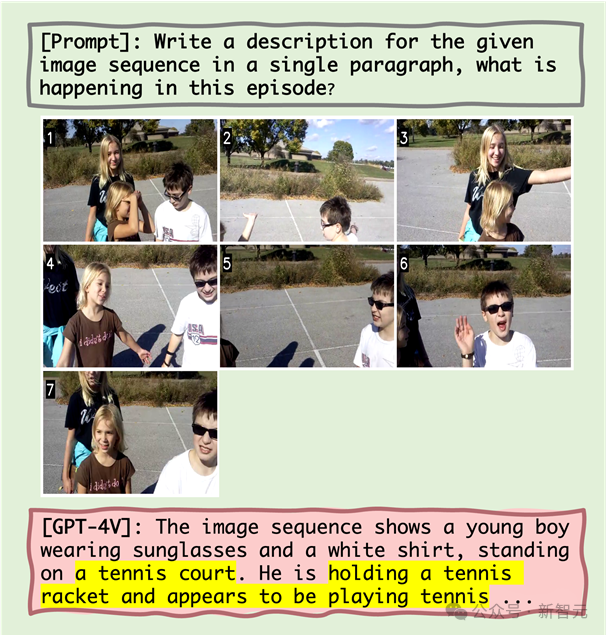

1. 對象與行為幻覺之間的相互作用

研究假設(shè),錯誤的對象識別會導致隨后的行為識別不準確。量化分析和案例研究表明,對象幻覺會在一定程度上導致行為幻覺。例如,當MLLM錯誤地將場景識別為網(wǎng)球場后,可能會描述人物正在打網(wǎng)球,即使這種行為在圖像序列中并不存在。

2. 共現(xiàn)對行為幻覺的影響

MLLM傾向于生成在圖像序列推理中常見的行為組合,這加劇了行為幻覺的問題。例如,在處理機器人領(lǐng)域的圖像時,MLLM可能錯誤地描述一個機器人手臂在“抓取把手”之后拉開抽屜,即使實際行為是“抓取抽屜的側(cè)面”。

3. 行為幻覺的雪球效應

隨著圖像序列的進行,錯誤可能會逐漸累積或加劇,這稱為雪球效應。在圖像序列推理中,如果早期出現(xiàn)錯誤,這些錯誤可能會在序列中積累和放大,導致對象和行為識別的準確性下降。

舉個例子

圖片

圖片

從上圖可知,MLLM失敗原因包括對象幻覺以及對象幻覺與行為幻覺之間的相關(guān)性,以及共現(xiàn)行為。

例如,在出現(xiàn)「網(wǎng)球場」的對象幻覺后,MLLM隨后展現(xiàn)出「拿著網(wǎng)球拍」的行為幻覺(對象幻覺與行為幻覺之間的相關(guān)性)以及「似乎在打網(wǎng)球」的共現(xiàn)行為。

圖片

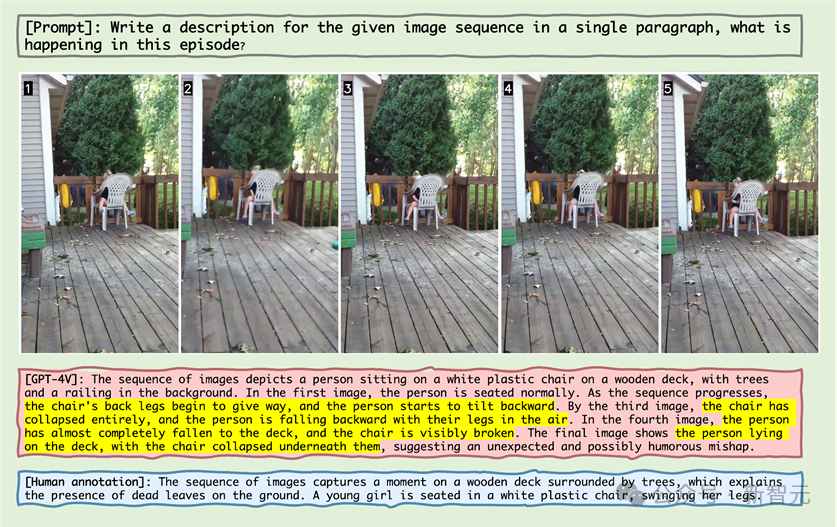

圖片

觀察上圖中的樣本,可以發(fā)現(xiàn)MLLM錯誤地認為椅子再往后仰并且認為椅子碎掉了。

這一現(xiàn)象揭示了MLLM對于圖像序列中的靜止的對象,它也會產(chǎn)生這個對象發(fā)生了某些動作的幻覺。

圖片

圖片

在上圖關(guān)于機械臂的圖像序列展示中,機械臂伸到了把手旁邊,MLLM就錯誤地認為機械臂抓住了把手,證明了MLLM會生成在圖像序列推理中常見的行為組合,從而產(chǎn)生幻覺。

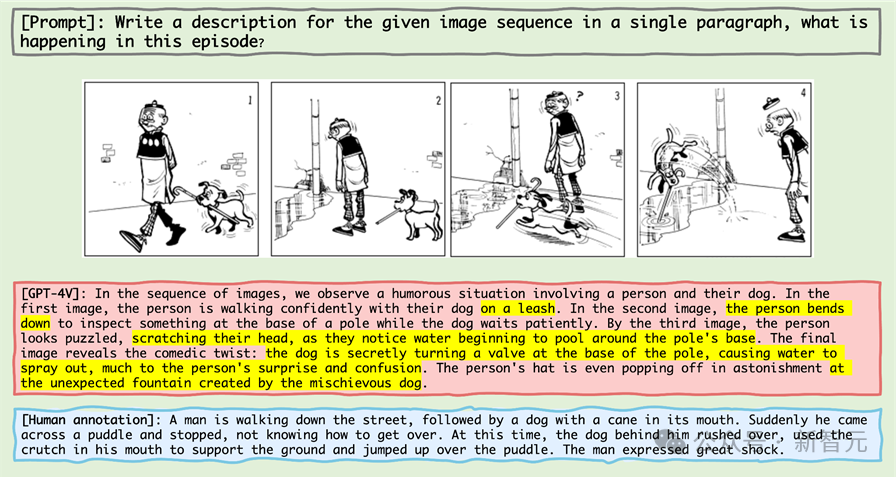

圖片

圖片

在上圖的案例中,老夫子并沒有牽著狗,MLLM錯誤地認為遛狗就要牽著狗,并且「狗的撐桿跳」被識別成了「創(chuàng)造了噴泉」。

大量的錯誤反映了MLLM對于漫畫領(lǐng)域的不熟悉,在二次元動漫領(lǐng)域,MLLM可能需要大幅度的優(yōu)化和預訓練.

在附錄中,作者通過詳細展示了各主要類別中的失敗案例,并進行了深入的分析。

總結(jié)

近年來,多模態(tài)大型語言模型在處理各種視覺-語言任務上展現(xiàn)出了卓越的能力。

這些模型,如GPT-4V和Gemini,能夠理解和生成與圖像相關(guān)的文本,極大地推動了人工智能技術(shù)的發(fā)展。

然而,現(xiàn)有的MLLM基準測試主要集中于基于單張靜態(tài)圖像的推理,而對于從圖像序列中推斷,這對于理解我們不斷變化的世界至關(guān)重要,的能力研究相對較少。

為了解決這一挑戰(zhàn),研究人員提出了一種新的基準測試「Mementos」,目的是評估MLLMs在序列圖像推理方面的能力。

Mementos包含了4761個不同長度的多樣化圖像序列。此外,研究團隊還采用了GPT-4輔助方法來評估MLLM的推理性能。

通過對九個最新的MLLMs(包括GPT-4V和Gemini)在Mementos上的仔細評估,研究發(fā)現(xiàn)這些模型在準確描述給定圖像序列的動態(tài)信息方面存在挑戰(zhàn),常常導致對象及其行為的幻覺/誤表達。

量化分析和案例研究識別出三個關(guān)鍵因素影響MLLMs的序列圖像推理:

1. 對象和行為幻覺之間的相關(guān)性;

2. 共現(xiàn)行為的影響;

3. 行為幻覺的累積影響。

這一發(fā)現(xiàn)對于理解和提升MLLMs在處理動態(tài)視覺信息方面的能力具有重要意義。Mementos基準不僅揭示了當前MLLMs的局限性,也為未來的研究和改進提供了方向。

隨著人工智能技術(shù)的快速發(fā)展,MLLMs在多模態(tài)理解領(lǐng)域的應用將變得更加廣泛和深入。Mementos基準測試的引入,不僅推動了這一領(lǐng)域的研究,也為我們提供了新的視角,去理解和改進這些先進的AI系統(tǒng)如何處理和理解我們復雜多變的世界。

參考資料:

https://github.com/umd-huanglab/Mementos