普林斯頓DeepMind用數(shù)學(xué)證明:LLM不是隨機(jī)鸚鵡!「規(guī)模越大能力越強(qiáng)」有理論根據(jù)

今天故事的主角是兩位科學(xué)家,Sanjeev Arora和Anirudh Goyal。

Arora來自普林斯頓大學(xué),而Goyal則來自谷歌DeepMind。

他們湊到一起,只想探究一個(gè)問題。

那就是,LLM,究竟是只會嘰嘰喳喳學(xué)舌的隨機(jī)鸚鵡,還是真學(xué)會了什么,搖身一變成為了具有涌現(xiàn)能力的智能體?

AI先驅(qū)Hinton和吳恩達(dá)曾經(jīng)也聊過這個(gè)問題,但彼時(shí)并沒有得出什么明確的結(jié)論。

不過Hinton表示,在這個(gè)問題的回答上如果我們不能達(dá)成共識,那么在AI會產(chǎn)生多大危害這個(gè)問題上也不可能達(dá)成共識。

而Arora和Goyal的觀點(diǎn)是,LLM并不是只會學(xué)舌的鸚鵡。具體來說,他們不認(rèn)為LLM的輸出內(nèi)容只是從海量的訓(xùn)練數(shù)據(jù)中隨機(jī)組合而來的。

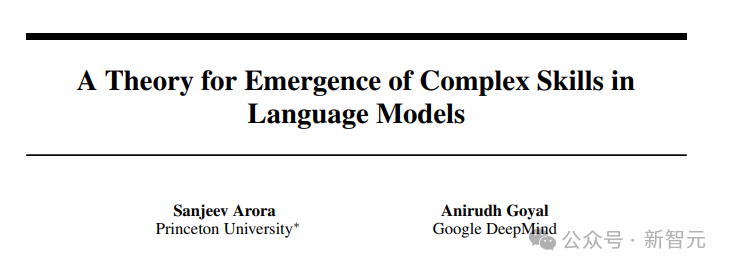

兩個(gè)人為此合寫了一篇論文。

論文地址:https://arxiv.org/abs/2307.15936

真相則是,經(jīng)過大量訓(xùn)練,LLM的規(guī)模變得越來越大,它們的相關(guān)能力會得到切實(shí)的提升,并開發(fā)出新的能力。

這可不是一般的排列組合能做到的。

大模型之「大」

眾所周知,LLM是一個(gè)龐大的人工神經(jīng)網(wǎng)絡(luò),連接著一個(gè)個(gè)「神經(jīng)元」。

其實(shí)說的就是模型的參數(shù)。參數(shù)越多,LLM的規(guī)模越大。

咱們先了解一下訓(xùn)練LLM的機(jī)制和環(huán)節(jié)。

訓(xùn)練的過程會有這么個(gè)環(huán)節(jié)——給LLM提供一個(gè)單句,把最后一個(gè)詞隱藏掉,然后讓LLM根據(jù)概率來預(yù)測空缺的詞匯應(yīng)該是誰。

假如LLM知道1000個(gè)單詞,那它就會搞出1000個(gè)概率。最后選一個(gè)概率最大的填上。

一開始,LLM可能選不準(zhǔn)詞,算法就會給出一個(gè)損失值,即在某個(gè)高維的數(shù)學(xué)空間中,LLM給出的初始答案和原句正確答案之間的「距離」(distance),然后用這個(gè)值來對參數(shù)進(jìn)行微調(diào)。

之后,還是同一個(gè)句子,LLM就能算出一個(gè)更正確的概率分布,上述損失值就會稍微降低一點(diǎn)。

如此這般,訓(xùn)練數(shù)據(jù)中數(shù)以十億計(jì)的句子都跑一遍這個(gè)流程,等LLM的總體損失值降低到一個(gè)還不錯(cuò)的程度為止。

同樣,測試LLM也會走這個(gè)流程,根據(jù)損失值得出測試的結(jié)果(當(dāng)然,測試用的句子肯定不在訓(xùn)練數(shù)據(jù)里,要不然不是作弊了嘛)。

訓(xùn)完練,測完試,LLM在遇到全新的文本prompt時(shí),就有極大可能生成最正確的那個(gè)詞了。一個(gè)詞出來,扔到prompt里,再生成下一個(gè)詞。

慢慢生成下去,一個(gè)看似連貫的回答就躍然紙上了。

然而在這個(gè)過程中,并沒有跡象表明,規(guī)模更大的LLM會在需要推理能力(reasoning)的提問上表現(xiàn)更好。

注意跟上思路,沒有跡象表明,意思是說沒有實(shí)證能指向這個(gè)結(jié)果,但是從表面上的事實(shí)來看,這個(gè)結(jié)論是對的。

也就是說,規(guī)模更大的LLM會在推理能力上表現(xiàn)的比小規(guī)模的模型好,雖然二者在訓(xùn)練方式上沒有不同,只差在規(guī)模上。

Arora大惑不解,那這能力是從哪來的?

這也就是Arora和Goyal研究的起點(diǎn)了——試圖構(gòu)建一個(gè)理論框架來分析這些新能力是如何出現(xiàn)的。

于是,他們把目光轉(zhuǎn)向了數(shù)學(xué)領(lǐng)域,瞄上了一個(gè)叫隨機(jī)圖的東西。簡單來說,這個(gè)名詞處于圖論和概率論兩個(gè)領(lǐng)域的交叉地帶。

在隨機(jī)圖中,任何兩個(gè)節(jié)點(diǎn)之間是否存在一條把它們連起來的邊,是隨機(jī)的,就好像拋硬幣一樣。

硬幣擲出正面,就有一條邊,概率為p。

p的值發(fā)生某些變化的時(shí)候,整個(gè)隨機(jī)圖的屬性就可能發(fā)生突然的轉(zhuǎn)變。比方說,p值超過某個(gè)特定閾值,有些孤立的節(jié)點(diǎn)(即和其它節(jié)點(diǎn)不存在連接的點(diǎn)),就會突然消失。

兩位科學(xué)家意識到,隨機(jī)圖的這個(gè)特點(diǎn)可能是模擬大語言模型的一種直觀方式。

雖說神經(jīng)網(wǎng)絡(luò)的復(fù)雜程度難以言說,幾乎難以分析,但是隨機(jī)圖這個(gè)概念已經(jīng)被數(shù)學(xué)家研究了相當(dāng)長的一段時(shí)間,還開發(fā)出了各種工具來分析。

也許,通過隨機(jī)圖的相關(guān)理論,神經(jīng)網(wǎng)絡(luò)的研究人員就可以試著理解并分析大語言模型的一些特征。

這里,兩位研究人員把目光專注在了二分圖上,圖里會包含兩種類型的節(jié)點(diǎn)。

在他們的模型中,一種類型的節(jié)點(diǎn)代表著文本片段。注意,這里的片段從篇幅上看最起碼得是個(gè)段落,甚至長達(dá)幾頁都有可能,而非單個(gè)的詞匯。

這類節(jié)點(diǎn)構(gòu)成一條直線。

第二類節(jié)點(diǎn),代表著理解上述給定文本所需要的的技能。比方說,對邏輯關(guān)系的理解,或是計(jì)算的能力,更具體點(diǎn),還可能有理解諷刺的能力。

舉這幾個(gè)例子是為了講明白,這第二類節(jié)點(diǎn)所代表的能力多種多樣,沾的上邊的都算。

Arora表示,LLM如果能看出某段文本里含有反諷,可能對整體的理解都會出現(xiàn)較大變化。

不過,我們上面講到過,第二類節(jié)點(diǎn)所代表的能力,不代表LLM在訓(xùn)練的過程中的目的是為了實(shí)現(xiàn)這些能力。換句話說,LLM在訓(xùn)練的時(shí)候只訓(xùn)練了對下一個(gè)可能出現(xiàn)的單詞的預(yù)測能力。

也就是說,第二類節(jié)點(diǎn)所代表的能力,是Arora和Goyal從結(jié)果的角度設(shè)計(jì)的,為的是更好的理解LLM所展現(xiàn)出來的能力。

設(shè)定講完了,兩類節(jié)點(diǎn)就要開始互相連接了,連接代表的是LLM為了讀懂某段文字需要哪些能力。可能一對一,可能一對多,也可能多對一。

還拿讀懂反諷舉例,這個(gè)技能點(diǎn)就會和所有包含反諷元素的文本建立聯(lián)系。

連接可沒那么簡單。要知道,OpenAI和DeepMind這種大公司,是不會公開訓(xùn)練數(shù)據(jù)或者測試數(shù)據(jù)的。所以兩位研究人員不能依賴這些。

此外,他倆想搞明白的還是規(guī)模和行為、能力之間的關(guān)系。

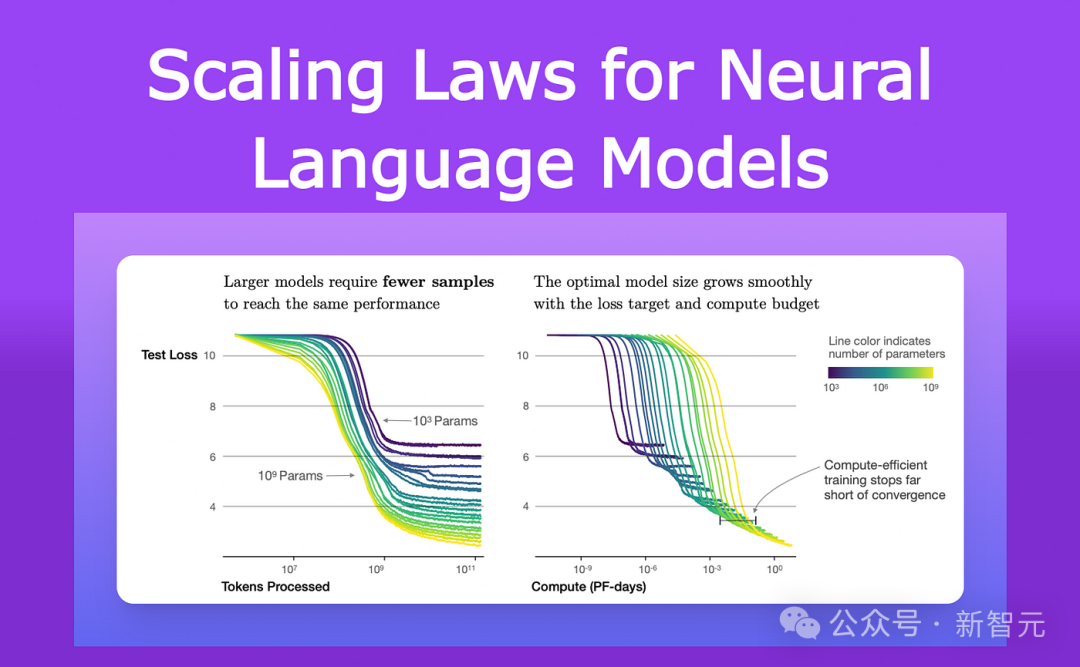

自從2021年以來,研究LLMs和其他神經(jīng)網(wǎng)絡(luò)性能的研究人員已經(jīng)觀察到了一個(gè)普遍的特征。

他們注意到,隨著模型的增大,無論是在大小還是在訓(xùn)練數(shù)據(jù)量上,它在測試數(shù)據(jù)上的損失(在訓(xùn)練后對新文本的預(yù)測與正確答案之間的差異)以一種非常特定的方式減少。

這些觀察已被編碼為一個(gè)叫做神經(jīng)縮放定律的方程。

因此,Arora和Goyal表示,他們的理論不依賴于任何單個(gè)LLM的情況、或者特定的一組訓(xùn)練和測試數(shù)據(jù),而是某種普適法則:通過縮放定律預(yù)測的損失。

而他們進(jìn)一步研究的關(guān)鍵,就是神經(jīng)縮放定律和上面介紹的二分圖之間的關(guān)系。

二分圖的借用

首先,研究人員假設(shè)存在一個(gè)對應(yīng)LLM在測試數(shù)據(jù)上行為的二分圖。

為了利用好LLM在測試數(shù)據(jù)上的損失變化,他們設(shè)想了一種如下這種方式,來描繪LLM是如何習(xí)得技能的。

還是以能理解反諷這種技能為例——

這個(gè)概念由一個(gè)技能節(jié)點(diǎn)表示,因此研究人員查看這個(gè)技能節(jié)點(diǎn)連接到了哪些文本節(jié)點(diǎn)。

如果幾乎所有這些連接的文本節(jié)點(diǎn)都成功——意味著LLM對這個(gè)特定技能所代表的文本的預(yù)測非常準(zhǔn)確——那么LLM在這個(gè)特定技能上是有能力的。

但如果超過一定比例的技能節(jié)點(diǎn)連接到失敗的文本節(jié)點(diǎn),那么LLM在這個(gè)技能上就算失敗了。

這些二分圖與LLMs之間的連接使Arora和Goyal能夠利用隨機(jī)圖理論的工具來分析LLM的行為。

研究這些圖揭示了節(jié)點(diǎn)之間的某些關(guān)系。這些關(guān)系進(jìn)而轉(zhuǎn)化為一種有邏輯,且可測試的方法,得以解釋大語言模型究竟怎么獲得一些意想不到的能力。

這里,Arora和Goyal首先解釋了一個(gè)關(guān)鍵行為——為什么較大的LLMs在個(gè)別技能上比相對較小的模型更加熟練。

他們從神經(jīng)縮放定律預(yù)測的較低測試損失開始。

如果失敗的測試節(jié)點(diǎn)較少,那么說明失敗的測試節(jié)點(diǎn)與技能節(jié)點(diǎn)之間的連接也較少。因此,更多的技能節(jié)點(diǎn)與成功的測試節(jié)點(diǎn)相連接,就表明模型在技能方面的能力增強(qiáng)。

接下來,兩位研究人員又找到了一種解釋更大模型所獲得的能力的方法——隨著LLM的大小增加和測試損失減小,技能節(jié)點(diǎn)的隨機(jī)組合開始連接到個(gè)別文本節(jié)點(diǎn)。

這表明LLM也變得更擅長同時(shí)使用多個(gè)技能,并開始使用多個(gè)技能生成文本,即使這些確切的技能組合在訓(xùn)練數(shù)據(jù)的任何文本中都沒有出現(xiàn)過。

比方說,一個(gè)LLM已經(jīng)可以使用一種技能來生成文本了,那么如果我們把LLM的參數(shù)數(shù)量或訓(xùn)練數(shù)據(jù)擴(kuò)大一個(gè)數(shù)量級,它將同樣擅長生成需要兩種技能的文本。

以此類推,再擴(kuò)大一個(gè)數(shù)量級,LLM現(xiàn)在就可以執(zhí)行需要同時(shí)具備四種技能的任務(wù)了!而且,在各項(xiàng)能力上所具有的熟練程度也是相同的。

因此,更大的LLMs有更多將技能組合在一起的方式,從而導(dǎo)向LLM自身的性能得到大幅提升。

隨著LLM的擴(kuò)大,它在訓(xùn)練數(shù)據(jù)中遇到所有這些技能組合的可能性變得越來越小,直至0。

根據(jù)隨機(jī)圖理論的規(guī)則,每種組合都來自對可能技能的隨機(jī)抽樣。因此,如果圖中存在大約一千個(gè)基本的單個(gè)技能節(jié)點(diǎn),并且假設(shè)我們想要組合四種技能,那么有大約1000的四次方——也就是足足一萬億種可能的組合方式。

也就是說,如果一個(gè)LLM真的能夠通過組合這1000種技能中的四種來執(zhí)行這些任務(wù),那么意味著該模型一定具備了泛化能力,更進(jìn)一步說,這個(gè)模型很可能就不是一個(gè)隨機(jī)鸚鵡了。

但是Arora和Goyal想要超越理論,進(jìn)一步來測試他們的觀點(diǎn)——LLMs在規(guī)模和訓(xùn)練數(shù)據(jù)增加時(shí),會更擅長組合更多的技能,因此在泛化方面表現(xiàn)得更好。

他們與團(tuán)隊(duì)其他成員一起設(shè)計(jì)了一種稱為技能混合的方法,用于評估LLM使用多種技能生成文本的能力。

為了對LLM進(jìn)行測試,研究團(tuán)隊(duì)要求它生成關(guān)于隨機(jī)選擇的主題的三個(gè)句子,這些句子的生成首先展示了LLM隨機(jī)選擇的技能點(diǎn)。

比方說,他們要求GPT-4寫一篇有關(guān)劍術(shù)的文章,然后他們再要求該模型展示來自四個(gè)領(lǐng)域的技能:自我偏見、比喻、統(tǒng)計(jì)學(xué)和物理學(xué)嘗試的掌握。

GPT-4的輸出是這樣的:

在這場與鋼鐵的舞蹈中,我的勝利(用上了比喻)像物體會自由落體一樣確定(用上了物理學(xué)嘗試)。

而作為一名著名的決斗者,我天生靈活,就像大多數(shù)人所知曉的我一樣(用上了統(tǒng)計(jì))。失敗?只可能是由于戰(zhàn)場偏向了敵人,不可能是由于我的不足(自我偏見)。

實(shí)際上的結(jié)果,正如數(shù)學(xué)所預(yù)測的那樣,GPT-4的性能遠(yuǎn)遠(yuǎn)超過了GPT-3.5。

Arora大膽猜想,會不會一年后,會有遠(yuǎn)超GPT-4的模型出現(xiàn)呢?