10倍英偉達GPU:大模型專用芯片一夜成名,來自谷歌TPU創業團隊

我們知道,大模型到 GPT-3.5 這種千億體量以后,訓練和推理的算力就不是普通創業公司所能承擔的了,人們用起來速度也會很慢。

但自本周起,這種觀念已成為歷史。

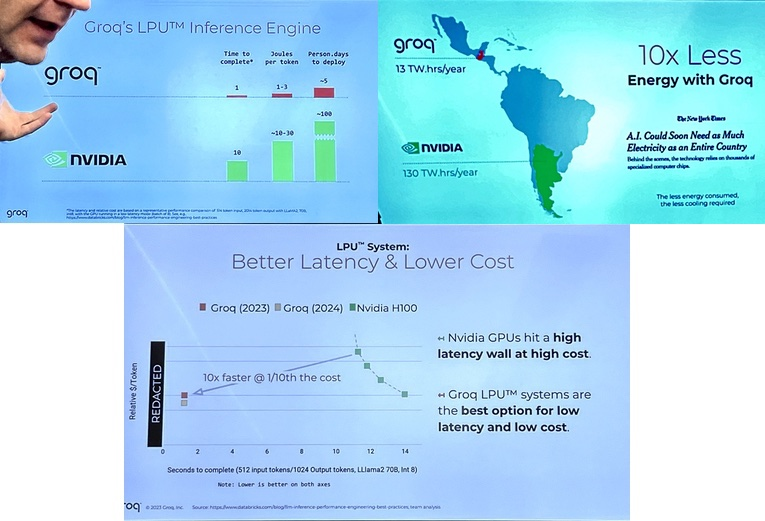

有名為 Groq 的初創公司開發出一種機器學習處理器,據稱在大語言模型任務上徹底擊敗了 GPU—— 比英偉達的 GPU 快 10 倍,而成本僅為 GPU 的 10%,只需要十分之一的電力。

這是在 Groq 上運行 Llama 2 的速度:

來源:https://twitter.com/emollick/status/1759633391098732967

這是 Groq(Llama 2)和 ChatGPT 面對同一個 prompt 的表現:

圖源:https://x.com/JayScambler/status/1759372542530261154?s=20

圖源:https://x.com/JayScambler/status/1759372542530261154?s=20

盡管看起來不可思議,但事實就是如此,感興趣的朋友不妨一試。

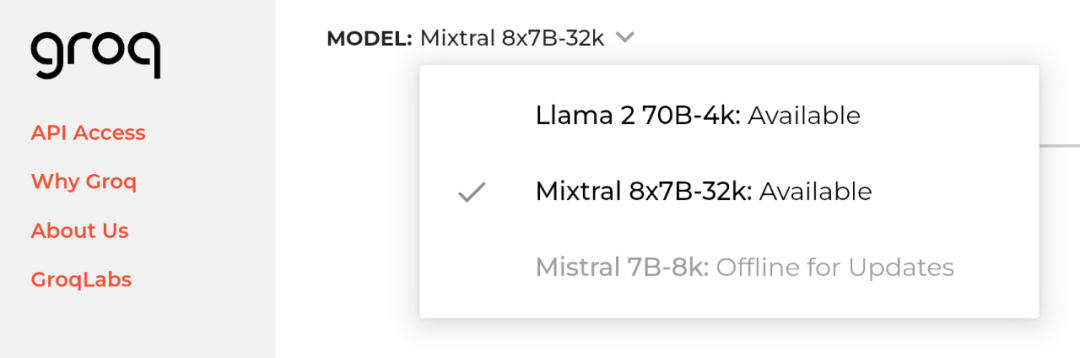

目前,Groq 的官網提供了試用體驗,有這些模型可選:

官網地址:https://groq.com/

Groq 的處理器名為 LPU(語言處理單元),是一種新型的端到端處理單元系統,可以為具備序列組件的計算密集型應用(比如 LLM)提供極快的推理速度。

它帶動的大模型速度能達到前所未有的 500 Token/s,并且實現了極低的延遲。

用硬件加速軟件,總能給人一種力大磚飛的感覺。Groq 還在 LPU 上運行了最新銳的開源模型 Mixtral,模型在不到一秒的時間內回復了包含數百個單詞的事實性的、引用的答案(其中四分之三的時間是用來搜索):

Groq 放出的 Demo 視頻下,有人評論道:這也太快了,不該這么快。

有網友因此提出建議:因為大模型生成內容的速度太快,所以從用戶體驗的角度來看不應該再自動翻頁了,因為人眼看不過來。

或許在 LPU 的加持下,生成式 AI 真的要如同 Gartner 最近預測所言:在兩年內對搜索引擎構成巨大威脅了。仔細一想也確實合理,畢竟當年神經網絡就是被 GPU 算力的發展帶飛的。

至于為什么這么快?

有人分析,GPU 專為具有數百個核心的并行處理而設計,主要用于圖形渲染,而 LPU 的架構旨在為 AI 計算提供確定性的性能。

LPU 的架構不同于 GPU 使用的 SIMD(單指令、多數據)模型,而是采用更精簡的方法,消除了對復雜調度硬件的需求。這種設計允許有效利用每個時鐘周期,確保一致的延遲和吞吐量。

能源效率是 LPU 相對于 GPU 的另一個值得注意的優勢。通過減少與管理多個線程相關的開銷并避免核心利用率不足,LPU 可以提供更多的每瓦計算量,將其定位為更環保的替代方案。

Groq 的芯片設計允許將多個 TSP 連接在一起,不會出現 GPU 集群中的傳統瓶頸,使其具有極高的可擴展性。隨著更多 LPU 的添加,這可以實現性能的線性擴展,從而簡化大規模 AI 模型的硬件要求,并使開發人員更輕松地擴展其應用程序,而無需重新架構其系統。

在 A100 和 H100 相對緊缺的時代,LPU 或許會成為大模型開發商的新選擇。

Groq 成立于 2016 年,這家公司的創始團隊出自谷歌,曾經設計了谷歌自研 AI 芯片張量處理單元 TPU 系列。據官網介紹,Groq 公司創始人、首席執行官 Jonathan Ross 曾經承擔了 TPU 的 20% 工作。

Jonathan Ross。

在去年的高性能計算會議 SC23 上,Groq 就展示過在 LPU 上運行 LLM 的全球最佳低延遲性能。當時,Groq 能夠以每秒超過 280 個 Token 的速度生成回復,刷新了 Llama-2 70B 推理的性能記錄。

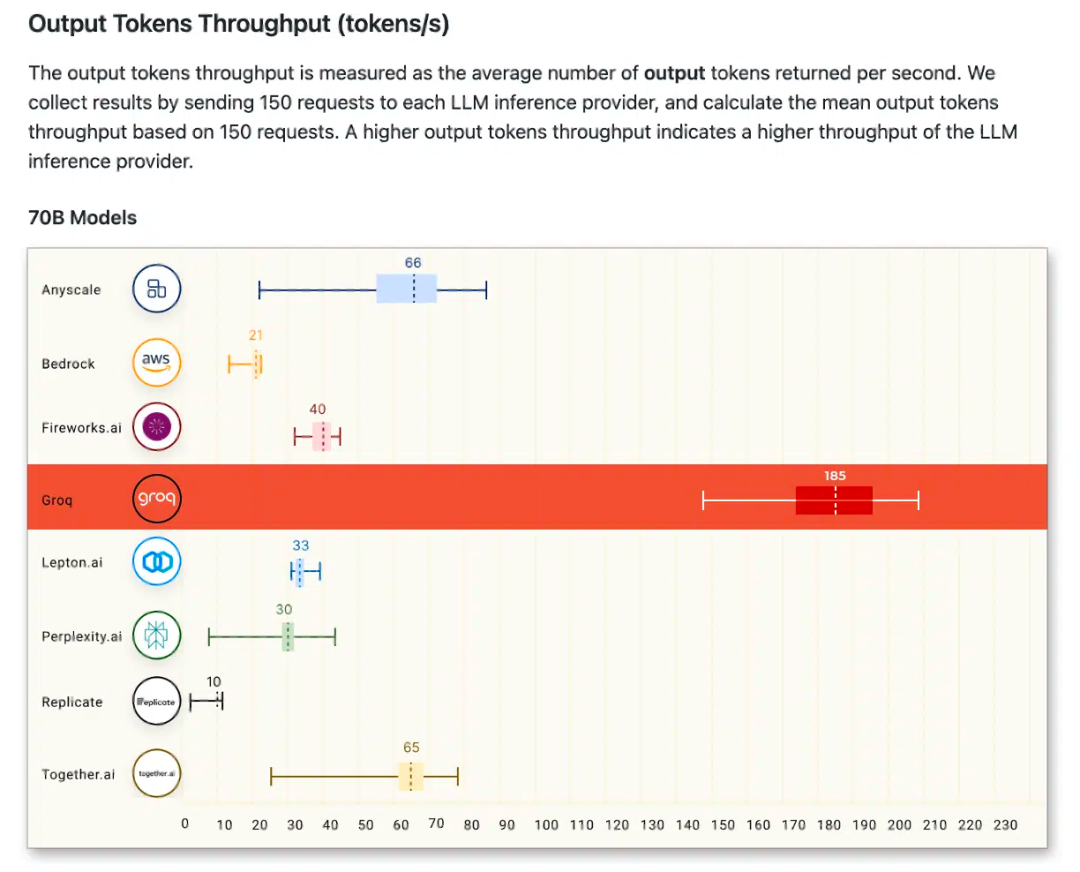

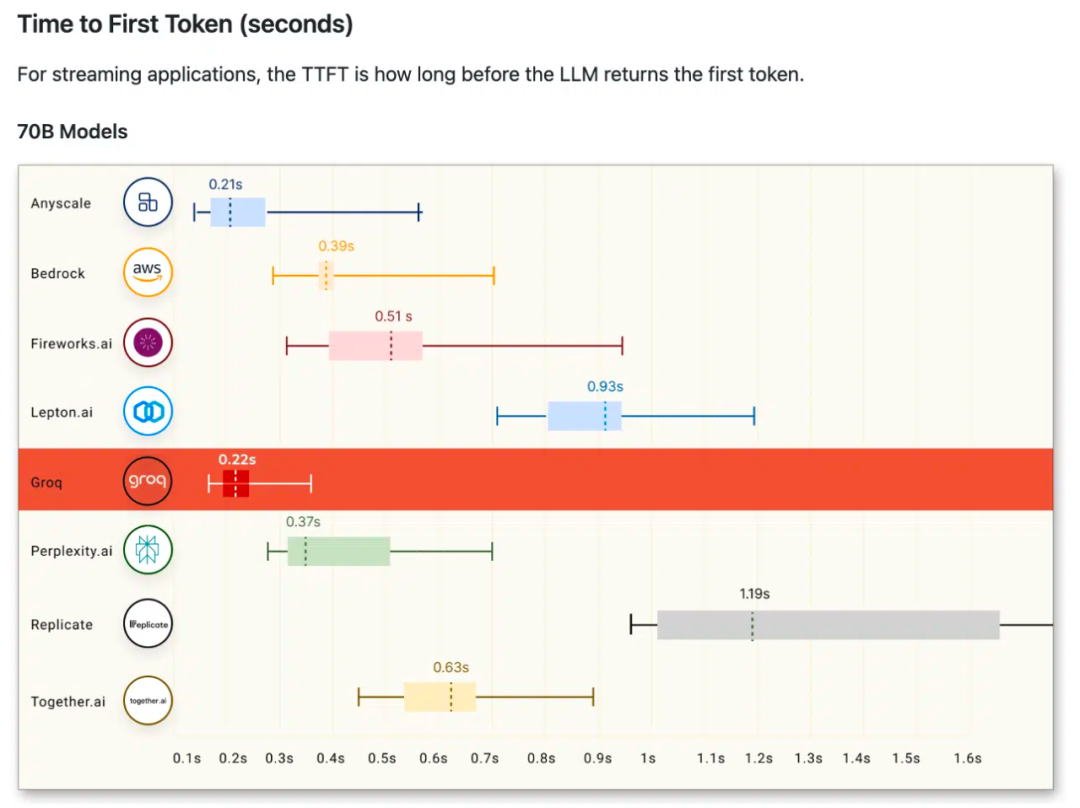

今年 1 月,Groq 首次參與公開基準測試,就在 Anyscale 的 LLMPerf 排行榜上取得了突出的成績,遠超其他基于云的推理提供商。

圖源:https://github.com/ray-project/llmperf-leaderboard?tab=readme-ov-file

圖源:https://github.com/ray-project/llmperf-leaderboard?tab=readme-ov-file

人工智能已經在科技界掀起了一場風暴。2023 年可能是世界意識到人工智能將成為現實的一年,而 2024 年則是人工智能真正成為現實而不僅僅是假設的一年。這是 Jonathan Ross 曾經表達的一個觀點。

當我們擁有 100 萬 Token 上下文的 Gemini Pro 1.5、每秒 500 Token 推理速度的 Groq、推理能力更進一步的 GPT-5,夢想還會遠嗎?