「AI透視眼」,三次馬爾獎獲得者Andrew帶隊解決任意物體遮擋補全難題

遮擋是計算機視覺很基礎但依舊未解決的問題之一,因為遮擋意味著視覺信息的缺失,而機器視覺系統卻依靠著視覺信息進行感知和理解,并且在現實世界中,物體之間的相互遮擋無處不在。牛津大學 VGG 實驗室 Andrew Zisserman 團隊最新工作系統性解決了任意物體的遮擋補全問題,并且為這一問題提出了一個新的更加精確的評估數據集。該工作受到了 MPI 大佬 Michael Black、CVPR 官方賬號、南加州大學計算機系官方賬號等在 X 平臺的點贊。以下為論文「Amodal Ground Truth and Completion in the Wild」的主要內容。

- 論文鏈接:https://arxiv.org/pdf/2312.17247.pdf

- 項目主頁:https://www.robots.ox.ac.uk/~vgg/research/amodal/

- 代碼地址:https://github.com/Championchess/Amodal-Completion-in-the-Wild

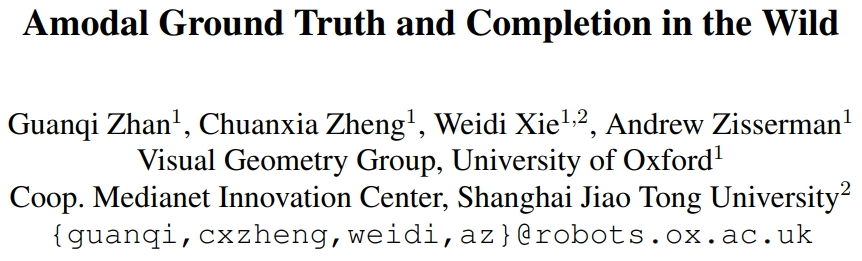

非模態分割(Amodal Segmentation)旨在補全物體被遮擋的部分,即給出物體可見部分和不可見部分的形狀掩碼。這個任務可以使得諸多下游任務受益:物體識別、目標檢測、實例分割、圖像編輯、三維重建、視頻物體分割、物體間支撐關系推理、機器人的操縱和導航,因為在這些任務中知道被遮擋物體完整的形狀會有所幫助。

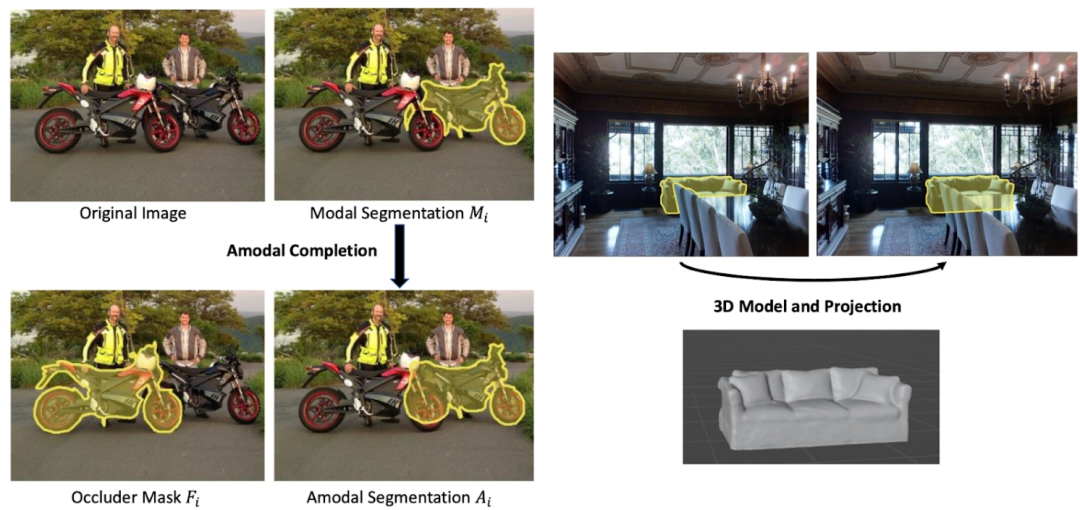

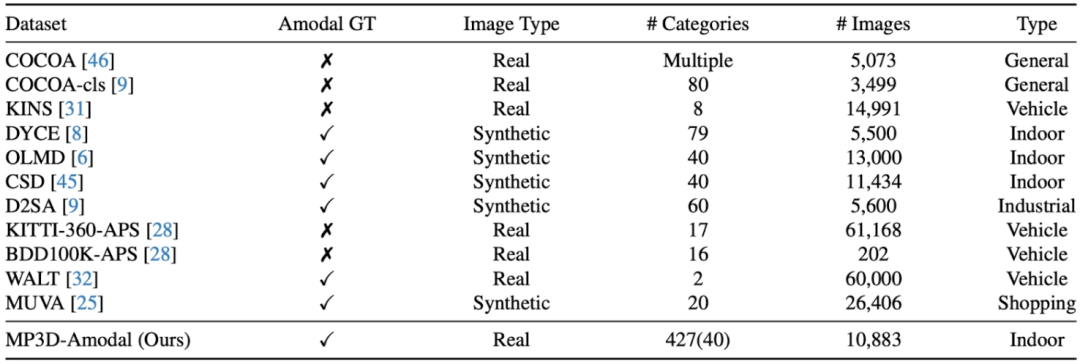

然而,如何去評估一個模型在真實世界做非模態分割的性能卻是一個難題:雖然很多圖片中都有大量的被遮擋物體,可是如何得到這些物體完整形狀的參考標準 或是非模態掩碼呢?前人的工作有通過人手動標注非模態掩碼的,可是這樣標注的參考標準難以避免引入人類誤差;也有工作通過制造合成數據集,比如在一個完整的物體上貼直接另一個物體,來得到被遮擋物體的完整形狀,但這樣得到的圖片都不是真實圖片場景。因此,這個工作提出了通過 3D 模型投影的方法,構造了一個大規模的涵蓋多物體種類并且提供非模態掩碼的真實圖片數據集(MP3D-Amodal)來精確評估非模態分割的性能。各不同數據集的對比如下圖:

具體而言,以 MatterPort3D 數據集為例,對于任意的有真實照片并且有場景三維結構的數據集,我們可以將場景中所有物體的三維形狀同時投影到相機上以得到每個物體的模態掩碼(可見形狀,因為物體相互之間有遮擋),然后將場景中每個物體的三維形狀分別投影到相機以得到這個物體的非模態掩碼,即完整的形狀。通過對比模態掩碼和非模態掩碼,即可以挑選出被遮擋的物體。

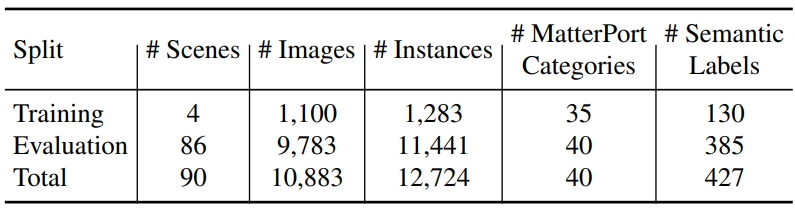

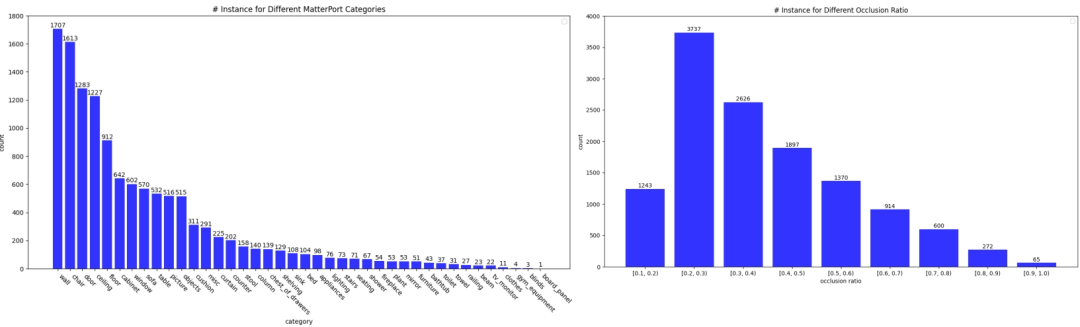

數據集的統計數據如下:

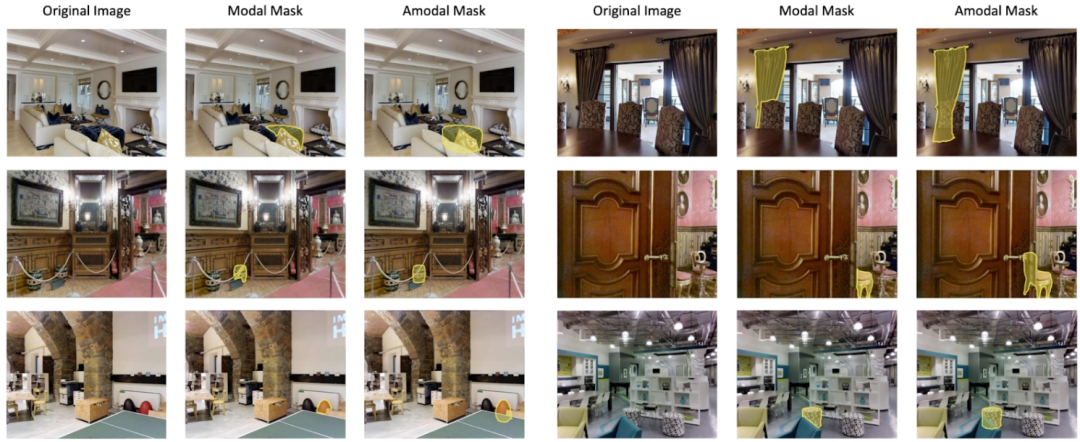

數據集的樣例如下:

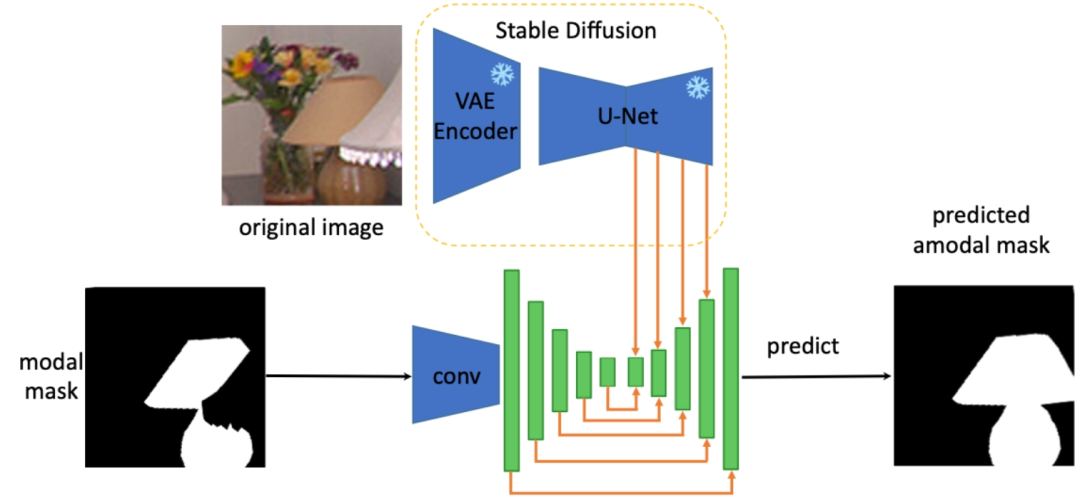

此外,為解決任意物體的完整形狀重建任務,作者提取出 Stable Diffusion 模型的特征中關于物體完整形狀的先驗知識,來對任意被遮擋物體做非模態分割,具體的架構如下(SDAmodal):

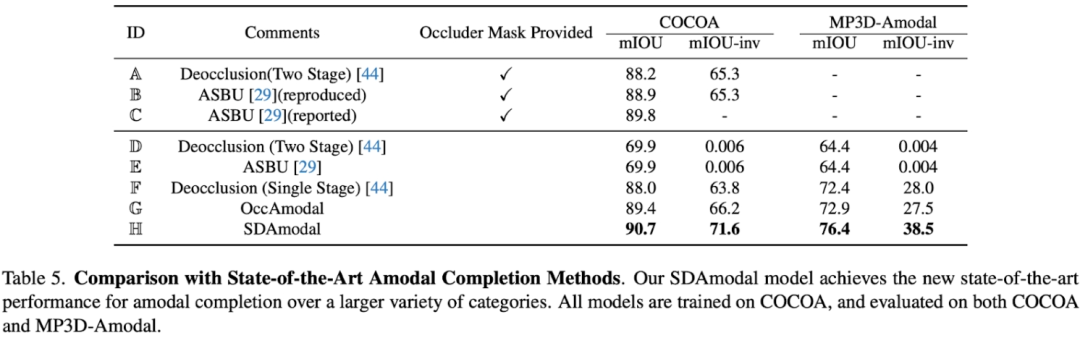

提出使用 Stable Diffusion Feature 的動機在于,Stable Diffusion 具有圖片補全的能力,所以可能一定程度上包含了有關物體的全部信息;而且由于 Stable Diffusion 經過大量圖片的訓練,所以可以期待其特征在任意環境下有對任意物體的處理能力。和前人 two-stage 的框架不同,SDAmodal 不需要已經標注好的遮擋物掩碼作為輸入;SDAmodal 架構簡單,卻體現出很強的零樣本泛化能力(比較下表 Setting F 和 H,僅在 COCOA 上訓練,卻能在另一個不同域、不同類別的數據集上有所提升);即使沒有關于遮擋物的標注,SDAmodal 在目前已有的涵蓋多種類被遮擋物體的數據集 COCOA 以及新提出的 MP3D-Amodal 數據集上,都取得了SOTA表現(Setting H)。

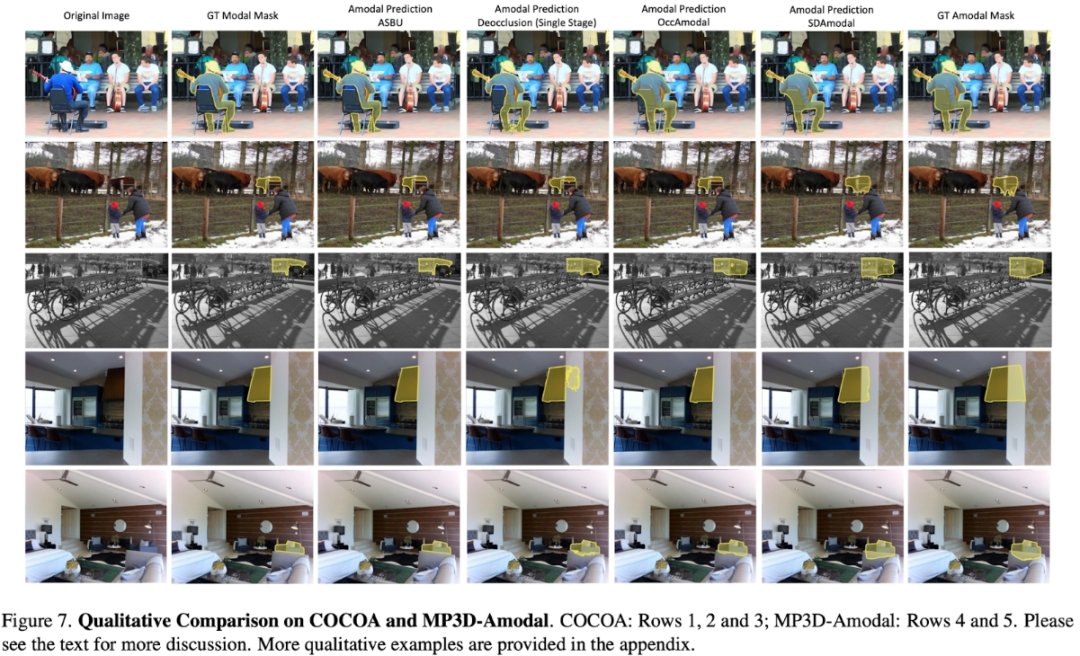

除了定量實驗,定性的比較也體現出了 SDAmodal 模型的優勢:從下圖可以觀察到(所有模型都只在 COCOA 上訓練),對于不同種類的被遮擋物體,無論是來自于 COCOA,還是來自于另一個MP3D-Amodal,SDAmodal 都能大大提升非模態分割的效果,所預測的非模態掩碼更加接近真實的。

更多細節,請閱讀論文原文。