馬斯克大模型Grok1.5來了:推理能力大升級,支持128k上下文

Grok 1 開源才剛有 10 天,Grok 1.5 就來了。

本周五早上,馬斯克旗下的人工智能公司 xAI 正式推出了 Gork 大模型的最新版本 Grok-1.5。新一代模型實現了長上下文理解和高級推理能力,計劃將在未來幾天內向早期測試人員和 X 平臺(前 Twitter)上的現有 Grok 用戶提供。

上周一,馬斯克剛剛開源了 3140 億參數的混合專家(MoE)模型 Grok-1。通過開源 Grok-1 的模型權重和網絡架構,Gork 項目已展示了 xAI 截至去年 11 月所取得的進展。在最新模型 Grok-1.5 中,Gork 又有了進一步提高。

能力與推理

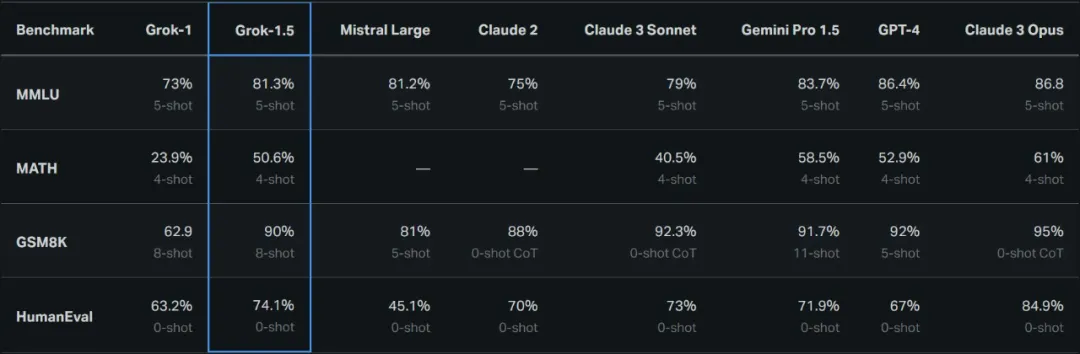

Grok-1.5 最明顯的改進之一是其在代碼和數學相關任務中的性能。在 xAI 的測試中,Grok-1.5 在 MATH 基準上取得了 50.6% 的成績,在 GSM8K 基準上取得了 90% 的成績,這兩個數學基準涵蓋了廣泛的小學到高中的競賽問題。

此外,它在評估代碼生成和解決問題能力的 HumanEval 基準測試中得分為 74.1%。

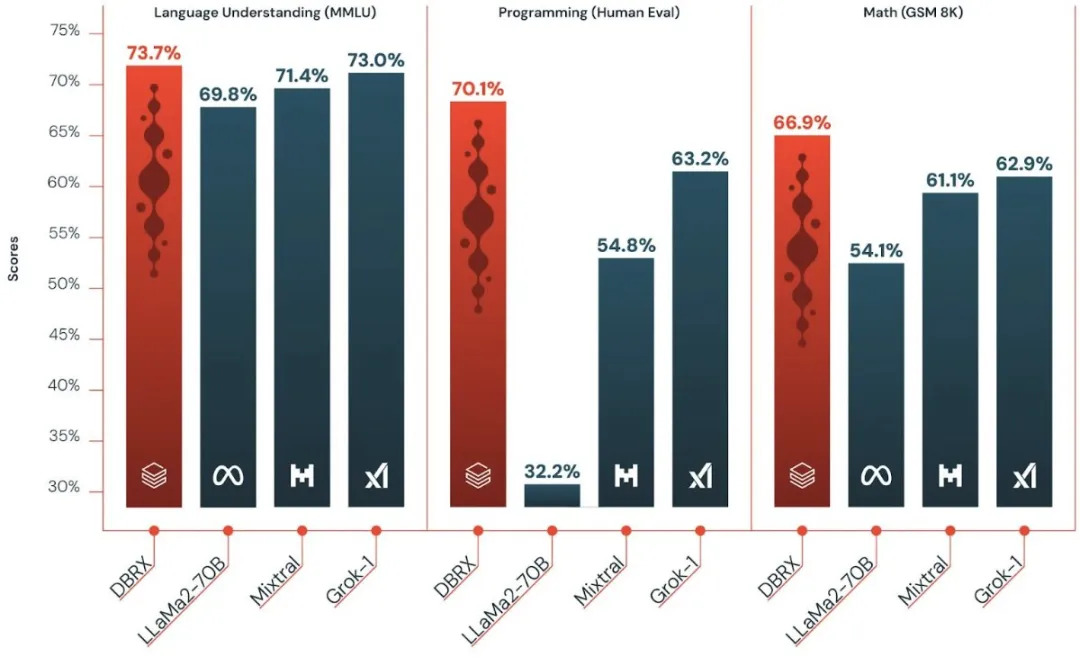

還記得昨天 Databricks 開源的通用大模型 DBRX 嗎?當時的對比圖表如下所示,看起來新版本 Grok 的提升是顯著的。

就是不知這個大幅升級的 1.5 版會在什么時候開源?

長上下文理解

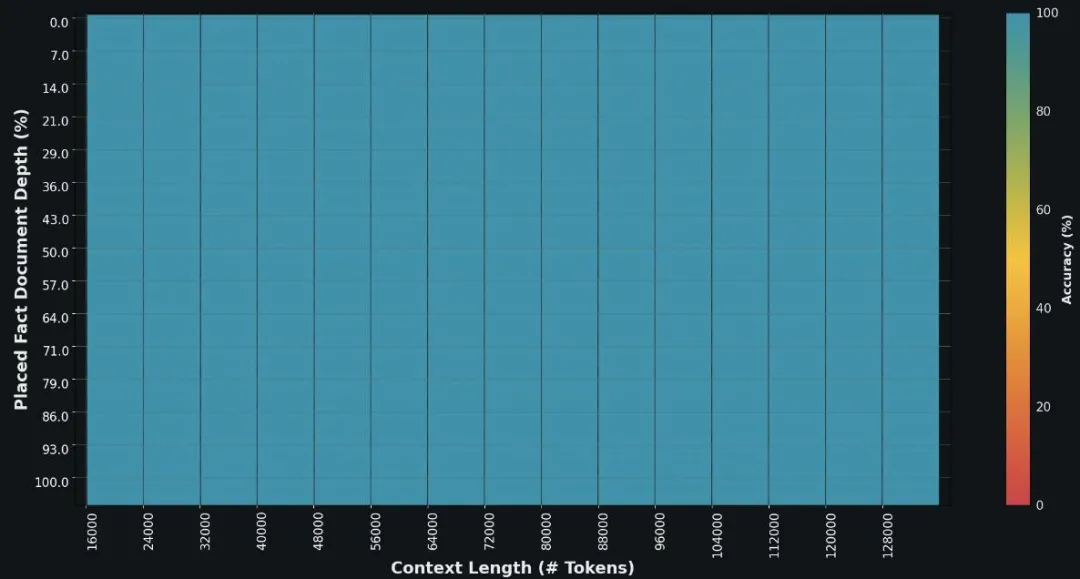

Grok-1.5 中的另一個重要升級是在其上下文窗口內可以處理多達 128K token 的長上下文。這使得 Grok 的容量增加到之前上下文長度的 16 倍,從而能夠利用更長文檔中的信息。

此外,該模型可以處理更長、更復雜的提示(prompt),同時在上下文窗口擴展時仍然能保持其指令跟蹤能力。在大海撈針(NIAH)評估中,Grok-1.5 展示了強大的檢索能力,可以在長度高達 128K token 的上下文中嵌入文本,實現完美的檢索結果。

訓練 Grok-1.5 的基礎設施

xAI 進一步介紹了用于訓練模型的算力設施。在大規模 GPU 集群上運行的先進大型語言模型(LLM)研究需要強大而靈活的基礎設施。Grok-1.5 構建在基于 JAX、Rust 和 Kubernetes 的自定義分布式訓練框架之上。該訓練堆棧允許開發團隊能夠以最小的精力構建想法原型并大規模訓練新架構。

在大型計算集群上訓練 LLM 的主要挑戰是最大限度提高訓練作業的可靠性和正常運行時間。xAI 提出的自定義訓練協調器可確保自動檢測到有問題的節點,并將其從訓練作業中剔除。工程師還優化了檢查點、數據加載和訓練作業重新啟動等問題,以最大限度地減少發生故障時的停機時間。

展望

為了尋求替代微軟支持的 OpenAI 和 Google 大模型的解決方案,馬斯克去年推推動了 AI 創業公司 xAI,以創建他所說的「最大程度尋求真相的人工智能」 。去年 12 月,這家初創公司為 X 的 Premium+ 訂閱者推出了 Grok。

xAI 表示,Grok-1.5 很快就會向早期測試者開放,其團隊將繼續改進 Grok。隨著新版本推向公眾,在未來幾天 X 上的大模型將陸續推出一些新功能。