EMNLP 2023|利用LLM合成數據訓練模型有哪些坑?

大家好,我是HxShine

今天我們將介紹EMNLP2023的一篇大模型(LLMs)生成文本分類任務合成數據的文章,標題是《Synthetic Data Generation with Large Language Models for Text Classification: Potential and Limitations》。

實際落地中,高質量訓練數據的收集和篩選既耗費時間又成本昂貴,研究人員探索使用LLMs生成合成數據作為替代方法。然而,LLMs生成的合成數據在支持不同文本分類任務的模型訓練上效果有好有差。本文試圖分析不同因素如何影響LLMs生成合成數據的有效性。

這篇論文研究了大型語言模型(LLMs)生成合成數據集用于文本分類模型訓練的潛力和限制。 分析發現,任務的主觀性(標注一致性越差)越高,利用合成數據來訓練模型效果也越差。另外合成數據效果好不好的關鍵影響因素在于生成數據的多樣性如何,few-shot方式可以提高生成樣本的多樣性,通過few-shot方式生成的樣本效果也一般優于zero-shot的樣本。

? Title: Synthetic Data Generation with Large Language Models for Text Classification: Potential and Limitations

? Url: https://arxiv.org/abs/2310.07849

? Authors: Zhuoyan Li, Hangxiao Zhu, Zhuoran Lu, Ming Yin

1 Motivation

? 利用LLM生成訓練數據(例如文本分類數據)是否有效?效果的影響因素有哪些?

? 這項研究旨在探討大型語言模型生成合成數據對文本分類模型訓練的有效性及其在不同任務中的表現差異性。

? 作者們尤其關注分類任務的主觀性如何影響基于合成數據訓練的模型的性能。

背景:研究者最近探索了使用大型語言模型(LLMs)生成合成數據集作為一種替代方法。然而在不同的分類任務中,LLM生成的合成數據在支持模型訓練方面的有效性并不一致。

2 Methods

方法:論文通過采用兩種數據生成策略,10個文本分類任務數據集,利用BERT和RoBERTa作為基座模型,在多個角度對生成的數據進行了分析,從而推導出關于LLMs在合成數據生成中的潛力和局限性,最后通過對比分析得到了合成數據在模型訓練中的表現與任務和實例的主觀性負相關(標注一致性越低、主觀性越高)的結論。

實驗和評估方法總結:

實驗方法:

1. 數據生成:

? 零樣本(Zero-shot):在沒有真實世界數據的情況下,使用LLM直接生成文本實例。這涉及到構建上下文提示來設定生成環境,然后提供數據生成提示來指導LLM生成具有特定標簽的文本。

? 少樣本(Few-shot):在有少量真實世界數據的情況下,這些數據作為例子指導LLM生成新的文本實例。這種方法旨在讓LLM學習真實數據的模式,并在此基礎上生成合成數據。

2. 數據集選擇:選擇了10個不同的文本分類任務數據集,這些數據集涵蓋了從低到高不同程度的主觀性,以便研究主觀性對模型性能的影響。

3. 模型訓練:使用BERT和RoBERTa預訓練模型作為編碼器,訓練分類模型。訓練過程中,分別使用真實世界數據、零樣本合成數據和少樣本合成數據。

評估方法:

1. 性能指標:評估模型性能的主要指標是Macro-F1分數和準確率(Accuracy Score)。這些指標用于衡量模型在測試集上的表現,并與金標準標簽進行比較。

2. 主觀性評估:通過眾包研究收集任務和實例級的主觀性判斷。任務主觀性通過比較任務對的客觀性來確定,而實例級主觀性則通過標注人員對文本實例標簽的一致性來衡量(標注一致性)。

3. 數據多樣性分析:使用Remote Clique Score和Chamfer Distance Score來量化數據集的多樣性,以探索模型性能差異的潛在原因。

4. 實例級性能分析:研究了模型在不同主觀性水平的任務實例上的性能差異,即通過改變實例級標注人員一致性閾值來觀察模型準確率的變化。

5. 實驗重復性:為了確保結果的穩健性,所有實驗都進行了多次重復,并報告了平均性能。

3 Conclusion

? 研究結果表明,分類任務的主觀性越大(標注一致性也越差),使用LLM生成合成數據訓練的模型的效果越差,這在任務級別和實例級別都得到了印證。

圖片

圖片

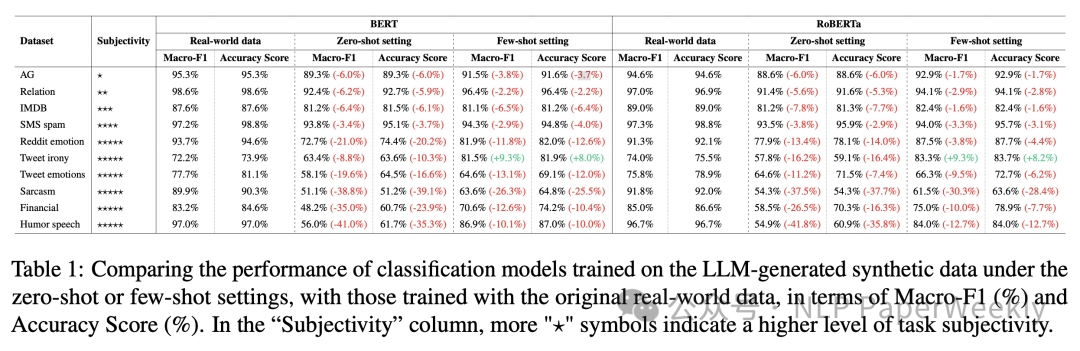

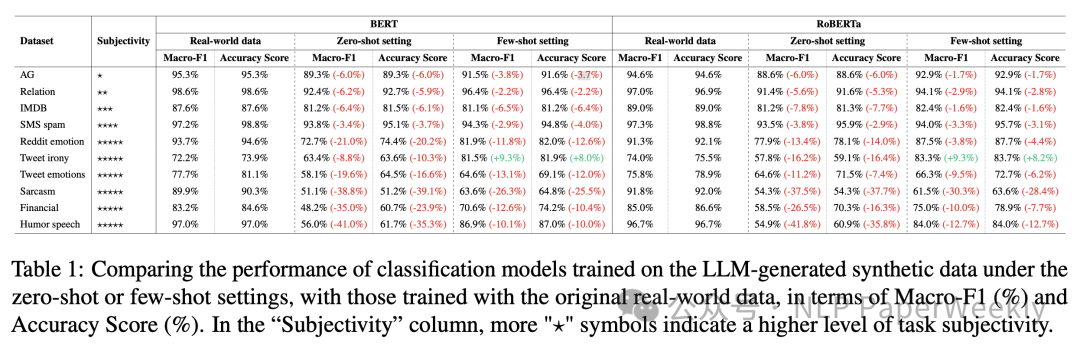

Table 1: Comparing the performance of classification models trained on the LLM-generated synthetic data

二、詳細內容

1 詳細實驗方案設置

本文的實驗設置主要圍繞使用大型語言模型(LLMs)生成合成數據以支持文本分類模型的訓練。探討了LLM生成的合成數據在不同分類任務中的有效性,并特別關注了任務的主觀性如何影響模型性能。以下是實驗的主要設置:

1. 數據生成設置:

? 零樣本(Zero-shot):在這種設置下,假設沒有真實世界的數據(即“文本-標簽對”)存在。研究者們構建了兩個連續的提示(prompts),直接提供給預訓練的大型語言模型(如GPT-3.5-Turbo),以生成特定風格的文本和標簽。

? 少樣本(Few-shot):在這種設置下,假設有少量真實世界數據可用于文本分類任務。這些數據點作為例子,指導LLM生成合成數據。在生成文本之前,每次都會提供幾個隨機抽樣的真實世界數據實例(包括文本和標簽)作為例子。

2. 任務和數據集:

? 實驗涵蓋了10種代表性的數據集,覆蓋了各種文本分類任務,如新聞分類、電影評論情感分析、短信垃圾郵件過濾等。這些數據集被選中是為了涵蓋廣泛的任務主觀性。

? 對于每個任務,研究者們使用預訓練的BERT和RoBERTa模型作為編碼器,并使用這些模型最后一層的表示嵌入作為分類模型的輸入。

3. 模型訓練和評估:

? 在零樣本和少樣本設置下,分別生成了3000個合成數據,用于訓練分類模型。

? 三類數據訓練的模型進行對比:使用真實世界數據訓練的模型、零樣本設置下生成的合成數據訓練的模型以及少樣本設置下生成的合成數據訓練的模型進行比較。

? 模型性能通過Macro-F1和準確率(Accuracy)分數來評估,并與測試集中的金標準標簽進行比較。

4. 主觀性評估:

? 為了確定不同文本分類任務的主觀性水平,利用眾包收集了人群對任務主觀性的判斷。

? 通過比較任務之間的主觀性,構建了一個有向圖,并應用拓撲排序算法來獲得任務主觀性的線性排序。

5. 數據多樣性分析:

? 為了探索模型性能差異的潛在原因,研究者們對訓練數據的多樣性進行了探索性分析,使用了遠程小團體得分(Remote Clique Score)和Chamfer距離得分(Chamfer Distance Score)來量化數據集的多樣性。

6. 實例級主觀性評估:

? 對于每個任務,研究者們還探討了任務實例的主觀性如何影響模型性能。通過眾包研究收集了實例級注釋,并計算了每個任務實例的主觀性水平。

2 實驗結論

圖片

圖片

Table 1: Comparing the performance of classification models trained on the LLM-generated synthetic data

1. 數據集和任務:表中列出了10個不同的文本分類任務,包括AG新聞、IMDB評論、短信垃圾郵件、金融短語庫、Reddit情緒、推特諷刺、推特情緒、諷刺新聞、幽默演講等。

2. 任務主觀性:表中通過星號(?)的數量來表示任務的主觀性水平,星號越多表示任務越主觀。

3. 模型性能:對于每個任務,表中展示了使用BERT和RoBERTa模型在真實世界數據、零樣本設置下的合成數據和少樣本設置下的合成數據上訓練的模型的性能。

4. 性能比較:表中的數據展示了在不同數據集上,使用合成數據訓練的模型與使用真實世界數據訓練的模型之間的性能差異。性能差異以百分比形式表示,負值表示合成數據訓練的模型性能低于真實數據訓練的模型。

5. 主要結論:

? 使用真實世界數據訓練的模型在幾乎所有任務上都優于使用合成數據訓練的模型,無論是零樣本還是少樣本設置。

? 在少樣本設置下,模型的性能通常優于零樣本設置,這表明使用真實世界數據作為例子可以提高合成數據的有效性。

? 對于主觀性較低的任務(如新聞分類、關系分類、IMDB評論和短信垃圾郵件),合成數據訓練的模型與真實數據訓練的模型之間的性能差異相對較小。

? 對于主觀性較高的任務(如幽默或諷刺檢測),使用合成數據訓練的模型性能下降更為顯著。

這些結論表明,任務的主觀性是影響LLM生成合成數據有效性的一個重要因素。對于高度主觀的任務,LLM生成的合成數據可能不足以支持有效的模型訓練。

3 真實數據與合成數據的多樣性分析

圖片

圖片

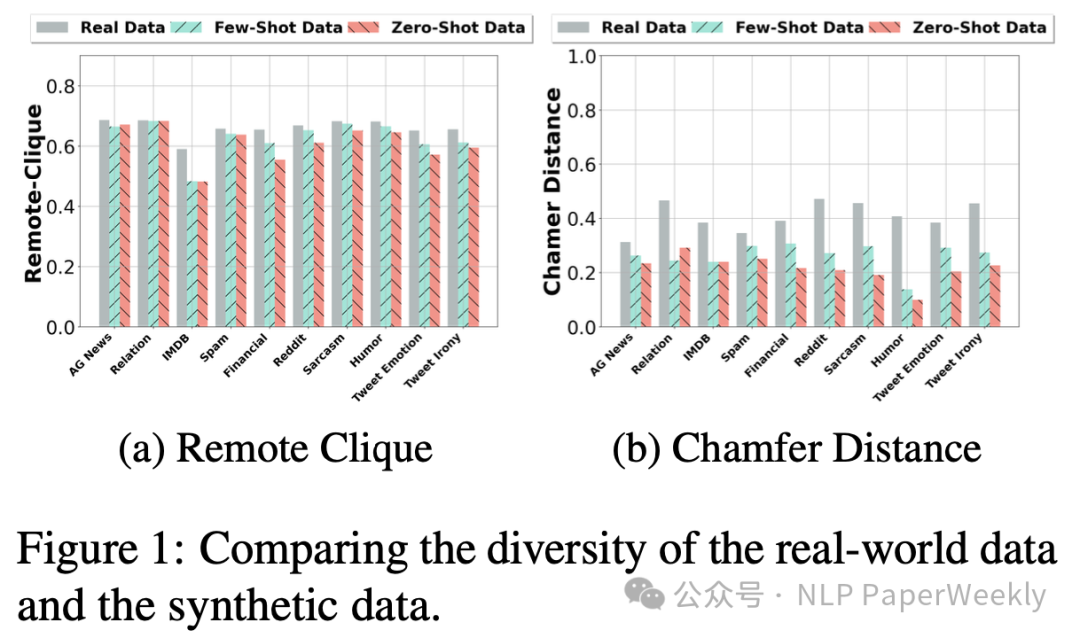

Figure 1 在文檔中提供了關于真實世界數據與LLM生成的合成數據多樣性的比較。這個比較是通過兩個指標來量化的:Remote Clique Score(遠程小團體得分)和Chamfer Distance Score(Chamfer距離得分)。這兩個指標用于衡量數據集中實例之間的多樣性,其中較高的值表示更大的數據多樣性。

Remote Clique Score 是數據實例到其他實例的平均平均距離,而 Chamfer Distance Score 是數據實例到其他實例的平均最小距離。在這兩個指標中,較高的值意味著數據實例之間的差異更大,即數據集的多樣性更高。

Figure 1 結論:

1. 數據多樣性:真實世界數據通常比少樣本設置下生成的合成數據更具多樣性,而少樣本合成數據又比零樣本設置下生成的合成數據更具多樣性。

2. 任務主觀性與數據多樣性:在高主觀性任務(如幽默檢測、諷刺檢測等)中,真實世界數據與合成數據之間的多樣性差異更為顯著,特別是在Chamfer Distance Score上。這表明對于需要理解復雜人類情感和語境的任務,LLM可能無法生成能夠覆蓋真實生活場景全貌的數據實例。

3. 模型性能與數據多樣性:數據多樣性的差異可能部分解釋了為什么在真實世界數據和少樣本合成數據上訓練的模型通常優于在零樣本合成數據上訓練的模型。多樣性更高的數據集可能有助于模型學習到更廣泛的特征和模式,從而提高模型的泛化能力。

4 不同文本分類任務實例級主觀性的量化評估

圖片

圖片

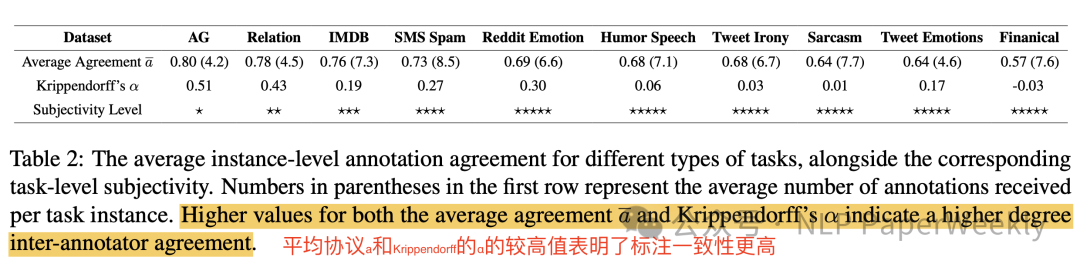

Table 2: The average instance-level annotation agreement for different types of tasks

Table 2 在文檔中提供了不同文本分類任務實例級主觀性的量化評估,以及這些任務的平均標注人員的一致性。這些數據有助于理解任務實例的主觀性如何影響模型在這些實例上的性能。表中包含以下內容和結論:

1. 任務實例級主觀性:表中列出了不同文本分類任務,如AG新聞、關系分類、IMDB評論等,并提供了每個任務實例的平均標注人員的一致性(平均同意度 a)和Krippendorff’s α(一種衡量標注人員間一致性的統計量)。

2. 標注人員的一致性:平均同意度 a 和 Krippendorff’s α 的值越高,表示標注人員在給定任務實例的標簽上達成一致的可能性越大,即任務實例的主觀性較低。

3. 任務主觀性水平:表中還提供了任務的主觀性水平,用星號(?)的數量表示。星號越多,表示任務的主觀性越高。

4. 主要結論:

? 任務實例的平均標注人員的一致性與Krippendorff’s α值緊密相關,這表明平均同意度 a(標注一致性) 可以作為任務實例主觀性的合理代理。

? 對于主觀性較高的任務,如幽默檢測和諷刺檢測,標注人員在標簽上的一致性較低,這可能意味著這些任務的實例更具主觀性,從而對模型訓練構成挑戰。

? 在同一類型的任務中,模型在主觀性較低的任務實例上(即標注人員在這些實例上達成較高一致性的實例)通常表現更好。

這些結論強調了任務實例的主觀性對模型性能的影響,特別是在使用LLM生成的合成數據進行訓練時。對于高度主觀的任務實例,即使是在少樣本設置下,模型的性能也可能受到限制,因為這些實例可能難以通過合成數據得到充分的表示。

5 準確率隨標注一致性的變化情況

圖片

圖片

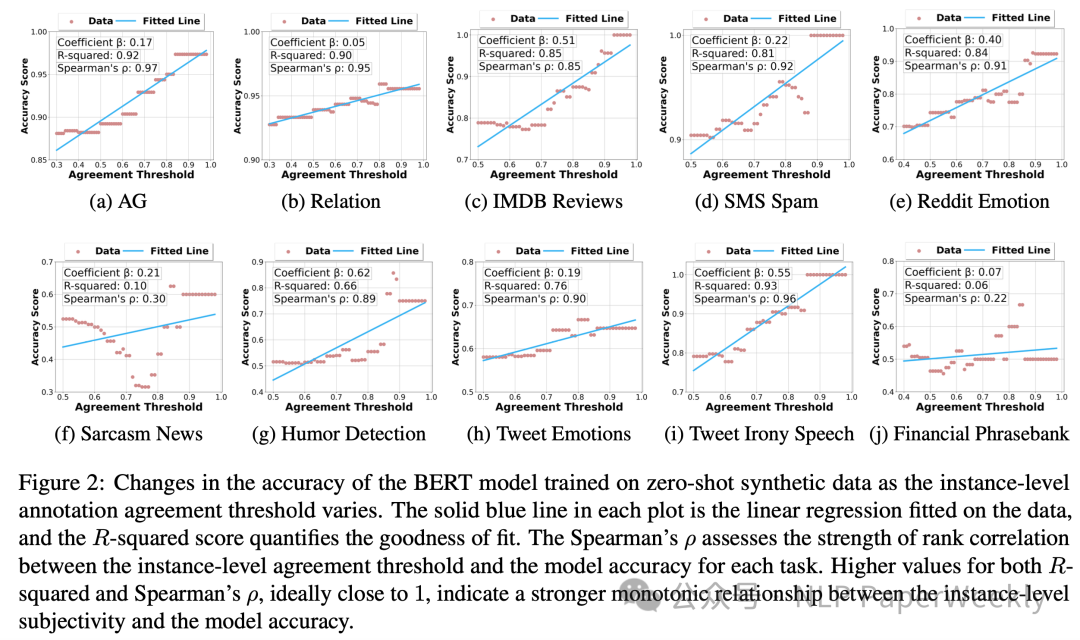

Figure 2: Changes in the accuracy of the BERT model trained on zero-shot synthetic data as the instance-level annotation agreement threshold varies

Figure 2 在文檔中展示了BERT模型在零樣本合成數據上訓練時,模型準確率隨著實例級標注人員一致性閾值(γ)變化的情況。

1. 模型準確率與實例級標注人員一致性:對于大多數任務(除了Sarcasm News和Financial Phrasebank數據集),模型準確率與實例級標注人員一致性閾值之間存在強烈的單調遞增關系。這意味著隨著閾值的增加(即過濾掉更多主觀性較高的任務實例),模型的準確率通常會提高。

2. 相關性和擬合度:每個子圖中的實線表示數據的線性回歸擬合,R-squared分數量化了擬合的好壞。Spearman’s ρ評估了實例級標注人員一致性閾值與模型準確率之間的排名相關性的強度。理想情況下,R-squared和Spearman’s ρ的值接近1,表明實例級主觀性與模型準確率之間存在強烈的單調關系。

3. 主要結論:

? 對于大多數任務,模型在主觀性較低的任務實例上表現更好。

? 這種趨勢在真實世界數據訓練的模型中也存在,但通常比合成數據訓練的模型表現得要弱。這可能意味著合成數據可能無法完全捕捉到真實世界數據的復雜性和多樣性。

三、總結

這篇論文討論了利用LLM生成合成數據帶來的潛力以及其在文本分類任務應用中的局限性。研究表明,當涉及到主觀性較高的任務時,合成數據可能不足以支持高性能模型的訓練。這項工作對于那些正在利用或計劃使用LLM生成數據的研究人員來說非常重要,它提供了對合成數據有效性的深入理解,并指導了未來可能需要采取的方向和改進。

結論:

? 對于低主觀性任務(標注一致性好),LLM生成的合成數據可以有效地支持模型訓練。

? 對于高主觀性任務(標注一致性差),合成數據可能不足以支持有效的模型訓練。

? 合成數據效果不好的關鍵影響因素在于多樣性比真實數據差,few-shot方式可以提高生成樣本的多樣性。

? 任務主觀性與眾包標注人員的一致性強相關,標注一致性 可以作為任務實例主觀性的合理表示。

本文轉載自微信公眾號「NLP PaperWeekly」,可以通過以下二維碼關注。轉載本文請聯系NLP PaperWeekly公眾號。