編輯 | 伊風、諾亞

出品 | 51CTO技術棧(微信號:blog51cto)

Meta麾下“羊駝”一路狂奔在開源的大道上。

在過去的一年里,Llama系列可以說開辟了開源LLM的半壁江山。

嫌棄開源模型能力只有GPT-3.5,不夠用?

如今Llama 3發布,又是一石激起千層浪。粗看其基礎benchmark,足以讓國內外一眾大模型公司瑟瑟發抖。借用一句業內人士的話,“性能上來說感覺就是GPT-3.7的水平。一己之力急速拉高了開源水位”。

首先從數據層面看,Llama 3 在15T tokens上進行了訓練,踐行了又一次堪稱恐怖的大力出奇跡;再者從訓練資源方面看,2.4萬卡集群訓練的部署也足以展示Meta的志在必得。

Llama 3讓Meta重奪開源大模型的王位,且其性能無限接近甚至超過OpenAI GPT、Gemini和Claude等閉源大模型。

難怪Meta有底氣放言,就各自的參數數量而言,經過兩個定制的24000 GPU集群訓練的Llama 3 8B和Llama 3 70B是目前可用的性能最佳的生成式AI模型之一。

更加勁爆的是。扎克伯格在最新訪談中透露,Llama3的三個版本中,是80億參數、700億參數的模型開源了,而超過 4000 億個模型還在加緊訓練的路上……

圖片

圖片

有網友在訪談下調侃道,難怪扎克伯格看起來如此“人性化”,肯定是偷偷運行Llama 3了!

圖片

圖片

讓小扎都更加AGI的Llama 3,究竟為何能這么牛呢,不妨來一起看看其細節!

一、性能 PK,刺刀見紅:Llama3恐怖如斯

Meta力大磚飛確實有奇效!扎克伯格說,Llama3 80億的模型幾乎與此前發布的最大版本的Llama2(參數700億)一樣強大。

眾所周知,諸如MMLU(旨在衡量知識)、ARC(試圖衡量技能習得)和DROP(測試模型對文本片段的理解能力)等流行AI基準測試的有效性和實用性尚存爭議。但無論好壞,它們仍是AI玩家評估其模型的少數標準化手段之一。

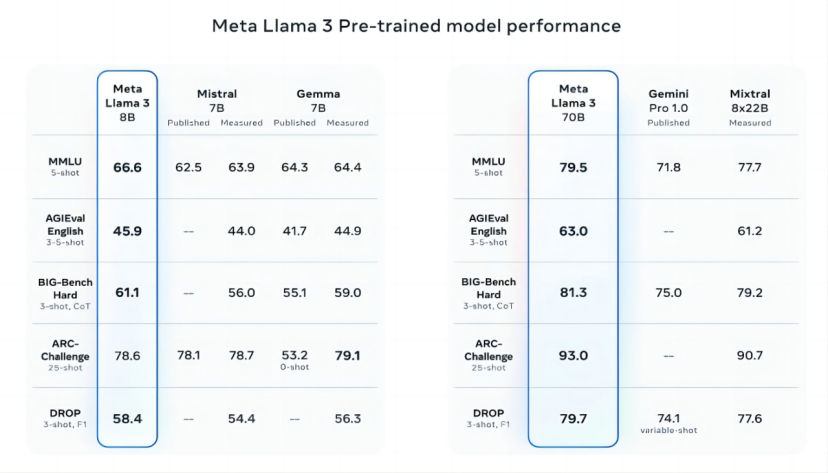

Llama 3 8B在至少九項基準測試中超越了其他開源模型,如Mistral的Mistral 7B和Google的Gemma 7B:MMLU、ARC、DROP、GPQA(一組涉及生物、物理和化學的問題)、HumanEval(一項代碼生成測試)、GSM-8K(數學應用題)、MATH(另一項數學基準)、AGIEval(問題解決測試集)以及BIGbench Hard(常識推理評估)。

誠然,Mistral 7B和Gemma 7B并非處于最前沿(Mistral 7B于去年9月發布),并且在Meta引用的幾項基準中,Llama 3 8B僅比二者高出幾個百分點。但Meta聲稱,參數數量更大的Llama 3 70B模型,可與包括Google Gemini系列最新款Gemini 1.5 Pro在內的旗艦級生成式AI模型相媲美。

圖片

圖片

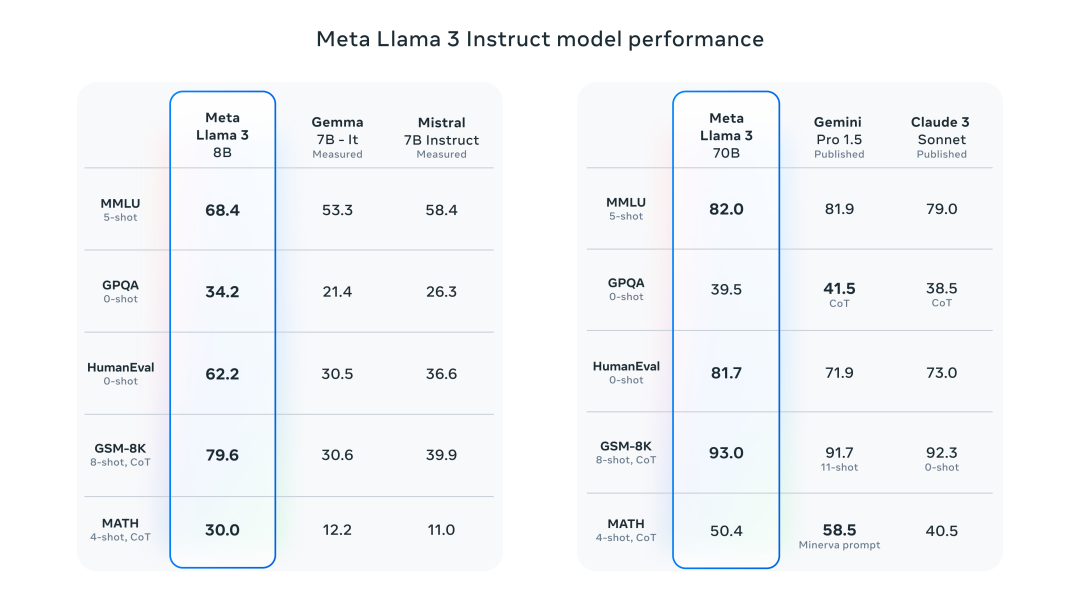

Instruct-tuned模型與Gemma、Mistral、Gemini Pro 1.5、Claude 3 Sonnet在MMLU、GSM-8k等benchmark上的對比如下:

圖片

圖片

Llama 3 70B在MMLU、HumanEval和GSM-8K三項測試中勝過Gemini 1.5 Pro。盡管它無法與Anthropic表現最為強勁的模型Claude 3 Opus匹敵,但在五個基準(MMLU、GPQA、HumanEval、GSM-8K及MATH)上,Llama 3 70B的成績優于Claude 3系列中第二弱的模型Claude 3 Sonnet。

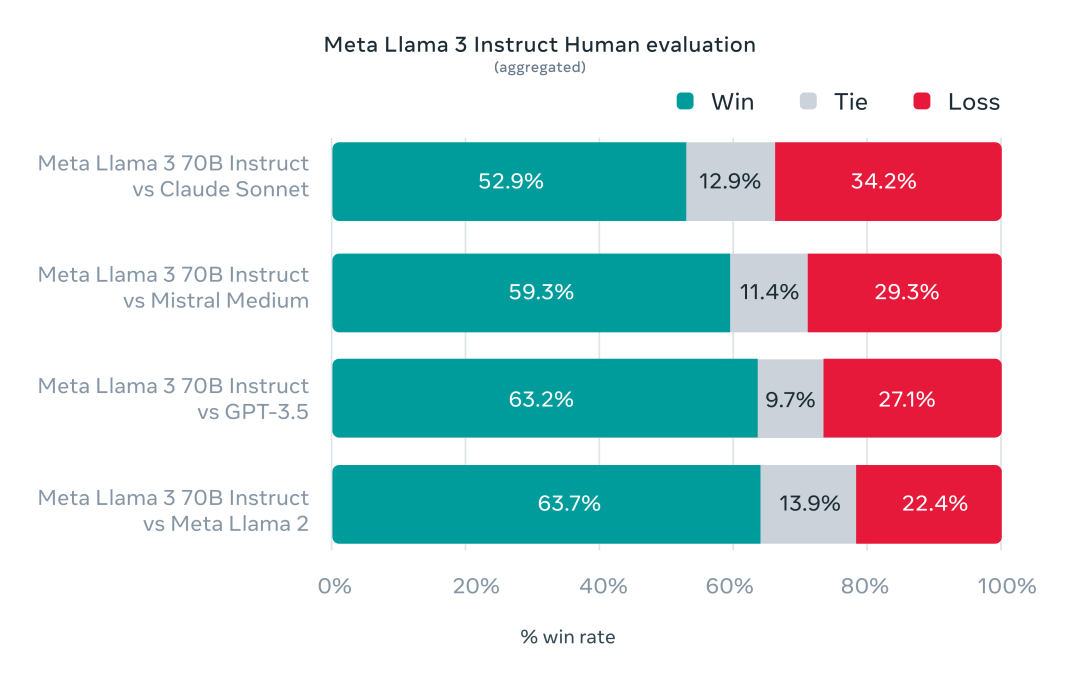

為了測試Llama 3在標準基準測試上的性能,Meta甚至特意開發了一個新的高質量人類評估集。這個評估集包含1800個提示,涵蓋尋求建議、頭腦風暴、角色扮演等12個關鍵用例。為了測試的公平,評估集不允許自己的建模團隊訪問。結果是,70B的Llama 3Instruct-tuned模型在人類評測中勝過Claude Sonnet和GPT 3.5:

圖片

圖片

然而,鑒于測試集由Meta自身設計,顯然這些結果需要持保留態度看待。

從定性角度來說,Meta宣稱新Llama模型的用戶可以期待更高的“可控性”,即模型更愿意回答問題,并且在瑣事問題、涉及歷史和STEM(如工程與科學)領域的提問以及通用編碼建議方面表現出更高的準確性。

二、Llama 3 技術細節,訓練集是上代7倍大

在模型架構方面,與Llama 2 基本一致,最關鍵的不同在于以下幾點:

1.Llama 3使用了一個128K Token 的詞匯表,而 Llama-2 的詞匯量為 32K。

2.訓練數據使用了 15 萬億個 Token,而不是 Llama-2 的 2 萬億。

3.8 億參數的模型也使用了分組查詢注意力(GQA)(與 Llama 2 7b 則沒有)。

4.代碼數據是原來的 4 倍。

為了訓練Llama 3,Meta在超過15Token的令牌上進行了預訓練。所使用的訓練數據集是Llama 2所使用的七倍。

在Llama 3的開發過程中,Meta對scaling law有了一些新體會。這次訓練以Chinchilla做指導,但是他們發現雖然對于一個8B模型來說,對應的最優訓練量約200B個令牌,即使在訓練了700億個Token后,模型性能仍在繼續提高。

這些龐大的數據源自何處?Meta并未透露具體來源,僅表示數據來自“公開可用資源”,其中包含的代碼量是Llama 2訓練集的四倍,并且有5%的非英語數據(覆蓋約30種語言),旨在提升除英語外其他語言的表現(不過仍然有大佬吐槽Llama 3的中文表現一般)。Meta還表示使用了合成數據(即AI生成的數據)來創建長篇文檔供Llama 3模型訓練,這一做法因可能帶來性能弊端而頗具爭議。

許多生成式AI供應商視訓練數據為競爭優勢,因此對其保密。但訓練數據詳情也是潛在的知識產權相關訴訟源頭,這也成為不愿透露過多信息的另一個原因。近期報道顯示,在與AI競爭對手保持同步的過程中,Meta曾不顧自家律師警告,使用受版權保護的電子書進行AI訓練。

那么,對于生成式AI模型常見的毒性與偏見問題,Llama 3同樣采取了措施。

Meta表示已開發新的數據過濾管道以提升模型訓練數據質量,并更新了其生成式AI安全套件Llama Guard和CybersecEval,旨在防止Llama 3模型及其他模型被濫用以及產生有毒的文本生成。該公司還發布了一款名為Code Shield的新工具,用于檢測生成式AI模型產生的可能引入安全漏洞的代碼。然而,過濾并非萬無一失。我們需要等待觀察Llama 3模型在實際應用中的表現,包括學術界對其在替代基準上的測試。

三、抽干閉源模型的護城河:4000億參數的“巨無霸”已經在路上

Meta指出,Llama 3模型已經可以下載。

Llama 3為Facebook、Instagram、WhatsApp、Messenger和網頁版Meta AI助手提供支持。不久,其將在包括AWS、Databricks、Google Cloud、Hugging Face、Kaggle、IBM WatsonX、Microsoft Azure、Nvidia NIM和Snowflake在內的廣泛云平臺上以托管形式提供。

未來,針對AMD、AWS、Dell、Intel、Nvidia和Qualcomm硬件優化的模型版本也將發布。

盡管Llama 3模型可能廣泛可用,但我們會將其描述為“開放”而非“開源”。這是因為,其Llama系列模型并非如其聲稱的那樣無附加條件。

它們既可用于研究也可用于商業應用。然而,Meta禁止開發者使用Llama模型訓練其他生成式模型,同時月活躍用戶超過7億的應用開發者必須向Meta申請特殊許可,Meta將根據其判斷決定是否授予許可。

更強大的Llama模型已在籌備中。

Meta稱正在訓練規模達4000億參數的Llama 3模型,這類模型能夠進行多語言對話,處理更多類型的數據,理解圖像和其他模態信息,與文本一樣,這將使Llama 3系列與Hugging Face的Idefics2等開放發布版本保持一致。

“我們的近期目標是讓Llama 3實現多語言和多模態,具備更長的上下文理解能力,并在諸如推理和編程等大型語言模型核心功能上繼續提升整體性能,”Meta在其博客文章中寫道。“未來還有許多值得期待的進步。”

隨著400B的“巨無霸”逐漸展露真容,大模型競技場的氛圍愈加焦灼。環視四周,我們可以發現,今天發布的Llama-3 70B,和Gemini 1.5 Pro,Cohere CMD R+,Claude Sonnet以及老版GPT-4差不多站在了同樣的分界線里。

谷歌曾直言,我們沒有護城河。OpenAI同樣如此。面對 Llama-3 70B的當頭一擊,谷歌最先進的模型Gemini1.5 Pro也要避其鋒芒。閉源模型的護城河每每挖深一點,似乎就會在猝不及防間被扎克伯格抽干一次。大模型的開源與閉源之爭短時間內并不會有解,但Meta在開源立場上的堅持,卻讓這場曠日持久的Battle有了更多的可能性。

就像Yann LeCun在近期的演講中所提到的,我們不能讓少數幾個AI助手掌控全世界每個公民的全部數字生活。這位AI界的泰斗從始至終堅持開源主張,“我們需要的不是一個AI助手,而是像Llama 2、Mistral和Gemma這樣的基礎模型,任何人都可以對其進行微調”,這樣我們才可以避免回音室,避免讓少數幾家AI平臺來控制人們的所見所思,真正獲得多樣化的信息來源。

四、 Llama 3開源,AI賽道玩家誰喜誰憂?

朱嘯虎在他的“中國現實主義AIGC故事”中談論過一個非常現實的問題:即如果一家公司投入巨資去研發類似于GPT-4的大模型,而一旦其他組織開源了類似的技術,那么之前的投入可能會白費。

現在開源的王Llama 3橫空出世,已經無限逼近這個預言。對于場上閉源大模型的玩家來說,必須得做到比最強開源大模型領先,才能證明自己的價值。

而Llama 3這樣急速拉高開源模型水位線的做法,無疑是打在其他大模型企業腹地上一記又快又狠的重拳。

但對于AI應用層的企業來說,“奶媽”Llama 3的表現著實讓人驚喜。獵豹CEO傅盛在凌晨兩點的視頻中提到,絕大多數的模型都是基于Llama重新訓練或者進行微調的,而最讓人驚喜的點就在于Llama 3沒有將目標一味聚焦在“大”上,而是讓8B的小模型也跑出了強性能。

傅盛發布視頻截圖

傅盛發布視頻截圖

小扎在訪談中提到無法讓人使用的AI與新技術的濫用一樣糟糕,因此“擁有一個優秀且成為標準的開源人工智能,可能是緩解這種情況的最佳方法。”而Llama 3的優秀和強大,本身就是對“開源社區會越來越落后”論調的最強反擊。

AI技術想要服務于人類福祉,就需要更多人能伸手摘到這顆樹上的果實。Llama 3已經來了,企業和研究機構在強大底座上的二次開發和技術創新也就不遠了。

參考鏈接:

1.https://www.youtube.com/watch?v=bc6uFV9CJGg

2.https://ai.meta.com/blog/meta-llama-3/?utm_source=twitter&utm_medium=organic_social&utm_cnotallow=video&utm_campaign=llama3