CVPR 2024 | 面向真實感場景生成的激光雷達擴散模型

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

原標題:Towards Realistic Scene Generation with LiDAR Diffusion Models

論文鏈接:https://hancyran.github.io/assets/paper/lidar_diffusion.pdf

代碼鏈接:https://lidar-diffusion.github.io

作者單位:CMU 豐田研究院 南加州大學

論文思路:

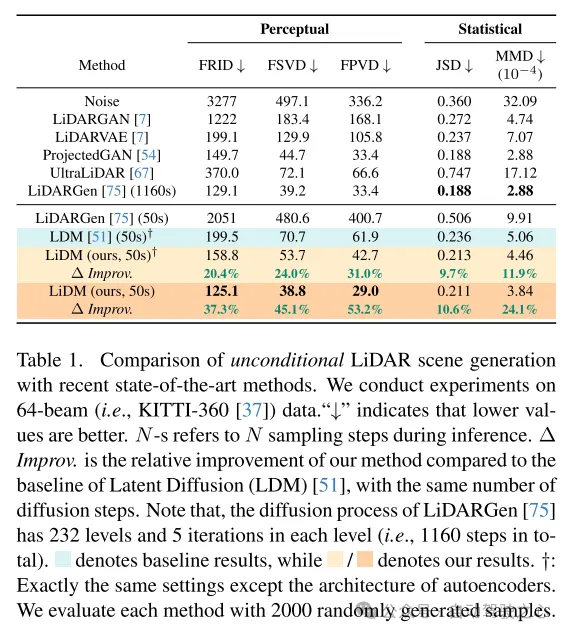

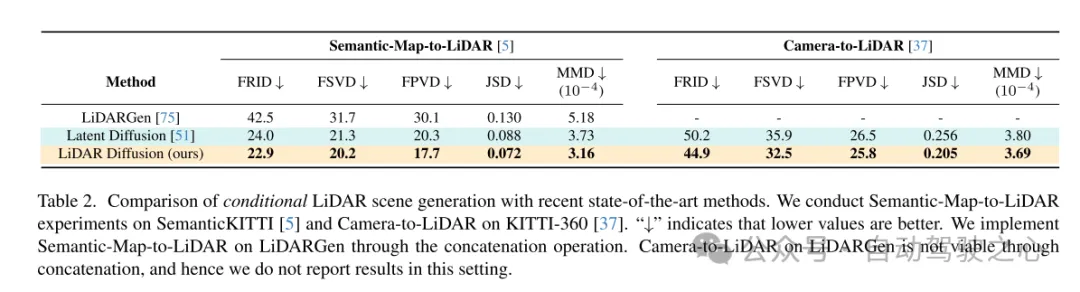

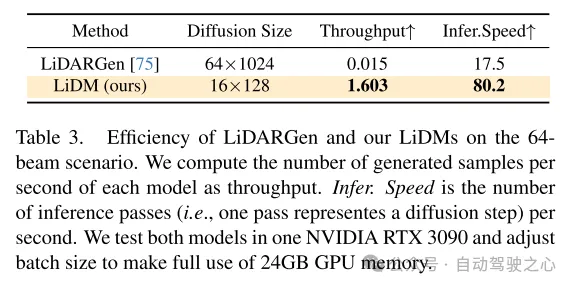

擴散模型(DMs)在逼真的圖像合成方面表現出色,但將其適配到激光雷達場景生成中卻面臨著重大挑戰。這主要是因為在點空間運作的DMs 難以保持激光雷達場景的曲線樣式和三維幾何特性,這消耗了它們大部分的表征能力。本文提出了激光雷達擴散模型(LiDMs),這一模型通過在學習流程中融入幾何先驗,能夠從為捕獲激光雷達場景的真實感而定制的隱空間中生成逼真的激光雷達場景。本文的方法針對三個主要愿望:模式的真實性、幾何的真實性和物體的真實性。具體來說,本文引入了曲線壓縮來模擬現實世界的激光雷達模式,點級(point-wise)坐標監督來學習場景幾何,以及塊級(patch-wise)編碼以獲得完整的三維物體上下文。憑借這三個核心設計,本文在無條件激光雷達生成的64線場景中建立了新的SOTA,同時與基于點的DMs相比保持了高效率(最高可快107倍)。此外,通過將激光雷達場景壓縮到隱空間,本文使 DMs 能夠在各種條件下控制,例如語義地圖、相機視圖和文本提示。

主要貢獻:

本文提出了一種新穎的激光雷達擴散模型(LiDM),這是一種生成模型,能夠用于基于任意輸入條件的逼真激光雷達場景生成。據本文所知,這是第一個能夠從多模態條件生成激光雷達場景的方法。

本文引入了曲線級壓縮以保持逼真的激光雷達模式,點級坐標監督以規范場景級幾何的模型,并且引入了塊級編碼以完全捕捉3D物體的上下文。

本文引入了三個指標,用于在感知空間中全面且定量地評估生成的激光雷達場景質量,比較包括距離圖像、稀疏體積和點云等多種表示形式。

本文的方法在64線激光雷達場景的無條件場景合成上實現了最新水平,并且相比于基于點的擴散模型實現了高達107倍的速度提升。

網絡設計:

近年來,條件生成模型的發展迅猛,這些模型能夠生成視覺上吸引人且高度逼真的圖像。在這些模型中,擴散模型(DMs)憑借其無可挑剔的性能,已經成為最受歡迎的方法之一。為了實現任意條件下的生成,隱擴散模型(LDMs)[51] 結合了交叉注意力機制和卷積自編碼器,以生成高分辨率圖像。其后續擴展(例如,Stable Diffusion [2], Midjourney [1], ControlNet [72])進一步增強了其條件圖像合成的潛力。

這一成功引發了本文的思考:我們能否將可控的擴散模型(DMs)應用于自動駕駛和機器人技術中的激光雷達場景生成?例如,給定一組邊界框,這些模型能否合成相應的激光雷達場景,從而將這些邊界框轉化為高質量且昂貴的標注數據?或者,是否有可能僅從一組圖像生成一個3D場景?甚至更有野心地,我們能設計出一個由語言驅動的激光雷達生成器來進行可控模擬嗎?為了回答這些交織在一起的問題,本文的目標是設計出能夠結合多種條件(例如,布局、相機視角、文本)來生成逼真激光雷達場景的擴散模型。

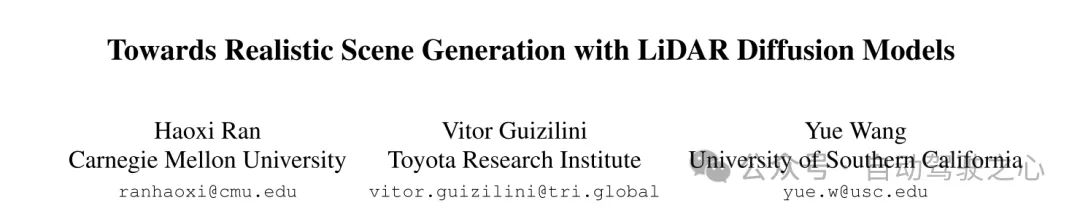

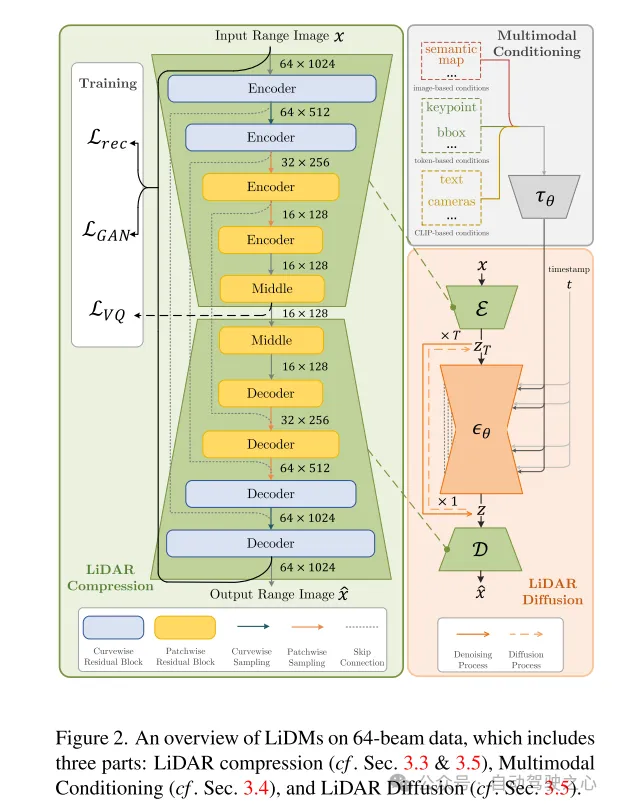

為此,本文從最近自動駕駛領域的擴散模型(DMs)工作中獲取了一些見解。在[75]中,介紹了一種基于點的擴散模型(即LiDARGen),用于無條件的激光雷達場景生成。然而,這個模型往往會產生嘈雜的背景(如道路、墻壁)和模糊不清的物體(如汽車),導致生成的激光雷達場景與現實情況相去甚遠(參見圖1)。此外,在沒有任何壓縮的情況下對點進行擴散,會使得推理過程計算速度變慢。而且,直接應用 patch-based 擴散模型(即 Latent Diffusion [51])到激光雷達場景生成,無論是在質量上還是數量上,都未能達到令人滿意的性能(參見圖1)。

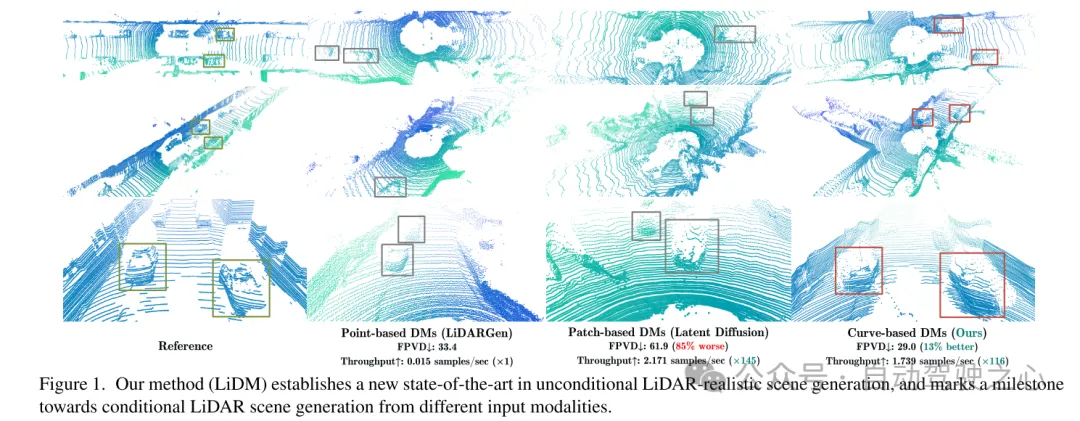

為了實現條件化的逼真激光雷達場景生成,本文提出了一種基于曲線的生成器,稱為激光雷達擴散模型(LiDMs),以回答上述問題并解決近期工作中的不足。LiDMs 能夠處理任意條件,例如邊界框、相機圖像和語義地圖。LiDMs 利用距離圖像作為激光雷達場景的表征,這在各種下游任務中非常普遍,如檢測[34, 43]、語義分割[44, 66]以及生成[75]。這一選擇是基于距離圖像與點云之間可逆且無損的轉換,以及從高度優化的二維卷積操作中獲得的顯著優勢。為了在擴散過程中把握激光雷達場景的語義和概念本質,本文的方法在擴散過程之前,將激光雷達場景的編碼點轉換到一個感知等效的隱空間(perceptually equivalent latent space)中。

為了進一步提高真實世界激光雷達數據的逼真模擬效果,本文專注于三個關鍵組成部分:模式真實性、幾何真實性和物體真實性。首先,本文利用曲線壓縮在自動編碼過程中保持點的曲線圖案,這一做法受到[59]的啟發。其次,為了實現幾何真實性,本文引入了點級坐標監督,以教會本文的自編碼器理解場景級別的幾何結構。最后,本文通過增加額外的塊級下采樣策略來擴大感受野,以捕捉視覺上較大物體的完整上下文。通過這些提出的模塊增強,所產生的感知空間使得擴散模型能夠高效地合成高質量的激光雷達場景(參見圖1),同時在性能上也表現出色,與基于點的擴散模型相比速度提升了107倍(在一臺NVIDIA RTX 3090上評估),并支持任意類型的基于圖像和基于 token 的條件。

圖1. 本文的方法(LiDM)在無條件的激光雷達逼真場景生成方面確立了新的SOTA,并標志著從不同輸入模態生成條件化激光雷達場景方向上的一個里程碑。

圖2. 64線數據上 LiDMs 的概覽,包括三個部分:激光雷達壓縮(參見第3.3節和3.5節)、多模態條件化(參見第3.4節)以及激光雷達擴散(參見第3.5節)。

實驗結果:

圖3. 在64線場景下,來自 LiDARGen [75]、Latent Diffusion [51] 以及本文的 LiDMs 的例子。

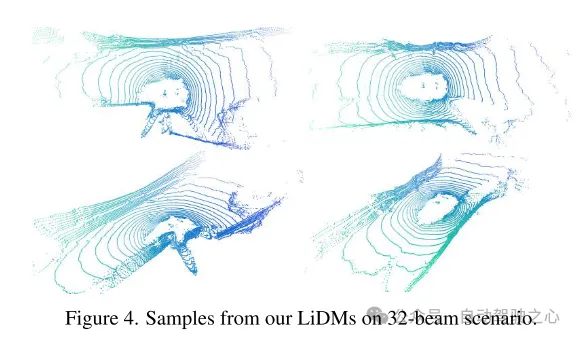

圖4. 在32線場景下,來自本文 LiDMs 的例子。

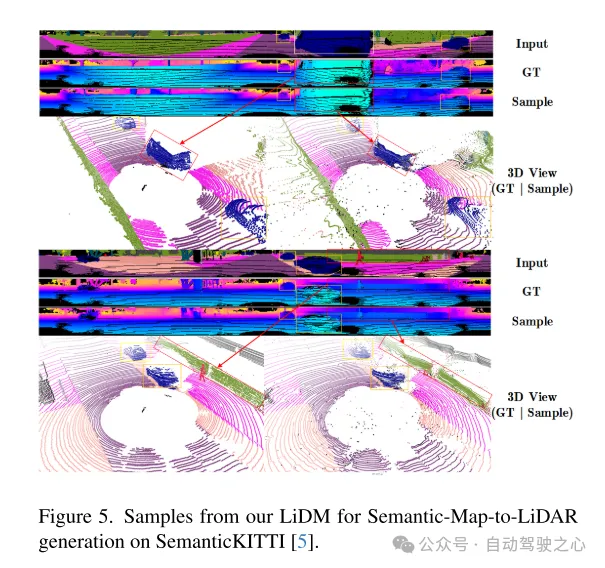

圖5. 在SemanticKITTI [5]數據集上,用于語義地圖到激光雷達生成的本文的 LiDM 的例子。

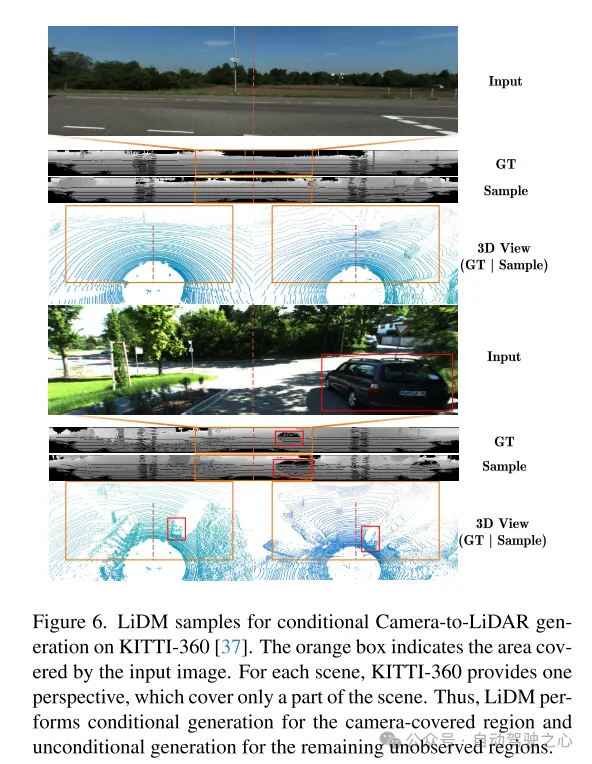

圖6. 在KITTI-360 [37]數據集上,用于條件相機到激光雷達生成的 LiDM 的例子。橙色框表示輸入圖像所覆蓋的區域。對于每個場景,KITTI-360提供一個視角,它只覆蓋了場景的一部分。因此,LiDM 對相機覆蓋的區域執行條件生成,對其余未觀測到的區域執行無條件生成。

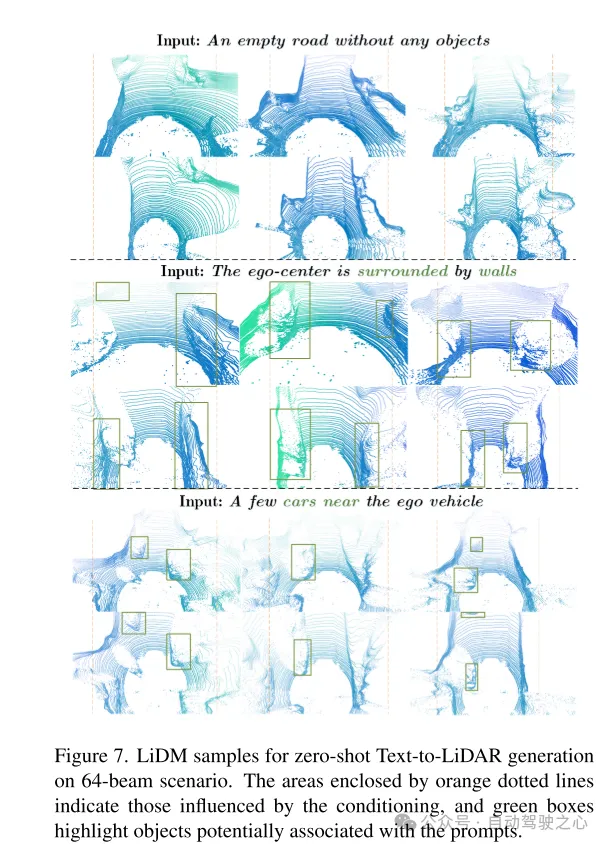

圖7. 在64線場景下,用于 zero-shot 文本到激光雷達生成的 LiDM 的例子。橙色虛線框起的區域表示受條件影響的區域,綠色框突出顯示了可能與提示詞相關聯的物體。

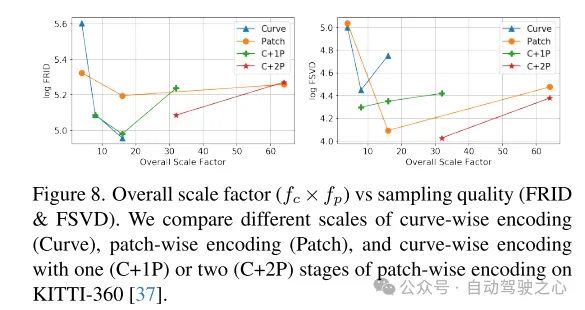

圖8. 總體縮放因子()與采樣質量(FRID和FSVD)的對比。本文在KITTI-360 [37]數據集上比較了不同規模的曲線級編碼(Curve)、塊級編碼(Patch)以及帶有一(C+1P)或兩(C+2P)階段塊級編碼的曲線級編碼。

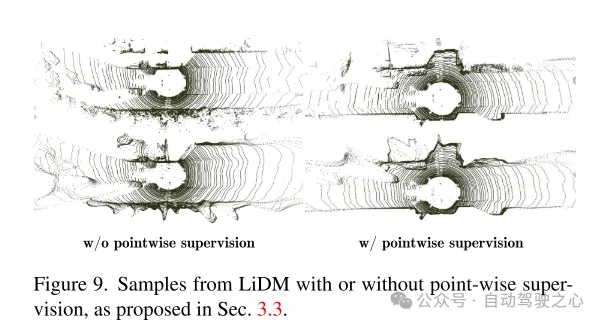

圖9. LiDM 的例子,包括有或沒有點級監督,如第3.3節所提出的。

總結:

本文提出了激光雷達擴散模型(LiDMs),這是一個用于激光雷達場景生成的通用條件化框架。本文的設計著重于保留曲線狀的圖案以及場景級別和物體級別的幾何結構,為擴散模型設計了一個高效的隱空間,以實現激光雷達逼真生成。這種設計使得本文的 LiDMs 在64線場景下能夠在無條件生成方面取得有競爭力的性能,并在條件生成方面達到了最先進的水平,可以使用多種條件對 LiDMs 進行控制,包括語義地圖、相機視圖和文本提示。據本文所知,本文的方法是首次成功將條件引入到激光雷達生成中的方法。

引用:

@inproceedings{ran2024towards,

title={Towards Realistic Scene Generation with LiDAR Diffusion Models},

author={Ran, Haoxi and Guizilini, Vitor and Wang, Yue},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year={2024}

}