全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅為 GPT-4-Turbo 的近百分之一

想象一下,一個人工智能模型,不僅擁有超越傳統計算的能力,還能以更低的成本實現更高效的性能。這不是科幻,DeepSeek-V2[1],全球最強開源 MoE 模型來了。

DeepSeek-V2 是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由 236B 個參數組成,其中 21B 個參數用于激活每個標記。與 DeepSeek 67B 相比,DeepSeek-V2 性能更強,同時節省了 42.5% 的訓練成本,減少了 93.3% 的 KV 緩存,最大生成吞吐量提高到 5.76 倍。

DeepSeek 是一家探索通用人工智能(AGI)本質的公司,并致力于將研究、工程和商業三者融為一體。

DeepSeek-V2 的綜合能力

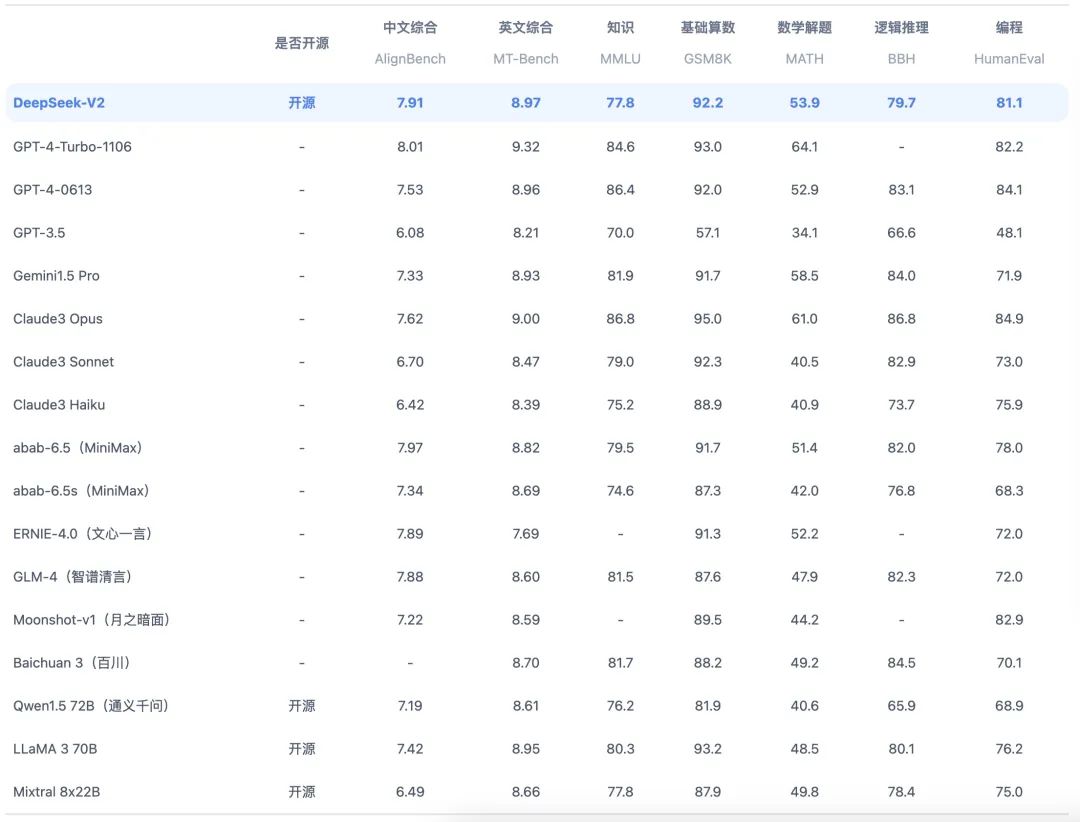

在目前大模型主流榜單中,DeepSeek-V2 均表現出色:

- 中文綜合能力(AlignBench)開源模型中最強:與 GPT-4-Turbo,文心 4.0 等閉源模型在評測中處于同一梯隊

- 英文綜合能力(MT-Bench)處于第一梯隊:英文綜合能力(MT-Bench)與最強的開源模型 LLaMA3-70B 處于同一梯隊,超過最強 MoE 開源模型 Mixtral 8x22B

- 知識、數學、推理、編程等榜單結果位居前列

- 支持 128K 上下文窗口

全新的模型結構

當 AI 的潛力被不斷挖掘,我們不禁要問:什么是推動智能進步的關鍵?DeepSeek-V2 給出了答案 —— 創新架構與成本效益的完美結合。

DeepSeek-V2,以 236B 的總參數和 21B 激活,大致達到了 70B~110B Dense 模型的能力,同時顯存消耗僅為同級別模型的 1/5~1/100。在8卡H800機器上,每秒可處理超過 10 萬tokens 的輸入,輸出超過每秒 5 萬 tokens。這不僅是技術上的飛躍,更是成本控制的革命。

在 AI 技術飛速發展的今天,DeepSeek-V2 的出現,不僅代表了技術的突破,更預示著智能應用的普及化。它將 AI 的門檻降低,讓更多企業和個人能夠享受到高效智能服務。

中文能力 VS 價格

在中文能力方面,DeepSeek-V2 在 AlignBench 排名中全球領先,同時提供極具競爭力的 API 價格。

模型和論文雙開源

DeepSeek-V2,不只是一款模型,它是通往更智能世界的鑰匙。它以更低的成本,更高的性能,開啟了 AI 應用的新篇章。DeepSeek-V2 的開源,是對這一信念的最好證明,它將激發更多人的創新精神,共同推動人類智能的未來。

- 模型權重:https://huggingface.co/deepseek-ai

- 開源地址:https://github.com/deepseek-ai/DeepSeek-V2

在 AI 不斷進化的今天,你認為 DeepSeek-V2 將如何改變我們的世界?讓我們拭目以待,感興趣的話,可以訪問 chat.deepseek.com 親自體驗 DeepSeek-V2 帶來的技術變革。

參考資料

[1]

DeepSeek-V2: https://www.deepseek.com/zh