Ilya出走加劇OpenAI離職潮!RLHF作者Jan Leike同日辭職,超級對齊項目分崩離析

Ilya Sutskever宣布退出OpenAI,震動整個AI圈。

數小時后,RLHF發明者之一Jan Leike也追隨他的腳步一起離開,再次給OpenAI的前途蒙上了一層陰影。

兩人共同領導的超級對齊團隊成立還不到一年,已經分崩離析。

△他甚至不留下一句客套話

△他甚至不留下一句客套話

Jan Leike在GPT-4項目上與Ryan Lowe共同領導了對齊工作,而后者也已于3月底離開OpenAI。

所以說不止超級對齊團隊,而是整個OpenAI安全研究方向的人才,都在持續動蕩中。

超級對齊成員之一William Saunders,以及參與過GPT-4對抗性測試的Daniel Kokotajlo,此前兩人均已離開OpenAI。

其中Kokotajlo在Less Wrong論壇留下了自己的理由:

對OpenAI能否在AGI時代負責任的行動失去了信心。

按他的說法,當前的AI監管努力集中在“評估風險和采取緩解措施”的組合上,這種組合很容易被大型公司鉆空子利用,最終導致“選擇性暫停”,也就是最需要被監管的前沿大型AI實驗室反而沒被監管到。

“幻滅了”,這是他用來形容辭職原因的說法,可能也代表了所有這些AI安全研究人員的心情。

對于這一系列事件,有網友表示:Ilya和Leike離開后,OpenAI可能不再是原來的OpenAI了。

還有人更悲觀一些,失去兩人以后,把對OpenAI能做好AGI的預期調整為零。

以及AI安全問題如此重要,讓人們無法以看熱鬧的心態來看待這些“抓馬”。

超級對齊團隊或不復存在

為什么Jan Leike的離開引起這么大影響?

他早年在DeepMind工作,與OpenAI團隊共同開發了人類反饋強化學習RLHF,后來成為ChatGPT的核心技術之一。

加入OpenAI后,從代碼大模型Codex、ChatGPT的前身InstrucGPT,到ChatGPT、GPT-4他都是重要貢獻者。

在去年11月的OpenAI董事會叛變風波中,Jan Leike也發揮了關鍵作用,可能是促成Ilya最終回心轉意結束亂局的因素之一。

2023年底,《時代》雜志將他列為人工智能領域100名最具影響力的人物之一。

2023年7月,Jan與Ilya發起了OpenAI超級對齊團隊,拿出20%總算力,直接越級瞄準如何控制還不存在的超級智能。

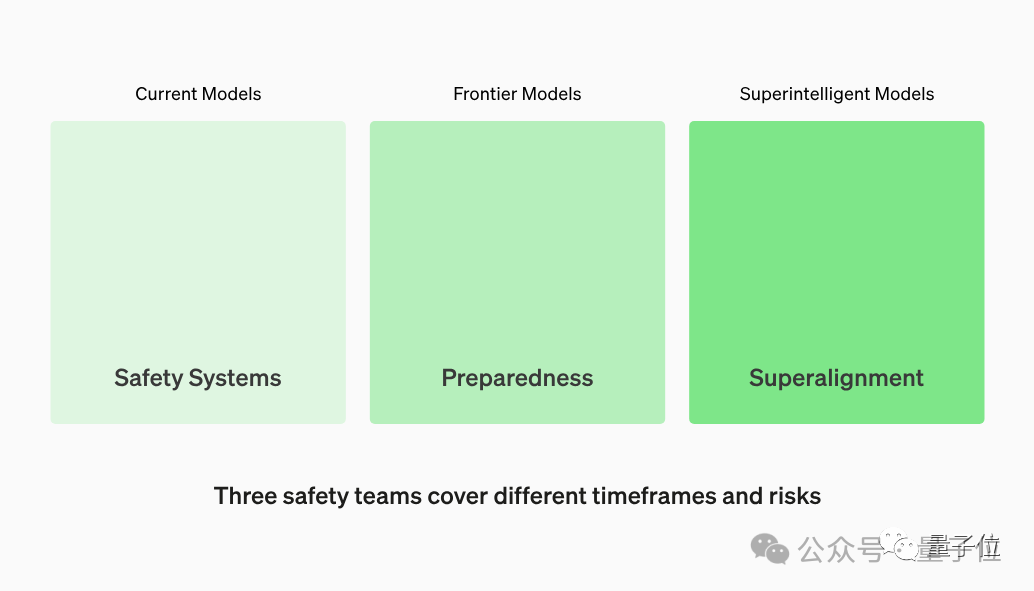

對于不同時間尺度的AI風險,OpenAI有三個團隊來分別應對,其中超級對齊負責遙遠的未來。

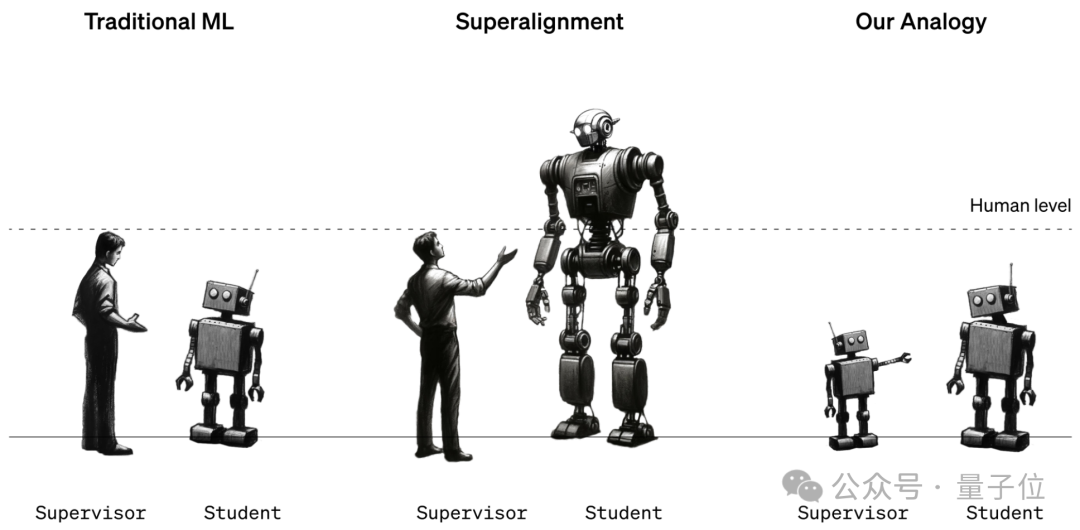

超級對齊團隊的第一個成果《Weak-to-Strong Generalization》,試圖證明通過弱模型監管強模型是一條行之有效的路徑

此外他們還開源了用于分析大模型可解釋性的工具OpenAI Transformer Debugger。

這個工具結合了自動可解釋性技術和稀疏自動編碼器,支持神經元和注意力頭干預,讓研究者無需便攜代碼即可獲得數據。

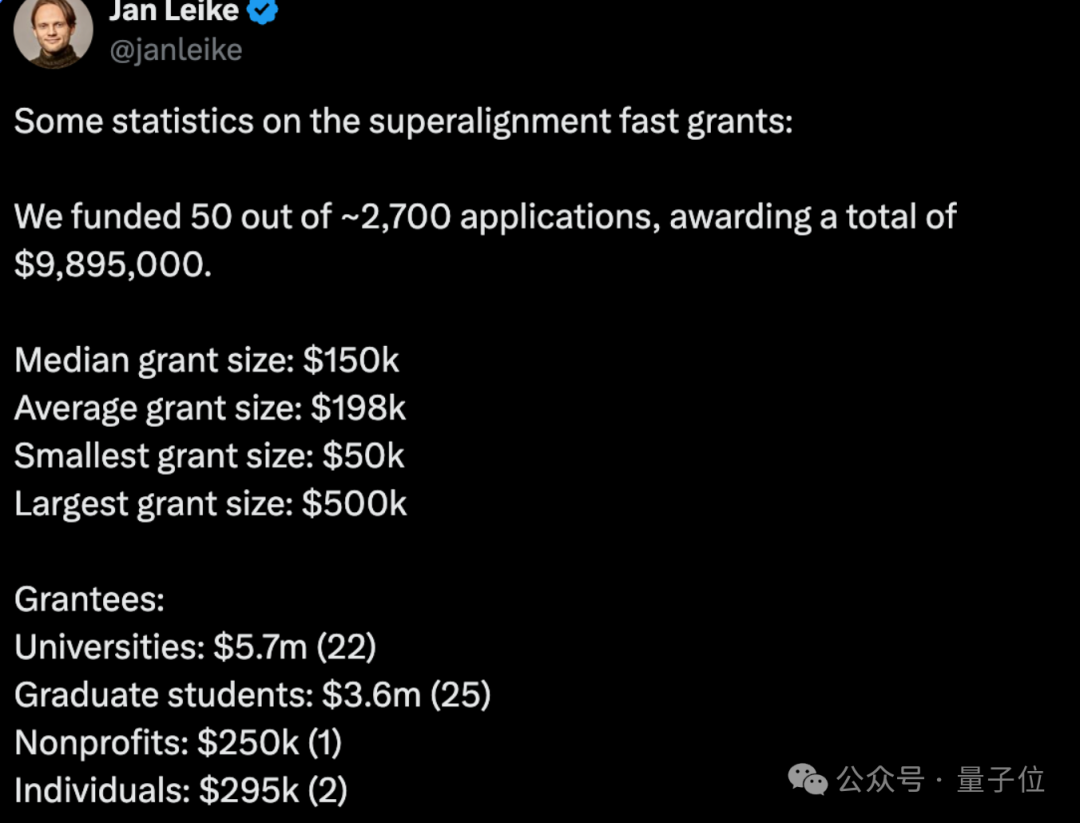

除了研究之外,超級對齊團隊此前還有一系列資助AI安全研究的計劃,第一期總計向學校、非營利組織和個人發放了1000萬美元資金。

可能也就此成為絕唱。

One More Thing

在大量人才持續出走的同時,OpenAI也引進了一些新鮮血液。

最新消息,他們挖來了谷歌搜索廣告業務的21年老將。

在商業化的路上不斷加速,或許是AI安全團隊選擇分道揚鑣的原因之一。

參考鏈接:

[1]https://x.com/janleike/status/1790603862132596961