GPT-2能監督GPT-4,Ilya帶頭OpenAI超級對齊首篇論文來了:AI對齊AI取得實證結果

過去一年,以「預測下一個 Token」為本質的大模型已經橫掃人類世界的多項任務,展現了人工智能的巨大潛力。

在近日的一次訪談中,OpenAI 首席科學家 Ilya Sutskever 大膽預言,如果模型能夠很好地預測下一個詞,那么意味著它能夠理解導致這個詞產生的深刻現實。這意味著,如果 AI 按照現有路徑發展下去,也許在不久的將來,一個超越人類的人工智能系統就會誕生。

但更加令人擔心的是,「超級人工智能」可能會帶來一些意想不到的負面后果。這也是「對齊」的意義。

此前的對齊方法依賴于人類的監督,如在 ChatGPT 訓練中起到關鍵作用的人類反饋的強化學習(RLHF)。但未來的人工智能系統或許能夠做出極其復雜和富有創造性的行為,使人類難以對其進行可靠的監督。例如,超人類模型可能會編寫出數百萬行新奇的、具有潛在危險的計算機代碼,即使是人類專家也很難理解這些代碼。

一旦人工智能的水平超過人類,我們又該如何監督比自己聰明得多的人工智能系統?人類文明最終會被顛覆甚至摧毀嗎?

即使是 Hinton 這樣的學界巨佬,對這個問題同樣持悲觀態度 —— 他表示自己「從沒見過更高智能水平的東西被遠遠更低智能水平的東西控制的案例」。

剛剛,OpenAI「超級對齊」團隊發布了成立以來的首篇論文,聲稱開辟了對超人類模型進行實證對齊的新研究方向。

論文鏈接:https://cdn.openai.com/papers/weak-to-strong-generalization.pdf

OpenAI「超級對齊」團隊成立于今年 7 月,目標是在四年內解決超智能 AI 的對齊問題,即搞清楚如何構建一種值得信任的人類水平的研究器,然后將其用于解決對齊問題。據說這個團隊投入了公司 20% 的算力。

在這篇論文中,OpenAI 對「人類監督超級人工智能」這個問題做了一個簡單的類比:讓小模型監督大模型。

研究表明,15 億參數的 GPT-2 模型可以被用來激發 GPT-4 的大部分能力,使其達到接近 GPT-3.5 級別的性能,甚至可以正確地泛化到小模型失敗的難題上。

OpenAI 將這種現象稱為「弱到強泛化」(Weak-to-strong generalization),這表明強大的模型具備如何執行任務的隱含知識,并且即使在給出粗制濫造的指令時也可以在其自身中找到這些知識。

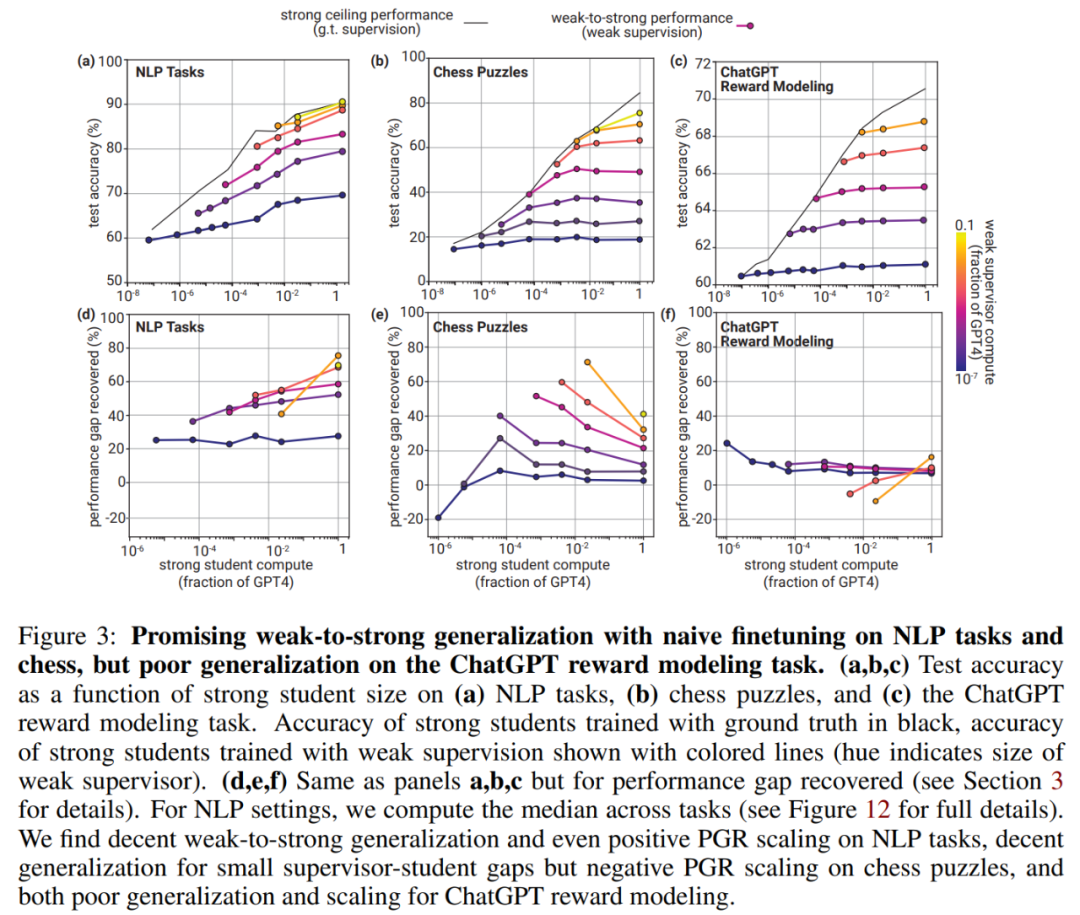

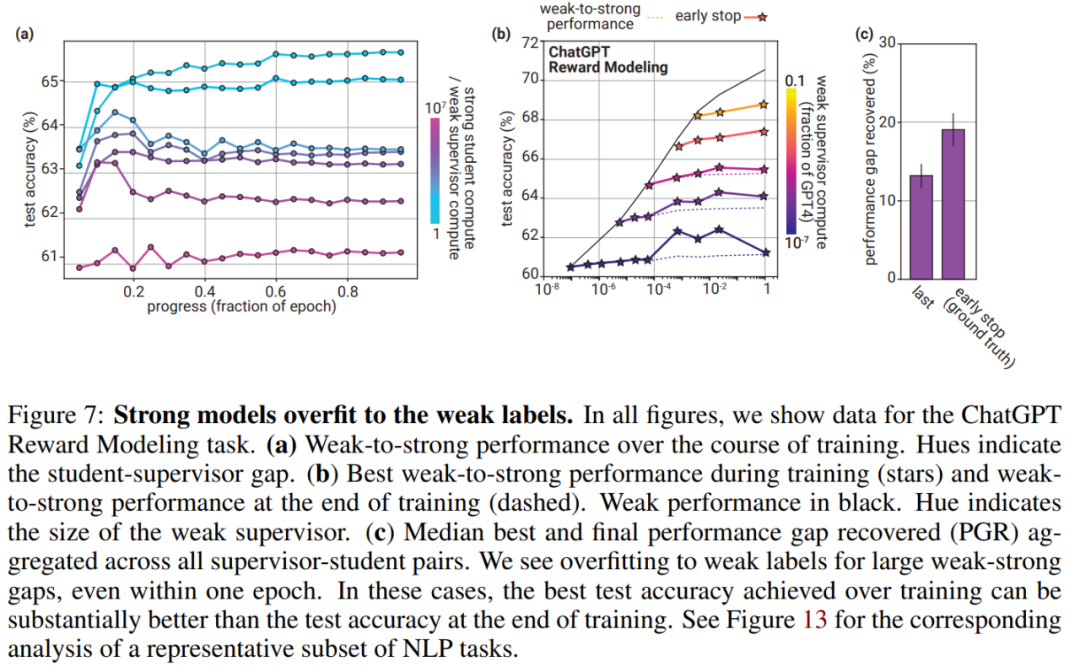

但研究同時指出,用弱監督訓練的強模型和用真實標簽訓練的強模型之間仍然存在很大的差距。這表明在沒有額外工作的情況下,諸如基于人類反饋的強化學習(RLHF)之類的技術可能無法很好地擴展到超人類模型。對于 ChatGPT 獎勵建模任務來說,性能差距尤其大。

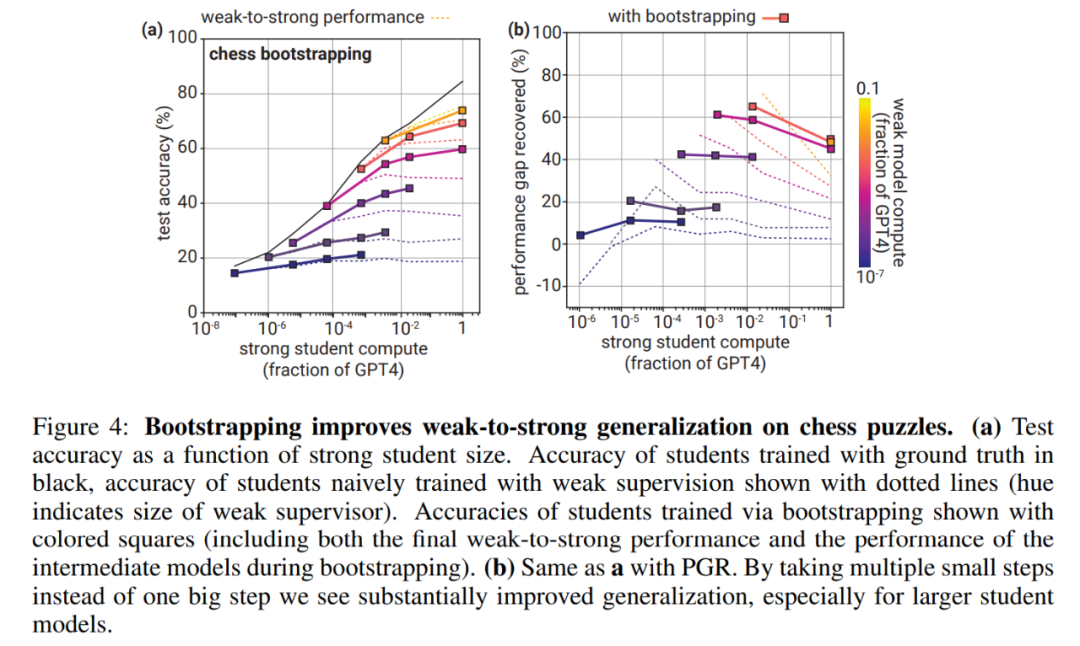

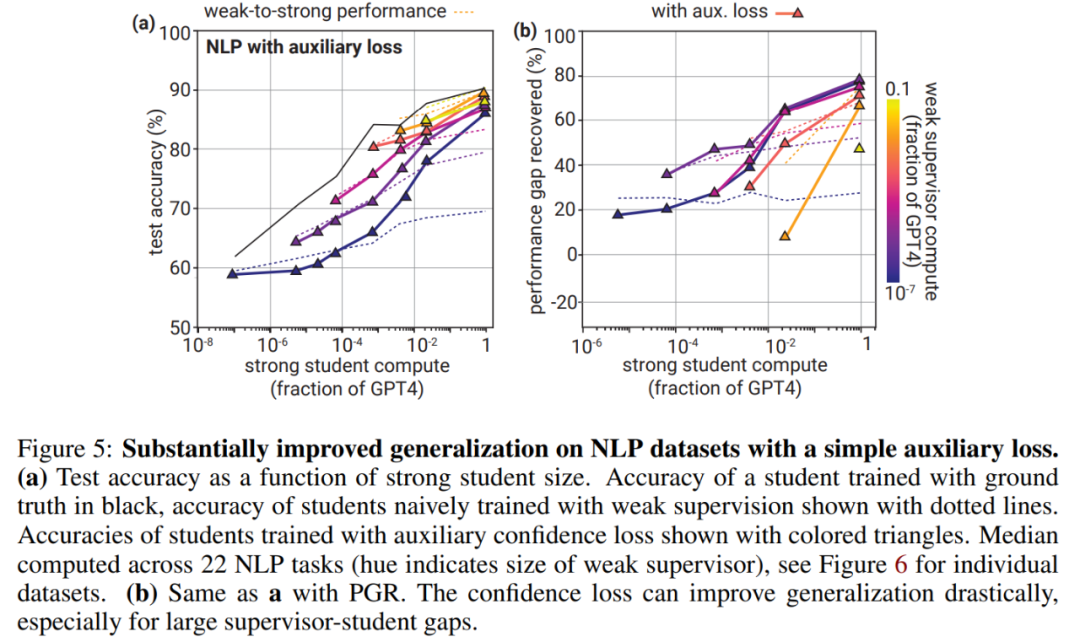

幾種簡單的方法可以顯著提高弱到強的泛化能力,比如使用中間模型大小進行引導監督,在微調時添加輔助置信度損失以鼓勵模型即使在與弱標簽相矛盾時也能保持自信,或者通過額外的無監督預訓練改進表征學習。

為了鼓勵其他研究人員解決此類問題,OpenAI 今天還宣布將提供 1000 萬美元的資助,用于各種比對方法的研究。

以下是論文細節。

研究方法

本文主要通過人類反饋 (RLHF) 的強化學習來指導或對齊模型,他們是這樣做的:強化評估人員評價高的行為,懲罰評估人員評價低的行為。假如說人類評估者能夠準確判斷模型行為是好是壞,這種做法非常有效,并且這種方式還是訓練如 ChatGPT 等大語言模型的核心部分。

然而問題來了,超級模型可能做出人類無法完全理解的復雜行為和創造性行為。例如,一個超級助手模型生成的代碼達到一百萬行,那么人類將無法為關鍵對齊相關任務提供可靠的監督,包括代碼是否遵循用戶的意圖,助手模型是否如實地回答有關代碼的問題,代碼執行是否安全或危險,等等。

因此,如果我們在人類的監督下微調超級模型,我們無法確定這個模型將如何泛化到那些人類自己也難以可靠監督的復雜行為。換句話說,這意味著即使在人類的指導下,這些超級模型在處理一些復雜或未知情況時的表現仍然是不確定的。

這就為對齊超級模型帶來了挑戰:不那么聰明的監督者怎么能控制比他們聰明得多的模型呢?盡管這個問題很重要,但目前很難進行實證研究。

一般來講,超級對齊的一個核心挑戰是人類需要監督比自己更聰明地模型。這是一個弱 - 強(weak-to-strong)的學習問題:一個弱監督者如何監督一個比它聰明得多的模型?為了解決這個問題,本文提出了一個簡單的類比,用弱模型作為監督者來代替較弱的人類監督者。

一般來講,傳統的機器學習側重于這種設置,即人類監督的模型比人類弱。但對于最終的超級對齊問題,人類監督的模型比他們聰明。因而本文研究了一個類似的問題:使用弱模型來監督強模型。

他們是這樣實現的,對于一個給定的任務:

- 構建弱監督者。本文通過在真值標簽上微調較小的預訓練模型來構造弱監督者,他們把弱監督者的表現稱為弱表現,并通過弱模型的預測來生成弱標簽。

- 通過弱監督訓練強學生模型。本文使用生成的弱標簽微調強模型,并將該模型稱為強學生模型,將其產生的性能稱為從弱到強的性能。

- 訓練一個以真值標簽為上限的強模型。為了比較,本文使用真值標簽對強模型進行了微調。將此模型的最終性能稱為強大的上限性能。

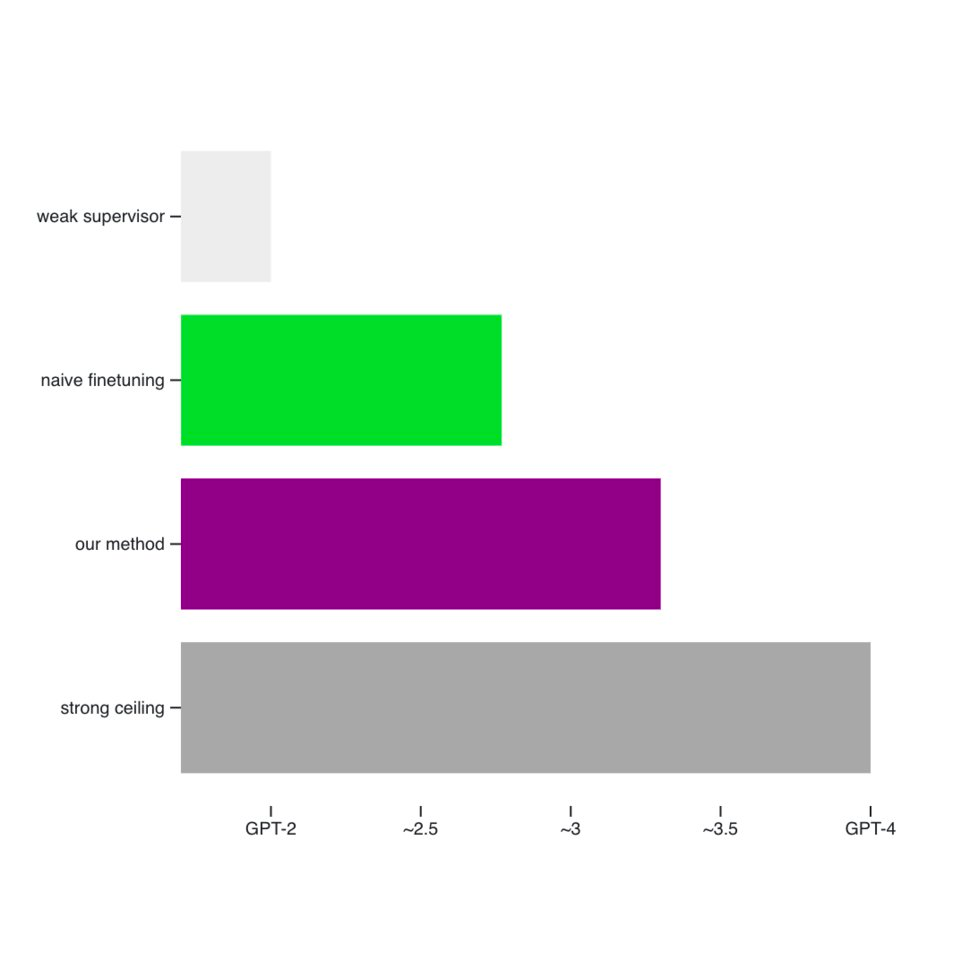

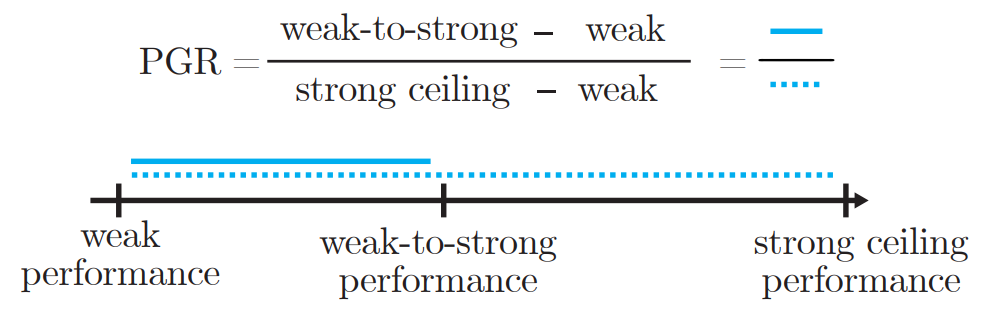

通常,弱到強的表現將介于弱表現和強上限表現(strong ceiling)之間。本文將 PGR(performance gap recovered)定義為上述三種性能(弱、弱到強和強上限)的函數,如下圖所示。

如果實現完美的弱到強泛化,則 PGR 為 1。如果弱到強模型的表現并不比弱監督者更好,則 PGR 為 0。

實驗結果

在 NLP 任務、國際象棋和獎勵建模任務中,本文評估了強學生模型的表現,結果如下。總的來說,在所有的設置中,本文觀察到從弱到強的泛化:強學生模型始終勝過他們的弱監督者。

本文發現可以使用簡單的方法來大大提高弱到強的泛化,如圖 4 所示。

圖 5 表明,對于較小的強學生來說,雖然它的表現比 naive 基線稍差,但提高泛化能力還是很明顯的。

圖 7 (a) 顯示了 ChatGPT RM 任務訓練過程中的真值測試準確度曲線,圖 7 (b) 和 (c) 比較了最佳和最終真值測試的準確度。

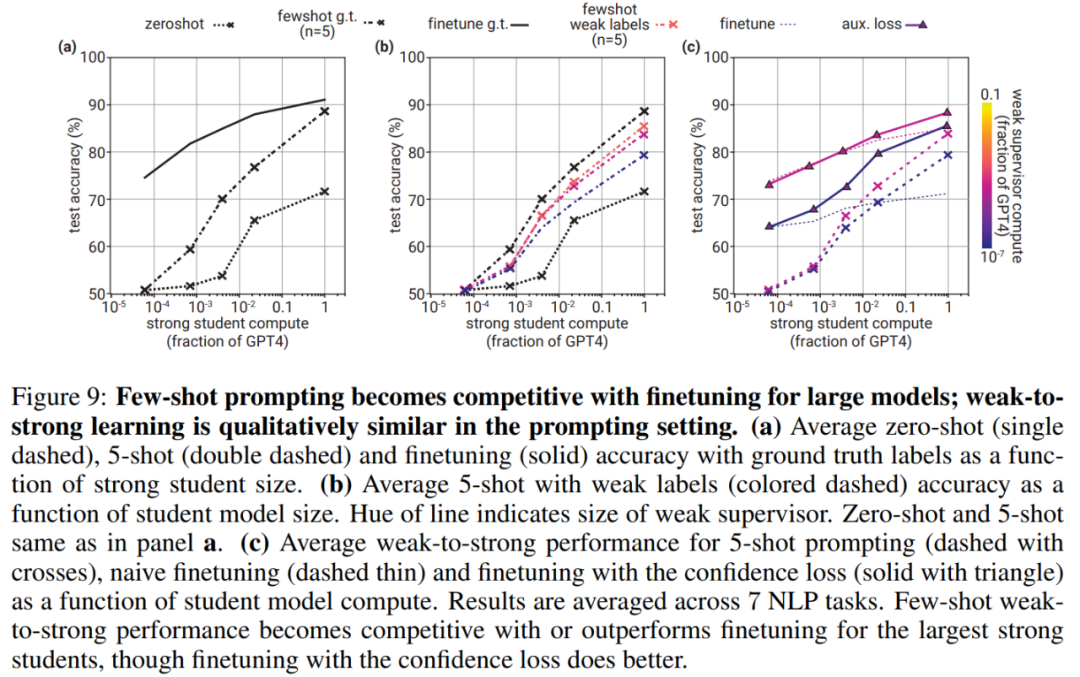

圖 9a 考慮了 7 個有代表性的 NLP 任務,并比較了微調、零樣本提示和 5-shot 提示;對于零樣本和 5-shot 基線,本文使用表 2 中總結的特定于任務的提示。

了解更多內容,請參考原論文。