OpenAI前員工預(yù)測:2027年AGI降臨!GPT智商飆升,4年從幼兒園躥到高中生

AGI到底是科技公司畫的大餅,還是可預(yù)測的未來?

幾天前,Anthropic一名25歲的高管在博客上發(fā)文,表示自己已經(jīng)準(zhǔn)備好了3年后退休,讓AI取代自己的工作。

最近,OpenAI前員工的一篇博客文章也有類似的觀點。

圖片

圖片

他不僅認為AGI很可能實現(xiàn),而且「奇點」預(yù)計就在2027年。

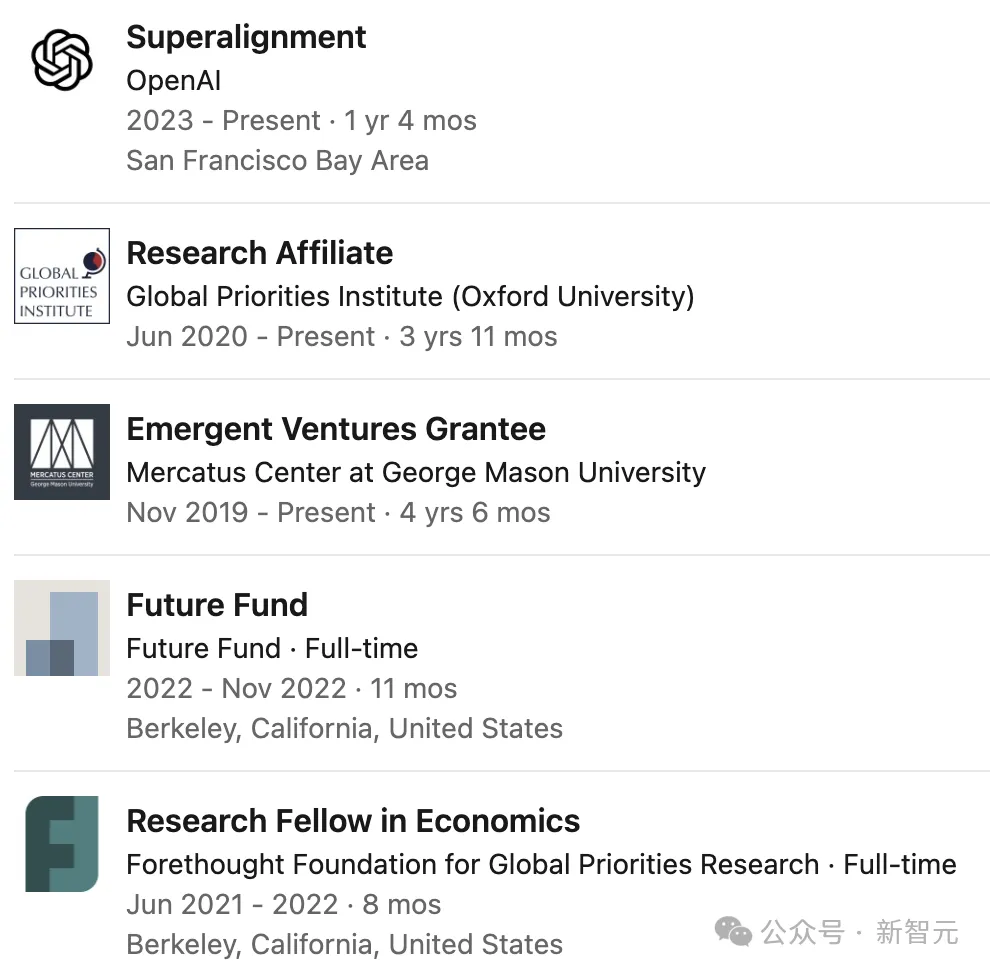

文章作者名為Leopold Aschenbrenner,于2023年入職OpenAI超級對齊團隊,工作了1年6個月。

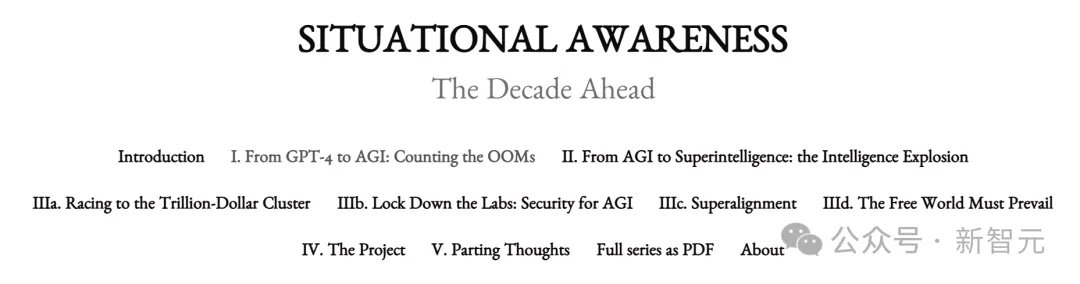

Aschenbrenner認為,到2027年,大模型將能夠完成AI研究人員或工程師的工作。

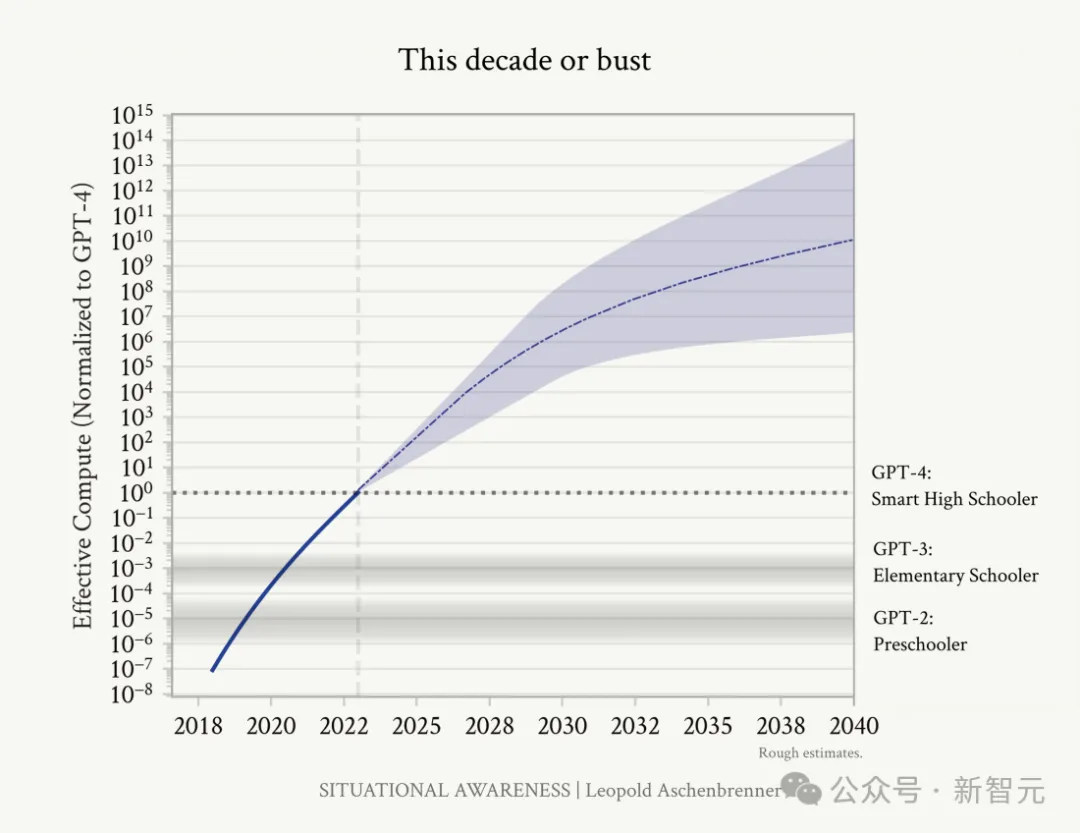

他的論據(jù)也很簡潔直觀——你不需要相信科幻小說,只需要看到圖上的這條直線。

畫出過去4年GPT模型有效計算量的增長曲線,再延伸到4年后,就可以得出這個結(jié)論。

圖片

圖片

距離GPT-4發(fā)布已經(jīng)過去了一年多的時間,包括Gary Marcus和Yann LeCun在內(nèi)的很多人都不再對模型的Scaling Law深信不疑,甚至持否定態(tài)度。

雖然我們看起來正在碰壁,但Aschenbrenner提醒我們:往后退一步,看看AI已經(jīng)走了多遠。

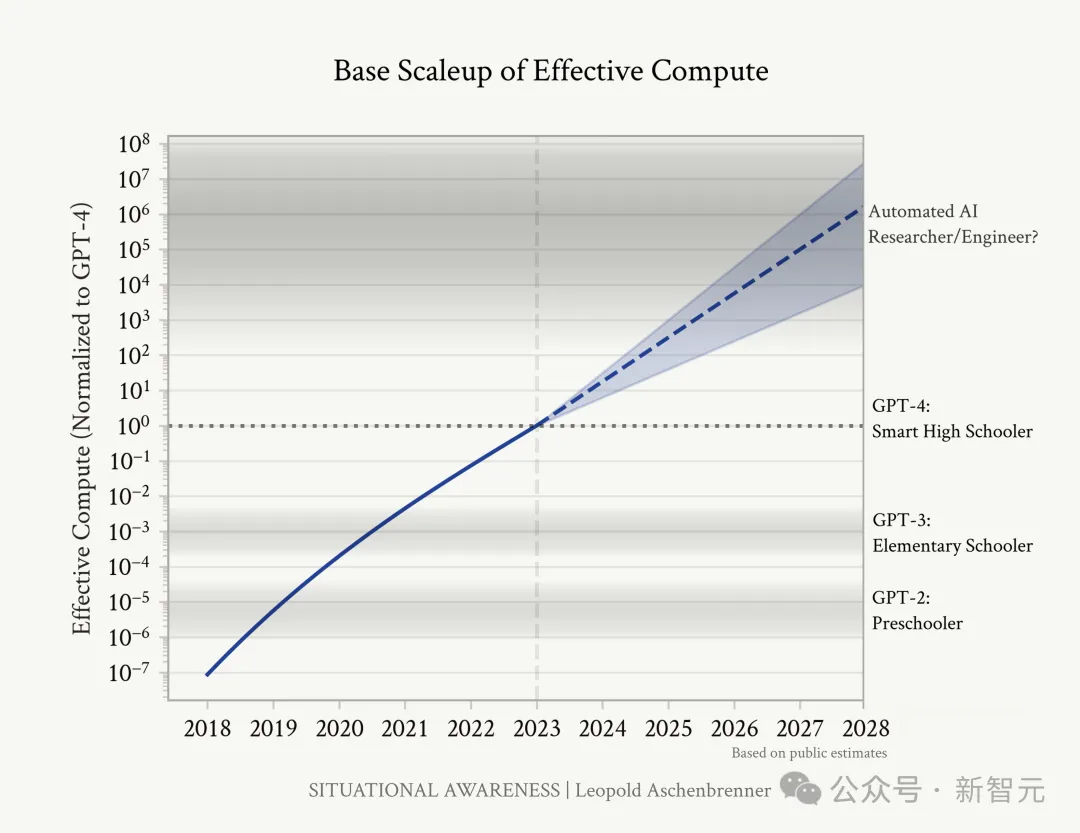

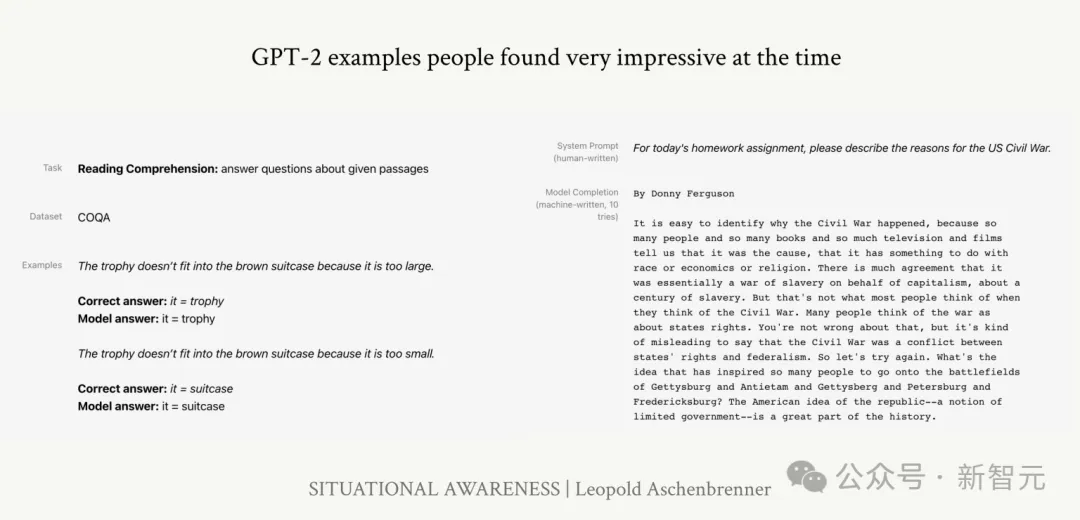

直覺上,我們可以將模型能力類比為人類的智能水平,從而衡量AI能力的進步:從2019年學(xué)齡前兒童水平的GPT-2,到2023年聰明高中生水平的GPT-4,OpenAI只用了4年。

用4年從學(xué)齡前讀到高中,是人類智力發(fā)展速度的3倍不止。

圖片

圖片

GPT-2只能寫出一個半連貫的段落,幾乎不能順利地從1數(shù)到5。在文章總結(jié)任務(wù)中,生成的結(jié)果只比隨機選3個句子稍微好一點。

圖片

圖片

GPT-3能生成更長、邏輯更一致的段落,具備了少樣本學(xué)習(xí)能力,還可以完成一些基本的算術(shù)或代碼任務(wù)。

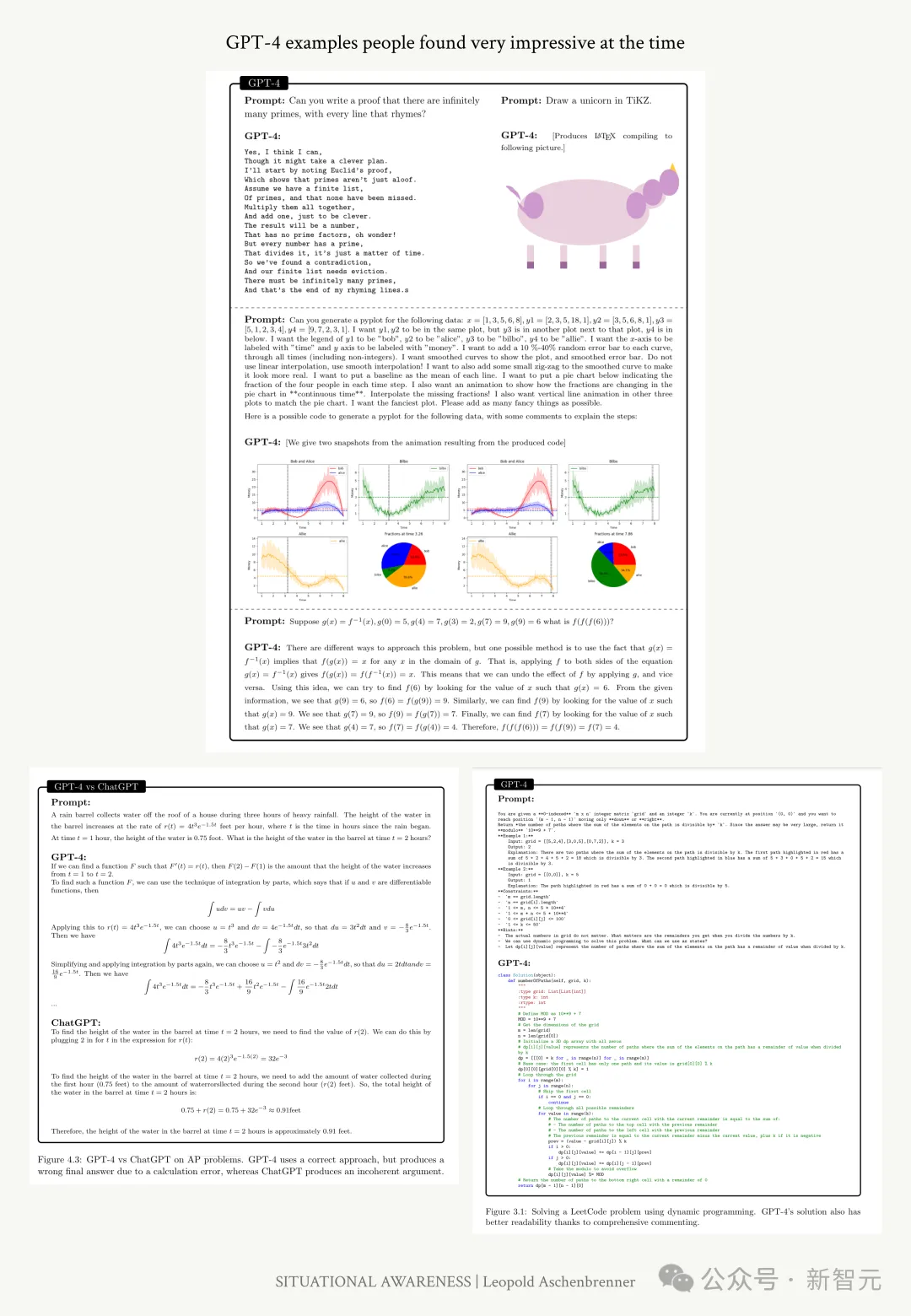

圖片

圖片

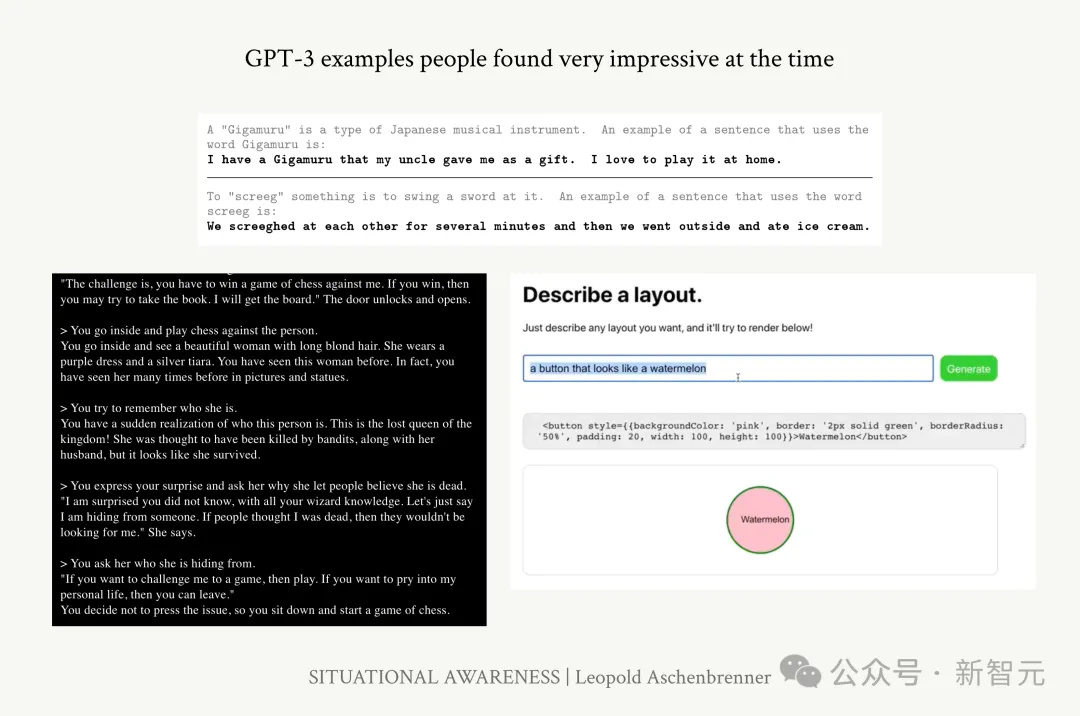

GPT-4不僅可以思考和推理數(shù)學(xué)問題,還能編寫復(fù)雜的代碼并迭代調(diào)試。語言能力也是飛躍性的提高,不僅能在更長的文本中實現(xiàn)邏輯和內(nèi)容的一致,也能掌握各種復(fù)雜話題。

在所有測試中,GPT-4都能擊敗絕大多數(shù)高中生,包括AP和SAT分?jǐn)?shù)。

圖片

圖片

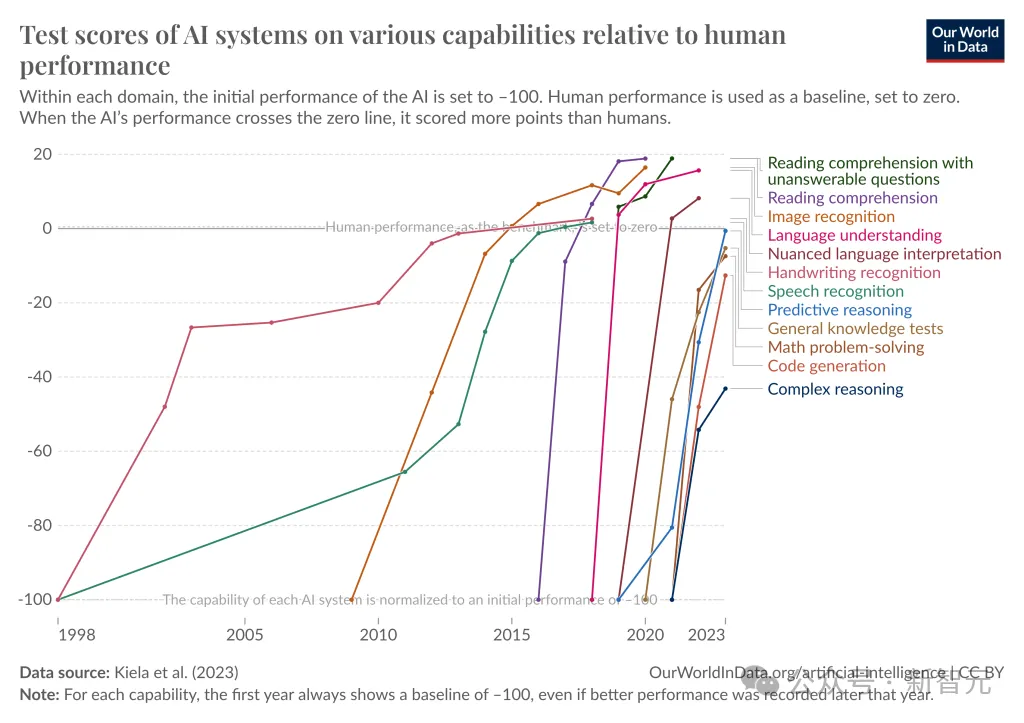

從基準(zhǔn)測試的角度衡量,可以看到下面這張圖。

根據(jù)Contextual AI去年7月發(fā)布的研究結(jié)果,AI在語言理解、閱讀理解、文字細微差異的解釋、圖像識別等方面的能力都已經(jīng)超過了人類表現(xiàn)。

圖片

圖片

預(yù)測性推理、一般性知識測試和解決數(shù)學(xué)問題等任務(wù)上也與人類水平接近。

此外也可以看出,在模型能力增長得越來越快的同時,基準(zhǔn)測試愈發(fā)捉襟見肘。

過去需要幾十年的時間才能達到飽和的基準(zhǔn)測試,現(xiàn)在只需要幾個月。

2020年,MMLU測試發(fā)布,相當(dāng)于高中和大學(xué)的所有最難考試的水平,研究人員希望它可以經(jīng)得起時間考驗。

結(jié)果僅僅三年后,LLM就幾乎解決了這個測試,像GPT-4和Gemini這樣的模型可以獲得超過90%的評分。

數(shù)學(xué)測試也是一樣的趨勢。

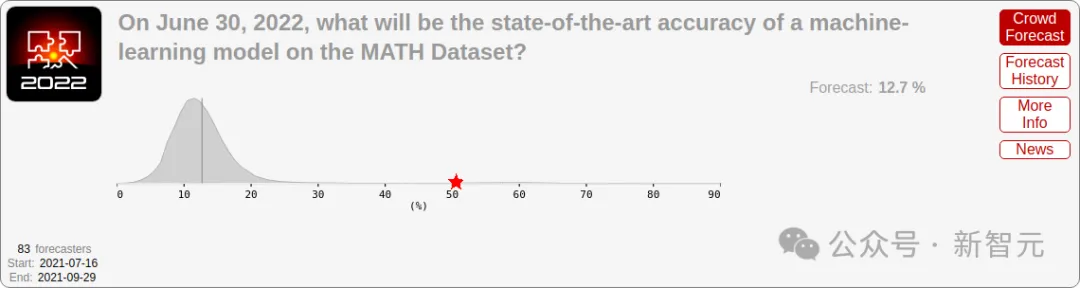

2021年MATH基準(zhǔn)發(fā)布時,SOTA模型只能正確回答約5%的問題。

當(dāng)時很多研究者都認為,算法方面的根本性突破才能提升模型的數(shù)學(xué)能力,未來幾年能取得的進展非常微小。

圖片

圖片

2021年,研究人員對模型未來在MATH數(shù)據(jù)集上的表現(xiàn)給出了非常悲觀的預(yù)測

然而,又一次超乎所有人的想象。2022年一年的時間內(nèi),模型準(zhǔn)確率從5%上升到50%,最近的SOTA可以達到90%。3年前公認難度很高的基準(zhǔn)測試,很快飽和。

基準(zhǔn)測試似乎也無法跟上模型的速度了。

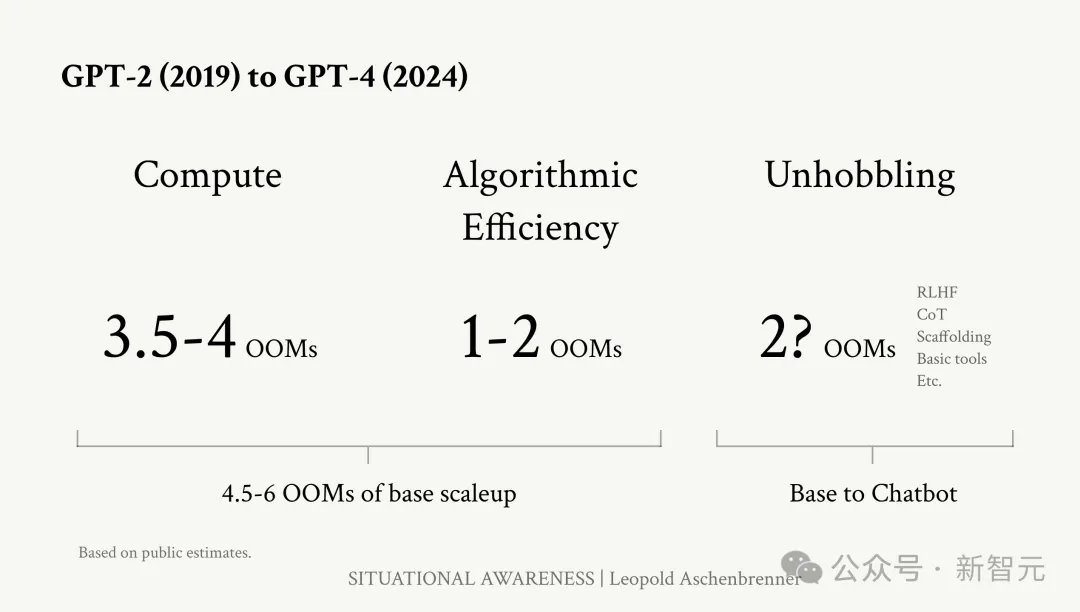

為了更嚴(yán)謹(jǐn)?shù)卦u估深度學(xué)習(xí)的發(fā)展速度和趨勢,作者使用了OOM指數(shù),即「計算數(shù)量級」(order of magnitude)。

不僅要考量模型的算力和算法效率,作者還引入了一種新的概念,「解開收益」(unhobbling gains)。

算力規(guī)模

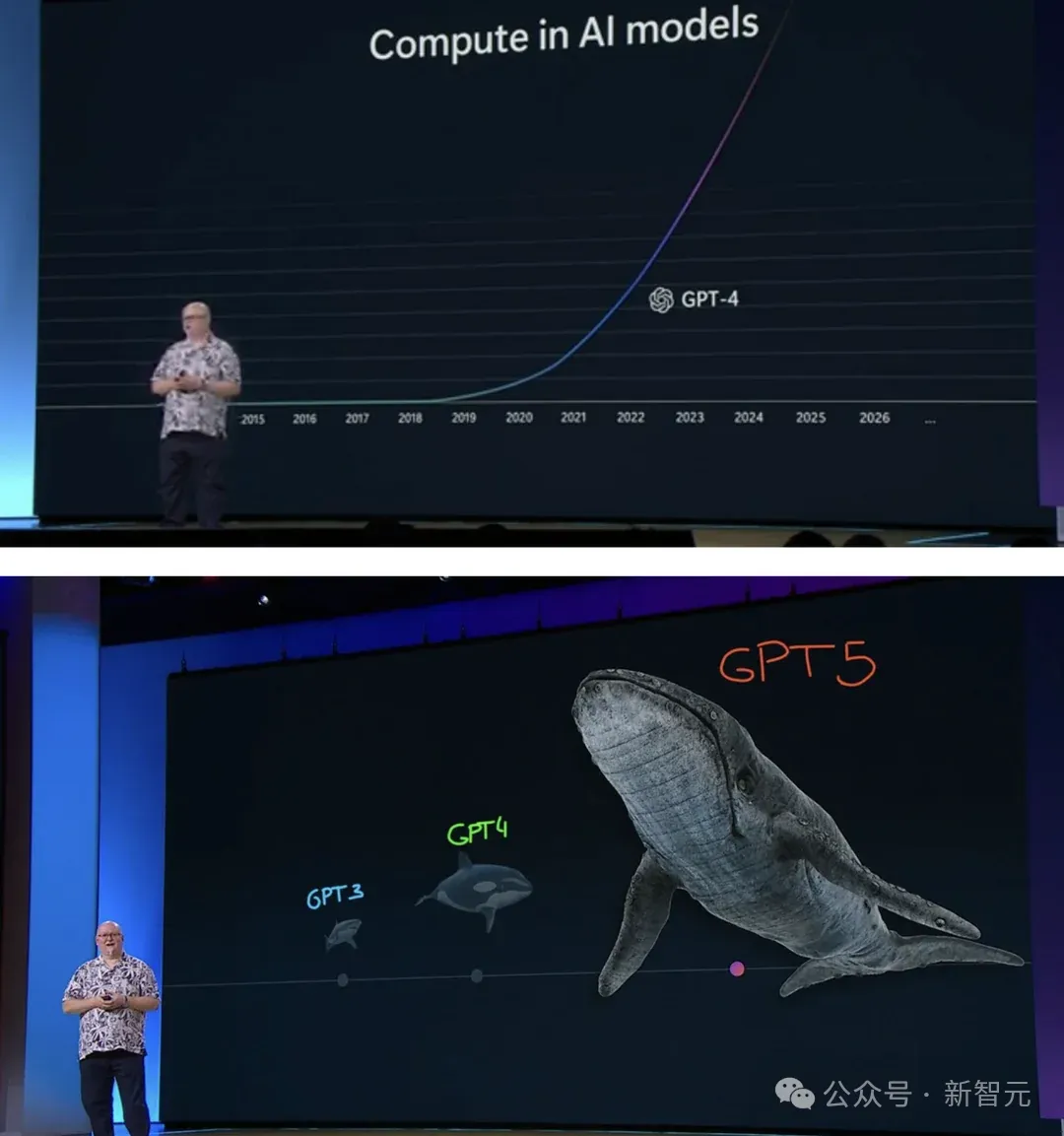

剛剛結(jié)束的ComputeX大會上,英偉達、AMD紛紛宣布了芯片年更計劃。

這說明了什么?大模型性能呈指數(shù)級增長,對算力需求也在不斷放大。

而在微軟Build大會上,CTO Kevin Scott更是用海洋動物形象地闡述了,OpenAI模型進階對算力的吞噬之極。

圖片

圖片

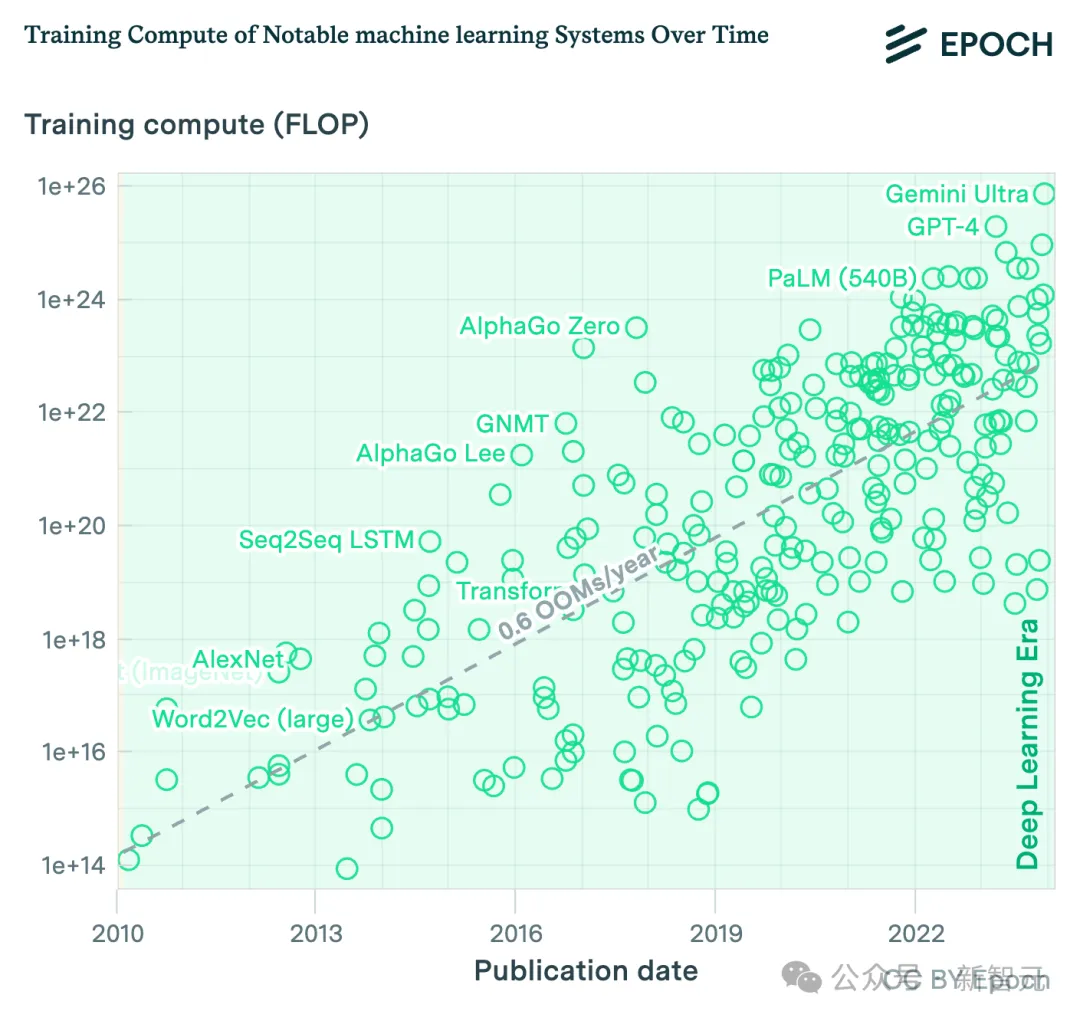

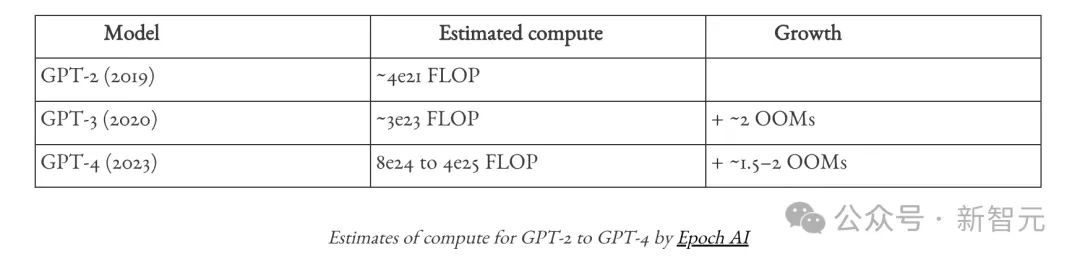

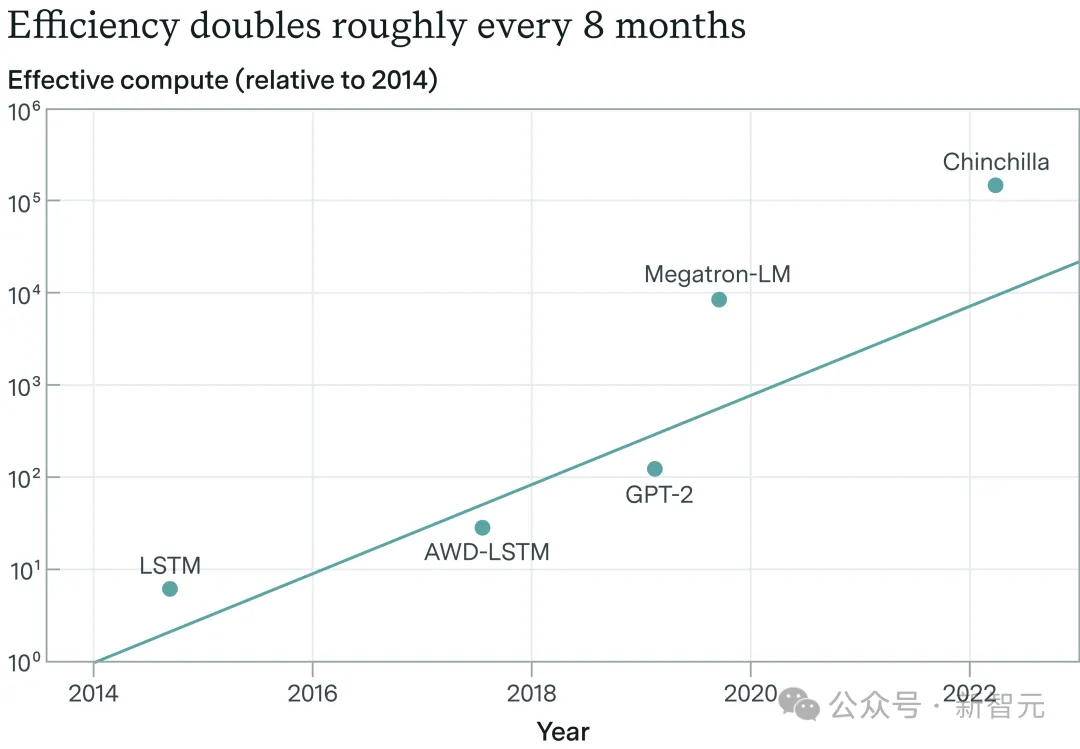

提到算力增長,很多人的第一反應(yīng)會認為,這是摩爾定律的延伸。

然而作者指出,事實并非如此。AI硬件的改進速度遠遠快于摩爾定律。

大模型時代來臨前,即使摩爾定律處于鼎盛時期,每10年也僅有1-1.5個OOM的增長。

但現(xiàn)在,每年都有0.6個OOM的增長,比曾經(jīng)摩爾定律的5倍還多。

圖片

圖片

Epoch AI對著名深度學(xué)習(xí)模型的訓(xùn)練算力進行估算

以GPT系列為例,GPT-2到GPT-3實現(xiàn)了設(shè)備的過渡,從較小的實驗設(shè)備變成了數(shù)據(jù)中心,一年內(nèi)增長了2個OOM。

GPT-4延續(xù)了這種戲劇性增長,而且從OpenAI囤積芯片的動作來看,這個增長速度會逐漸演變?yōu)殚L期趨勢。

這種龐大的增長,并不能主要歸因于摩爾定律,而是投資算力的熱潮。

曾經(jīng),在一個模型上花100萬美元是令人發(fā)指的想法,沒有人會接受;但現(xiàn)在,這只是科技巨頭囤芯片、訓(xùn)模型的零頭。

過去一年里,科技巨頭們談?wù)摰脑掝}已經(jīng)從100億美元計算集群轉(zhuǎn)向1000億美元集群,再變成萬億美元集群上的競爭。

每隔六個月,董事會的計劃里,就會增加一個「0」。

作者預(yù)估,「在這個十年結(jié)束之前,將有數(shù)萬億美元投入到GPU、數(shù)據(jù)中心和電力建設(shè)中。為支持AI的發(fā)展,美國至少將電力生產(chǎn)提高數(shù)十個百分點」。

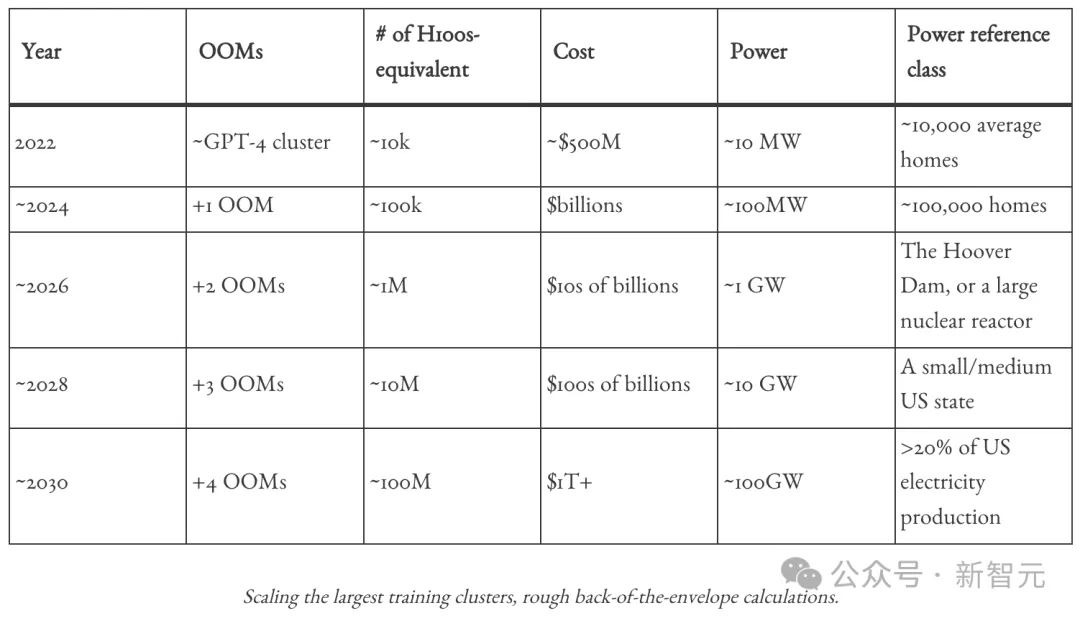

圖片

圖片

隨著AI產(chǎn)品收入的快速增長,谷歌、微軟等公司在2026年左右的年收入可能達到1000億美元。

這將進一步刺激資本,到2027年,每年的AI投資總額可能超過1T美元。

圖片

圖片

時間線再拉遠,到2028年,單個訓(xùn)練集群就需要耗資千億美元,比一個國際空間站還貴。

而到本世紀(jì)末,一個集群就能吞掉1T美元,每年產(chǎn)出上億個GPU,AI所需電力占美國發(fā)電總量的百分比,將從現(xiàn)在的不到5%上升到20%。

算法效率

對算力的瘋狂投資帶來的驚人收益是非常明顯的,但算法進步的驅(qū)動力很可能被嚴(yán)重低估了。

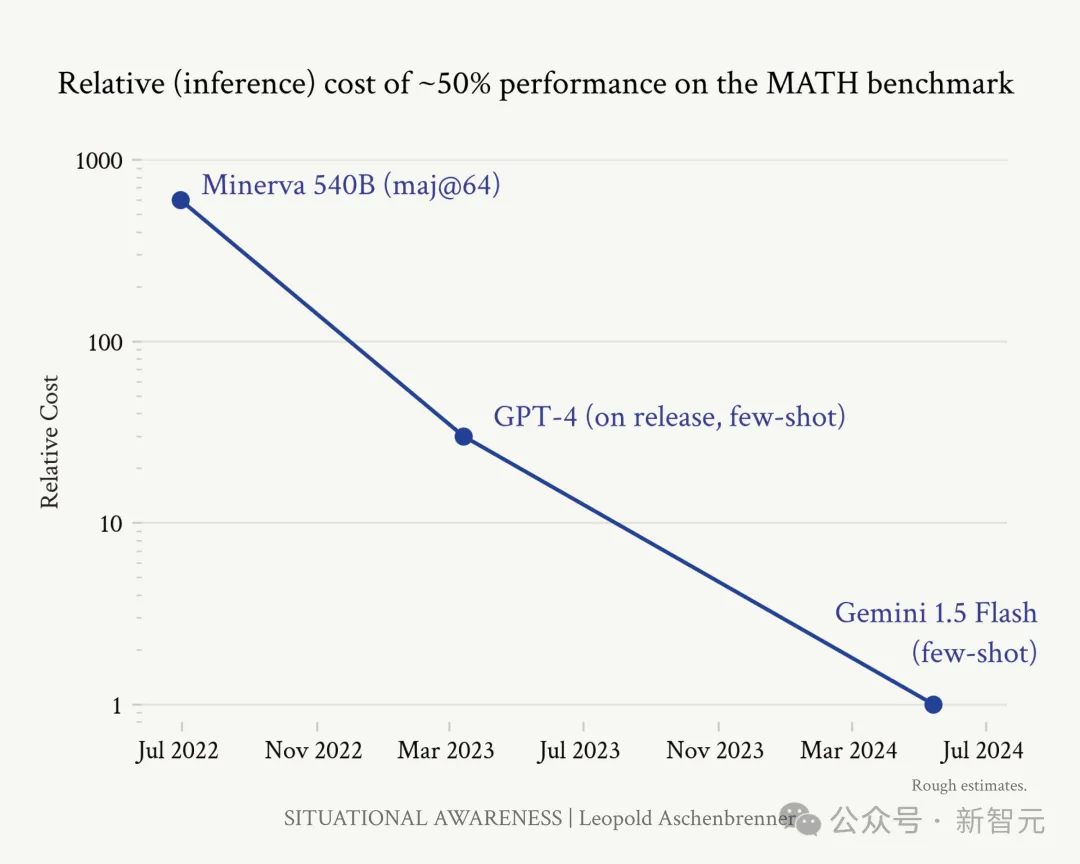

比如,很少有人關(guān)注到模型推理成本的大幅下降。

以MATH基準(zhǔn)測試為例,過去兩年內(nèi),從Minerva到最新發(fā)布的Gemini 1.5 Flash,在MATH上取得50%準(zhǔn)確率(一個不喜歡數(shù)學(xué)的計算機博士生可以得到40%)的推理效率提高了將近3個OOM,也就是1000倍的效率提升。

圖片

圖片

雖然推理效率不等同于訓(xùn)練效率,但這個趨勢可以表明,大量的算法進步是可行的,而且正在發(fā)生。

從長期趨勢來看,算法進展的速度也相當(dāng)一致,因此很容易根據(jù)趨勢線做出預(yù)測。

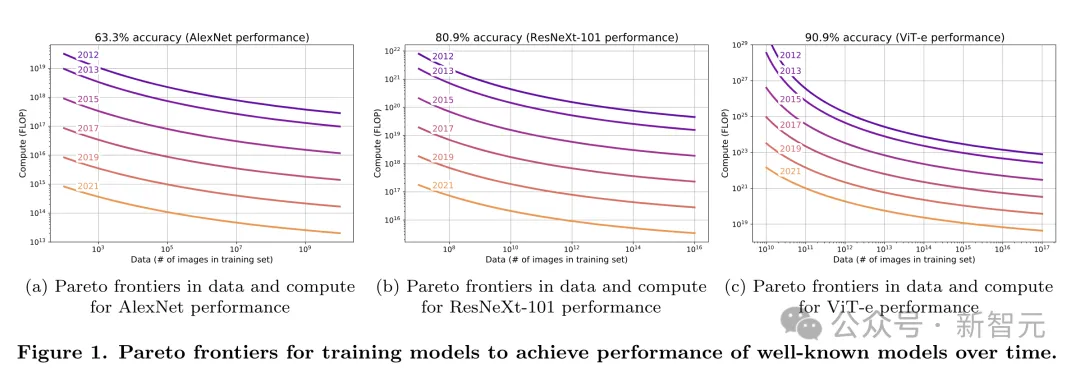

回顧2012年-2021年期間ImageNet上的公開算法研究,可以發(fā)現(xiàn),訓(xùn)練相同性能模型的計算成本以近乎一致的速度下降,每年減少約0.5個OOM,而且每種模型架構(gòu)都是如此。

圖片

圖片

雖然LLM的團隊一般不會公開算法效率相關(guān)的數(shù)據(jù),但根據(jù)Epoch AI的估算,2012年-2023年期間,每年算法效率的收益也約為0.5個OOM,也就是在8年時間里提升了1萬倍。

圖片

圖片

「解開」收益

相比算力和算法效率,「解開」收益帶來的提升更加難以量化。

所謂「解開收益」,是指某些情況下模型的原始能力被阻礙了,而通過簡單的算法改進可以解鎖和釋放這些潛在能力。

雖然它也是一種算法改進,但不僅僅是在已有范式內(nèi)提升訓(xùn)練效果,而是跳出訓(xùn)練范式,帶來模型能力和實用價值的躍升。

比如基礎(chǔ)的語言模型經(jīng)過了RLHF,才變成真正可用的產(chǎn)品。InstructGPT論文的量化結(jié)果顯示,根據(jù)人類評分者的偏好,有RLHF的小模型相當(dāng)于非RLHF的大100倍的模型。

再比如,近年來被廣泛使用的CoT可以為數(shù)學(xué)或推理問題提供10倍多的有效計算能力提升。

上下文長度的增加也是如此。從GPT-3的2k tokens、GPT-4的32k,到Gemini 1.5 Pro的1M+,更長的上下文可以解鎖更多的用例和應(yīng)用場景。

訓(xùn)練后改進(post-training improvment)帶來的收益也不容忽視。OpenAI聯(lián)創(chuàng)John Schulman表示,與GPT-4首次發(fā)布時相比,當(dāng)前的GPT-4有了實質(zhì)性的改進,這主要歸功于釋放潛在模型能力的后期訓(xùn)練。

Epoch AI進行的一項調(diào)查發(fā)現(xiàn),在許多基準(zhǔn)測試中,這類技術(shù)通常可以帶來5-30倍的有效計算收益。

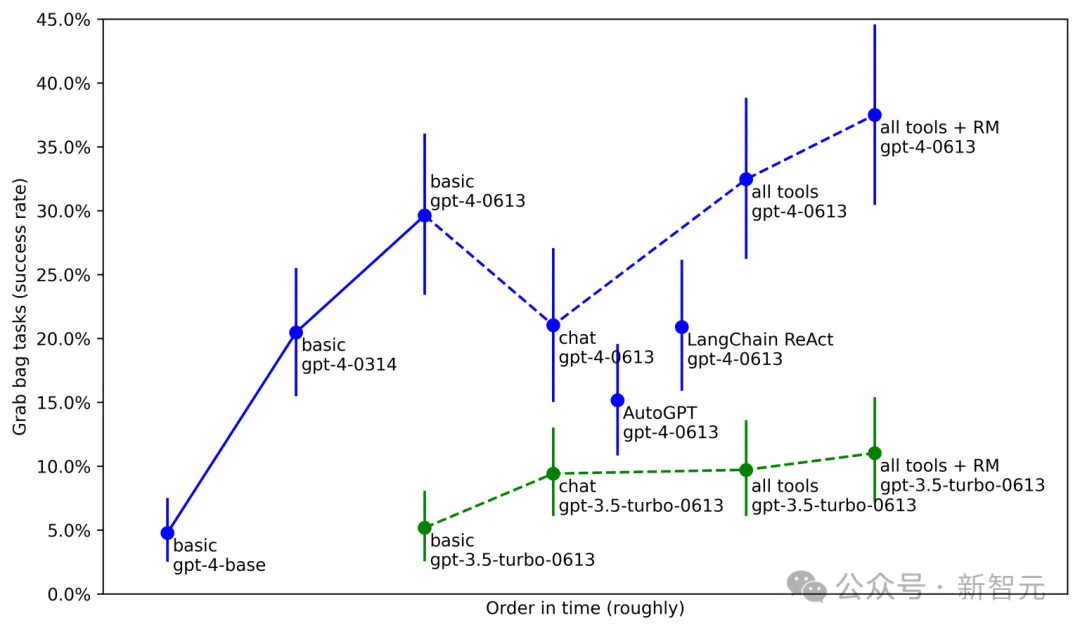

METR(一個評估模型的非營利組織)同樣發(fā)現(xiàn),基于相同的GPT-4基礎(chǔ)模型,「解開收益」非常可觀。

在各種代理任務(wù)中,僅使用基本模型時性能只有5%,經(jīng)過后期訓(xùn)練可以達到20%,加上工具、代理腳手架和更好的后期訓(xùn)練,可以達到今天的近40%。

圖片

圖片

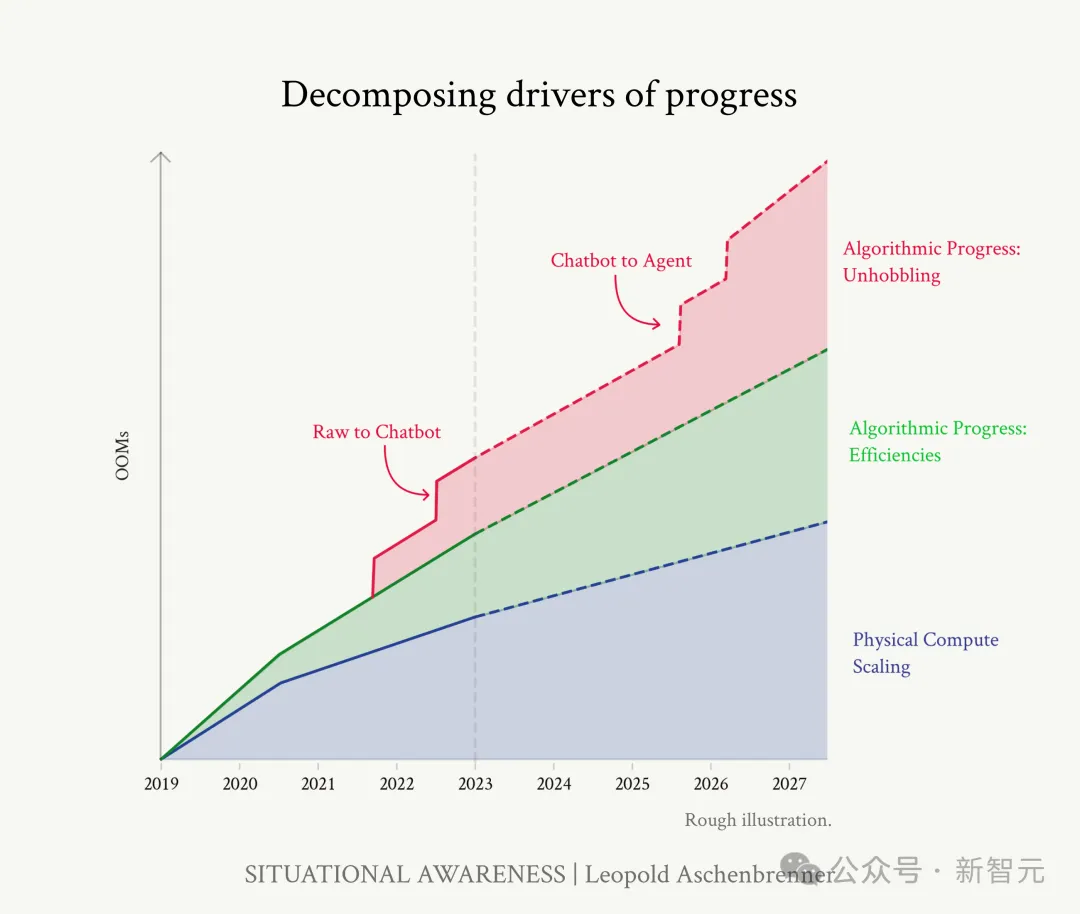

與算力和算法效率帶來的單一維度的擴展不同,「解開收益」能夠解鎖模型能力的巨大可能性,帶來「階梯式」、不拘一格的進步。

想象一下,如果AI可以使用電腦,有長期記憶,能針對一個問題進行長期思考和推理,而且具備了入職新公司所需的上下文長度,它會有多么強悍的能力?

圖片

圖片

算力、算法效率、「解開收益」疊加

2027年,取代所有認知工作

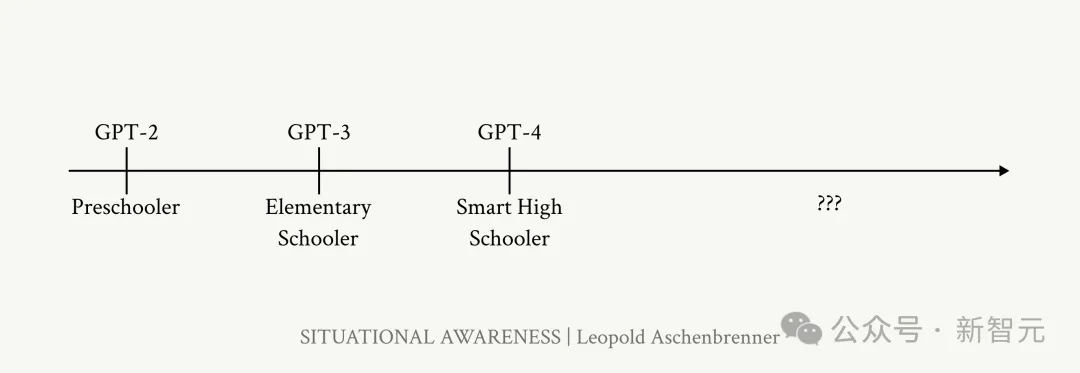

綜合考慮算力、算法效率與解開收益這三個方面的疊加,GPT模型從第2代到第4代,大致經(jīng)歷了4.5-6個OOM的有效計算擴展。

此外,從基本模型到聊天機器人,相當(dāng)于約2個OOM的「解開收益」。

圖片

圖片

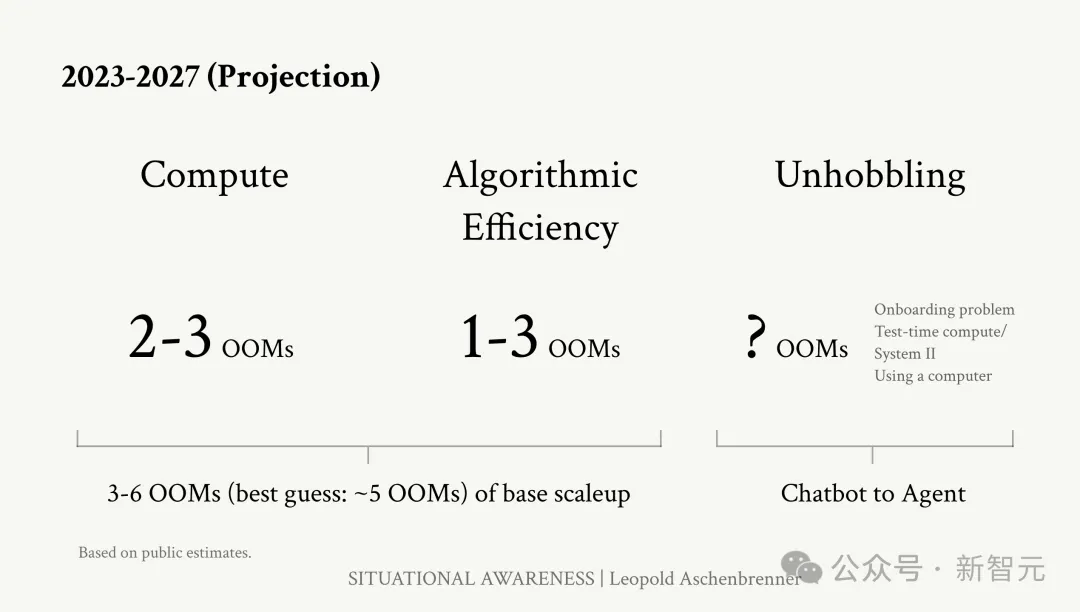

基于這個發(fā)展速度,數(shù)一數(shù)OOM,未來4年我們可以期待什么?

圖片

圖片

首先,隨著計算效率提高,迭代速度會越來越快。假設(shè)GPT-4訓(xùn)練花了3個月的時間,到2027年,領(lǐng)先的AI實驗室將能夠在一分鐘內(nèi)訓(xùn)練一個GPT-4級別的模型。

而且,由于「解開收益」的存在,我們不能僅僅是想象一個非常聰明的ChatGPT,還需要把它看成一個非常智能的、能獨立工作的Agent。

到2027年,這些AI系統(tǒng)基本上能夠自動化所有認知工作,或者說是所有可以遠程進行的工作。

但是作者同時也提醒道,這其中有很大的誤差范圍。如果「解開收益」逐漸停滯,或者算法的進展沒能解決數(shù)據(jù)耗盡的問題,就會推遲AGI的來臨時間。

但也有可能,「解開收益」釋放了模型更大的潛能,讓AGI的實現(xiàn)時間比2027年更早。

圖片

圖片

雖然這篇文章有比較全面的論據(jù),但「2027年實現(xiàn)AGI」的結(jié)論還是引發(fā)了不少網(wǎng)友的質(zhì)疑。

將GPT-4的智力水平類比成聰明的高中生,很難讓人相信。

圖片

圖片

也沒有談到一些關(guān)鍵問題,比如當(dāng)前LLM最大的挑戰(zhàn)之一——幻覺,這也是AI實現(xiàn)自動化工作的巨大障礙。

圖片

圖片

有人指責(zé)作者,將曲線外插和巨大的誤差范圍包裝成一份技術(shù)分析。

圖片

圖片

圖片

圖片

也有人指出,文中經(jīng)常提及的「有效計算」是一個非常模糊的概念,沒有進行嚴(yán)謹(jǐn)準(zhǔn)確的定義。

圖片

圖片

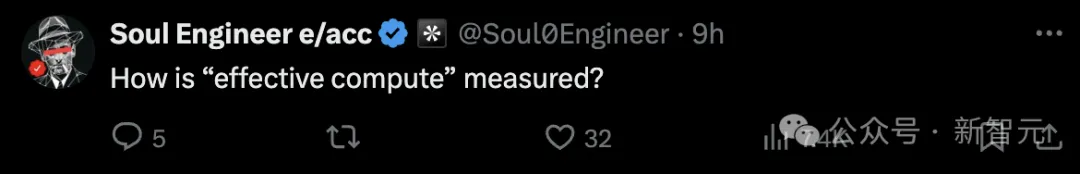

拋開2027年這個頗有噱頭的結(jié)論,作者的論證過程至少可以給我們一個啟示——很多情況下,AI的發(fā)展速度會超出所有人的想象。

圖片

圖片

GAN網(wǎng)絡(luò)從2014年到2018年的進展

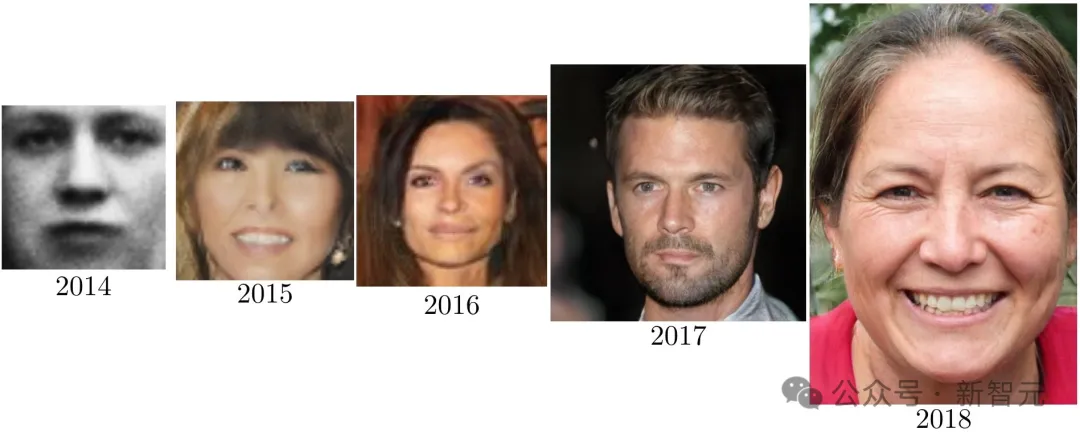

作者簡介

Leopold Aschenbrenner本科畢業(yè)于哥倫比亞大學(xué),大三時入選Phi Beta Kappa學(xué)會,并被授予John Jay學(xué)者稱號。

19歲時,以最優(yōu)等成績(Summa cum laude)畢業(yè),作為畢業(yè)生代表在典禮上致辭。

本科期間,他不僅獲得了對學(xué)術(shù)成就授以最高認可的Albert Asher Green獎,并且憑借著「Aversion to Change and the End of (Exponential) Growth」一文榮獲了經(jīng)濟學(xué)最佳畢業(yè)論文Romine獎。

圖片

圖片

Leopold Aschenbrenner來自德國,現(xiàn)居風(fēng)景優(yōu)美的加利福尼亞州舊金山,志向是為后代保障自由的福祉。

他的興趣相當(dāng)廣泛,從第一修正案法律到德國歷史,再到拓撲學(xué),以及人工智能。目前的研究專注于實現(xiàn)從弱到強的AI泛化。

圖片

圖片

他最近離開OpenAI后計劃創(chuàng)辦一家AGI領(lǐng)域的投資公司,已經(jīng)獲得了Stripe創(chuàng)始人Collison兄弟以及GitHub前CEO Nat Friedman的投資。

參考資料:https://situational-awareness.ai/from-gpt-4-to-agi/