i人小助手:Meta推出多模態對話圖,幫你輕松識別社交狀態

本文通訊作者為佐治亞理工學院計算機系博士生 Wenqi Jia(秋季起將轉入伊利諾伊香檳分校),導師為 James M. Rehg 及 Danfei Xu。她的主要研究方向聚焦于第一人稱視角下的人類行為分析及意圖理解,曾參與 Ego4D 項目,并在 CVPR,ECCV,ACL 等頂級會議上發表多篇論文。個人主頁:https://vjwq.github.io/

近年來興起的第一人稱視角視頻研究為理解人類社交行為提供了無法取代的直觀視角,然而,絕大多數的既往工作都側重于分析與攝像機佩戴者相關的行為,并未關注處于社交場景中其他社交對象的狀態。此外,多數現有模型能理解一種社交行為信號,而人類的實際社交行為是多樣且密集的:在一個嘈雜的面對面多人對話場景中,我們總是在主動判斷自己究竟在和誰說話,誰又在試圖聽我說話,也完全有能力推測這一群組中其他人之間的對話狀態。不難想象,如果有一個算法可以幫助快速準確地做出對當前社交狀態的判斷,將會極大助力我們日常溝通的質量和效率。

- 論文地址:https://arxiv.org/abs/2312.12870

- 項目主頁:https://vjwq.github.io/AV-CONV/

在今年 CVPR 上,來自佐治亞理工學院、Meta 和伊利諾伊香檳分校的研究者們提出了新問題:一個同時應用第一人稱視角音 - 視頻信號的多模態框架是否可以像人類一樣識別討論組里同時存在的、錯綜復雜的對話狀態?

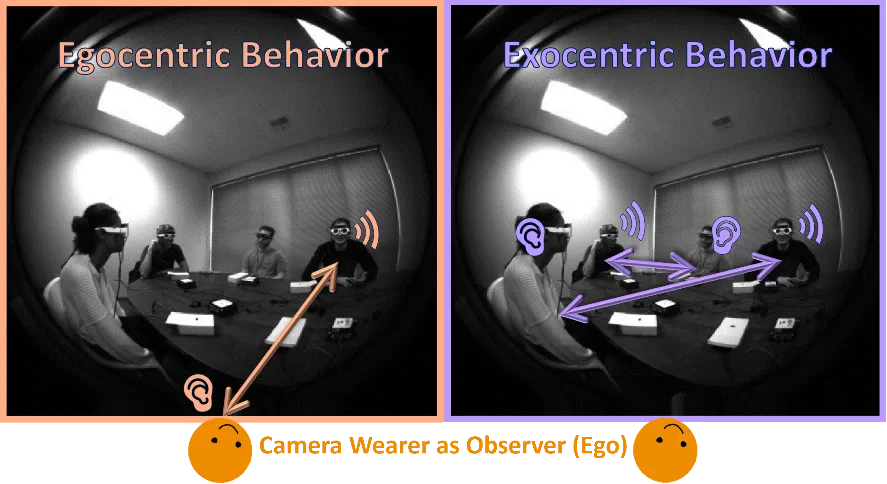

第一 (Ego) --- 第三 (Exo) 人稱對話行為

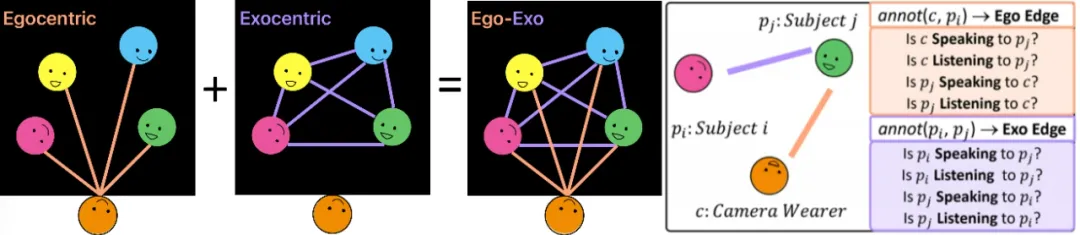

Ego-Exo 對話圖

對此,他們引入了一個有向的第一 (Ego) --- 第三 (Exo) 人稱對話圖的概念來進行社交行為建模。與視覺關系場景圖識別任務概念類似,這一任務旨在識別目標對之間的對話行為關系。具體來說,多人對話場景中包括相機佩戴者在內的每一個人都被表示為一個節點(node),當給定任意兩個節點 AB 時,對話圖利用連接他們的有向社交關系邊(directional edge)表示這個社交對之間存在怎樣的傾聽和講話屬性(A 是否在對 B 說話 / 傾聽,反之同理)。

第一 (Ego) --- 第三 (Exo) 人稱對話圖 兩個社交對的有向社交關系邊屬性

多模態對話注意力方法

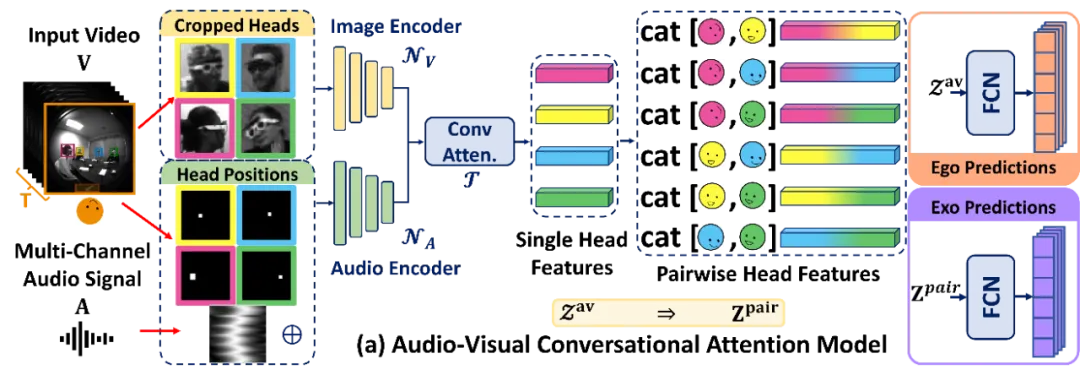

人類在進行多人對話的社交活動時自然地利用著音視頻信號的協同:我們需要視覺輸入幫助識別社交對象的位置和外觀,同時需要音頻信號幫助確認哪些社交對象在發言。受此啟發,該研究提出了一個統一的端到端多模態框架 --- 音視頻對話注意力(AV-CONV),通過采用自注意力機制來建模跨時間、跨主體和全局 - 局部跨模態的表示來幫助解決這一對話圖識別任務。

音視頻對話注意力(AV-CONV)模型結構

這一框架包含了兩個主要組件:1)社交對象多模態特征的生成;2)利用對話注意力模塊(Conversational Attention)對多模態特征的增強,特征對的組裝及輸出預測。

對于每個時長為 3 秒鐘的視頻輸入,AV-CONV 接收 6 個均勻采樣的第一人稱視頻幀和相應的多通道音頻信號。在每一幀上,人臉檢測算法幫助裁剪出所有可見的社交對象面部作為視覺信號。同時,這些人臉在視頻幀上的相對位置以二值掩膜(binary mask)的形式與音頻信號串連,生成具有位置敏感性的聽覺輸入。這些視覺和音頻信號由兩個獨立的 ResNet18 網絡編碼,然后連接起來形成多模態音視頻特征。

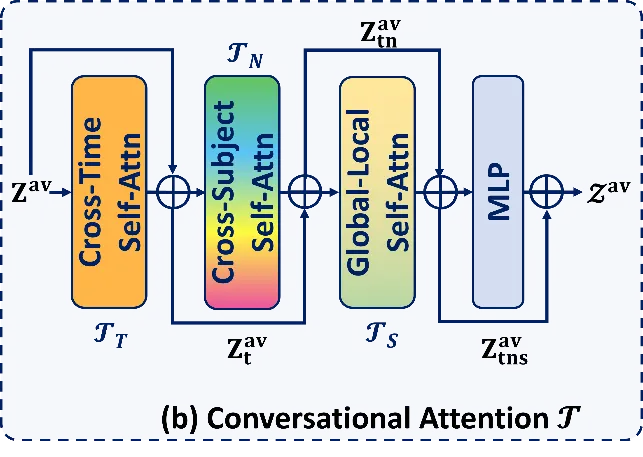

對話注意力模塊(Conversational Attention)細節

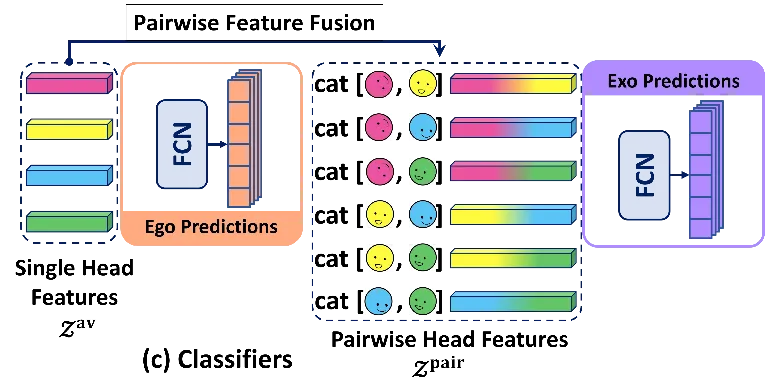

社交對象特征對組裝及預測頭

接下來,由三個雙層自注意力子模塊組成的對話注意力模塊會從時間維度、不同社交對象維度和不同模態維度對這些多模態特征進行增強,這些特征會被直接輸入一組分類器,以得到對包含相機佩戴者在內的社交對的關系預測結果。

此外,任意兩個社交對象特征被組合成第三人稱視角下的社交特征對。它們被輸入另一組分類器,以得到對不包含相機佩戴者在內的其它社交對的關系預測結果。

對比及消融實驗

這一方法在第一人稱并發對話數據集 (Egocentric Concurrent Conversations Dataset) 上進行實驗以驗證其有效性。在這個數據集中,每個數據采集場景由被分為兩組同時分別進行對話的 5 個人組成。該數據集收集了來自 50 名不同參與者的第一人稱視頻,總時長約為 20 小時。

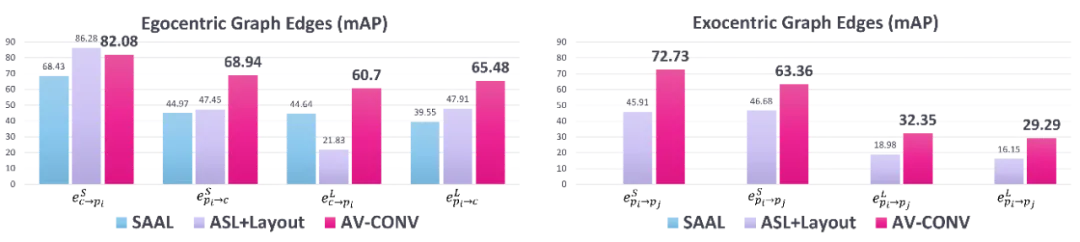

基準比較實驗結果

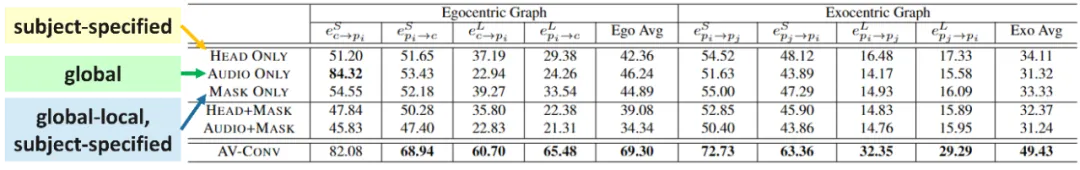

對比實驗采用了兩個相關工作的擴展變體(SAAL, ASL+Layout)作為基準。實驗結果表明,AV-CONV 在所有任務和指標上都大幅領先基準值。此外,一系列針對對話注意力模塊和模型輸入的消融實驗進一步探索了模型設計細節的有效性。

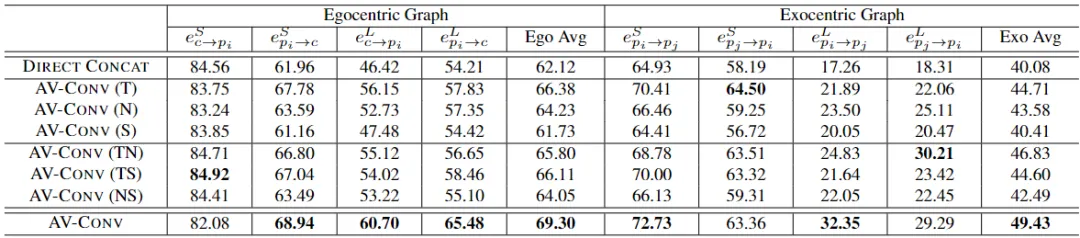

具體來說,對話注意力模塊中每個組件及其不同的組合都會對整體性能產生影響。可以看到,完全去掉整個注意力模塊的直接連接(DIRECT CONCAT)方法在幾乎所有任務中都表現最差,而單獨使用跨時間注意力(Cross-Time attention)、跨主體注意力(Cross-Subject attention)或全局 - 局部(Global-Local attention)跨模態注意力都對提升性能有積極的貢獻。值得注意的是,跨時間的注意力帶來了最大的增益,表明從相鄰幀中聚合信息對于更可靠地檢測語音活動至關重要。

針對模型輸入的消融實驗也揭示了不同模態對整體性能的影響。AV-CONV 的輸入模態包括三個部分:1) 從第一人稱視頻幀裁剪的社交對象頭部圖像。2) 包含來自第一人稱視頻的多通道音頻的全局特征。3) 頭部圖像的二值掩碼,指定了幀中每個個體的位置,并作為一種介于全局和局部信息之間的表示。實驗結果表明,僅使用頭部圖像會導致所有與說話相關的任務性能顯著下降,因為理解說話行為需要音頻信息的輸入。另一方面,僅使用音頻有助于識別相機佩戴者的聲音活動,但在其他需要與對話伙伴相關的局部特征的任務上表現不佳。僅使用位置掩碼的表現與僅使用頭部圖像相似,但它可以通過整個場景中頭部位置的抽象表示推斷出社交伙伴之間的潛在關系。例如,在與傾聽相關的子任務上,它的表現優于僅使用頭部圖像,可能是因為這些任務更多地依賴于空間中社交對象的位置信息。

在這個示例中,攝像機佩戴者和其他兩個社交對象同時與他人進行對話。在整個 3 秒的時間窗口內,一些發言者保持持續的對話,而其他人則暫停后繼續。從預測值(黃色框)和真實值(綠色框)的對比中可以看到,AV-CONV 能夠迅速捕捉到樣本中發生的每一個動態演變,并給出準確的預測。

后續工作展望

受限于數據集類型和采集設備,這一工作局限于對話中的社交行為。然而提出的社交圖概念可以輕松推廣到對其他人類行為,如眼神交流或身體語言的分析。其他可能的后續工作包括使用大生成對話群組的提要及情感分析,以及從未經預定義群組的自由多人對話中挖掘對話群組的分裂、合并等復雜群體動態。