全面超越Transformer!清華螞蟻推出純MLP架構,長短程時序預測大幅提升

Transformer很強,Transformer很好,但Transformer在處理時序數據時存在一定的局限性。

如計算復雜度高、對長序列數據處理不夠高效等問題。

而在數據驅動的時代,時序預測成為許多領域中不可或缺的一部分。

于是乎,螞蟻同清華聯合推出一種純MLP架構的模型TimeMixer,在時序預測上的性能和效能兩方面全面超越了Transformer模型。

他們結合對時序趨勢周期特性的分解以及多尺度混合的設計模式,不僅在長短程預測性能上大幅提升,而且基于純MLP架構實現了接近于線性模型的極高效率。

來康康是如何做到的?

純MLP架構超越Transformer

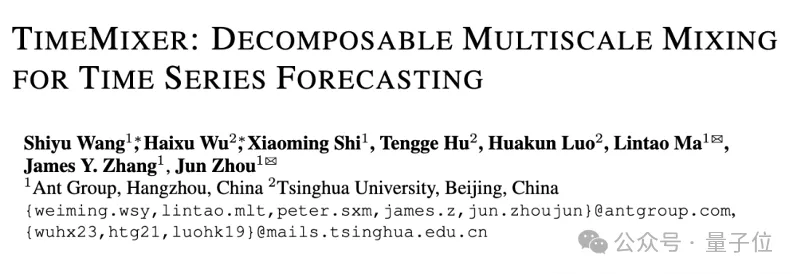

TimeMixer模型采用了一個多尺度混合架構,旨在解決時間序列預測中的復雜時間變化問題。

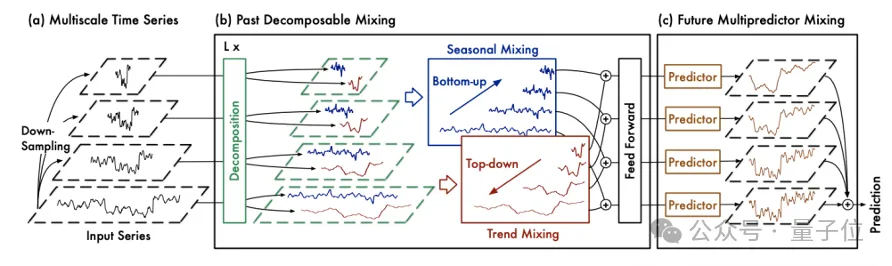

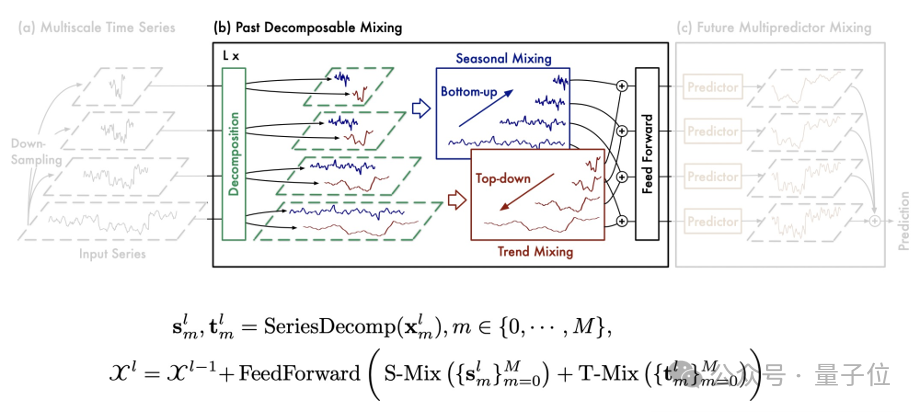

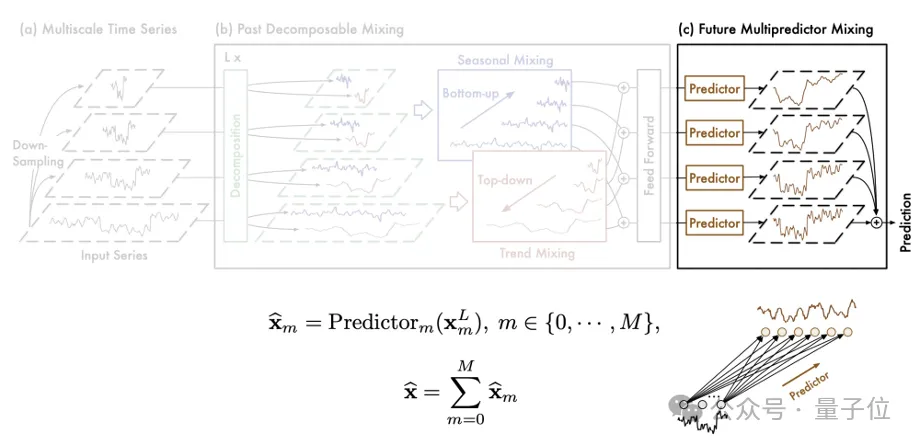

該模型主要采用全MLP(多層感知機)架構,由過去可分解混合Past Decomposable Mixing (PDM) 和未來多預測器混合Future Multipredictor Mixing (FMM) 兩大塊構成,能夠有效利用多尺度序列信息。

其中PDM模塊,負責提取過去的信息并將不同尺度上的季節性和趨勢組分分別混合。

PDM以季節和趨勢混合為動力,將詳細的季節信息由細到粗逐步聚合,并利用較粗尺度的先驗知識深入挖掘宏觀趨勢信息,最終實現過去信息提取中的多尺度混合。

FMM則是多個預測器的集合,其中不同的預測器基于不同尺度的過去信息,使 FMM 能夠集成混合多尺度序列的互補預測功能。

實驗效果

為了驗證TimeMixer的性能,團隊在包含長程預測,短程預測,多元時序預測以及具有時空圖結構的18組基準數據集上進行了實驗,包括電力負荷預測、氣象數據預測和股票價格預測等。

實驗結果表明,TimeMixer在多個指標上全面超越了當前最先進的Transformer模型,具體表現如下:

預測精度:在所有測試的數據集上,TimeMixer均表現出更高的預測精度。以電力負荷預測為例,TimeMixer相比于Transformer模型,平均絕對誤差(MAE)降低了約15%,均方根誤差(RMSE)降低了約12%。

計算效率:得益于MLP結構的高效計算特性,TimeMixer在訓練時間和推理時間上均顯著優于Transformer模型。實驗數據顯示,在相同硬件條件下,TimeMixer的訓練時間減少了約30%,推理時間減少了約25%。

模型可解釋性:通過引入Past Decomposable Mixing和Future Multipredictor Mixing技術,TimeMixer能夠更好地解釋不同時間尺度上的信息貢獻,使得模型的決策過程更加透明和易于理解。

泛化能力:在多個不同類型的數據集上進行測試,TimeMixer均表現出良好的泛化能力,能夠適應不同的數據分布和特征。這表明TimeMixer在實際應用中具有廣泛的適用性。

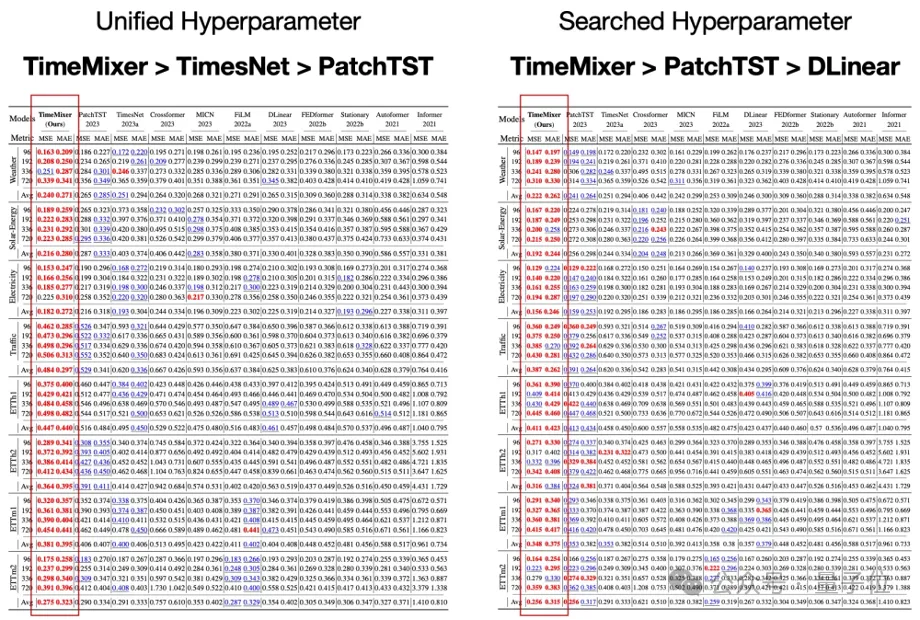

長程預測:為了確保模型比較的公平性,使用標準化參數進行實驗,調整輸入長度、批量大小和訓練周期。此外,鑒于各種研究的結果通常源于超參數優化,該研究還包括了綜合參數搜索的結果。

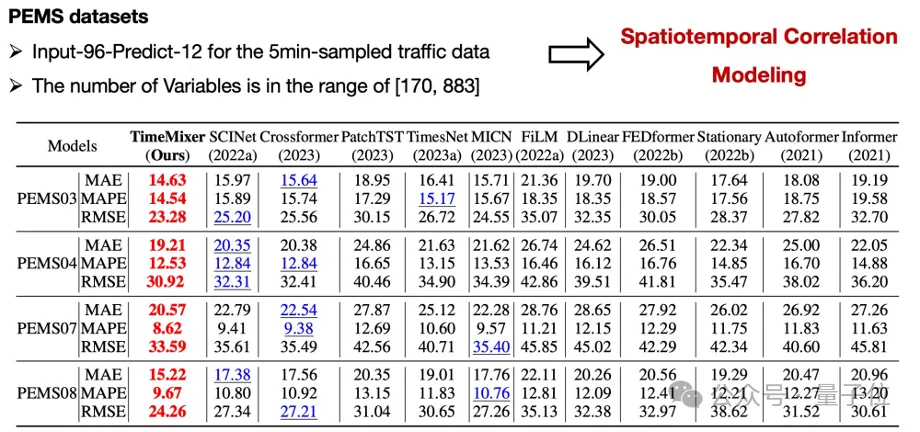

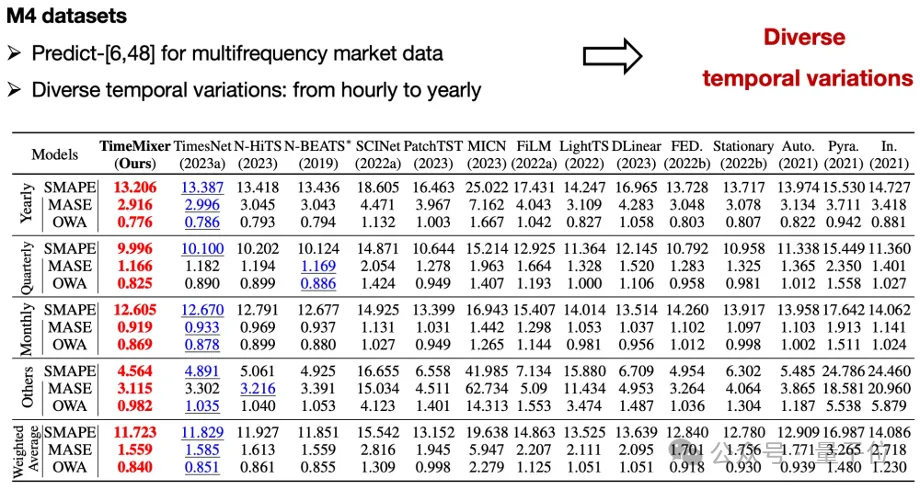

短程預測:多變量數據

短程預測:單變量數據

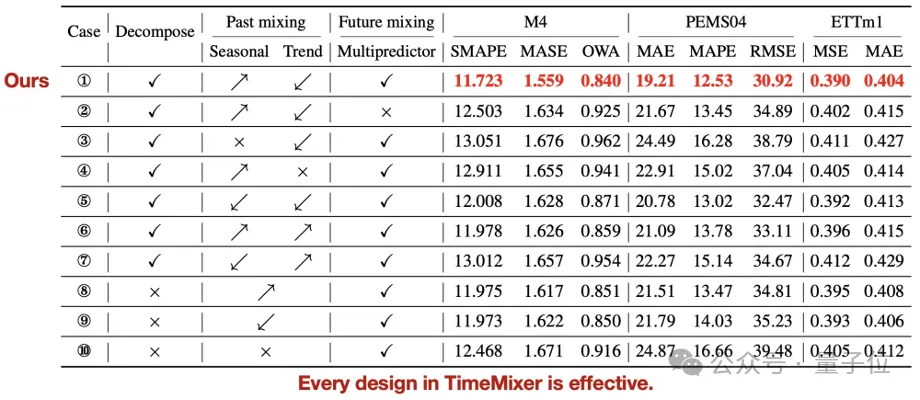

消融實驗:為了驗證 TimeMixer 每個組件的有效性,我們在所有 18 個實驗基準上對 Past-Decomposable-Mishing 和 Future-Multipredictor-Mishing 模塊中的每種可能的設計進行了詳細的消融研究。

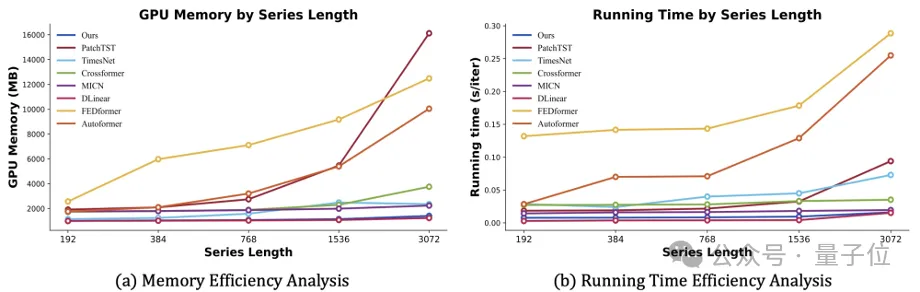

模型效率:團隊將訓練階段的運行內存和時間與最新最先進的模型進行比較,其中 TimeMixer 在 GPU 內存和運行時間方面,對于各種系列長度(范圍從 192 到 3072)始終表現出良好的效率),此外還具有長期和短期預測任務一致的最先進性能。

值得注意的是,TimeMixer 作為深度模型,在效率方面表現出接近全線性模型的結果。這使得 TimeMixer 在各種需要高模型效率的場景中大有前途。

好了,TimeMixer為時序預測領域帶來了新的思路,也展示了純MLP結構在復雜任務中的潛力。

未來,隨著更多優化技術和應用場景的引入,相信TimeMixer將進一步推動時序預測技術的發展,為各行業帶來更大的價值。

本項目獲得了螞蟻集團智能引擎事業部旗下AI創新研發部門NextEvo支持。

螞蟻集團NextEvo-優化智能團隊負責螞蟻運籌優化、時序預測以及預測優化相結合的智能決策等技術方向,團隊工作涵蓋算法技術、平臺服務和解決方案的研發。

論文地址:https://arxiv.org/abs/2405.14616v1

論文代碼:https://github.com/kwuking/TimeMixer