單張A100全精度推理!谷歌明星開源模型Gemma 2上新9B/27B,挑戰(zhàn)3140億Grok-1

就在昨晚,谷歌的明星開源大模型系列,又迎來兩位新成員——Gemma 2 9B和Gemma 2 27B!

四個月前谷歌宣布重磅開源Gemma,四個月后Gemma 2上線,專門面向研究和開發(fā)人員。

目前,模型權(quán)重已經(jīng)在HuggingFace上公開。

項(xiàng)目地址:https://huggingface.co/collections/google/gemma-2-release-667d6600fd5220e7b967f315

Gemma 2的核心亮點(diǎn)概括來說就是:參數(shù)雖小但性能極佳。

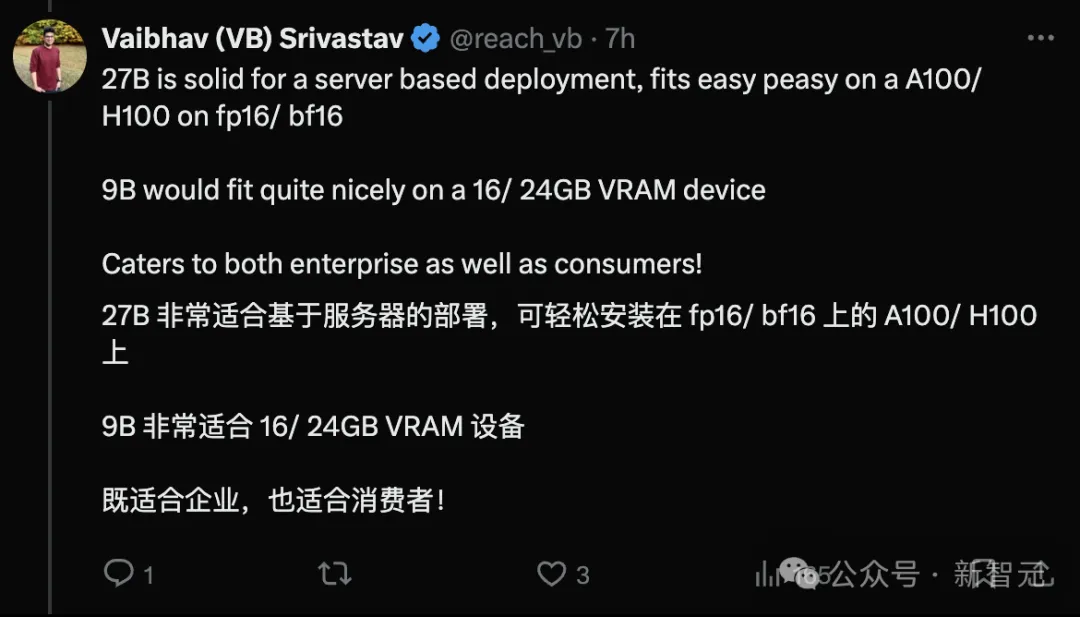

而且,27B模型甚至可在單張谷歌云TPU、英偉達(dá)A100 80GB GPU或英偉達(dá)H100 GPU上,以全精度高效運(yùn)行推理。

高效新模型的誕生

Gemma 2在設(shè)計(jì)的架構(gòu)上均有創(chuàng)新,旨在實(shí)現(xiàn)卓越的性能和提高推理效率。

在技術(shù)報(bào)告中,Gemma 2最引人注目的三大創(chuàng)新優(yōu)勢在于:

首先,性能遠(yuǎn)超同同等規(guī)模模型。

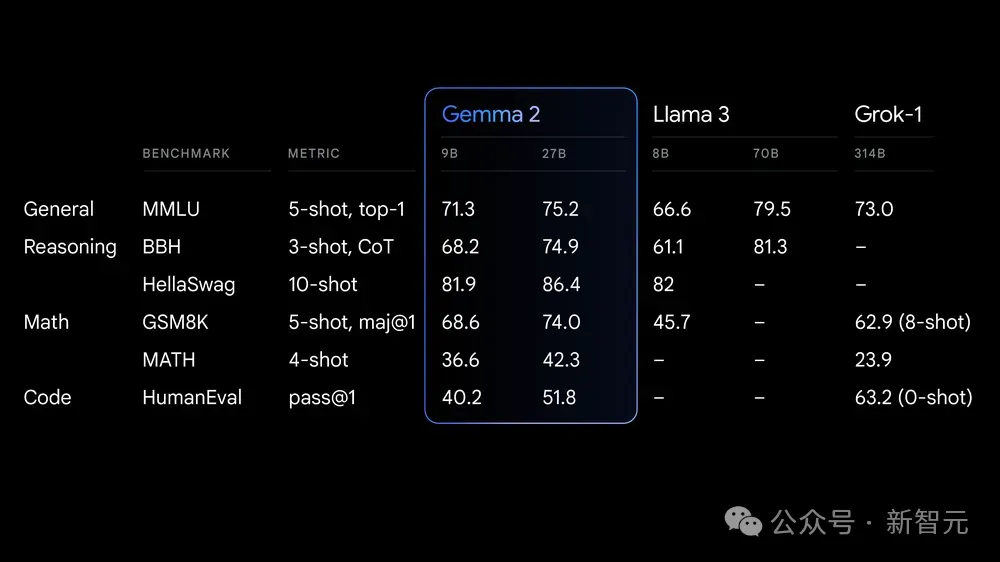

Gemma 2 27B在同類產(chǎn)品中性能最佳,甚至能挑戰(zhàn)規(guī)模更大的模型。

Gemma 2 9B的性能在同類產(chǎn)品中也處于領(lǐng)先地位,超過了Llama 3 8B和其他同規(guī)模的開源模型。

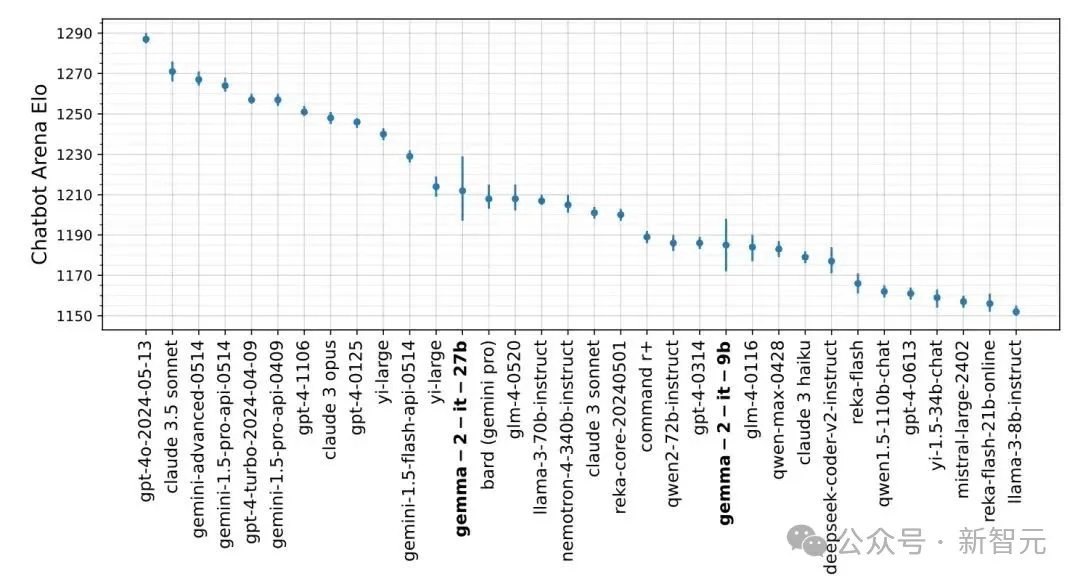

與其他大模型在Lmsys同場競技,同等規(guī)模模型中Gemma 2的性能「一覽眾山小」。

其次,超高效率,節(jié)約成本。

27B模型可用于在單個谷歌Claude TPU主機(jī)或NIVIDIA H100 GPU上以全精度高效運(yùn)行推理,從而在保持高性能的同時大幅降低成本。

用較小的模型規(guī)模能夠在更廣泛的硬件上部署,對于開發(fā)者和研究人員帶來許多便利。

最后,能夠跨硬件快速推理。

Gemma 2經(jīng)過優(yōu)化,可在各種硬件上以驚人的速度運(yùn)行。

比如在Google AI Studio中嘗試全精度的Gemma 2,在CPU上使用量化版本 Gemma.cpp解鎖本地性能,或通過 Hugging Face Transformers庫在配備英偉達(dá)RTX或GeForce RTX的家用電腦上,均可使用。

高效的源頭:架構(gòu)創(chuàng)新

Gemma是谷歌團(tuán)隊(duì)推出的一系列輕量級、先進(jìn)的開源模型,基于與Gemini模型相同的研究和技術(shù)構(gòu)建的文本生成解碼器大型語言模型。

Gemma 2訓(xùn)練數(shù)據(jù)量大約是第一代的兩倍,并沿用了上一代的基本架構(gòu),但進(jìn)行了全方位的改良。

局部滑動窗口和全局注意力

Gemma 2交替使用局部滑動窗口注意力和全局注意力層級進(jìn)行切換,局部注意力層的滑動窗口大小設(shè)置為4096個token,而全局注意力層的設(shè)置為8192個token。

在正確捕捉文本細(xì)節(jié)的同時,又能保持對上下文和全局的正確理解。

Logit軟上限

按照Gemini 1.5版,Gemma對每個注意層和最終層的logit進(jìn)行軟封頂。

通過將logits設(shè)置在一個合理的固定范圍內(nèi),可以有效提升訓(xùn)練的穩(wěn)定性,防止內(nèi)容過長。

使用RMSNorm進(jìn)行前后歸一化

為了使訓(xùn)練更加穩(wěn)定,Gemma 2運(yùn)用了RMSNorm對每個轉(zhuǎn)換層、注意層和反饋層的輸入和輸出進(jìn)行歸一化。

這一步和Logit軟上限都使得模型訓(xùn)練更穩(wěn)定平滑,不易出現(xiàn)崩潰。

分組查詢注意力

GQA通過對于注意力分組,將算力用于一組注意力的組內(nèi)。

在計(jì)算時顯示出更快的數(shù)據(jù)處理速度,同時還能保持下游性能。

知識蒸餾

傳統(tǒng)訓(xùn)練大語言模型的方法主要是根據(jù)上一個Token,預(yù)測下一個Token,需要大量的數(shù)據(jù)進(jìn)行訓(xùn)練。

但是,人類的學(xué)習(xí)過程并不依賴走量的知識輸入。比如,一位學(xué)生由于閱讀原著的需要學(xué)習(xí)一門外語,他并不需要看遍所有的書籍,只需要以一本書為綱,通過理解后融會貫通。

而知識蒸餾法與人的學(xué)習(xí)過程更加類似。一個小模型向另一個已經(jīng)進(jìn)行過預(yù)訓(xùn)練的大模型學(xué)習(xí),通過這種方式助產(chǎn)小模型對于Token的預(yù)測。

站在老師模型的肩膀上,學(xué)生模型能用較少的訓(xùn)練數(shù)據(jù)達(dá)到更好的效果。

功能強(qiáng)大,實(shí)用為先

人工智能有可能解決人類一些最緊迫的問題,但前提是每個人都擁有使用人工智能的工具。

因此,Gemma 2非常注重實(shí)用性,輕量級且開源是Gemma 2最核心的兩個關(guān)鍵詞。

Gemma 2同樣沿用了Gemma 1的許可證,使開發(fā)人員和研究人員能夠共享他們的創(chuàng)新成果并將其商業(yè)化。

此外,Gemma 2具有廣泛的框架兼容性。

Gemma 2可通過本地Keras 3.0、vLLM、Gemma.cpp、Llama.cpp與Ollama、Hugging Face Transformers等主要人工智能框架兼容,從而輕松地將 Gemma 2與個人偏好的工具和工作流程結(jié)合使用。

從下個月開始,Google Cloud客戶將能夠在Vertex AI上輕松部署和管理Gemma 2。

例如,用戶可以自己探索新的Gemma Cookbook,其中包含一系列實(shí)用示例和codebook;也可指導(dǎo)構(gòu)建自己的應(yīng)用程序,并針對特定任務(wù)微調(diào)Gemma 2模型。

因此,Gemma 2對于個人使用非常便利,能夠輕松地將Gemma與各類工具結(jié)合使用,包括用于精準(zhǔn)檢索等常見任務(wù)。

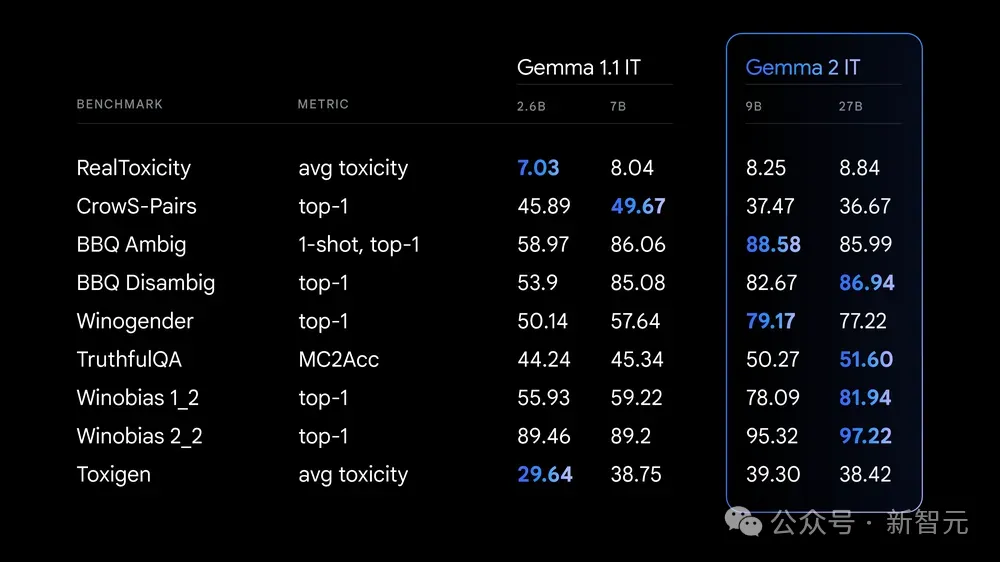

對AI安全性的提升

Gemma 2在實(shí)用高效的同時,也從安全角度做出了新舉措。

谷歌提供了「負(fù)責(zé)任的生成式AI工具包」,LLM Comparator可以讓開發(fā)人員和研究人員深入評估語言模型,使用實(shí)用工具的同時保證安全部署。

就個人用戶而言,可以使用配套的Python庫對模型和數(shù)據(jù)運(yùn)行比較評估,并在應(yīng)用程序中將結(jié)果可視化。

另外,在訓(xùn)練Gemma 2時,預(yù)訓(xùn)練數(shù)據(jù)都經(jīng)過了嚴(yán)格的篩選,并根據(jù)一套安全指標(biāo)進(jìn)行嚴(yán)格的測試和評估,以識別并降低潛在的偏差和風(fēng)險。

可以看出,AI安全在成為越來越多人關(guān)注的問題后,谷歌著重平衡了智力進(jìn)展和安全保障。希望在后續(xù)的網(wǎng)友測評中,不會再出現(xiàn)Gemini 1.5 Pro的翻車案例了。

打造史上「最親民」大模型

Gemma首次推出后,下載量超過1000萬次。

全球各地都使用Gemma制作項(xiàng)目。例如,Navarasa利用Gemma創(chuàng)建了一個植根于印度語言多樣性的模式。

Gemma 2目前可以在Google AI Studio中使用,在Gemma 27B下測試其全部性能,而無需硬件要求。

此外,為方便研發(fā)人員使用,Gemma 2還可通過Kaggle或谷歌Colab免費(fèi)獲取。