只需將感知推理能力拆分,2B大模型就能戰勝20B!國產新框架高效處理視覺任務

只要把推理和感知能力拆分,2B大模型就能戰勝20B?!

上海AI Lab聯合南京大學、香港中文大學等機構,共同推出了一套兩階段框架——Prism。

這一框架不僅顯式地解耦了視覺語言模型(VLM) 的感知和推理,還提供了一種更高效的處理視覺語言任務的方案。

最終讓2B VLM和ChatGPT的組合表現出相當于10倍參數量VLM的性能。

Prism框架架構及功能

在解決復雜的視覺語言任務時,模型的感知和推理能力至關重要。當模型在基準測試中表現不佳時,我們如何區分問題源自感知能力還是推理能力?

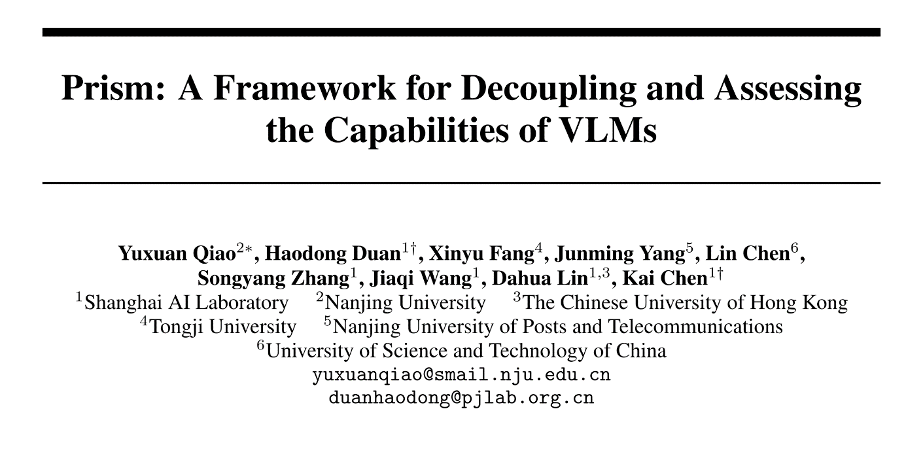

針對這一問題,Prism框架將視覺語言任務處理拆分為兩個獨立階段:

- 感知階段: VLM作為感知模塊遵循指令提取輸入圖片的視覺信息,并以文本形式輸出

- 推理階段: LLM作為推理模塊根據提取得到的文本信息,結合輸入文本生成回復

框架架構如下圖所示:

Prism框架中用于引導VLM生成圖片描述的指令可以是問題相關的,也可以是問題無關的。

VLM在框架中只用于視覺感知,而推理任務則由LLM解決。通過固定框架中的LLM,可以測試不同VLM的感知能力;相對應地,通過固定VLM并使用不同LLM,可以觀察VLM的性能是否被推理能力限制。

除此以外,通過選定VLM和LLM,Prism具有解決視覺語言任務的能力。

利用Prism,團隊對現有VLMs的感知和推理能力進行了解耦分析,揭示了若干有趣的發現。從這些發現中汲取靈感,團隊在Prism框架內整合了專注于感知的輕量級VLM和一個專注于推理的強大LLM。

定量結果表明,這種組合在各種視覺語言任務中表現出卓越的性能和效率。

視覺語言模型感知推理解耦分析

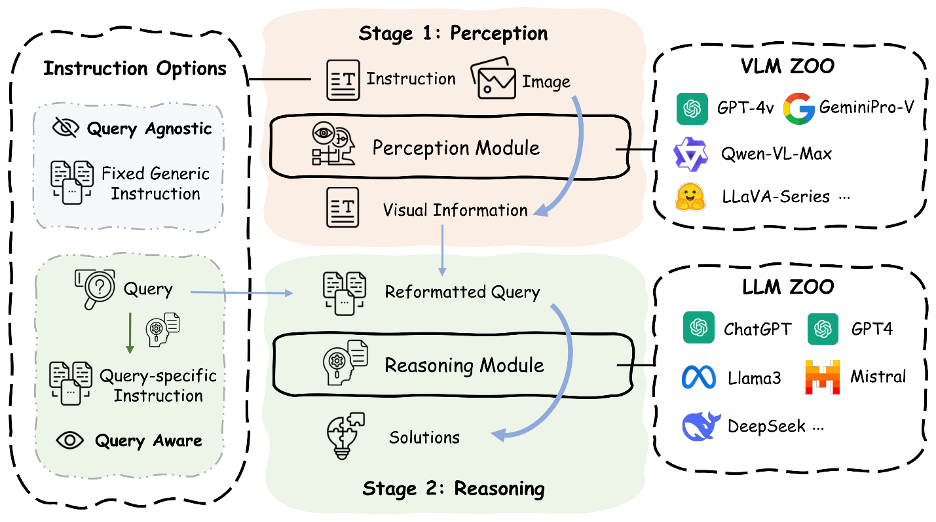

固定Prism中的LLM為ChatGPT-3.5可以進行不同VLM感知性能的對比。考慮到對視覺輸入依賴、數據泄露以及復雜性等問題的考慮,團隊選擇MMStar作為實驗的基準。

實驗使用了兩類不同的指令。一是問題無關的通用指令,提前設定并固定;二是問題相關指令,其由問題需要關注的內容與通用指令拼接得到。問題需要關注的內容由推理模塊LLM根據輸入問題通過few shot輸出。評估過程中最大輸出長度設置為512,并采用貪心解碼策略。

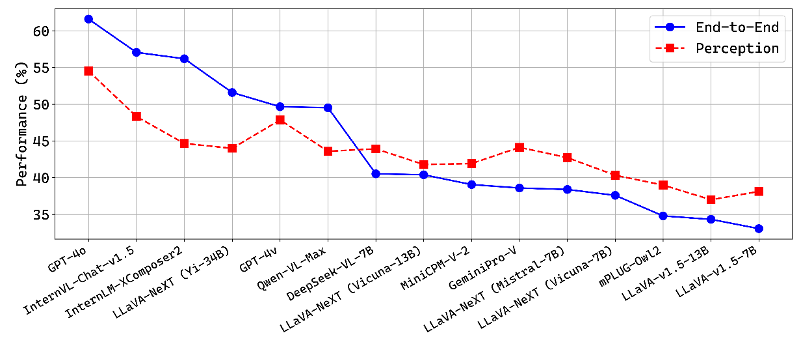

不同VLM在兩類指令上overall的性能表現為:

在兩類指令中,GPT-4o 表現出了最強的感知能力。

在開源模型領域,InternVL-Chat-v1.5 表現最佳。在問題相關指令的結果中,InternVL-Chat-v1.5 不僅在開源模型中表現最好,還微弱領先于 GPT-4v。

細粒度分析

閉源商用模型與開源模型的感知能力比較

GPT-4o作為閉源商用模型,在感知能力方面明顯超過其他模型,并且可以熟練地處理各種感知任務。一些開源模型,例如 InternVL-Chat-v1.5 和 LLaVA-NeXT (Yi-34B),已經取得了顯著的性能,接近 GPT-4v 和 GeminiPro-V 等閉源VLM的能力。其他開源模型由于感知能力有限,通常表現稍差。值得注意的是,MiniCPM-V-2 作為一款具有約3B參數的輕量級VLM,相比某些7B VLM表現出更好的感知性能。

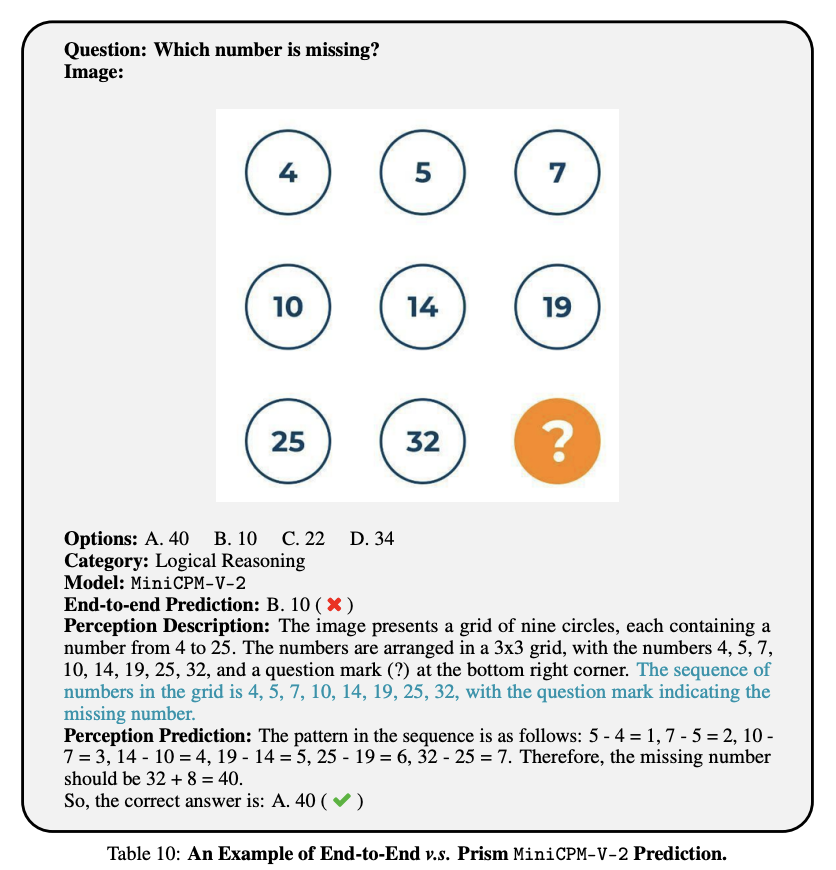

感知能力的表現與端到端的性能表現的差異

除了以端到端的方式解決視覺問題外,Prism 還提供了一個替代管道,其中 VLM 僅用于感知。這兩種方法之間的區別在于推理過程:前者在VLM內部進行推理,而后者基于使用外部LLM(ChatGPT)進行推理。這兩種方法在MMStar上的比較如下圖所示:

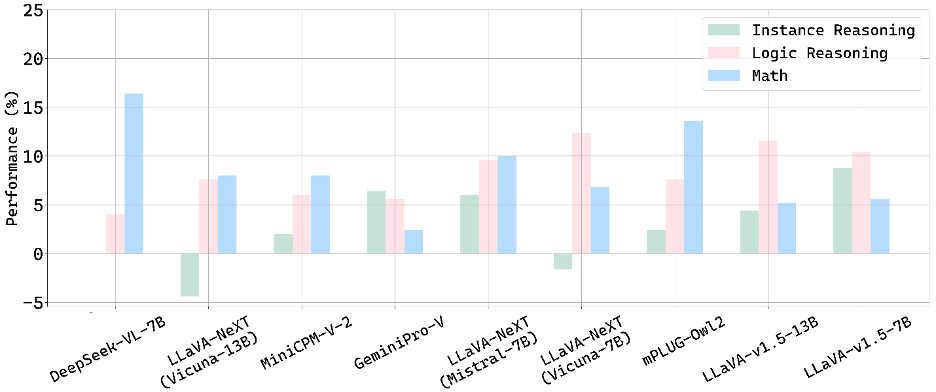

對于最先進的大規模VLM,如 GPT-4o 和 InternVL-Chat-v1.5,它們具有出色的推理能力,使用外部ChatGPT進行推理可能會降低整體性能。相反,對于大多數小規模的VLM,使用ChatGPT進行推理可以顯著提高它們的性能,特別是在推理相關的VQA中,如下圖所示。這一現象表明,小規模VLM的整體性能可能會受到語言模型的大小的嚴重限制。

ChatGPT 的推理能力是否限制了最先進的VLM呢?答案為是的。

將GPT-4o分別用作感知和推理模塊進行解耦得到總體準確率為61%,與端到端GPT-4o性能61.6%幾乎相同。

語言模型對感知能力的影響

評估過程中觀察到當使用更大的語言模型時,LLaVA-v1.5 系列沒有顯示出顯著的改進。這表明當使用相對低分辨率的視覺主干時,感知性能可能與語言模型的大小無關。

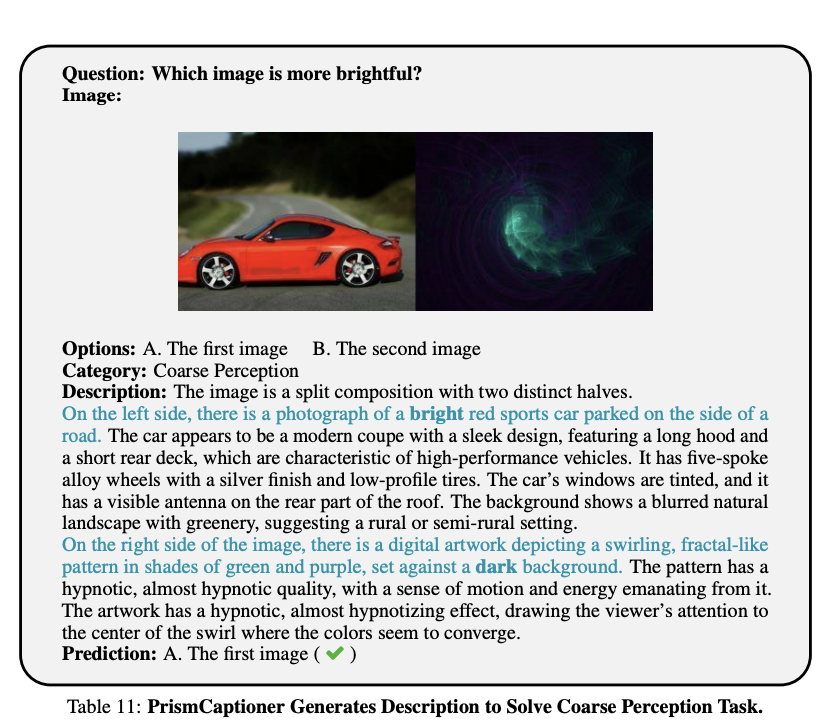

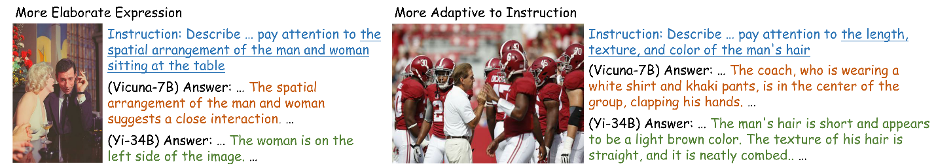

同時,LLaVA-NeXT 系列的定量結果表明,擴大語言模型會略微增強模型感知,特別是在使用問題相關指令時。其主要原因為:更精細的表達以及更適應于指令,如下圖例子所示:

消融實驗

團隊針對Prism中的通用指令,推理模塊LLM以及VLM視覺編碼器對感知能力的影響做了消融實驗,結果如下:

- 通用指令:對人工手寫、GPT生成、思維鏈以及任務分解等不同類型指令的實驗結果表明,即使差距并不明顯,評估分析中所采用的指令是其中最有效的。

- 推理模塊:比較不同的LLM推理模塊的結果顯示,ChatGPT在推理性能上表現良好,而GPT4則進一步提高了性能。開源模型 Llama3-70B-Instruct 表現出與GPT4相當的能力,表明開源模型在視覺信息推理中的潛力。

- 視覺編碼器:關于VLM中視覺編碼器對感知性能影響的實驗表明,SigLip-SO400M 相比于 CLIP ViT-L/14 和 InternViT-6B 在實驗基準上表現更好。

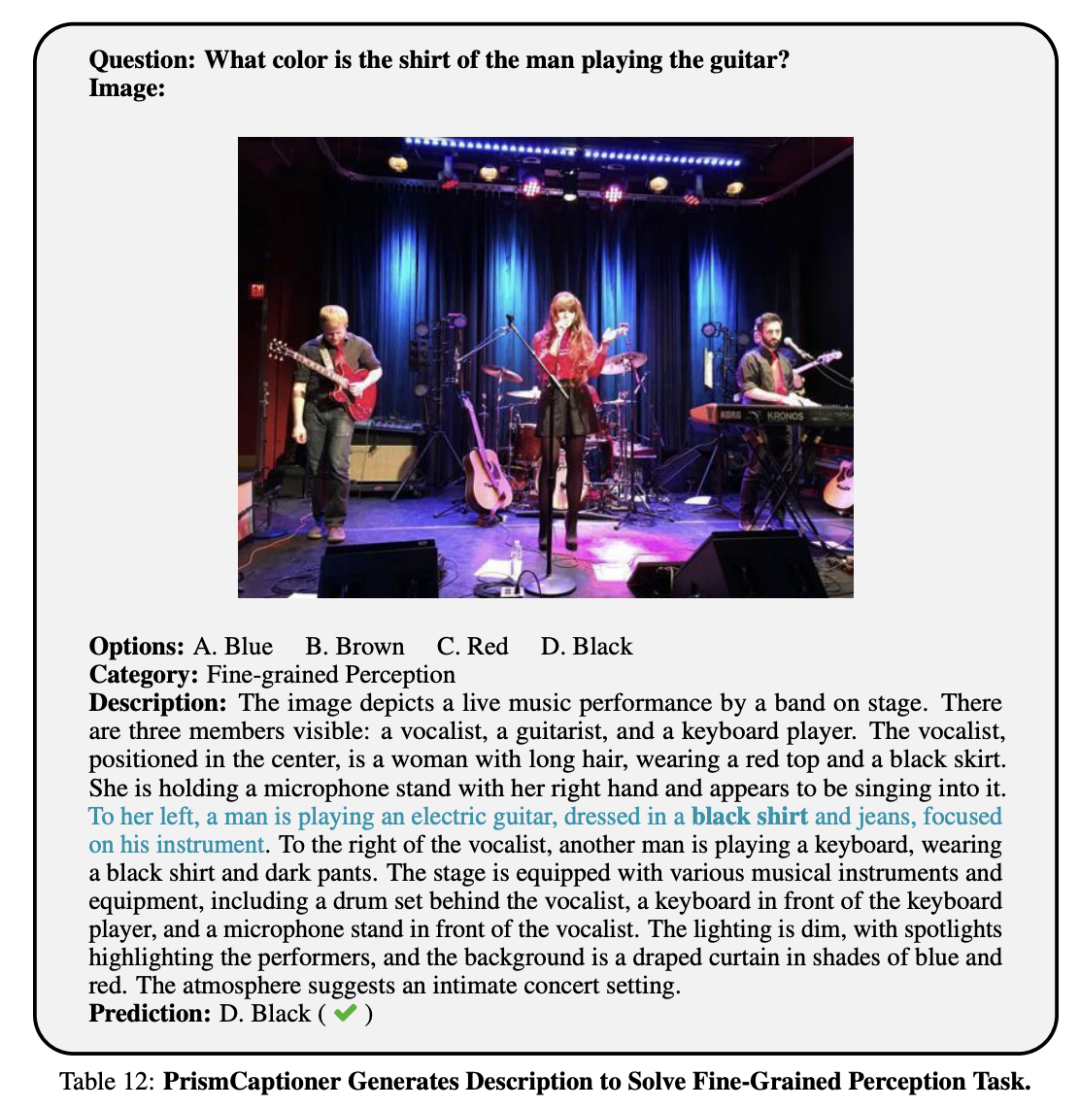

專注感知的輕量級視覺語言模型

團隊從分析的結果中得到啟發,使用ALLaVA數據訓練了專注感知的輕量級VLM--PrismCaptioners ,并在Prism框架中與強大的LLM進行整合。

數據與架構

數據集

PrismCaptioners使用ALLaVA中的 ALLaVA-Caption-4V 和 Evol-Intruct-GPT4-Turbo-143K 作為指令調優數據。與QA格式的指令調優數據相比,利用描述性數據進行指令調優可以更好地訓練VLM提取和表達視覺信息的能力。

模型架構

使用 SigLip-SO400M 作為視覺編碼器,InternLM2-[1.8B/7B] 作為語言編碼器,訓練了兩個不同尺度的視覺captioner,稱為 PrismCaptioner-[2B/7B]。

模型性能

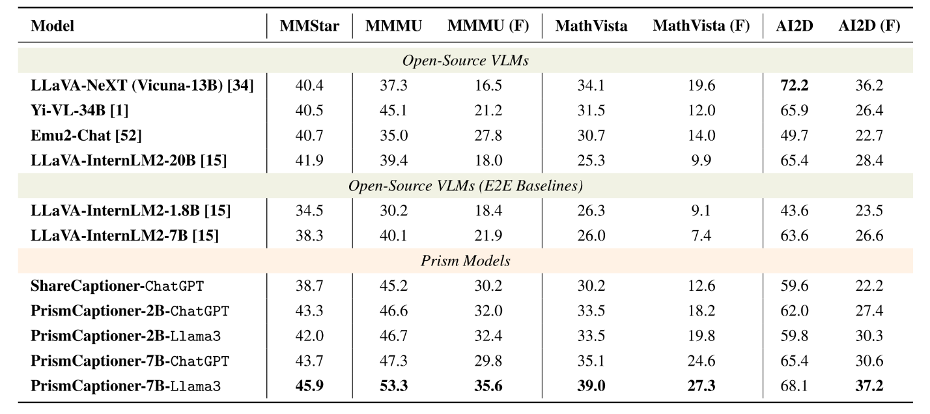

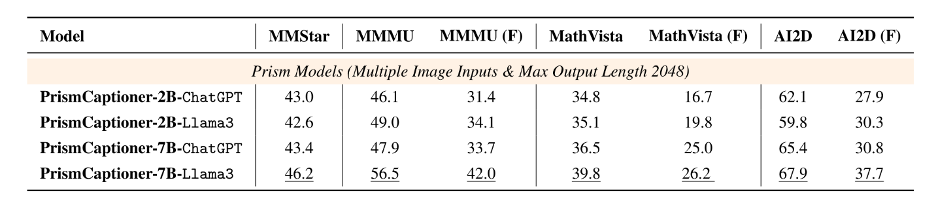

團隊在MMStar, MMMU, MathVista,AI2D以及后三者的子集上進行了實驗。子集選取的策略類似于MMStar。將PrismCaptioner作為Prism感知模塊并接入ChatGPT或Llama3的性能表現如下表所示。公平起見,模型均使用單個圖像作為輸入,并將最大輸出長度限制為512。

通過Prism整合VLM與LLM的方式相比于基于LLaVA數據訓練的端到端baseline有顯著的性能提高。同時,PrismCaptioner相比于另一開源caption生成模型ShareCaptioner也有更好的效果。

對于7B版本,Llama3 的接入帶來大幅性能提升,使組合PrismCaptioner-7B的方案成為極具競爭力的視覺語言模型,特別是在 MMStar 和 MMMU 上。對于2B版本,接入Prism后,它實現了與其十倍以上大小 VLM 相當的性能水平。這表明 Prism 能夠提供一個強大而高效的解決方案,例如帶有 ChatGPT 的 PrismCaptioner-2B,并展現了令人印象深刻的結果。

當最大輸出長度設置為2048,并允許多張圖像輸入時(為每張生成描述并拼接),接入Llama3的方案在MMMU上取得了更高的性能,在開源領域優勢明顯,如下表所示:

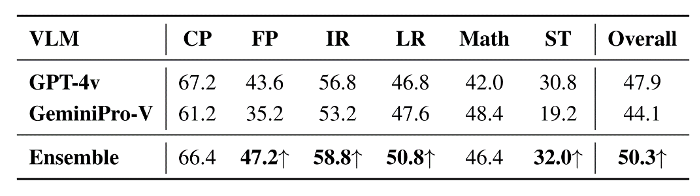

此外,Prism允許靈活地結合多個VLM以增強感知。例如,簡單地將GPT-4v和GeminiPro-V的輸出拼接起來,即可在MMStar基準測試中的大多數指標上顯示出了顯著的改進,如下圖所示:

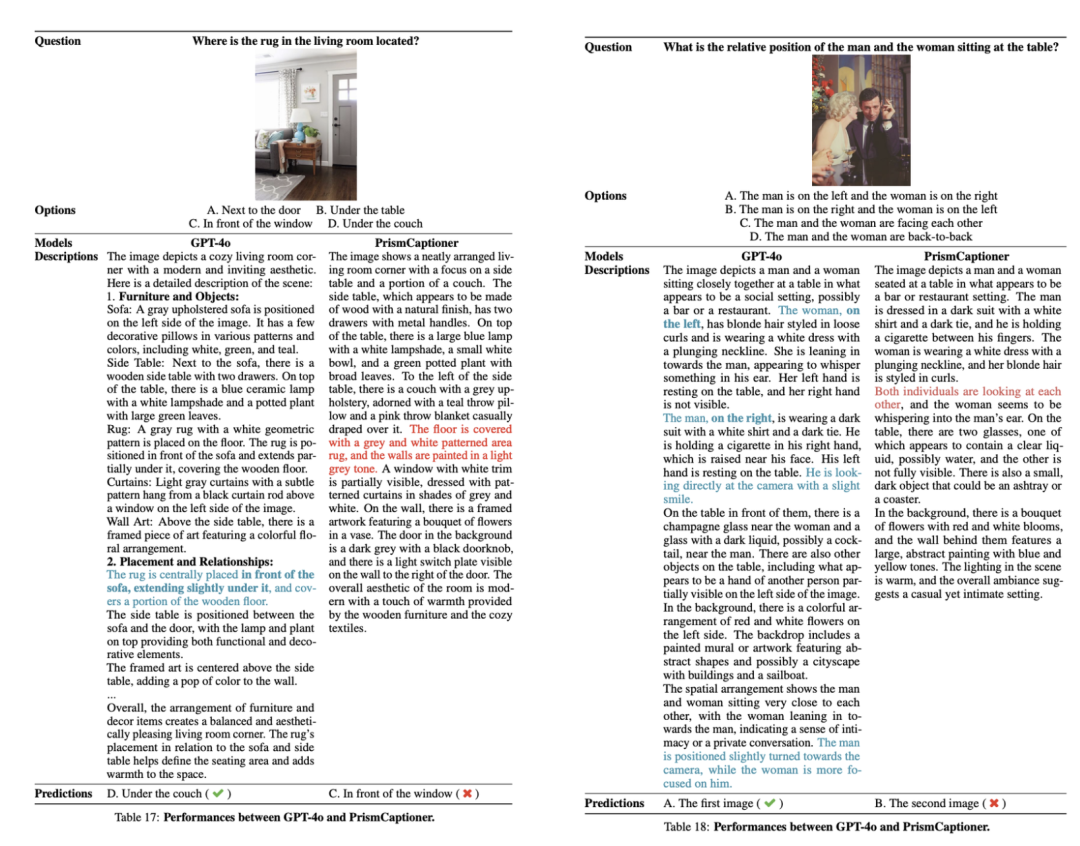

此外,他們還跟GPT-4o進行了一個對比,發現仍有一定的進步空間。GPT-4o在空間感知推理方面能力更強,描述的更為詳細和準確。

Prism框架的引入為視覺語言模型的研究和應用開辟了新途徑。

通過有效解耦感知和推理,Prism不僅能夠用于模型的分析和視覺語言任務的解決,還為未來的研究提供了新的方向。我們期待Prism在更多視覺語言任務中的應用,進一步推動這一領域的發展。

論文鏈接:

https://arxiv.org/abs/2406.14544

Github鏈接:

https://github.com/SparksJoe/Prism