一分鐘原畫變3D角色,清華VAST成果入選圖形學頂會SIGGRAPH

隨便一張立繪都能生成游戲角色,任意IP快速三維化有新招了!

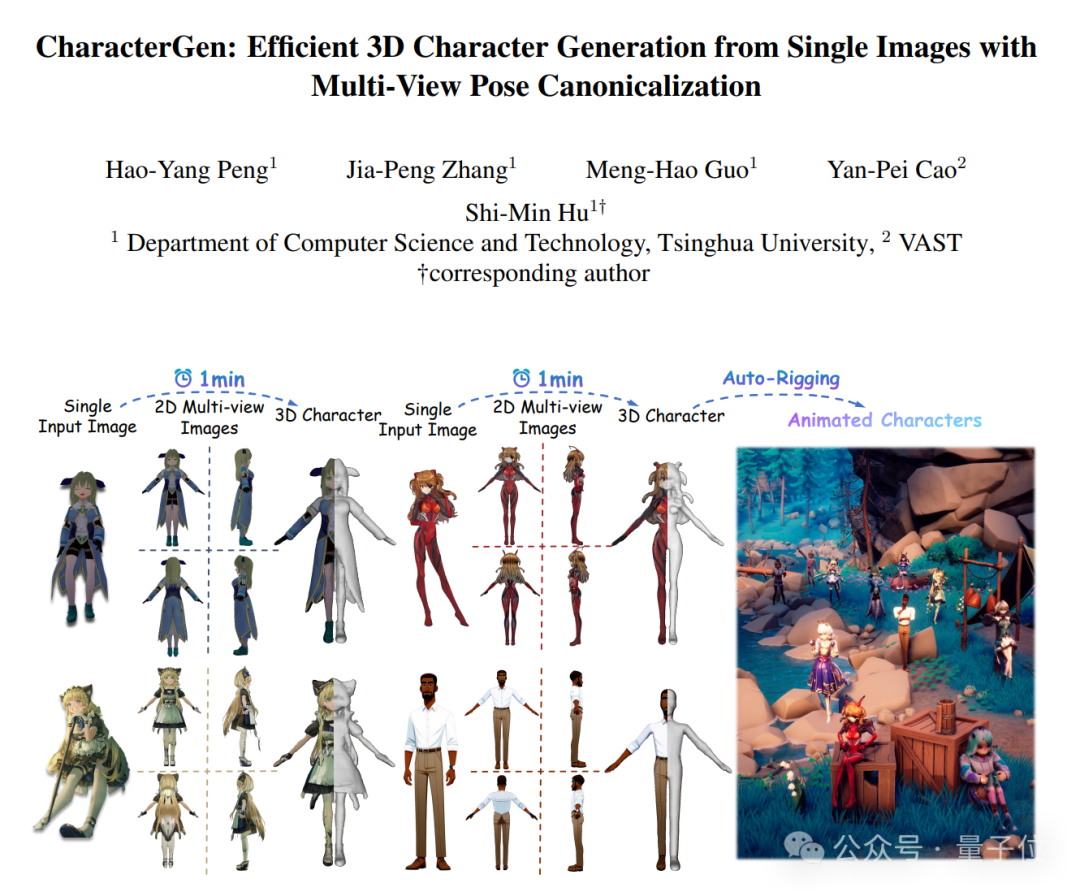

來自清華大學和VAST的研究人員聯(lián)合推出了CharacterGen——

一種三維風格化人物生成框架。

圖片

圖片

具體而言,CharacterGen采用兩階段生成模式,可在1分鐘內(nèi)從單圖生成高質(zhì)量的標準姿態(tài)三維人體。

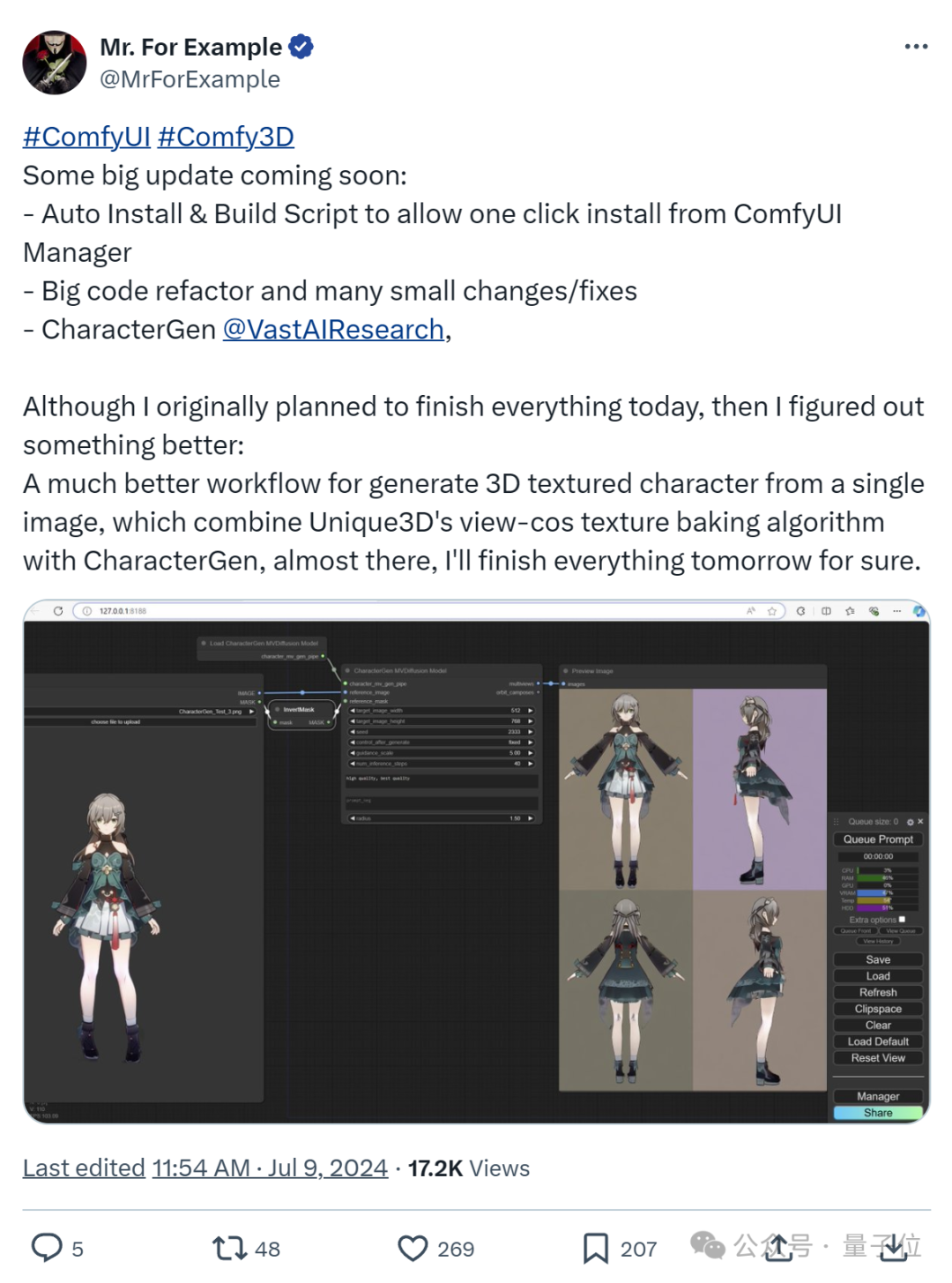

目前相關(guān)論文已入選計算機圖形學頂會SIGGRAPH 2024,且在社區(qū)引發(fā)了熱烈討論。

CharacterGen開源后,已有玩家第一時間將其納入了ComfyUI-3D工作流。

圖片

圖片

網(wǎng)友們搓手表示:

迫不及待看到構(gòu)建3D角色工作流更簡單!

圖片

圖片

更多詳情接下來一起康康~

1分鐘單圖變3D角色

新框架CharacterGen想做的事兒,是將用戶輸入的復雜人物圖像轉(zhuǎn)換為標準Pose的三維人物網(wǎng)格。

總體而言,框架可分為如下兩部分:

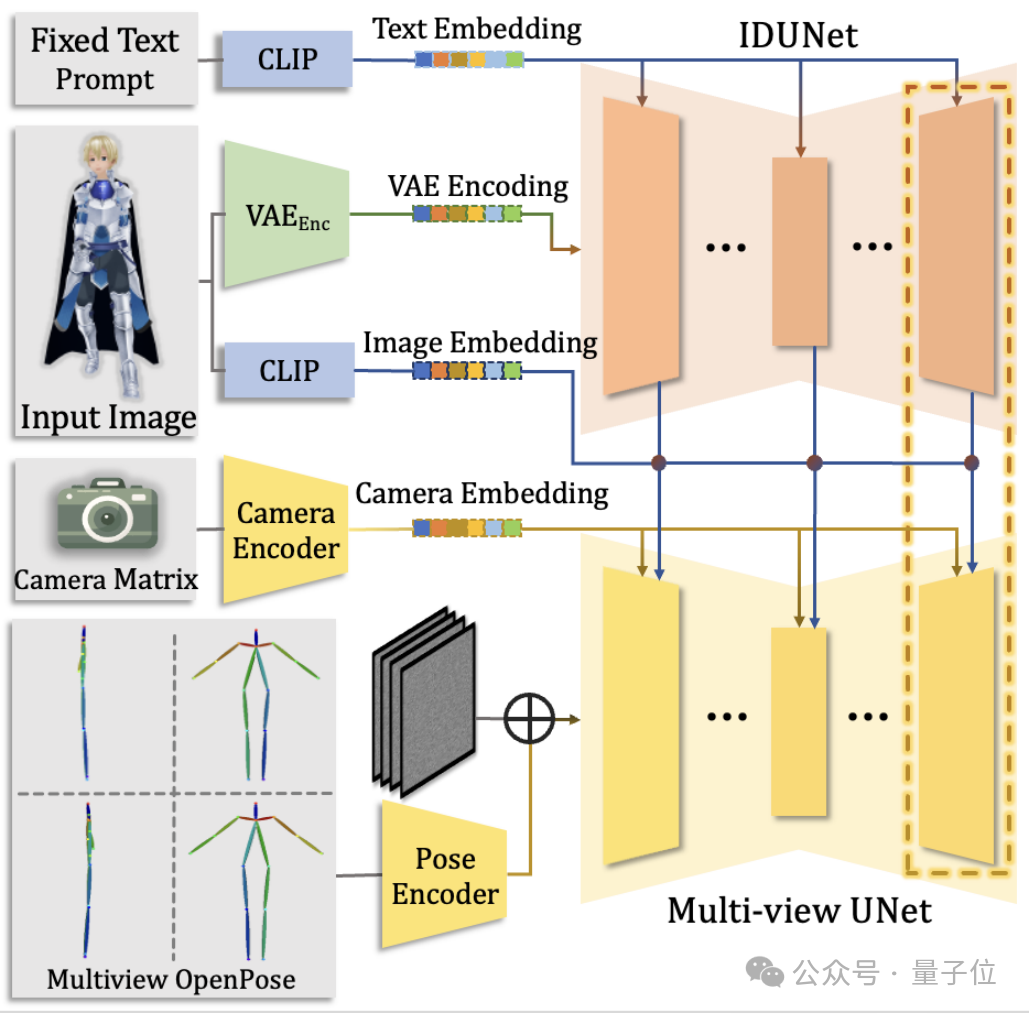

- 多視角人物圖像生成器。以給定的帶姿勢人物圖作為輸入,通過Diffusion模型生成高度一致性的四視角圖像。

- 三維重建模型。將生成的四視角圖像重建,得到最終的三維人體以及對應的粗紋理。

最終,通過紋理投影策略,將多視角圖像投影到重建的粗紋理之中,得到最后的高質(zhì)量三維人物模型。

整個流程可以在A800單卡上1分鐘內(nèi)完成。

并且由于A-pose(人物兩腳并攏,雙手自然下垂,身體直立)的設(shè)置,可以方便地運用于下游的各種任務。

“A-pose”是動畫和3D建模中的一個基準點,它提供了一個簡單、統(tǒng)一的起點來進行后續(xù)的建模和動畫工作。

圖片

圖片

為了進一步提高擴散模型理解3D角色的能力,團隊準備了包含13,746個風格化角色主題的Anime3D數(shù)據(jù)集。

而且為了讓多視角人物圖像生成器能學到足夠的先驗,完成對風格化人物的多視角生成和人物的姿勢轉(zhuǎn)換,團隊渲染并篩選了組數(shù)據(jù)。

每一組數(shù)據(jù)都包含了多組同一個人物在一個非標準姿勢和標準姿勢下的四視角渲染圖像。

多視角人物圖像生成器

團隊采用了Dual-pass的多視角人物圖像生成器。

它不僅能生成四視圖的人物圖像,還能在生成過程中完成姿勢的標準化。

圖片

圖片

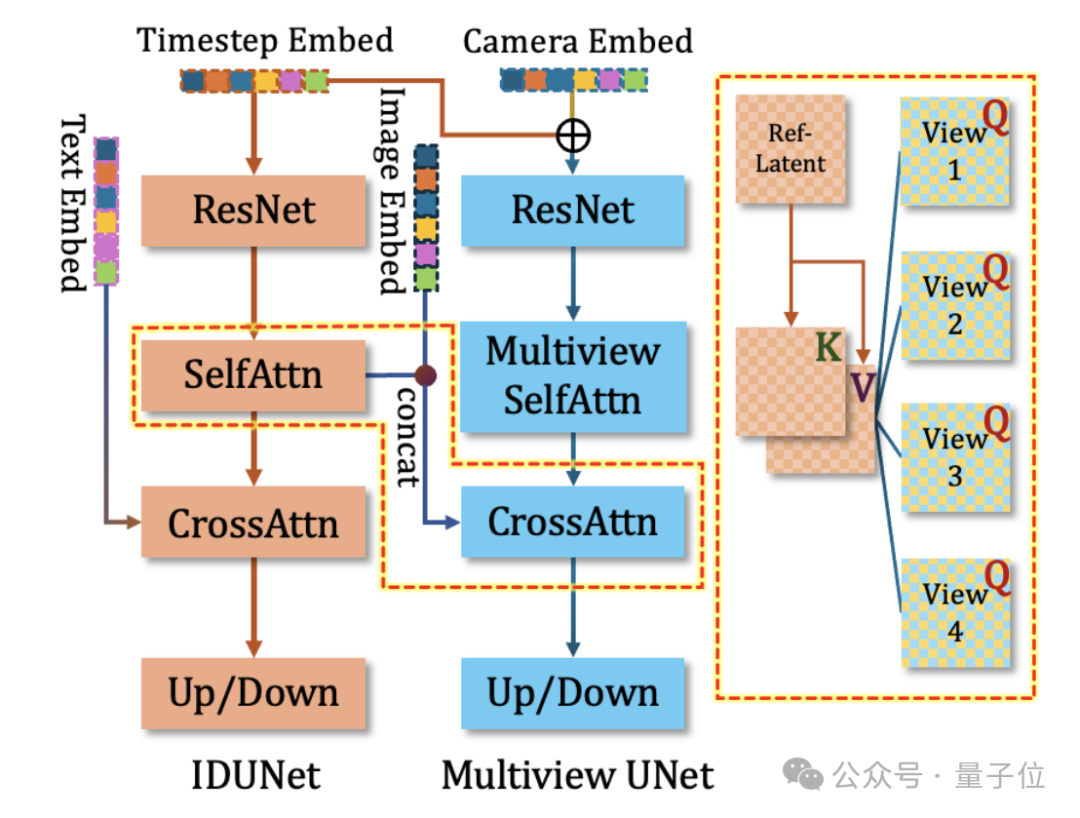

此外,團隊在基本的多視角diffusion模型之外,添加了一個同樣結(jié)構(gòu)的IDUNet來提取輸入人物圖片的特征。

IDUNet逐層提取未加噪的圖像的外表特征,通過Cross-Attention機制和Base-Diffusion模型中的多視角圖像進行Patch-level的交互,使得最終生成的多視角人物具有極高的一致性。

最后,生成器也包含一個布局姿勢指導器Pose Guider,進一步為人物的姿勢提供先驗,并且使得生成人物的布局能夠位于圖片正中。

三維重建模型

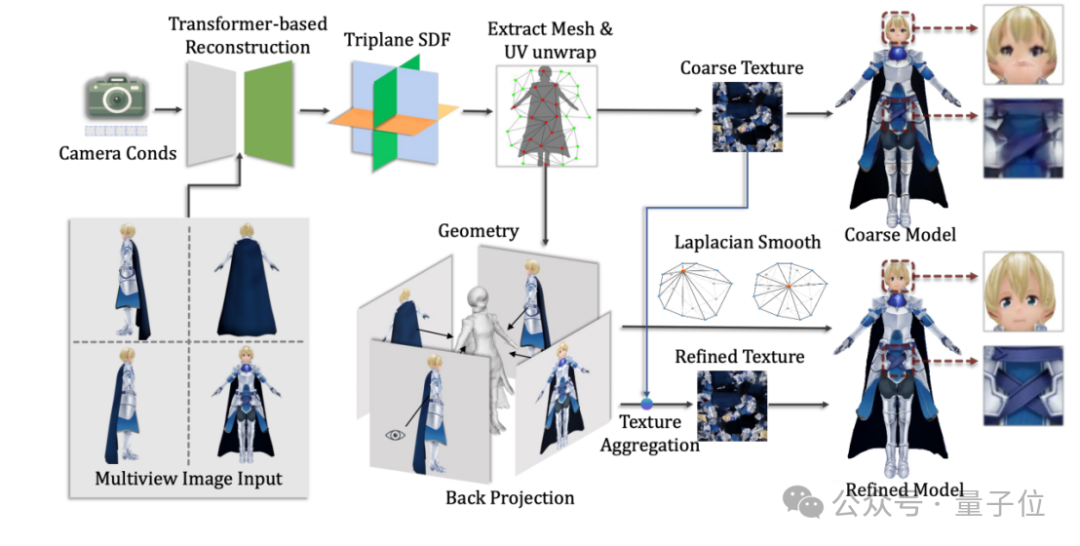

參考三維重建大模型(LRM),團隊設(shè)計了針對四視角輸入圖像的三維重建模型。

團隊首先仿照LRM,訓練了基于NeRF的重建模型。

為了獲得更好的表面幾何,在訓練第二階段使用SDF表達作為輸出,進一步精調(diào)重建模型。

最后,由于重建模型難以獲得高清晰度的紋理,研究團隊還引入了紋理投影機制。

具體而言,通過四視角本身預設(shè)的相機參數(shù),將高質(zhì)量的四視角生成圖片投影到粗紋理圖上,同時使用法向數(shù)值來篩出重疊和邊緣的像素,得到最終的紋理貼圖。

圖片

圖片

實驗結(jié)果

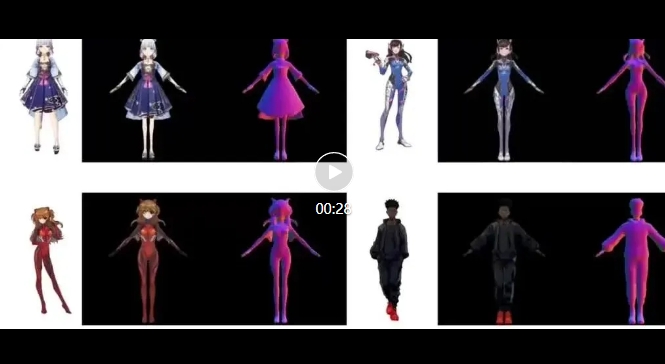

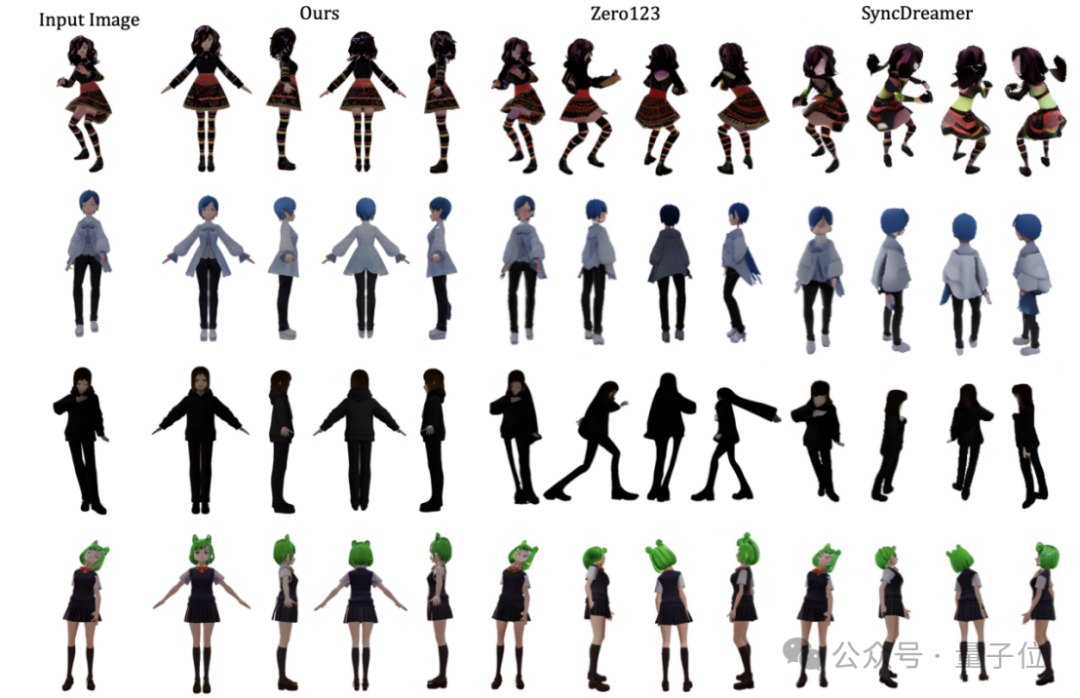

研究團隊分別從二維多視角圖片質(zhì)量以及三維人物模型質(zhì)量上對方法進行了評估。

在二維方法上,研究團隊選取了Zero123和SyncDreamer作為Baseline進行比較。

結(jié)果顯示,在生成人物圖像的紋理質(zhì)量和外表一致性上,CharacterGen取得了超越之前方法的效果。

圖片

圖片

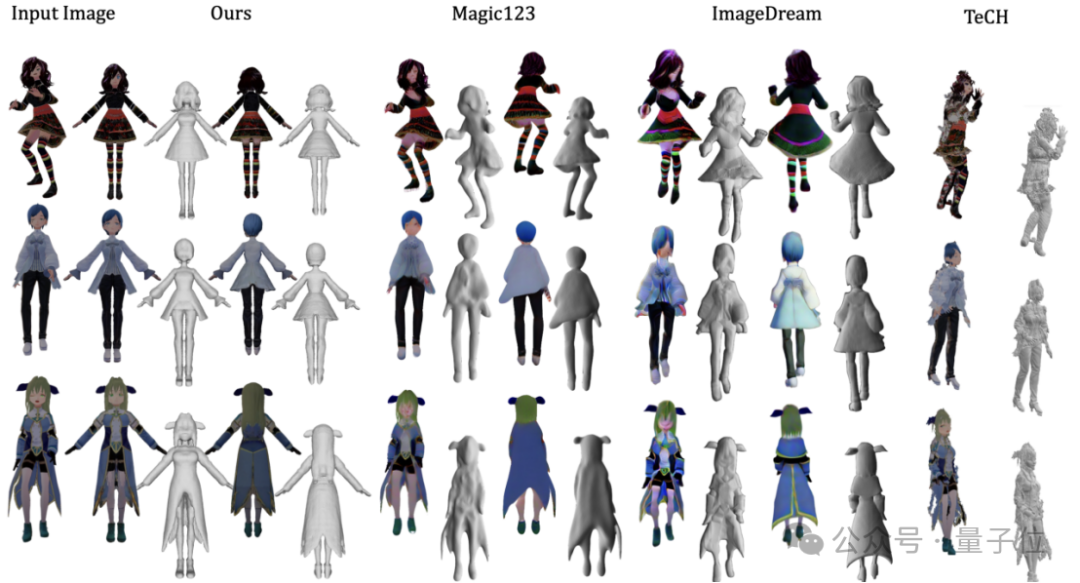

在三維方法上,團隊選取了Magic123和ImageDream作為泛用圖像驅(qū)動生成的Baseline,選擇TeCH作為圖像驅(qū)動SMPL生成的Baseline。

實驗表明,CharacterGen生成的標準A-pose姿勢人體能夠避免網(wǎng)格的黏貼問題,并且在紋理和幾何上擁有更高的質(zhì)量。

圖片

圖片

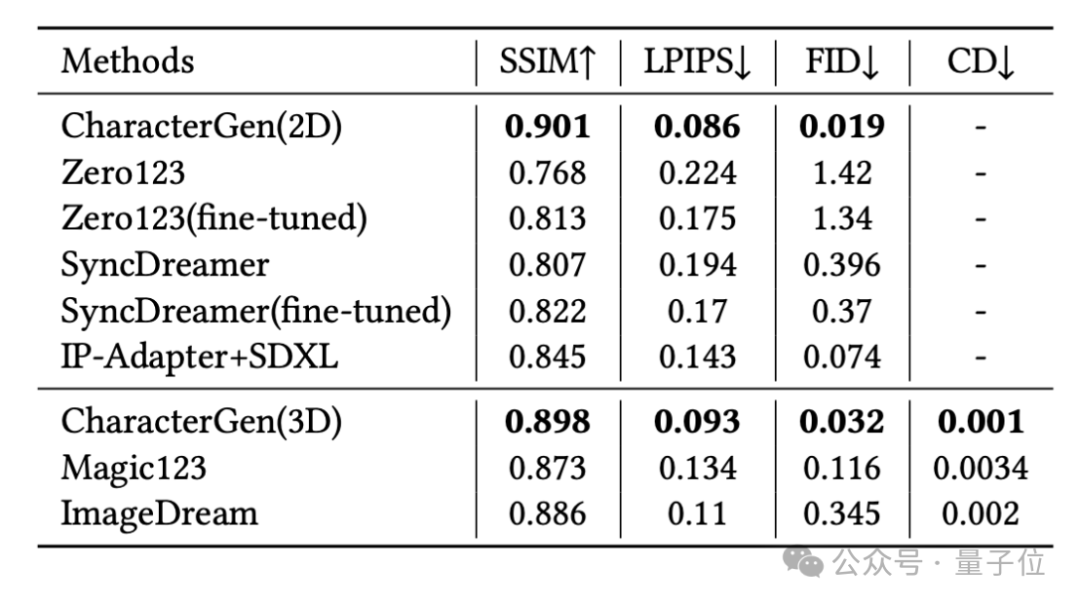

此外,團隊也在Anime3D的驗證集上,對CharacterGen和Baseline方法進行了定量的比較。

評估指標包括:

- SSIM和LPIPS指標:衡量生成的對應視角圖片與ground-truth圖片的相似程度

- FID指標:評價風格上的一致性

- Chamfer-Distance指標:比較生成網(wǎng)格的幾何質(zhì)量

在這些指標上,CharacterGen都能獲得更優(yōu)的效果。

圖片

圖片

目前相關(guān)論文已公開,感興趣可以進一步了解。

此外,研究團隊還開源了基于Jittor框架JDiffusion庫的CharacterGen實現(xiàn)(計圖Jittor是清華大學計算機系圖形學實驗室于2020年3月20日發(fā)布并開源的深度學習框架)。

計圖Jittor倉庫鏈接:https://github.com/JittorRepos/JDiffusion/tree/master/examples/CharacterGen

項目主頁:https://charactergen.github.io/論文:https://arxiv.org/abs/2402.17214Huggingface Gradio Demo: https://huggingface.co/spaces/VAST-AI/CharacterGenGitHub:https://github.com/zjp-shadow/CharacterGen