如何通過壓縮提示降低GPT-4的成本

譯文

譯者 | 李睿

審校 | 重樓

如果使用得當,LLMLingua可以降低使用高級LLM的成本,并使更廣泛的用戶和應用程序可以使用LLM。

像GPT-4和Claude這樣的大型語言模型(LLM)可以通過良好的提示工程學習新任務。然而,較長的提示會增加使用這些模型的成本,并且還會減慢它們的運行速度。

LLMLingua是微軟公司開發的一項新技術,通過消除無關部分來壓縮提示。值得注意的是,LLMLingua可以在不影響模型響應質量的情況下將提示的規模壓縮高達20倍。如果使用得當,LLMLingua可以降低使用高級LLM的成本,并使更廣泛的用戶和應用程序可以使用LLM。

提示工程的成本

提示工程是利用LLM進行實際應用的基石。諸如思維鏈、場景學習以及集成相關文檔或歷史對話等技術有助于增強特定任務的模型性能。然而,這些方法通常需要更長的提示,有時可能達到數千個令牌。這可能會對使用高級模型的成本產生重大影響,尤其是像GPT-4這樣成本高昂的LLM。

雖然有不同的方法來優化模型和降低成本,但一個研究方向是利用自然語言固有的冗余來壓縮提示。有些方法通過提示調優來學習專門的令牌,以減少推理期間所需的令牌數量。

然而,這些方法通常是特定于任務的,可能需要對整個模型進行微調,從而限制了它們的使用,并使它們與基于API的模型(例如ChatGPT)不兼容。

其他技術使用LLM來總結對話,以創建濃縮的記憶和知識表示。但是,這些方法通常涉及對LLM的多次成本高昂的調用。

選擇性場景是一種令人關注的方法,使用一個規模較小的語言模型來評估文本片段的信息量,丟棄信息較少的內容來壓縮提示。微軟公司的最新技術建立在這種方法的基礎上,并對其進行了改進。

LLMLingua

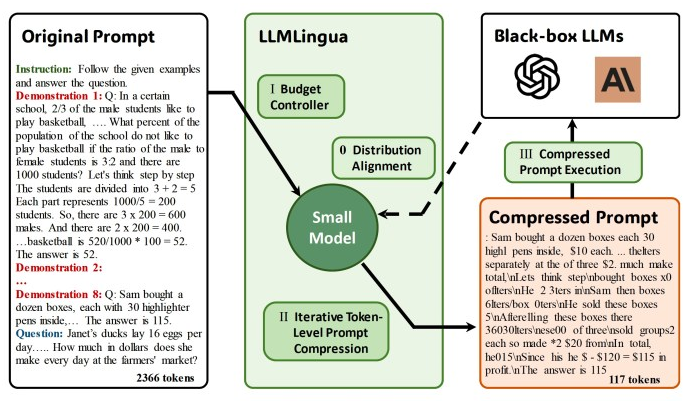

LLMLingua是一種創新技術,它將提示從粗粒度壓縮到細粒度級別。這種方法由幾個部分組成。

第一個組成部分是“預算控制器”,它動態地將不同的壓縮比分配給原始提示的元素,例如指令、演示和問題。基本原則是指令和問題通常對生成的結果有更直接的影響,因為它們包含了LLM生成答案所需的基本知識。與其相反,當提示包含多個演示時,信息可能是重復的。因此,預算控制器為指令和問題分配更大的預算(意味著更小的壓縮比),同時為演示分配更小的預算。

LLMLingua使用較小的語言模型(如GPT-2或LLaMA)來管理這一分配。該模型計算每個演示的困惑度,作為文本與模型響應相關性的衡量標準。然后,LLMLingua優先考慮具有最高困惑值的演示,將其納入提示中,直到滿足演示的令牌預算。剩下的預算用于完善指導和問題。

LLMLingua的第二個組成部分是迭代令牌級提示壓縮(ITPC)算法,它允許更細粒度的壓縮。迭代令牌級提示壓縮(ITPC)首先對提示進行分段,然后使用小模型確定這些分段之間的困惑度分布。接著,該算法構造一個壓縮提示,該提示保留具有高困惑度的令牌,通過考慮令牌之間的條件依賴關系來確保保留關鍵信息。

第三個組成部分涉及基于指令調優的方法,該方法同步大型和小型語言模型的分布模式。這個過程從一個預先訓練好的小型語言模型開始,然后使用較大的LLM生成的數據對其進行微調。通過指令調優,小模型的行為與大模型的行為更加一致,增強了整體壓縮過程。

測試LLMLingua

在他們的實驗中,研究人員使用GPT-3.5 Turbo和Claude 1.3作為主要LLM,并使用Alpaca-7B或GPT2-Alpaca完成壓縮任務。他們在各種基準測試中測試了LLMLingua,包括用于推理和場景學習的GSM8k和BBH,以及用于會話場景理解和摘要任務的ShareGPT和Arxiv-March23。

研究人員在發布的一份報告說:“在幾乎所有的實驗中,我們提出的方法始終以很大的優勢優于先前的方法。”

在GSM8K和BBH的推理和場景學習基準測試中,LLMLingua不僅取得了比全景(Full-shot)方法更高的結果,而且獲得了5倍和3倍的顯著壓縮比。

研究人員寫道:“這很好地證明了我們的壓縮提示有效地保留了原始提示中包含的推理信息。”

對于ShareGPT和Arxiv-March23上的場景理解基準,LLMLingua將提示壓縮了9倍和3.3倍。這表明LLMLingua在壓縮初始提示時保留了它們的語義完整性。此外,LLMLingua在準確性和壓縮程度上都優于其他提示壓縮方法。在某些情況下,它在原始提示符上實現了高達20倍的壓縮。

盡管涉及多個步驟和兩個模型的復雜性,LLMLingua設法實現了從1.7到5.7倍的加速,并且計算開銷最小。

研究人員總結說:“我們的方法具有重大的實際意義,因為它不僅降低了計算成本,而且為LLM中適應更長的場景提供了一種潛在的解決方案。”

為了使LLMLingua得到更廣泛的采用,微軟公司通過一個易于使用的開源庫提供了LLMLingua。開發人員可以使用這個庫將LLMLingua集成到他們自己的應用程序中。

原文標題:Reduce the costs of GPT-4 with prompt compression,作者:Ben Dickson

鏈接:https://bdtechtalks.com/2023/12/20/llmlingua-prompt-compression/。