Nature封面:AI訓練AI,越訓越離譜

我們知道,大模型面臨的三大挑戰是算法、算力和數據。前兩者靠優化升級,后者靠積累。隨著技術的不斷發展,高質量數據已經逐漸成為最大的瓶頸。

在很多新模型上,人們為了提升模型能力,都采用了使用 AI 生成數據來訓練的方式。人們普遍認為,使用合成數據可以顯著提升模型質量。

不過,最新的研究認為,使用 AI 生成的數據并不是什么好辦法,反而可能會讓模型陷入崩潰。

今天發表在學術頂刊《自然》雜志的封面研究認為,如果放任大模型用自動生成的數據訓練自己,AI 可能會自我退化,在短短幾代內將原始內容迭代成無法挽回的胡言亂語。

這篇由牛津大學等機構提交的研究,強調了由于自我訓練導致人工智能模型崩潰(Model Collapse)的風險,論證了原始數據源和仔細數據過濾的必要性。

論文鏈接:https://www.nature.com/articles/s41586-024-07566-y

哪種模型容易崩潰?

研究認為,當人工智能模型在生成的數據上進行過度訓練時,就會發生不可逆轉的模型崩潰。

「模型崩潰是指由于對合成數據進行不加區分的訓練而導致模型崩潰的現象」,牛津大學研究員、該論文的主要作者 Ilia Shumailov 表示。

根據論文所述,大型語言模型等生成式 AI 工具可能會忽略訓練數據集的某些部分,導致模型只對部分數據進行訓練。

眾所周知,大語言模型(LLM)需要巨量數據進行訓練,從而使自身獲得解釋其中信息并應用于各種用例的能力。LLM 通常是為了理解和生成文本而構建的,但研究小組發現,如果忽略它據稱正在閱讀并納入其知識庫的大量文本,可能會很快地使 LLM 淪為空殼。

「在模型崩潰的早期階段,模型首先會失去方差,在少數數據上的表現下降,在模型崩潰的后期階段,模型則會完全崩潰」,Shumailov 說道。因此,隨著模型繼續在模型本身生成的越來越不準確和相關的文本上進行訓練,這種遞歸循環會導致模型退化。

模型崩潰,到底是什么

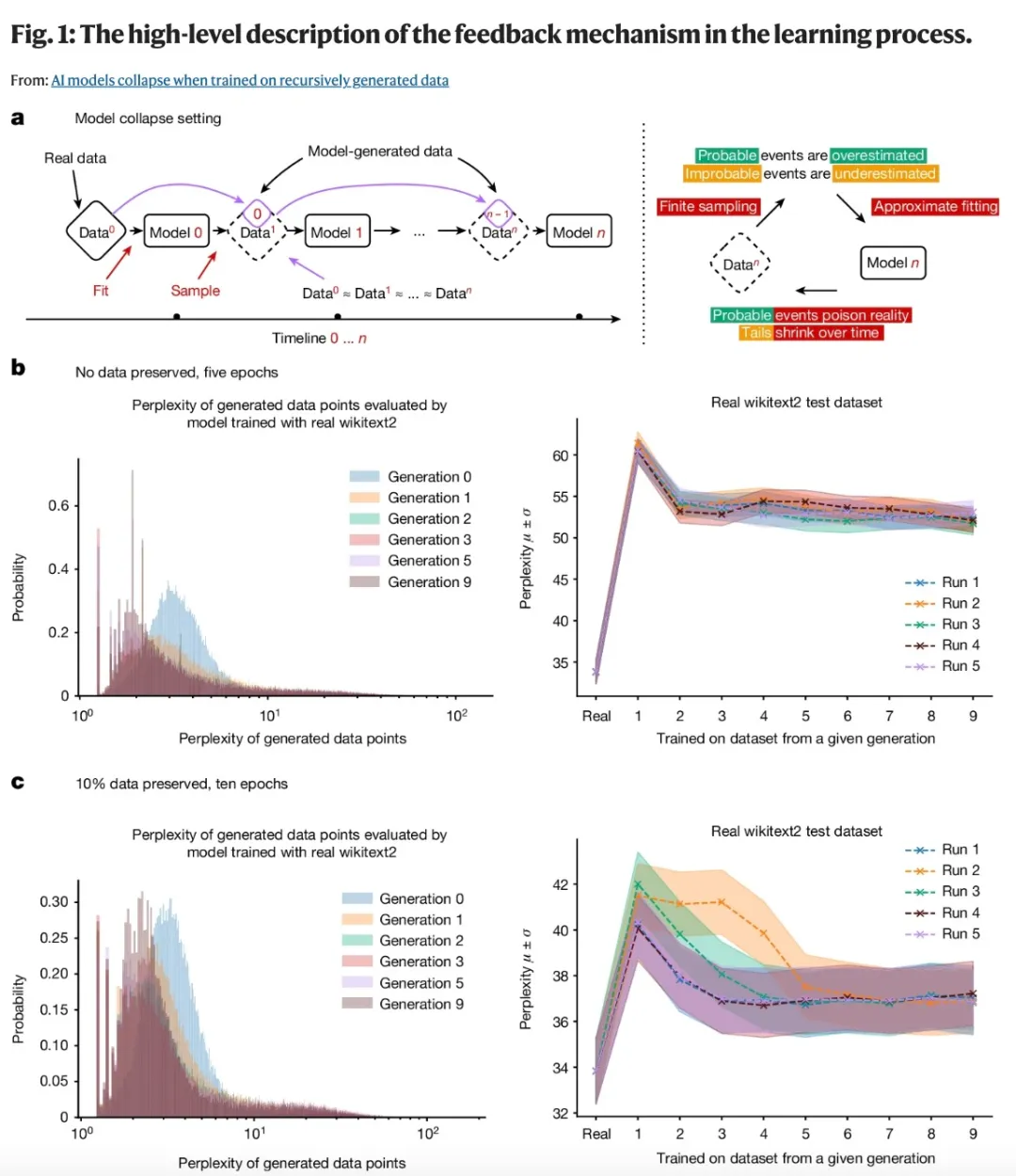

在該論文中,作者發現的模型崩潰效應是一種退化過程,模型生成的數據會污染下一代模型的訓練集。模型接受受污染數據的訓練,會錯誤地感知現實,如下圖 (a) 所示。

模型崩潰可以分為早期和后期階段,早期模型會在少數數據上表現下降,后期模型會收斂到一種與原始分布幾乎沒有相似之處的分布,并且方差通常大大減少。

模型崩潰發生主要是因為下述三個特定誤差源在幾代模型中復合,并導致與原始模型出現較大偏差:

- 統計近似誤差。這是由于樣本數量有限而產生的主要誤差,并且隨著樣本數量趨于無窮大而消失。發生這種情況是因為重采樣的每一步都可能丟失信息。

- 函數表達誤差。這是第二種類型的誤差,是由于函數逼近器表達能力有限而產生的。特別是,神經網絡只是通用逼近器,無法完美地逼近任何分布。神經網絡可以在原始分布之外引入非零似然,或者在原始分布內引入零似然。函數表達誤差的一個簡單例子是,如果我們嘗試用單個高斯擬合兩個高斯的混合。即使我們有關于數據分布的完美信息(即無限數量的樣本),模型誤差也將是不可避免的。然而,在沒有其他兩種類型的誤差的情況下,這種情況只能發生在第一代模型。

- 函數逼近誤差。這是次要類型的誤差,主要源于學習過程的局限性,例如隨機梯度下降的結構偏差。

上述每一項都可能導致模型崩潰變得更糟或更好。更高的逼近能力甚至可以是一把雙刃劍,更好的表達能力可以抵消統計噪聲,從而很好地逼近真實分布,但它同樣會加劇噪聲。這通常會產生級聯效應,其中個體的不準確性結合起來會導致整體誤差增加。

例如,過度擬合密度模型會導致模型錯誤推斷,將高密度區域分配給訓練集未覆蓋的低密度區域。

值得注意的是,還存在其他類型的誤差。例如,計算機在實踐中的精度有限。

語言模型中的模型崩潰

作者在文中還評估了模型崩潰對語言模型的影響。模型崩潰在各種機器學習模型中普遍存在。然而,與通常從零開始訓練的小模型(如 GMMs 和 VAEs)不同,LLM 需要巨大的成本從頭開始訓練,因此通常使用預訓練模型(如 BERT、RoBERTa 或 GPT-2)初始化,這些模型是在大型文本語料庫上訓練的。隨后,這些模型被微調以適應各種下游任務。

在這篇論文中,作者探討了當語言模型使用由其他模型生成的數據進行連續微調時會發生什么。本文中涉及的所有實驗可以在非微調設置下用更大的語言模型輕松復制。鑒于訓練一個中等規模的模型需要的算力也非常可觀,作者選擇不進行這樣的實驗,而是專注于更現實的概念驗證設置。

需要注意的是,本文描述的語言實驗即使在這種情況下也需要幾周時間才能完成。作者評估了訓練語言模型的最常見設置 —— 微調設置,其中每個訓練周期都從一個具有最新數據的預訓練模型開始。這里的數據來自另一個經過微調的預訓練模型。由于訓練被限制在生成與原始預訓練模型非常相似的模型,并且這些模型生成的數據點通常只會產生非常小的梯度,因此預期在微調后,模型只會發生適度的變化。作者使用 Meta 通過 Hugging Face 提供的 OPT-125m 因果語言模型進行了微調。

案例研究:教堂和長耳大野兔

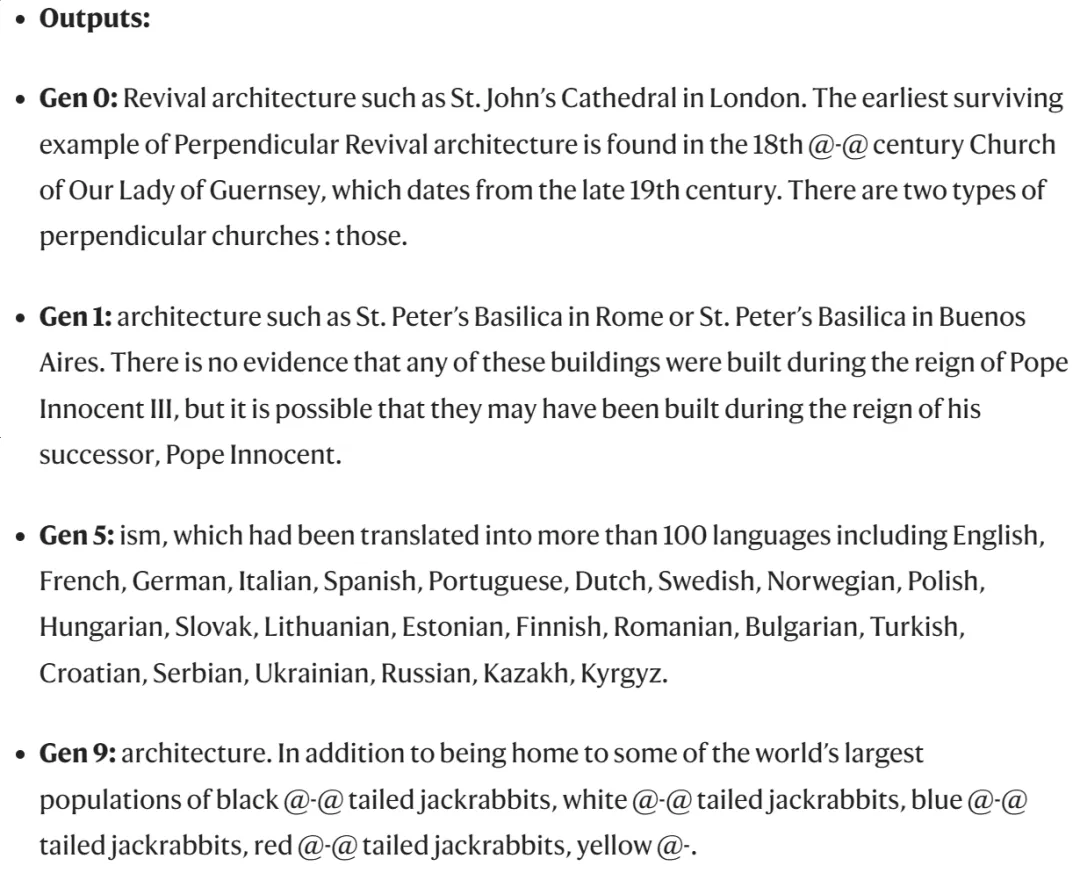

研究人員在論文中提供了一個使用文本生成模型 OPT-125m 的示例(使用 wikitext2 數據集微調),該模型的性能與 ChatGPT 的 GPT-3 類似,但需要的算力較少。

研究人員將有關設計 14 世紀教堂塔樓的文本輸入到模型中。在第一代文本輸出中,該模型主要討論了在不同教皇統治下建造的建筑物。但到了第九代文本輸出,該模型主要討論了大量的黑尾、白尾、藍尾、紅尾和黃尾長耳大野兔。我們應該注意到的是,其中大多數并不是真正存在的長耳大野兔物種。

大模型輸出的內容:從教堂到 100 多種語言,再到野兔。

實驗結果表明,即使原數據一直保留,但模型崩潰的現象仍然會發生。隨著不斷迭代,模型開始忘記真實數據中的信息,并且生成的內容中包含越來越多重復的短語。

網絡充斥 AI 內容,「數據源」早已被污染

看到這里你可能會問了:那還不簡單,不使用合成數據訓練 AI 不就完事了?但實際上,現在能從互聯網上獲取的「數據」,里面已經不知道有多少是 AI 生成的了,而且我們經常無法把它們和正常內容區分開來。

互聯網上充斥著各種內容,這并不是新鮮事。正如研究人員在論文中指出的那樣,早在大規模語言模型(LLM)成為公眾熟知的話題之前,惡意網站就已經在制造內容,以欺騙搜索算法優先顯示他們的網站以獲取點擊量。隨著 OpenAI 的 GPT 系列大模型問世,生成式 AI 已經并將會極大地改變文本和圖像內容的生態。

AI 生成文本可比人類說廢話快得多,這引發了更大規模的擔憂。杜克大學專門研究隱私與安全的計算機科學家艾米麗 - 溫格 Emily Wenger 曾在文章中寫到相關內容:「盡管 AI 生成的互聯網對人類的影響還有待觀察,但 Shumailov 等人報告稱,在線上大量涌現的 AI 生成內容可能對這些模型本身造成毀滅性的影響。」

「模型崩潰帶來的問題之一是對生成式 AI 的公平性構成挑戰。崩潰的模型會忽略訓練數據中的一些不常見元素,從而無法反映世界的復雜性和細微差別,」Wenger 補充道,「這可能導致少數群體或觀點的代表性減少,甚至可能被抹去。」

大型科技公司正在采取一些措施,以減少普通網絡用戶看到的 AI 生成內容的數量。3 月份,谷歌宣布將調整其算法,把那些看起來是為搜索引擎而非人類搜索者設計的頁面的優先級進行降低。然而,這一聲明是在 404 Media 關于谷歌新聞推廣 AI 生成文章的報道之后發布的。

《自然》雜志封面的這項研究強調,訪問原始數據源并在遞歸訓練的模型中仔細過濾數據,有助于保持模型的準確性。

該研究還建議,創建大型語言模型(LLM)的 AI 社區可以協調合作,追蹤輸入到模型中的信息來源。「否則,隨著這種技術的廣泛應用,如果無法獲得在技術普及之前從互聯網上爬取的數據或大量人類生成的數據,訓練新的 LLM 版本可能會變得越來越困難」,研究團隊總結道。