Nature封面:AI訓(xùn)AI,越訓(xùn)越傻

AI訓(xùn)練AI,可能會讓AI變傻?!

來自牛津、劍橋等學(xué)校機(jī)構(gòu)的研究人員最新發(fā)現(xiàn),使用合成數(shù)據(jù)訓(xùn)練,大模型可能會崩潰。其研究成果被選為最新的Nature封面。

直接一個:GARBAGE OUT!

要知道,現(xiàn)在絕大部分科技公司的大模型都在用合成數(shù)據(jù)來緩解“數(shù)據(jù)荒”。這下無疑是整個行業(yè)澆了一波冷水。

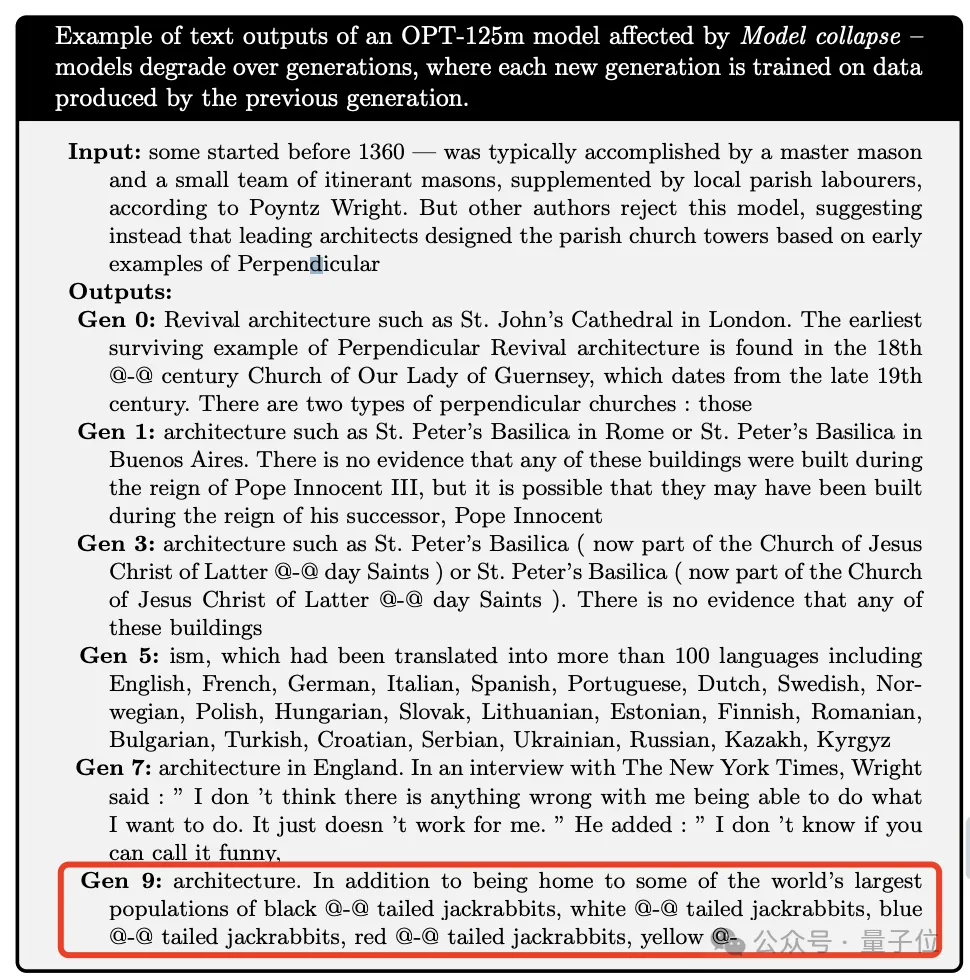

研究團(tuán)隊給了這樣一個例子。

他們測試了Meta的OPT-125m模型,詢問了關(guān)于中世紀(jì)建筑的相關(guān)信息。

每一次微調(diào)都是由上一次生成的數(shù)據(jù)來訓(xùn)練。結(jié)果前面幾輪回答還好。結(jié)果就在第九次,就開始胡說八道……

扯到兔子是什么鬼?!

該論文主要作者表示,他們曾考慮過合成數(shù)據(jù)可能對大模型造成誤差,但未曾預(yù)料到模型的惡化速度會如此迅速。

三個誤差導(dǎo)致模型崩潰

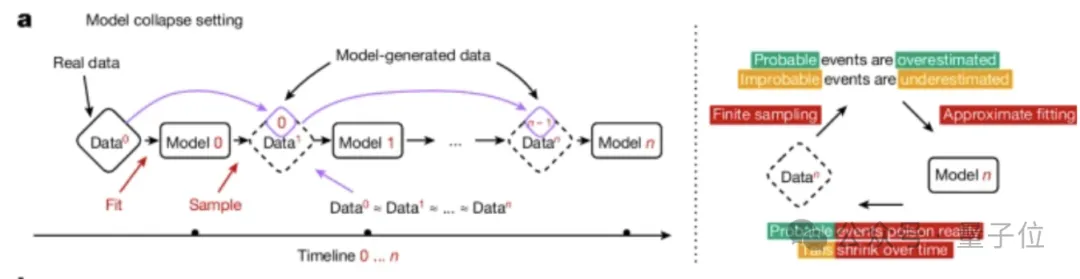

首先,團(tuán)隊定義了什么是模型崩潰。

模型崩潰是一個退化過程,模型生成的內(nèi)容會污染下一代的訓(xùn)練數(shù)據(jù)集。而在被污染的數(shù)據(jù)上訓(xùn)練之后,新一代模型就容易誤解現(xiàn)實。

以此循環(huán)往復(fù),一代更比一代差。

按照時間推移,主要分為兩種情況:早期模型崩潰和晚期模型崩潰。

早期模型崩潰中,模型開始丟失一些尾部信息。(類似概率分布中一些低概率事件) 而在晚期模型崩潰,模型將收斂到同原始分布幾乎沒有任何相似之處。

這一過程的發(fā)生,同模型設(shè)計、學(xué)習(xí)過程和所用數(shù)據(jù)質(zhì)量有關(guān)。

具體到理論中,主要包括了這三個誤差導(dǎo)致大模型同原始模型的偏離。

- 統(tǒng)計近似誤差。這是主要類型的誤差,由于樣本數(shù)量有限而產(chǎn)生,并隨著樣本數(shù)量趨于無窮大而消失。這是因為在重新采樣的每一步中信息都有可能丟失,這種概率不為零。

- 函數(shù)表達(dá)性誤差。這種誤差是由于函數(shù)近似表達(dá)能力有限而產(chǎn)生的。特別是,神經(jīng)網(wǎng)絡(luò)只有在其規(guī)模達(dá)到無窮大時才是通用近似值。不過,在沒有其他兩種誤差的情況下,這種誤差只會發(fā)生在第一代。

- 函數(shù)近似誤差。主要由學(xué)習(xí)過程局限性引起,例如隨機(jī)梯度下降的結(jié)構(gòu)偏差或目標(biāo)的選擇。這種誤差可以看作是在無限數(shù)據(jù)和每一代都具有完美表達(dá)能力的情況下產(chǎn)生的誤差。

對語言模型的影響

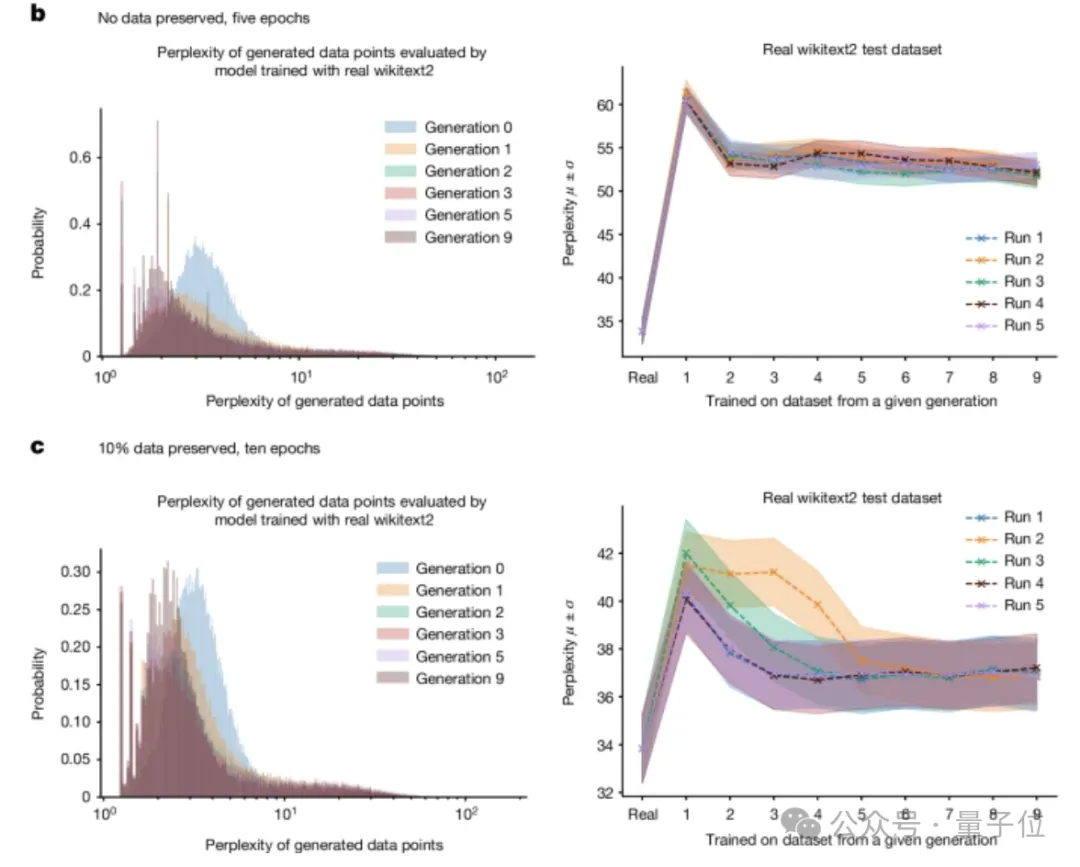

隨后研究人員評估了模型崩潰對語言模型的影響。由于從頭開始訓(xùn)練大模型成本非常高,他們選擇評估語言模型最常見的設(shè)置:微調(diào)設(shè)置。

每個訓(xùn)練周期都從具有最新數(shù)據(jù)的預(yù)訓(xùn)練模型開始。訓(xùn)練數(shù)據(jù)來自另一個經(jīng)過微調(diào)的預(yù)訓(xùn)練模型。

他們用Meta因果語言模型OPT-125m,在wikitext2上進(jìn)行了微調(diào)。

為了從訓(xùn)練好的模型中生成數(shù)據(jù),團(tuán)隊使用了five-way波束搜索。他們將訓(xùn)練序列設(shè)為 64 個token長度;然后對于訓(xùn)練集中的每個token序列,要求模型預(yù)測下一個64個token。

他們會瀏覽所有原始訓(xùn)練數(shù)據(jù)集,并生成一個相同大小的人工數(shù)據(jù)集。如果模型的誤差為0,它就會生成原始的wikitext2數(shù)據(jù)集。

為了進(jìn)一步感受區(qū)別,他們采用兩種不同的設(shè)置:一組是除了最開始訓(xùn)練,后續(xù)過程沒有任何原始訓(xùn)練數(shù)據(jù);另一組則是保留10%的原始數(shù)據(jù)。

結(jié)果顯示,隨著時間推移,模型產(chǎn)生的錯誤會增加。在模型完全崩潰之前,它還會導(dǎo)致模型遺忘數(shù)據(jù)集中低概率事件,他們的輸出也變得更加同質(zhì)化。最終也就出現(xiàn)了開頭這一現(xiàn)象。

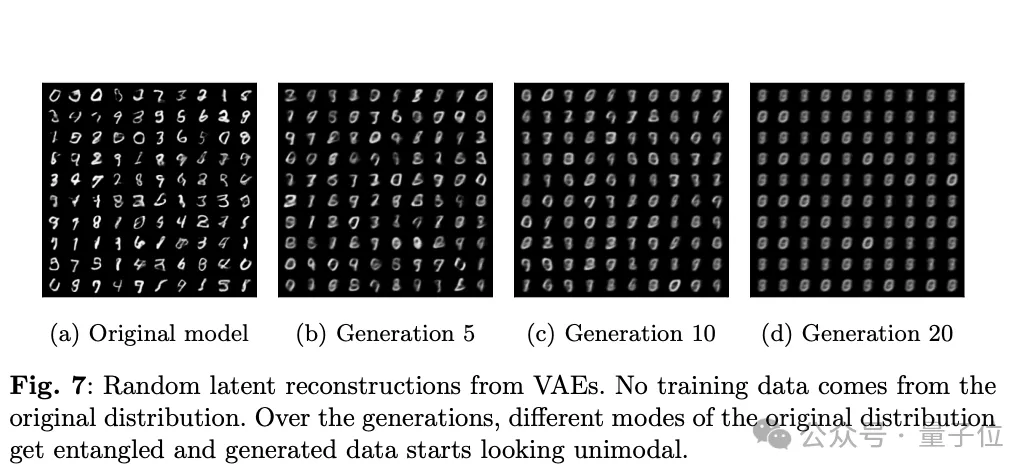

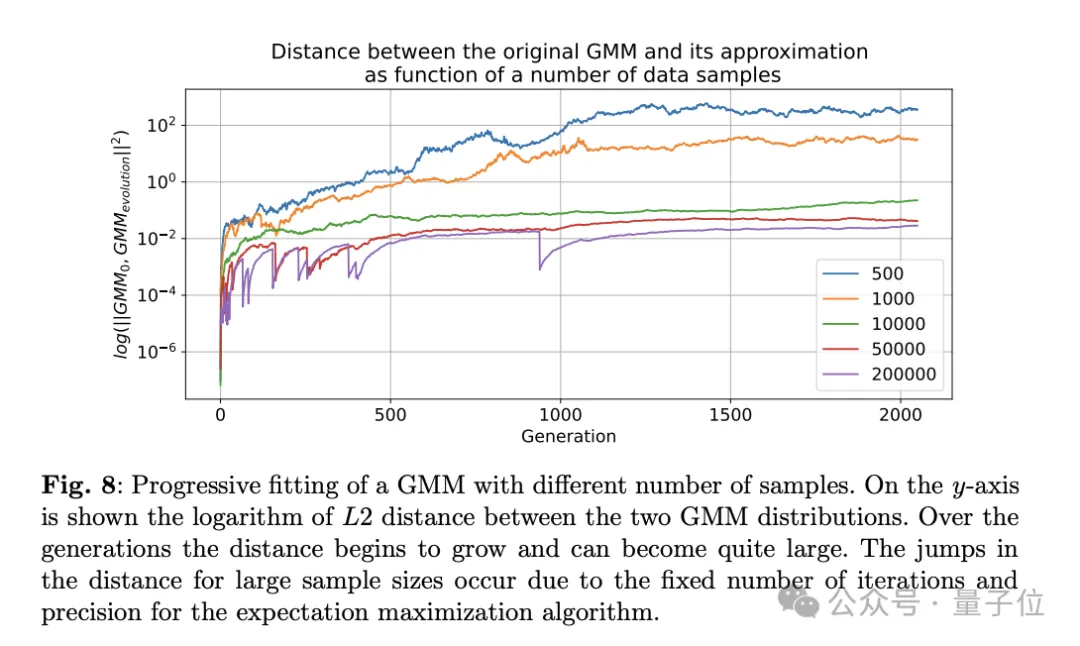

另外在VAE、GMM模型中看到了類似模型崩潰的現(xiàn)象。

來自杜克大學(xué)的Emily Wenger教授表示,到目前為止,要緩解這一問題并非易事。

有領(lǐng)先的科技公司已經(jīng)部署了一項技術(shù),即嵌入“水印”——

標(biāo)記AI生成的內(nèi)容,讓其在訓(xùn)練數(shù)據(jù)中排除。但困難在于,這需要科技公司之間的協(xié)調(diào),因此不太具有商業(yè)可行性。

這樣一來,那從之前互聯(lián)網(wǎng)獲取數(shù)據(jù)的公司,他們訓(xùn)練的模型更能代表現(xiàn)實世界。所以,最開始那一波大模型算是有了先發(fā)優(yōu)勢。

對于這一觀點,你怎么看呢?

參考鏈接:

[1]https://www.nature.com/articles/d41586-024-02420-7。

[2]https://www.nature.com/articles/d41586-024-02355-z。

[3]https://www.nature.com/articles/s41586-024-07566-y。