牛津劍橋「投毒」AI失敗9次登Nature封面,引爆學(xué)術(shù)圈激辯!AI訓(xùn)AI能否打破崩潰魔咒?

AI時(shí)代,數(shù)據(jù)就是新的石油。全球人類數(shù)據(jù)逐漸枯竭的時(shí)代,合成數(shù)據(jù)是我們的未來(lái)嗎?

最近Nature封面一篇論文引起的風(fēng)波,讓我們明白:重要的并不是「合成數(shù)據(jù)」,而是「正確使用合成數(shù)據(jù)」。

本周四,牛津、劍橋、帝國(guó)理工、多倫多大學(xué)等機(jī)構(gòu)的一篇論文登上了Nature封面。

他們提出了AI的「近親繁殖」問(wèn)題,即如果在訓(xùn)練中不加區(qū)別地只用AI產(chǎn)生的內(nèi)容,就會(huì)發(fā)生模型崩潰。

不過(guò),讓人沒(méi)想到的是,論文一經(jīng)刊出便引發(fā)了AI社區(qū)的大量討論。

一些人認(rèn)為,問(wèn)題的核心不在「合成數(shù)據(jù)」上,而是在「數(shù)據(jù)質(zhì)量」上。

即使全部用的是人工數(shù)據(jù),如果質(zhì)量太差,那結(jié)果一樣也是「垃圾進(jìn)垃圾出」。

甚至,有人覺(jué)得研究者故意采用了與實(shí)際操作不匹配的方法,實(shí)際上是在「嘩眾取寵」。

對(duì)此,馬毅教授表示,如今我們已經(jīng)走進(jìn)了缺少科學(xué)思想和方法的時(shí)代——

許多研究,不過(guò)都是重新發(fā)現(xiàn)一些科學(xué)常識(shí)。

如何避免模型崩潰?

那么問(wèn)題來(lái)了,在使用AI合成數(shù)據(jù)時(shí),如何才能避免發(fā)生模型崩潰呢?

混合數(shù)據(jù)才是未來(lái)

對(duì)于這篇Nature封面的文章,Scale AI的CEO Alexandr Wang深表贊同。

他表示,利用純合成數(shù)據(jù)來(lái)訓(xùn)練模型,是不會(huì)帶來(lái)信息增益的。

通常,當(dāng)評(píng)估指標(biāo)因「自蒸餾」(self-distillation)而上升時(shí),大概率是因?yàn)橐恍└[蔽的權(quán)衡:

- 合成數(shù)據(jù)可以在短期內(nèi)提升評(píng)估結(jié)果,但之后你會(huì)為模型崩潰付出代價(jià)

- 你在訓(xùn)練或微調(diào)模型過(guò)程中積累了隱形的債務(wù),而這些債務(wù)將很難償還

具體而言,在連續(xù)幾代的合成訓(xùn)練中,錯(cuò)誤主要來(lái)自三個(gè)方面:

- 統(tǒng)計(jì)近似誤差(statistical approximation error)

- 功能表達(dá)誤差(functional expressivity error)

- 功能近似誤差(functional approximation error)

也就是,每次你用上一個(gè)模型生成的數(shù)據(jù)來(lái)訓(xùn)練新模型時(shí),都會(huì)丟失一些信息和精度,導(dǎo)致模型變得越來(lái)越空洞,最終無(wú)法正常工作。

雖然這些實(shí)驗(yàn)是在小規(guī)模模型(100M參數(shù))上進(jìn)行的,但觀察到的基本效應(yīng)也會(huì)隨著時(shí)間的推移在更大規(guī)模的模型上出現(xiàn)。

例如,今天的大多數(shù)模型無(wú)法生成像Slate Star Codex風(fēng)格的博客文章,這也是由于模型崩潰的原因。隨著我們連續(xù)訓(xùn)練模型,它們逐漸失去了在廣泛分布上進(jìn)行預(yù)測(cè)的能力。

在Wang看來(lái),混合數(shù)據(jù)(Hybrid Data)才是未來(lái)的發(fā)展方向,它能夠避免所有與模型崩潰相關(guān)的棘手問(wèn)題。

也就是說(shuō),在合成數(shù)據(jù)的過(guò)程中,必須通過(guò)某種新的信息來(lái)源來(lái)生成:

(1)使用真實(shí)世界數(shù)據(jù)作為種子

(2)人類專家參與

(3)形式邏輯引擎

相比之下,那些不慎使用了無(wú)信息增益的合成數(shù)據(jù)來(lái)訓(xùn)練模型的開(kāi)發(fā)者,終將會(huì)發(fā)現(xiàn)他們的模型隨著時(shí)間的推移變得越來(lái)越奇怪和愚蠢。

強(qiáng)化學(xué)習(xí)is all you need

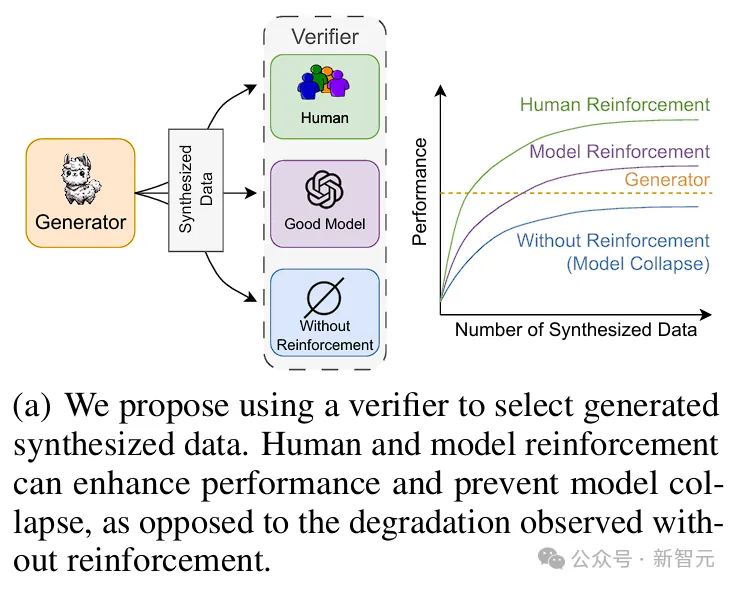

來(lái)自Meta、紐約大學(xué)和北京大學(xué)的研究人員,提出了一種通過(guò)人類或較弱模型的「排序-修剪反饋」方法,可以恢復(fù)甚至超越模型原來(lái)的性能。

對(duì)于這項(xiàng)研究,LeCun也進(jìn)行了轉(zhuǎn)發(fā),表示支持。

眾所周知,不管是對(duì)于人類還是機(jī)器來(lái)說(shuō),區(qū)分一個(gè)示例的好壞,要遠(yuǎn)比從頭生成一個(gè)高質(zhì)量的樣本容易得多。

基于此,作者提出了一種全新的方法——通過(guò)合成數(shù)據(jù)反饋來(lái)防止模型崩潰。

論文地址:https://arxiv.org/abs/2406.07515

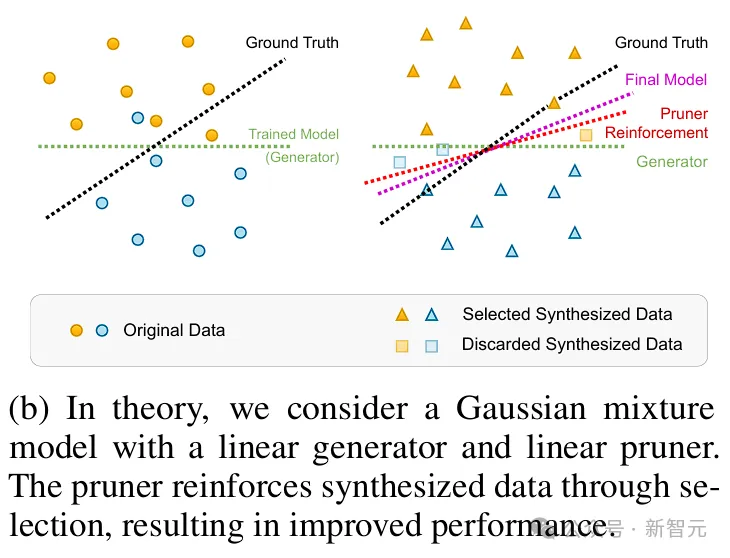

為了研究這個(gè)問(wèn)題,作者首先在理論環(huán)境中提供了分析結(jié)果。

在這里,作者提出了高維極限下的高斯混合模型和線性模型作為分類器,并讓一個(gè)驗(yàn)證者(例如人類或oracle)來(lái)選擇或修剪生成的數(shù)據(jù)。

結(jié)果顯示,當(dāng)合成數(shù)據(jù)點(diǎn)的數(shù)量趨于無(wú)限時(shí),基于選定數(shù)據(jù)訓(xùn)練的模型可以達(dá)到與原始數(shù)據(jù)訓(xùn)練相媲美的最佳結(jié)果。

在合成數(shù)據(jù)上的模擬顯示,與使用原始標(biāo)注相比,oracle監(jiān)督始終能產(chǎn)生接近最佳的結(jié)果。

此外,由于通過(guò)人類監(jiān)督來(lái)分辨高質(zhì)量數(shù)據(jù)比直接人類標(biāo)注更簡(jiǎn)單且成本更低,這為人類參與監(jiān)督的有效性提供了有力的證據(jù)。

一個(gè)具有線性生成器和線性剪枝器的高斯混合模型:其中的剪枝器通過(guò)選擇強(qiáng)化合成數(shù)據(jù)來(lái)提高性能

接下來(lái),作者進(jìn)行了兩個(gè)大規(guī)模的實(shí)驗(yàn):

1. 在算術(shù)任務(wù)(矩陣特征值預(yù)測(cè))上訓(xùn)練Transformer,并使用與真實(shí)值的距離來(lái)修剪大量合成數(shù)據(jù)

2. 使用大語(yǔ)言模型(Llama 2)和有限的合成數(shù)據(jù)進(jìn)行新聞?wù)?/span>

結(jié)果顯示,在這兩種情況下,僅依賴生成數(shù)據(jù)會(huì)導(dǎo)致性能下降,即使數(shù)據(jù)量增加,也會(huì)出現(xiàn)模型崩潰。

并且,僅根據(jù)困惑度從生成池中選擇最佳解決方案并不會(huì)提升性能,即模型本身缺乏基于困惑度選擇最佳預(yù)測(cè)的能力。

相反,在oracle監(jiān)督下,可以獲得一個(gè)基于反饋增強(qiáng)的合成數(shù)據(jù)集,其性能隨著數(shù)據(jù)量的增加而超過(guò)了原始數(shù)據(jù)集。

通過(guò)人類和模型的強(qiáng)化,可以提升性能并防止模型崩潰;而在沒(méi)有強(qiáng)化的情況下則會(huì)出現(xiàn)性能下降

因此,在用合成數(shù)據(jù)訓(xùn)練新模型時(shí),不僅要關(guān)注生成器的質(zhì)量,還需要一個(gè)高質(zhì)量的驗(yàn)證者來(lái)選擇數(shù)據(jù)。

一句話總結(jié)就是:reinforcement is all you need!

真實(shí)數(shù)據(jù)+合成數(shù)據(jù)

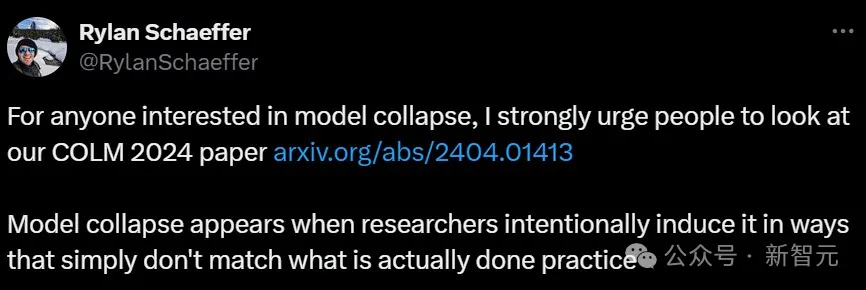

對(duì)于讀者們對(duì)于這篇Nature封面論文的吐槽,斯坦福大學(xué)的博士生Rylan Schaeffer表示理解。

他指出,模型崩潰通常出現(xiàn)在研究人員故意采用與實(shí)際操作不匹配的方法時(shí)。

數(shù)據(jù)積累可以崩潰,也可以不崩潰,這完全取決于具體的操作細(xì)節(jié)。

你們故意把它弄崩潰,它當(dāng)然就會(huì)崩潰了。??

在這篇斯坦福、馬里蘭和MIT等機(jī)構(gòu)合著的論文中,Schaeffer研究了積累數(shù)據(jù)對(duì)模型崩潰有何影響。

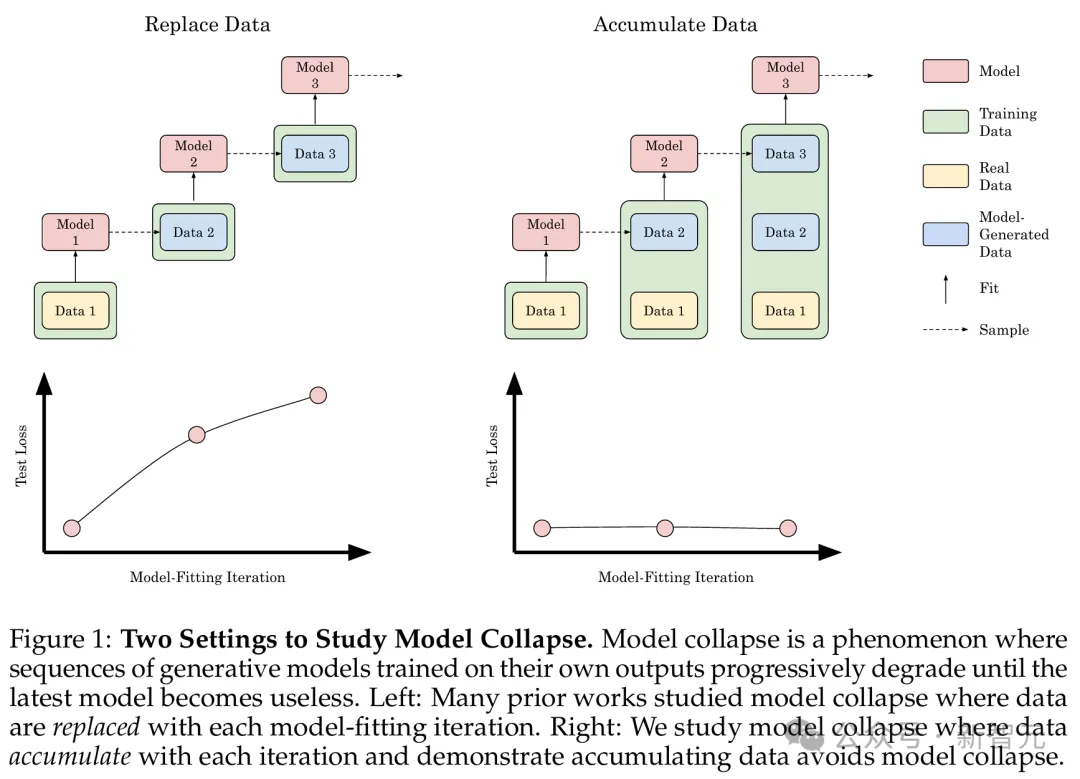

經(jīng)過(guò)實(shí)驗(yàn)后他們確認(rèn),用每一代的合成數(shù)據(jù)替換原始的真實(shí)數(shù)據(jù),確實(shí)會(huì)導(dǎo)致模型崩潰。

但是,如果將連續(xù)幾代的合成數(shù)據(jù)與原始的真實(shí)數(shù)據(jù)一起積累,可以避免模型崩潰。

論文地址:https://arxiv.org/abs/2404.01413

在實(shí)踐中,后代LLM會(huì)隨著時(shí)間推移,在不斷增加的數(shù)據(jù)中進(jìn)行訓(xùn)練,比如Llama 1需要1.4萬(wàn)億個(gè)token,Llama 2需要2萬(wàn)億個(gè)token,Llama 3需要15萬(wàn)億個(gè)token。

從某種意義上說(shuō),這種數(shù)據(jù)積累設(shè)定是極其悲觀的——

在這個(gè)假設(shè)的未來(lái)中,合成數(shù)據(jù)被不受控制地傾倒在互聯(lián)網(wǎng)上,用于訓(xùn)練模型的下一次迭代。

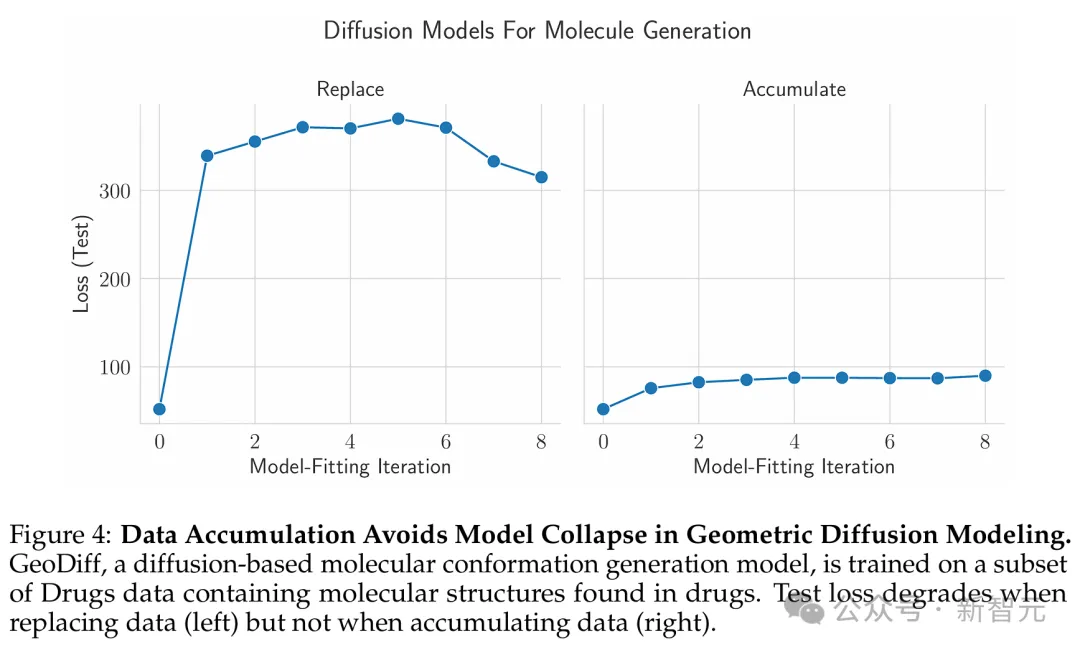

如圖右側(cè)所示,積累數(shù)據(jù)可以避免模型崩潰

研究者使用了因果Transformer、擴(kuò)散模型和自變分編碼器三種不同的實(shí)驗(yàn)設(shè)置,分別在真實(shí)文本、分子構(gòu)象和圖像數(shù)據(jù)集上進(jìn)行了訓(xùn)練。

他們發(fā)現(xiàn),替換數(shù)據(jù)會(huì)導(dǎo)致所有模型和所有數(shù)據(jù)集的模型崩潰,而積累數(shù)據(jù)可以避免模型崩潰。

基于Tranformer的因果語(yǔ)言建模

首先,他們?cè)谖谋緮?shù)據(jù)上訓(xùn)練了因果Transformer。

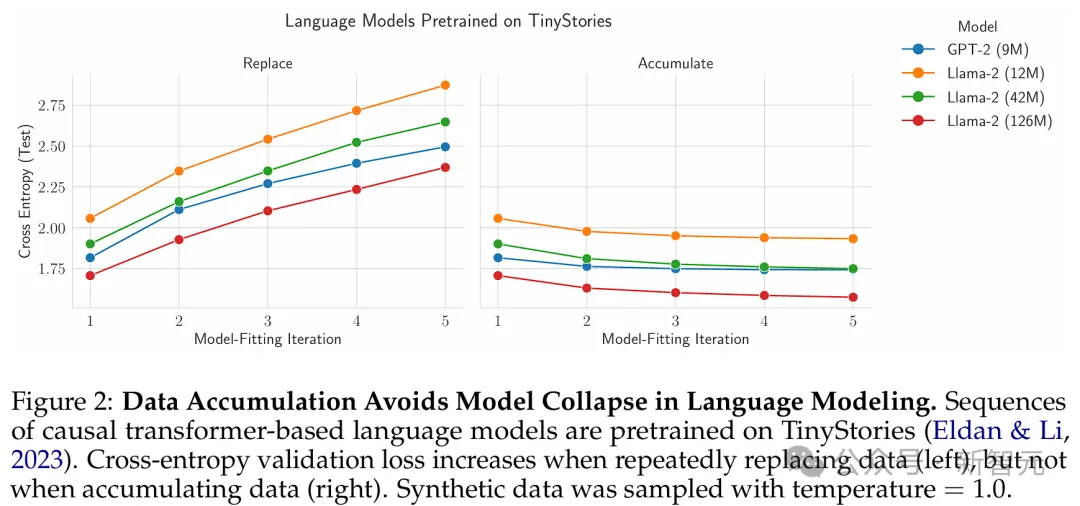

具體來(lái)說(shuō),就是在TinyS-tories上預(yù)訓(xùn)練了單個(gè)epoch的9M參數(shù)GPT-2和 12M、42M和125M參數(shù)的Llama 2語(yǔ)言模型。

前者是一個(gè)470M token的,GPT-3.5/4生成的幼兒園閱讀水平的短篇故事數(shù)據(jù)集。

對(duì)于每次模型擬合迭代n≥2,研究者會(huì)從上一次迭代的語(yǔ)言型中采樣一個(gè)與TinvStories大小相同的新數(shù)據(jù)集,然后用新生成的數(shù)據(jù)集替換或連接以前的數(shù)據(jù)集。

在每次模型擬合迭代中,他們會(huì)來(lái)自上一次迭代的替換或串聯(lián)數(shù)據(jù)集來(lái)預(yù)訓(xùn)練一個(gè)新的初始化模型。

結(jié)果顯示,對(duì)于所有架構(gòu)、參數(shù)計(jì)數(shù)和采樣溫度,隨著模型擬合迭代次數(shù)的增加,替換數(shù)據(jù)會(huì)導(dǎo)致測(cè)試交叉熵的增加(圖2左)。

同時(shí)他們還發(fā)現(xiàn),對(duì)于所有架構(gòu)、參數(shù)計(jì)數(shù)和采樣溫度,隨著模型擬合迭代次數(shù)的增加,積累的數(shù)據(jù)會(huì)導(dǎo)致測(cè)試交叉熵等于或更低(圖2右)。

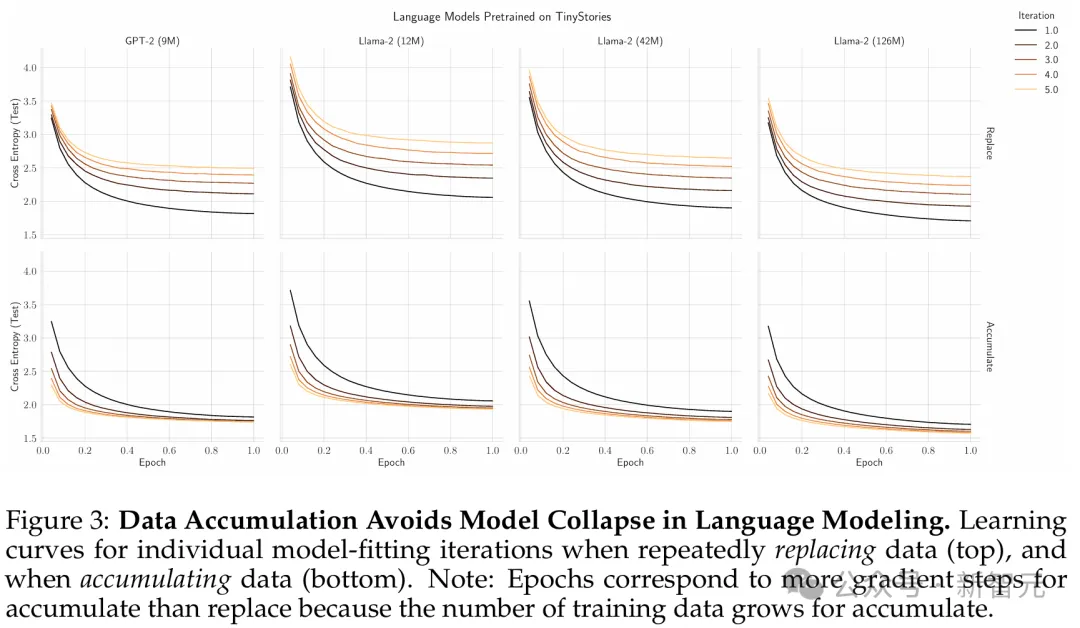

圖3是重復(fù)替換數(shù)據(jù)(頂部)和積累數(shù)據(jù)(底部)時(shí)各個(gè)模型擬合迭代的學(xué)習(xí)曲線。

結(jié)果顯示,數(shù)據(jù)積累避免了語(yǔ)言建模中的模型崩潰。

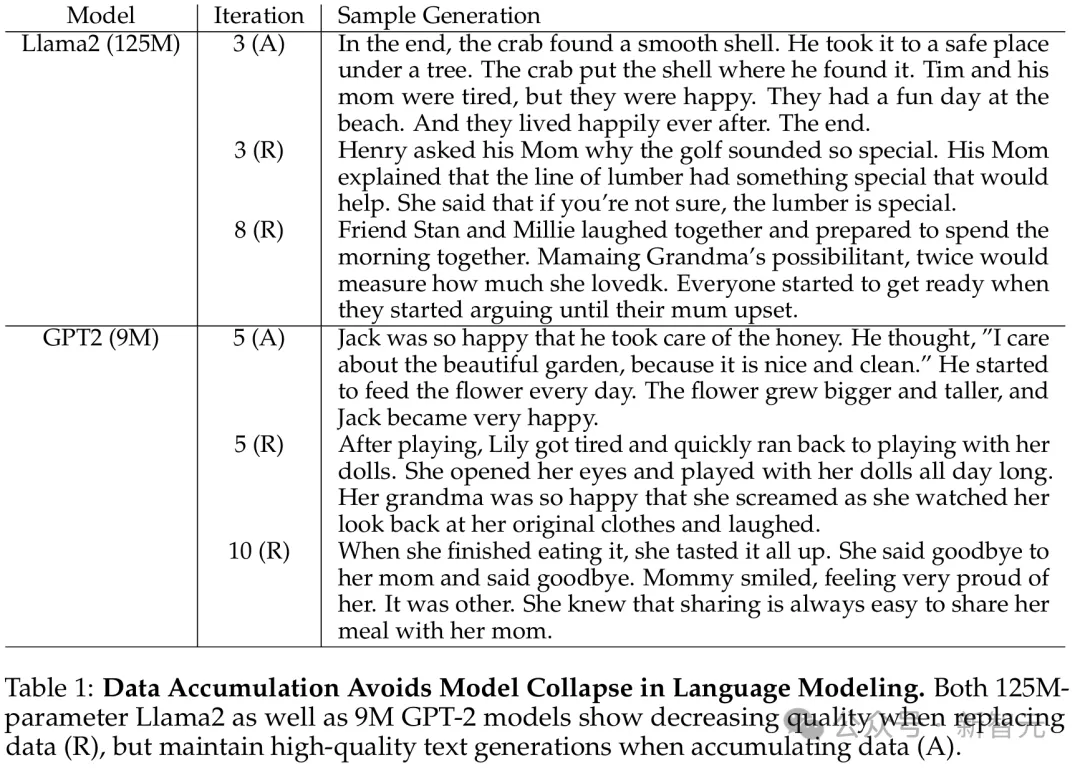

125M的Llama2和9M的GPT-2,在替換數(shù)據(jù)(R)時(shí)都表現(xiàn)出了質(zhì)量下降,但在積累數(shù)據(jù)(A)時(shí),卻保持了高質(zhì)量的文本生成。

分子構(gòu)象數(shù)據(jù)的擴(kuò)散模型

接下來(lái),他們?cè)诜肿訕?gòu)象數(shù)據(jù)上訓(xùn)練擴(kuò)散模型序列。

具體來(lái)說(shuō),研究者在GEOMDrugs數(shù)據(jù)集上訓(xùn)練了GeoDiff,這是一種用于分子構(gòu)象生成的幾何擴(kuò)散模型。

他們將GEOM-Drugs數(shù)據(jù)集的訓(xùn)練部分下采樣到40,000個(gè)分子構(gòu)象,將其用作初始訓(xùn)練集,并為每個(gè)預(yù)測(cè)執(zhí)行50個(gè)擴(kuò)散步驟。

結(jié)果經(jīng)過(guò)8次模型擬合迭代,研究者發(fā)現(xiàn):替換數(shù)據(jù)時(shí)測(cè)試損失增加,這與我們的語(yǔ)言模型實(shí)驗(yàn)相匹配,并且累積數(shù)據(jù)時(shí)測(cè)試損失保持相對(duì)恒定(圖4)。

與語(yǔ)言模型不同,他們發(fā)現(xiàn),當(dāng)替換數(shù)據(jù)時(shí),在合成數(shù)據(jù)訓(xùn)練的第一次模型擬合迭代中,性能會(huì)顯著惡化,并且在后續(xù)迭代中不會(huì)進(jìn)一步大幅下降。

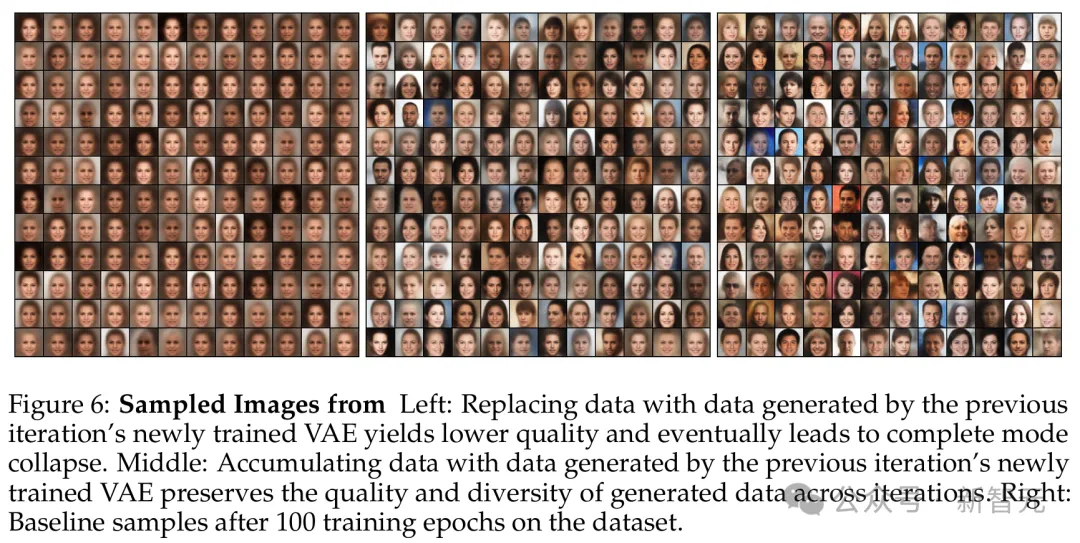

圖像數(shù)據(jù)的自變分編碼器

實(shí)驗(yàn)最后,研究者在CelebA上訓(xùn)練了自變分編碼器(VAE)序列,該數(shù)據(jù)集包含了20萬(wàn)張人臉圖像,分為訓(xùn)練集和測(cè)試集。

這種選擇,在具有許多樣本、彩色圖像和分辨率的現(xiàn)實(shí)數(shù)據(jù)集,和在累積數(shù)據(jù)上訓(xùn)練模型多次迭代的計(jì)算可行性之間,達(dá)到了平衡。

結(jié)果他們發(fā)現(xiàn),在每次迭代中替換數(shù)據(jù)再次表現(xiàn)出模型崩潰——

測(cè)試誤差會(huì)隨著每次額外的迭代而迅速上升,并且每次迭代產(chǎn)生的質(zhì)量較低且生成的面孔多樣性較少,直到所有模型生成都代表單一模式。

相比之下,在每次迭代中,積累數(shù)據(jù)會(huì)顯著減緩模型崩潰——

隨著每次額外的迭代,測(cè)試誤差的增加速度顯著減慢。

雖然與圖6的中圖和右圖相比,世代的多樣性確實(shí)下降了,它仍然代表數(shù)據(jù)集中變化的主要軸,例如性別,但模型似乎不再沿著數(shù)據(jù)流形的更短軸生成其他細(xì)節(jié),例如眼鏡和配件。

還有一個(gè)有趣的現(xiàn)象是,與語(yǔ)言建模不同,積累數(shù)據(jù)的測(cè)試誤差確實(shí)會(huì)隨著迭代次數(shù)的增加而增加(盡管比替換數(shù)據(jù)慢得多)。

為什么會(huì)存在這種差異?這個(gè)研究方向就留給未來(lái)了。