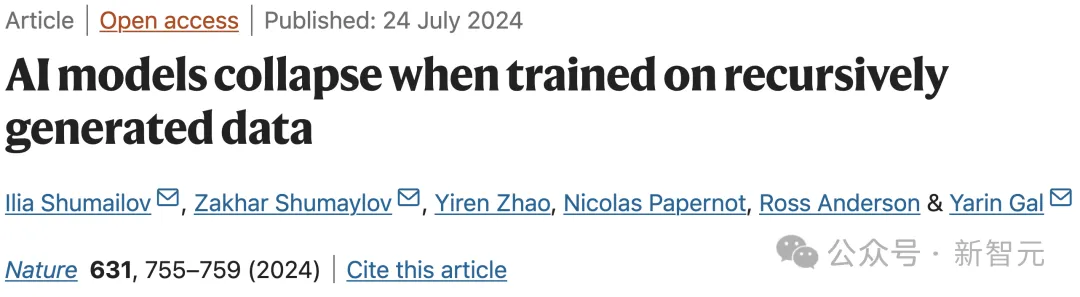

AI訓AI慘遭投毒9次大崩潰,牛津劍橋等驚天發現登Nature封面!

用AI生成的數據訓練AI,模型會崩潰?

牛津、劍橋、帝國理工、多倫多大學等機構的這篇論文,今天登上了Naure封面。

如今,LLM已經強勢入侵了人類的互聯網,極大地改變了在線文本和圖像的生態系統。

如果網絡上的大部分文本都是AI生成的,我們用網絡數據訓練出的GPT-n,會發生什么?

論文地址:https://www.nature.com/articles/s41586-024-07566-y

研究者發現,如果在訓練中不加區別地使用AI產生的內容,模型就會出現不可逆轉的缺陷——原始內容分布的尾部(低概率事件)會消失!

這種效應,被稱為「模型崩潰」。

換句話說,合成數據就像是近親繁殖,會產生質量低劣的后代。

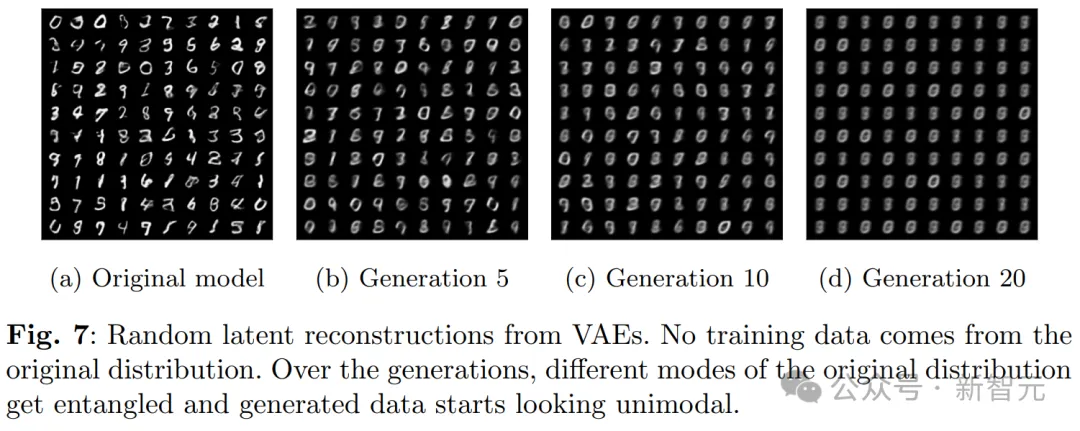

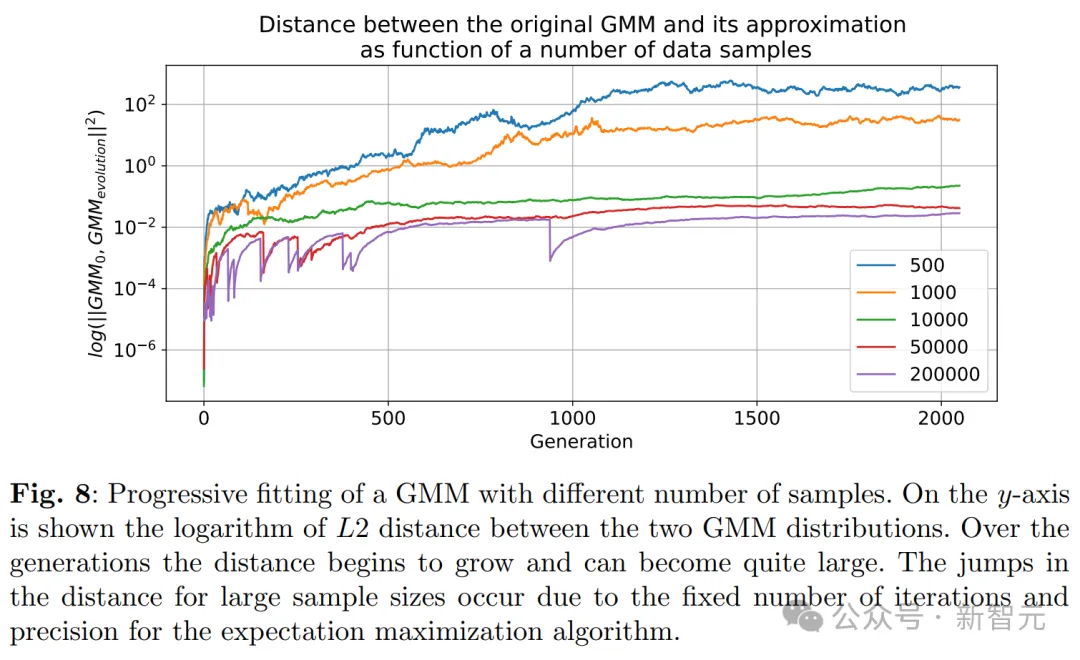

模型崩潰在LLM、變分自編碼器VAEs和高斯混合模型GMM中,都可能會發生。

有網友認為,是時候敲響警鐘了!

「如果大模型真的在AI生內容的重壓下崩潰,這對它們的可信度來說是一個末日場景。如果它們吃的是機器人的反芻的內容,我們真的能相信LLM的輸出嗎」?

真實數據,價值連城

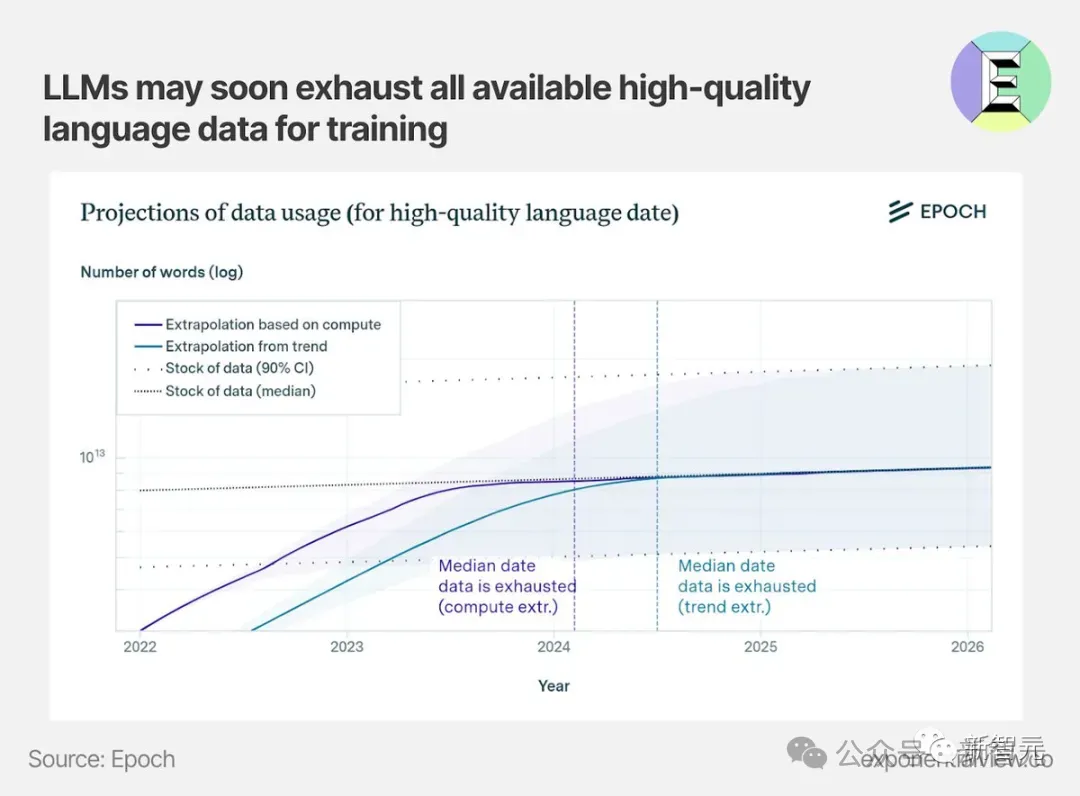

我們都知道,如今全球已陷入高質量數據荒。

EpochAI預測,全球在今年就會陷入高質量數據荒

當前的大模型(包括GPT-3)還是主要基于人類生成的文本進行訓練的,但是未來可就不一定了!

Meta研究員Thomas Scialom表示,Llama 3在后訓練階段沒有使用任何人類編寫的答案,全是Llama 2合成的數據

如果未來,大多數模型的訓練數據也是從網上抓取的,那它們不可避免地會用上前輩模型生成的數據。

如果當某個版本的GPT生成的大部分文本,成為了后續模型的訓練數據集,隨著版本號的增加,GPT-{n}會發生什么變化?

LLM迭代至第9代,完全胡言亂語

簡單講,LLM生成的數據最終污染了下一代模型的訓練集,就會出現「模型崩潰」(model collapse)的現象。

由于在被污染的數據上進行訓練,LLM隨后會錯誤地感知現實。

這樣一來,會導致多代AI生成模型的退化。

也就是那句經典名言——垃圾進,垃圾出。

合成數據,無異于給數據集「投毒」。

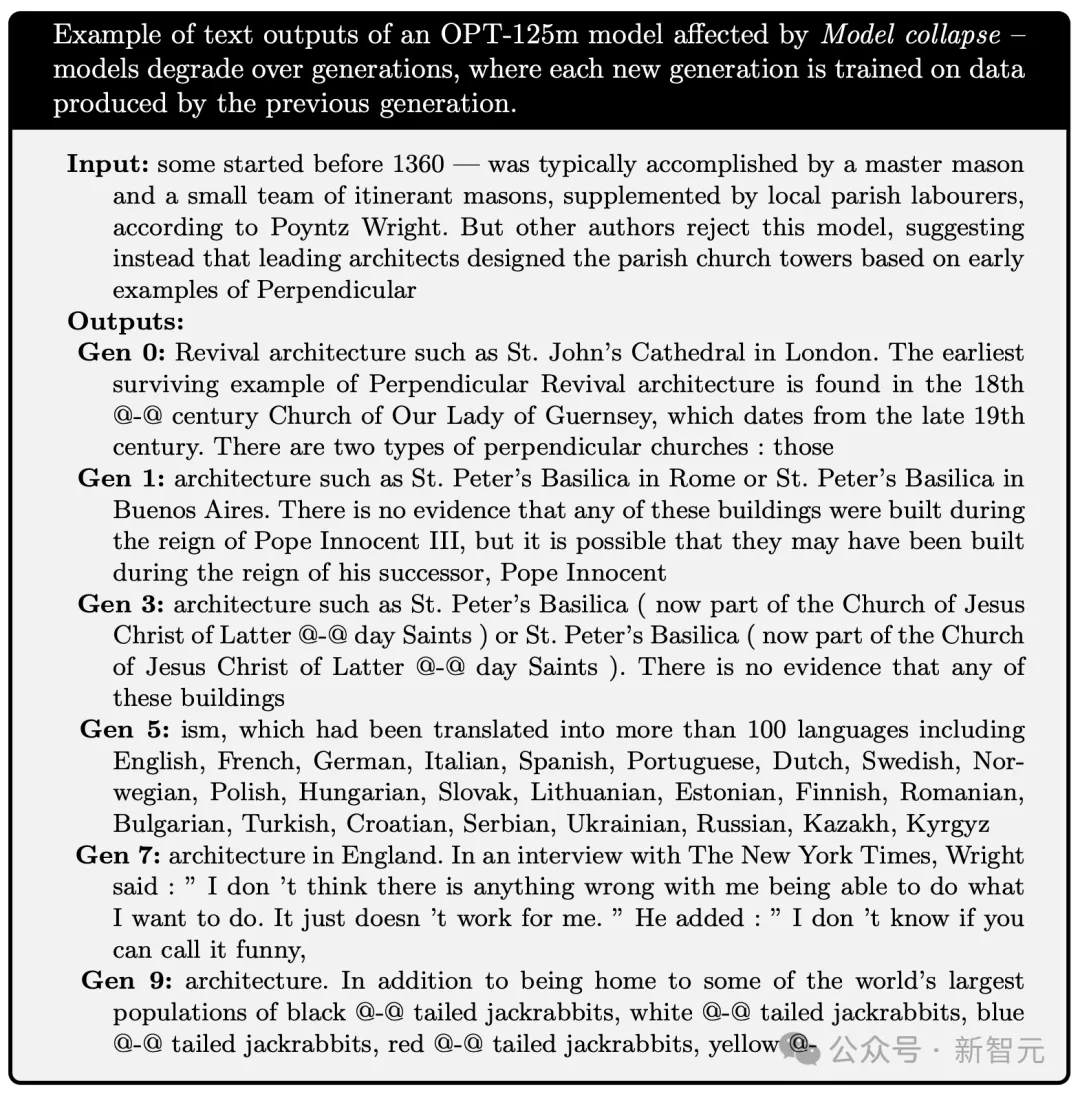

研究中,作者們使用維基百科文章先訓練了模型OPT-125m,并在前一代模型生成的文本上,訓練了多代模型。

模型們被要求續寫一段來自wiki的關于「薩默塞特(Somerset)一級登錄建筑」條目的文本。

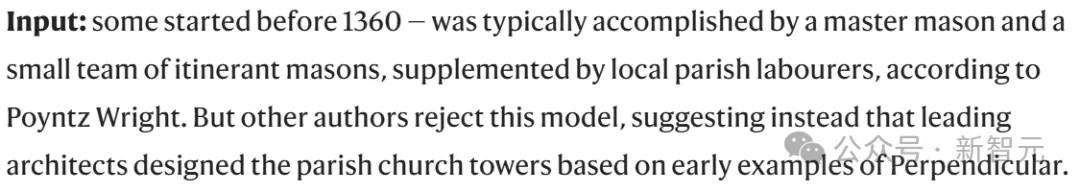

輸入的提示如下所示,這是關于設計14世紀教堂塔樓主題的文本:

輸入:據Poyntz Wright所說,一些教堂塔樓在1360年之前就開始建造了,通常是由一位大師石匠和一小隊流動石匠完成,輔以當地教區的工人。但其他作者不同意這種觀點,他們認為主要是由著名建筑師根據早期的垂直風格設計了這些教區教堂的塔樓。

在第0代模型中,輸入同樣的提示,得到的輸出是:

可以看到,Gen0的續寫已經開始有點前言不搭后語了,而且還出現了詭異的符號「@-@」。

奇怪的事實錯誤是,圣約翰大教堂位于紐約,不在倫敦。

第0代:復興建筑的典型例子包括倫敦的圣約翰大教堂。最早的垂直復興建筑實例可以在18@-@世紀的根西島圣母教堂中找到,該教堂實際建于19世紀晚期。垂直教堂有兩種類型:那些。

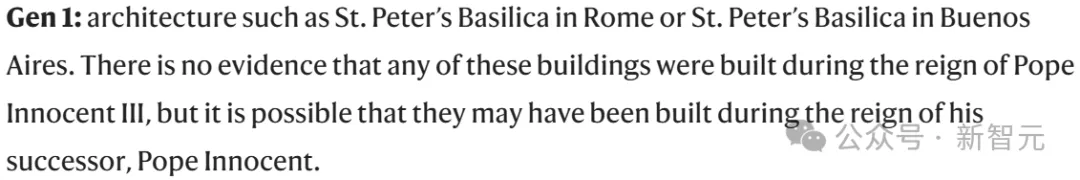

在Gen1中,雖沒有奇怪符號的輸出,但同樣出現了事實錯誤——

圣彼得大教堂(St. Peter's Basilica)真正位于梵蒂岡,而不是什么羅馬、布宜諾斯艾利斯。

而且建造于公元1506和1626年之間,由教皇朱利奧二世開始建造,直至教皇奧本八世。

第1代:像羅馬的圣彼得大教堂或布宜諾斯艾利斯的圣彼得大教堂這樣的建筑。雖然沒有證據表明這些建筑是在教皇英諾森三世統治期間建造的,但它們有可能是在他的繼任者教皇英諾森統治期間建造的。

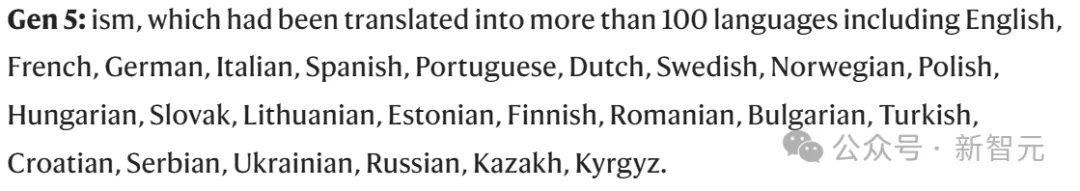

接下來,到了第五代模型,輸出的結果完全是胡言亂語了。

以ism起句,講了一大堆語種,根本不是續寫的相關素材。

第5代:ism,已被翻譯成100多種語言,包括英語、法語、德語、意大利語、西班牙語、葡萄牙語、荷蘭語、瑞典語、挪威語、波蘭語、匈牙利語、斯洛伐克語、立陶宛語、愛沙尼亞語、芬蘭語、羅馬尼亞語、保加利亞語、土耳其語、克羅地亞語、塞爾維亞語、烏克蘭語、俄語、哈薩克語、吉爾吉斯語。

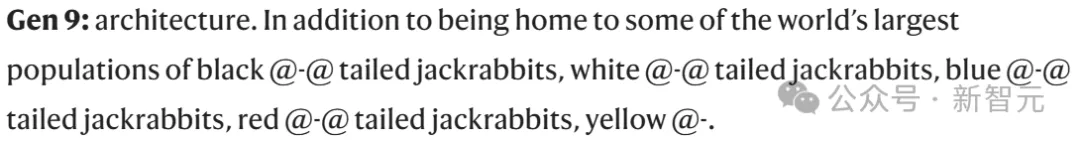

再到第9代,奇怪的@-@符號又出現了,而且還輸出了更加無關的內容——tailed jackrabbits。

第9代:建筑。除了擁有世界上最大數量的黑@-@尾兔、白@-@尾兔、藍@-@尾兔、紅@-@尾兔、黃@-。

以下是所有迭代模型,完整輸出的過程。每一代新的模型都是在前一代生成的數據上進行訓練的。

看得出,模型在每一代次迭代中退化。研究人員發現,所有遞歸訓練后的模型,皆會輸出重復的短語。

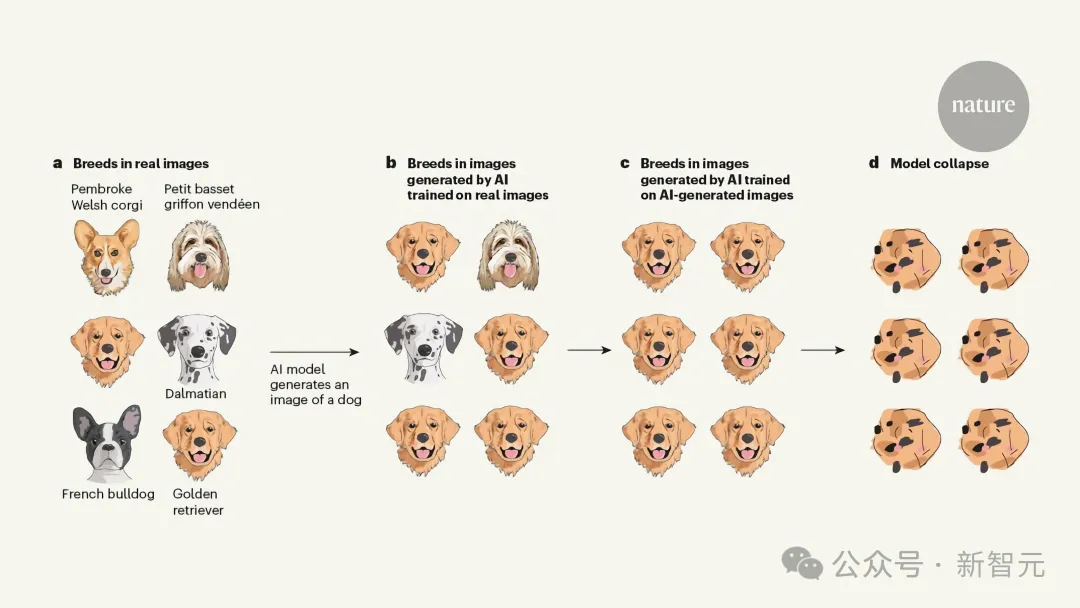

另一個案例是,今天杜克大學助理教授Emily Wenger,發表在Nature上一篇社論文章中指出:

AI基于自身數據訓練,生成的圖像扭曲了狗的品種。

數據集中,不僅有金毛、柯基,還有法國斗牛犬、小體巴塞特雪橇犬等。

基于真實數據訓練后的模型,輸出的圖像中,常見品種如金毛尋回犬占大多數,而不太常見的品種斑點狗會消失。

然后,基于AI生成的數據訓練模型,生成的品種全是金毛了。

最終,經過多次迭代,金毛的圖像就完全出現混亂,臉不是臉鼻子不是鼻子,LLM就此完全崩潰了。

此外,2023年來自斯坦福和UC伯克利的一項研究中,作者同樣發現了,LLM在少量自己生成數據內容重新訓練時,就會輸出高度扭曲的圖像。

論文地址:https://arxiv.org/pdf/2311.12202

他們還在實驗中展示了,一旦數據集受到污染,即便LLM僅在真實圖像上重新訓練,模型崩潰現象無法逆轉。

作者警示道,為了模型不再被自己「降級」,AI需要能夠區分真實和虛假內容。

這一觀點,與杜克Wenger不謀而合。

她認為,緩減LLM崩潰并不簡單,不過領先科技公司已經部署了嵌入「水印」的技術,進而可以把標記AI生成內容,從數據集中剔除。

此外,模型崩潰的另一個關鍵寓意是,那些早已構建的AI模型,有著先發優勢。

因為,從AI時代互聯網獲取訓練數據的公司,可能擁有更能代表真實世界的模型。

什么是模型崩潰?

最新研究中,作者表示,模型崩潰包含了兩種特殊的情況:早期模型崩潰、晚期模型崩潰。

在早期模型崩潰中,模型開始丟失關于數據分布尾部的信息;在晚期模型崩潰中,模型收斂到一個與原始分布幾乎沒有相似性的分布,通常方差顯著降低。

這一過程的發生,是由于三種特定誤差源,在多代模型中逐漸累積,最終導致模型偏離原始模型:

- 統計近似誤差

這是主要的誤差類型,由于樣本數量有限而產生,并且在樣本數量趨向無限時會消失。這是因為在每一步重采樣過程中,信息丟失的概率總是存在。

- 函數表達誤差

這是次要誤差類型,由于函數近似器(function approximator)的表達能力有限而產生。

特別是,神經網絡只有在其規模無限大時,才能成為通用近似器。

因此,神經網絡可能會在原始分布的支撐集(support)之外,引入「非零概率」,或在原始分布的支撐集內引入「零概率」。

一個簡單的例子是,如果我們用單個高斯分布,來擬合兩個高斯分布的混合。即使有完美的數據分布信息(即無限數量的樣本),模型產生誤差也是不可避免的。

然而,在沒有其他兩種類型誤差的情況下,這種誤差只會在第一代發生。

- 函數近似誤差

這也是次要的誤差類型,主要由于學習過程的限制而產生,例如隨機梯度下降的結構偏差或目標函數選擇的影響。

這種誤差可以看作,即便在理想條件下,即擁有無限數據且完美表達能力,仍在每一代模型中產生。

綜上所述,每種誤差都可能會導致模型崩潰變得愈加嚴重,或得到一些改善。

更強的近似能力甚至可能是一把「雙刃劍」。

因為更好的表達能力可能抵消統計噪聲,從而更好地逼近真實分布,但同樣也可能放大噪聲。

更常見的情況下,我們會得到一種級聯效應(cascading effect),其中個別的不準確性會結合起來,導致整體誤差的增長。

例如,過擬合密度模型會導致模型錯誤地外推,并將高密度區域分配給訓練集中未覆蓋的低密度區域。

這些錯誤分配的區域,隨后會被頻繁采樣。

值得注意的是,除上述內容之外,還存在其他類型的誤差。比如,在實際操作中,計算機精度是有限的。

接下來,研究人員將通過「數學直覺」來解釋上述誤差是如何產生的,不同誤差來源如何復合(compound),以及我們如何量化平均模型偏差。

理論直覺

在所有基于前幾代生成數據進行遞歸訓練的生成模型,這種現象都是普遍存在的。

所以,到底是什么原因,導致了模型崩潰?

研究者提供了幾種理論解釋。

通過研究兩個數學模型,研究者量化了前一部分討論的誤差來源。

這兩個模型分別是一個在沒有函數表達能力和近似誤差情況下的離散分布模型,以及一個描繪聯合函數表達能力和統計誤差的多維高斯近似模型。

它們既足夠簡單,可以提供感興趣量的解析表達式,同時也能描繪模型崩潰的現象——

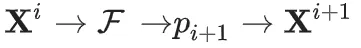

考慮的總體隨機過程,作者稱之為「代際數據學習」。

第i代的數據集D_i由具有分布p_i的獨立同分布隨機變量 組成。

組成。

其中,數據集的大小j∈{1,…,?M_i}。

從第i代到第i+1代,我們需要估計樣本在新數據集D_i中的分布,近似為 。

。

這一步稱之為函數近似, 。

。

然后通過從 中采樣,生成數據集

中采樣,生成數據集 。

。

其中,非負參數α_i,?β_i,?γ_i的和為1,即它們表示來自不同代的數據的比例。

它們對應的混合數據,分別來自原始分布(γ_i)、上一代使用的數據(β_i)和新模型生成的數據(α_i)。

這一步,稱為采樣步驟。

對于即將討論的數學模型,我們考慮α_i=γ_i=0,即僅使用單步的數據,而數值實驗則在更現實的參數選擇上進行。

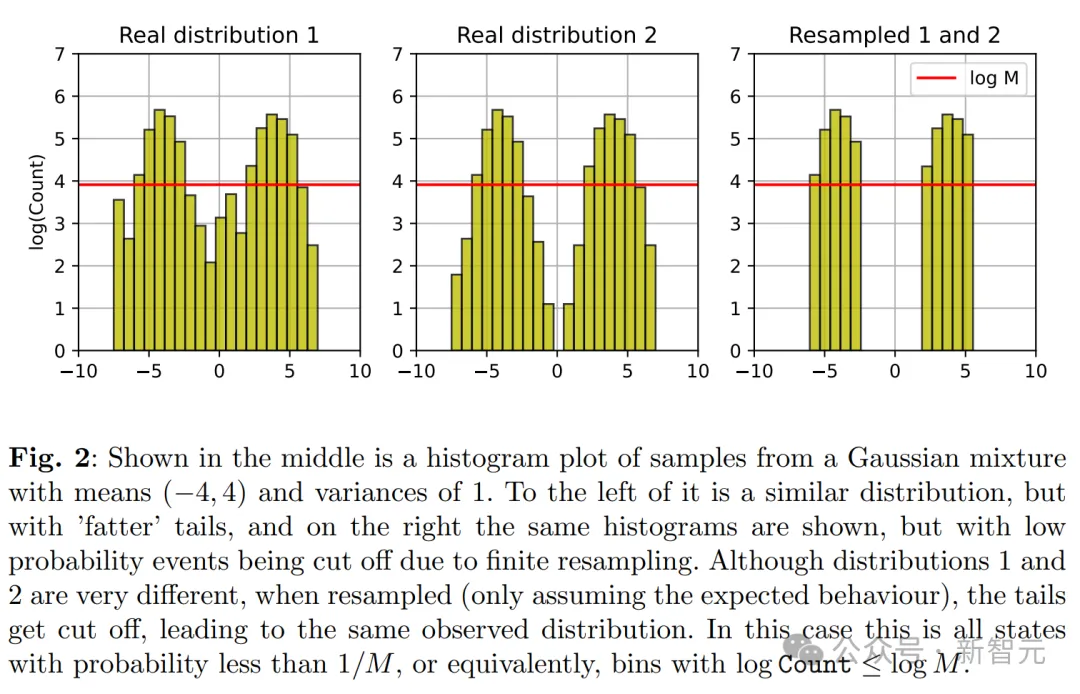

離散分布的精確近似

在本小節中,我們討論一種沒有函數近似和表達誤差的離散概率分布,即 。

。

在這種情況下,模型崩潰的原因僅僅是采樣步驟中的統計誤差。

首先,由于低概率事件被采樣到的概率很低,它們的尾部(低概率事件)會逐漸消失,隨著時間的推移,分布的支持范圍也會縮小。

假設樣本量為M,如果我們考慮一個概率為q≤1/M的狀態i,那么來自這些事件的i值樣本的期望數量將小于1。

也就是說,我們會失去關于這些事件的信息。

如果更一般地考慮一個概率為q的狀態i,使用標準條件概率,我們可以證明失去信息的概率(即在某些代中沒有采樣到數據)等于1?q。

這也就意味著,分布最終會收斂到某個狀態處的δ函數,最終落在某個狀態的概率等于從原始分布中采樣該狀態的概率。

將 這個過程看作一個馬爾可夫鏈,我們就可以直接證明上述結論,因為X^(i+1)僅依賴于X^i。

這個過程看作一個馬爾可夫鏈,我們就可以直接證明上述結論,因為X^(i+1)僅依賴于X^i。

此外,如果所有 的值都相同,那么在下一代,近似分布將完全是一個δ函數。因此所有

的值都相同,那么在下一代,近似分布將完全是一個δ函數。因此所有 的值也將相同。

的值也將相同。

這就意味著,馬爾可夫鏈至少包含一個吸收態,因此它會以概率1收斂到其中一個吸收態。

對于這個鏈,唯一的吸收態是那些對應于δ函數的狀態。

因此,隨著我們跟蹤的模型逐漸崩潰,我們必然會陷入一個常數狀態;當這條鏈被完全吸收時,原始分布的所有信息就都喪失了。

在一般情況下,這個論點也是成立的,因為浮點表征是離散的,因此使得模型參數的馬爾可夫鏈也是離散的。

因此,只要模型參數化允許使用δ函數,我們一定會到達這個結論,因為由于采樣誤差的原因,唯一可能的吸收態就是δ函數。

基于上述討論,我們可以看到,無論是早期模型崩潰(僅低概率事件被切斷)還是后期模型崩潰(過程開始收斂到單一模式)的現象,只要是在具有完美函數近似的離散分布下,都必然會出現。

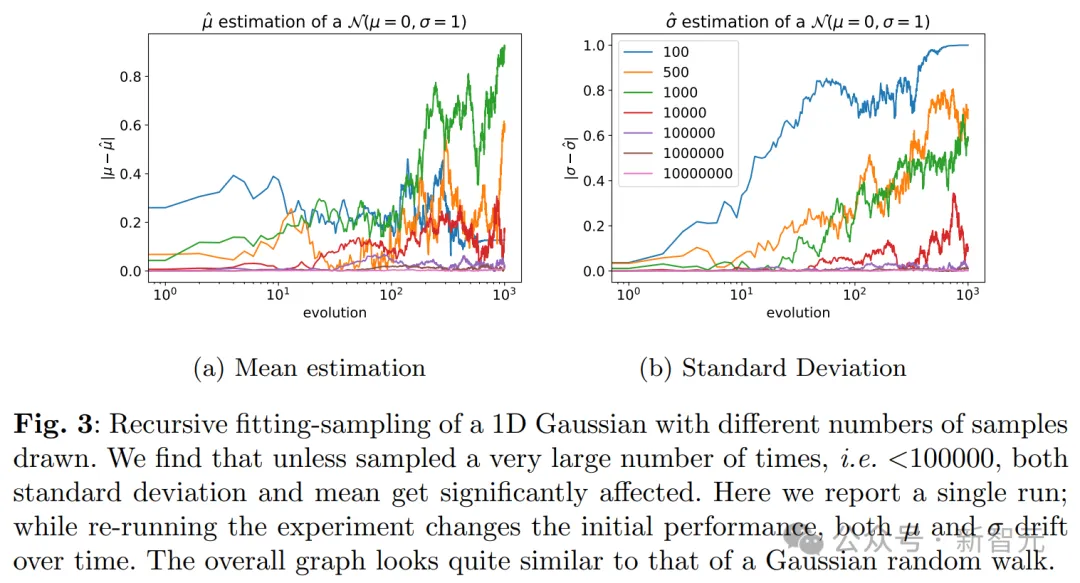

多維高斯分布

在討論了離散分布之后,我們就可以提出一個更通用的結果,它可以在高斯近似的背景下得到證明。

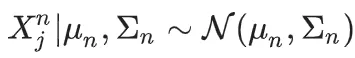

在這種情況下,每一代的數據都是通過上一代的均值和方差的無偏估計來近似的。

高斯模型崩潰

假設原始數據是從分布D_0(不一定是高斯分布)中采樣的,且樣本方差不為零。假設X^n是遞歸地使用上一代的無偏樣本均值和方差估計來擬合的,其中 且樣本量是固定的。

且樣本量是固定的。

此時就可以得到 。

。

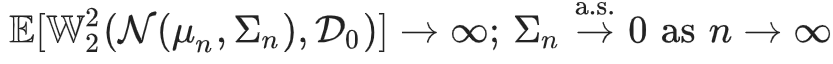

其中,W_2表示第n代的真實分布和其近似之間的Wasserstein-2距離。

換句話說,這意味著不僅第n代的近似值會任意遠地偏離原始分布,而且隨著代數的增加,它也會以概率1收斂到零方差,從而發生崩潰。

這個定理展示了后期模型崩潰的效果,即過程開始收斂到零方差。這個過程,與離散情況非常相似。

語言模型中的模型崩潰

當模型發生崩潰,會對語言模型產生哪些影響?

模型崩潰在各種機器學習模型中都是普遍現象,然而像變分自編碼器(VAE)和高斯混合模型(GMM)這樣的小模型通常是從頭開始訓練的,而LLM則有所不同。

從頭訓練的成本非常高,因此通常使用預訓練模型(如BERT、RoBERTa或GPT-2)進行初始化,然后再對預訓練模型進行微調以適應各種下游任務。

那么,當LLM使用其他模型生成的數據進行微調會發生什么呢?

實驗評估了訓練大語言模型最常見的微調設置,其中每個訓練周期(epoch)都從一個預訓練模型開始,并使用最新數據。

這里的數據來自另一個已經微調過的預訓練模型。

由于訓練范圍限制在生成接近原始預訓練模型的模型,由于這些模型生成的數據點通常只會產生非常小的梯度,因此實驗的預期是模型在微調后只會發生適度的變化。

實驗微調了Meta通過Hugging Face提供的OPT-125m因果語言模型,在wikitext2數據集上對模型進行微調。

為了生成訓練模型所需的數據,實驗使用五向集束搜索(beam search)。

將訓練序列限制為64個token,然后對于訓練集中的每個token序列,讓模型預測接下來的64個token。

用上面的方法調整所有原始訓練數據集,并生成一個大小相同的人工數據集。

由于范圍涉及所有原始數據集并預測了所有塊(Block),如果模型的誤差為0,它將生成原始的wikitext2數據集。

每一代的訓練都從原始訓練數據的生成開始,每個實驗運行五次,結果顯示為五次獨立運行,使用不同的隨機種子。

用wikitext2數據微調的原始模型,平均困惑度(perplexity)從零樣本基線的115下降到34,說明它成功地學習了任務。

最后,為了盡可能接近現實情況,實驗使用了在原始任務上表現最好的模型,使用原始wikitext2驗證集進行評估,作為后續幾代的基礎模型。

這意味著,實際上觀察到的模型崩潰可能更加明顯。

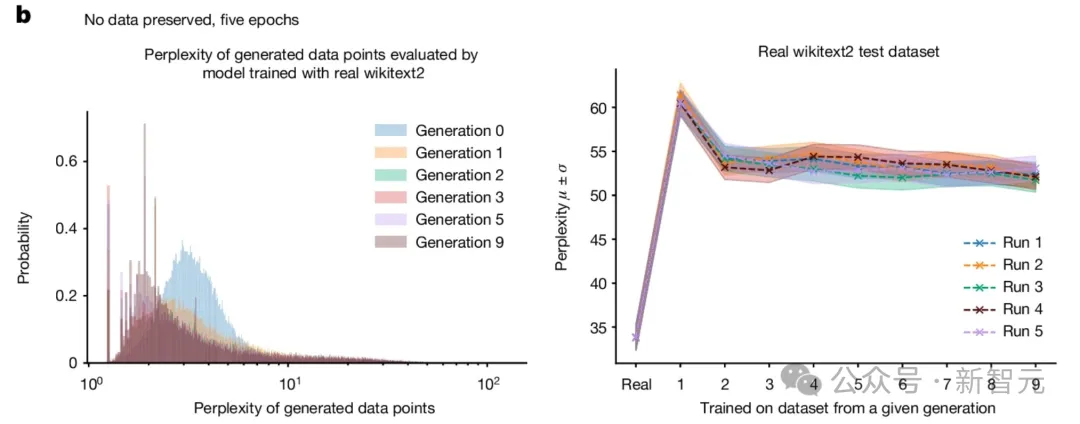

實驗還考慮了考慮兩種不同的設置:

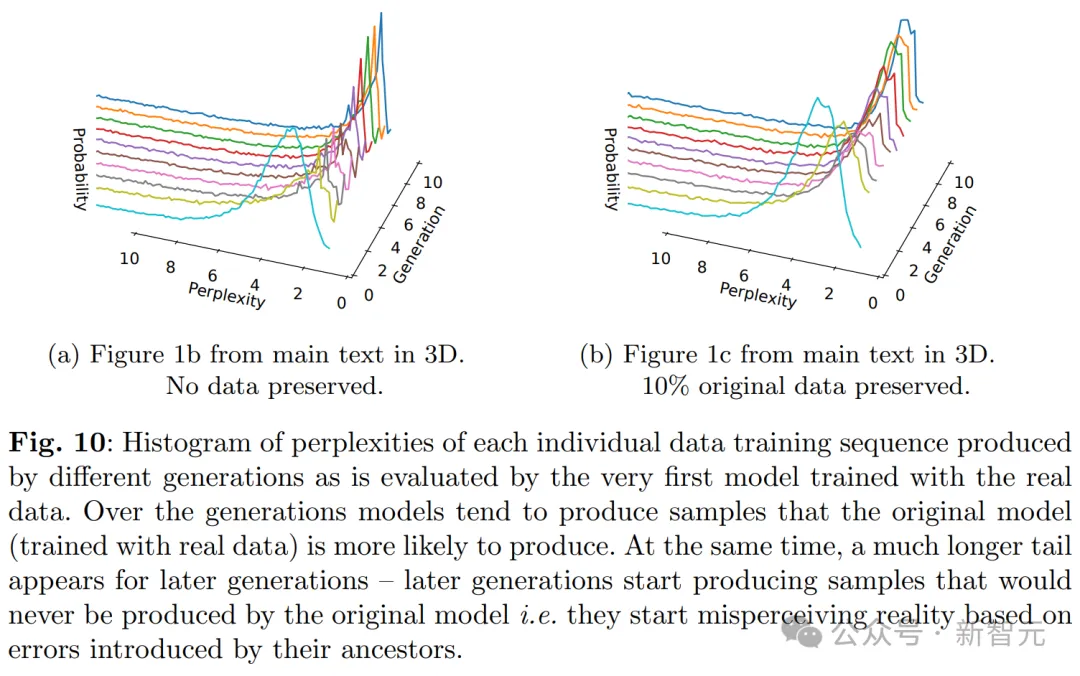

- 5個epoch,不保留原始訓練數據。

在這種情況下,模型在原始數據集上訓練五個周期,但在后續的訓練中不再使用原始數據。

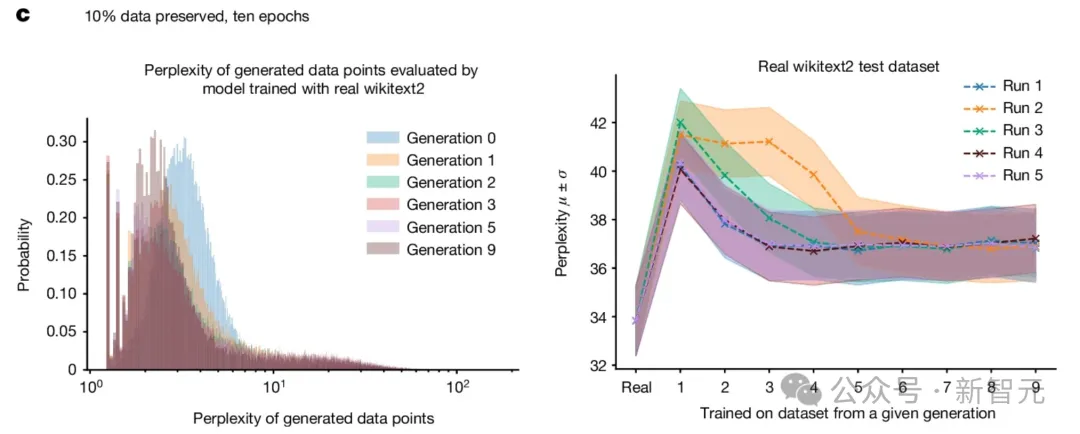

整體的原始任務表現如圖所示。

實驗發現,使用生成的數據進行訓練雖然能適應基本任務,但性能有所下降,困惑度從20增加到28。

- 10個epoch,保留10%的原始訓練數據。

在這種情況下,模型在原始數據集上訓練十個周期,并且每次新的訓練時,隨機保留10%的原始數據點。

整體的原始任務表現如圖所示。

實驗發現,保留部分原始數據可以更好地進行模型微調,并且僅導致性能的輕微下降。

雖然兩種訓練方式都導致了模型性能下降,但實驗發現使用生成數據進行學習是可行的,模型也能成功地學習一些基礎任務。

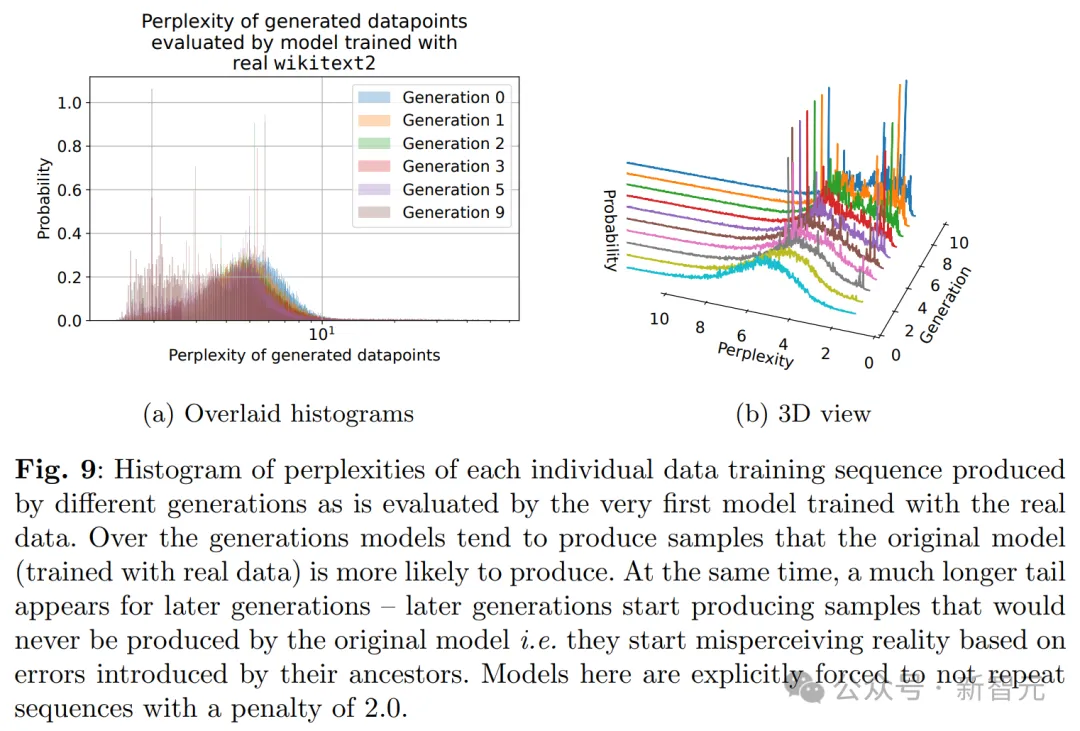

特別是,從圖下及其3D版本中可以看到,模型崩潰現象確實發生了,因為低困惑度樣本的密度隨著訓練代次的增加而開始累積。

這意味著,在多個訓練代次中,采樣數據可能會逐漸趨向于一個δ函數。

到這里,結論就和「理論直覺」中的一般直覺一致了。

可以看到,生成的數據有更長的尾部,這就表明某些數據是原始模型永遠不會生成的。而這些錯誤,就是來自代際數據學習的積累。

這也給我們敲響了警鐘——

如果沒有大規模采用AI泛濫之前從網上抓取的數據,或者直接使用人類生成的大規模數據,訓練新版本的LLM,恐怕會變得越來越困難!

有什么辦法嗎?

研究團隊認為,AI生成數據并非完全不可取,但一定要對數據進行嚴格過濾。

比如,在每一代模型的訓練數據中,保持10%或20%的原始數據;使用多樣化數據,如人類產生的數據;或者研究更魯棒的訓練算法。

沒想到吧,人類創造的數據,居然有一天會如此價值連城。