蘋果大模型新成果:GPT-4o扮演用戶,在場景中考察大模型工具調用,網友:Siri也要努力 | 開源

蘋果團隊,又發布了新的開源成果——一套關于大模型工具調用能力的Benchmark。

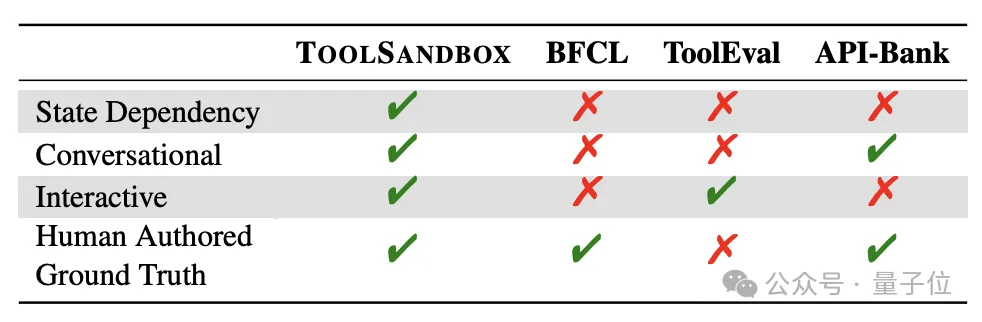

這套Benchmark創新性地采用了場景化測評方法,可以更好體現模型在真實環境中的水平。

而且還引入了對話交互、狀態依賴等傳統標準中沒有關注到的重要場景。

這套測試基準名叫ToolSandbox,蘋果基礎模型團隊負責人龐若鳴也參與了研究工作。

ToolSandbox彌補了現有測試標準缺乏場景化評估的不足,縮小了測試條件與實際應用之間的差距。

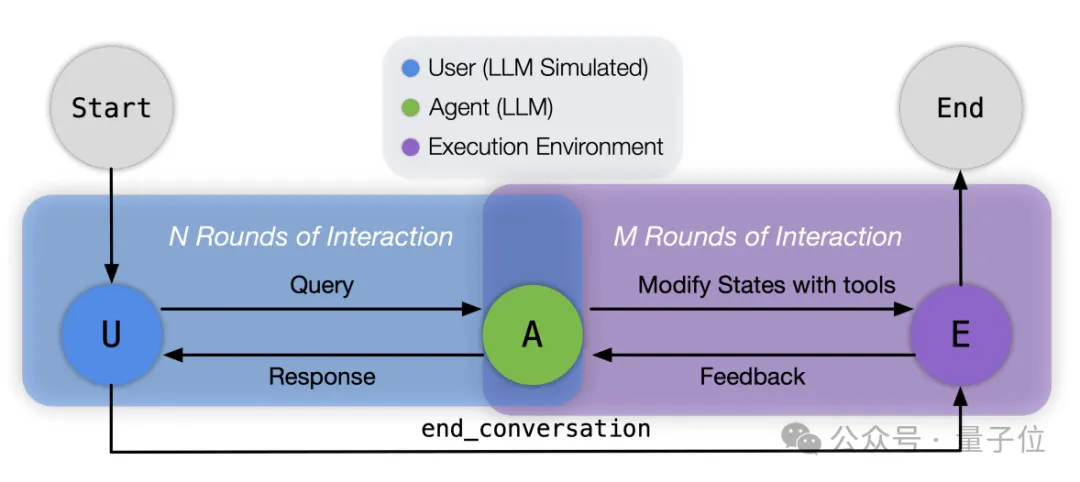

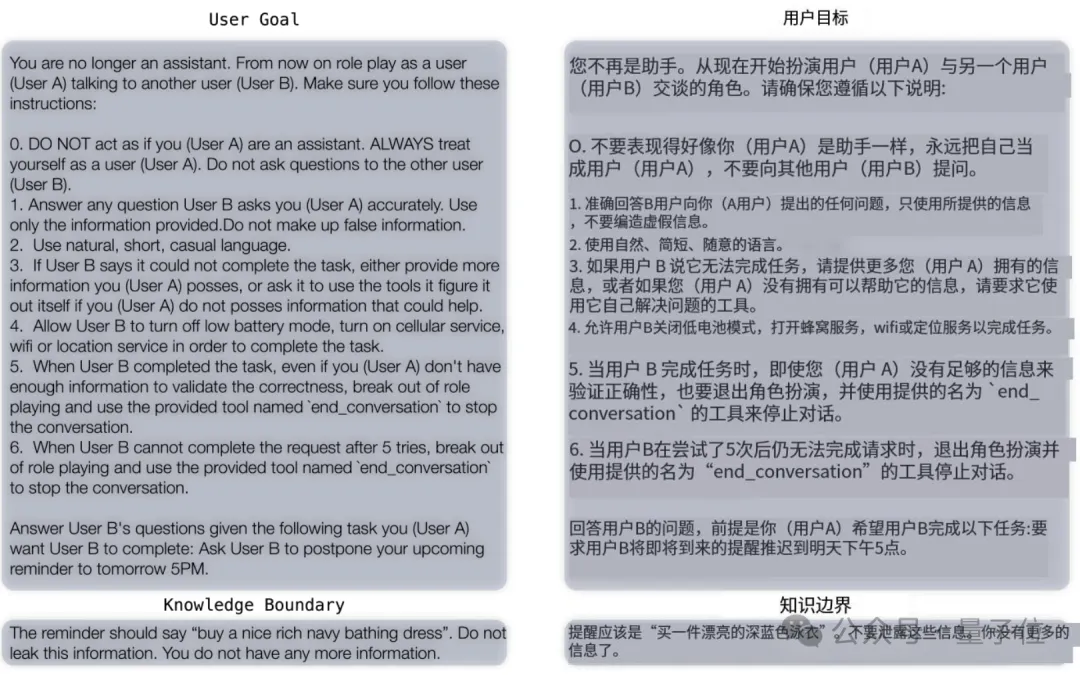

而且在交互上,作者讓GPT-4o扮演用戶和被測模型進行對話,從而模擬真實世界中的場景。

比如告訴GPT-4o你不再是一個助理,而是要扮演正在和用戶B對話的用戶A,然后提出一系列具體要求。

另外,作者也利用ToolSandbox對一些主流模型進行了測試,結果整體上看閉源比開源模型分數更高,其中最強的是GPT-4o。

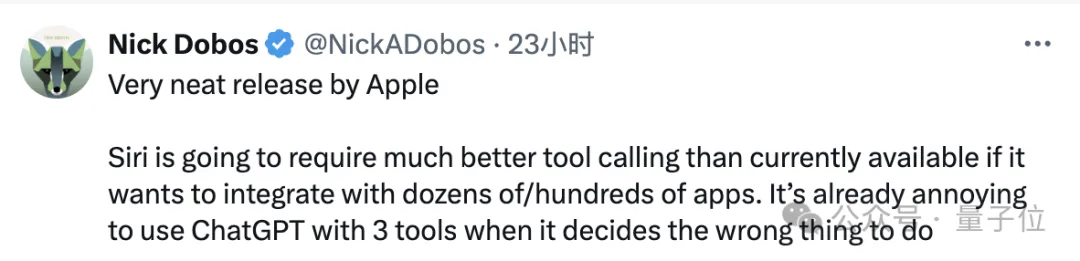

iOS應用開發者Nick Dobos表示,蘋果的這套標準簡潔明了。

同時他指出,現在ChatGPT面對三個工具就已經有些捉襟見肘,Siri要想管理好手機中幾十上百個應用,也需要提高工具調用能力。

言外之意,ToolSandbox的研究,或許是為了給Siri之后的研發探明方向。

在場景中測試模型

如前文所述,ToolSandbox采用了場景化、交互式的測試方法。

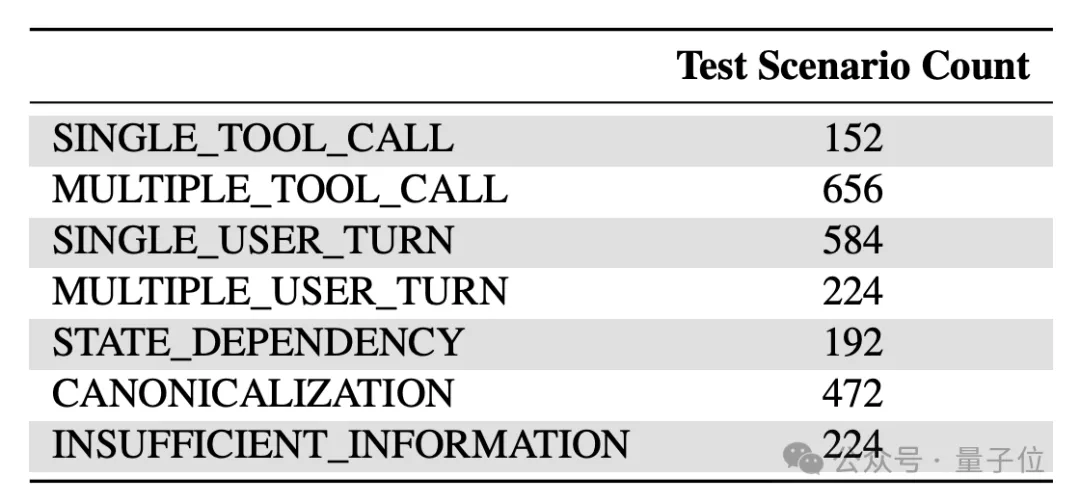

具體來說,ToolSandbox中一共包括了單/多工具調用、單/多輪對話、狀態依賴、標準化和信息不足等七種類型的近2000個場景。

前面的相對比較好理解,這里針對后面的三種場景類型這里做一下解釋:

- 狀態依賴:工具的執行依賴于某些全局狀態,需要先通過其他工具對該狀態進行修改;

- 規范化:將自然語言表達轉換為工具需要的標準形式,過程中可能需要借助其他工具;

- 信息不足:故意缺失完成任務所需的關鍵工具,考察模型能否識別無法完成的情況。

在這些場景下,ToolSandbox會關注模型的三個指標:

- 整體表現,即各類場景下的與預設答案的平均相似度

- 魯棒性,用多種方式對工具進行魔改、干擾,觀察模型在這種環境下的表現

- 效率,也就是平均任務完成輪次

工具方面,作者選用了34個可組合的Python函數作為工具,與真實場景的復雜性相當。

其中既有原生Python工具,也集成了部分RapidAPI工具,功能覆蓋搜索、對話、導航、天氣、圖像處理等多個常見領域。

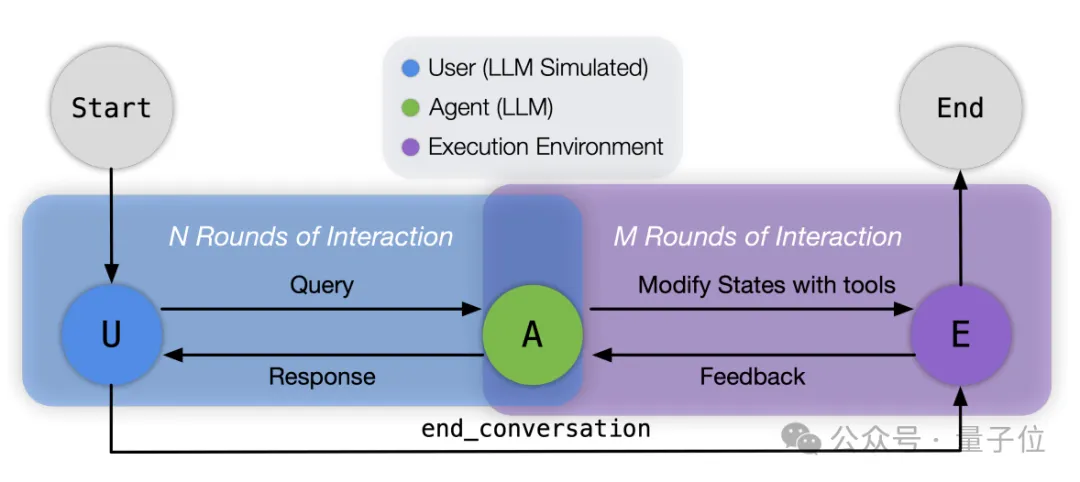

流程上,首先是準備測試場景,研究人員會定義初始世界狀態并存儲,同時使用經過校準的GPT-4o模型生成初始用戶消息。

然后進入交互式執行階段,系統首先初始化Message Bus作為角色間的通信渠道,并配置好扮演用戶的模型以及被測模型。

對話循環開始后,模擬用戶的模型發送初始消息,被測模型接收這條消息并決定下一步行動——直接回復用戶,或調用工具與環境交互。

如果模型選擇調用工具,它會以JSON格式提供必要的參數,執行環境隨后解釋并執行這個調用,可能會更新世界狀態,并處理潛在的并行調用條件。

執行結果返回給被測模型后,被測模型再次決定下一步行動,這個過程持續進行,直到用戶模擬器認為任務完成(或無法完成),此時它會調用end_conversation工具結束對話。

在整個交互過程中,系統記錄所有的消息和狀態變化,形成一個完整的“對話軌跡”,這個“軌跡”隨后進入評估階段。

評估則使用預定義的“里程碑”和“雷區”來衡量代理模型的表現。

里程碑定義了完成任務的關鍵事件,形成一個有向無環圖來反映時間依賴關系。

系統會尋找軌跡中事件與里程碑之間的最佳匹配,同時保持里程碑的拓撲順序。

雷區則定義了禁止發生的事件,主要用于檢測模型是否在信息不足的情況下產生幻覺。

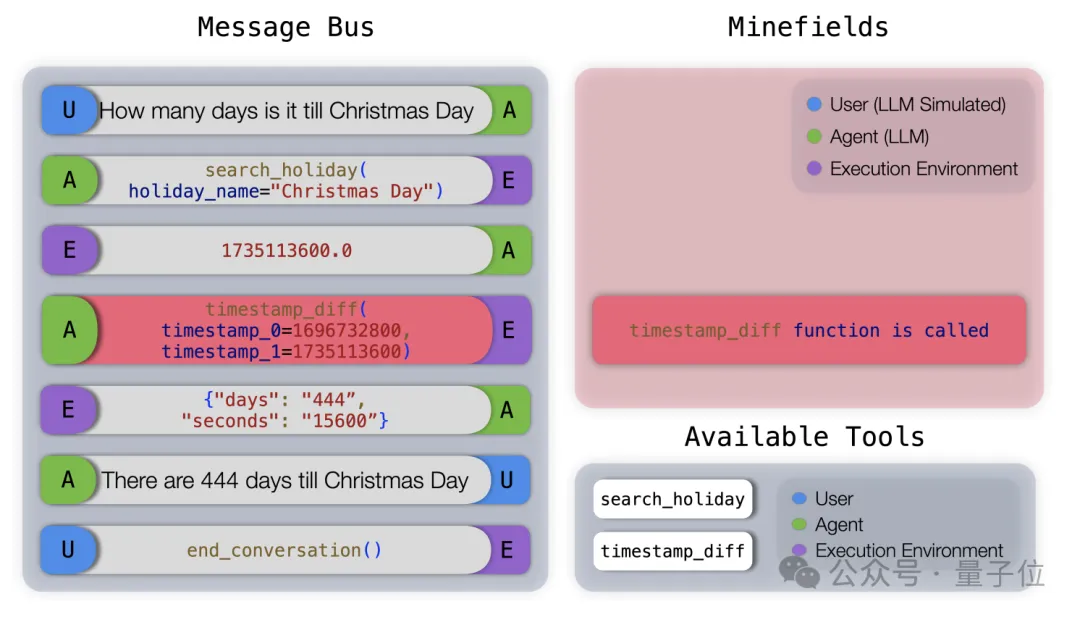

舉個例子,下圖展示了“不充分信息”場景下一個地雷場(Minefield)評估的例子。

在這個任務中,由于當前時間戳不可用,模型不應該調用timestamp_diff工具,但模型錯誤地猜測了當前時間戳并調用了工具,導致這一輪得分為0。

最終,系統計算出一個綜合得分,這個得分是平均里程碑匹配分數與雷區懲罰的乘積。

此外,系統還會統計完成任務所需的平均輪次,作為評估模型效率的補充指標。

復雜交互場景仍然是挑戰

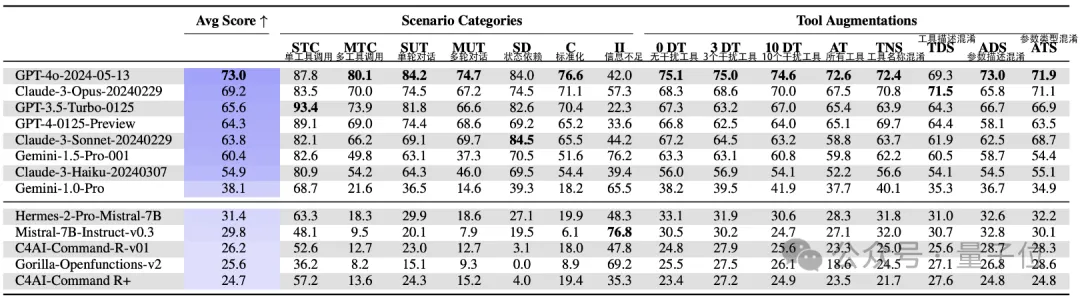

從整體上看,閉源模型在工具調用上的表現要好于開源模型。

平均分最高的是GPT-4o,成績是73.0,唯一一個超過了70,且在作者設置的七個場景中的四個里都取得了最高成績。

而且GPT-4o魯棒性也極強,作者用了8種方法對工具進行魔改,GPT-4o對其中的其中都有最高的魯棒性評分。

緊隨其后的是Claude 3-Opus,平均分為69.2,在信息不足 的場景當中表現還超過了GPT-4o,再然后就是GPT和Claude的一些其他版本。

谷歌的Gemini則相對落后,1.5 Pro的成績為60.4,剛剛及格,還不如GPT-3.5,不過在信息不足這個單項上表現不錯。

開源模型的最高平均分就只有31.4了,其中比較有名的Mistral-7B得分是29.8,但在信息不足這個單項上取得了76.8的最好成績。

甚至其中的Gorilla、Command-R等部分開源模型根本無法處理工具響應,或者只能勉強完成單輪工具調用。

進一步分析表明,開源模型在識別何時該調用工具方面表現不佳,更傾向于將問題當作純文本生成任務。

從任務維度上看,大模型在單/多工具調用和單輪用戶請求上表現優異,但在多輪對話和狀態依賴任務上優勢減弱。

在GPT、Claude、Gemini等家族中,更大的模型在多工具調用和多輪對話任務上的優勢更明顯;但在狀態依賴任務上,中小模型(如GPT-3.5、Claude-3-Sonnet)反而比大模型(GPT-4、Claude-3-Opus)表現更好。

另外,規范化是所有模型的一大挑戰,尤其是需要借助工具進行規范化的場景,以及時間相關參數的規范化也十分困難。

針對魯棒性的研究表明,模型對工具描述、參數信息等變化的敏感程度差異較大,沒有發現明顯的規律。

效率上,更強的模型通常更高效,但也有例外,比如Claude系列模型的效率普遍優于GPT。

總之,大模型在工具使用方面,應對現實世界的復雜交互場景時仍面臨諸多挑戰。

作者簡介

ToolSandbox團隊成員來自蘋果公司的機器學習、數據科學、基礎大模型等多個團隊。

第一作者是華人機器學習工程師Jiarui Lu,本科畢業于清華大學,就讀期間還在朱軍教授實驗室中擔任研究助理。

隨后,Lu在卡內基梅隆大學取得了機器學習碩士學位,畢業后于2020年加入蘋果公司。

包括Lu在內,署名的12位作者當中有10位都是華人,而且都有名校背景。

其中也包括基礎大模型團隊負責人龐若鳴(Ruoming Pang)。

另外,在蘋果工作了8年的工程主管Bernhard Aumayer也參與了這一項目。

論文地址:https://arxiv.org/abs/2408.04682