ECCV 2024 | 單目深度估計的擴散模型:克服挑戰性條件

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

原標題:Diffusion Models for Monocular Depth Estimation: Overcoming Challenging Conditions

論文鏈接:https://arxiv.org/pdf/2407.16698

代碼鏈接:https://github.com/fabiotosi92/Diffusion4RobustDepth

作者單位:博洛尼亞大學

論文思路:

本文提出了一種新穎的方法,旨在解決單張圖像深度估計任務中由挑戰性、分布外數據帶來的復雜性。首先,從那些由于沒有不利因素而便于深度預測的圖像開始,本文系統地生成包含全面挑戰和相關深度信息的用戶定義場景。這是通過利用具有深度感知控制的最前沿文本到圖像擴散模型實現的,這些模型以生成高質量圖像內容而著稱,同時保持生成圖像與源圖像之間的3D結構一致性。隨后,通過一種自蒸餾協議對任何單目深度網絡進行微調,該協議考慮到使用本文策略生成的圖像及其在簡單、無挑戰場景中的深度預測。針對本文的目的設計的基準測試實驗展示了本文提案的有效性和多功能性。

主要貢獻:

- 本文率先使用擴散模型作為一種新穎的解決方案,解決單張圖像深度估計中的挑戰,特別是涉及惡劣天氣條件和非朗伯面(non-Lambertian surfaces)場景的情況。

- 通過蒸餾擴散模型的知識,本文的方法提高了現有單目深度估計模型的魯棒性,尤其是在具有挑戰性的分布外環境中。

- 本文的方法同時應對惡劣天氣和非朗伯面挑戰,展示了在實現與依賴額外訓練信息的專門解決方案(如[18, 27])相媲美的結果的同時,解決多個挑戰性場景的潛力。

論文設計:

單目深度估計作為計算機視覺中的關鍵任務,由于深度學習技術的最新突破而取得了顯著進展。這在多個領域有著廣泛的應用,從增強機器人技術和增強現實到提高自動駕駛的安全性和精確度,特別是在由于資源或空間限制而無法依賴多張圖像進行深度估計的情況下。然而,盡管單目深度估計在實際應用中具有優勢,但它面臨著從單張圖像推斷深度的挑戰,這一問題被公認為具有不良設定和嚴重欠約束的特性。通常,解決這一挑戰的方法包括通過監督方法[9, 15, 46, 61, 93, 98, 101]訓練單目深度網絡,使用主動傳感器的標注數據,或利用在訓練時使用立體圖像對[29]或單目視頻序列[112]的自監督技術。

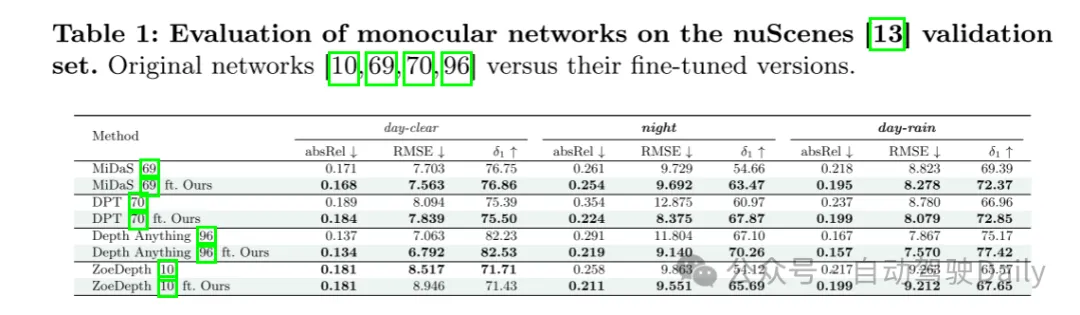

最先進的模型,如DPT [69]和較新的Depth Anything [96],結合了大量數據集的見解,每個數據集的深度標注使用不同的技術提取。這種廣泛的訓練協議使這些模型能夠在廣泛的現實場景中表現出色。然而,必須強調的是,即使這些模型在許多設置中表現優異,當處理遠離訓練期間觀察到的分布的數據時,仍面臨顯著挑戰,例如惡劣條件(如雨天和夜間)或具有非朗伯表面的物體。這些挑戰主要源于缺乏用于魯棒模型訓練的高質量標注數據,以及現有基于視覺的深度提取技術和主動傳感器(如LiDAR、ToF、Kinect等)的局限性,這些技術在復雜環境中(如雨、雪或具有特定反射特性的材料)表現不佳。因此,在這些情況下的深度估計往往不可靠,對依賴準確3D信息的后續應用產生嚴重影響。通常,當前的方法傾向于獨立解決這些挑戰。有些方法專注于解決光照不足和惡劣天氣的問題 [26, 27, 91],而另一些則處理非朗伯表面的問題 [18]。這些分散的方法突顯了需要一種統一的方法——一個能夠同時處理所有不利場景的單一框架,提供更魯棒和通用的解決方案。

在這項工作中,本文引入了最初為圖像合成設計的擴散模型[20, 44],作為一種開創性的策略,以應對那些位于通常用于訓練深度估計模型的數據分布長尾部分的圖像所帶來的嚴峻挑戰。

基于具有多模態控制的文本到圖像擴散模型的原理[56, 106],本文旨在創建一個多樣化的高度逼真的場景集合,這些場景準確復制特定參考環境的3D結構,但有意地加入了各種不利因素。重要的是,這些條件完全是任意的,可以根據特定應用的需求通過用戶定義的文本提示進行定制。

更具體地說,本文的方法首先選擇那些最初描繪沒有與不利條件相關的復雜性的場景圖像。這些樣本可以從現有的現實世界數據集[17, 28, 57]中獲取,通過自定義集合收集,甚至可以使用生成模型[2, 59]生成。對于預選的圖像,本文采用任何現成的單目深度估計網絡來提供場景的初始3D表示。重要的是,這樣的模型可以在不同的大規模數據集上進行預訓練,或者根據應用需求定制到特定領域。

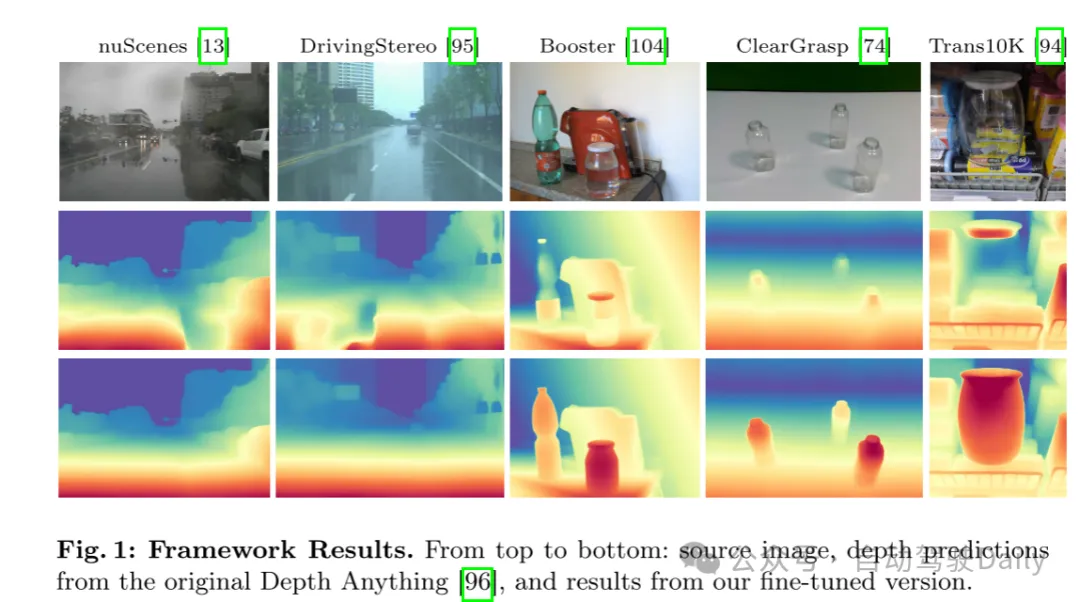

隨后,本文應用文本到圖像擴散模型,將最初簡單的圖像轉化為更復雜的圖像,同時保持相同的基礎3D場景結構(即深度)。在結合復雜和簡單圖像后,用于3D數據生成的預訓練深度網絡進入微調階段。在此階段,本文將模型暴露于組合數據集,提供具有挑戰性的訓練圖像及其在初始步驟中獲得的相應深度圖。這一微調過程提升了單目網絡推斷深度的能力,使其能夠更好地處理不利環境,如圖1所示。

圖1:框架結果。從上到下分別為:源圖像、原始Depth Anything [96]的深度預測,以及本文微調版本的結果。

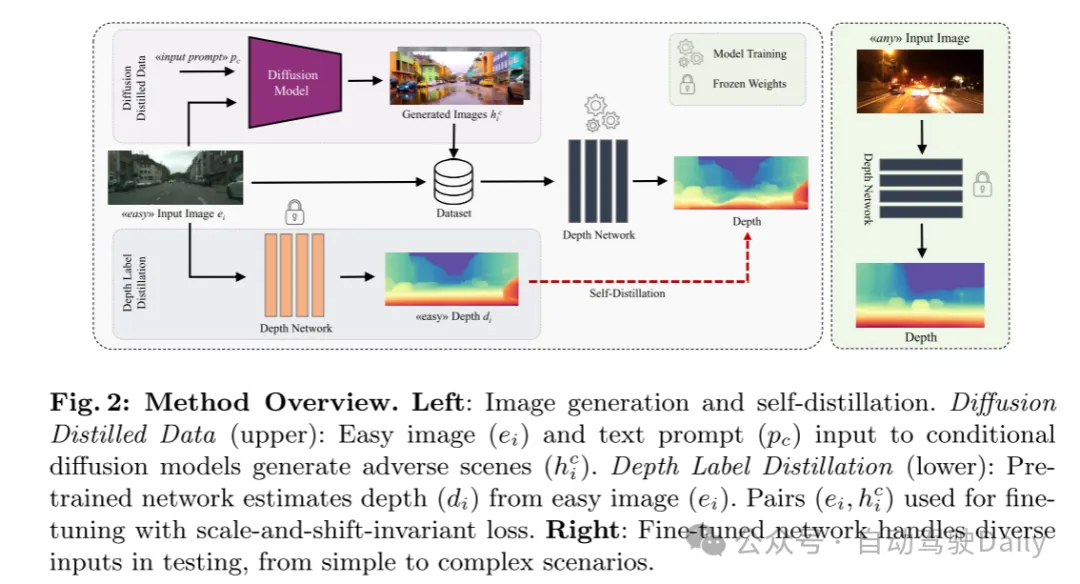

本節概述了本文的框架,如圖2所示,旨在改善在不利環境下的單目深度估計。假設在一個領域中不存在同時描繪簡單和復雜條件的圖像,本文的方法使用具有深度感知控制的擴散模型將簡單樣本轉換為復雜樣本。隨后,本文通過自蒸餾和使用生成數據的尺度和偏移不變損失來微調預訓練的單目深度網絡。

圖2:方法概述。左側:圖像生成和自蒸餾。擴散蒸餾數據(上):簡單圖像()和文本提示()輸入到條件擴散模型中生成不利場景()。深度標簽蒸餾(下):預訓練網絡從簡單圖像()估計深度()。使用()對 進行微調,采用尺度和偏移不變損失。右側:微調后的網絡在測試中處理從簡單到復雜場景的多樣化輸入。

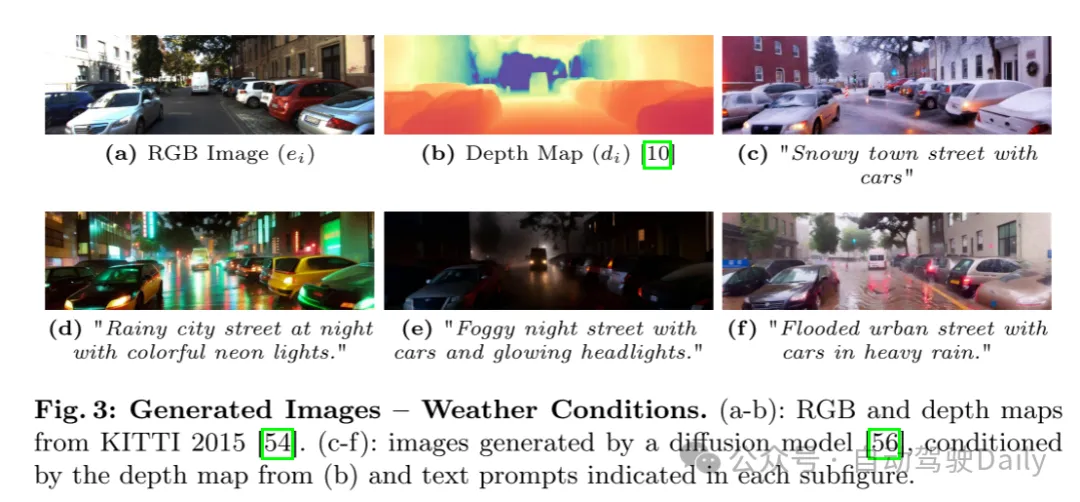

圖3:生成圖像——天氣條件。(a-b):來自KITTI 2015 [54]的RGB圖像和深度圖。(c-f):由擴散模型[56]生成的圖像,這些圖像由(b)中的深度圖和每個子圖中指示的文本提示條件生成。

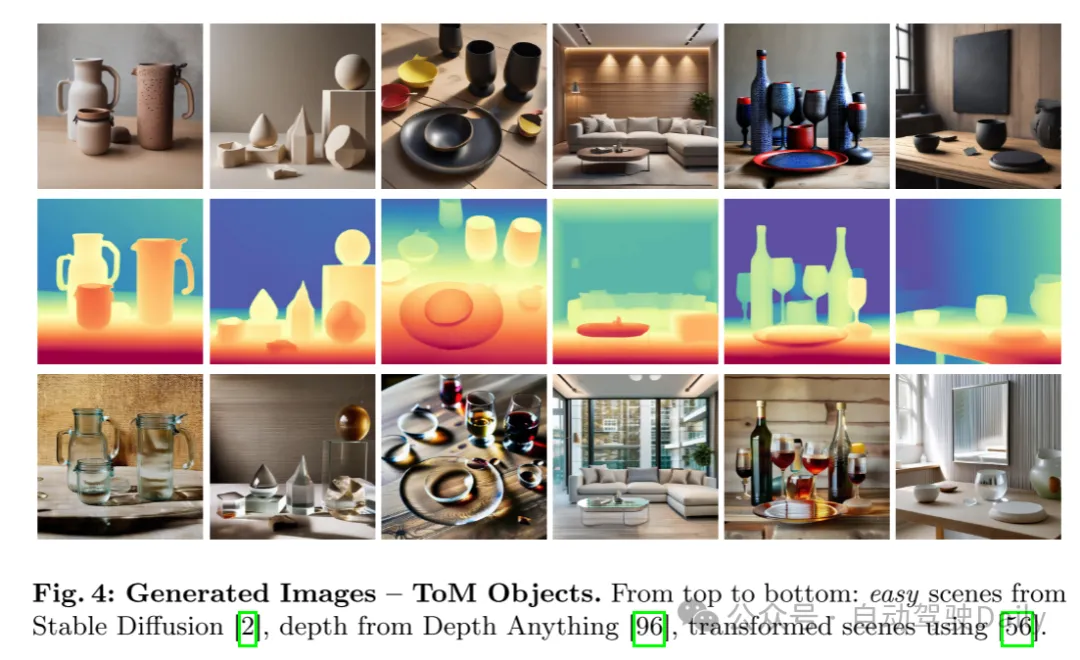

圖4:生成圖像——ToM對象。從上到下分別為:來自Stable Diffusion [2]的簡單場景,來自Depth Anything [96]的深度圖,使用[56]生成的轉換場景。

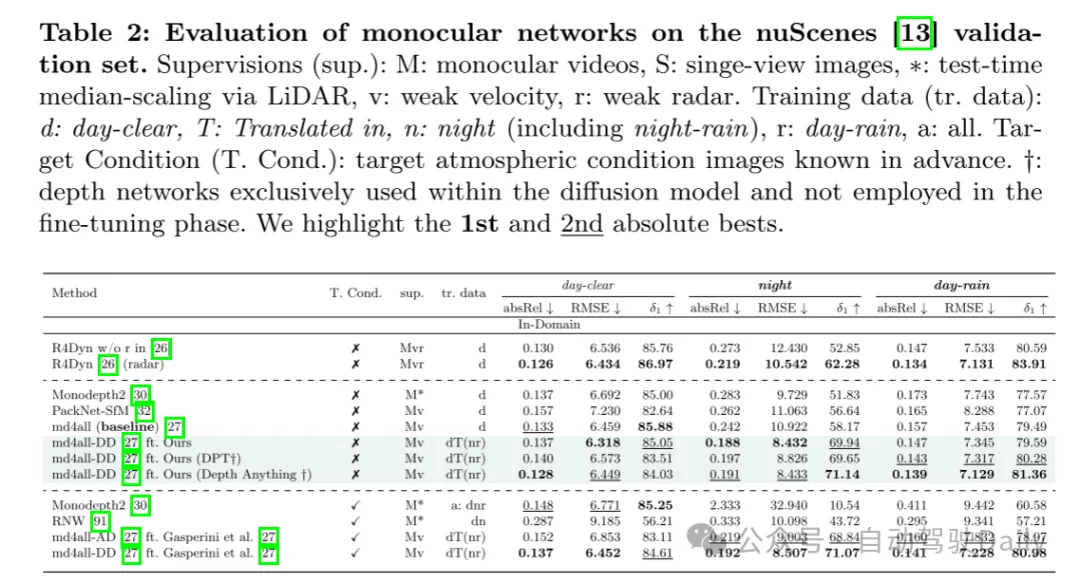

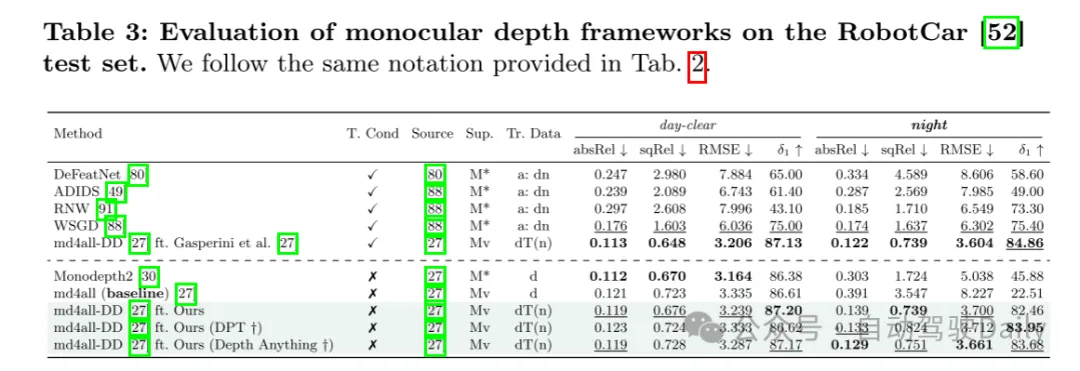

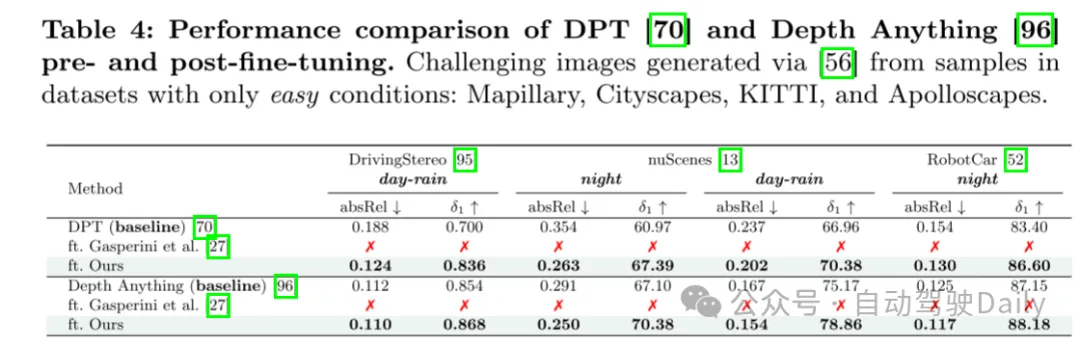

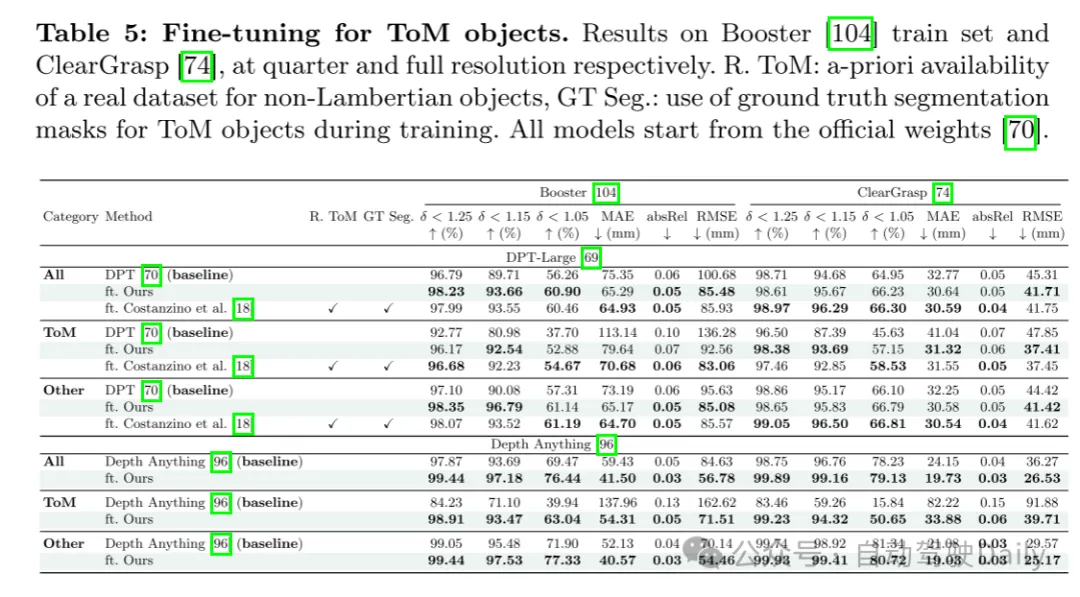

實驗結果:

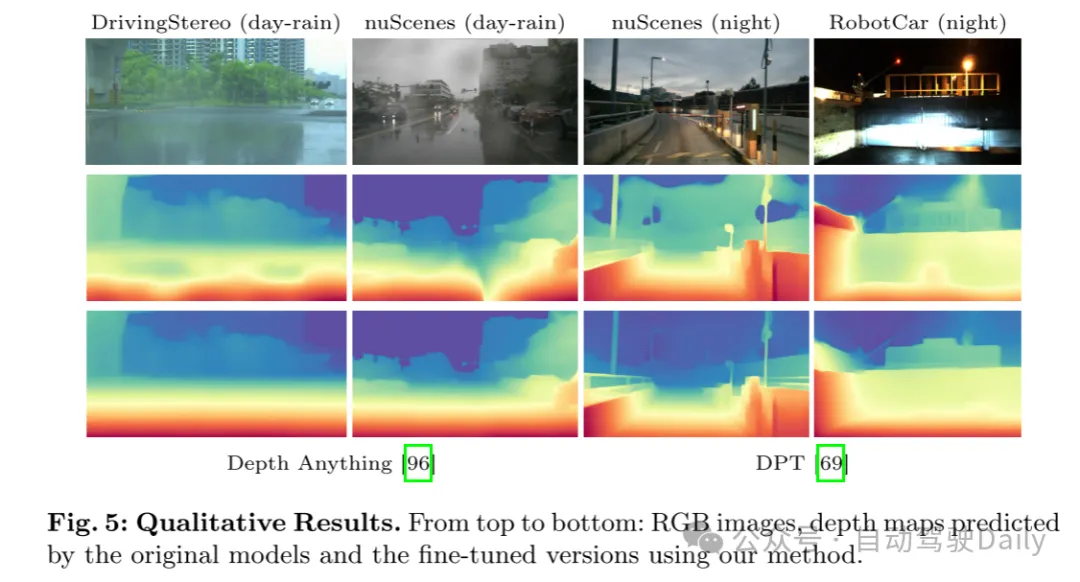

圖5:定性結果。從上到下分別為:RGB圖像、原始模型預測的深度圖以及使用本文方法微調版本預測的深度圖。

總結:

本文引入了一種開創性的單目深度估計訓練范式,該范式利用擴散模型來應對分布外場景。通過將簡單樣本轉換為復雜樣本,本文生成了捕捉現實世界挑戰的多樣化數據。本文的微調協議增強了現有深度網絡的魯棒性和泛化能力,使其能夠在不需要特定域數據的情況下處理惡劣天氣和非朗伯表面。跨多個數據集和最先進架構的廣泛實驗表明了本文方法的有效性和多功能性。