搜索圖片有新招了!北大課題組提出圖像檢索新方法,輸入草圖or藝術or低分辨率 | ECCV 2024

從一大堆圖片中精準找圖,有新招了!論文已經中了ECCV 2024。

北京大學袁粒課題組,聯合南洋理工大學實驗室,清華自動化所提出了一種新的通用檢索任務:通用風格檢索(Style-Diversified Retrieval)。

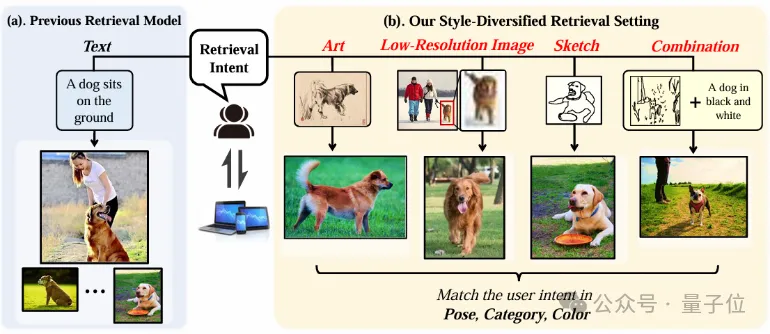

一句話,這種檢索任務要求模型面對風格多樣的查詢條件時,依然能精準找圖。

傳統圖片檢索主要靠文本查詢,查詢方法單一不說,在使用其他檢索方案的性能也一般。

而論文提出的新圖像檢索方法,能夠根據多樣化的查詢風格(如草圖、藝術畫、低分辨率圖像和文本等)來檢索相應圖像,甚至包括組合查詢(草圖+文本、藝術+文本等)。

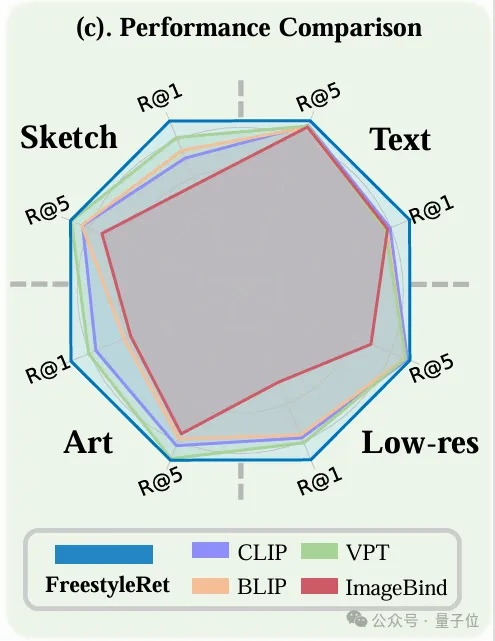

同時,模型在與其他檢索基線之間的性能比較中達到SOTA。(最外圍藍色)

目前,論文已在arXiv公開,相關代碼和數據集也已開源。

新圖像檢索方法

當前,圖像檢索的一大痛點是:

讓檢索模型具備理解多樣化用戶查詢向量的能力

通俗點說就是,不管用戶用哪種方式檢索查詢,最后都能命中用戶想要的圖像。

為了實現這一點,團隊進行了兩項工作:

- 構建專有的檢索數據集,包括多種類型的查詢圖片。

- 提出即插即用的框架,使傳統檢索模型也能快速具有通用檢索能力。

數據集構建

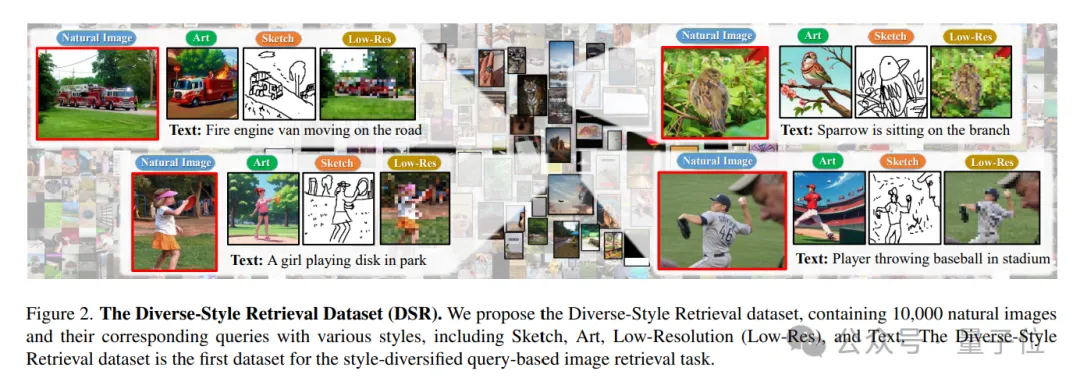

針對多種查詢風格的圖片文本檢索任務,團隊生成并構建了細粒度檢索數據集DSR(Diverse-Style Retrieval Dataset)。

展開來說,數據集包括10,000張自然圖片以及對應的四種檢索風格(文本、草圖、低分辨率、卡通藝術)。

其中的草圖標注由FSCOCO數據集提供,卡通藝術圖片和低分辨率圖像由AnimateDiff生成。

同時,團隊也采用ImageNet-X作為大尺寸粗粒度的多風格檢索數據集。

ImageNet-X包括100萬張帶有各種風格標注的自然圖片,相較于DSR,ImageNet-X數據集的圖片更加簡單,便于檢索。

提出FreestyleRet框架

概括而言,FreestyleRet框架通過將圖片風格提取并注入,有效解決了當前圖片檢索模型無法兼容不同類型的檢索向量的問題。

在構建FreestyleRet框架時,團隊主要考慮到兩個問題:

- 如何有效地理解不同風格的查詢向量的語義信息。

- 如何有效利用現有的圖文檢索模型,實現優秀的擴展能力。

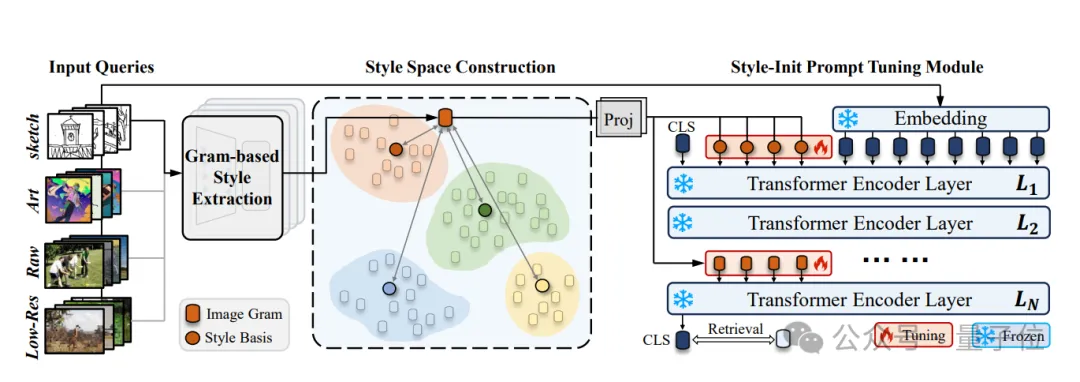

圍繞這兩個核心問題,團隊設計三個模塊來組成FreestyleRet框架:

(1)基于格拉姆矩陣的風格提取模塊用于顯式提取未知查詢向量的風格表征;

(2)風格空間構建模塊,通過對風格表征聚類從而構建檢索的風格空間,并將聚類中心作為風格的一致性表征;

(3)風格啟發的提示微調模塊,通過對檢索模型的Transformer layer進行風格初始化的插值,實現對現有檢索模型的多風格查詢能力擴展。

風格提取與風格空間的構建

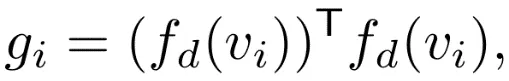

格拉姆矩陣被驗證為有效的圖像風格提取方案,在本論文中團隊采用基于格拉姆矩陣的風格提取模塊對不同類型的查詢向量進行風格提取。

團隊采用凍結的VGG輕量化網絡對查詢向量進行表征編碼,并選取淺層卷積表征作為風格提取的基特征,具體公式如下:

在得到查詢向量對應的風格表征集合后,團隊為查詢向量集合構建整體的風格空間。

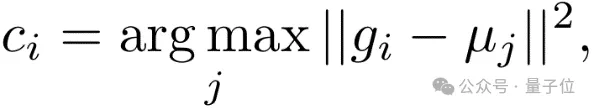

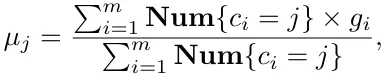

具體來說,采用K-Means聚類算法,迭代式的計算四種不同風格的查詢向量集合對應的聚類中心,然后再對每個風格表征計算其所屬的風格中心,并根據新的風格表征集合重新調整聚類中心的位置。

當聚類中心位置不再發生變化即為迭代完畢,公式如下:

在風格空間中,團隊將不同查詢向量風格對應的不同聚類中心作為風格空間的基向量。

而在推理過程中面對未知風格的查詢向量,風格空間將計算查詢向量在基向量上的投影,通過對基向量投影與基向量的加權求和,風格空間實現對未知風格的量化。

高效風格注入的提示微調模塊

在圖像文本檢索領域,基于Transformer結構的ALBEF, CLIP, BLIP等基礎檢索模型受到廣泛的使用,很多下游工作采用了這些基礎檢索模型的編碼器模塊。

為了讓FreestyleRet框架能夠便捷且高效的適配這些基礎檢索模型,團隊采用風格表征初始化的token對基礎編碼器的Transformer結構進行提示微調。

具體來說,在encoder layer的每層都插入使用量化風格表征初始化的可學習token,從而實現風格向編碼器注入的流程。

實驗性能展示

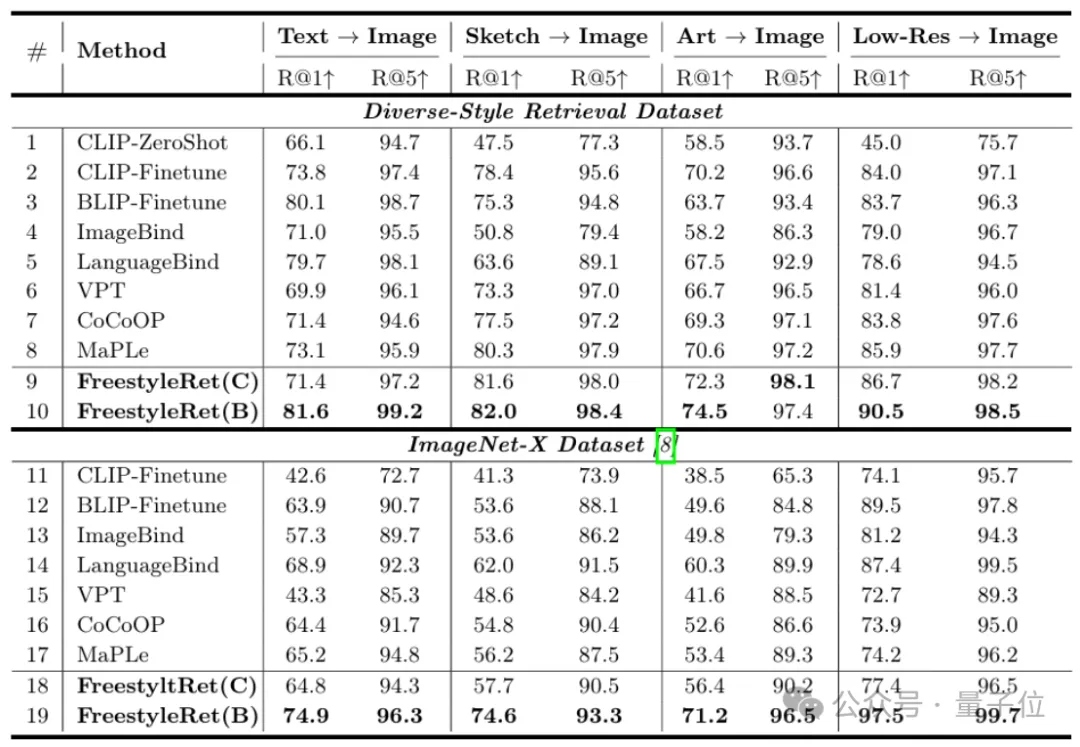

在定量實驗角度,團隊分析了基于FreestyleRet架構的BLIP和CLIP模型在DSR數據集以及ImageNet-X數據集的Recall@1, Recall@5性能。

實驗證明,面對多種風格的查詢向量時,FreestyleRet框架可以顯著增強現有檢索模型的泛化能力,具有2-4%的提升。

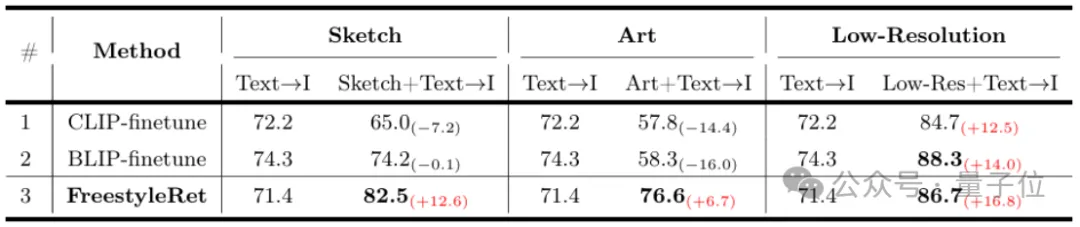

而團隊也進一步驗證FreestyleRet框架對于多個不同風格的查詢向量共同輸入的性能,共同輸入的查詢向量可以進一步提升模型的檢索精度。

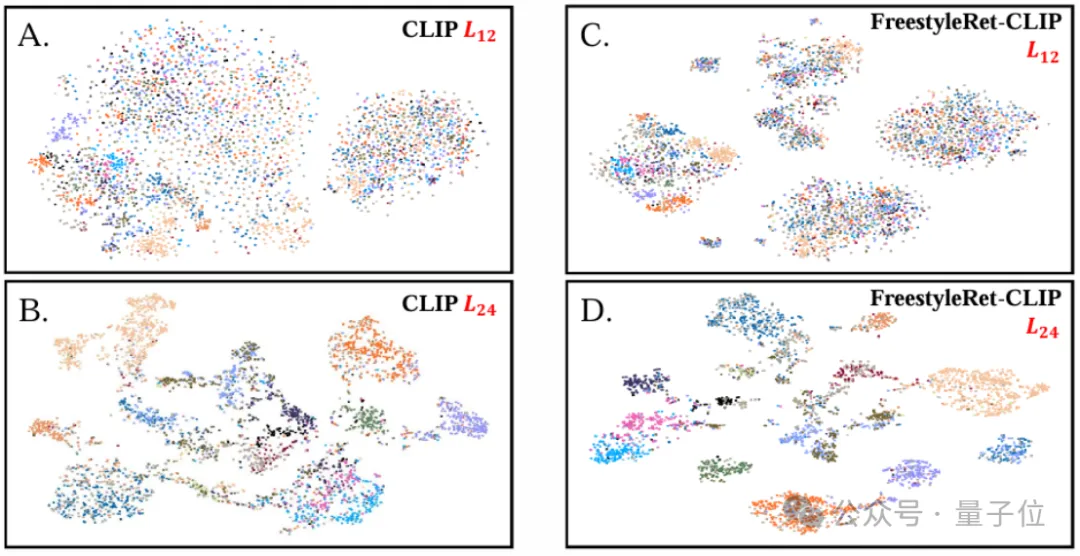

通過對特征分布進行可視化,團隊發現使用FreestyleRet結構的基礎檢索模型能夠有效分離查詢向量中的風格信息與語義信息,并實現語義角度的高維空間聚類。

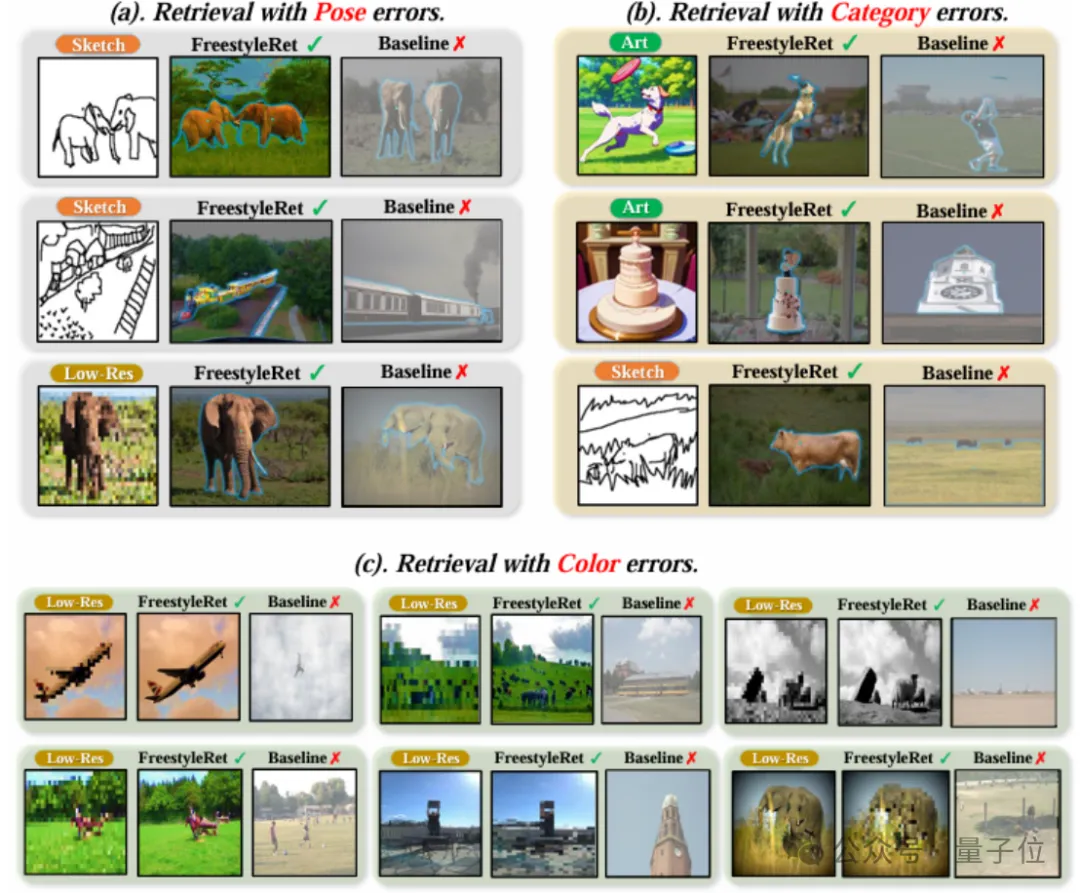

團隊也對實際的檢索推理流程進行了示例的可視化,以驗證模型的泛化性。

總之,模型在5種不同類型的檢索向量上都取得了良好效果,而且還在多種檢索向量共同檢索的子任務上表現了良好的擴展性。

更多詳情歡迎查閱原論文。

論文:https://arxiv.org/abs/2312.02428

代碼、數據集:https://github.com/CuriseJia/FreeStyleRet