統(tǒng)一Transformer與Diffusion!Meta融合新方法劍指下一代多模態(tài)王者

一般來說,多模態(tài)生成模型需要能夠感知、處理和生成離散元素(如文本或代碼)和連續(xù)元素(如圖像、音頻和視頻數(shù)據(jù))。

在離散模態(tài)領(lǐng)域,以預(yù)測下一個詞為目標(biāo)的語言模型占據(jù)主導(dǎo)地位,而在生成連續(xù)模態(tài)方面,擴散模型及其泛化形式則是當(dāng)前最先進(jìn)技術(shù)。

研究者一直試圖將語言模型與擴散模型結(jié)合,一種方法是直接擴展語言模型,使其能夠利用擴散模型作為一個工具,或者將一個預(yù)訓(xùn)練的擴散模型嫁接到語言模型上。另一種替代方案是對連續(xù)模態(tài)進(jìn)行量化處理,然后在離散的 token 上訓(xùn)練一個標(biāo)準(zhǔn)的語言模型,這種方法雖然簡化了模型架構(gòu),但也會造成信息的丟失。

在這項工作中,來自 Meta 、 Waymo 等機構(gòu)的研究者展示了通過訓(xùn)練單個模型來預(yù)測離散文本 token 和擴散連續(xù)圖像,從而實現(xiàn)兩種模態(tài)的完全集成,且不會丟失任何信息。

具體而言,本文引入了一個訓(xùn)練模型的新方法 Transfusion,能夠無縫地生成離散和連續(xù)的模態(tài)。Transfusion 將語言模型損失函數(shù)與擴散相結(jié)合,在混合模態(tài)序列上訓(xùn)練單個 transformer。

該研究還在文本和圖像數(shù)據(jù)混合基礎(chǔ)上從頭開始預(yù)訓(xùn)練多個 Transfusion 模型,最多可達(dá)到 7B 參數(shù)量,并針對各種單模態(tài)和跨模態(tài)基準(zhǔn)建立擴展定律。

- 論文地址:https://arxiv.org/pdf/2408.11039

- 論文標(biāo)題:Transfusion: Predict the Next Token and Diffuse Images with One Multi-Modal Model

實驗表明,Transfusion 的擴展能力顯著優(yōu)于將圖像量化并在離散圖像 token 上訓(xùn)練語言模型的方法。通過引入特定于模態(tài)的編碼和解碼層,該研究證明可以進(jìn)一步提高 Transfusion 模型的性能,并且甚至可以將每張圖像壓縮到僅 16 個 patch。

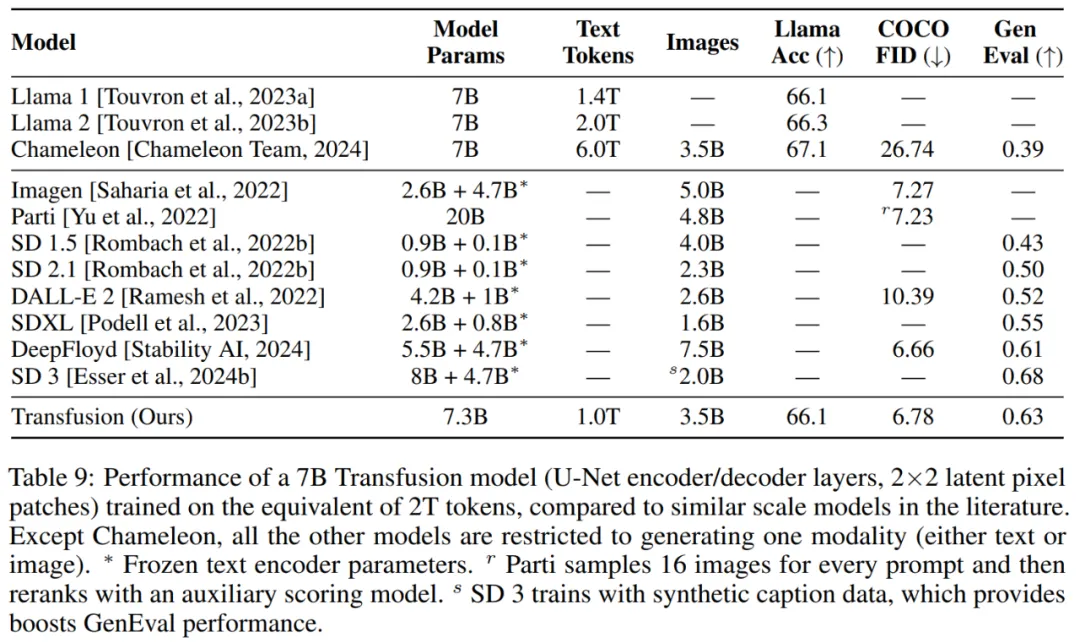

最后將 Transfusion 方法擴展到 70 億參數(shù)和 2 萬億多模態(tài) token,能夠生成與相似規(guī)模的擴散模型和語言模型相媲美的圖像和文本,從而獲得兩個領(lǐng)域的優(yōu)勢。這意味著 Transfusion 模型不僅能夠處理圖像和文本的生成,還能在這兩種類型的生成上達(dá)到領(lǐng)先水平,有效地結(jié)合了圖像和文本生成的優(yōu)點。

在 GenEval 基準(zhǔn)測試中,本文模型(7B)優(yōu)于其他流行模型,例如 DALL-E 2 和 SDXL;與那些圖像生成模型不同,它可以生成文本,在文本基準(zhǔn)測試中達(dá)到與 Llama 1 相同的性能水平。因此,Transfusion 是一種很有前途的訓(xùn)練真正多模態(tài)模型的方法。

Transfusion 介紹

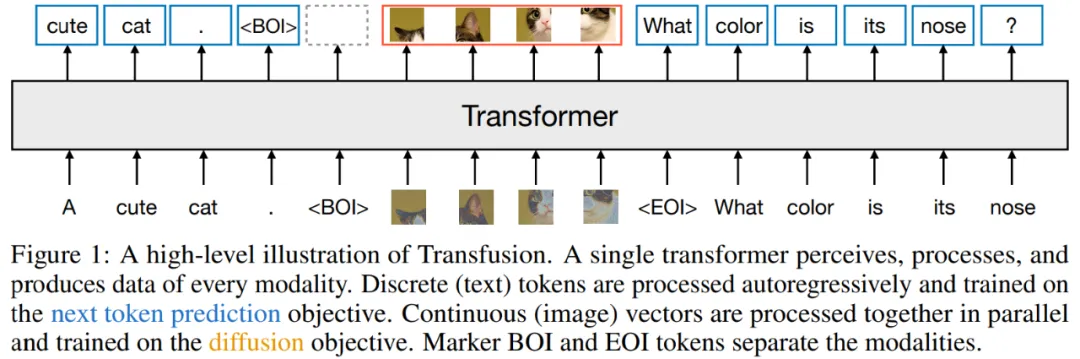

Transfusion 是一種訓(xùn)練單一統(tǒng)一模型來理解和生成離散和連續(xù)模態(tài)的方法。本文的主要創(chuàng)新是證明了可以在共享數(shù)據(jù)和參數(shù)上對不同模態(tài)使用單獨的損失(針對文本使用語言建模,針對圖像使用擴散)。圖 1 說明了 Transfusion。

模型架構(gòu):模型中的大部分參數(shù)來自單個 transformer,用來處理每一個序列,不論其模態(tài)如何。Transformer 接收一系列高維向量作為輸入,并產(chǎn)生相似的向量作為輸出。研究者為了將數(shù)據(jù)轉(zhuǎn)換成這種空間,他們使用了具有非共享參數(shù)的輕量級特定于模態(tài)的組件。

對于文本,這些是嵌入矩陣,Transformer 將每個輸入的整數(shù)轉(zhuǎn)換成向量空間,每個輸出向量轉(zhuǎn)換成一個關(guān)于詞匯表的離散分布。

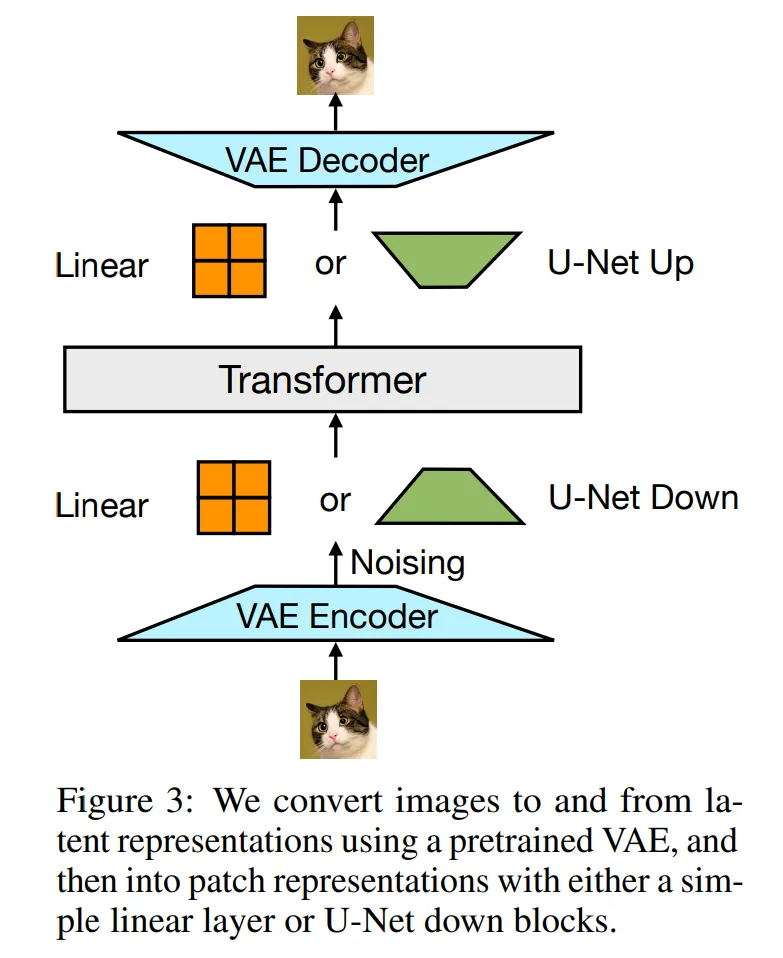

對于圖像,研究者嘗試了兩種方法來壓縮 k×k patch 向量的局部窗口到一個單一 transformer 向量(以及反向操作):(1)一個簡單的線性層;(2)U-Net 的 up 和 down 塊。圖 3 展示了整體架構(gòu)。

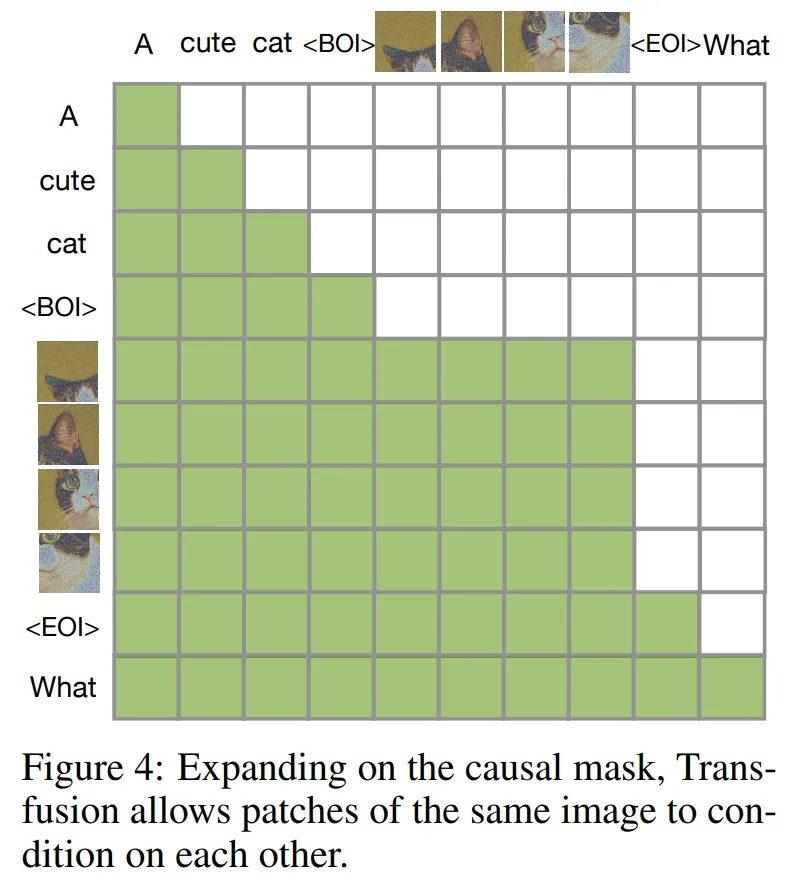

Transfusion 注意力:語言模型通常使用因果掩碼來有效地計算單個前向 - 后向傳播中整個序列的損失和梯度,而不會泄露未來 token 的信息。雖然文本是自然連續(xù)的,但圖像不是,并且通常使用不受限制的(雙向)注意力進(jìn)行建模。

Transfusion 通過將因果注意力應(yīng)用于序列中的每個元素,并將雙向注意力應(yīng)用于每個單獨圖像的元素中,從而結(jié)合了兩種注意力模式。這使得每個圖像 patch 能夠關(guān)注同一圖像中的每一個其他 patch,但只限于關(guān)注序列中之前出現(xiàn)的文本或其他圖像的 patch 。這種設(shè)計允許圖像內(nèi)部的高效信息交流,同時限制了與序列前面內(nèi)容的交互,有助于模型在處理復(fù)雜數(shù)據(jù)序列時,更好地聚焦和整合相關(guān)信息。圖 4 顯示了 Transfusion 注意力掩碼的示例。

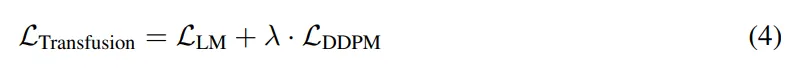

訓(xùn)練目標(biāo):為了訓(xùn)練模型,研究者將語言建模目標(biāo) 應(yīng)用于文本 token 的預(yù)測;將擴散目標(biāo)

應(yīng)用于文本 token 的預(yù)測;將擴散目標(biāo) 應(yīng)用于圖像 patch 的預(yù)測。總損失可以表示為如下形式:

應(yīng)用于圖像 patch 的預(yù)測。總損失可以表示為如下形式:

實驗結(jié)果

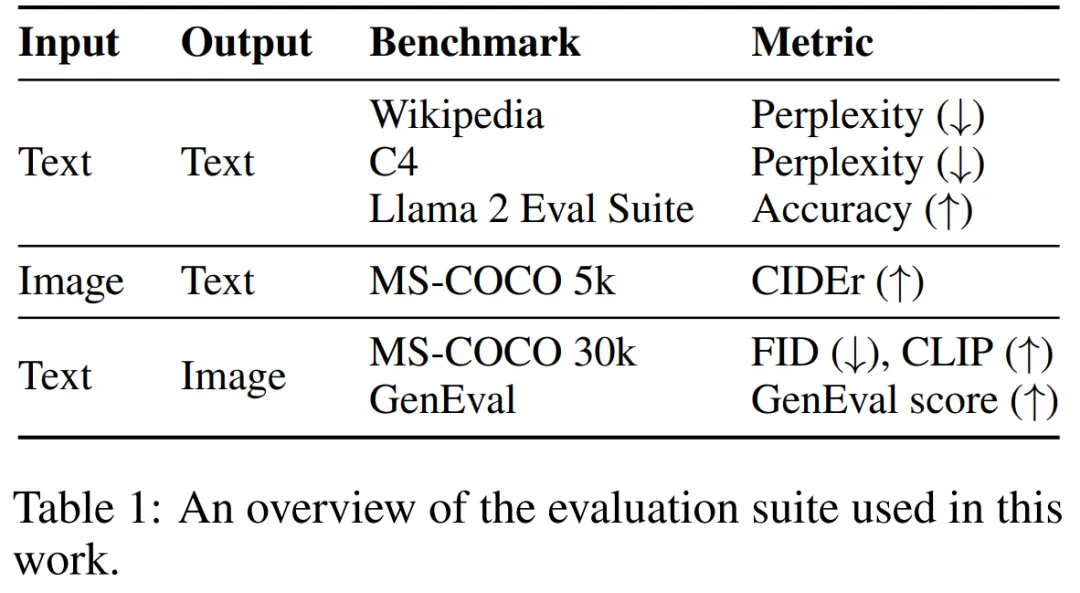

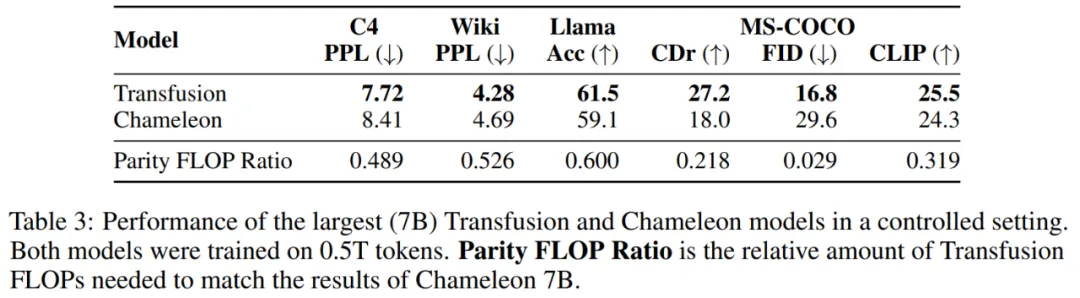

該研究通過實驗證明了 Transfusion 是一種可行、可擴展的統(tǒng)一多模態(tài)模型訓(xùn)練方法。研究者在一系列標(biāo)準(zhǔn)的單模態(tài)和跨模態(tài)基準(zhǔn)上評估模型性能,如表 1 所示。

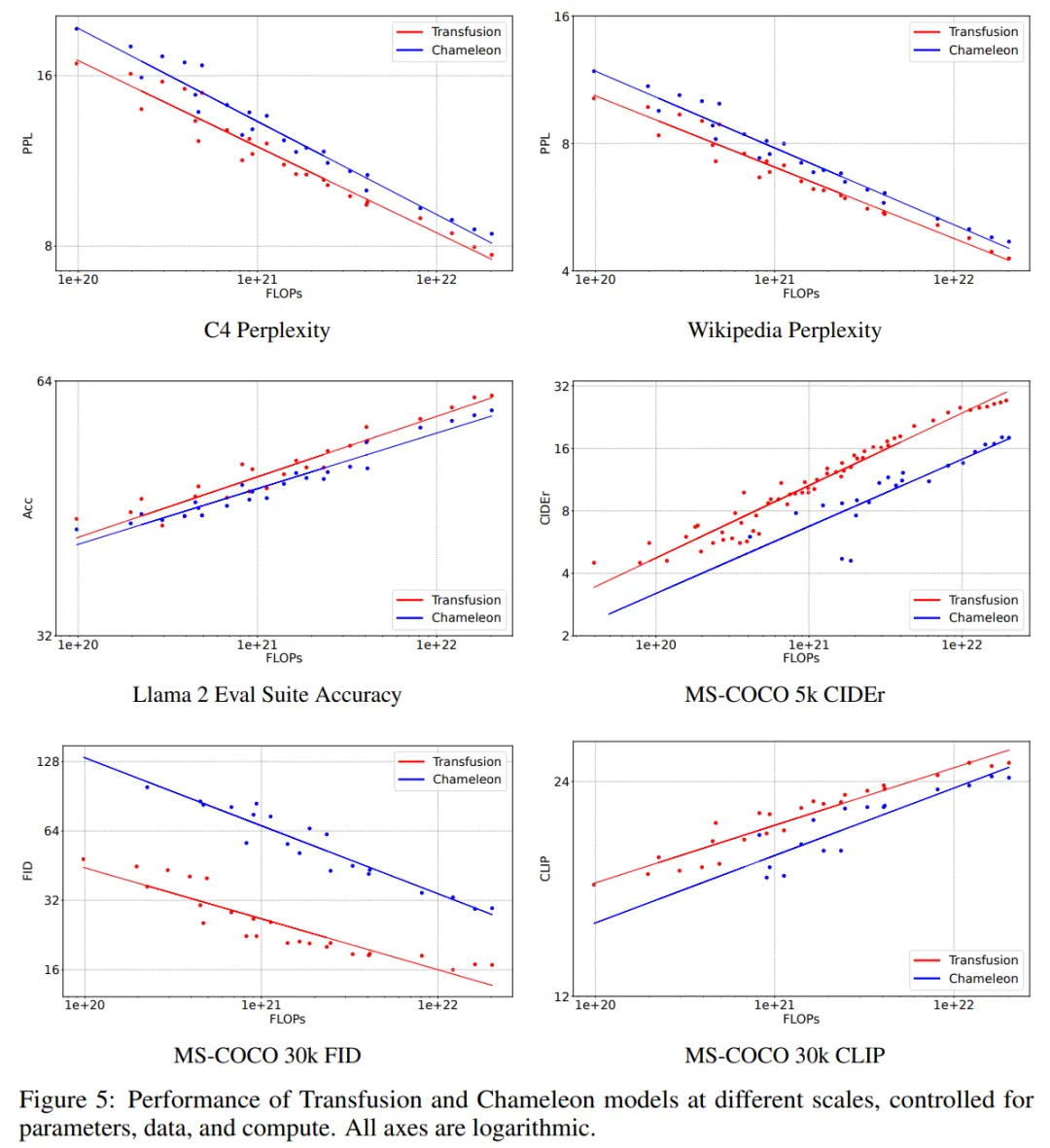

圖 5 直觀顯示了擴展趨勢。在每個基準(zhǔn)測試中,Transfusion 始終表現(xiàn)出比 Chameleon 更好的擴展規(guī)律。雖然線條接近平行,但 Transfusion 的優(yōu)勢更明顯。

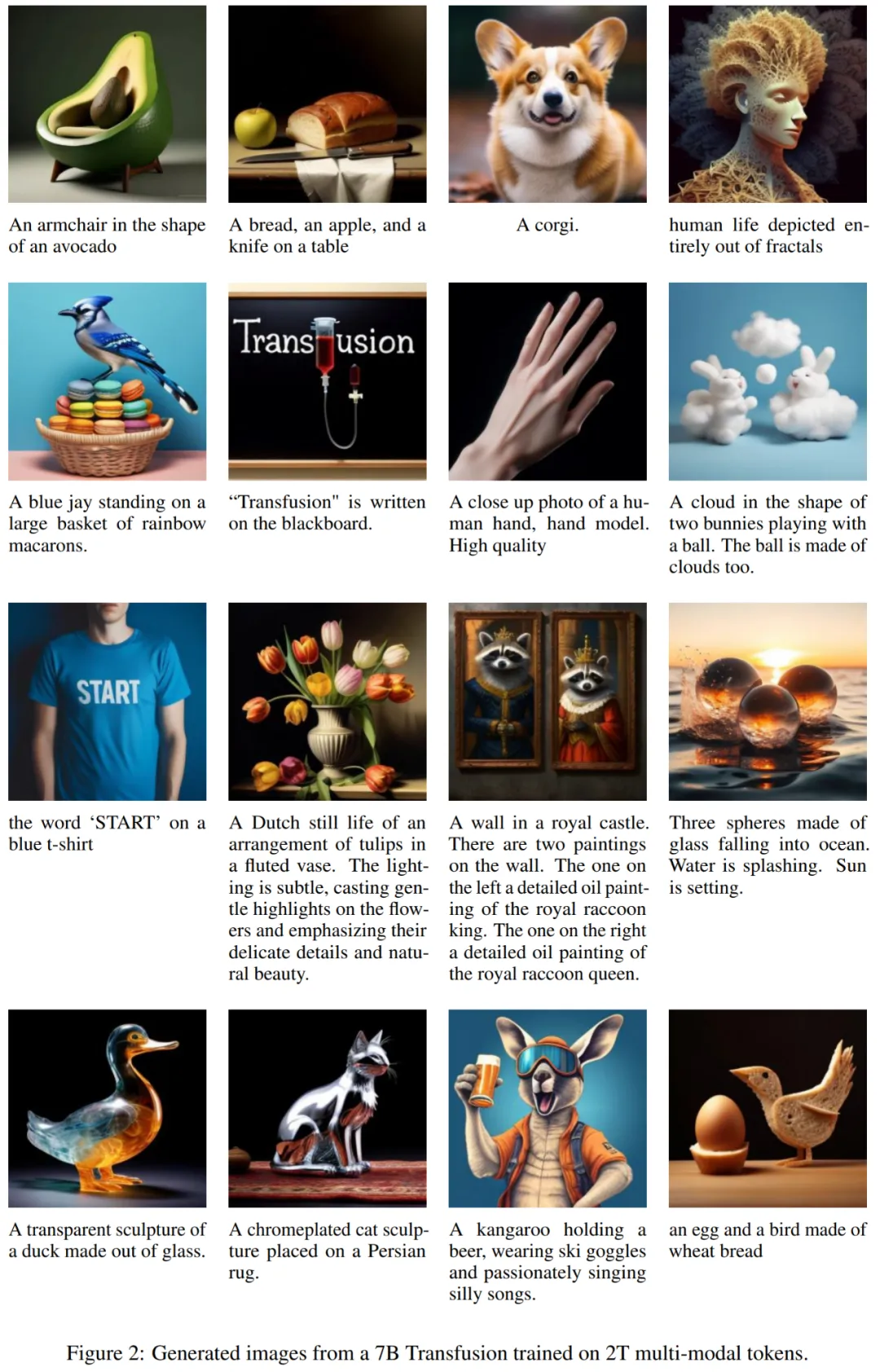

該研究在 2T token 的數(shù)據(jù)集上訓(xùn)練了一個 7B 參數(shù)模型,生成的圖像如下所示:

表 9 顯示,Transfusion 實現(xiàn)了與 DeepFloyd 等高性能圖像生成模型類似的性能,同時超越了之前發(fā)布的模型,包括 SDXL。

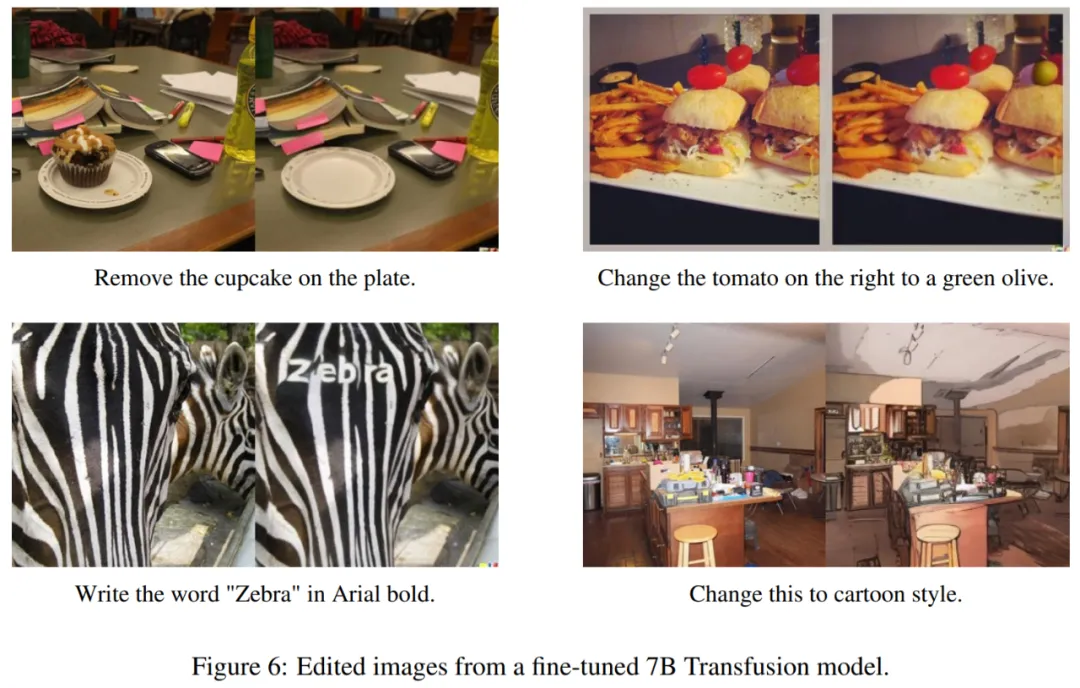

圖像編輯。經(jīng)過微調(diào)的 Transfusion 模型可以按照指示執(zhí)行圖像編輯,比如將紙杯蛋糕從盤子中移除。