用大模型優化大模型預訓練數據,節省20倍計算量,實現顯著性能提升!

生成式人工智能研究實驗室(GAIR,主頁:https://plms.ai/)是國內首個聚焦于生成式人工智能的高校研究組。匯聚了來自于 CMU、復旦、交大(ACM 班、IEEE 試點班等)等頂尖高校的年輕本碩博人才。實驗室專注于三大核心領域:大模型基礎研究、對齊系統和社會影響,致力于培養頂尖人工智能人才(具有原創、批判精神等)、開發尖端的生成式人工智能技術,賦能人類解決復雜問題,提升人類生活質量。

Program-Every-Example (ProX) 是上海交通大學生成式人工智能實驗室 (GAIR Lab) 、上海人工智能實驗室、新加坡 Sea AI Lab 聯合研究的一個用于提升大規模預訓練語料質量的數據優化框架。

1. 背景介紹

在大模型研發過程中,數據質量是決定模型成功與否的關鍵因素之一,而大規模預訓練數據則是構建強大語言模型的基礎。業界的實踐通常是抓取互聯網上的海量的網頁數據,然后由人類專家設計專門的規則來進行數據清洗,這些規則雖然能夠在處理數千億甚至上萬億 token 級別的語料時保持較高的效率,但其局限性也逐漸顯現。數據的清洗效果往往決于規則是否全面,然而這些規則并不能理解文檔中的上下文語境,同時也很難為每一個文檔去定制規則,故此面對多樣化的樣本需求,這些靜態規則難以靈活應對,導致語料質量提升空間有限,制約了模型的進一步突破。

為此,上海交通大學生成式人工智能實驗室 (GAIR Lab)、上海人工智能實驗室以及新加坡 Sea AI Lab 聯合提出了 Program-Every-Example (ProX) 框架。ProX 通過采用語言模型而非人類規則進行自動化的數據優化,靈活應對多樣化的樣本特征,顯著提升了預訓練語料的質量,為大規模預訓練模型的性能突破提供了一種可能的數據優化思路

- 論文: https://huggingface.co/papers/2409.17115

團隊還以開源的方式為社區提供了:

- 代碼框架: https://github.com/GAIR-NLP/ProX

- 預訓練實驗的全實驗細節和模型: https://huggingface.co/gair-prox

- 超過 100B 的高質量通用語料和 5B 的高質量數學語料: https://hf.co/collections/gair-prox/prox-dataset-66e81c9d560911b836bb3704

2. 用語言模型提升語言模型 「自己」 的數據質量

傳統的預訓練數據清洗和優化方法主要依賴人工設計的規則,雖然這些規則能夠有效過濾低質量數據,但無法針對每個樣本進行更細粒度的處理。這種方式難以處理復雜的多樣化數據,最終可能導致模型性能的瓶頸。Program-Every-Example (ProX) 的出現旨在改變這一局面,它通過利用語言模型自動生成優化程序,能夠對每個數據樣本進行個性化處理,提升數據的整體質量。ProX 不僅可以識別低質量的文本,還能進行更精準的優化和清理,如字符串標準化、噪聲行刪除等操作,確保每個樣本都能以最佳狀態進入預訓練過程。

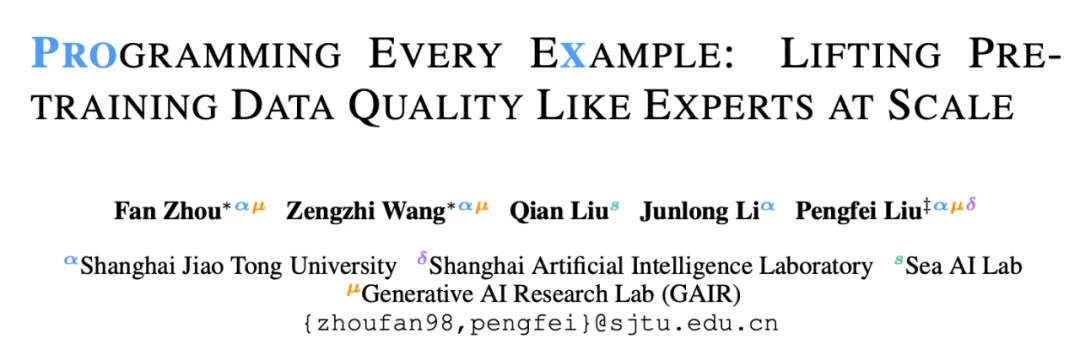

圖:ProX 總體框架,利用語言模型生成程序 + 執行,提升數據質量。

3. 如何兼顧效率和質量?Program-Every-Example!

在利用語言模型提升數據質量的同時,如何提高數據處理的成本和效率也是研究中的一大挑戰,特別是考慮到預訓練所需要的語料往往突破了數萬億級別 (TB) token。

近期,業界和各個研究團隊(如 meta 的 llama 團隊,阿里千問團隊)也在積極研究直接利用大語言模型來選擇和過濾語料,這些方法主要應用于文檔級別的數據過濾和選擇,能夠有效識別低質量的文檔并加以排除,提升整體數據集的質量。然而,這類方法潛在的局限性在于其精細化處理能力不足,通常只停留在文檔的選擇層面,可能沒有進一步對文檔內的細節進行更深入的優化和清理,例如字符級別的規范化處理、噪聲行的刪除等操作,從而限制了數據優化的效果。

同時,直接的數據合成方法正在成為另一個研究熱點。該方法通過大語言模型(LLM)基于種子數據或特定話題,主動生成新的高質量數據。這種合成技術盡管展示了生成多樣化、豐富語料的潛力,但其挑戰在于需要極大的計算資源支持,特別是在大規模生成時,計算代價非常高。此外,LLM 生成的數據還面臨幻覺問題,即生成內容與事實不符,無法保證訓練數據的真實性和一致性。這些問題給直接數據合成方法的實際應用帶來了很大挑戰,特別是在需要高精度和高可信度的領域。

于是在 ProX 中,研究者們提出了 Program-Every-Example 的設計。 他們通過使用較小的語言模型(如 0.3B 的超小規模模型)來執行數據優化任務,并且將數據優化的過程轉變為調用特定的 python 函數,對每個文檔都生成特定的函數調用。ProX 框架會再通過執行這些程序,來對語料進行文檔級別的過濾和噪聲行、字符級別的處理。

這樣簡單的 Program 設計,大大節省了輸出端的 token 數量,相比較于依賴于大語言模型數據合成方法(通常依賴于 7B 甚至 70B 規模的模型)顯著減少了計算成本,同時又做到了簡單過濾方法無法實現的精細化操作。

圖:ProX 設計的函數接口,覆蓋了文檔級別過濾、噪聲行去除、字符串清洗等操作。

4. 如何構造數據優化模型?

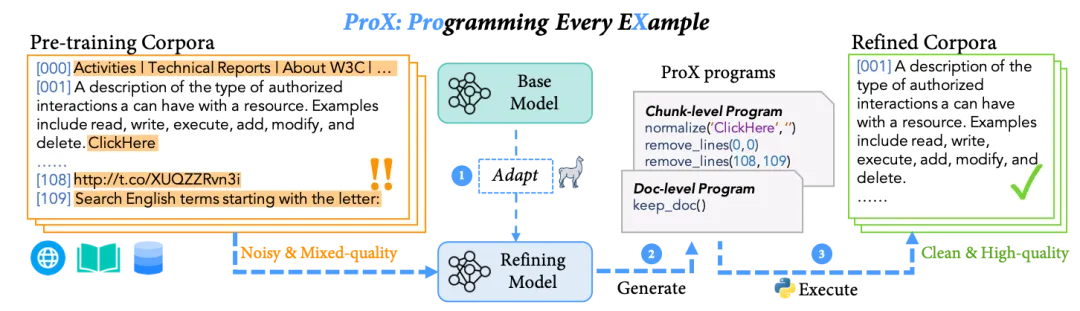

如何構造這樣的數據優化模型呢?是否要對不同 domain 都有不同的構造方法呢?在這里,ProX 采用了一種統一的構造思路,無需對特定領域進行額外設計就可以廣泛適用。首先,針對數據優化的粒度,ProX 將優化分為兩個階段:文檔級別和子文檔 / 塊級別 (將文檔切分成更小的窗口),分別對應文檔級別的過濾和更細粒度的塊內優化如行級別和字符級別的優化。

由于直接讓模型,尤其是較小的模型生成這樣上述設計的函數調用是較為困難的,因此 ProX 合成了對應的微調數據,以便對基座模型進行微調以處理和優化真實的語料。在文檔級別操作中,ProX 借鑒了近期紐約大學的 Self-Rewarding 以及 Hugginface 的 FineWeb-Edu 中所采用的評分機制,對數萬個隨機采樣的種子文檔進行了教育價值評分、文檔格式評分,并構建出保留高分文檔、去除低分文檔的優化程序。在子文檔 / 塊級別級別的操作中,ProX 利用了 Llama-3 和少樣本提示的方法,構造了對于多種噪聲的函數調用,并對這些離散的函數調用進行語法檢查和正確性分析,篩選然后合并為一個較為復雜的程序。

最終,ProX 對兩個優化階段,分別構建了適用于通用領域的約 50K 函數調用數據集,并以相同的方法針對數學領域生成了同等規模的數據集。ProX 隨后通過 SFT(監督微調) 在一個小模型上進行訓練,模型快速收斂,且成功應用于真實的大規模語料處理任務中,在后續的大量實驗中展示了其高效的優化能力與廣泛的適用性。

圖:ProX 構造 SFT 數據和數據優化模型的流程示意圖。

5. 在廣泛數據集上得以驗證

那么 ProX 得到的數據效果到底如何?

超越人工規則,超越此前的基于語言模型的數據選擇方法

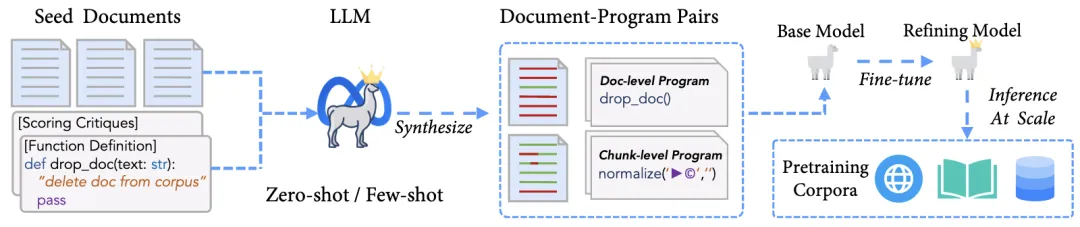

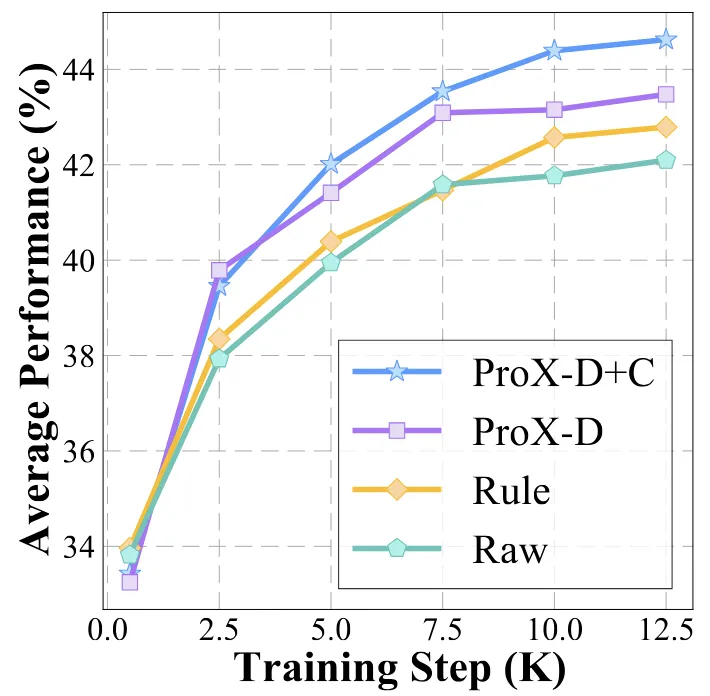

初步實驗發現,ProX 在小于 1B 規模的模型訓練中超越了此前多個人工設計的規則過濾方法,并且在多數的標準化測試數據集中穩定達到更高的表現。

表:ProX 和人工規則的對比,表現出穩定且大幅度的增長。

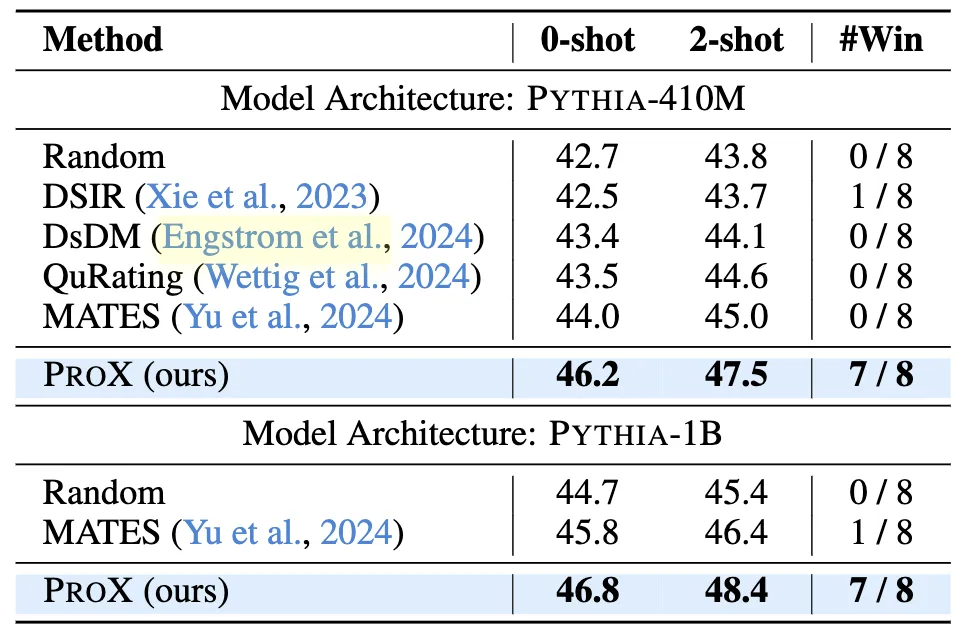

ProX 還和此前利用語言模型選擇預訓練數據的方法進行了比較。團隊僅采用了文檔級別的優化,以保持和數據選擇方法較為公平的優化粒度,仍然在 8 個下游數據集上,大幅度提升了之前的利用語言模型進行數據選擇方法 ( > 2.0%)。

表:Prox 和現有的利用語言模型進行數據選擇方法對比,超越了所有基準方法。

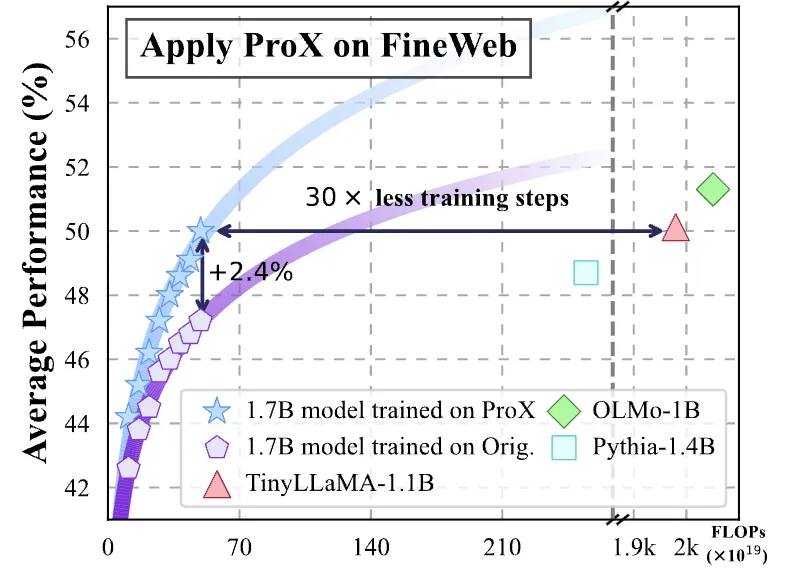

更大規模的實驗:50B 語料訓練媲美 3T 性能?

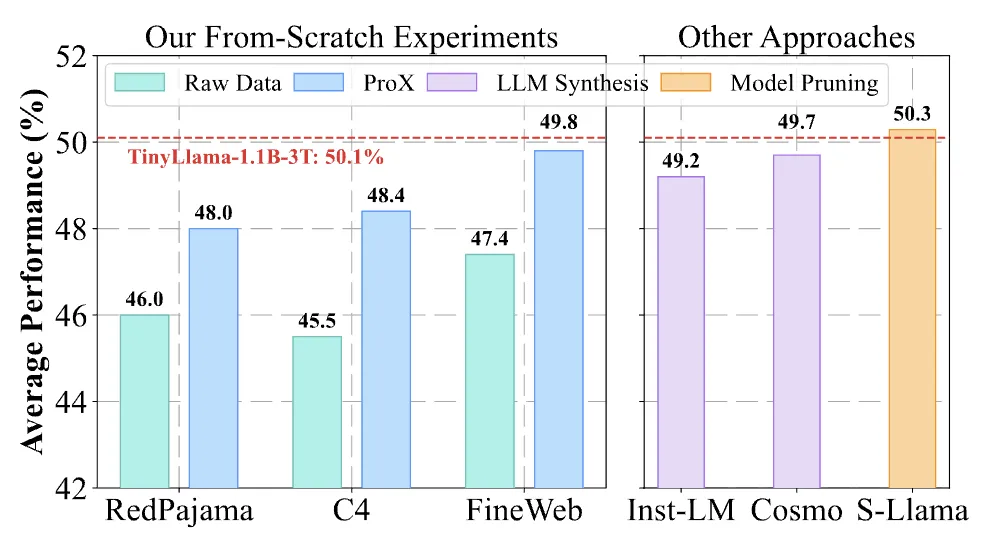

團隊在 1.7B 模型上訓練了 50B ProX 優化后的數據,發現其表現已經接近于甚至超越一些用超過數百 B 甚至 TB 級別語料訓練的語言模型,例如 OLMo、Pythia、TinyLlama 等等。且訓練后的模型和現有的利用超大模型直接數據合成語料上訓練更充足的模型,表現也非常接近。這充分說明了 ProX 優化數據質量的有效性。

圖:ProX 和原始數據、Tinyllama (3T token)、OLMo (2T token)、Pythia (300B token) 的訓練代價及性能表現對比。

在這些對比的模型中,Inst-LM 實際采用了更大規模的經過重構的下游數據集 + 微調的 Mistral-7B 模型,合成了更多的 100B tokens;Cosmo 則采用了更大規模的 Mistral-8x7B 模型合成了 25B tokens,并重復訓練了 180B 總 tokens;Sheared-Llama 則是通過模型剪枝算法,從 Llama-2-7B 中剪枝并且繼續訓練 50B tokens 得到。相比于 ProX 僅用了 0.3B 的優化模型和 50B tokens 的訓練代價,這些模型的數據開發和訓練成本都要大得多。而 ProX 取得了和他們十分接近的數據集表現,也進一步反應了 ProX 的高效和節省計算量。

圖:ProX 和 LLama-2 模型剪枝方法、其他合成語料訓練的模型之間的性能比較。

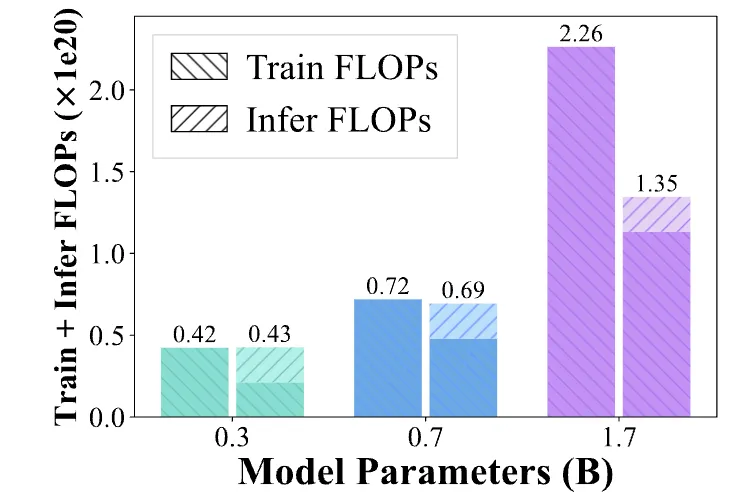

通過對 FLOPs 的定量分析,團隊發現隨著訓練模型參數量的擴大,ProX 的數據優化的推理成本占訓練成本的比例在不斷下降,達到相同下游表現的總訓練成本也在大幅下降。并且相比于利用大模型,直接進行大規模數據合成高質量語料所需要的代價要小得多。

圖:達到相同性能,使用 / 不使用 ProX 所需的總計算量成本。

特定領域預訓練 :無需額外設計,大幅提升數學性能

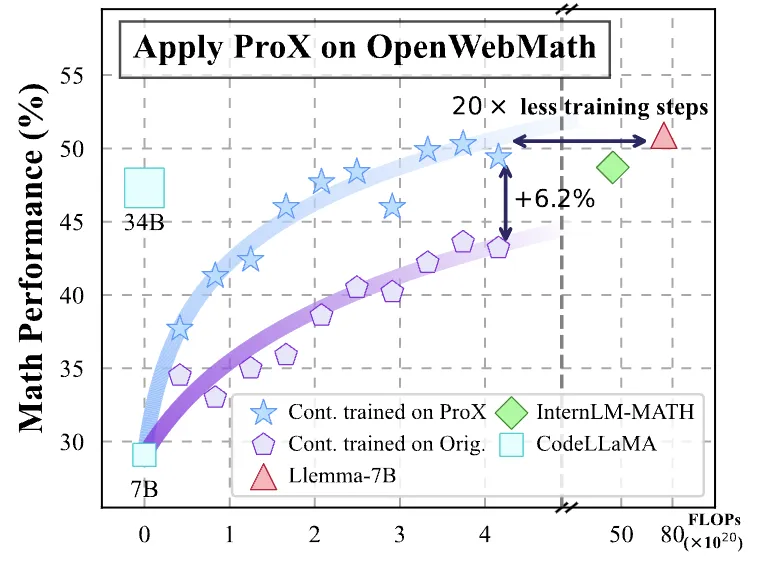

ProX 在數學語料上也有相似的提升。ProX 對現有最好的開源數學文本語料 Open-Web-Math 進行優化,得到了約 5B 高質量的數據。在對 7B 模型 (如,CodeLlama,Llama,Mistral)經過了 10B~15B 的預訓練后,模型在 9 個數學相關榜單上最高提升 20% 的性能。注意到 ProX 僅用了約 1/20 的訓練代價,就得到了效果堪比現有的使用開源數據訓練 50B 甚至 200B 的專用數學大模型,再次證明了數據質量對于模型的重要性。

值得注意的是,ProX 并未對數學領域的數據優化模型、優化函數、數據收集進行額外的設計;他們直接使用了和通用領域相同的提示詞、函數實現、構建策略,就得到了出色的效果;這也極大降低了定制化垂類大模型的開發成本。

圖:ProX 在數學語料上的續訓練以及在 9 個數學任務上的平均性能表現。

6. 未來展望

ProX 可以怎么樣幫助社區做下一步的研究?他們在論文的最后還構想中了如下幾點:

- 設計出更靈活的接口,以覆蓋多樣化的數據優化需求,進一步提升數據質量。

- 將 ProX 發展到更多專用 domain:例如代碼領域、多語言語料上,促進領域大模型的發展。

- 通過進一步減小模型尺寸、和其他加速手段,減小推理代價,使清洗 TB 級別文檔不再遙遠。

最后,隨著近期 openai o1 模型的發布,test time scaling 成為研究者們和業界關心的話題。對此,ProX 團隊也懷有相同的期待:在數據優化階段投入更多的計算量來優化數據,或許同樣能夠成為模型突破瓶頸、邁向通用人工智能(AGI)的重要技術手段之一。