全球首次!時序大模型突破十億參數,華人團隊發布Time-MoE,預訓練數據達3000億個時間點

在當今以數據為驅動的時代,時序預測已成為眾多領域不可或缺的核心組成。然而,構建一個兼具強大性能與高效運算的大規模時序預測模型始終是一個巨大的挑戰。此外,高質量的大型公共時間序列數據庫的匱乏進一步加劇了這一難題。

近日,由來自普林斯頓大學、格里菲斯大學等全球多地的華人國際科研團隊攜手通力合作,創新性地提出了一種基于混合專家架構(Mixture of Experts, MoE)的時間序列基礎模型Time-MoE,首次將時間序列預訓練大模型的參數規模推向十億級別,在時序預測領域實現了里程碑式的突破。

圖片

圖片

論文鏈接:https://arxiv.org/pdf/2409.16040

代碼鏈接:https://github.com/Time-MoE/Time-MoE

與此同時,團隊精心整理了預訓練數據集Time-300B,這是目前時序領域最大的公開數據集,為各類時序任務提供了前所未有的通用解決方案。這是首次在時序領域中采用如此大規模的預訓練模型,標志著時序預測技術邁入了一個全新的時代。

Time-MoE模型通過MoE架構的獨特優勢,將模型參數成功擴展至24億,不僅顯著提升了預測精度,還在降低計算成本的同時超越了眾多現有模型,全面達到了SOTA(State of the Art)水平。

關鍵技術突破

1. 強大的混合專家架構:Time-MoE采用稀疏激活機制,在預測任務中僅激活部分網絡節點,這不僅確保了高預測精度,還顯著降低了計算負擔,完美解決了時序大模型在推理階段的計算瓶頸。

2. 靈活的預測范圍:Time-MoE支持任意長度的輸入和輸出范圍,能夠處理從短期到長期的各種時序預測任務,實現了真正的全域時序預測。

3. 全球最大規模的開源時序數據集:團隊開發了Time-300B數據集,涵蓋9個領域的超過3000億個時間點,為模型提供了豐富的多領域訓練數據,確保其在多種任務中的卓越泛化能力。

圖片

圖片

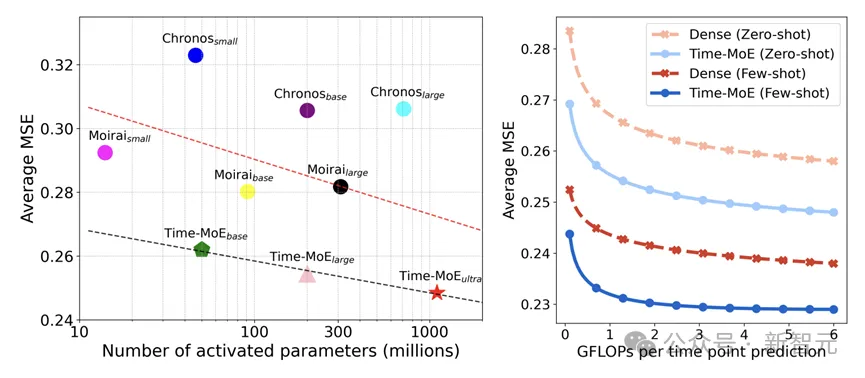

在相同激活參數條件下,Time-MoE顯著超越了現有的時序基礎模型。在相同的FLOPs下,其稀疏架構展現出相較于密集模型的卓越精度優勢。

模型框架

圖片

圖片

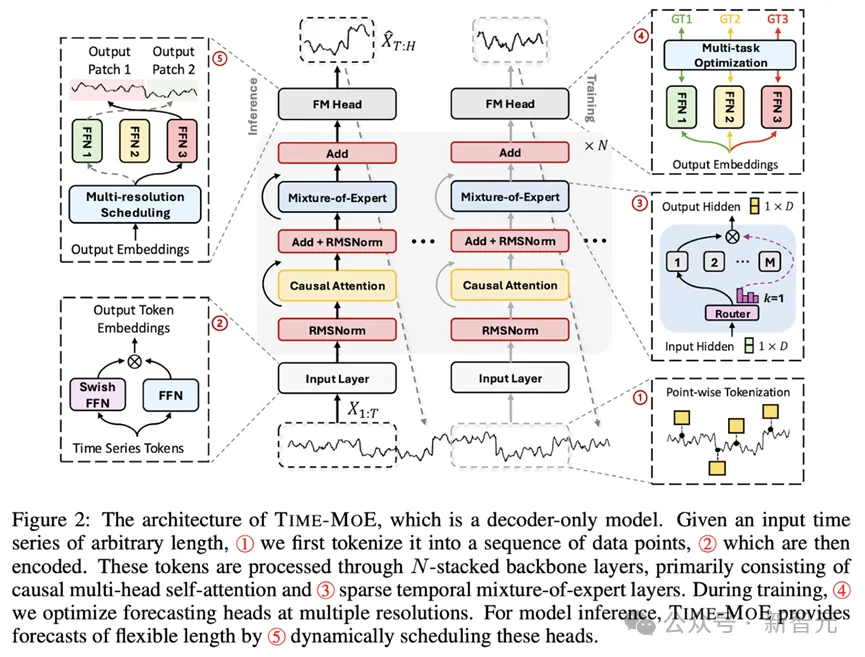

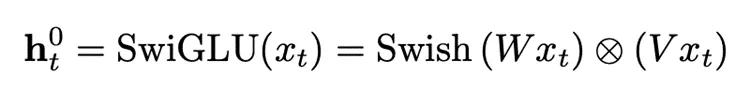

輸入Token Embedding

Time-MoE使用逐點分詞方法以確保時間序列信息的完整性,提高了模型處理不同長度序列的靈活性與適用性,如模型框架圖中①所示。在②中,SwiGLU激活函數對每個時間序列點進行嵌入,其中包括一個Feed-forward network (FFN) 和一個Swish FFN,從而增強模型對多維輸入的處理能力:

圖片

圖片

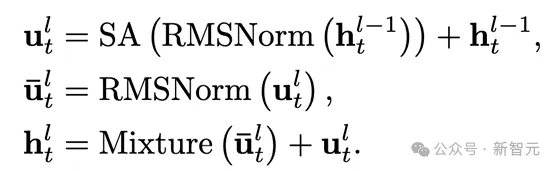

MoE Transformer模塊

Time-MoE基于decoder-only Transformer,并結合了大規模語言模型中的最新技術。Transformer模塊里, RMSNorm對每個子層輸入進行了歸一化處理,從而提升了訓練的穩定性。

同時,采用旋轉位置編碼代替絕對位置編碼,使得模型在處理可變序列長度時具備更好的外推能力。此外,模型引入了稀疏激活的混合專家層來取代標準Transformer模塊里的FFN。

公式化概括如下:

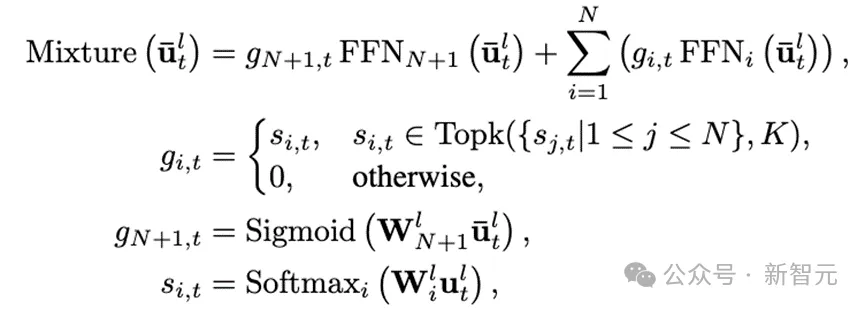

其中Mixture代表混合專家層。如模型框架圖中③所示,單個時間序列數據點可以被分配給一個或多個專家。通過選擇部分專家網絡來處理特定時間點的輸入,模型的計算效率得到了提高。

多分辨率預測

如模型框架圖中④和⑤所示,Time-MoE設計了一種多分辨率預測頭,可以同時進行不同尺度的預測,突破了單一尺度預測的局限。

在訓練時,不同分辨率頭會被聯合優化。在與推理時,模型采用貪心算法,利用不同尺度的輸出組合成任意的預測長度。這種設計允許模型根據不同的預測范圍進行靈活預測,并在訓練過程中綜合多個預測尺度的誤差來優化模型的泛化能力,從而顯著提升預測的準確性和魯棒性。

實驗效果

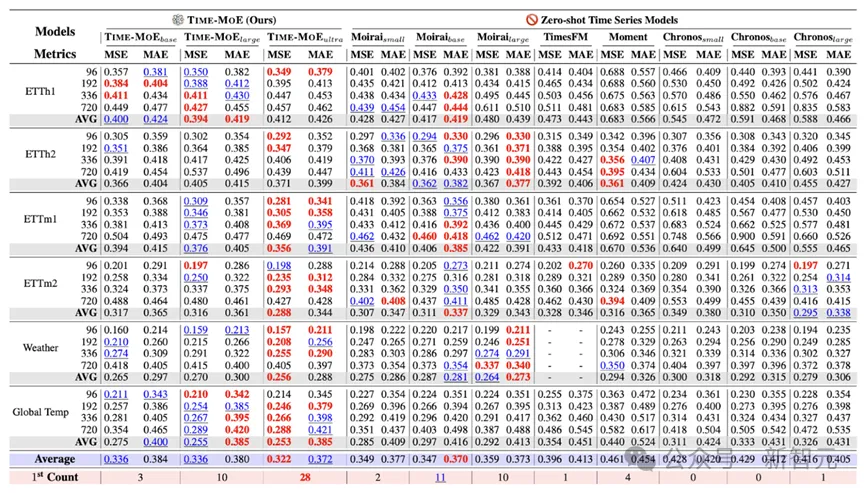

1. 零樣本zero-shot預測

零樣本預測能有效檢驗時序基礎模型的泛化能力和通用性。實驗表明,與現有的時序基礎模型相比,Time-MoE達到了最好的預測效果,均方誤差(MSE)降低了約20%

圖片

圖片

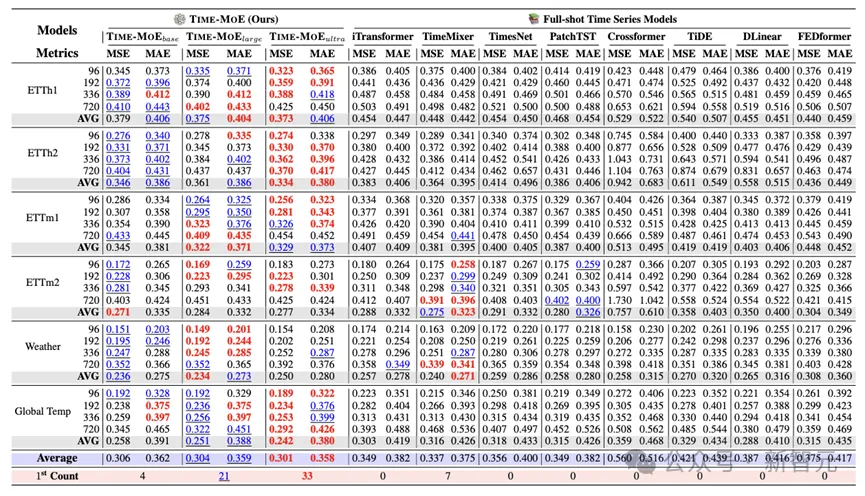

2. 全樣本full-shot預測

在全樣本預測中,預訓練的Time-MoE會使用相應數據的訓練集進行微調。實驗表明,與專門為全樣本預測設計的時序模型相比,Time-MoE依然能達到最優的效果, MSE降低了約24%。這體現了模型對于不同領域數據的適用性,以及預訓練基礎模型對于下游任務幫助的有效性。

圖片

圖片

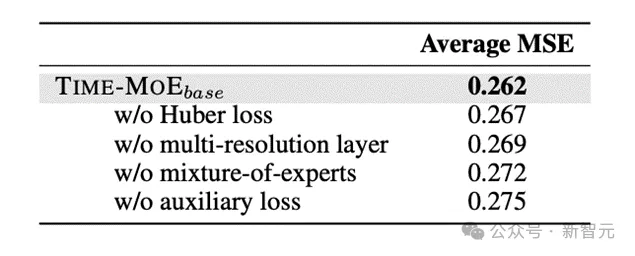

3. 消融實驗

文中進一步提供了一系列消融實驗來驗證模型框架設計的合理性。實驗表明,Time-MoE的設計在提升模型精度上是有效的。特別地,在不使用混合專家的情況下,模型的MSE會有明顯的退化。

圖片

圖片

4. Scalability分析

作者對于模型的規模化效果進行了詳細分析,如下圖所示。左圖的實驗表明,與稠密模型相比,稀疏模型減少了平均78%的訓練成本和39%的推理成本。

右圖的結果表明,隨著數據量和模型參數的增大,Time-MoE持續表現出穩定的性能提升,并且與同規模的稠密模型相比,總能達到更小的MSE和更好的預測性能。

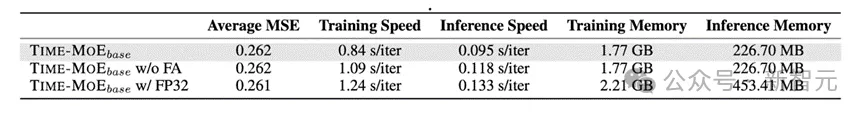

此外,作者還分析了訓練精度的影響。如下表所示,與使用float32精度進行訓練相比,使用bfloat16精度能得到相似的預測性能,但是bfloat16模型能在訓練速度上獲得12%的提升,內存占用上有 20%的減少。

圖片

圖片

此外,bfloat16還可以與flash-attention(表中簡稱為FA)無縫結合,從而進一步在訓練和推理速度上帶來23%和19%的提升。

總結

Time-MoE的成功標志著時序預測領域邁入了一個全新時代。它不僅在性能上全面超越了現有模型,更為構建大規模、高效、通用的時序預測基礎模型奠定了一個可行的范式。Time-MoE的發布不僅為學術界開辟了全新的研究方向,也為工業界的多種時序應用場景注入了巨大的潛力。在能源管理、金融預測、電商銷量、氣象預報等眾多關鍵領域,Time-MoE將成為企業和研究機構的強大工具。

團隊成員相關論文:

[1] Foundation Models for Time Series Analysis: A Tutorial and Survey, KDD 2024.

https://arxiv.org/abs/2403.14735

[2] Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook, arXiv 2023

https://arxiv.org/abs/2310.10196

[3] Position: What Can Large Language Models Tell Us about Time Series Analysis, ICML 2024.

https://arxiv.org/abs/2402.02713

[4] Time-LLM: Time Series Forecasting by Reprogramming Large Language Models, ICLR 2024.

https://arxiv.org/abs/2310.01728

[5] TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting, ICLR 2024.

https://arxiv.org/abs/2405.14616

[6] iTransformer: Inverted Transformers Are Effective for Time Series Forecasting, ICLR 2024.

https://arxiv.org/abs/2310.06625

[7] TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis, arXiv 2024

https://arxiv.org/abs/2410.16032

[8] Towards Neural Scaling Laws for Time Series Foundation Models, arXiv 2024 https://www.arxiv.org/pdf/2410.12360

[9] Time-MMD: A New Multi-Domain Multimodal Dataset for Time Series Analysis, NeurIPS 2024.

https://arxiv.org/abs/2406.08627

[10] Time-FFM: Towards LM-Empowered Federated Foundation Model for Time Series Forecasting, NeurIPS 2024.

https://arxiv.org/abs/2405.14252