豆包文生圖技術報告發(fā)布!數(shù)據(jù)處理、預訓練、RLHF全流程公開

今天,豆包大模型團隊正式發(fā)布文生圖技術報告,首次公開 Seedream 2.0 圖像生成模型技術細節(jié),覆蓋數(shù)據(jù)構建、預訓練框架、 后訓練 RLHF 全流程。

該報告針對 Seedream 2.0 原生中英雙語理解、文字渲染、高美感、分辨率與畫幅變換等特性的實現(xiàn),進行了具體介紹。

本文將呈現(xiàn)其中精華內容,報告完整版可通過下方鏈接獲取:

技術展示頁:https://team.doubao.com/tech/seedream技術報告:https://arxiv.org/pdf/2503.07703

豆包大模型團隊文生圖模型 Seedream 2.0 于 2024 年 12 月初在豆包 APP 和即夢上線,已服務上億 C 端用戶,并成為國內許多專業(yè)設計師輔助創(chuàng)作的首選模型。

相比 Ideogram 2.0、Midjourney V6.1、Flux 1.1 Pro 等主流模型,該模型更好解決了文本渲染能力欠佳、對中國文化理解不足等諸多實際問題,支持原生中英雙語,美感、指令遵循等能力有整體提升。

具體來看,模型支持中英文指令的高精度理解與遵循,能生成高美感度的圖像作品。

針對字體渲染和海報設計等實際場景,生成文字崩壞率大幅降低,且字體變化呈現(xiàn)更自然、更具美感。

對于國風圖案與元素,比如國畫、泥塑、文玩、旗袍、書法等,Seedream 2.0 也可輸出高品質的呈現(xiàn)結果。

團隊為了較全面客觀地評估模型,圍繞圖文匹配度、結構準確率、美感等基礎維度,嚴格構建了 Bench-240 評測基準。

通過測試,團隊發(fā)現(xiàn) Seedream 2.0 面向英文提示詞,其生成內容的結構合理性、文本理解準確性高于主流模型。

注:面向英文提示詞,Seedream 2.0 在不同維度上的表現(xiàn)。本圖各維度數(shù)據(jù)以最佳指標為參照系,已進行歸一化調整。

注:面向英文提示詞,Seedream 2.0 在不同維度上的表現(xiàn)。本圖各維度數(shù)據(jù)以最佳指標為參照系,已進行歸一化調整。

中文綜合能力同樣突出,其生成與渲染文字可用率達 78%,完美響應率為 63%,高于業(yè)界目前其他模型。

注:面向中文提示詞,Seedream 2.0 在不同維度上的表現(xiàn)。本圖各維度數(shù)據(jù)以最佳指標為參照系,已進行歸一化調整。

以下將從數(shù)據(jù)預處理、預訓練、后訓練維度介紹模型技術細節(jié)。

1. 深度融合知識的數(shù)據(jù)預處理框架

生成式 AI 技術,正從規(guī)模至上的 “暴力美學” ,向滿足特定要求的 “精準智能” 轉變,與之同步,數(shù)據(jù)預處理也演變?yōu)閺碗s的系統(tǒng)工程。

面對百億量級的中英多模態(tài)數(shù)據(jù),Seedream 2.0 團隊構建了以 “知識融合” 為核心的預處理框架,從以下三個方面實現(xiàn)技術突破。

- 四維數(shù)據(jù)架構,實現(xiàn)質量與知識的動態(tài)平衡

傳統(tǒng)圖像生成模型訓練數(shù)據(jù)篩選常面臨 “質量-規(guī)模” 的兩難抉擇,數(shù)據(jù)量級是模型能力的基礎,但大規(guī)模數(shù)據(jù)構建,往往伴隨質量下滑,進而影響模型表現(xiàn)。

為此,團隊創(chuàng)新設計了四維拓撲網(wǎng)絡,突破單一模態(tài)限制。該架構包含四個數(shù)據(jù)層:

1)優(yōu)質數(shù)據(jù)層:精選高分辨率、知識密度強的數(shù)據(jù)(如科學圖解、藝術創(chuàng)作),奠定質量基礎;

2)分布維持層:采用雙層級降采樣策略,從數(shù)據(jù)源維度對頭部平臺等比降維,從語義維度通過 10 萬級細粒度聚類維持多樣性;

3)知識注入層:構建 3 萬+ 名詞和 2000+ 動詞分類體系,結合百億級跨模態(tài)檢索,為數(shù)據(jù)注入文化特征;

4)定向增強層:建立 “缺陷發(fā)現(xiàn)-數(shù)據(jù)補充-效果驗證” 閉環(huán),優(yōu)化動作序列、反現(xiàn)實生成等場景。

這一架構有效平衡了數(shù)據(jù)質量與知識多樣性,為模型訓練提供堅實的數(shù)據(jù)支撐。

- 智能標注引擎:三級認知進化

傳統(tǒng)標注的 Caption 系統(tǒng)受單模態(tài)理解局限,對圖像內容描述不夠全面精準。團隊在其基礎上,實現(xiàn)了智能標注引擎的三級認知進化,提升模型理解、識別能力。

首先,構建分層描述體系,通過短、長和特殊場景 Caption 結合,實現(xiàn)多維度、多層級精準圖片描述,既能捕捉圖像核心內容,又能提供豐富細節(jié)與藝術解釋。

其次,建立文化專有名詞映射庫,實現(xiàn)跨語言對齊,將中英文生成質量差異壓縮至 2% 以內,提升模型在多語言環(huán)境下表現(xiàn)。

最后,引入動態(tài)質檢機制,利用 LLM 進行預篩選,通過 Badcase 驅動 prompt 模板迭代,優(yōu)化描述質量,確保數(shù)據(jù)質量與可靠性。

- 工程化重構:百億數(shù)據(jù)的流水線并行處理

工程化方面,傳統(tǒng) ETL 流程存在算力錯配與迭代遲滯痛點。

這不僅導致非核心任務占用大量高算力資源,擠占核心任務資源,也造成數(shù)據(jù)處理流程難以適應業(yè)務與數(shù)據(jù)變化,限制整體效能。

團隊從兩方面重構工程系統(tǒng)。

一方面通過異構調度,將水印檢測等非核心任務遷移至低算力集群,釋放高算力資源用于關鍵任務。另一方面,采用 “分片-校驗-裝載” 三級流水線并行處理方法,打包速度提升 8 倍。

這些改進大幅提高數(shù)據(jù)處理效率與質量,為大規(guī)模數(shù)據(jù)管理利用奠定基礎。

2. 預訓練聚焦雙語理解與文字渲染

在預訓練階段,團隊基于大量用戶調研與技術預判認為,多語言語義理解、雙語文字渲染和多分辨率場景適配等模塊的突破,對于圖像生成技術發(fā)展極為關鍵,可大幅提升模型適用性與用戶體驗,滿足不同語言文化背景的用戶需求,并拓展應用場景。

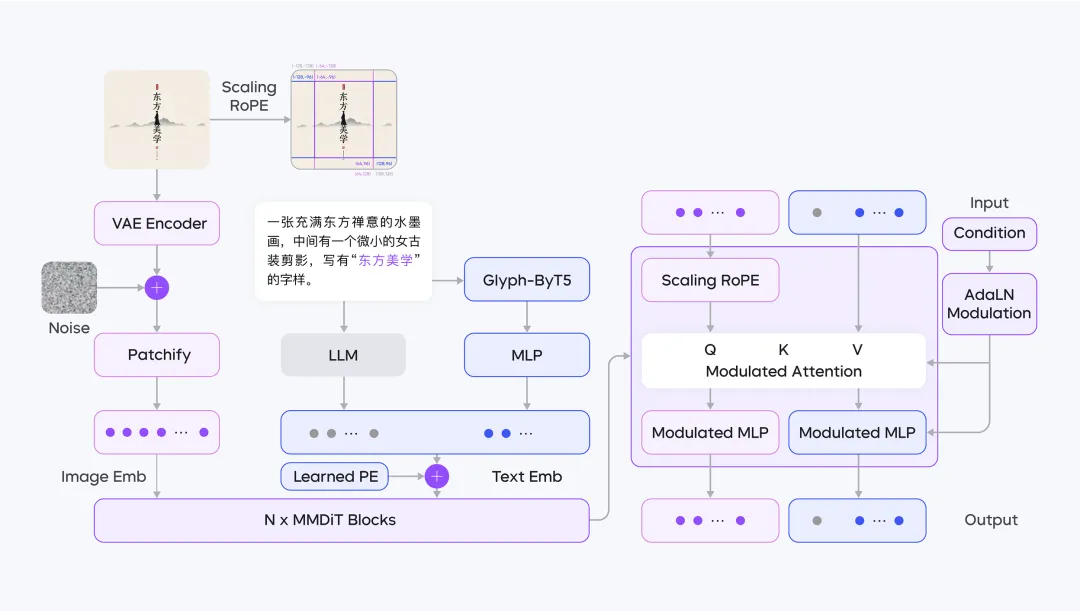

因此,Seedream 2.0 采用了全新的預訓練架構設計,其整體框圖如下。

具體來看,Seedream 2.0 從三個方面實現(xiàn)了關鍵技術升級。

- 原生雙語對齊方案,打破語言視覺次元壁

面向雙語文生圖場景,傳統(tǒng)的 CLIP/T5 編碼器對中文語義和文化細節(jié)的捕捉能力有限,大語言模型雖具備多語言理解能力,但文本嵌入與圖像特征的空間分布差異卻導致擴散模型訓練難以收斂。

為此,團隊提出基于 LLM 的雙語對齊方案。通過大規(guī)模文本-圖像對數(shù)據(jù),微調 Decoder-Only 架構的 LLM,使文本 Embedding 與視覺特征形成空間映射對齊。

同時,針對中文書法、方言俚語、專業(yè)術語等場景構建專用數(shù)據(jù)集,加強模型對文化符號的深度理解與感知。

這種“預訓練對齊 + 領域增強”的雙軌策略,使模型能夠直接從大量中英文數(shù)據(jù)中習得“地道”的本土知識,進而,準確生成具有文化細微差別的中文或英文美學表達圖像,打破不同語言與視覺的次元壁。

- 讓模型既看懂文本,又關注字體字形

在過去,圖像生成模型的文本渲染常面臨兩難困境:依賴 ByT5 等字形模型易導致長文本布局混亂,而引入 OCR 圖像特征又需額外布局規(guī)劃模塊。

為此,團隊構建了雙模態(tài)編碼融合系統(tǒng)—— LLM 負責解析“文本要表達什么”,ByT5 專注刻畫“文字應該長什么樣”。

具體來說,通過 MLP 投影層,將 ByT5 的字形特征對齊到 LLM 語義空間,二者拼接后輸入擴散模型。

此種方法下,字體、顏色、大小、位置等渲染屬性不再依賴預設模板,而是通過 LLM 直接描述文本特征,進行端到端訓練。

如此一來,模型既能從訓練數(shù)據(jù)中學習文本渲染特征,也可以基于編碼后的渲染特征,高效學習渲染文本的字形特征。

- 三重升級 DiT 架構,讓圖像生成縮放自如

多分辨率生成是圖像生成場景的常用需求,團隊在 SD3 的 MMDiT 架構基礎上,進行了兩重升級:

其一,在訓練穩(wěn)定性方面。團隊引入 QK-Norm 抑制注意力矩陣的數(shù)值波動,結合全分片數(shù)據(jù)并行策略(FSDP),使模型訓練收斂速度提升 300%。

其二,團隊設計了 Scaling ROPE 技術方案。傳統(tǒng)二維旋轉位置編碼(RoPE)在分辨率變化時,可能會導致位置標識錯位。Seedream 2.0 通過動態(tài)縮放因子調整編碼,使圖像中心區(qū)域在不同寬高比下,保持空間一致性。這使得模型在推理過程中,能夠生成從未訓練過的圖像尺寸和各種分辨率。

3. 后訓練 RLHF 突破能力瓶頸

Seedream 2.0 的后訓練過程包含四個階段:

其中,CT 和 SFT 增強模型美學吸引力;人類反饋對齊(RLHF)利用自研獎勵模型與反饋算法,提升模型整體性能;Prompt Engineering 借助微調大語言模型優(yōu)化美學與多樣性表現(xiàn);超分模型提高圖像分辨率并修復細微結構錯誤。

其中最值得一提的是,團隊開發(fā)了基于人類反饋對齊的(RLHF)優(yōu)化系統(tǒng),提升了 Seedream 2.0 整體性能。

其核心工作包含以下三個方面:

- 多維度偏好數(shù)據(jù)體系,提升模型偏好上限

團隊收集并整理了一個多功能的 Prompt 集合,專門用于獎勵模型(RM)訓練和反饋學習階段,并通過構建跨版本和跨模型標注管道,增強了 RM 的領域適應性,并擴展了模型偏好的上限。

在標注階段,團隊構建了多維融合注釋。這一做法成功擴展了單一獎勵模型的多維度偏好表征邊界,促進模型在多個維度上實現(xiàn)帕累托最優(yōu)。

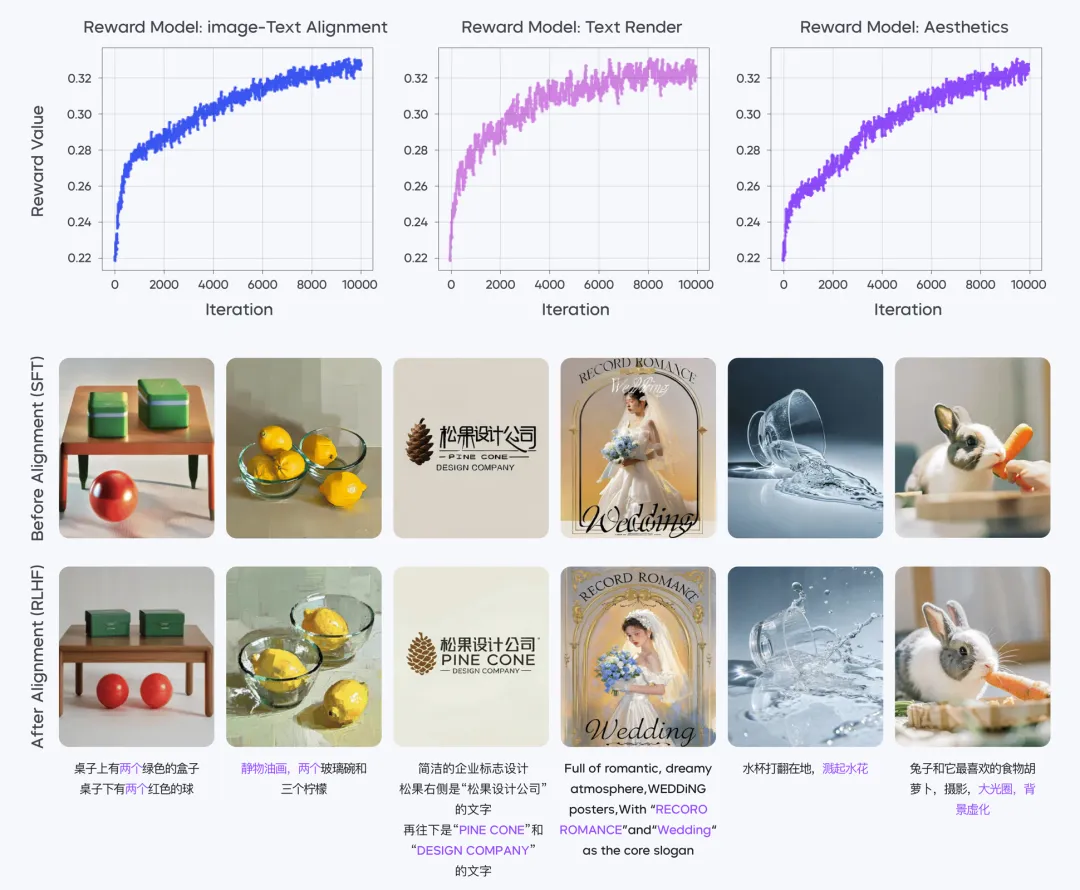

- 三個不同獎勵模型,給予專項提升

Seedream 2.0 直接利用 CLIP 嵌入空間距離,作為基礎獎勵值。這省去了回歸頭等冗余參數(shù)結構以及不穩(wěn)定訓練情況。

同時,團隊精心制作并訓練了三個不同的獎勵模型:圖像文本對齊 RM、美學 RM 和文本渲染 RM。

其中,文本渲染 RM 引入了觸發(fā)式激活機制,在檢測到“文本生成”類標簽時,模型將強化字符細節(jié)優(yōu)化能力,提升漢字生成準確率。

- 反復學習,驅動模型進化

團隊通過直接最大化多個 RM 的獎勵,以改進擴散模型。通過調整學習率、選擇合適的去噪時間步長和實施權重指數(shù)滑動平均,實現(xiàn)了穩(wěn)定的反饋學習訓練。

在反饋學習階段,團隊同時微調 DiT 和文本編碼器。此種聯(lián)合訓練顯著增強了模型在圖像文本對齊和美學改進方面的能力。

經(jīng)過 RLHF 階段對擴散模型和獎勵模型的多輪迭代,團隊進一步提高了模型性能。

獎勵曲線顯示,在整個對齊過程中,不同獎勵模型的表現(xiàn)分數(shù)值都呈現(xiàn)穩(wěn)定且一致的上升趨勢。

4. 寫在最后

此次技術報告的發(fā)布,旨在推動圖像生成技術進一步發(fā)展,加強業(yè)內交流。

展望未來,團隊將持續(xù)探索更高效地 Scaling 模型參數(shù)及數(shù)據(jù)的創(chuàng)新技術,進一步提升模型的性能邊界。

伴隨 2025 年強化學習浪潮興起,團隊將持續(xù)探索基于強化學習的優(yōu)化機制,包括如何更好地設計獎勵模型及數(shù)據(jù)構建方案。

后續(xù),豆包大模型團隊也將持續(xù)分享技術經(jīng)驗,共同推動行業(yè)發(fā)展。