3D大模型助力,15分鐘即可訓練高質量、個性化的數字人模型,代碼已開放

本文的作者主要來自于浙江大學和字節跳動。第一作者是浙江大學計算機學院的博士生葉振輝,導師為趙洲教授,主要研究方向是說話人視頻合成,并在 NeurIPS、ICLR、ACL 等會議發表相關論文。共一作者是來自浙江大學計算機學院的碩士生鐘添蕓。

個性化精品數字人(Personalized Talking Face Generation)強調合成的數字人視頻在感官上與真人具有極高的相似性(不管是說話人的外表還是神態)。目前業界主流的個性化精品數字人通常屬于在單個目標人數據上從頭訓練的小模型,雖然這種小模型能夠有效地學到說話人的外表和說話風格,這種做法存在低訓練效率、低樣本效率、低魯棒性的問題。相比之下,近年來許多工作專注于單圖驅動的通用數字人大模型,這些模型僅需單張圖片輸入即可完成數字人制作,但仍存在外表相似度較低、無法模仿目標人說話風格等問題。

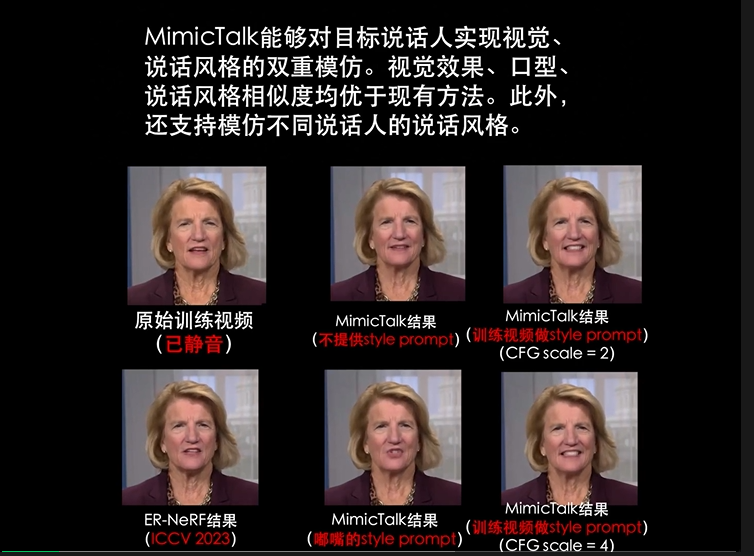

為了連接個性化數字人小模型和單圖驅動通用數字人大模型兩個領域之間的空白,浙江大學與字節跳動提出了 MimicTalk 算法。通過(1)將單圖驅動的通用 3D 數字人大模型 Real3D-Portrait (ICLR 2024) 適應到目標數字人的高效微調策略和(2)具有上下文學習能力的人臉動作生成模型,MimicTalk 可以生成相比原有方法更高質量、更具表現力的數字人視頻。此外,單個數字人模型的訓練時間可以被壓縮到 15 分鐘以內,相比現有最高效的同類方法快了 47 倍。

MimicTalk 算法被人工智能頂級會議 NeurIPS 2024 錄用,目前已開放源代碼和預訓練權重。

- 論文標題:MimicTalk: Mimicking a personalized and expressive 3D talking face in minutes

- 論文鏈接:https://arxiv.org/pdf/2410.06734

- 項目主頁:https://mimictalk.github.io/

- 代碼鏈接:https://github.com/yerfor/MimicTalk

話不多說直接看效果,以下視頻中的數字人模型都通過從 3D 數字人大模型進行 1000 步微調(5 分鐘訓練時間)得到。

模型技術原理

深悉 MimicTalk 模型的內在原理,還要回到開頭提到的個性化數字人兩個核心目標:(1)外表上與真人相似;(2)說話風格上與真人相似。

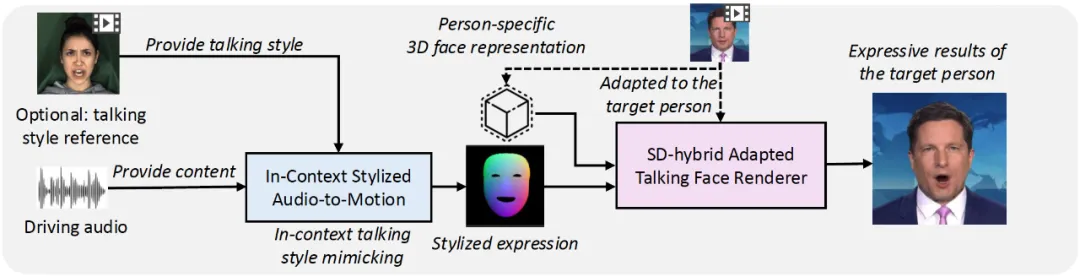

MimicTalk 分別使用(1)基于通用 3D 數字人大模型微調的高質量人臉渲染器和(2)一個具有上下文學習能力的人臉動作生成模型來實現它們。

圖 2. MimicTalk 包含一個高質量人臉渲染器(紫色)和一個能夠模仿說話風格的動作生成器(藍色)

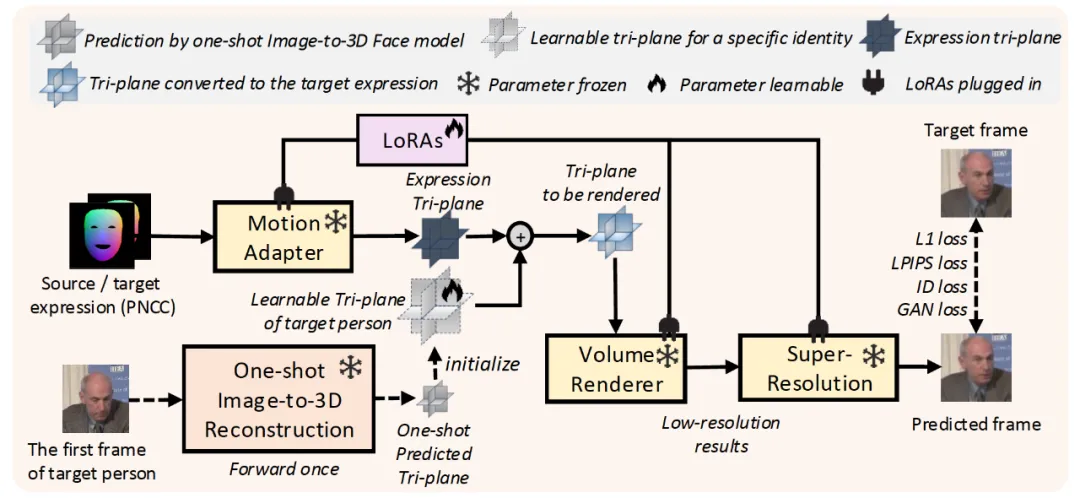

對于第一個問題,傳統方法通常從頭訓練一個小規模的 NeRF 模型來記憶目標人的外表特征,但這種做法通常導致較長的訓練時間(數個小時)、較高的數據量要求(數分鐘)、較低的魯棒性(對極端條件無法輸出正確的結果)。針對這一問題,團隊首次提出采用一個單圖驅動的通用 3D 數字人大模型作為基礎模型,并提出了一個「動靜結合」的高效率微調方案。

他們發現通用大模型的輸出通常存在牙齒、頭發等靜態細節不足,且肌肉運動等動態細節不真實的問題。因此針對靜態細節和動態細節的特性設計了動靜結合的微調方案。

具體來說,研究者發現現有的 3D 數字人通用模型通常會將 3D 人臉的靜態細節儲存在一個 3D 人臉表征(tri-plane)中作為模型的輸入,而 3D 人臉的動態細節,則通過模型內部的參數進行儲存。因此,MimicTalk 在個性化數字人渲染器的訓練過程中,不僅會更新儲存靜態細節的 3D 人臉表征,還通過 LoRA 技術對通用模型的參數進行了可拆卸的高效微調。

圖 2. 將通用 3D 數字人大模型適應到單個目標人,動靜結合的高效微調方案

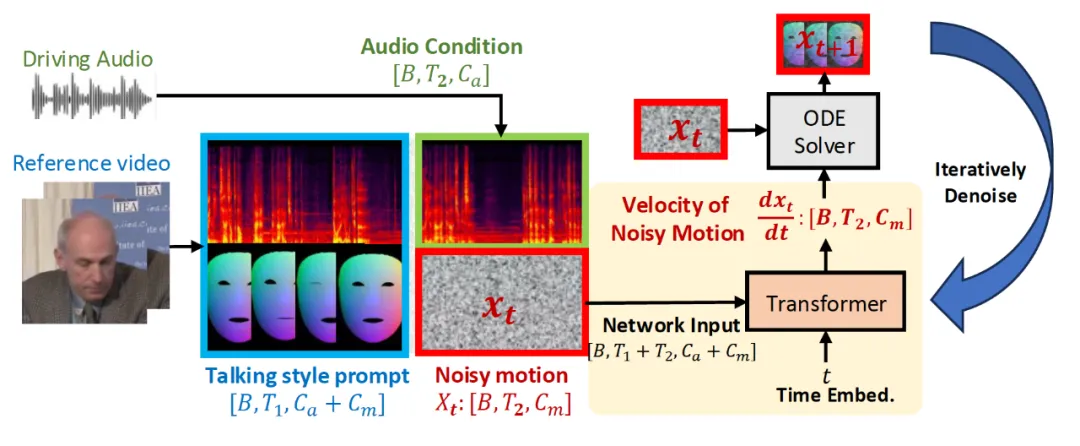

在實現圖像上與真人的高度相似后,下一個問題是如何生成與真人說話風格相似的面部動作。傳統方法通常會額外訓練一個說話風格編碼器,但是由于模型內部信息瓶頸的存在通常會性能損失。與之相比,受啟發大語言模型、語音合成等領域的啟發,MimicTalk 首次提出從上下文中學習目標人說話風格的訓練范式。在訓練階段,Flow Matching 模型通過語音軌道和部分未被遮擋的人臉動作軌道的信息,對被遮擋的人臉動作進行去噪。在推理階段,給定任意音頻 - 視頻對作為說話人風格提示,模型都能生成模仿該說話風格的人臉動作。

圖 3. 能在上下文中學習目標人說話風格的人臉動作生成模型

模型的應用前景

總體來看,MimicTalk 模型首次實現了高效率的個性化精品數字人視頻合成。可以預見的是,隨著技術的不斷迭代、普及,在智能助手、虛擬現實、視頻會議等多個應用場景中都將會出現虛擬人的身影。而借助 MimicTalk 算法,個性化高質量數字人的訓練成本被「打了下去」,人們將會享受到更真實、更舒適的交互體驗。隨著各個領域的大模型技術的興起,擁抱大模型的超強能力并與垂直領域中的特殊場景、需求相結合,已經成為了技術演進的大勢所趨。而 MimicTalk 模型為后續基于數字人通用模型的個性化數字人算法研究工作提供了參考。但現階段 MimicTalk 也并不是完美無缺的,由于依賴通用大模型的結果作為初始化,對基礎模型的質量有較高的要求,此外從推理效率上看與現有小模型還存在一定差距。

總而言之,過去幾年,隨著個性化數字人技術的不斷進步,口型精度、圖像質量已然不斷提高;而 MimicTalk 模型的提出,進一步解決了制約個性化數字人的訓練成本問題。讓我們一同期待虛擬人技術的加速發展,用戶也將獲得更加極致的視覺體驗和生活便利。