大型多視角高斯模型LGM:5秒產出高質量3D物體,可試玩

為滿足元宇宙中對 3D 創意工具不斷增長的需求,三維內容生成(3D AIGC)最近受到相當多的關注。并且,3D 內容創作在質量和速度方面都取得了顯著進展。

盡管當前的前饋式生成模型可以在幾秒鐘內生成 3D 對象,但它們的分辨率受到訓練期間所需密集計算的限制,進而導致生成低質量的內容。這就產生了一個問題,能否只用 5 秒鐘來生成高分辨率高質量的 3D 物體?

本文中,來自北京大學、南洋理工大學 S-Lab 和上海人工智能實驗室的研究者提出了一個新的框架 LGM,即 Large Gaussian Model,實現了從單視角圖片或文本輸入只需 5 秒鐘即可生成高分辨率高質量三維物體。

目前,代碼和模型權重均已開源。研究者還提供了一個在線 Demo 供大家試玩。

- 論文標題:LGM: Large Multi-View Gaussian Model for High-Resolution 3D Content Creation

- 項目主頁:https://me.kiui.moe/lgm/

- 代碼:https://github.com/3DTopia/LGM

- 論文:https://arxiv.org/abs/2402.05054

- 在線 Demo:https://huggingface.co/spaces/ashawkey/LGM

想要達成這樣的目標,研究者面臨著如下兩個挑戰:

- 有限計算量下的高效 3D 表征:已有三維生成工作使用基于三平面的 NeRF 作為三維表征和渲染管線,其對場景的密集建模和光線追蹤的體積渲染技術極大地限制了其訓練分辨率(128×128),使得最終生成的內容紋理模糊、質量差。

- 高分辨率下的三維骨干生成網絡:已有三維生成工作使用密集的 transformer 作為主干網絡以保證足夠密集的參數量來建模通用物體,但這一定程度上犧牲了訓練分辨率,導致最終的三維物體質量不高。

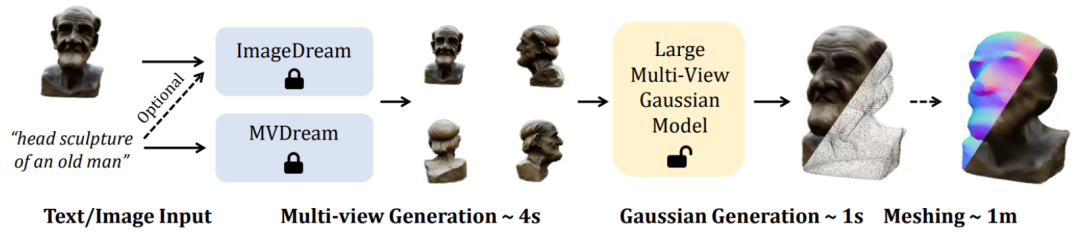

為此,本文提出了一個全新的方法來從四個視角圖片中合成高分辨率三維表征,進而通過已有的文本到多視角圖像或單圖到多視角圖像的模型來支持高質量的 Text-to-3D 和 Image-to-3D 任務。

在技術上,LGM 核心模塊是 Large Multi-View Gaussian Model。受到高斯濺射的啟發,該方法使用一個高效輕量的非對稱 U-Net 作為骨干網絡,直接從四視角圖片中預測高分辨率的高斯基元,并最終渲染為任意視角下的圖片。

具體而言,骨干網絡 U-Net 接受四個視角的圖像和對應的普呂克坐標,輸出多視角下的固定數量高斯特征。這一組高斯特征被直接融合為最終的高斯基元并通過可微渲染得到各個視角下的圖像。

在這一過程中,使用了跨視角的自注意力機制在低分辨率的特征圖上實現了不同視角之間的相關性建模,同時保持了較低的計算開銷。

值得注意的是,在高分辨率下高效訓練這樣的模型并非易事。為實現穩健的訓練,研究者仍面臨以下兩個問題。

一是由于訓練階段使用 objaverse 數據集中渲染出的三維一致的多視角圖片,而在推理階段直接使用已有的模型來從文本或圖像中合成多視角圖片。而由于基于模型合成的多視角圖片總會存在多視角不一致的問題,為了彌補這一域差距,本文提出了基于網格畸變的數據增強策略:在圖像空間中對三個視角的圖片施加隨機畸變來模擬多視角不一致性。

二是由于推理階段生成的多視角圖片并不嚴格保證相機視角三維幾何的一致,因此本文也對三個視角的相機位姿進行隨機擾動來模擬這一現象,使得模型在推理階段更加穩健。

最后,通過可微分渲染將生成的高斯基元渲染為對應圖像,通過監督學習直接端到端地在二維圖像上來學習。

訓練完成后,LGM 通過現有的圖像到多視角或者文本到多視角擴散模型,即可實現高質量的 Text-to-3D 和 Image-to-3D 任務。

給定同樣的輸入文本或圖像,該方法能夠生成多樣的高質量三維模型。

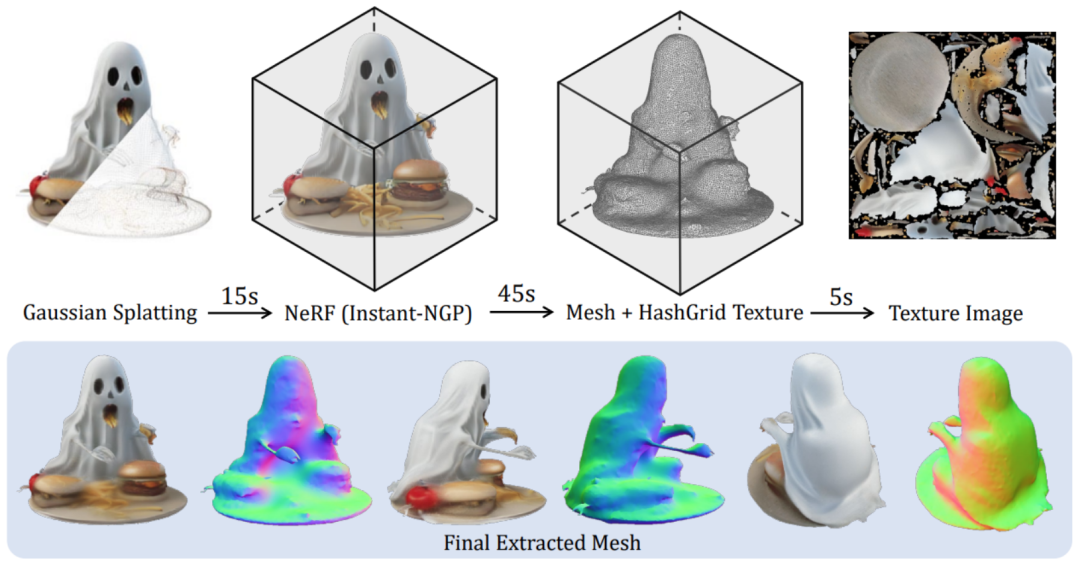

為了更進一步支持下游圖形學任務,研究者還提出了一個高效的方法來將生成的高斯表征轉換為平滑且帶紋理的 Mesh:

更多細節內容請參閱原論文。