把Waymo玩成GTA游戲!全生成式的車輛行駛軌跡視頻合成器來了

來自中科院自動化所的團隊提出 FreeVS,一個全生成式的新視角合成方法。相較于僅能在記錄的車輛行駛原軌跡上渲染高質量相機視角的基于場景重建的方法,FreeVS 能夠作為生成引擎渲染真實場景中任意車輛行駛軌跡下的視頻。FreeVS 可被直接部署于任何測試場景,而無需負擔通常耗時 2-3 小時的場景重建過程。

真實視頻

新軌跡下相機視頻

- 論文鏈接:https://arxiv.org/abs/2410.18079

- 項目主頁:https://freevs24.github.io/

以生成模型合成真實場景中的相機成像

現有駕駛場景中的新視角合成方法多遵循「場景重建 - 新視角渲染」的管線,依靠重建得到的 NeRF 或 3D-GS 等場景表示來渲染新視角下的成像。

然而基于重建的方法具有兩大瓶頸,1)無法合理渲染缺少對應觀測的新視角上的圖像,2)場景重建耗時長;這使得重建方法無法高效高質地在實際數據采集軌跡之外渲染大量新相機視圖。

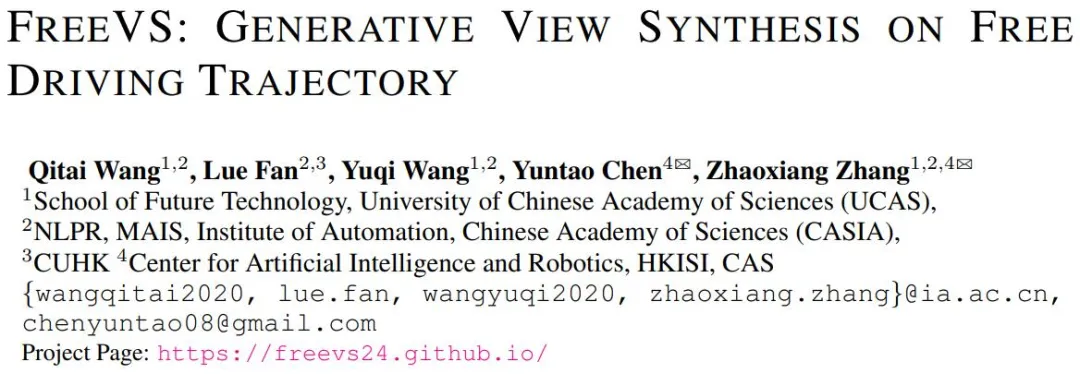

如簡單的視角左右平移即會引起前有方法圖像渲染質量的嚴重下降:

與前有重建方法在原訓練視角、訓練視角右一米、訓練視角上一米的視角合成效果對比。

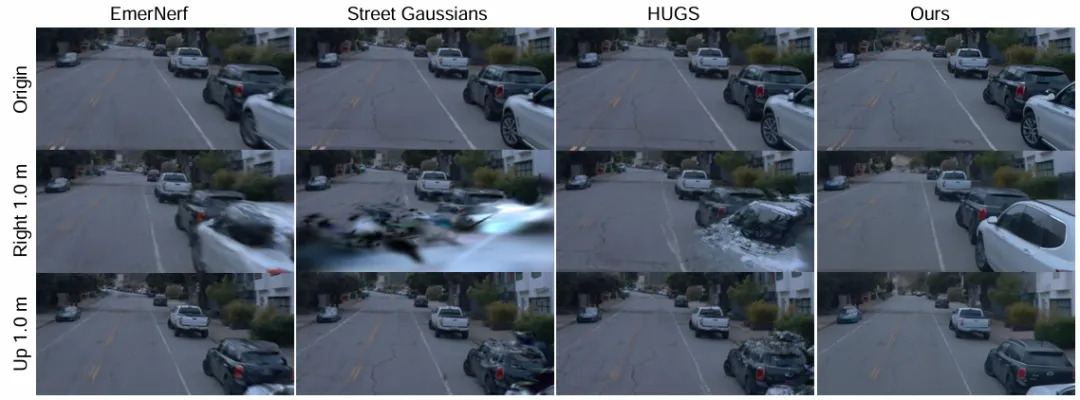

對此,作者提出一種新穎的完全基于生成模型的新視角合成方法 FreeVS。作者采用一簡潔有效的生成管線,可嚴格基于已觀測到的三維場景生成任意視角的相機觀測,且無需進行場景重建。

FreeVS 方法管線。生成模型基于染色點云投影恢復相機成像。

作者采用從稀疏點云投影中恢復相機成像的生成管線,這使得生成模型的行為類似于 Inpainting 模型,基于稀疏但可靠的點云投影點補全目標圖像。

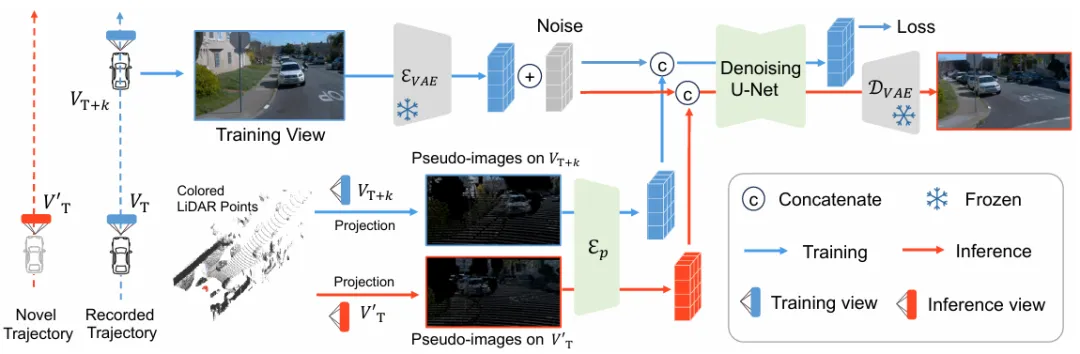

在訓練過程中,生成模型學習基于給定幀的三維先驗生成鄰近幀的相機成像。盡管訓練數據中駕駛車輛在絕大多情況下走直線前行,但生成模型可沿車輛軌跡在側向相機視角學習相機視角的橫向移動。

在測試階段,以圖像信息染色的場景三維點云被投影至任意所需視角,以控制圖像生成結果。

FreeVS 方法訓練數據與推理效果示例。即使訓練數據中無車輛橫向移動到逆行車道的例子,生成模型仍然可依靠側向相機的訓練對((c)->(a))學習相機的側向移動,從而生成合理的高質量成像 (f)。

車輛行駛模擬與場景編輯

以 Waymo 數據集中的真實場景為例,FreeVS 能夠在駕駛車輛原本并未移動的場景模擬車輛移動:

真實視頻

新軌跡下相機視頻

能模擬車輛變線行駛,甚至能秒變 GTA,使車輛撞向行人:

真實視頻

新軌跡下相機視頻

能在原本直行的場景令車輛走大 Z 型前進:

真實視頻

新軌跡下相機視頻

也能對場景內容進行編輯。任意替換場景車輛,或定制車輛運動。

真實視頻

場景編輯后相機視頻

真實視頻

場景編輯后相機視頻

與前有基于重建的方法比較,FreeVS 在新車輛運動軌跡下幾乎不受圖像模糊、偽影等現象困擾。

FreeVS 與前有方法在新軌跡模擬的表現對比。

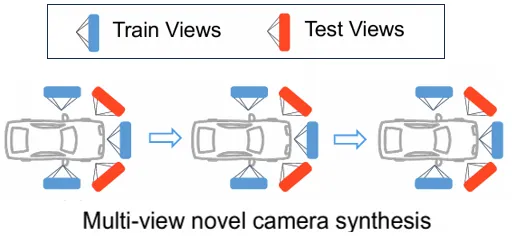

新相機模擬

除新行駛軌跡下視角合成,FreeVS 還能合成虛擬相機位置上的成像。而前有基于重建的方法難以應對虛擬相機位置上全部觀測的缺失。

新相機模擬示意圖

FreeVS 與前有方法在新相機模擬的表現對比。