不讓視覺語言模型「盲猜」,性能竟直接提升一倍?

團隊的共同一作林之秋(Zhiqiu Lin)是卡內基梅隆大學的博士研究生,由Deva Ramanan教授指導,專注于視覺-語言大模型的自動評估與優化。團隊的馬紫晛(Zixian Ma)是華盛頓大學的博士研究生,由Ranjay Krishna教授指導,專注于視覺-語言大模型的評測以及與人的交互。

在諸如 MME、MMBench、MMMU 和 ScienceQA 等復雜的視覺問答(VQA)基準上,GPT-4o、Qwen2-VL 等視覺語言模型已經取得了顯著進展。然而,這些模型真的理解自然圖像嗎?

近日,卡內基梅隆大學與華盛頓大學的研究團隊推出了 NaturalBench,這是一項發表于 NeurIPS'24 的以視覺為核心的 VQA 基準。它通過自然圖像上的簡單問題——即自然對抗樣本(Natural Adversarial Samples)——對視覺語言模型發起嚴峻挑戰。

- ??論文鏈接: https://arxiv.org/abs/2410.14669

- ??網站: https://huggingface.co/datasets/BaiqiL/NaturalBench

視覺語言模型(VLMs),如 GPT-4o、BLIP-3、LLaVA-OneVision、Llama3.2-Vision、Molmo 和 Qwen2-VL,在 MMMU 和 MME 等復雜視覺問答(VQA)基準上表現出色。這些基準涵蓋了大學課程、常識推理、圖表理解,以及數學、編程、物理和時序預測等任務。

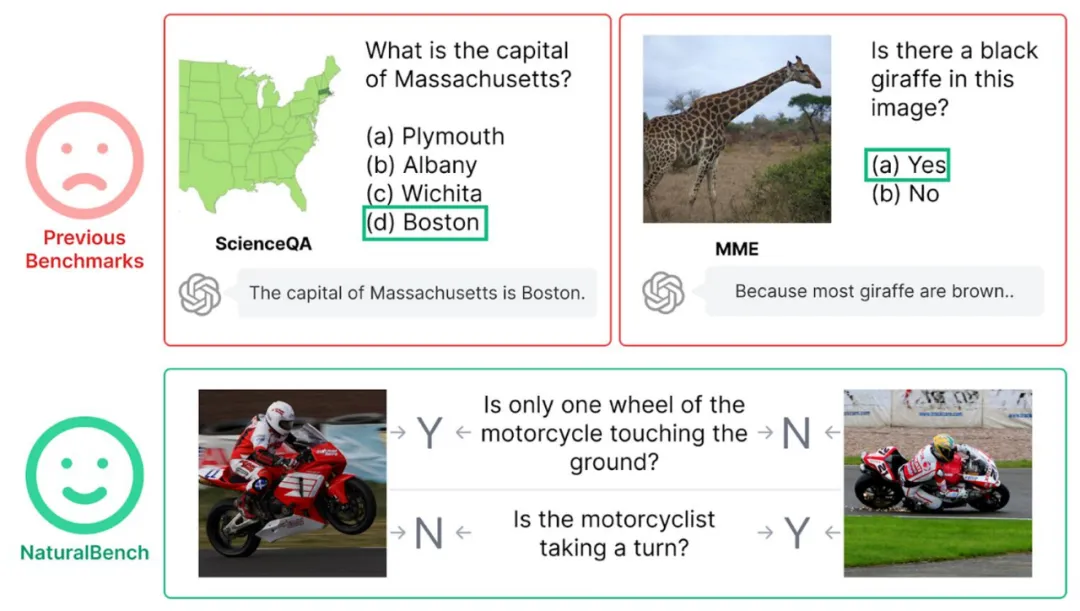

然而,研究團隊發現,這些模型在應對自然圖像中的簡單問題時仍存在不足。下圖展示了人類能輕松解答的 VQA 示例,但即使是最先進的模型也常會出錯,研究團隊將這些問題稱為「自然對抗樣本」。

模型之所以能在以往流行的 VQA 基準上表現出色,主要依賴于其過度的語言偏見(Language Bias)。為證明這一點,研究團隊展示了六大基準中的一些問題,即使不查看圖像也能作答。

例如,模型可以通過語言先驗(Language Prior)回答諸如「馬薩諸塞州的首府是什么?」(「波士頓」)和「圖片中有黑色長頸鹿嗎?」(「否」)這樣的問題,而無需依賴圖像信息。

為了解決這一問題,NaturalBench 設計了配對任務,將兩幅圖片與兩個相反答案的問題匹配,以避免模型可以憑「盲猜」僥幸答對。

NaturalBench 數據集收集過程

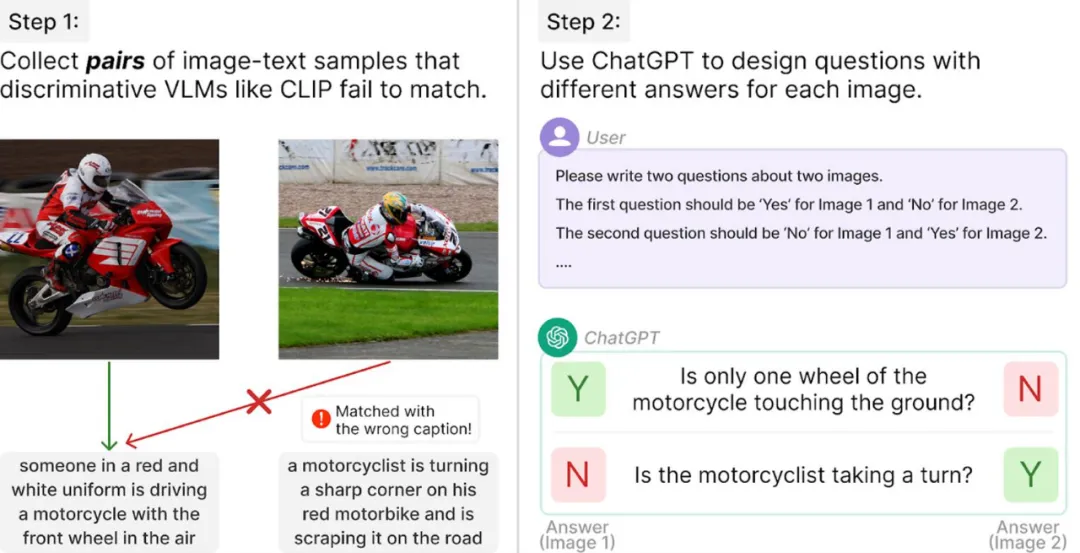

NaturalBench 通過一個簡單的流程從 Flickr30K 等圖文數據集中構建,具體步驟如下:

1. 找出 CLIP 無法正確匹配的圖文對。

2. 使用 ChatGPT 為每個圖文對生成相反答案的問題。

通過避免對圖像或問題進行非自然干擾,NaturalBench 生成了自然的對抗樣本。這些樣本基于自然圖像提出的問題,人類可以輕松理解并回答,但對模型來說卻極具挑戰性。

通過該流程及人工質檢,研究團隊最終收集了 10,000 個高質量 VQA 樣本,用于可靠評估視覺語言模型。

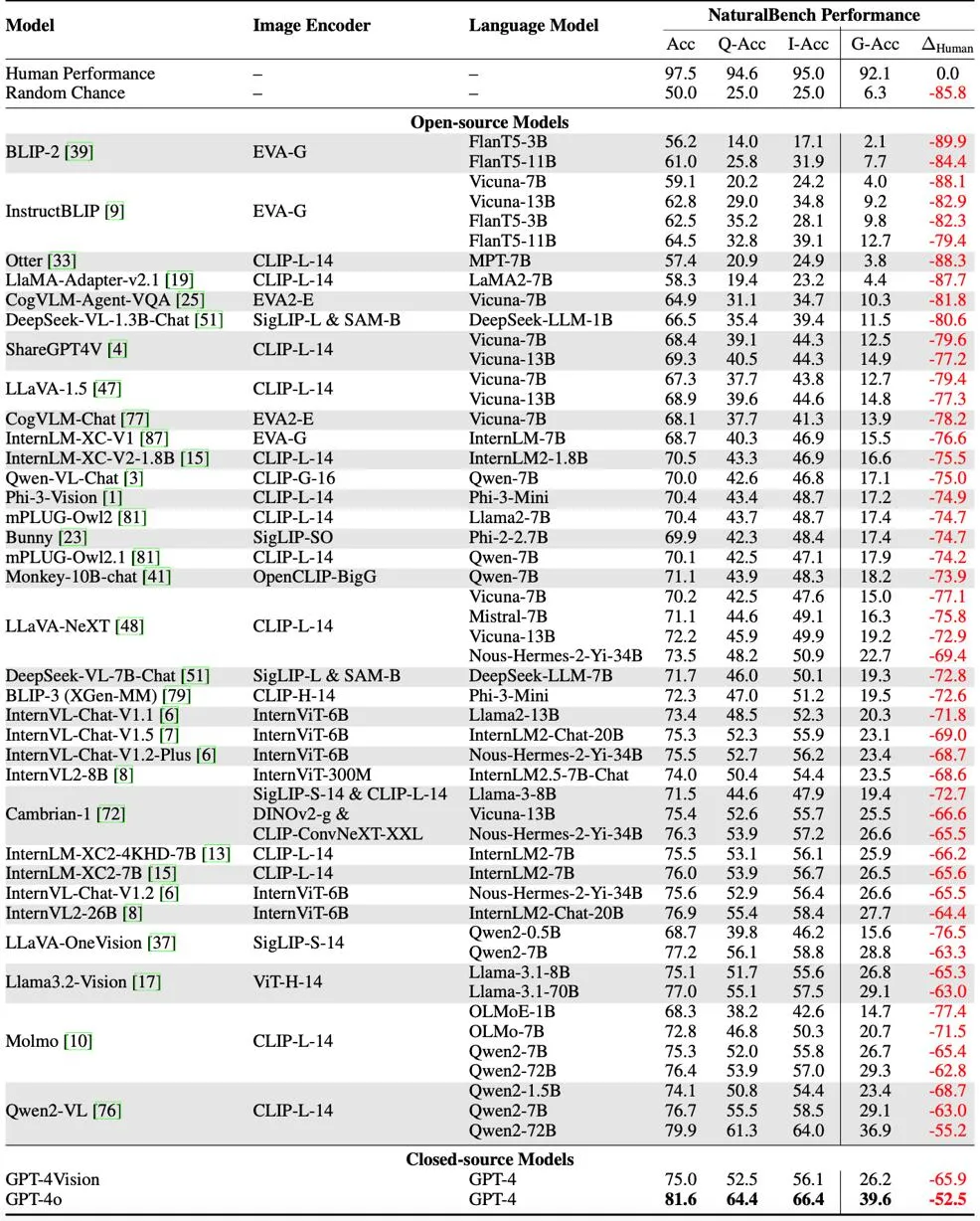

NaturalBench 實驗結果

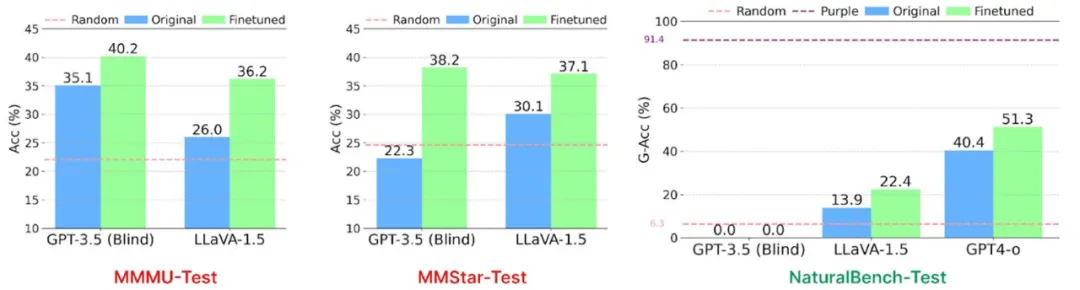

基于 NaturalBench 中「兩張圖片 + 兩個問題」配對的格式,研究團隊提出了更可靠的視覺為中心評估指標 ——Group Accuracy (G-Acc)。只有當模型正確回答一個樣本中的所有四個(圖片、問題)組合時,才能得一分。

研究人員發現了以下重要的實驗結論:

1、先前的 VQA 基準存在盲猜問題:流行的 VQA 基準,(如 MME 和 ScienceQA)可以通過微調不具視覺能力的 GPT-3.5 來解決,其表現甚至超過了經過視覺微調的 LLaVA-1.5。然而,在 NaturalBench 上,這種「盲猜」模型只能得到零分!

這表明,當前的視覺語言模型可能在視覺問答任務上依賴強大的語言盲猜能力「渾水摸魚」。

2、當前開源模型的表現有限:研究團隊對 53 個視覺語言模型進行了測試,結果顯示,大多數開源模型(如 BLIP-3、Cambrian-1、LLaVA-OneVision、Llama3.2-Vision、Molmo 和 Qwen2-VL)的得分僅比隨機水平高 10%-20%。即使是經過視覺微調的 GPT-4o,其表現仍比人類低 50%。

這表明,目前的視覺語言模型在自然圖像的視覺理解能力上還有巨大提升空間。

NaturalBench 實驗討論

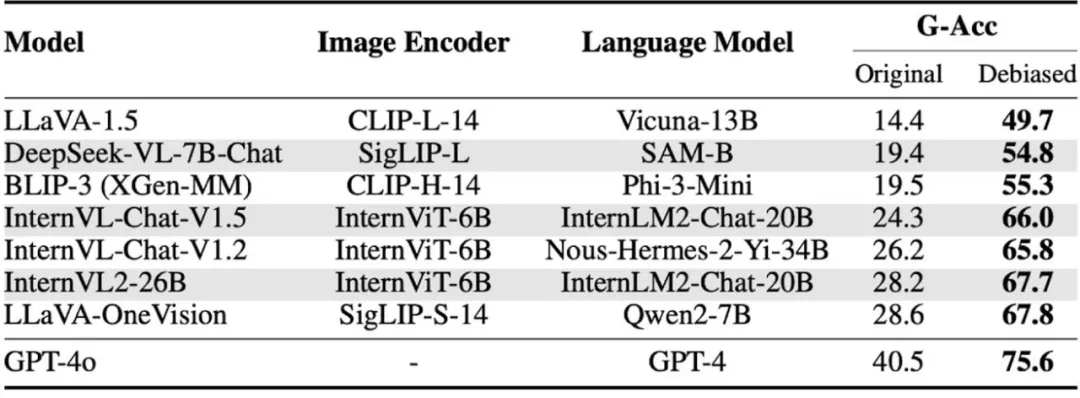

研究人員對提升視覺語言模型的方向進行了探討,并發現兩個重點:

1、讓大模型不再「盲選」:大多數模型失敗的關鍵在于,無論圖像內容如何,它們總是盲目選擇相同的選項。在 GPT-4o 出錯的問題中,超過 80% 是因為模型在任何圖像下都選擇了同一答案(如「是」)。研究人員發現,糾正這一傾向后,模型性能可提升兩到三倍!

研究團隊采用了一種基于評分的評估方式(VQAScore),通過調整同一問題下兩個不同選項的得分差,確保模型在回答「是」和「否」時的比例保持一致。僅憑這一簡單調整,像 GPT-4o 這樣的強大模型的表現幾乎翻了兩倍!

這意味著 NaturalBench 可以作為一個糾正模型偏見的基準,幫助減少模型的盲猜行為和幻覺問題。

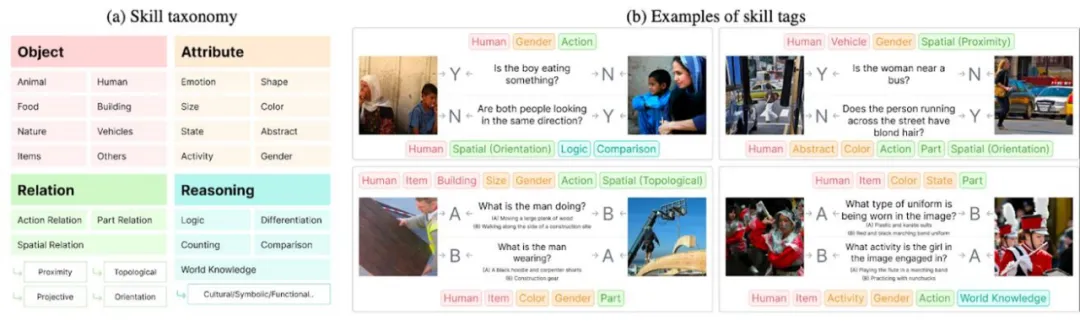

2、大模型仍需提升組合性思維(compositional reasoning)能力:NaturalBench 的大部分問題要求模型同時具備多種視覺技能(compositional reasoning),包括對象(object)、屬性(attribute)、關系(relation)和邏輯(logic)等維度。

為此,研究團隊為 NaturalBench 中的每個問題標注了 1 到 8 個技能標簽,對組合推理能力進行了細致評估。結果表明,即便是 GPT-4o,在空間關系、邏輯推理等方面仍有顯著的提升空間。

NaturalBench 對動態評測(Dynamic Evaluation)的意義

傳統機器學習模型在靜態基準上追平人類表現通常需要多年,例如 MNIST 用了 15 年,ImageNet 用了 7 年。然而,由于當前大模型大量使用互聯網數據,數據集泄露使新基準在數月內就可能過時。因此,近期研究提倡動態評估(Dynamic Evaluation),常見的方法是通過人機協作(human-and-model-in-the-loop)收集對抗樣本。

例如,Adversarial NLI 和 Dynabench 要求標注者不斷設計難題使模型出錯,而 Adversarial VQA 讓標注者為圖片反復生成問題,直到模型失敗。

相比之下,NaturalBench 不針對特定 VQA 模型,且只需標注者一次性驗證,大大提高了動態基準構建的效率。研究團隊還使用先進的 LongCLIP 等模型,從 DOCCI 和 XM3600 數據集中收集了更復雜且多語種的 VQA 樣本,證明了 NaturalBench 在未來大模型的動態評估中具有廣泛的適用性。

最后,NaturalBench 數據集已經開源:https://huggingface.co/datasets/BaiqiL/NaturalBench/

期待未來更加強大的視覺語言模型問世!