谷歌云更新 Kubernetes 引擎,可支持萬億參數的人工智能模型

生成式人工智能模型越來越大,參數已多達 2 萬億個,大型語言模型對計算和存儲的需求也在增加。

谷歌云(Google Cloud)今天宣布升級旗下 Kubernetes 引擎的容量,以應對更大規模的模型,Kubernetes 引擎的容量將從目前支持 15000 個節點集群升級到支持 65000 個節點集群。Kubernetes 引擎的擴容將為處理全球最復雜且資源密集型的人工智能任務提供所需的規模和計算能力。

在人工智能加速器工作負載上訓練數萬億參數的模型需要超過 10,000 個節點的集群。人工智能模型的參數指的是模型中的變量,這些變量控制著模型的行為方式和預測能力。變量越多,模型準確預測的能力就越強。參數有點類似于模型里的旋鈕或開關,模型開發者可以調整這些參數達到提高模型性能或準確性的目的。

谷歌云Kubernetes和無服務器高級產品總監 Drew Bradstock 在接受記者采訪時表示,“從根本上講,大型語言模型(LLM)不斷增大,世界各地公司需要非常大的集群才能高效運行這些模型。他們不僅僅需要大型集群。他們需要可靠、可擴展的集群才能應對運行這些 LLM 訓練工作負載實際遇到的挑戰。”

谷歌 Kubernetes 引擎(縮寫為 GKE)是谷歌提供的托管 Kubernetes 服務,GKE 可減少運行容器環境的工作量。GKE 可根據工作負載需求的變化自動添加和移除硬件資源,例如專用人工智能芯片或圖形處理單元。GKE 也可以為用戶 更新 Kubernetes 及監督其他維護任務。

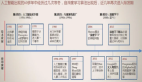

GKE 新的65,000節點集群能夠管理分布在250,000個張量處理單元上的人工智能模型,張量處理單元是用于加速機器學習和生成式人工智能工作負載的專用人工智能處理器。Bradstock 表示,這比 GKE 在單個集群上以前的基準(5 萬個 TPU 芯片)提高了五倍。

新的65,000節點集群大大提高了運行大規模人工智能工作負載的可靠性和效率。Bradstock 認為,規模的增加對大規模人工智能訓練和推理都很重要,因為 Kubernetes 允許用戶無需擔心停機就可以處理基于硬件的故障。這也能加快作業完成時間,因為額外的容量可以在更短的時間內運行更多的模型迭代。

Bradstock 表示,為了實現這一目標,谷歌云正在將GKE從開源的分布式鍵值存儲etcd過渡到更強大的基于谷歌分布式數據庫Spanner系統。這將使 GKE 集群能夠處理幾乎無限的規模并提供更低的延遲。

谷歌還對 GKE 基礎設施進行了重大改造,改造后 GKE 的擴展速度顯著加快。客戶需求因此能夠更快地得到滿足。此外,GKE 也能夠在單個集群中運行五個負載作業,每個作業的規模均與谷歌云之前訓練大型語言模型的記錄相匹配。

Bradstock表示,客戶的關注、該系統中人工智能的普及以及人工智能在整個行業的快速發展等等推動了升級需求。谷歌的客戶一直都在利用 GKE 的集群功能訓練他們的模型,客戶包括Anthropic PBC等領先的前沿人工智能模型開發商。

Anthropic 公司計算主管 James Bradbury 表示,“GKE 對更大型集群的新支持為我們提供了加快人工智能創新步伐所需的規模。”

Bradstock表示,在過去的一年里,GKE 上 TPU 和圖形處理單元的使用增加了 900%,大大超過了以前的使用量,而以前使用量就已經很大了。他表示,“這主要是由人工智能的快速增長所推動的。人工智能在未來將占 GKE 使用的主