AI模仿人類看漫畫,視頻大模型時序定位能力新SOTA

用看漫畫的方式,大幅提升視頻大模型時序定位能力!

方法名為NumPro,無需訓練,通過數字視覺提示就能增強。

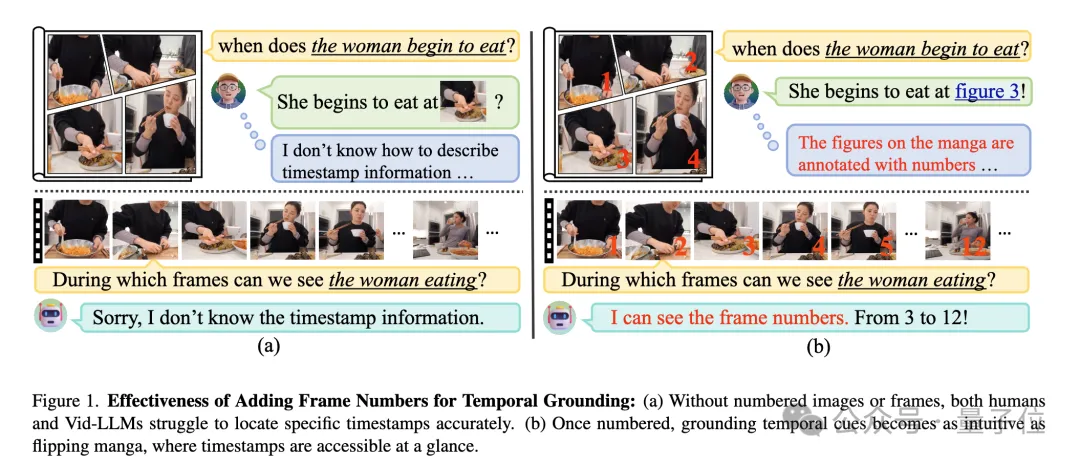

就像漫畫中用編號的畫格引導讀者按順序理解故事,將視覺內容與清晰的時間線聯系起來一樣。

NumPro通過在視頻幀上添加獨特的數字標識符,將視頻時序定位轉化為直觀的“翻閱漫畫”式過程,使Vid-LLMs能夠輕松“讀取”事件時間線,準確關聯視覺內容與相應的時序信息。

實驗中,NumPro顯著提升了視頻時序定位能力,在多個基準上超越此前SOTA,而且還能保持對模型通用視頻理解能力影響較小。

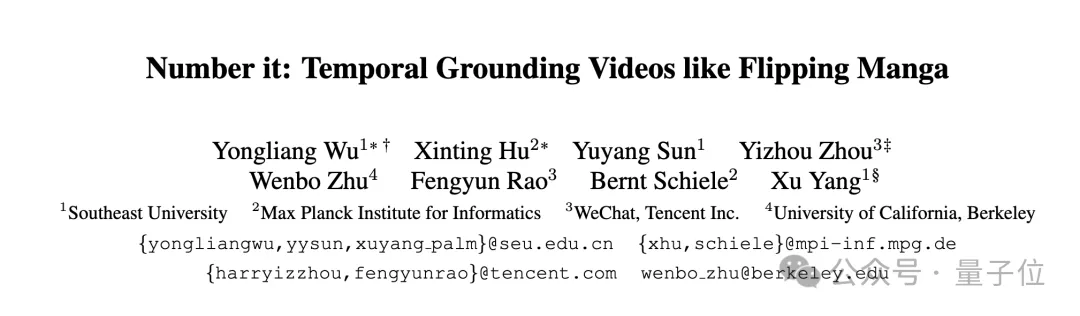

這項工作由來自東南大學、馬克斯·普朗克信息學研究所、騰訊微信團隊、加州大學伯克利分校的研究人員共同完成。

NumPro方法核心創新

視頻大語言模型(Vid-LLMs)在視頻內容理解問答對話方面已取得顯著進展,但在精確的時序定位任務(Video Temporal Grounding, VTG)上仍面臨挑戰。

例如,在實際應用中,識別視頻中事件的發生時刻,如定位廚師添加調料的精確時間,對于現有模型來說頗具難度,這一挑戰阻礙了視頻理解技術在眾多領域的深入應用。

傳統方法在增強模型的VTG能力時,往往需要大量的重新訓練或復雜的模型適配,靈活性和可遷移性受限。

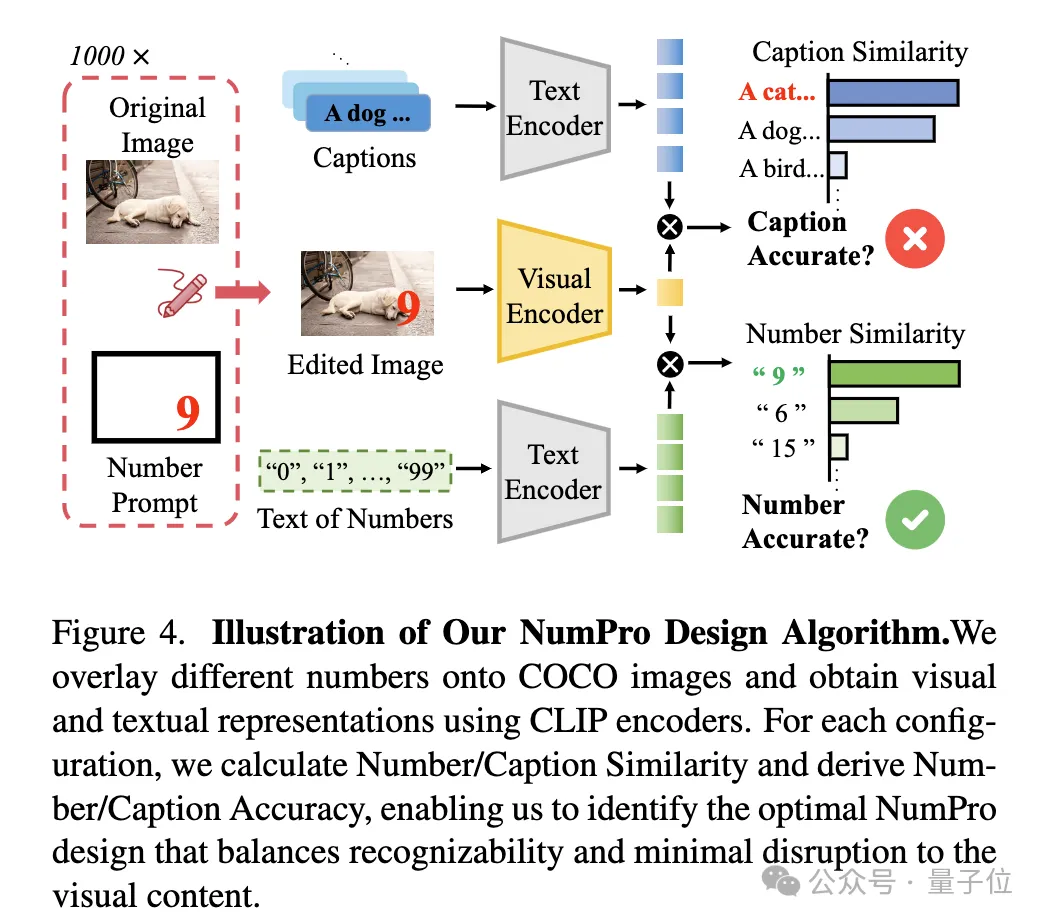

NumPro是如何實現的呢?

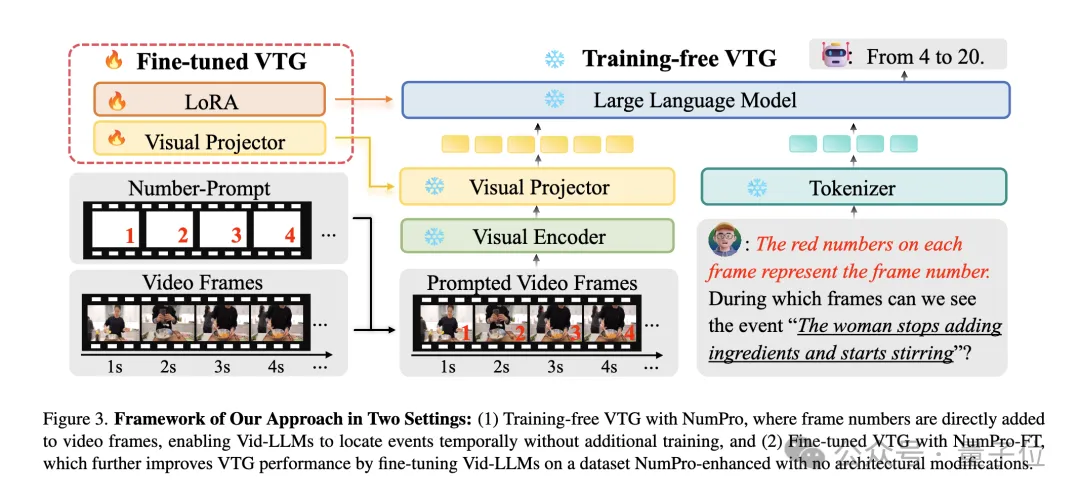

無需訓練設置(Training-Free):

在無訓練設置下,NumPro直接為每個視頻幀標記對應的幀號。

借助Vid-LLMs內置的光學字符識別(OCR)能力,模型能夠通過與視覺內容相關聯的幀號“讀取”時間線。

為明確添加數字的目的,在每個事件查詢前添加簡單指令,告知模型幀號的含義。如此,Vid-LLMs可直接將幀號與語言查詢鏈接,準確識別幀級邊界。

微調優化設置(Fine-tuning Setting):

為進一步提升性能,NumPro-FT在經過了NumPro增強數據集上對Vid-LLMs進行微調。

此過程將幀號與訓練數據中的時間跨度對齊,將時序定位能力嵌入模型的學習表示中。

微調時,凍結視覺編碼器,僅對視覺投影儀和大語言模型(LLM)組件進行優化,并采用低秩適應(LoRA)技術調整LLM,有效減少參數數量和訓練開銷。

為確保NumPro的有效性,研究團隊從字體大小、顏色和位置三個關鍵因素對其進行精心設計優化。

通過基于CLIP的實驗,使用Number Accuracy和Caption Accuracy兩個指標平衡數字的可識別性和對視覺內容的干擾。

最終確定了字體大小為40、顏色為紅色、位置在右下角的最優設計,該設計能最大程度發揮Vid-LLMs的OCR和視覺語言對齊能力,實現精準的視頻時序定位。

實驗成果顯著

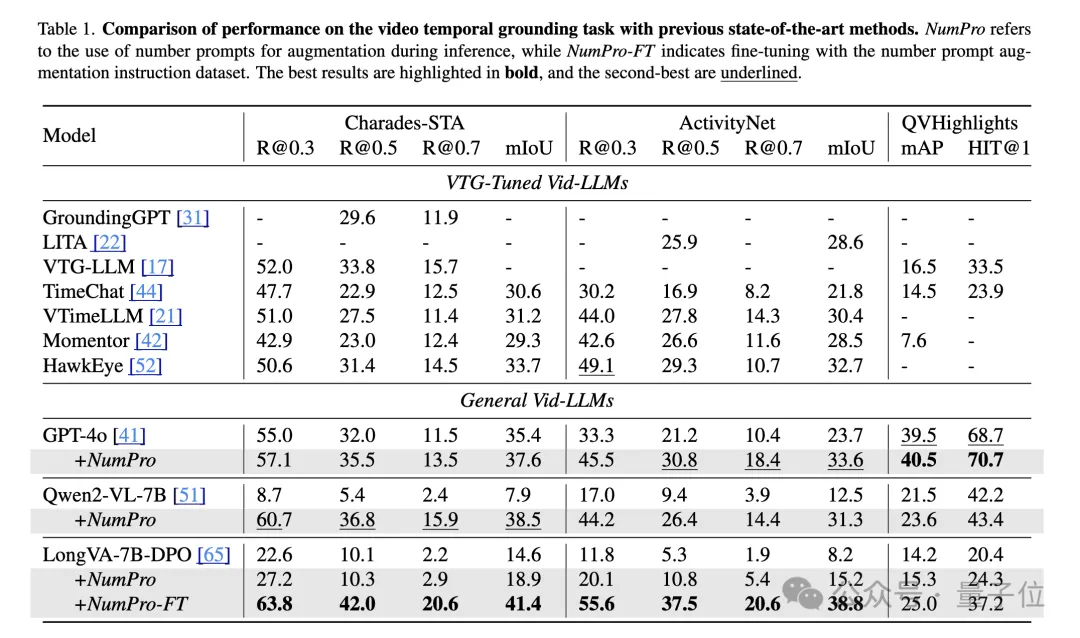

在標準VTG基準測試中,NumPro表現卓越。

在Moment Retrieval任務中,無需訓練的NumPro使Vid-LLMs性能接近或超越以往最優水平。

而經過NumPro-FT微調后,LongVA-7B-DPO在Charades-STA和ActivityNet數據集上的多個指標上均大幅超越現有SOTA,展現出NumPro在提升模型時序定位能力方面的巨大潛力。

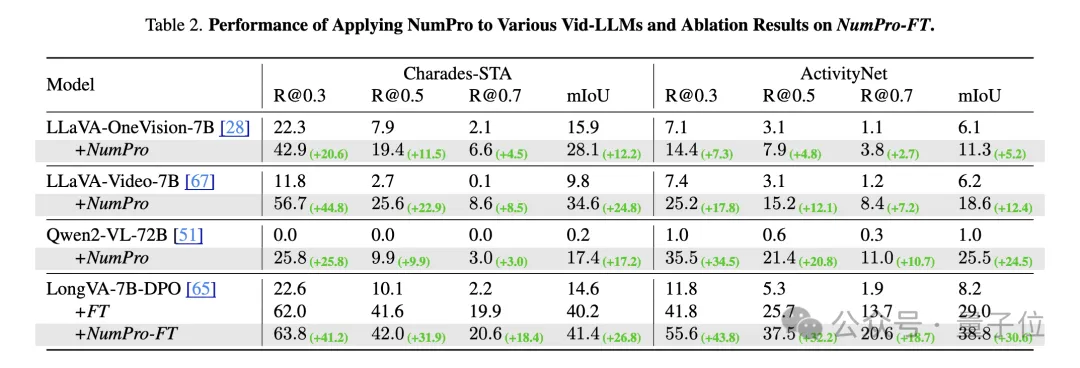

NumPro不僅在領先模型上效果顯著,對多種Vid-LLMs也具有廣泛的適用性。

應用于不同模型如LLaVA-Video-7B、LLaVA-OneVision-7B和Qwen2-VL-72B等,均帶來了顯著的性能提升。此外,在與微調結合時,NumPro-FT始終優于傳統微調方法,尤其在較長視頻數據集上表現出色。

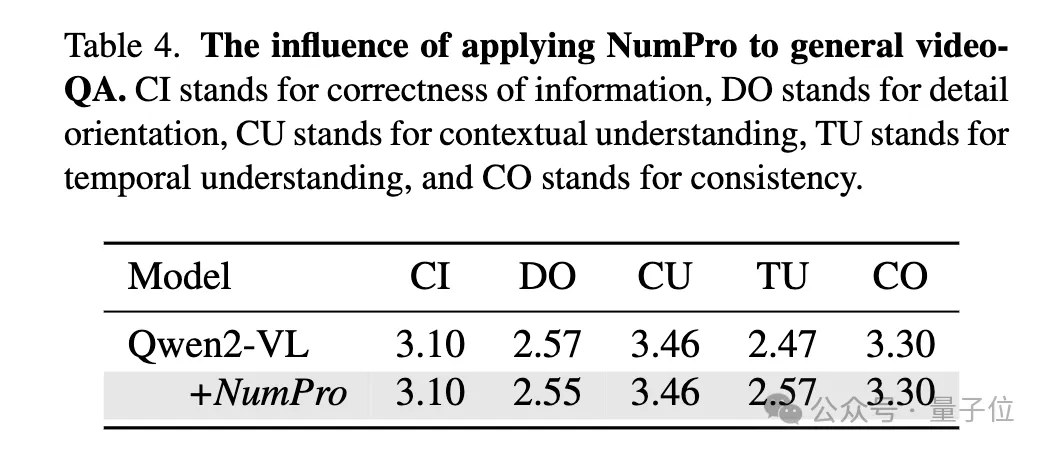

將NumPro集成到通用視頻問答任務(如VideoInstruct基準測試)中,發現其對一般理解指標影響極小,在保持強大通用視頻理解能力的同時,顯著提升了視頻時序定位能力。

論文連接:https://arxiv.org/pdf/2411.10332。

代碼倉庫:https://github.com/yongliang-wu/NumPro。