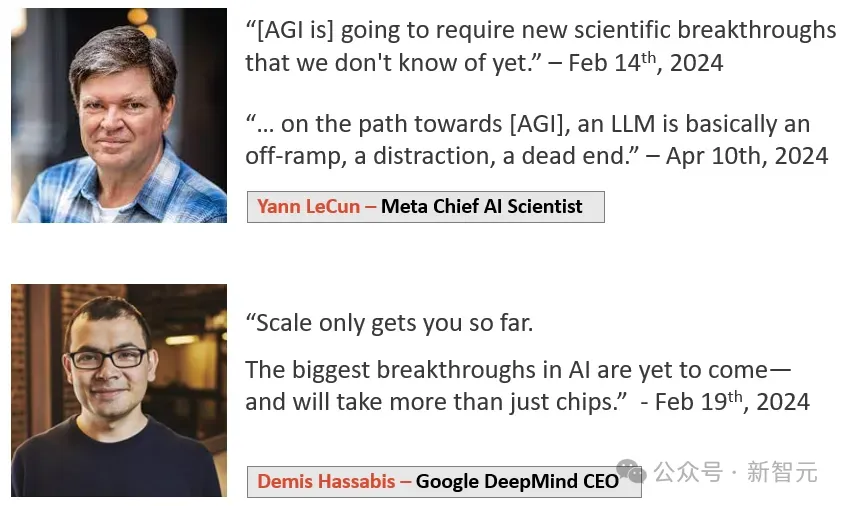

驚天反轉(zhuǎn)!LeCun竟與奧特曼達(dá)成共識(shí):承認(rèn)AGI 5到10年降臨,但LLM注定死路一條

就在剛剛,LeCun反水了!

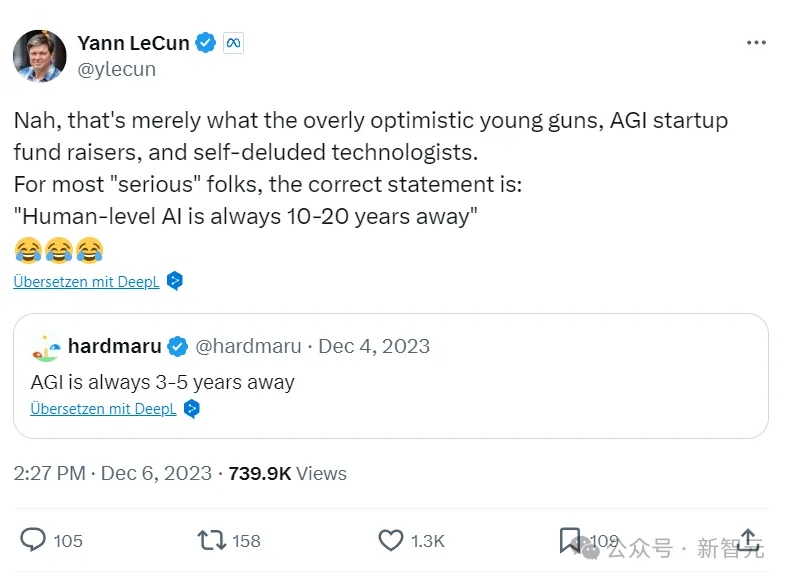

2023年12月,他言之鑿鑿地堅(jiān)稱:人類水平的AI,離我們還有10到20年。

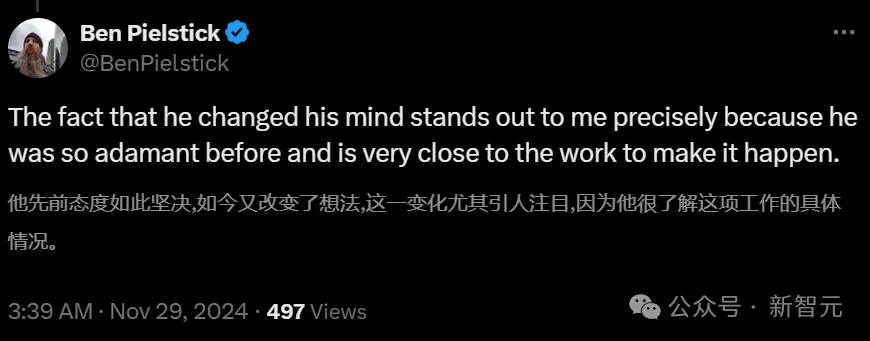

然而就在最近,他忽然改變說法了!

現(xiàn)在,他表示:在5到10年內(nèi),我們就能擁有人類水平的AI了。

主持人追問:我們感覺您之前似乎不喜歡這個(gè)觀點(diǎn)啊,您之前不是說過AGI離我們很遠(yuǎn)很遠(yuǎn)之類的話嗎?

LeCun立馬否決道:不,我不覺得AGI離我們很遠(yuǎn)。

他還強(qiáng)調(diào),自己對AGI何時(shí)到來的預(yù)測,跟Sam Altman、Demis Hassabis這些人也沒什么不同。

總之,AGI在十年內(nèi)大概率要到來,但不太可能是明年或后年。

不過,雖然他改變了對時(shí)間的預(yù)測,但并沒有改變對目前的大語言模型架構(gòu)是死路一條的看法。

他表示,我們不能盲目推斷LLM的能力,斷定只要繼續(xù)scaling,用更大的超算、更多的數(shù)據(jù),AGI就會(huì)涌現(xiàn)。

我們需要的是JEPA之類的全新架構(gòu),從周圍世界進(jìn)行學(xué)習(xí)的系統(tǒng)。這種AI能按重要性計(jì)劃一系列動(dòng)作,而不是像目前的LLM一樣,完全不加思考地在一個(gè)詞后產(chǎn)生另一個(gè)詞。

總之,我們需要的是系統(tǒng)2,而不是系統(tǒng)1。而目前的LLM,僅限于系統(tǒng)1的階段。而LeCun所探討系統(tǒng)「目標(biāo)驅(qū)動(dòng)的人工智能」,就是系統(tǒng)2。

對此,一眾網(wǎng)友都震驚了:他以前不是堅(jiān)定地否決AGI離我們很近這類觀點(diǎn)嗎?

有人解釋道,這大概是因?yàn)榇蠹疫€缺乏對于AGI共識(shí)的定義,因?yàn)閷τ贏GI定義很模糊,所以怎么說都能自圓其說。

其中,下面這條留言最為好笑。

網(wǎng)友表示,估計(jì)有Meta內(nèi)部的人找他談了。說如果想要實(shí)現(xiàn)AGI,就得拉很多很多投資。如果還在講什么AGI遙不可及,我們就沒辦法忽悠更多的投資人了!

AI的核心問題:對世界更好的心智模型

最近,LeCun接受了Nikhil Kamath主持的People by WTF欄目的訪問,討論了關(guān)于AI的諸多問題。

LeCun在巴黎的學(xué)校里學(xué)習(xí)的是EE(電氣工程),但隨著學(xué)習(xí)的深入,他開始對數(shù)學(xué)、物理和AI中更基本的問題更興趣。

在EE的學(xué)習(xí)中,總會(huì)有些課程涉及到計(jì)算機(jī)。在1980年代,LeCun就已經(jīng)和數(shù)學(xué)教授一起做了一些獨(dú)立項(xiàng)目。

現(xiàn)在,LeCun已經(jīng)成為圖靈三巨頭之一。

作為科學(xué)家,他嘗試建立世界的因果模型。

在他看來,幾乎我們面臨的每個(gè)問題,根源就是因?yàn)槿祟愔R(shí)和智慧的不足。我們會(huì)犯錯(cuò),就是因?yàn)椴粔蚵斆鳎瑹o法意識(shí)到存在問題,所以也無法找到解決方案。

LeCun表示,如果我們的智慧更多一點(diǎn),如果我們對于世界如何運(yùn)作有更好的心智模型,我們就不會(huì)像現(xiàn)在這樣犯錯(cuò),而是做出更理性的決策。

而這,也是AI領(lǐng)域的核心問題。

當(dāng)今世界的一個(gè)大問題,就是人們沒興趣去找出事實(shí),也不愿意自教育,但是,AI有可能放大全人類的整體智能,這是解決許多人類問題的關(guān)鍵。

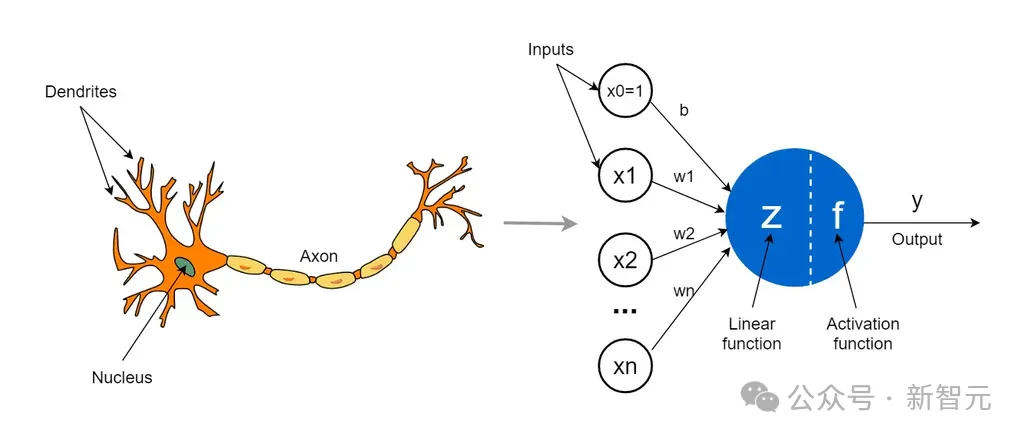

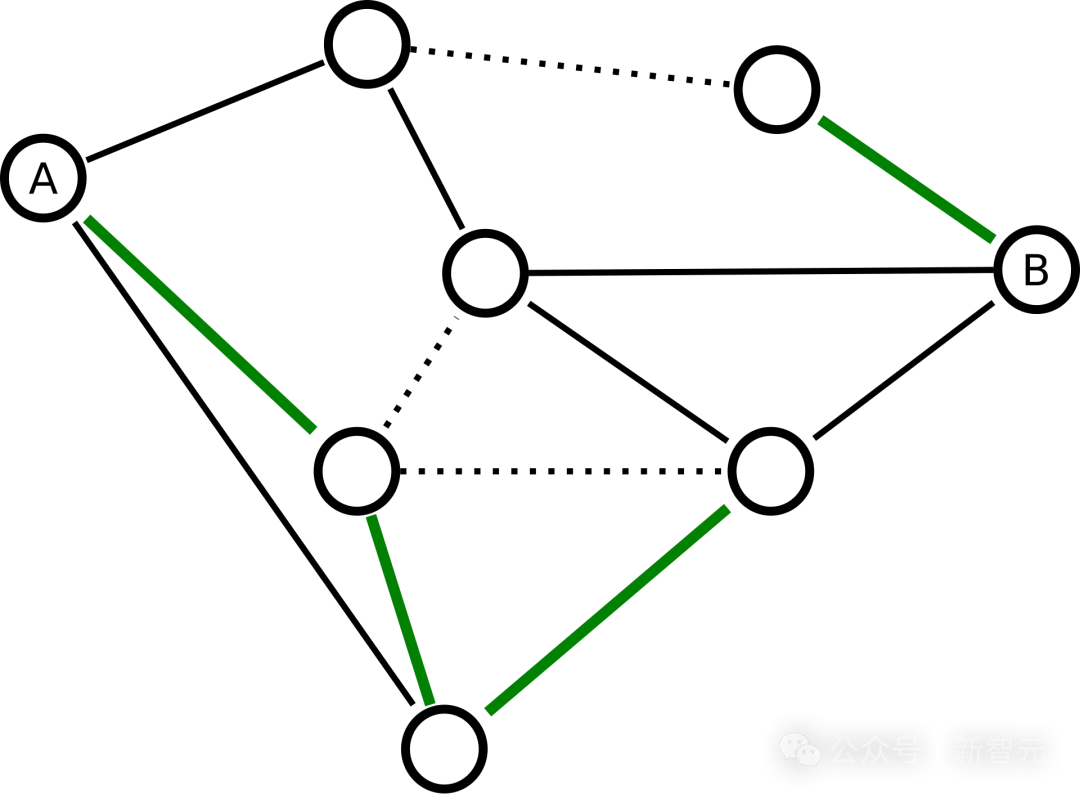

智能是一種由大量簡單元素組成的網(wǎng)絡(luò)相互連接所出現(xiàn)的現(xiàn)象。

在40、50年代,人們開始發(fā)現(xiàn),智能和記憶來自于神經(jīng)元之間連接強(qiáng)度的一種簡化方式。大腦學(xué)習(xí)的方式,是通過修改神經(jīng)元之間的連接強(qiáng)度來實(shí)現(xiàn)的。

因此,有些人提出了理論模型,并且用電子電路將之復(fù)現(xiàn)了。

經(jīng)典計(jì)算機(jī)科學(xué)的出現(xiàn):啟發(fā)式編程

按照解決問題能力和學(xué)習(xí)能力,AI形成了兩個(gè)分支。

后者在50、60年代取得了一些成果,但在60年代后期卻失敗了。因?yàn)楫?dāng)時(shí)設(shè)計(jì)的神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)程序非常有限,不可能用來制造真正智能的機(jī)器。

不過,它在模式識(shí)別的工程領(lǐng)域,卻產(chǎn)生了很大影響。

接下來,他們談到了啟發(fā)式編程。

機(jī)器學(xué)習(xí)最簡單的情況,就是去感知,解釋圖像,解釋聲音,這是經(jīng)典計(jì)算機(jī)科學(xué)出現(xiàn)的原因。

我們編寫一個(gè)程序,這個(gè)程序在內(nèi)部搜索解決方案,并且有一種方式來檢查它提出的方案是否合適,這就是啟發(fā)式編程。

然而,我們無法詳盡無遺地搜索所有可能的方案,來找到一個(gè)最好的解,因?yàn)榻鉀Q方案的數(shù)量大得驚人。

就像在國際象棋中,動(dòng)作序列是一個(gè)指數(shù)級(jí)的增長,以后我們需要啟發(fā)式方法,讓樹搜索或?qū)<褹I來運(yùn)行一個(gè)函數(shù),嘗試達(dá)到最終狀態(tài)。

好的系統(tǒng)和壞的系統(tǒng)的區(qū)別就在于,系統(tǒng)是否足夠聰明,能在不進(jìn)行窮盡搜索的情況下,找到一個(gè)好的解決方案。

這就引出了專家系統(tǒng),或基于世界的系統(tǒng)的AI。它們與搜索的概念密切相關(guān)。

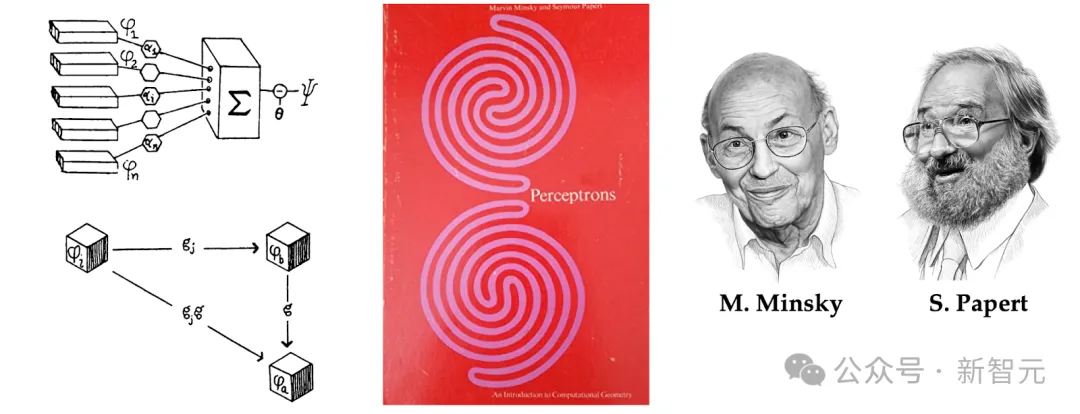

人們提出了一種算法,來改變神經(jīng)元之間連接的強(qiáng)度,使他們能夠?qū)W習(xí)任務(wù),這種類型的第一個(gè)機(jī)器叫做感知機(jī),在1957年被提出來。

MIT教授Marvin Minsky和同校的數(shù)學(xué)家Seymour Papert就合著了一本《感知機(jī)》,這種統(tǒng)計(jì)模型識(shí)別在現(xiàn)實(shí)世界中有巨大的應(yīng)用。

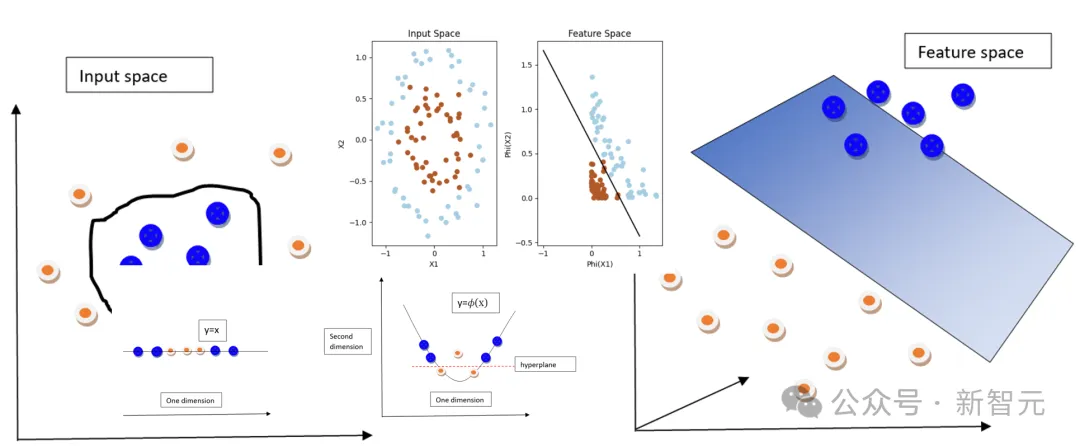

不過,感知機(jī)有個(gè)嚴(yán)重的問題,就是它可訪問的函數(shù)類型非常有限,沒辦法讓我們用一張自然圖片,就能訓(xùn)練系統(tǒng)判斷其中是否有狗、貓或者桌子。

系統(tǒng)不夠強(qiáng)大,無法真正計(jì)算這種復(fù)雜的函數(shù)。

強(qiáng)化學(xué)習(xí)與自監(jiān)督學(xué)習(xí)

在80年代,神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)改變了這一切。實(shí)際上,神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)的祖先,深度學(xué)習(xí)可以看作它的新名字。

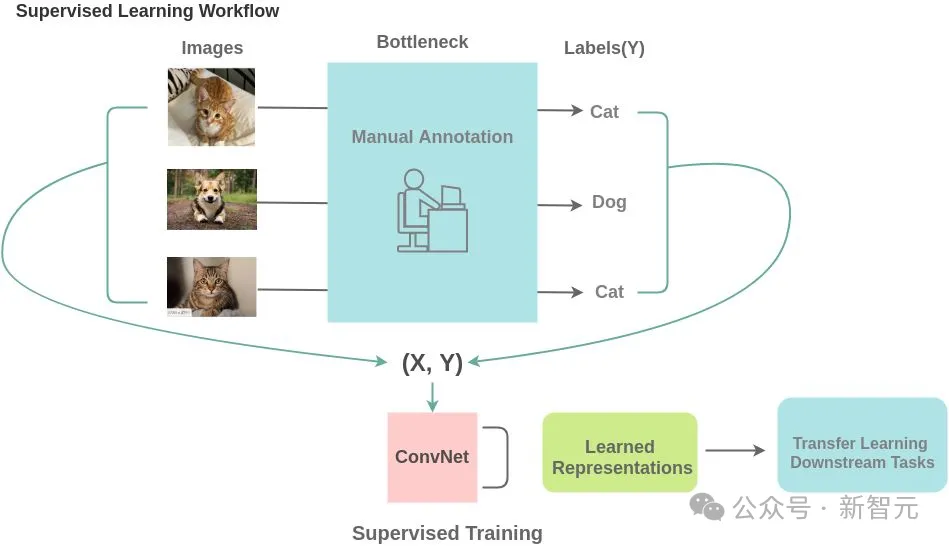

我們的想法是,不是完全編程讓機(jī)器去做某事,而是通過數(shù)據(jù)對其進(jìn)行訓(xùn)練。

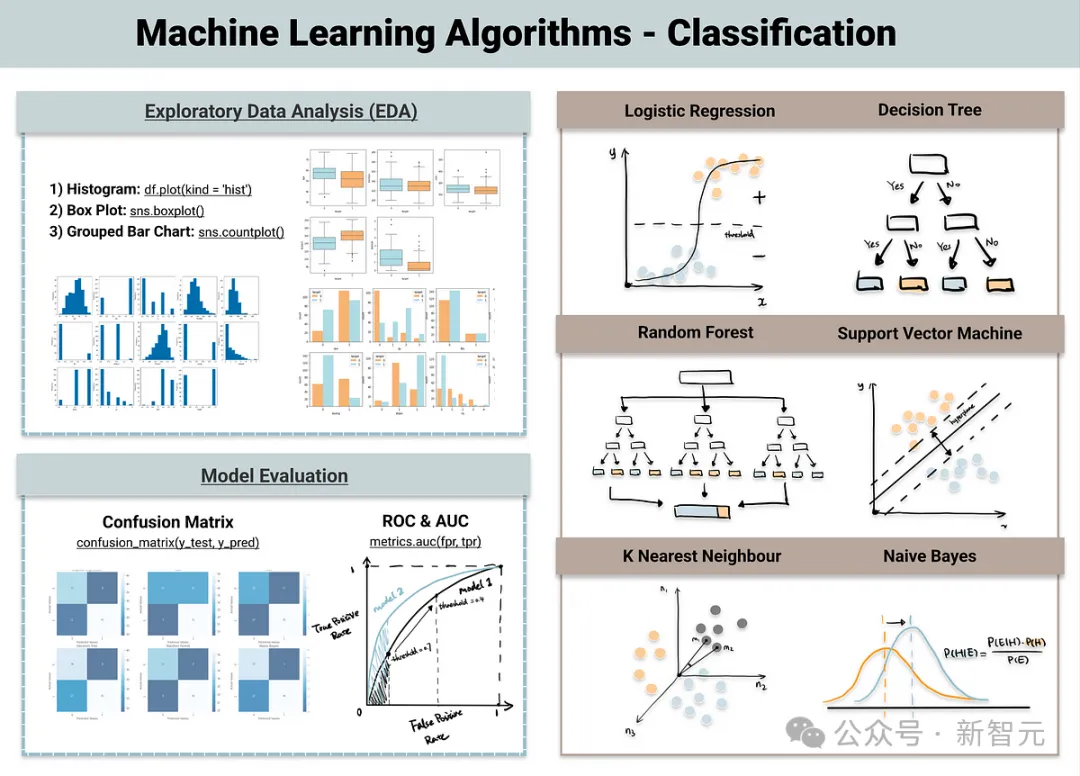

在機(jī)器學(xué)習(xí)中,有線性回歸,分類樹,支持向量機(jī)、核方法、貝葉斯推理等等。

在某種程度上,它們都遵循這樣的模型:我們構(gòu)建了一個(gè)程序,但它實(shí)際上還沒有完成。它有一堆可調(diào)參數(shù),輸入輸出函數(shù)由這些參數(shù)的值決定。

因此,我們使用迭代調(diào)整技術(shù)從數(shù)據(jù)中訓(xùn)練系統(tǒng)。如果示例答案不正確,就調(diào)整參數(shù),使其更接近我們想要的答案。

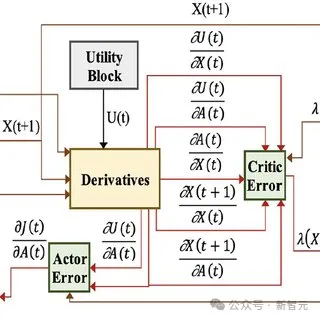

在強(qiáng)化學(xué)習(xí)中,我們不直接告知系統(tǒng)正確答案。只是告訴它所產(chǎn)生的答案好壞與否。

而過去五六年非常突出的自監(jiān)督學(xué)習(xí),已經(jīng)真正成為讓聊天機(jī)器人和自然語言理解系統(tǒng)成功的主要因素。

它更類似于監(jiān)督學(xué)習(xí),但不同之處在于不需要有一個(gè)明確的輸入和輸出,并訓(xùn)練系統(tǒng)從輸入生成輸出。

唯一的區(qū)別并不在于算法本身,而是體現(xiàn)在系統(tǒng)的結(jié)構(gòu)和數(shù)據(jù)的使用及生成方式上。

我們不需要有人逐一檢查數(shù)百萬張圖片,告訴它這是貓還是狗在桌子旁邊。我們只需展示一張狗、貓或桌子的照片,并對其進(jìn)行破壞,部分改變它,然后要求系統(tǒng)從損壞的圖像中恢復(fù)原始圖像。

這就是自監(jiān)督學(xué)習(xí)的一種特定形式。

而這,對于自然語言理解的成功起到了關(guān)鍵作用。

比如,在大語言模型中,我們訓(xùn)練一個(gè)系統(tǒng)來預(yù)測下一個(gè)詞,但是只允許它查看前面的詞語。這就需要以一種特定的方式構(gòu)建神經(jīng)網(wǎng)絡(luò),使得用于預(yù)測一個(gè)詞的連接只能看到前邊的詞,這樣就不必對輸入進(jìn)行干擾了。

最終,系統(tǒng)被訓(xùn)練成從內(nèi)容中預(yù)測出接下來的單詞。

在Transformer架構(gòu)下,基本原理就是將每個(gè)輸入與其他輸入進(jìn)行比較,并生成權(quán)重。

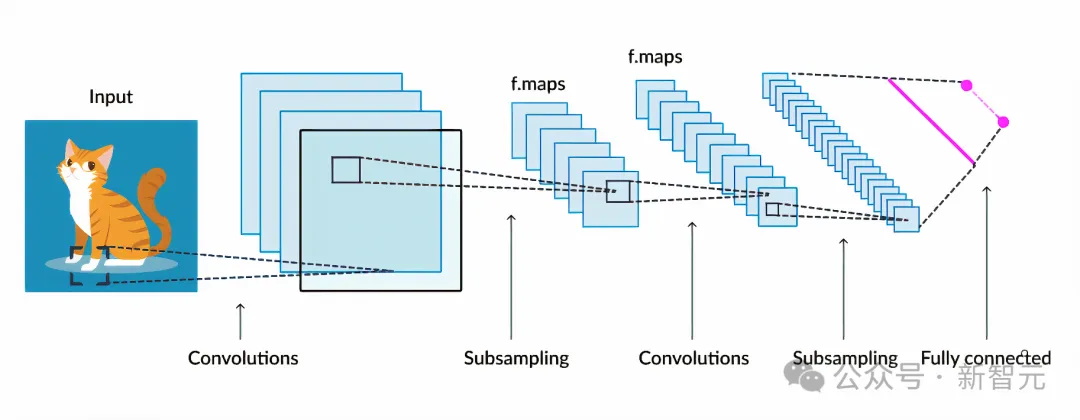

反向傳播算法與卷積神經(jīng)網(wǎng)絡(luò)

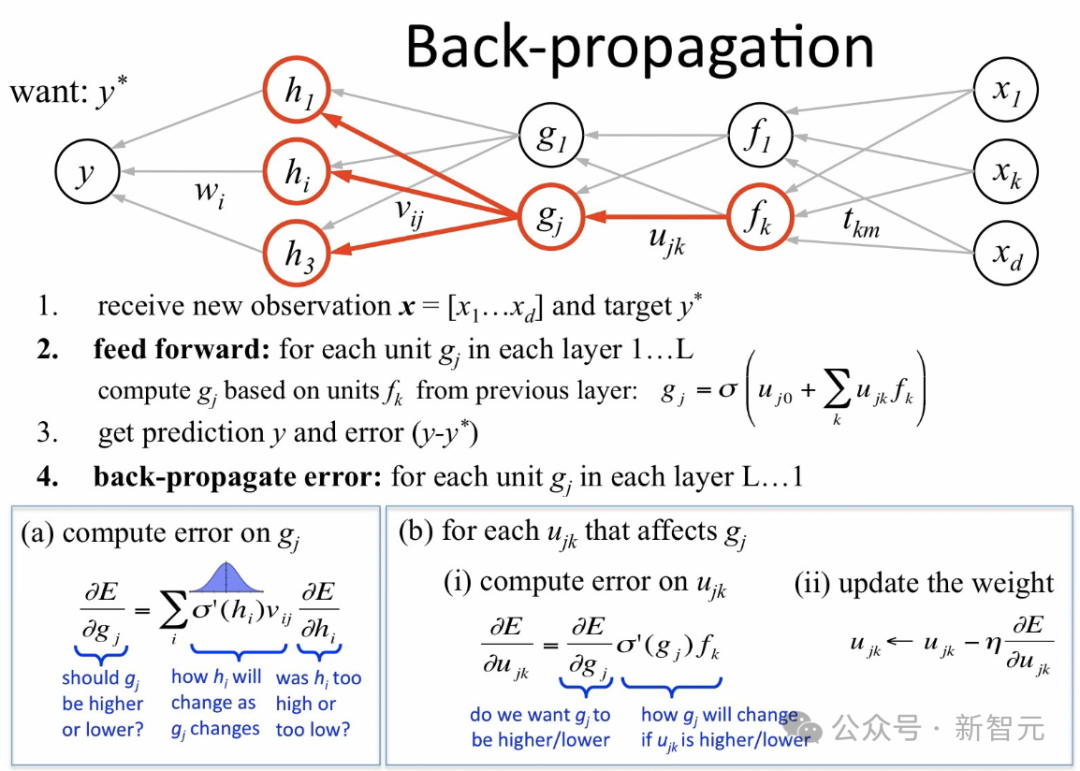

而反向傳播算法的作用,就是在我們展示一張C的圖像,并告訴系統(tǒng)這是C時(shí),它能激活相應(yīng)的輸出神經(jīng)元,而不激活其他神經(jīng)元。

它知道如何調(diào)整參數(shù),使得輸出更接近我們想要的結(jié)果。這是通過向后傳播信號(hào)來實(shí)現(xiàn)的,基本上可以說是確定每個(gè)權(quán)重對每個(gè)輸出的敏感度,從而改變權(quán)重,讓好的輸出增加,壞的輸出減少。

其實(shí),反向傳播算法之前就存在,但當(dāng)時(shí)人們沒有意識(shí)到它可以用于機(jī)器學(xué)習(xí),后來它從20世紀(jì)80年代開始風(fēng)靡。

反向傳播算法至關(guān)重要,因?yàn)樗蚱屏薓insky和Papert在20世紀(jì)60年代所說的感知機(jī)的限制,因此掀起了一股巨大的浪潮。

但人們后來意識(shí)到:訓(xùn)練這些神經(jīng)網(wǎng)絡(luò)需要大量的數(shù)據(jù)。

那時(shí)候還沒有互聯(lián)網(wǎng),數(shù)據(jù)并不豐富,計(jì)算機(jī)速度也不快,因而人們對此興趣減弱。

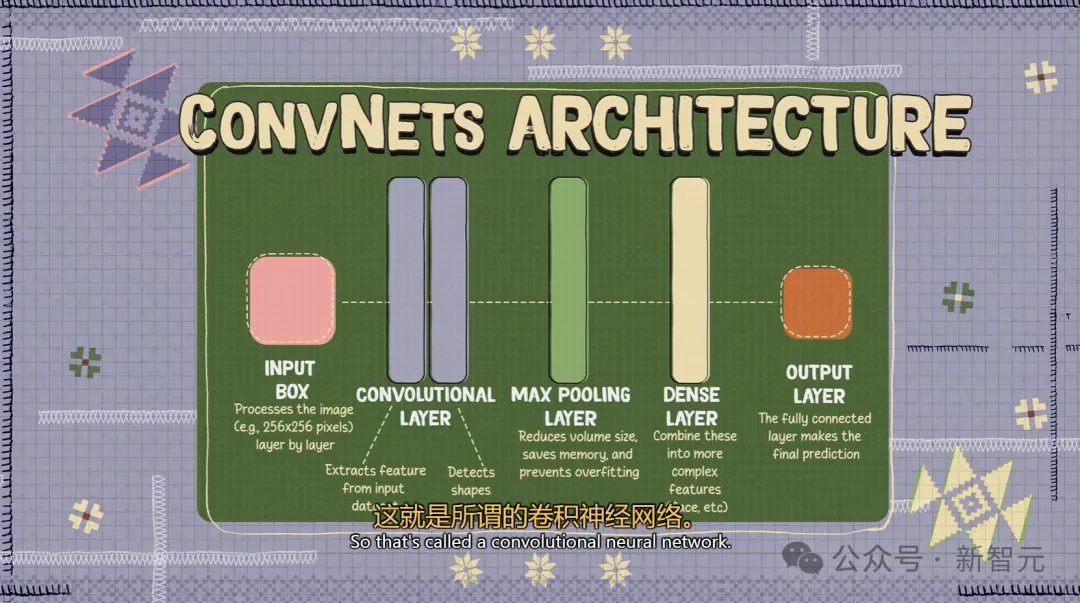

但是在80年代末、90年代初,LeCun研究的一個(gè)項(xiàng)目是,如果想讓這種系統(tǒng)識(shí)別圖像,就需要以某種特定的方式連接神經(jīng)元來促進(jìn)系統(tǒng)的關(guān)注。

他從生物學(xué)中獲得了靈感,借鑒了可以追溯到20世紀(jì)60年代的經(jīng)典神經(jīng)科學(xué)研究,以分層的方式來組織神經(jīng)元之間的連接,使它們傾向于找到良好的圖像識(shí)別解決方案。

這就是所謂的卷積神經(jīng)網(wǎng)絡(luò)。

它的設(shè)計(jì)靈感,來源于視覺皮層的架構(gòu)。

卷積神經(jīng)網(wǎng)絡(luò)特別適合處理來自自然世界的數(shù)據(jù),如果我們拍一張照片,并取其中兩個(gè)相鄰的像素點(diǎn),它們很可能具有相同的顏色或相同的強(qiáng)度。

像圖像和音頻這樣的自然數(shù)據(jù),以及幾乎所有類型的自然信號(hào)都有其內(nèi)在的結(jié)構(gòu)。如我們以特定方式構(gòu)建神經(jīng)網(wǎng)絡(luò)來利用這種結(jié)構(gòu),它將學(xué)得更快,并且只需較少樣本即可學(xué)習(xí)。

卷積是卷積神經(jīng)網(wǎng)絡(luò)中的一個(gè)組件。

它的思想是,一個(gè)神經(jīng)元查看輸入的一部分,另一個(gè)神經(jīng)元查看輸入的另一部分,但它計(jì)算與第一個(gè)神經(jīng)元相同的函數(shù)。

接著將這個(gè)相同的神經(jīng)元復(fù)制到輸入的所有位置上,這樣我們就可以把每個(gè)神經(jīng)元看作是在檢測輸入某一部分的一個(gè)特定模式,并且所有神經(jīng)元在輸入的不同部位都檢測同一個(gè)模式。

所以現(xiàn)在如果你取一個(gè)輸入并將其移動(dòng),就會(huì)得到同樣的輸出,但位置不同,因?yàn)橄嗤纳窠?jīng)元會(huì)查看,并在不同的位置上檢測到相同模式。

這就是為什么它會(huì)給你這種位移等變性,也就是所謂卷積。

它們之于真正的神經(jīng)元,就如同飛機(jī)的機(jī)翼之于鳥類的翅膀——功能相同,具有同樣的概念。

AI捕捉到了語法的機(jī)器學(xué)習(xí)機(jī)制

香農(nóng)的n-game模型,是一個(gè)語言模型。

我們可以在字符級(jí)別這樣做,但是在單詞級(jí)別這樣做,就會(huì)更困難,因?yàn)榭赡苡幸蝗f個(gè)可能的單詞。

我們需要在通過在一個(gè)大型文本語料庫上訓(xùn)練,來填充這個(gè)概率表,從而訓(xùn)練一個(gè)詞模型或語言模型。

但是在某個(gè)上下文長度以上,就變得不切實(shí)際了。因?yàn)樾枰罅康挠?jì)算和工作量,還涉及到存儲(chǔ)所有這些表格的記憶,另外這些表格的填充也會(huì)非常稀疏,因?yàn)榧词褂袛?shù)十億個(gè)詞的文本,大多數(shù)詞組組合都是不會(huì)出現(xiàn)的。

而如果采用Transformer這類架構(gòu)的話,就能構(gòu)建起一個(gè)系統(tǒng),使其能夠根據(jù)上下文中的詞語預(yù)測下一個(gè)詞。

如果讓這個(gè)上下文盡可能大,比如幾千個(gè)、幾萬個(gè)甚至一百萬個(gè)詞,那么就會(huì)得到具有涌現(xiàn)特性的系統(tǒng)。如果把它們做得足夠大,可能能達(dá)到數(shù)十億或數(shù)百億個(gè)參數(shù)。

在這種情況下,如果是文本的話,它們會(huì)復(fù)述解謎的答案,會(huì)給出你可能需要的問題答案。

這個(gè)過程中主要是檢索,有一點(diǎn)點(diǎn)推理,但不多。

人們真正感到驚訝的,是這些系統(tǒng)能以令人印象深刻的方式操縱語言。

要知道,人類在操縱語言方面其實(shí)相當(dāng)有限,但AI似乎做得很好——它們捕捉到了語法的機(jī)器學(xué)習(xí)機(jī)制。

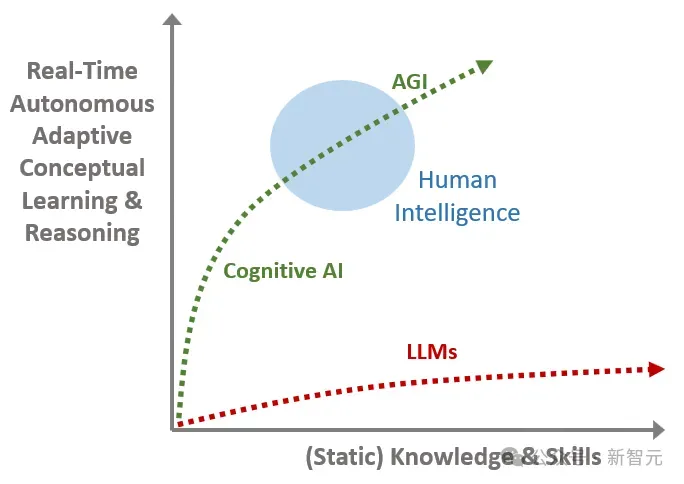

大語言模型,并不是通往AGI的路徑

在語言中,可能性有限的情況下,我們的確可以輸出一個(gè)概率列表。

但如果想預(yù)測視頻中會(huì)發(fā)生什么,幀數(shù)卻是無限的。一張圖像有一千個(gè)像素,像素顏色有三個(gè)值,因此需要生成三百萬個(gè)值,但我們還不知道如何表示所有可能的圖像集的概率分布。

這是我們很多人認(rèn)為AI領(lǐng)域下一個(gè)挑戰(zhàn)的地方。

如果說從視頻和圖片中學(xué)習(xí),這將是下一階段,那么它應(yīng)該放在哪里?它屬于大語言模型現(xiàn)在的范疇嗎?

不,它與大語言模型完全不同。這也是為什么LeCun一直明確表示,大語言模型并不是通往人類級(jí)別智能的路徑。

這也是為什么大語言模型無法理解物理世界,并且不能以目前的形式真正理解和應(yīng)對現(xiàn)實(shí)世界的原因。

盡管LLM在處理語言方面表現(xiàn)出色,但它們也會(huì)犯非常愚蠢的錯(cuò)誤,這表明其實(shí)它們并不理解世界是如何運(yùn)作的。

我們沒有真正理解基本事物的系統(tǒng),而這些是你的貓都能理解的事。

所以LeCun一直直言不諱地說,最聰明的LLM也并不比你家里貓更聰明。

JEPA:LeCun心中的「世界模型」

由此,也就引出了AI領(lǐng)域的下一個(gè)挑戰(zhàn)——如何構(gòu)建能夠通過視頻學(xué)習(xí)世界運(yùn)行規(guī)律的系統(tǒng)。

人類對于周遭世界的認(rèn)識(shí),特別是在生命的早期,很大程度上是通過「觀察」獲得的。

就拿牛頓的「運(yùn)動(dòng)第三定律」來說,即便是嬰兒,或者貓,在多次把東西從桌上推下并觀察結(jié)果,也能自然而然地領(lǐng)悟到:凡是在高處的任何物體,終將掉落。

這種認(rèn)識(shí),并不需要經(jīng)過長時(shí)間的指導(dǎo),或閱讀海量的書籍就能得出。

相比之下,如今的LLM只適用于離散的語言世界,而無法理解連續(xù)高維的物理世界,例如視頻中的動(dòng)態(tài)。

這種局限性使LLM難以應(yīng)對現(xiàn)實(shí)世界的問題,也就是為什么LLM能通過考試寫文章,但我們還沒有家用機(jī)器人和L5自動(dòng)駕駛。

目前,LLM的記憶分為兩種:

1. 參數(shù)記憶:在訓(xùn)練過程中學(xué)到的知識(shí),但無法逐字復(fù)述訓(xùn)練數(shù)據(jù)。

2. 上下文記憶:通過輸入提示詞暫時(shí)存儲(chǔ)信息,但范圍有限。

然而,真正理解物理世界的AI需要持久記憶,類似于人類大腦中的海馬體,能夠存儲(chǔ)和檢索長期信息。但目前的LLM缺乏獨(dú)立的記憶模塊,無法高效搜索和評(píng)估多種可能的答案。

為了實(shí)現(xiàn)這一目標(biāo),我們需要新的架構(gòu),擺脫LLM的自回歸方法,轉(zhuǎn)而適用于視頻的自監(jiān)督學(xué)習(xí)。

具體方法是讓AI通過預(yù)測視頻中接下來的變化來理解世界的底層結(jié)構(gòu),而不是簡單地生成每個(gè)像素的變化。

這種預(yù)測能力可以幫助AI構(gòu)建「世界模型」,從而支持規(guī)劃和推理。例如,預(yù)測推杯子、抓取、提起等動(dòng)作的結(jié)果是否能實(shí)現(xiàn)目標(biāo)。

回到如何讓機(jī)器通過觀察世界來學(xué)習(xí)這個(gè)問題上。很顯然,我們不能靠著現(xiàn)在這種僅僅生成視頻中每個(gè)像素的生成式架構(gòu)。

為此,LeCun的團(tuán)隊(duì)嘗試了近15年的時(shí)間,并在5年前提出了一種全新的方法——JEPA(聯(lián)合嵌入預(yù)測架構(gòu))。

一直以來,LeCun堅(jiān)信世界有一種「世界模型」,并著力開發(fā)一種新的類似大腦的AI架構(gòu),目的是通過更真實(shí)地模擬現(xiàn)實(shí)世界來解決當(dāng)前系統(tǒng)的局限性,例如幻覺和邏輯上的缺陷。

這也是想要AI接近人類智力水平,需要像嬰兒一樣學(xué)習(xí)世界運(yùn)作的方式。

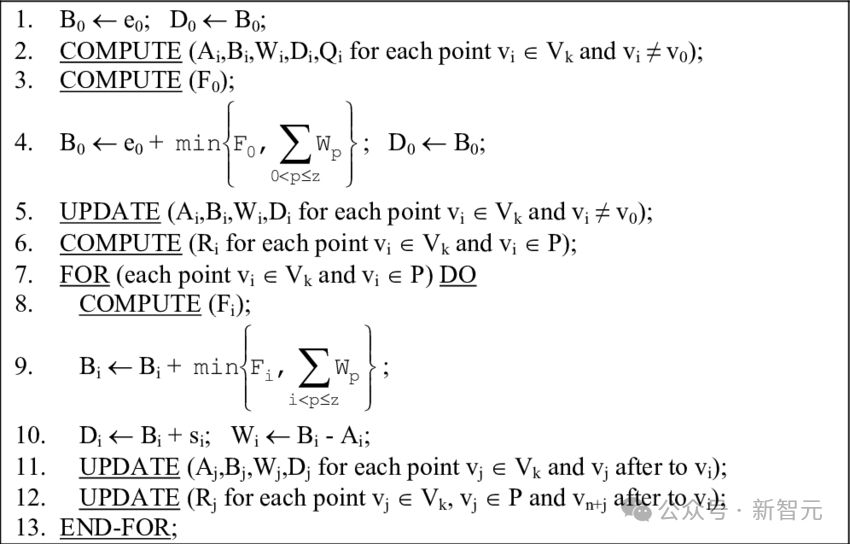

這個(gè)世界模型的架構(gòu),由6個(gè)獨(dú)立的模塊組成:配置器模塊、感知模塊、世界模型模塊、成本模塊、短期記憶模塊,以及參與者模塊。

其中,核心是世界模型模塊,旨在根據(jù)來自感知模塊的信息預(yù)測世界。能夠感知人在向哪移動(dòng)?汽車是轉(zhuǎn)彎還是繼續(xù)直行?

另外,世界模型必須學(xué)習(xí)世界的抽象表示,保留重要的細(xì)節(jié),并忽略不重要的細(xì)節(jié)。然后,它必須在與任務(wù)水平相適應(yīng)的抽象級(jí)別上提供預(yù)測。

自2022年LeCun首提JEPA之后,I-JEPA和V-JEPA分別基于圖像、視頻擁有強(qiáng)大的預(yù)測能力。

值得一提的是,V-JEPA的發(fā)布正好是OpenAI推出Sora模型的當(dāng)天。

論文地址:https://ai.meta.com/research/publications/revisiting-feature-prediction-for-learning-visual-representations-from-video/

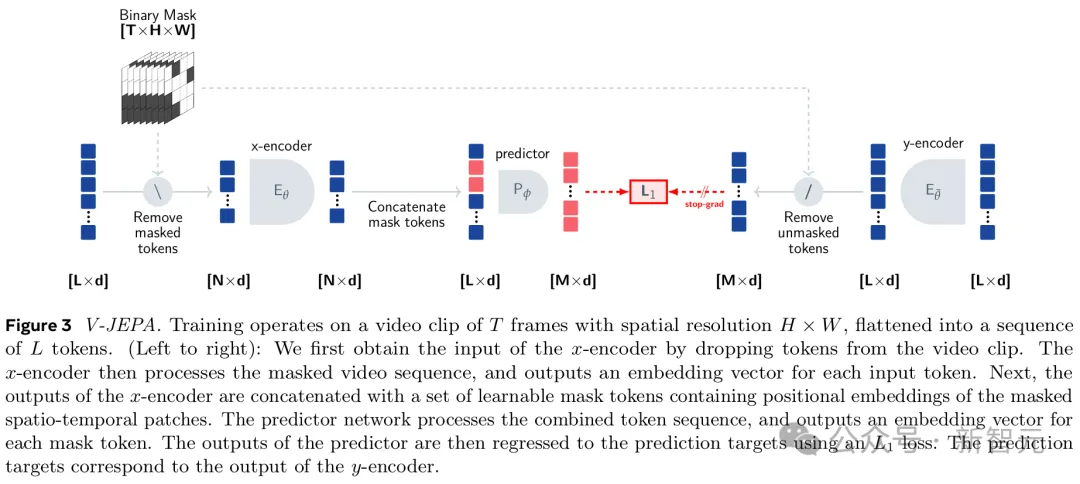

與生成式AI模型完全不同,V-JEPA是一種「非生成式模型」。它通過預(yù)測視頻中被隱藏或缺失部分,在一種抽象空間的表示來進(jìn)行學(xué)習(xí)。

這與圖像聯(lián)合嵌入預(yù)測架構(gòu)(I-JEPA)類似,后者通過比較圖像的抽象表示進(jìn)行學(xué)習(xí),而不是直接比較「像素」。

不同于那些嘗試重建每一個(gè)缺失像素的生成式方法,V-JEPA能夠舍棄那些難以預(yù)測的信息,這種做法使得在訓(xùn)練和樣本效率上實(shí)現(xiàn)了1.5-6倍的提升。

由于采用了自監(jiān)督的學(xué)習(xí)方式,V-JEPA可以完全依靠未標(biāo)注的數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練,然后再通過標(biāo)注數(shù)據(jù)進(jìn)行微調(diào)即可。

在看到下面視頻中的動(dòng)作時(shí),V-JEPA會(huì)說「將紙撕成兩半」。

再比如,翻看筆記本的視頻被遮擋了一部分,V-JEPA便能夠?qū)P記本上的內(nèi)容做出不同的預(yù)測。

這些,是V-JEPA在觀看200萬個(gè)視頻后,就獲取到的超能力。

總結(jié)來說,現(xiàn)有的大語言模型屬于系統(tǒng)一思維,即快速、直覺性的反應(yīng)。而AGI需要的是系統(tǒng)二思維:深度思考、理性分析和戰(zhàn)略規(guī)劃。

對此,LeCun提出的「目標(biāo)驅(qū)動(dòng)人工智能」架構(gòu)正是基于系統(tǒng)二思維,也就是說,它能夠從真實(shí)世界中學(xué)習(xí)并且可以進(jìn)行分層規(guī)劃。