“云計算一哥”一口氣發布六個大模型、3nm芯片!多模態還要搞Any-to-Any

就在剛剛,云計算一哥亞馬遜云科技,在大模型這件事兒上搞了波大的——

亞馬遜CEO Andy Jassy親自站臺re:Invent24,發布自家新款AI多模態系列大模型,名曰Amazon Nova。

而且是一口氣涵蓋文本對話、圖片生成、視頻生成,甚至直接吐露一個小目標:

將來我們不僅要Speech to Speech,更要Any-to-Any!

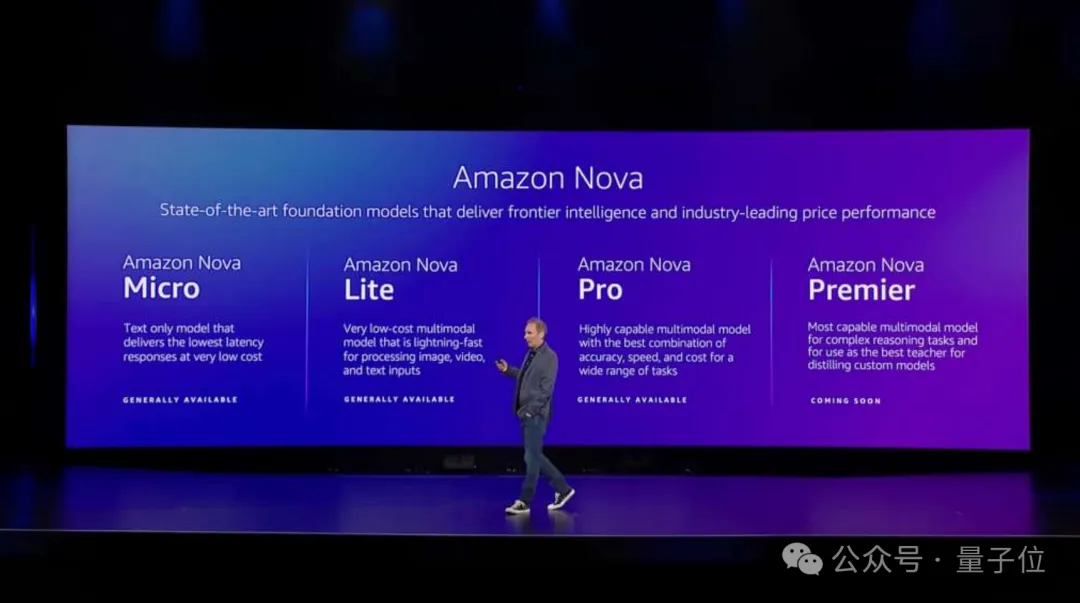

整體而言,Amazon Nova系列中的所有模型,均以功能和尺寸來劃分。

先來看下新版尖端基礎大模型的“文本對話篇”,一共包含四個杯型:

- Amazon Nova Micro:僅限文本對話,主打一個低價格和低延遲;

- Amazon Nova Lite:低成本的多模態大模型,處理圖像、視頻和文本輸入的速度極快。

- Amazon Nova Pro:高性能的多模態大模型,精度、速度和成本最佳“配方”,可處理廣泛的任務。

- Amazon Nova Premier:亞馬遜最強多模態大模型,可處理復雜的推理任務,也可用于蒸餾客戶定制化的模型。

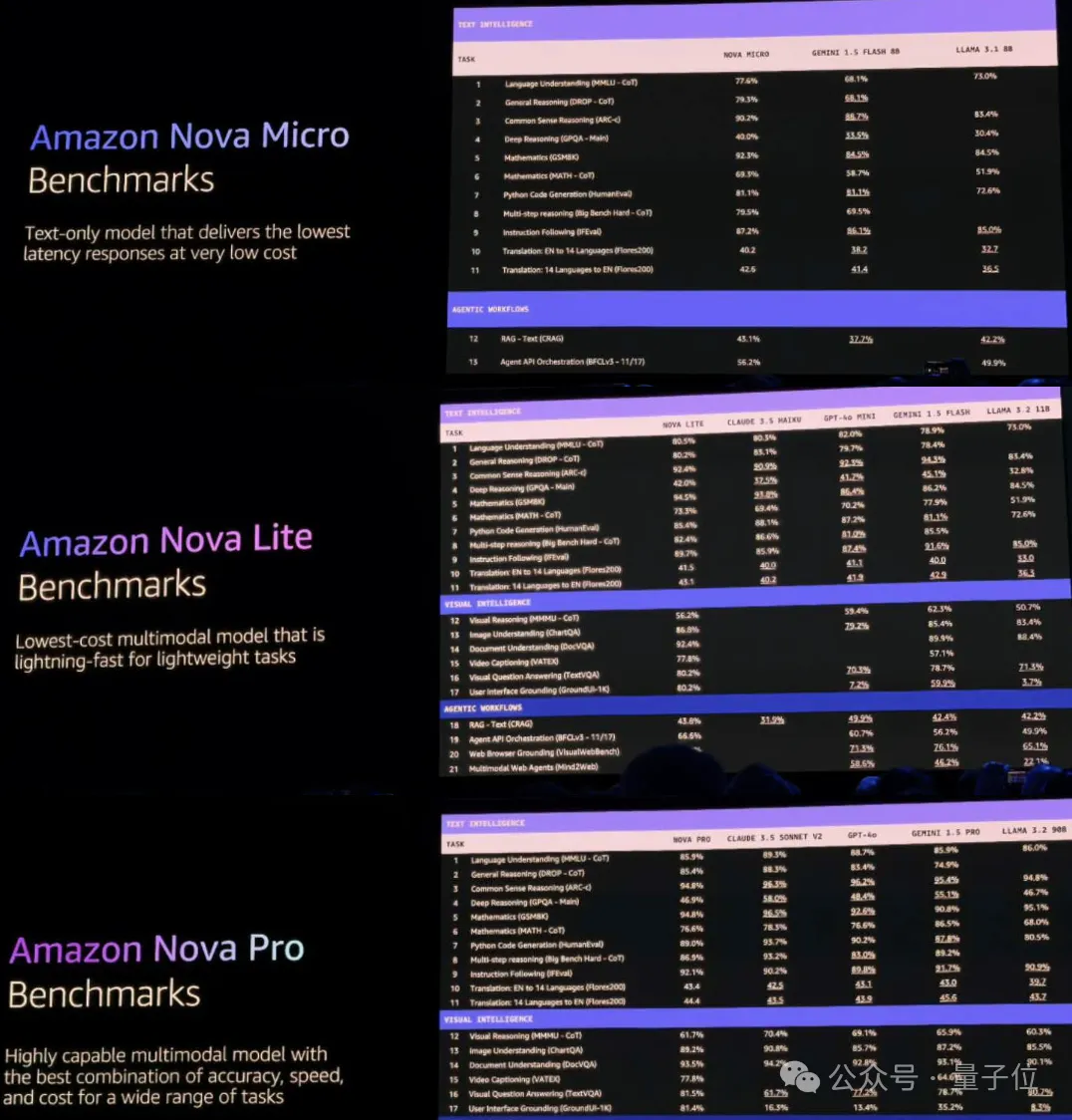

在現場,Andy也曬出了Amazon Nova在CRAG、BFCL、VisualWebBench和Mind2Web等Benchmarks上取得的分數。

從成績中不難看出,其在檢索增強生成(RAG)、函數調用和智能體應用方面具有較好的性能。

據悉,前三者已經上架亞馬遜云科技的“模型工廠”Amazon Bedrock,而Premier版本則將于2025年第一季度推出。

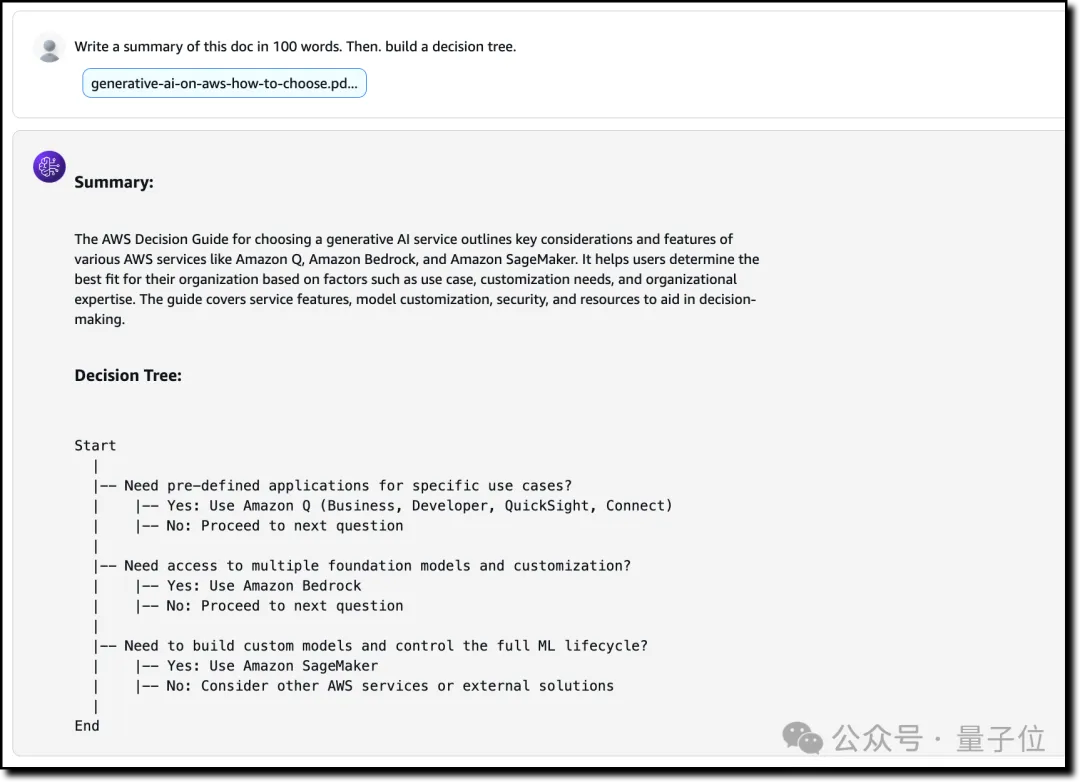

目前也有一些實測已經流出,例如給Amazon Nova Pro一句Prompt:

Write a summary of this doc in 100 words. Then, build a decision tree.

寫一篇100字的摘要。然后,構建一個決策樹。

啪的一下,結果就出來了:

它給出的答案是:

The video begins with a view of a rocky shore on the ocean, and then transitions to a close-up of a large seashell resting on a sandy beach.

視頻一開始是海洋上的巖石海岸,然后過渡到一個大貝殼躺在沙灘上的特寫。

接下來,就是“非文本生成篇”,一共包括兩款。

Amazon Nova Canvas,主打的是圖像生成,用官方的話來說,是達到了“State-of-the-art”(最先進)的水平:

至于視頻生成模型,名叫Amazon Nova Reel,給定一張圖片和一句話,即可讓它動起來:

而接下來Andy的一番話,直接讓現場不淡定了。

正如我們剛才提到的,Andy已經放出了話,Amazon Nova即將呈現出來的態勢是萬物皆可生成。

值得細細品味的一點是,亞馬遜云科技在生成式AI時代中,先前發布自研大模型并不算最吸睛的那一批。

雖然此前也發布過Amazon Titan大模型,但模態上也僅限于文本,更多的精力還是聚焦在了像Amazon Bedrock、Amazon Q這樣的平臺和應用。

而這次,亞馬遜云科技卻一反常態,以厚積薄發之勢把主流模態全面覆蓋,甚至一句“Any-to-Any”彰顯其雄心。

為何會如此?

縱觀整場發布會,透過亞馬遜云科技CEO Matt Garman的全程介紹,或許可以把答案總結為——

實力是一直有的,只是現在客戶有需求了。

△Matt Garman首次以CEO身份參加re:Invent

△Matt Garman首次以CEO身份參加re:Invent

這又該如何理解?我們繼續往下看。

算力再升級,價格很美麗

先看實力。

作為云計算一哥,算力是亞馬遜云科技的看家本領之一。

與傳統云服務廠商不同,其自主研發并優化的專用芯片和數據中心,包括Graviton和Nitro等專有服務器主機,為實時計算提供支持。

而這一次,從芯片到服務器,基礎設施上一系列的更新動作,可以分為三大板塊來看——

計算(Compute)、存儲(Storage)和數據庫(Database)。

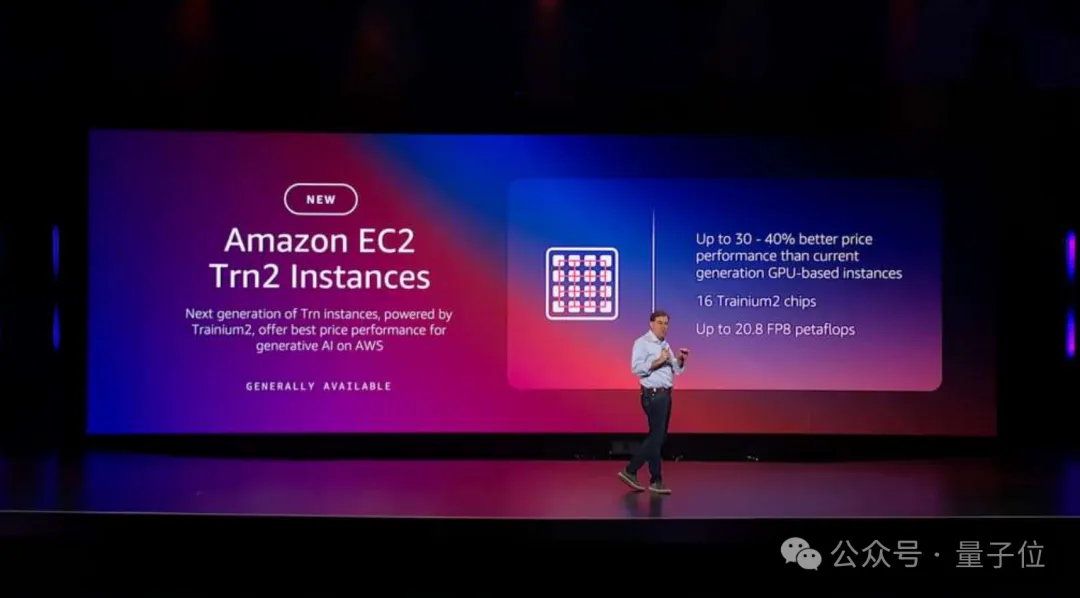

在計算層面上,亞馬遜云科技先是宣布Amazon EC2 Trn2實例正式可用。

EC2 Trn2實例采用了第二代Trainium 芯片(Trainium2),與上一代Trn1實例相比,性能提升顯著。具體來說:

- 訓練速度提高4倍:這一性能提升能有效減少模型訓練所需時間,加快企業應用落地;

- 內存帶寬提高4倍:更強的數據傳輸能力可以滿足復雜模型對實時數據處理的高要求;

- 內存容量提高3倍:為高參數量模型的運行提供了足夠的計算資源。

此外,Trn2實例在性價比上比當前基于GPU的EC2 P5e和P5en實例高出30-40%。

每個Trn2實例包含16個Trainium2芯片,192 vCPUs,2 TiB的內存,以及3.2 Tbps的Elastic Fabric Adapter (EFA) v3 網絡帶寬,這比上一代降低了高達 35% 的延遲。

針對更高性能需求,亞馬遜云科技同時推出了Trn2 UltraServer。

這是一種全新的超大規模計算產品,每臺UltraServer包含64個Trainium2芯片,并通過高帶寬、低延遲的 NeuronLink互連實現了卓越的性能。

這使得Trn2 UltraServer成為訓練超大規模基礎模型(如生成式 AI、LLM 等)的理想選擇。

NeuronLink是亞馬遜云科技專有的網絡互連技術,它能夠將多臺Trainium服務器組合成一個邏輯上的單一服務器,連接帶寬可達2TB/s的帶寬,而延遲僅為1微秒。

它的設計特別適合分布式深度學習任務,在網絡通信上的優化有助于顯著縮短訓練時間,提升資源利用率。

用官方的話來說就是:

這正是訓練萬億級參數的大型人工智能模型所需要的超級計算平臺,非常強大。

在現場,蘋果也來為亞馬遜站臺,機器學習和人工智能高級總監Benoit Dupin表示:

蘋果將使用亞馬遜云科技的Trainium2芯片。

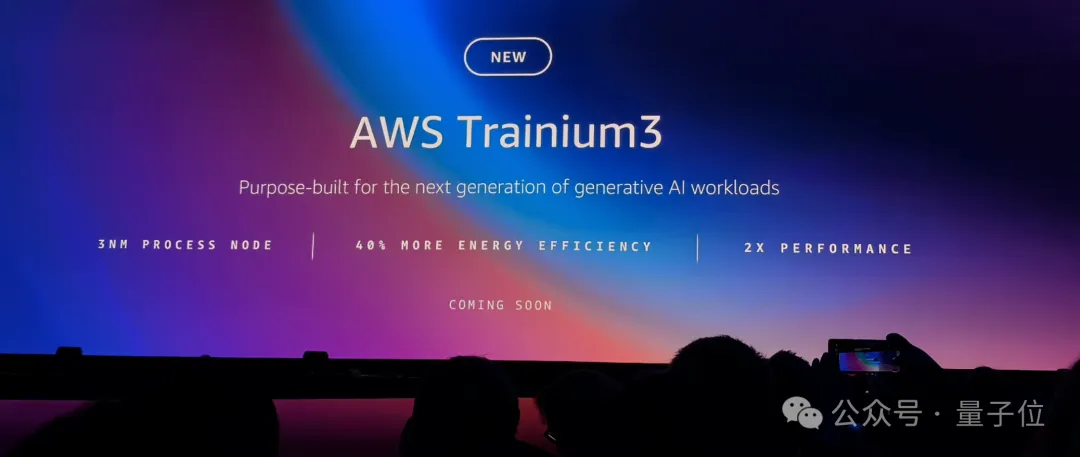

除此之外,在芯片層面上,亞馬遜云科技發布了AWS Trainium3芯片預覽版,預計于2025年正式推出。

據悉,Trainium3將采用3納米工藝制造,提供兩倍于Trainium2的計算能力,并提升40%的能效。

在計算(Compute)之后,便是存儲(Storage)上的更新。

我們都知道,在數據分析和大數據領域,處理和查詢大規模數據集的能力至關重要。

而傳統的數據查詢方法在處理海量數據時,常常導致性能瓶頸和管理復雜性,影響了企業的數據驅動決策能力。

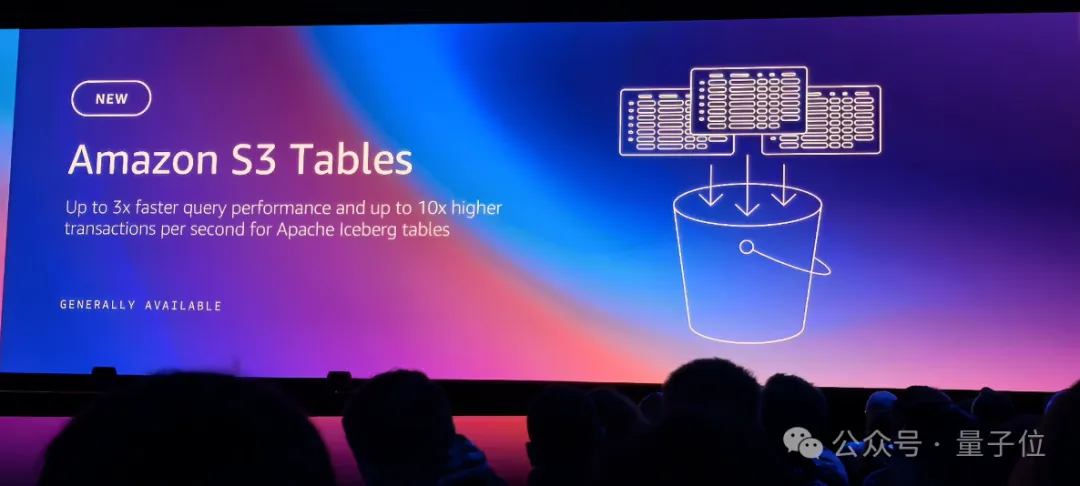

為此,亞馬遜云科技專門推出了Amazon S3 Tables。

Amazon S3 Tables提供了一種新的存儲方式,專為表格數據設計,支持使用Amazon Athena、Amazon EMR 和 Apache Spark等流行的查詢引擎進行輕松查詢。

S3的表存儲桶是它的第三種存儲桶類型,與現有的通用存儲桶和目錄存儲桶并列;可以將表存儲桶視為一個分析倉庫,用于存儲具有不同模式的Iceberg表格。

與自管理的表格存儲相比,S3 Tables可以實現高達3倍的查詢性能提升和10倍的每秒事務處理能力,同時提供全托管服務的操作效率。

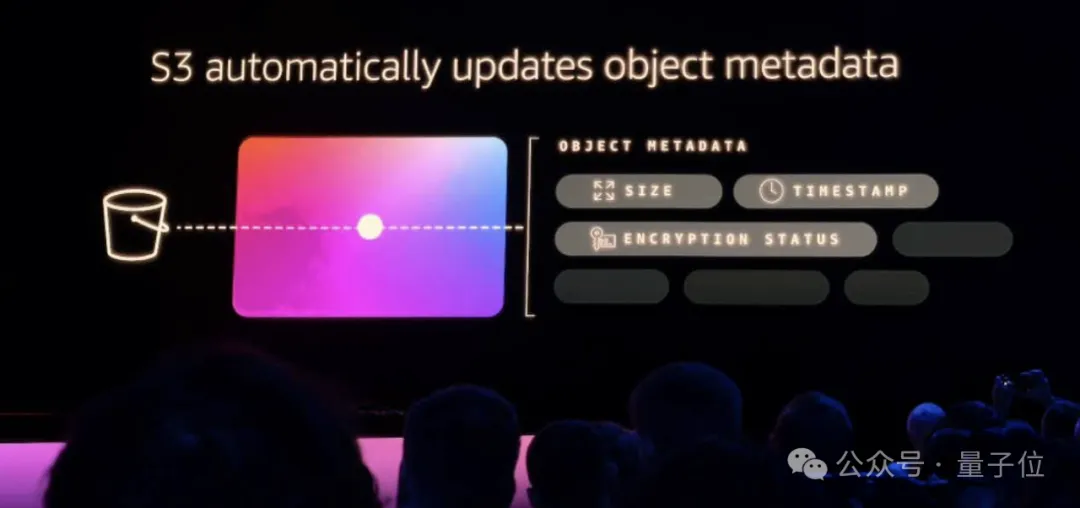

除此之外,元數據(Metadata)也變得越發重要,例如電話里面有很多照片,正是因為通過元數據儲存數據,現在可以實現用自然語言很快找到這張照片。

基于這樣的需求,亞馬遜云科技推出了Amazon S3 Metadata的預覽版。

Amazon S3 Metadata提供了一種自動化、易于查詢的元數據管理方式,這些元數據幾乎實時更新,幫助用戶整理、識別和使用S3數據進行業務分析、實時推理應用等。

它支持對象元數據,包括系統定義的詳細信息(如大小和對象來源)以及自定義元數據,允許用戶使用標簽為對象添加產品SKU、交易ID或內容評級等信息。

而這些元數據同樣也存儲在S3 Tables之中。

在計算、存儲之后,便是基礎設施的第三大板塊——數據庫(Database)。

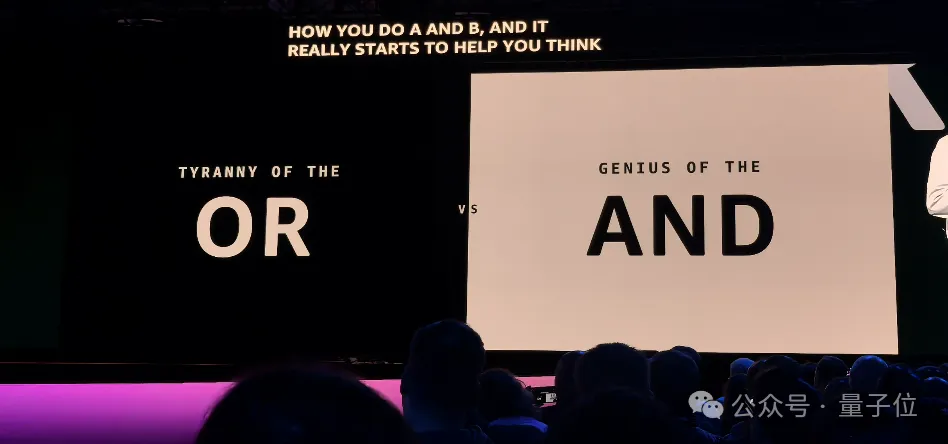

有意思的一點是,Matt在現場分享了一張“OR”還是“AND”的圖,表示企業在選擇數據庫時普遍遇到的艱難抉擇——跨區域一致、高可用性、低延遲,往往只能3選2。

而亞馬遜云科技此次給出的答卷是,都可以有。

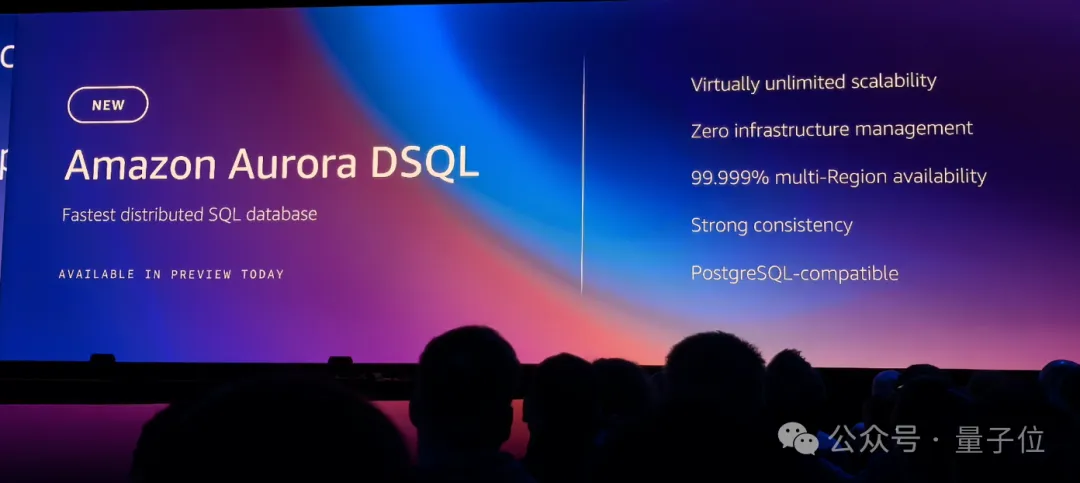

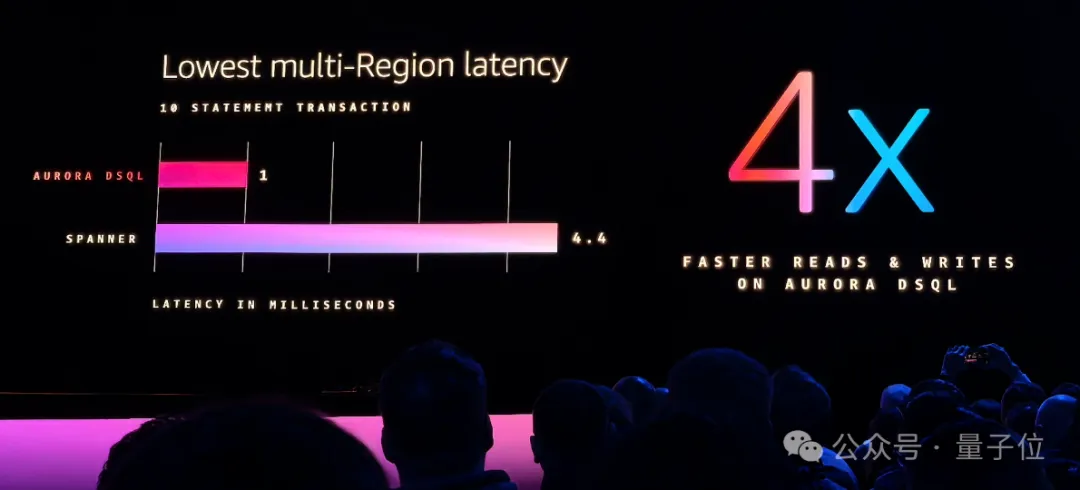

這就是新型無服務器分布式數據庫Amazon Aurora DSQL,旨在解決傳統數據庫在擴展性和性能方面的挑戰。

Aurora DSQL結合了傳統關系數據庫的強一致性和NoSQL數據庫的分布式擴展能力,提供了以下幾個關鍵優勢:

- 跨區域強一致性和低延遲:采用了全新的架構,使其能夠在多個地理區域中同時運行,而保持強一致性。

- 無限擴展:能夠處理數TB到數PB級的數據集,適用于任何規模的企業。

- 超高可用性:提供99.999%的可用性,這對于許多需要高可用性和無縫運行的企業級應用至關重要。

- 性能優越:其跨區域的讀寫操作比Spanner快了四倍。

以上便是亞馬遜云科技此次在基礎設施上的發力了。

新的積木——推理

如果說把基礎設施的三大板塊視為三塊積木,那么接下來,亞馬遜云科技在模型層和應用層方面添加了第四塊積木——推理(Inference)。

推理是生成式AI工作流的核心,它指的是將已經訓練好的模型應用到新數據上,進行預測、生成或推斷。

Matt在會上強調:

推理在AI模型的應用中變得尤為重要,尤其是在處理像大型語言模型等復雜模型時,推理要求極高的計算能力和低延遲響應。

而Amazon Bedrock作為亞馬遜云科技在模型層的一項AI平臺服務,先是與我們上述的基礎設施在推理上保持了同步。

換言之,Inferentia和Trainium芯片提供的推理的硬件優化,用戶可以通過Amazon Bedrock便捷訪問這些資源。

而至于Amazon Bedrock本身,這次也迎來多項能力的升級。

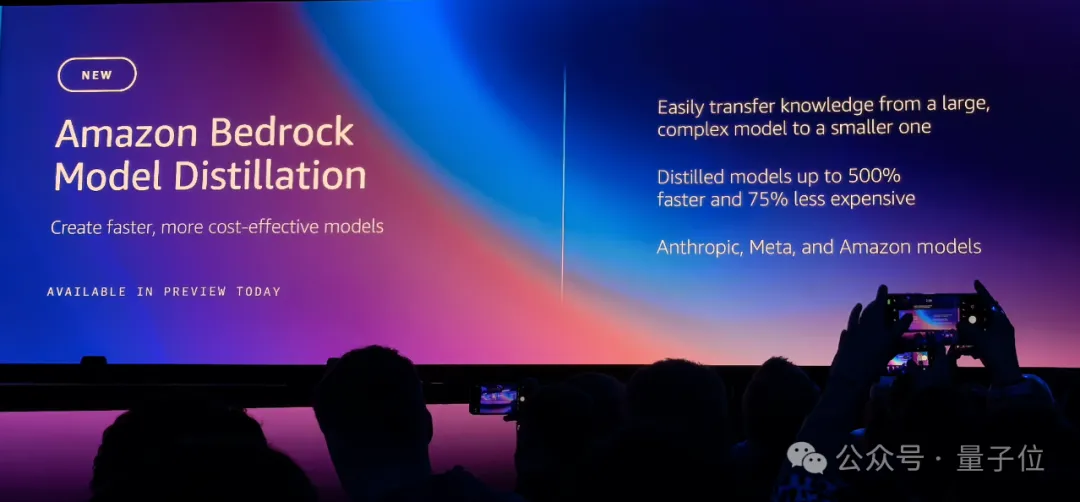

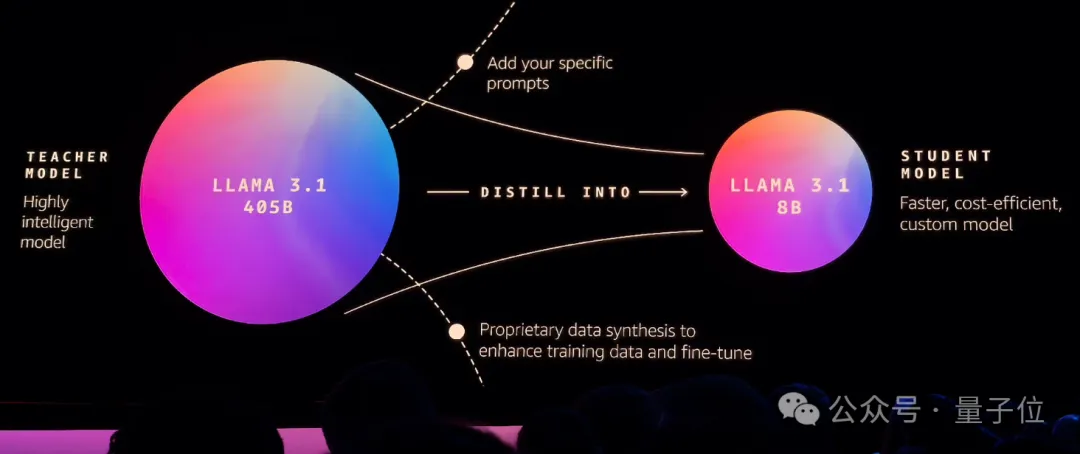

首先就是模型蒸餾(Model Distillation),能夠自動化創建針對特定用例的蒸餾模型。

主要是通過從大型基礎模型(教師模型)生成響應,并使用這些響應來微調較小的基礎模型(學生模型),從而實現知識轉移,提高小模型的精確度,同時降低延遲和成本。

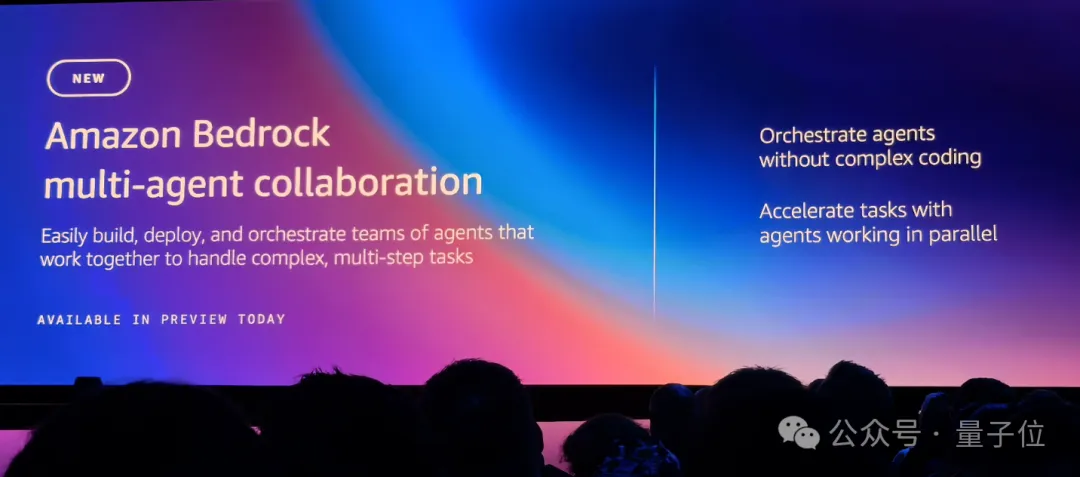

其次是多智能體協作(multi-agent collaboration)。

在需要多個智能體處理復雜任務的場景中,管理這些智能體變得具有挑戰性,尤其是隨著任務復雜性的增加。

使用開源解決方案的開發者可能會發現自己需要手動實現智能體編排、會話處理、內存管理等復雜操作。

這也正是亞馬遜云科技在Amazon Bedrock上推出多智能體協作的出發點。具體特點如下:

- 快速設置:無需復雜編碼,幾分鐘內創建、部署和管理協同工作的AI智能體。

- 可組合性:將現有智能體作為子智能體集成到更大的智能體系統中,使它們能夠無縫協作以應對復雜的工作流程。

- 高效的智能體間通信:監督智能體可以使用一致的接口與子智能體進行交互,支持并行通信以更高效地完成任務。

- 優化的協作模式:在監督模式和監督加路由模式之間選擇。在路由模式下,監督智能體將直接將簡單請求路由到相關的子智能體,繞過完整的編排。

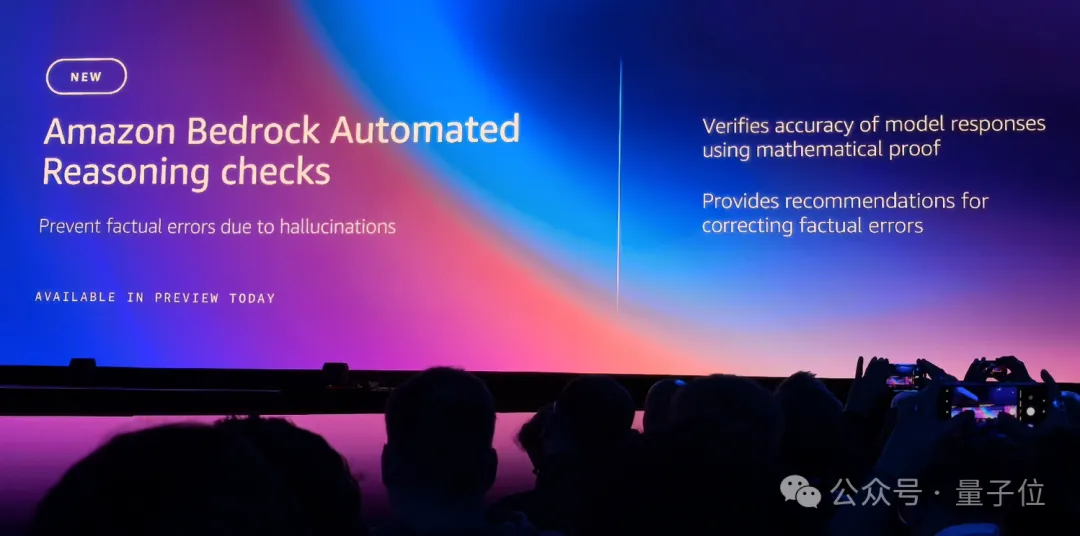

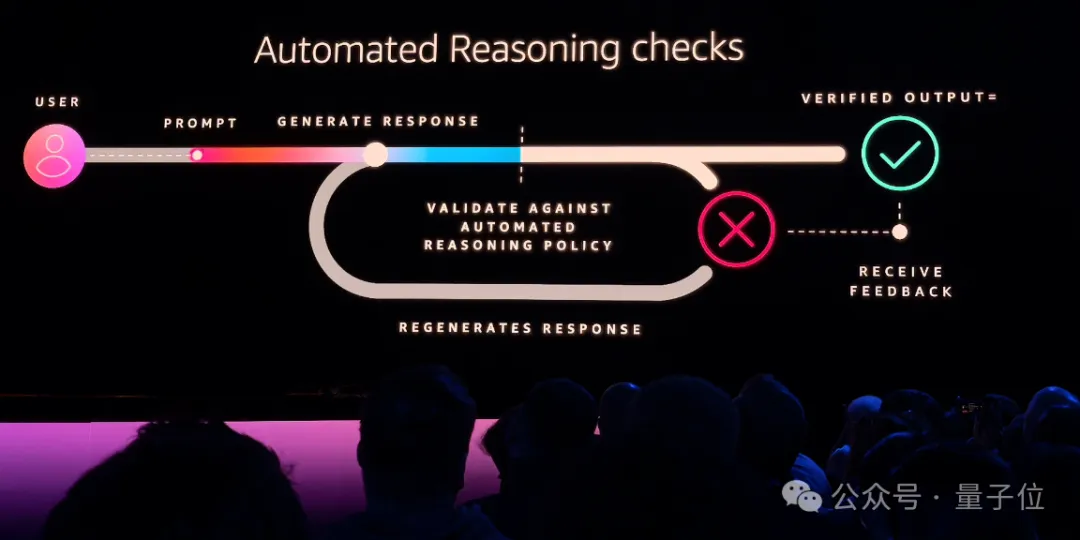

最后,也是更為重要的一點,便是防止大型語言模型幻覺導致的事實錯誤的功能——自動推理檢查(Automated Reasoning checks),這是Amazon Bedrock Guardrails中新增的一項功能。

這種新的防護措施,旨在通過數學驗證來確保LLMs生成的響應的準確性,并防止幻覺導致的事實錯誤。

自動推理檢查使用基于數學和邏輯的算法驗證和推理過程來驗證模型生成的信息,確保輸出與已知事實一致,而不是基于虛構或不一致的數據。

與機器學習(ML)不同,自動推理提供了關于系統行為的數學保證。

據悉,亞馬遜云科技已經在存儲、網絡、虛擬化、身份和密碼學等關鍵服務領域使用自動推理,例如,自動推理用于正式驗證密碼實現的正確性,提高性能和開發速度。

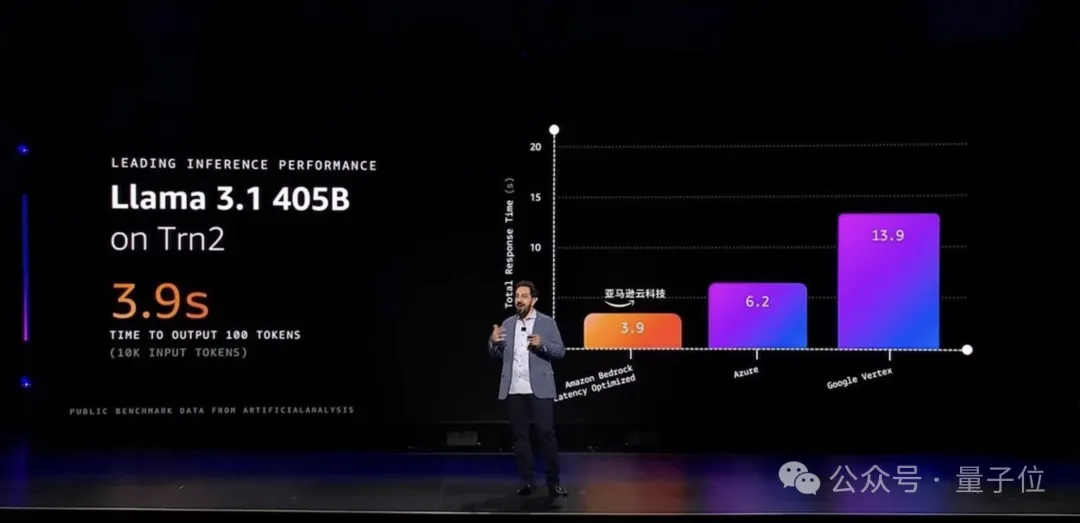

在性能方面,Bedrock還推出了低延遲優化推理,由此,用戶可以在使用最先進的大模型基礎上,還享受卓越的推理性能。

值得一提的是,Llama 405B和Llama 70B低延遲優化版本,在亞馬遜云科技上展現出超越其他云提供商的出色表現。

還有應用層和其它更新

針對開發者和企業,亞馬遜云科技在應用層上的代表作便是Amazon Q了。

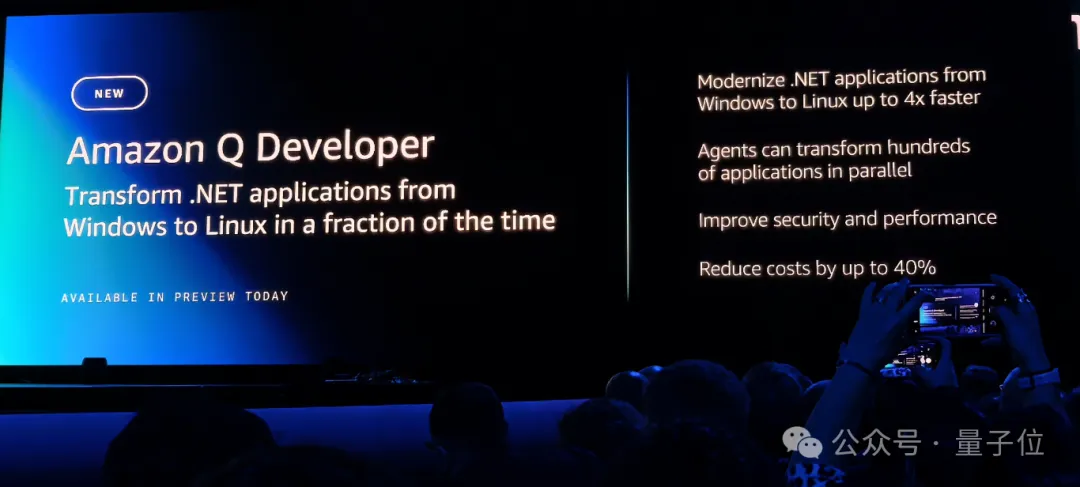

針對越來越多的企業尋求從本地數據中心遷移到云的痛點,亞馬遜云科技在Amazon Q Developer上推出了多項新功能。

其中較為引人注目的就是Transformation for Windows .NET Applications,這項功能使得企業能夠更快速地將.NET應用程序遷移到AWS,同時還能夠顯著降低遷移成本。

Amazon Q為.NET應用程序提供了自動化遷移工具,能夠識別應用程序中可能存在的不兼容問題,生成遷移計劃,并且自動調整源代碼,確保平滑過渡到云端。這種自動化遷移大幅提高了工作效率,減少了人為干預。

通過將應用程序從Windows遷移到Linux,企業能夠節省高昂的Windows許可費用,降低TCO(總擁有成本)。

Matt指出,使用Amazon Q的企業能夠節省多達40%的許可成本。

而且遷移速度比傳統手動遷移快了四倍,大大減少了系統遷移的停機時間和風險。

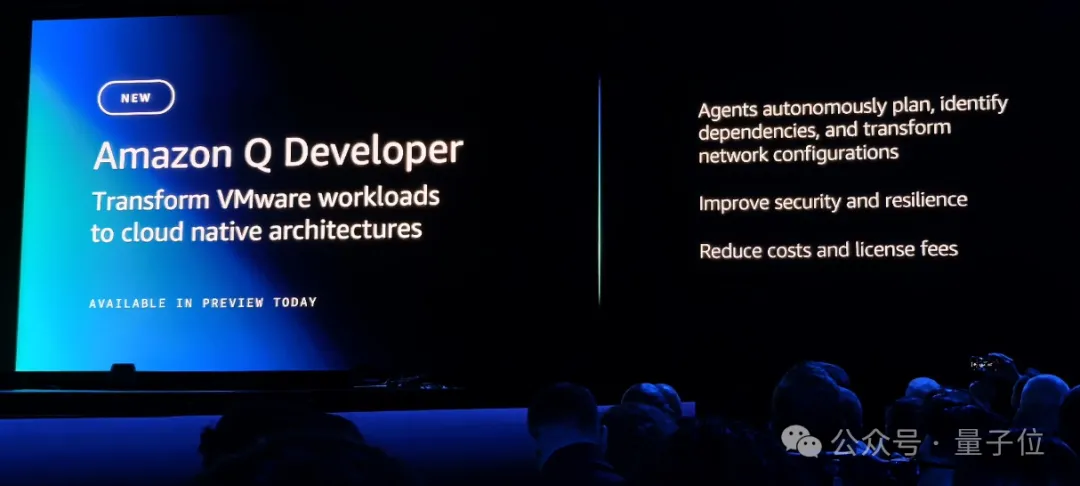

除了Windows應用的遷移,亞馬遜云科技還推出了Amazon Q Developer Transformation for VMware Workloads功能,專為運行在VMware上的企業工作負載設計。

通過這一工具,亞馬遜云科技可以幫助企業將本地的VMware環境遷移到云平臺。

應用層之外,還有諸如將AI和分析做結合的產品——Amazon SageMaker。

它作為一個可以幫企業加速AI應用的開發、訓練和部署的數據科學平臺,今天也正式步入了“下一代”。

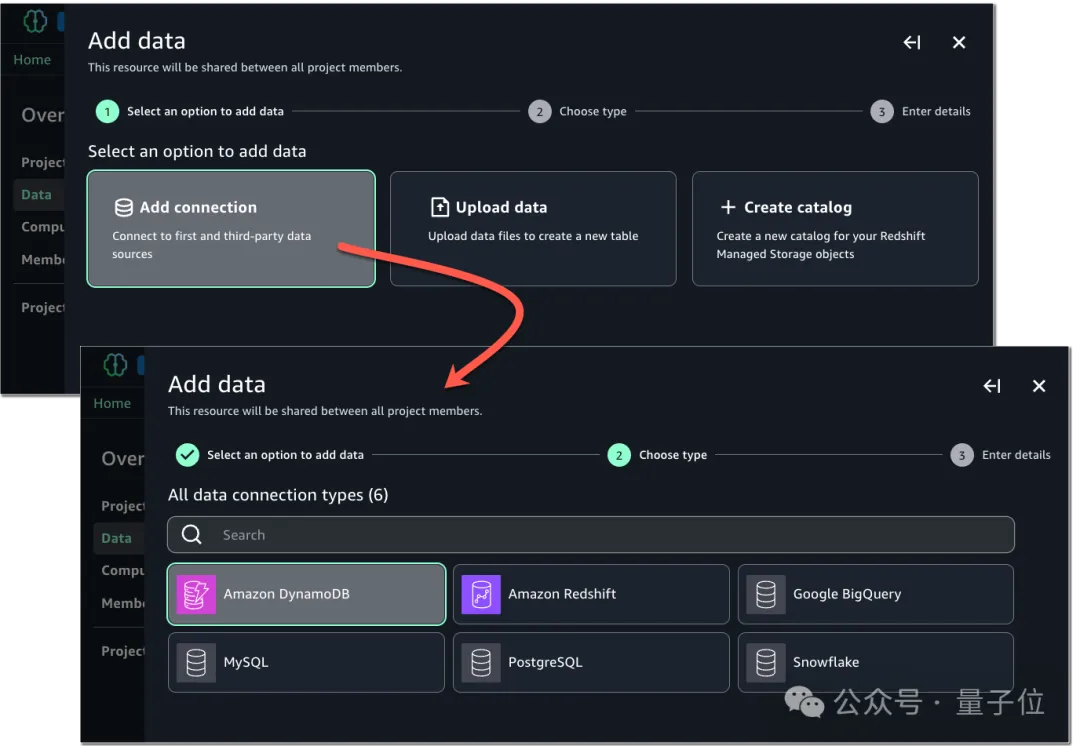

新一代SageMaker的核心是SageMaker Unified Studio。

這是一個單一的數據和AI開發環境,它整合了Amazon Athena、Amazon EMR、AWS Glue、Amazon Redshift、Amazon Managed Workflows for Apache Airflow (MWAA)以及現有的SageMaker Studio中的工具和功能。

其次是Amazon SageMaker Lakehouse,可以統一Amazon S3數據湖、Amazon Redshift數據倉庫和第三方及聯合數據源。

亞馬遜云科技的“AI步法”

在看完本屆re:Invent所有內容和實力之后,亞馬遜云科技在生成式AI時代的發展路徑其實也就比較清晰了——

從客戶的真實業務需求出發。

上文種種內容的更新,都是基于“客戶的服務出現了什么問題”,包括計算、存儲、數據庫上的瓶頸,包括客戶在模型上的選擇,再包括應用上的遷移服務等等。

洞悉了背后的實用主義邏輯,也就不難理解,亞馬遜云科技為何選擇在這個時間節點上發布一系列多模態大模型,還是因為客戶有需要。

這種需要,具體而言,就是客戶在模型上的選擇,畢竟“沒有一個模型可以一統天下”,每個模型都有自己所擅長的領域。

但亞馬遜云科技所做的,是利用自己在基礎設施、工具/模型和應用三個層面的深耕和實力,給客戶多提供了一個“快、好、省”的選項。

回顧亞馬遜云科技的起步,似乎這一點從未變過。

正如Matt在大會上回憶的那樣:

亞馬遜云科技在2006年推出時,初創公司是第一批用戶,他們總是非常積極地采用新技術,并且能夠提供有價值的反饋。

而這種反饋也進一步推動了亞馬遜云科技的發展,也有助于理解如何更好地支持創業精神。

因此,Matt在大會中還宣布了一個重磅消息:

將在2025年為全球的初創公司提供10億美元的資金支持!

One More Thing

本屆re:Invent共計6萬人參與,來感受一下這個熱情、這個feel~

參考鏈接:[1]https://www.aboutamazon.com/news/aws/amazon-nova-artificial-intelligence-bedrock-aws。

[2]https://aws.amazon.com/blogs/aws/amazon-ec2-trn2-instances-and-trn2-ultraservers-for-aiml-training-and-inference-is-now-available/。

[3]https://aws.amazon.com/blogs/aws/new-amazon-s3-tables-storage-optimized-for-analytics-workloads/。