阿里推出“眼睛”模型QVQ:全球第一個用于視覺推理的開放權重模型

這可能是全球第一個用于視覺推理的開源權重模型,名為QVQ,其中的“V”代表視覺。它只需讀取一張圖像和一條指令,就能開始思考,在需要時進行反思,持續推理,最后得出有把握的預測!不過,該模型仍處于實驗階段

人的語言和視覺緊密交織,塑造著我們感知和理解世界的方式,QVQ的主要目標是模仿人的這一思維方式

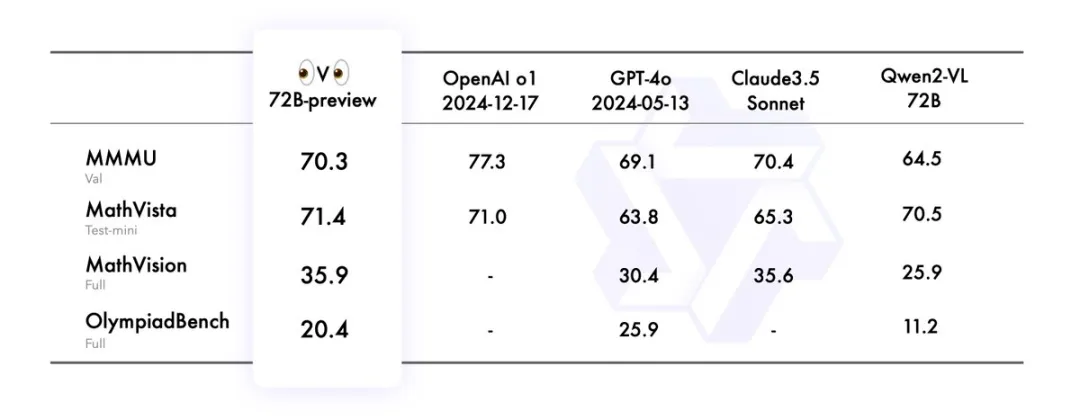

QVQ 在人工智能的視覺理解和復雜問題解決能力方面實現了重大突破。在 MMMU 評測中,QVQ 取得了 70.3 的優異成績,并且在各項數學相關基準測試中相比 Qwen2-VL-72B-Instruct 都有顯著提升。通過細致的逐步推理,QVQ 在視覺推理任務中展現出增強的能力,尤其在需要復雜分析思維的領域表現出色

模型表現

QVQ在 4 個數據集上評估 QVQ-72B-Preview,包括:

MMMU:大學級別的多學科多模態評測集,旨在考察模型視覺相關的綜合理解和推理能力

MathVista:數學相關的視覺推理測試集,評估拼圖測試圖形的邏輯推理、函數圖的代數推理和學術論文圖形的科學推理等能力

MathVision:高質量多模態數學推理測試集,來自于真實的數學競賽,相比于MathVista具有更多的問題多樣性和學科廣度

OlympiadBench:奧林匹克競賽級別的雙語多模態科學基準測試集,包含來自奧林匹克數學和物理競賽的8,476個問題,包括中國高考。每個問題都附有專家級別的注釋,詳細說明了逐步推理的過程

QVQ-72B-Preview 在 MMMU 基準測試中取得了 70.3 的分數,顯著超越了 Qwen2-VL-72B-Instruct。此外,在剩下的三個專注于數學和科學問題的基準測試中,該模型表現出色,有效縮小了與領先的最先進的 o1 模型之間的差距

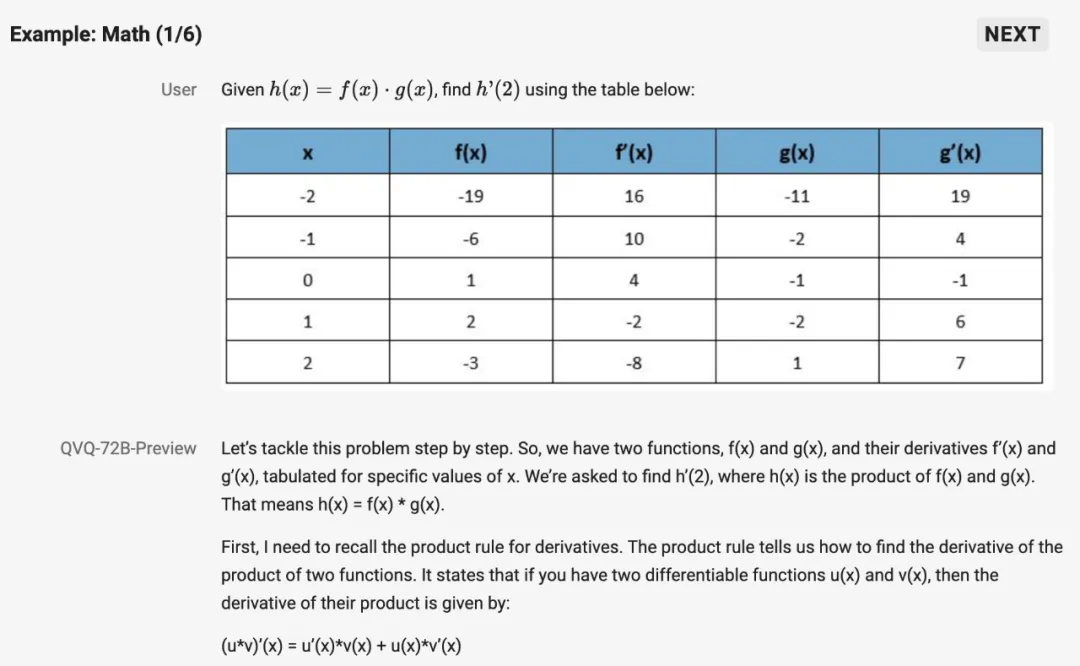

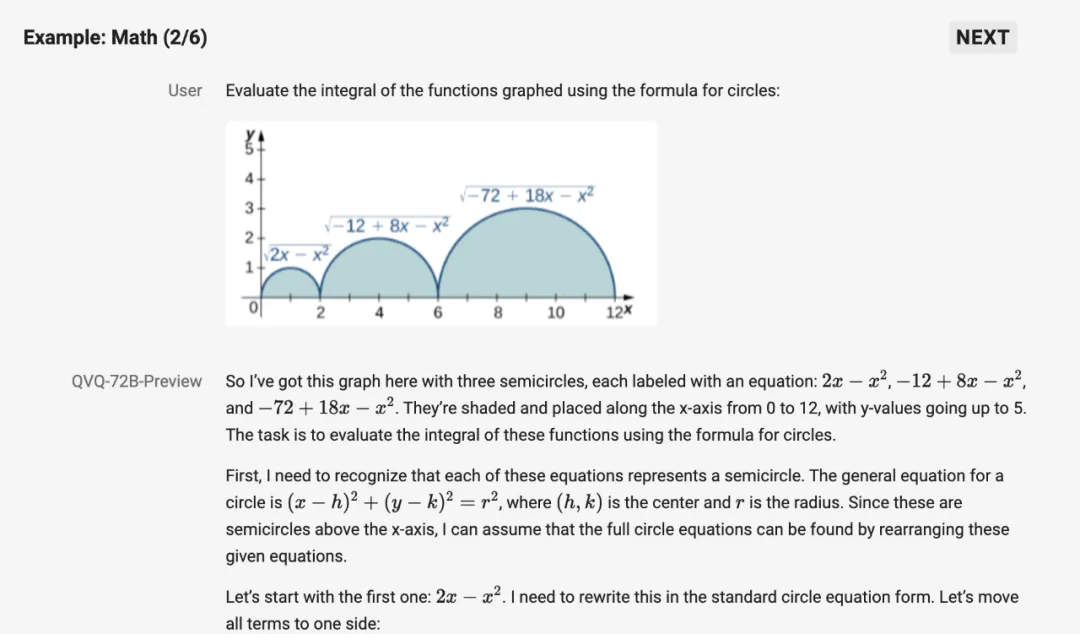

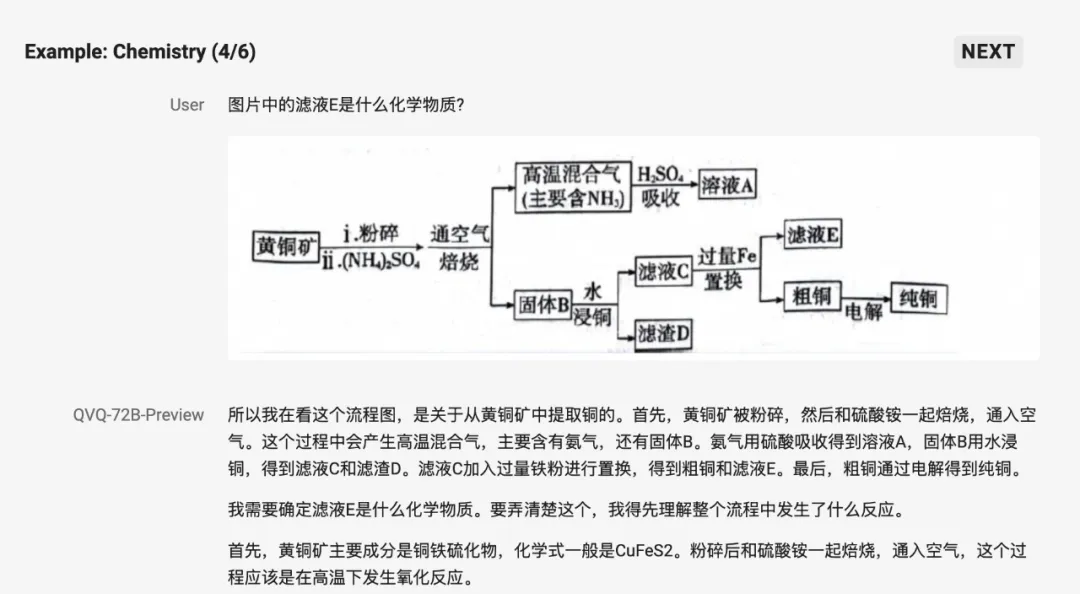

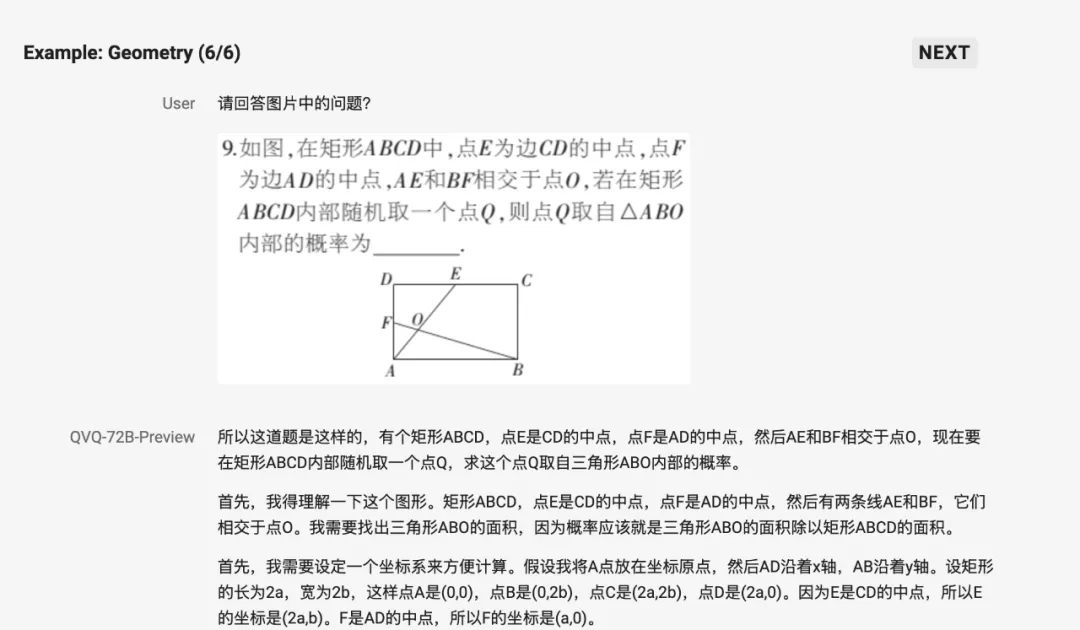

阿里展示幾個QVQ解題的例子,QVQ可以展現實時思維過程

盡管QVQ展示了令人驚嘆的能力,但它仍有一些局限性值得關注:

1. 語言混合與切換:模型可能會在不同語言間切換,影響表達的清晰度

2. 遞歸推理問題:在某些情況下,模型可能陷入循環邏輯,導致冗長卻無結論的回答

3. 安全與倫理問題:模型需要更高的安全性保障,用戶在部署時需格外謹慎

4. 性能與基準限制:在多步視覺推理中,模型可能逐漸失去對圖像內容的關注,產生“幻覺”結果

試用:

HF: https://huggingface.co/collections/Qwen/qvq-676448c820912236342b9888

ModelScope: https://modelscope.cn/models/Qwen/QVQ-72B-Preview

Kaggle: https://kaggle.com/models/qwen-lm/qvq-72b-preview