ChatGPT構建離不開PyTorch,LeCun言論引熱議,模型廠商不開放權重原來為此

這兩天,有關開源的話題又火了起來。有人表示,「沒有開源,AI 將一無所有,繼續保持 AI 開放。」這個觀點得到了很多人的贊同,其中包括圖靈獎得主、Meta 首席科學家 Yann LeCun。

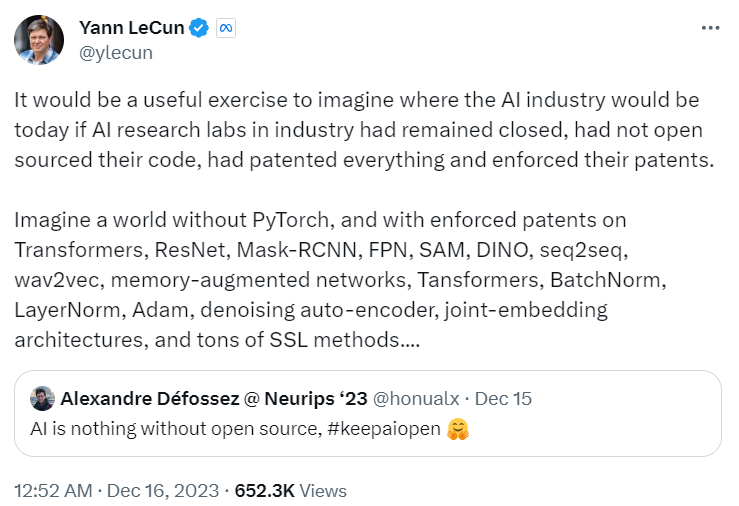

想象一下,如果工業界的 AI 研究實驗室仍然封閉、沒有開源代碼,并為所有內容申請和執行專利,那么今天的 AI 行業將會變成什么樣子?

想象一個沒有 PyTorch 的世界,并且 Transformer、ResNet、Mask-RCNN、FPN、SAM、DINO、seq2seq、wav2vec、內存增強網絡、Tansformers、BatchNorm、LayerNorm、Adam、去噪自動編碼器、聯合嵌入架構以及大量的 SSL 方法都被施加專利,AI 行業又會變成什么樣子?

圖源:https://twitter.com/ylecun/status/1735704308891484248

LeCun 觀點引起更多人共鳴,有人認為,「如果谷歌不開源 Transformers,OpenAI 甚至發明不了 GPT。真是虛假的『OpenAI』。」

圖源:https://twitter.com/ai_for_success/status/1735705570500640871

LeCun 還不忘說一句,「ChatGPT 的構建也離不開 PyTorch。」

這就出現了一個值得探討的問題,為什么像 OpenAI、Anthropic 這樣的公司不愿意開源大模型權重呢?外媒 VentureBeat 撰寫了一篇深度長文,采訪了一些高管人士,剖析了個中緣由。

我們知道,在機器學習尤其是深度神經網絡中,模型權重被認為至關重要,它們是神經網絡學習和做出預測的機制。訓練后權重的最終值決定了模型性能。

同時,非盈利機構蘭德公司的一項研究指出,雖然權重不是大模型需要保護的唯一組成部分,但它們與模型的大量計算、收集和處理的訓練數據和算法優化息息相關。獲取權重可以讓惡意行為者以非常小的訓練成本來利用完整的模型。

論文地址:https://www.rand.org/pubs/working_papers/WRA2849-1.html

大模型公司更加注重權重安全。Jason Clinton 是 Anthropic 首席信息安全官,他的主要任務是保護自家模型 Claude 的 TB 級權重文件免遭他人之手。「我可能將自己一半時間用來保護權重文件。這是我們最為關注和優先考慮的事情,也是投入資源最多的地方」,他在 VentureBeat 的采訪中這樣說道。

模型權重可不能落入「壞人」之手

Jason Clinton 強調,有人認為公司對模型權重的擔憂是因為這些權重代表著極高價值的知識產權。其實不然,Anthropic 更重要的考慮在于防止這些強大技術落入「壞人」之手,產生不可估量的負面影響。

對誰能獲取基礎模型權重深表擔憂的遠不止克林頓一人。事實上,白宮最近發布的關于「安全、可靠地開發和使用人工智能」的行政命令就要求基礎模型公司向聯邦政府提供文件,報告模型權重的所有權、占有情況以及采取的保護措施。

OpenAI 也表達了類似的立場。在 2023 年 10 月的一篇博文中,OpenAI 表示正在繼續投資網絡安全和內部威脅防護措施,以保護專有和未發布的模型權重。

40 種攻擊向量正在被執行

Rand 的報告《Securing Artificial Intelligence Model Weights》由 Sella Nevo 和 Dan Lahav 共同撰寫。報告強調了人工智能模型權重面臨的安全威脅和未來風險。

Nevo 在接受 VentureBeat 采訪時表明,當前最大的擔憂不是這些模型現在能做什么,而是未來可能發生什么,尤其是在國家安全方面,例如被用于開發生物武器的可能性。

該報告的目的之一是了解行為者可能采用的攻擊方法,包括未授權的物理訪問、破壞現有憑證和供應鏈攻擊等。報告最終確定了 40 種不同的攻擊向量,并強調它們不是理論上的,而是已有證據表明它們正在被執行,甚至在某些情況下已被廣泛部署。

開放基礎模型的風險

需要注意的是,并非所有專家都能在人工智能模型權重泄露的風險程度以及需要限制的程度上達成一致,尤其是在涉及開源人工智能時。這再次印證了人工智能領域治理的復雜性和諸多挑戰。

斯坦福大學人工智能學院政策簡報《Considerations for Governing Open Foundation Models》強調,盡管開放基礎模型(即權重廣泛可用的模型)可以對抗市場集中、促進創新并提高透明度,但其相對于封閉模型或現有技術的邊際風險尚不明確。

簡報鏈接:https://hai.stanford.edu/issue-brief-considerations-governing-open-foundation-models

這份簡報以事實為基礎,沒有刻意煽動恐懼,得到了人工智能治理高級顧問 Kevin Bankston 的「好評」。

該簡報以 Meta 的 Llama 2 為例,該模型于 7 月發布,其模型權重廣泛可用,使得下游修改和審查成為可能。雖然 Meta 公司曾承諾確保其未發布模型權重的安全,并限制能夠訪問模型權重的人員范圍,但在 2023 年 3 月 Llama 的模型權重泄露還是讓人印象深刻。

喬治城大學人工智能評估高級研究員 Heather Frase 指出,開源軟件和代碼歷來都非常穩定和安全,因為它可以依靠一個龐大的社區。在強大的生成式人工智能模型出現之前,普通的開源技術造成危害的幾率也十分有限。她提到,與傳統的開源技術不同,開源模型權重的風險在于,最可能受到傷害的不是用戶,而是被故意當作傷害目標的人,例如深度偽造騙局的受害者。

安全感通常來自開放

不過,也有其他人表達了相反的觀點。在接受 VentureBeat 采訪時,Hugging Face 機器學習工程師 Nicolas Patry 強調,運行任務程序固有的風險同樣適用于模型權重,但并不意味著應該封閉。

當談到開源模型時,他們的想法是開放給盡可能多的人,比如最近 Mistral 的開源大模型。Nicolas Patry 認為,安全感通常來自開放,透明意味著更安全,任何人都可以查看它。封閉的安全會讓人們不清楚你在做什么。

VentureBeat 同樣采訪了開源框架 PyTorch Lightning 背后公司 Lightning AI 的首席執行官 William Falcon,他認為如果公司擔心模型泄露,那就為時已晚。開源社區追趕的速度難以想象,并且開放研究可以衍生當前 AI 網絡安全所需的各種工具。在他看來,模型開放程度越高,能力越民主化,可以開發更好的工具來對抗網絡安全威脅。

對于 Anthropic 而言,該公司一方面尋求支持領域研究,另一方面要保證模型權重的安全,比如聘用優秀的安全工程師。

原文鏈接:https://venturebeat.com/ai/why-anthropic-and-openai-are-obsessed-with-securing-llm-model-weights/