多模態RAG技術:從語義抽取到VLM應用與規模化挑戰

一、基于語義抽取的多模態 RAG

多模態 RAG 的發展方向旨在構建一個高度集成的系統,能夠無縫融合文本、圖像和其它多媒體元素,為用戶提供更豐富的信息交互體驗。

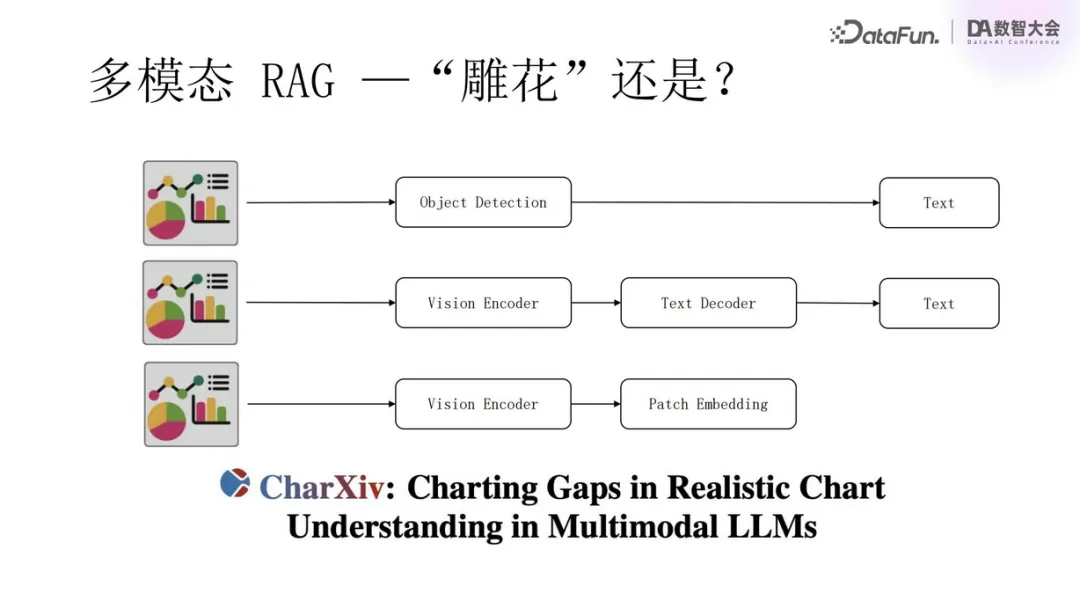

實現多模態 RAG 系統的三種主要技術路徑如下:

- 傳統對象識別與解析(雕花路線)

傳統的多模態文檔處理首先會運用圖像識別技術,如 OCR(Optical Character Recognition,光學字符識別),從圖像中抽取出文字、表格和圖片等元素。之后,這些獨立的對象會被進一步解析,轉換成文本格式,以便于后續的信息檢索與分析。 - 采用 Transformer 架構

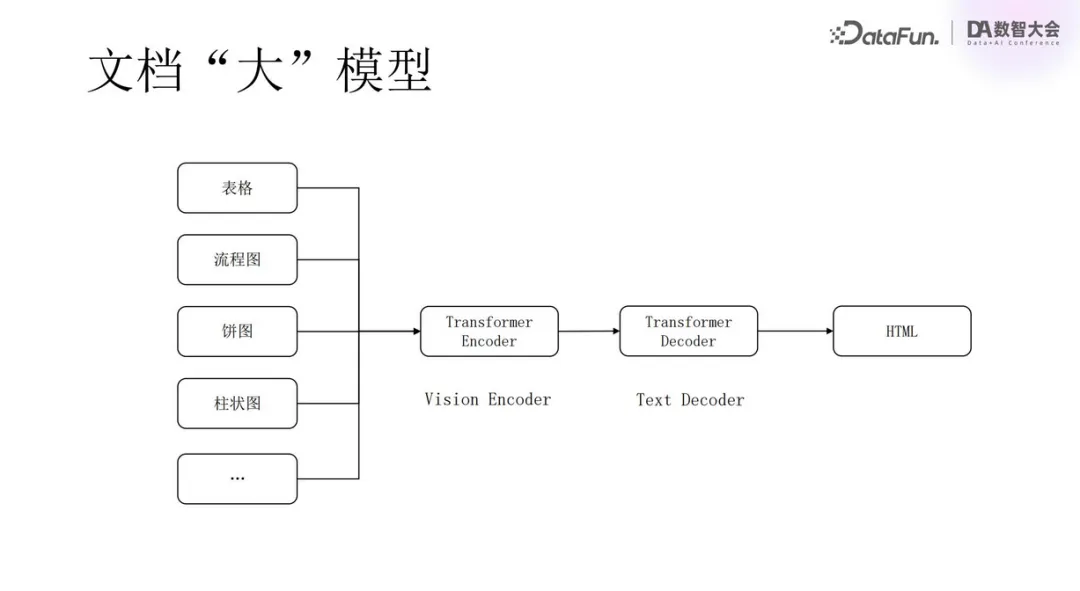

近年來,深度學習模型,特別是 Transformer 架構,在自然語言處理領域取得了巨大成功。在多模態 RAG 上,這種方法涉及使用編碼器(Encoder)對整個文檔進行編碼,再由解碼器(Decoder)將編碼后的信息轉化為可讀文本。這種方法與第一種類似,只是模型不同,第一種用的是 CNN,這種是 Transformer。此法的優勢在于可以更好地捕捉上下文依賴關系,提高信息的連貫性和一致性。 - 采用視覺語言模型

第三種方式是直接利用視覺語言模型(Visual Language Model, VLM)處理多模態數據。此類模型可以直接接收文檔、圖片或視頻等形式的原始輸入,將其轉化為向量(Patch Embedding)。這些向量可用于構建更加精細的文檔嵌入,有助于增強 RAG 系統的檢索和生成能力。尤其值得一提的是,由于單一向量難以充分反映復雜文檔的所有方面,使用多向量(或稱為張量)成為了優選方案,以減少信息丟失,更全面地代表文檔含義。

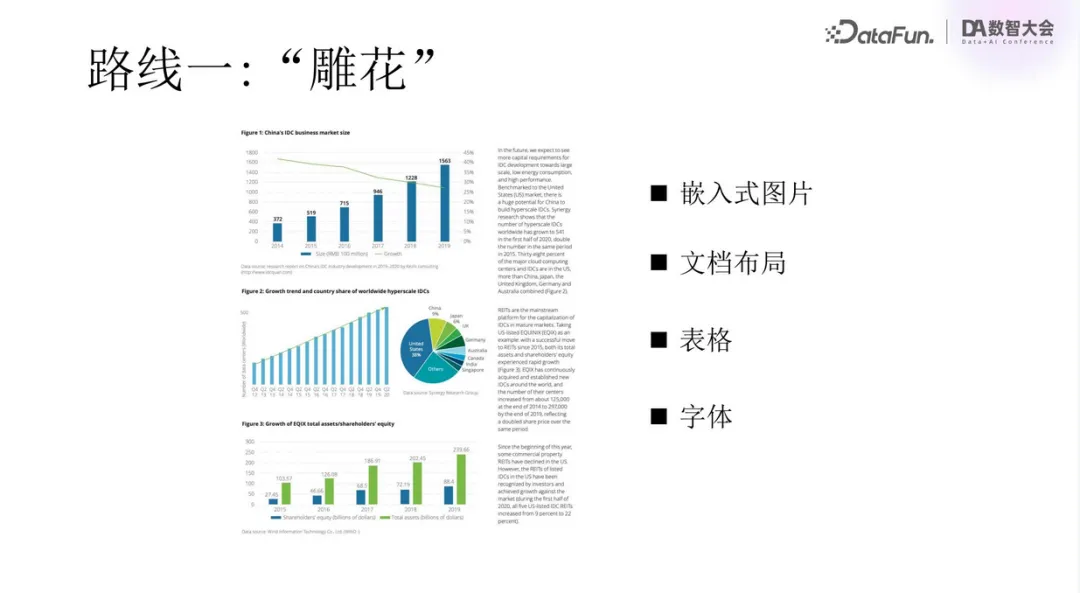

下面來具體看一下路線一,我們稱其為“雕花”式路線。

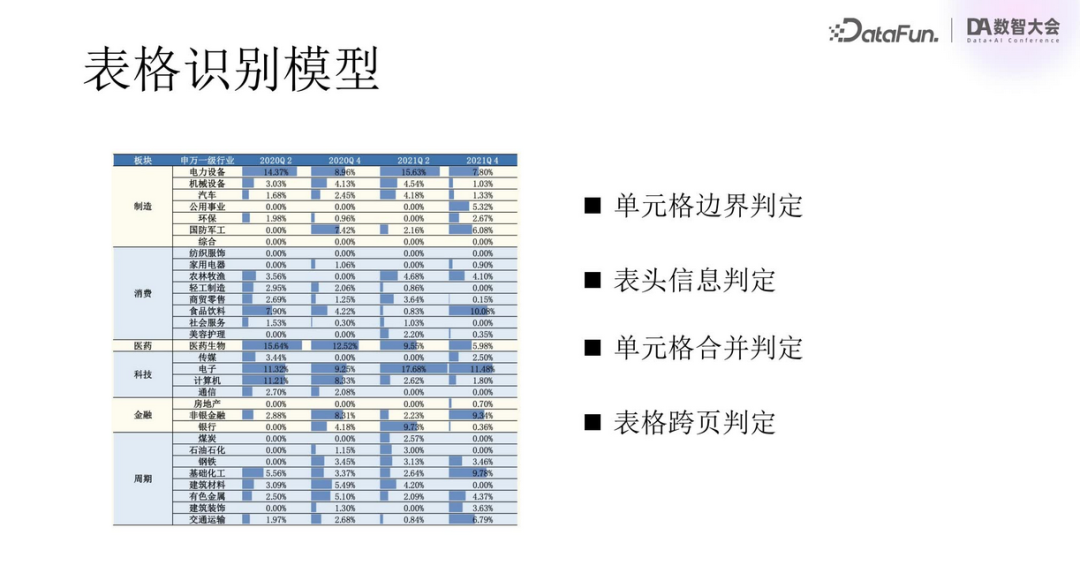

從上圖中可以看到,文檔通常富含圖形和表格,如折線圖、餅狀圖和柱狀圖,甚至存在表格跨頁、合并單元格等復雜情況,處理難度較高。

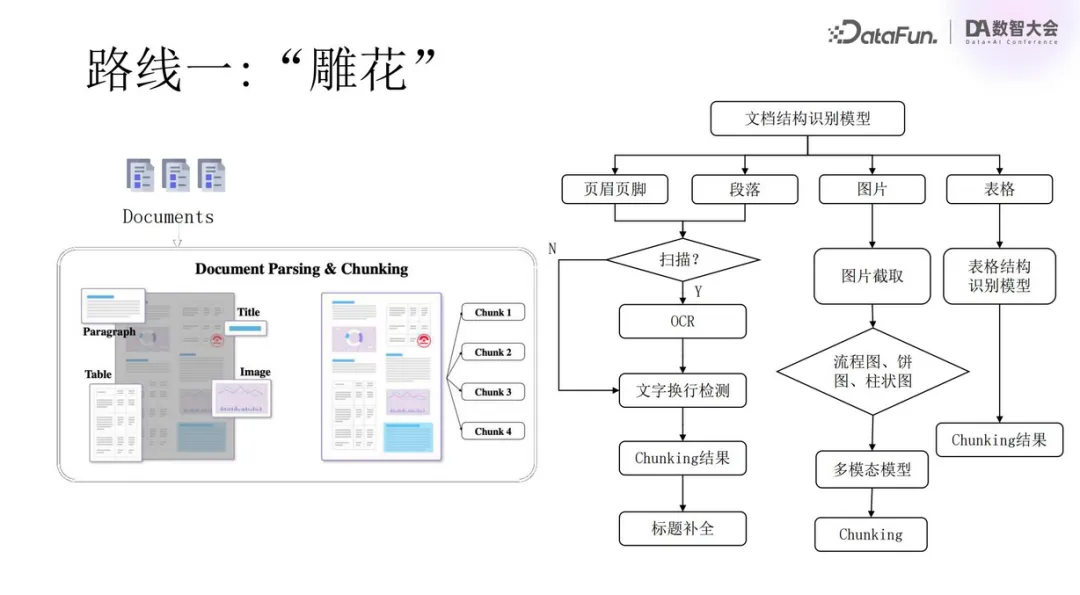

該路線的核心步驟如上圖所示。首先進行文檔結構識別,區分各個組成部分,明確哪些是段落、哪些是表格、哪些是圖表等。針對每一類識別出的對象進一步解析,對于文本部分,采用 OCR 技術轉錄文字;對于圖表,則需專門的模型進行識別和解析,理解其內容與意義。

“雕花”路線的特點在于其深度和廣度,幾乎覆蓋了文檔內的每一個細節。耗時費力,但對于確保信息的全面性和精準性具有不可替代的作用。但其處理效率相對較低,自動化程度受限,尤其面對大規模數據集時,挑戰更為顯著。

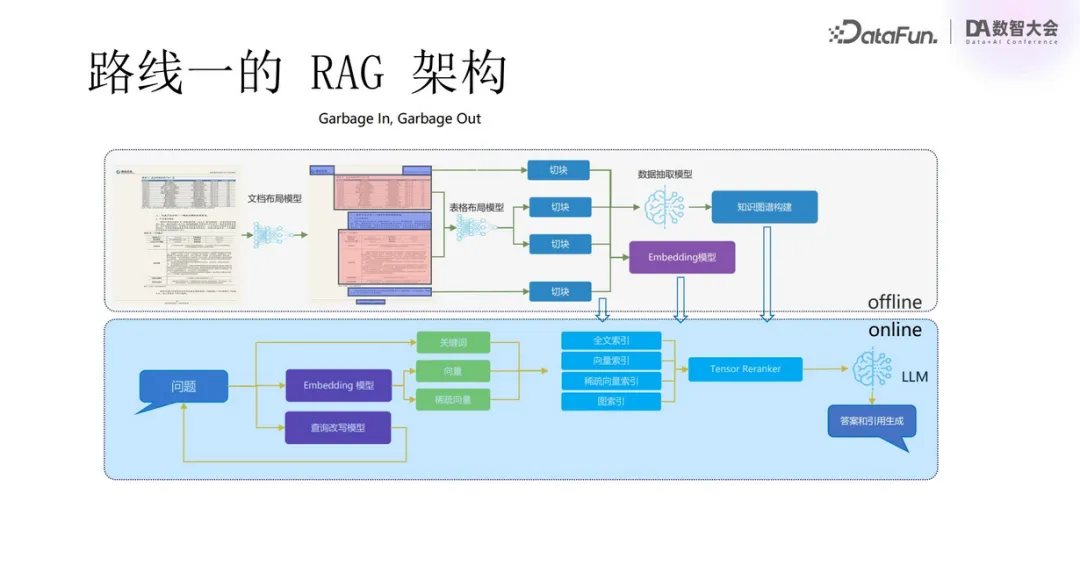

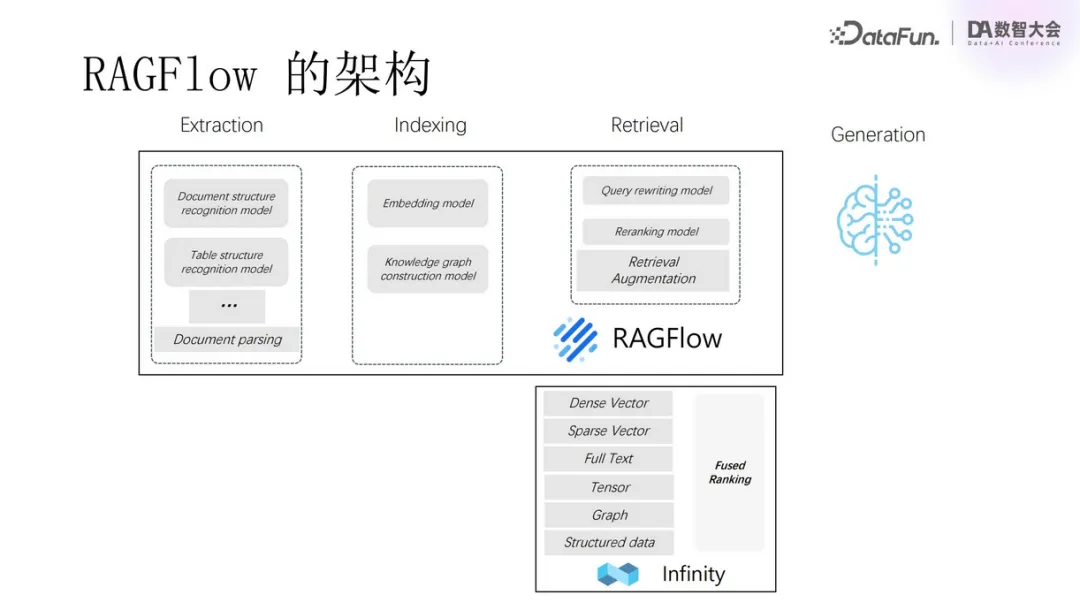

路線一的 RAG 架構是最基礎的 RAG:文檔被細分成 chunks,每一塊包含可獨立處理的內容片段,通過 Embedding 模型將每塊轉換成向量,以便在向量數據庫中進行相似性檢索,檢索結果作為提示詞提供給大模型。

實際應用場景下會更為復雜,需要進入更深層次的 RAG 架構。文檔布局模型識別出不同布局后,分離不同類型的 chunks。之后進行檢索,會用到全文索引、向量索引、稀疏向量索引以及圖索引等。檢索召回后,利用 Tensor Reranker 進行重排序,提升檢索效果。最后交由大模型生成回答。

在此過程中,面對復雜文檔,如果沒有“雕花”的過程,那么一定會存在信息混亂,導致“Garbage in, garbage out”。

我們根據第一種路線,設計了 RAGFlow 的功能模塊,并通過 Infinity 數據庫提供向量處理。

在“雕花”過程中,表格識別是一大難點。

表格通常布局復雜,需要判定單元格邊界、識別表頭和合并的單元格,還要判斷跨頁結構,對色彩標記、圖表嵌入等進行識別,處理難度很大。

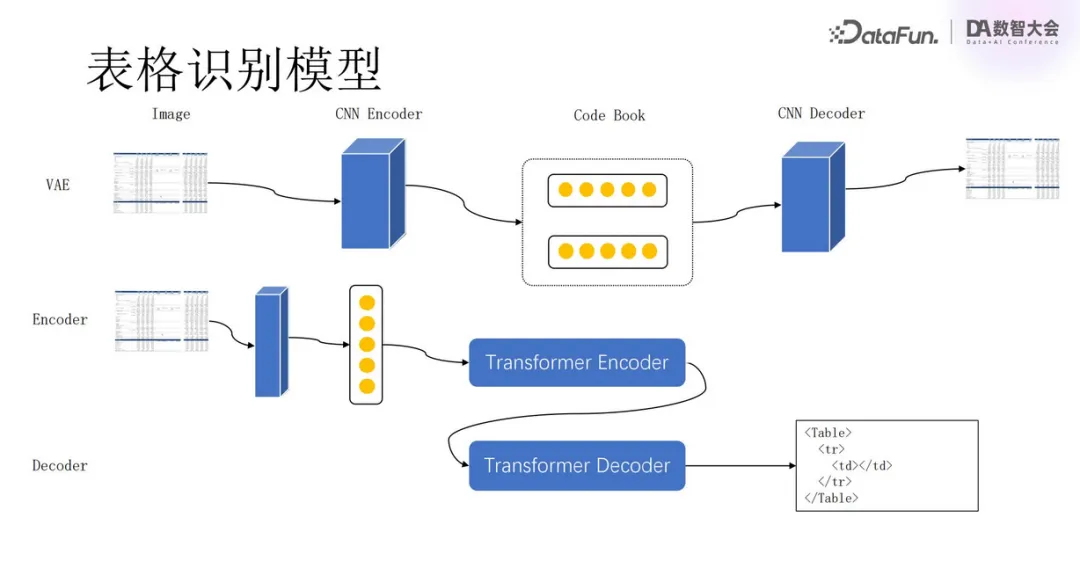

我們實現了利用 Transformer 架構對表格內容進行解析。

采用 VAE(Variational Auto Encoder)提取圖片特征,經過 Encoder 生成 Code Book,再經過 Decoder 得到最終結果。如果結果一致,則證明 Code Book 可以準確表達表格結構和內容。再來訓練 Encoder 和 Decoder,最后生成 HTML 表格。生成的表格與原表格經過嚴格對比,確認無誤后,我們就認為 Transformer 模型是準確有效的。

此流程不僅適用于表格識別,亦可用于流程圖、餅狀圖、柱狀圖等其它圖表類型的解析。

二、基于 VLM 的多模態 RAG

接下來介紹另一種路線——基于視覺語言模型的多模態 RAG。

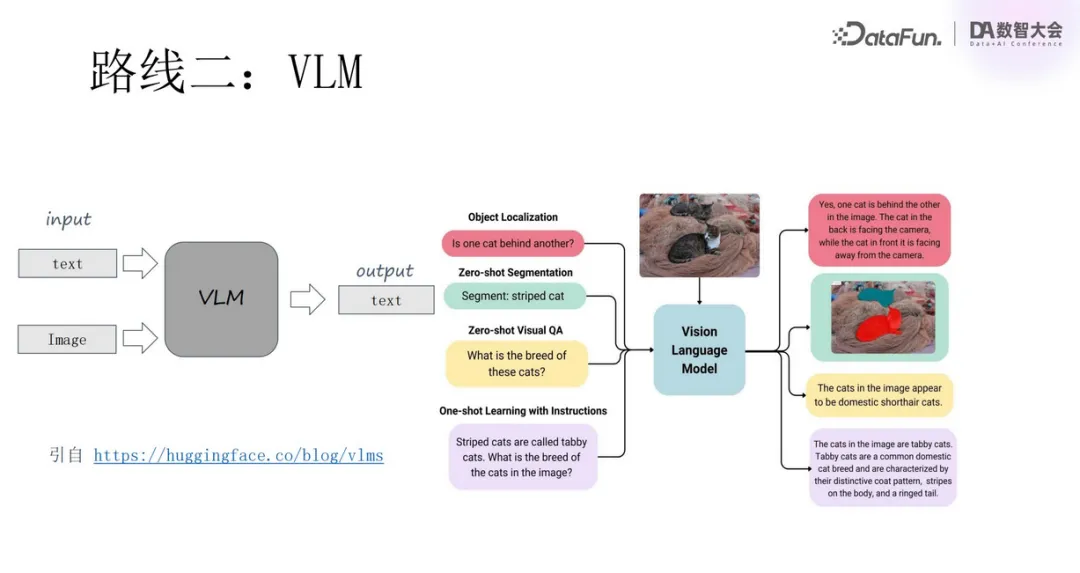

VLM 能夠同時處理圖像與文本信息,對復合媒介資料提供全面解析。如上圖中所示,模型不僅能夠識別出圖像中貓的位置,精確定位貓的輪廓,還可以回答關于圖像內容的提問,體現出其強大的多模態認知能力。下面來看一下 VLM 的進展。

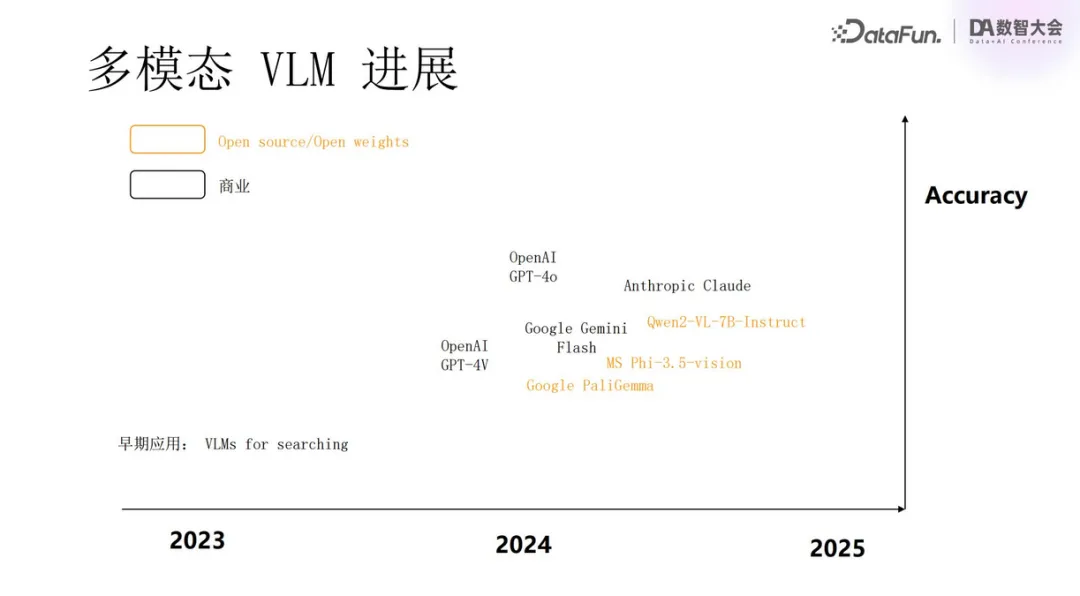

2024 年見證了多模態語言模型的迅猛崛起,以 GPT-4o 為代表的各種開源、閉源模型百花齊放,標志著多模態領域的重大進步。今年是多模態模型的爆發之年,那么明年是否會是多模態 RAG 的爆發之年呢?下面來看一些相關的例子。

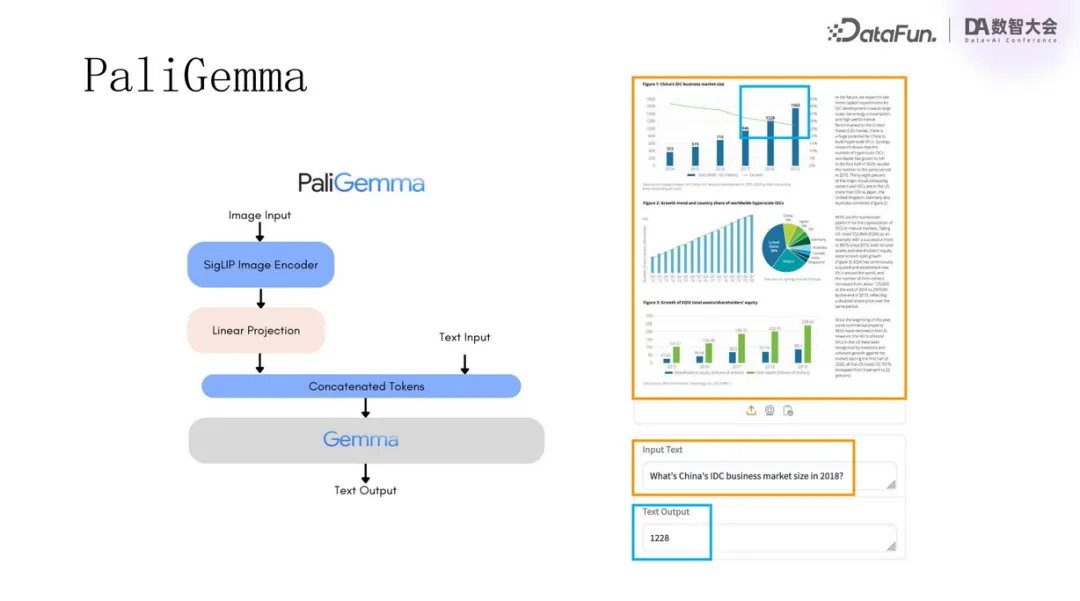

使用 PaliGemma 模型針對 PDF 文檔進行問答,例如提問 2018 年中國 IDC 市場規模有多大,模型直接給出了柱狀圖中的具體數字,非常準確。

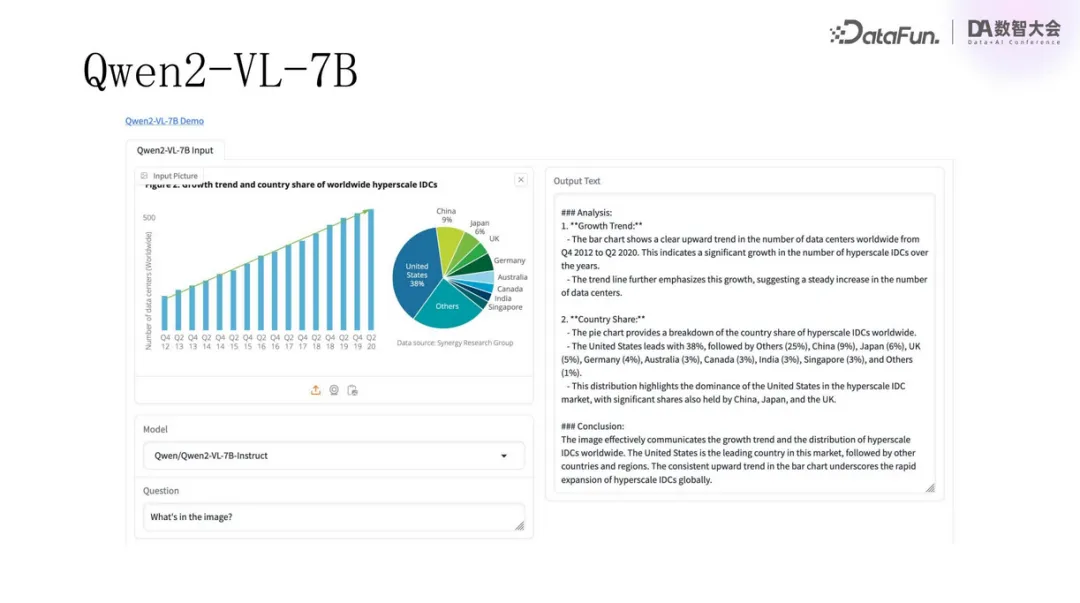

又如,對 Qwen2 模型提問一張圖表中的內容,模型也給出了準確而詳細的解析。

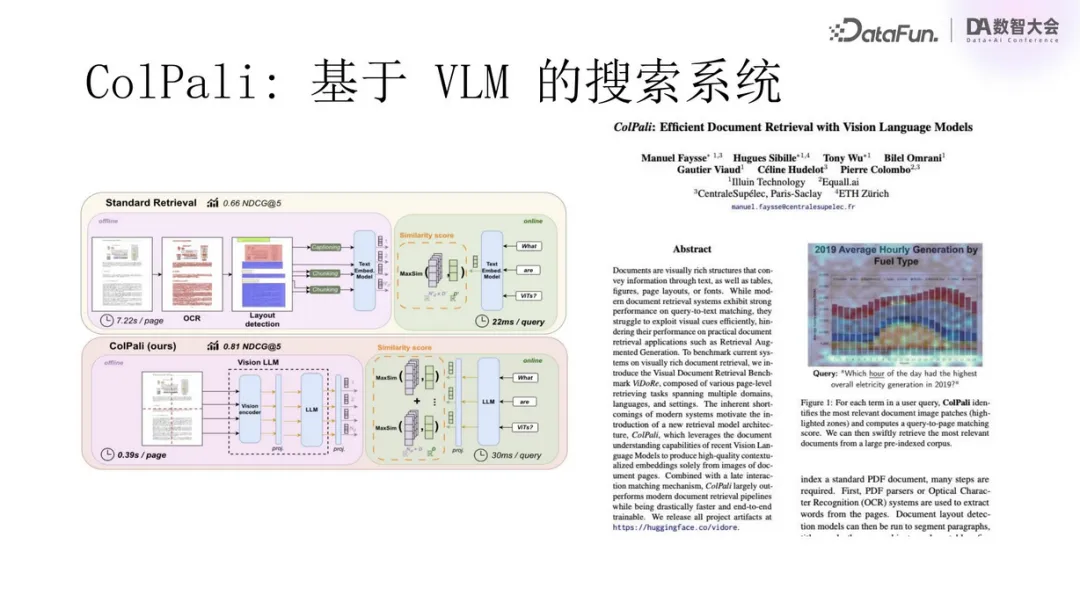

上圖中展示的是一篇利用 VLM 實現多模態搜索的論文,其中用到了 ColPali 方法,即基于上下文的延遲交互。其核心理念是將多模態文檔轉換為多維向量,再運用相似度匹配,交予大型模型生成答案,這一流程與現代 RAG 類似。其最為重要的一點是多模態信息如何表達。傳統搜索引擎使用全文索引,提取關鍵詞進行檢索,然后用倒排索引的方式進行打分。而在 AI 時代,文本采用向量的方式進行表達,可顯著提升信息處理效能。

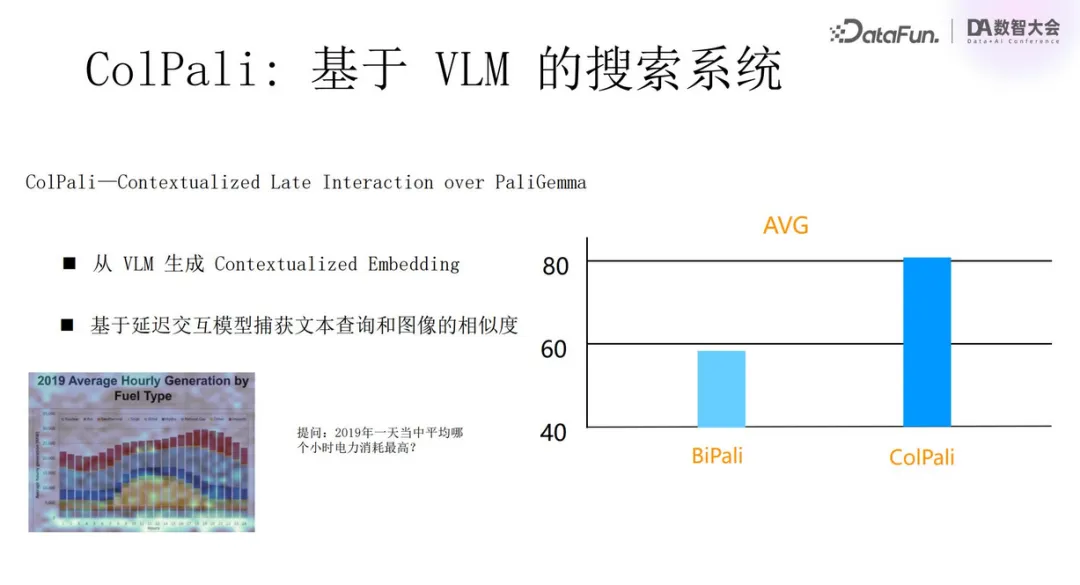

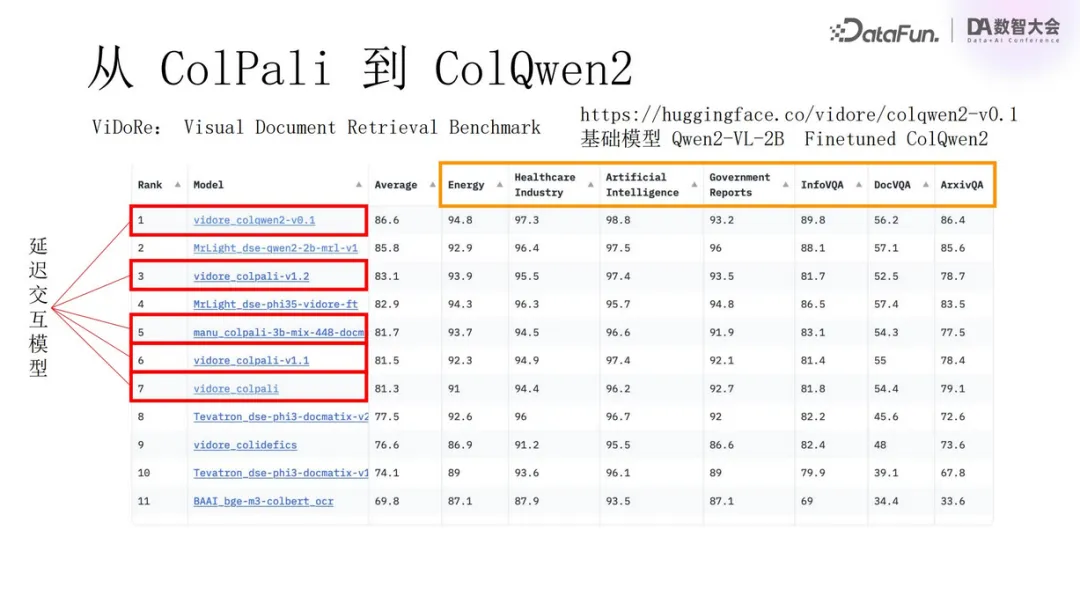

ColPali 系統的評估標準為 nDCG(歸一化折減累積增益),顯示出相比于以往方法,其準確度有了質的飛躍,達到了 80% 以上的水平,較之前低于 60% 的結果有著顯著改進。實驗表明,在特定數據集(如 MLDR)上的表現亦十分出色,實現了接近 70% 的準確度,充分證明了技術的有效性。

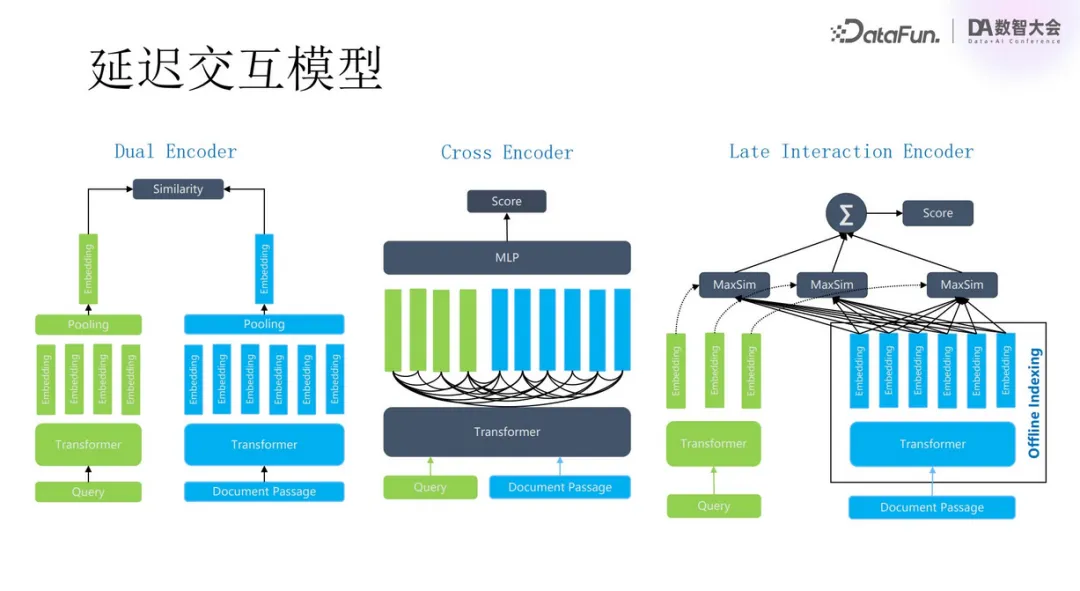

前面提到,ColPali 用到了基于上下文的延遲交互,也就是上圖中最右邊的一種模型。圖中第一種,Dual Encoder,是現在常用的利用向量數據庫做相似度匹配的方式。文檔經模型轉換為一系列向量,之后聚合簡化為單個向量,用于快速查詢和匹配。這種方式的優勢是速度快,效率高。局限性在于信息大量丟失,難以精確定位文檔與查詢間的關聯。

于是,引入了 Reranker,即圖中第二種方式,Cross Encoder。通過初篩獲取候選 chunks 后,采用該方式重新排序,模型根據相關性排序,再作為提示詞。這種方式的問題是需借助 GPU 運行,且文檔數量受限。

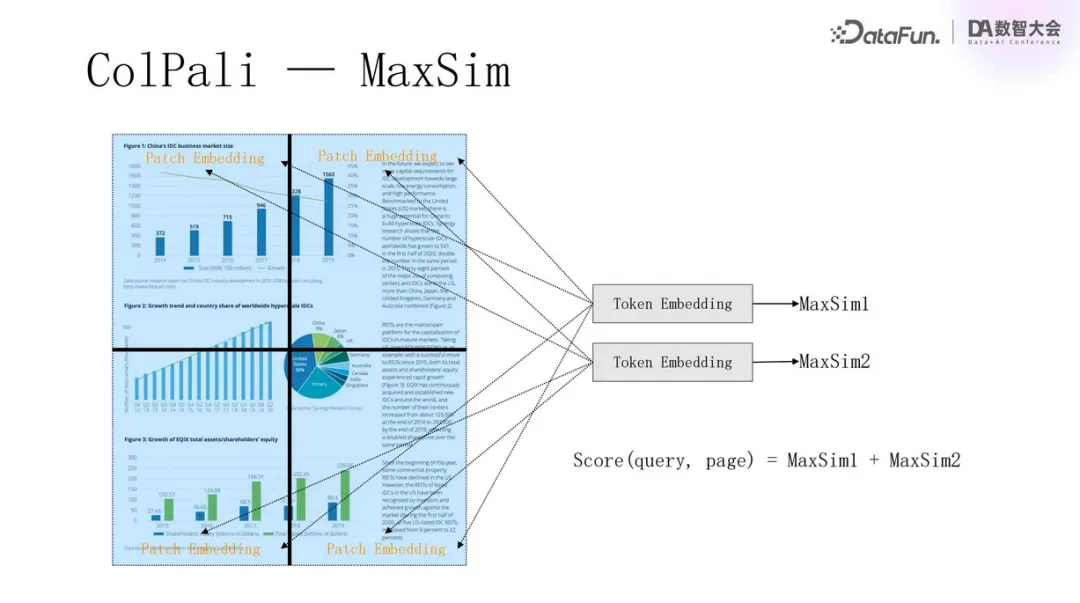

因此出現了延遲交互模型。首先將文檔生成為多向量(或稱為張量)存儲。用戶查詢時,同樣轉化為張量形式,計算內積 MaxSim 得分,而非依賴模型計算。這樣可以顯著減少計算量,待選文檔數量就可以增大,最后召回率就可以得到提升。

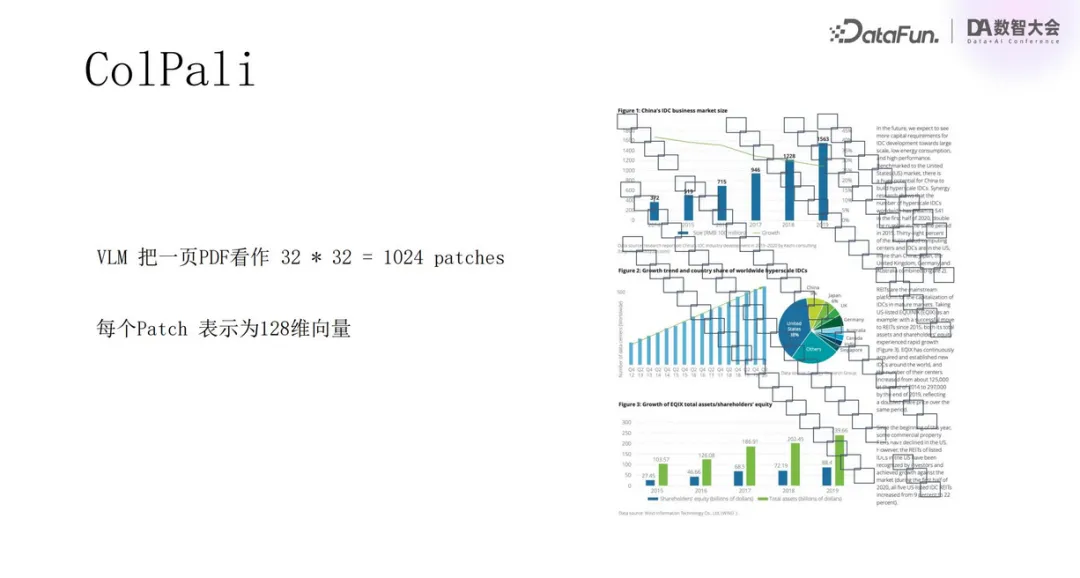

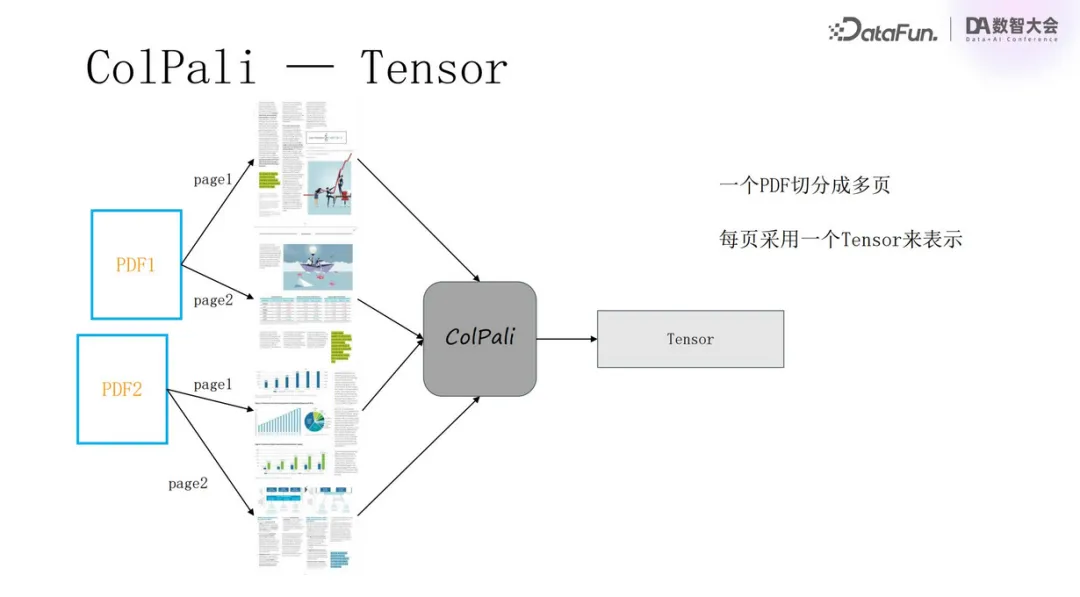

ColPali 就是采用了這種方式。將 PDF 文檔切為 1024 個 patches,每個 patch 使用 128 維向量表示,這樣一個 PDF 文檔就轉成了包含 1024 個向量的張量。

一個 PDF 切分為多頁,每頁采用一個 Tensor 來表示。

計算 MaxSim 得分。

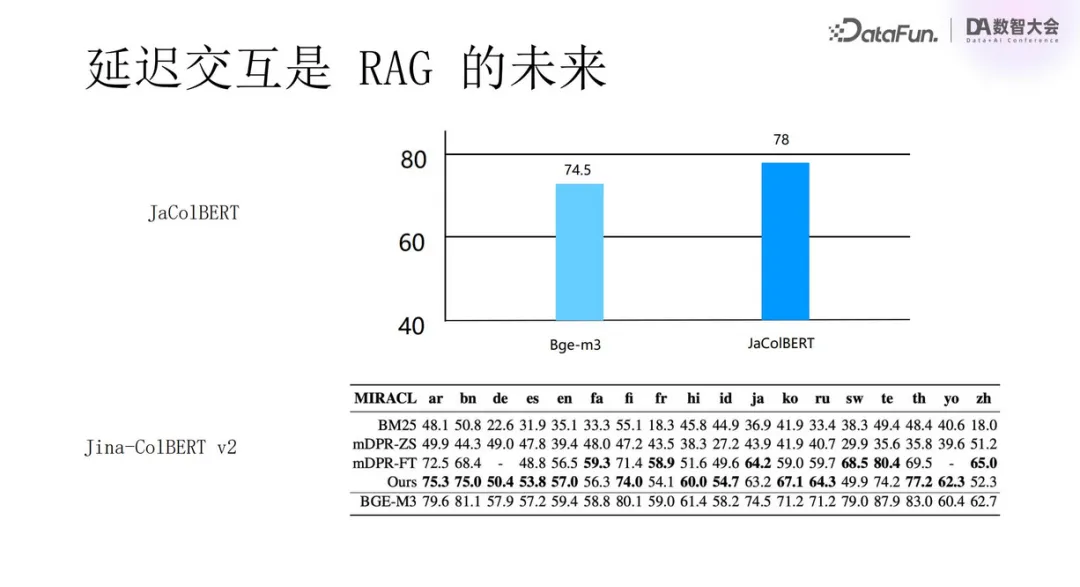

上圖中列出了一些相關模型的效果。它們都是名字中包含了“Col”的版本,相較于之前傳統版本都有著顯著提升。

三、如何 Scale 基于 VLM 的多模態 RAG

接下來探討如何應用基于 VLM 的多模態 RAG。

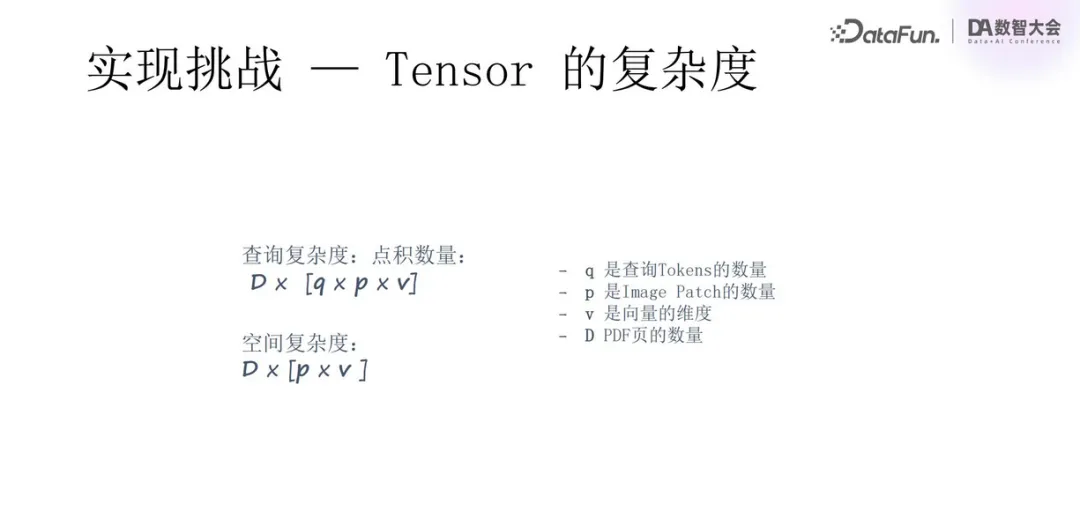

第一個挑戰是數據規模變大,Tensor 復雜度增加。例如前面提到的,用 1024 個向量來表示一個文檔,無論存儲復雜度還是計算復雜度都大幅上升。

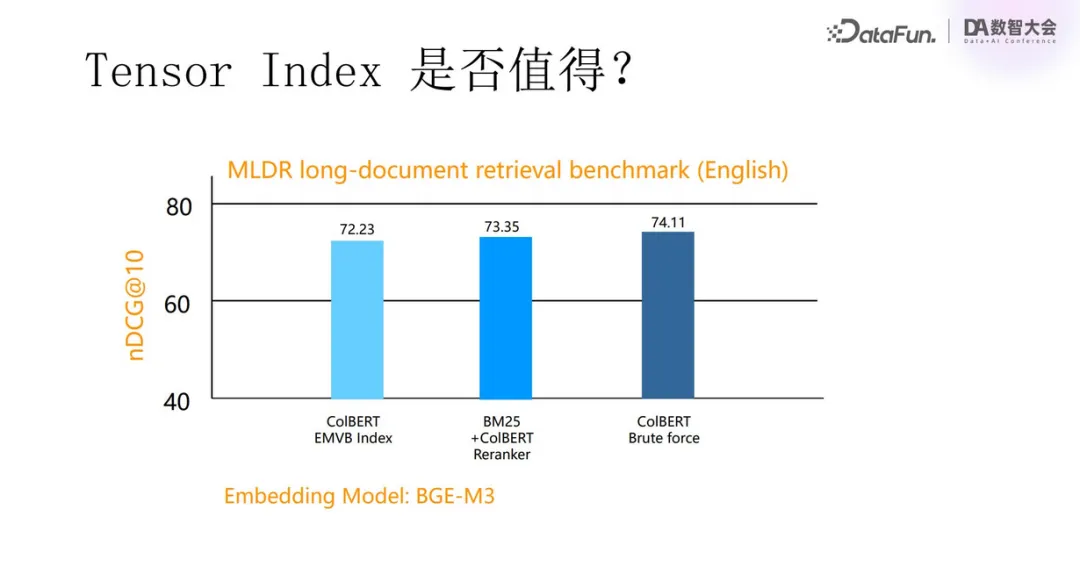

那么在張量之上是否還有必要建索引呢?索引對降低計算規模的作用是有限的。因此我們采取了對張量進行二值化處理等方式來減小數據規模。我們也發現,用張量做重排序,和直接用張量作為第一次搜索排序,其準確度是相近的。

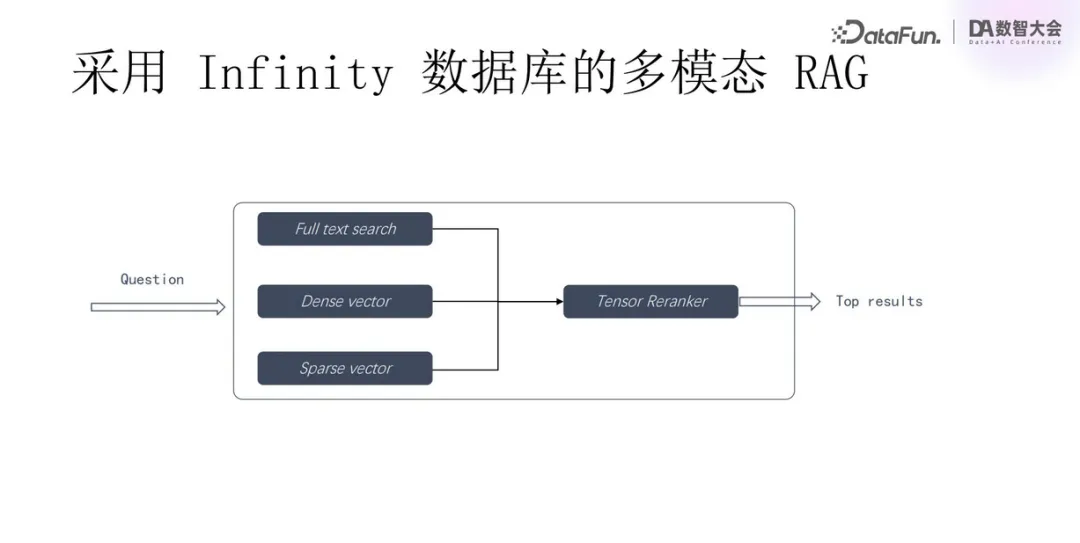

因此,利用 Infinity 數據庫,第一輪搜索采用全文搜索、稠密向量搜索和稀疏向量搜索,搜索得到的結果再經過 Tensor Reranker 重排序。

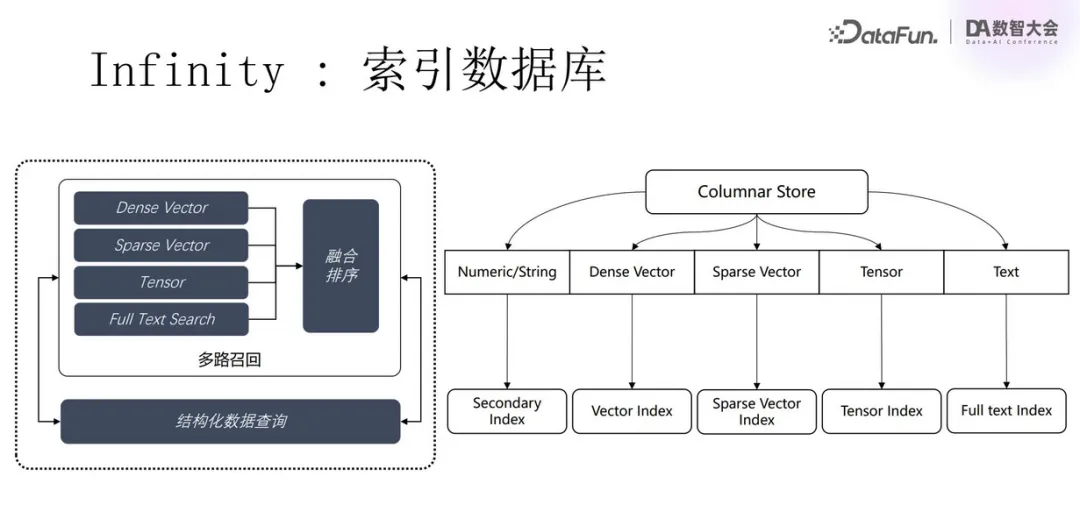

Infinity 數據庫針對結構化數據、稠密向量、稀疏向量、張量、全文搜索都有對應的索引,還可以進行融合搜索。

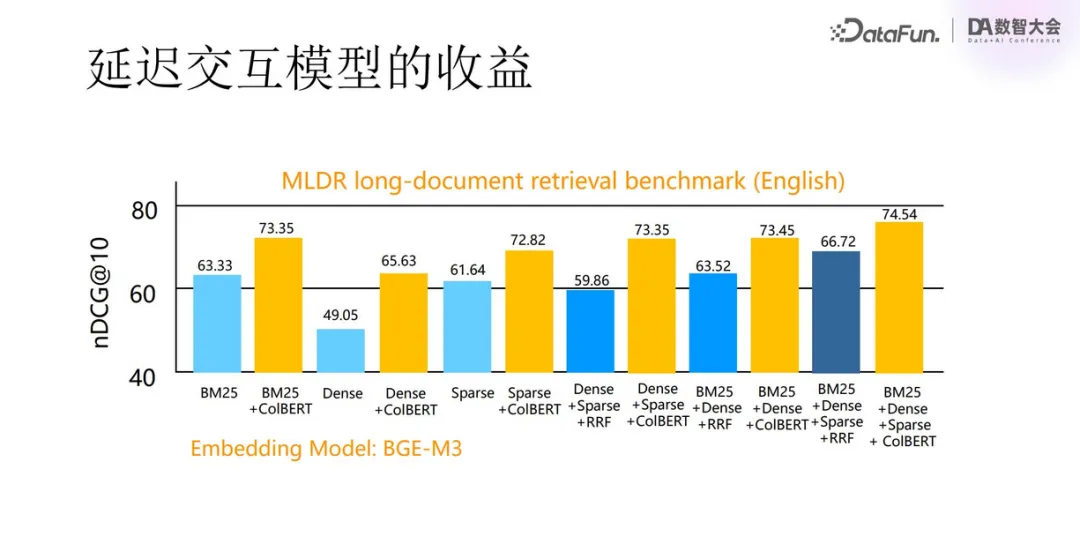

從上圖展示的測試結果中可以看到,藍色部分是沒有采用張量方式的搜索,BM25 是全文搜索,效果較好,而現在常用的稠密向量搜索效果最差。我們還對搜索方式兩兩進行排列組合,結果發現,組合和類型越多,搜索準確度越高。黃色是加上了張量重排序的搜索,可以看到準確度得到了顯著提升。

延遲交互將是 RAG 的未來發展趨勢。JaColBERT 和 Jina-ColBERT v2 都展現出了積極的進展。

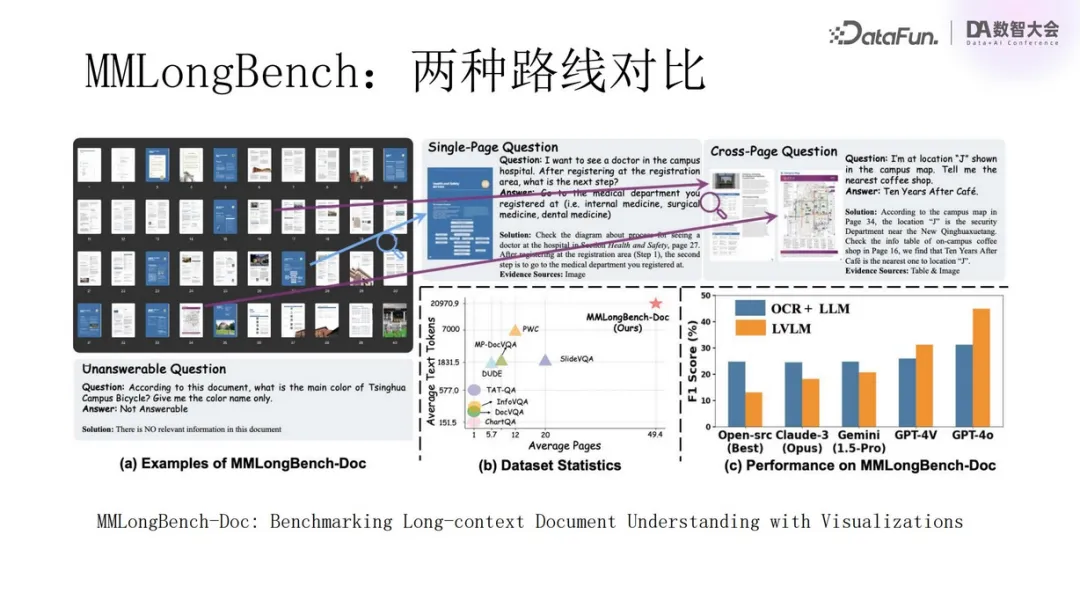

四、如何選擇技術路線

上圖所示的工作中認為視覺語言模型的路線更具優勢。但我們認為雕花路線和視覺語言模型各有所長,對于抽象圖像較多的文檔更適合采用 VLM 的方式,相反則更適合傳統手段。

兩種路線將長期并存:

- 基于 Transformer 的新一代 OCR,針對多模態文檔的提取精度更加準確。

- OCR 和 VLM 可以長期共存。

- 支持 Tensor 的延遲交互將是未來多模態 RAG 的標配選擇。

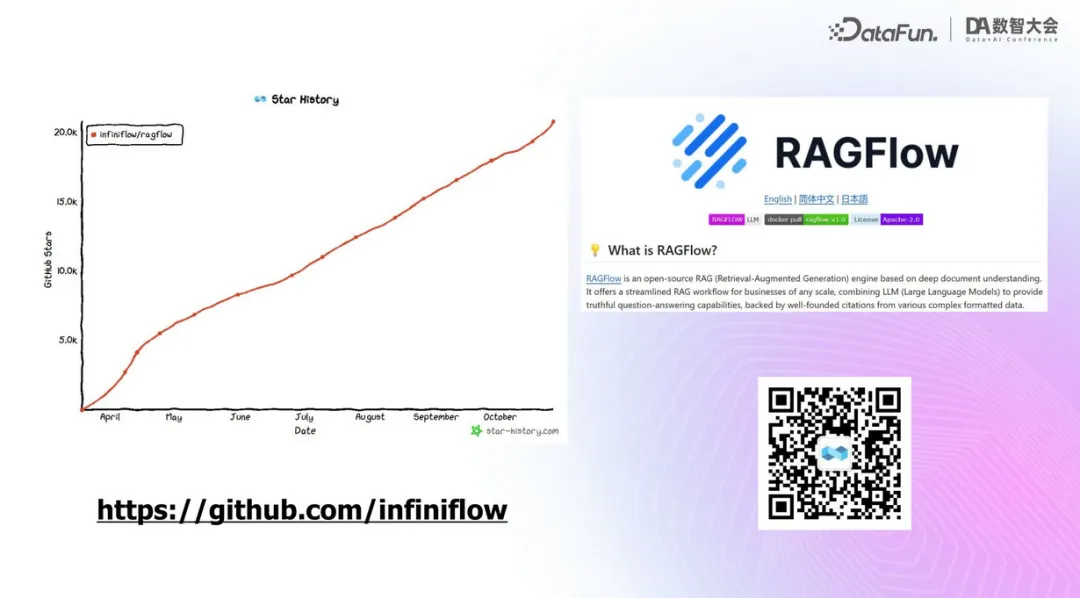

最后,歡迎大家關注 RAGFlow。

五、問答環節

Q1:如何應對多模態可能比自然語言擁有更大狀態空間的挑戰?是否有嘗試標準化處理?

A1:將圖表映射為 Excel 是一種理想化的處理方式,但難度非常大,首先已有的大量文檔無法都轉為 Excel,另外 Excel 的美觀性和展示效果還是有欠缺的。

Q2:為何選擇張量而非向量計算?

A2:向量維度固定,而張量尺寸靈活,適應變長數據。向量數據庫無法直接處理變長數據,故轉向張量計算。