Just keep scaling!思維鏈作者Jason Wei 40分鐘講座剖析LLM擴展范式

關注 AI 領域的人對 Jason Wei 這個名字一定不陌生。他是 OpenAI 的一位資深研究科學家,也常在 OpenAI 的發布活動中露臉。更重要的是,他是思維鏈概念開山之作《Chain-of-Thought Prompting Elicits Reasoning in Large Language Models》的第一作者。

圖片

圖片

他本科畢業就加入了谷歌。在那里,他推廣了思維鏈提示概念,共同領導了指令微調的早期工作,并和 Yi Tay、Jeff Dean 等人合著了關于大模型涌現能力的論文。2023 年初,他加入了 OpenAI,參與了 ChatGPT 的構建以及 o1 等重大項目。他的工作使思維鏈提示、指令微調和涌現現象等技術和概念變得廣為人知。

去年 11 月 20 日,Jason Wei 在賓夕法尼亞大學計算機與信息科學系 Mayur Naik 教授的「CIS 7000:大型語言模型(2024 秋季)」課程中進行了一場約 40 分鐘的客座講座,主題為「大型語言模型的擴展范式」。Jason Wei 從擴展(scaling)的定義談起,介紹了 LLM 的擴展范式從規模擴展到以思維鏈和強化學習為代表的推理擴展的轉變。真可謂內容豐富、干貨滿滿!

近日,Naik 教授在自己的 YouTube 頻道放出了 Jason Wei 的演講視頻和幻燈片。機器之心整理了其中的主要內容。

- 視頻地址:https://www.youtube.com/watch?v=yhpjpNXJDco

- 幻燈片:https://llm-class.github.io/slides/Jason_Wei.pdf

以下是演講內容的概要:

一、擴展的定義與重要性

- 擴展一般是指通過增加模型規模、數據量和 GPU 數量來持續改進 AI 能力。不過,Jason Wei 給出了一個更具體的定義:擴展就是你把自己放在一個可以沿著連續軸移動并期望獲得持續改進的情況下。

- 雖然擴展需要克服技術和心理挑戰,但它是 AI 進步的關鍵引擎,并將繼續主導這個領域的發展方向。

二、擴展范式一:下一詞預測(2018 年至今)

- 下一詞預測實際上是一個大規模多任務學習過程。

- 通過預測下一詞,模型可以學習語法、世界知識、情感分析、翻譯等多種能力。

- 你可以把下一詞預測的準確率看作多個子任務的加權和,這樣你就能理解為什么會有所謂的「涌現」現象。

- 僅僅通過下一詞預測也許可以實現 AGI,但會非常困難,我們需要繼續大量擴展。

三、擴展范式二:基于思維鏈擴展強化學習

- 純粹的下一詞預測在處理復雜任務時存在局限性。

- 思維鏈(CoT)讓模型能夠像人類一樣展示推理過程。

- OpenAI 通過強化學習優化了模型的思維鏈能力,使其能更好地解決復雜問題。

四、AI 文化的變革

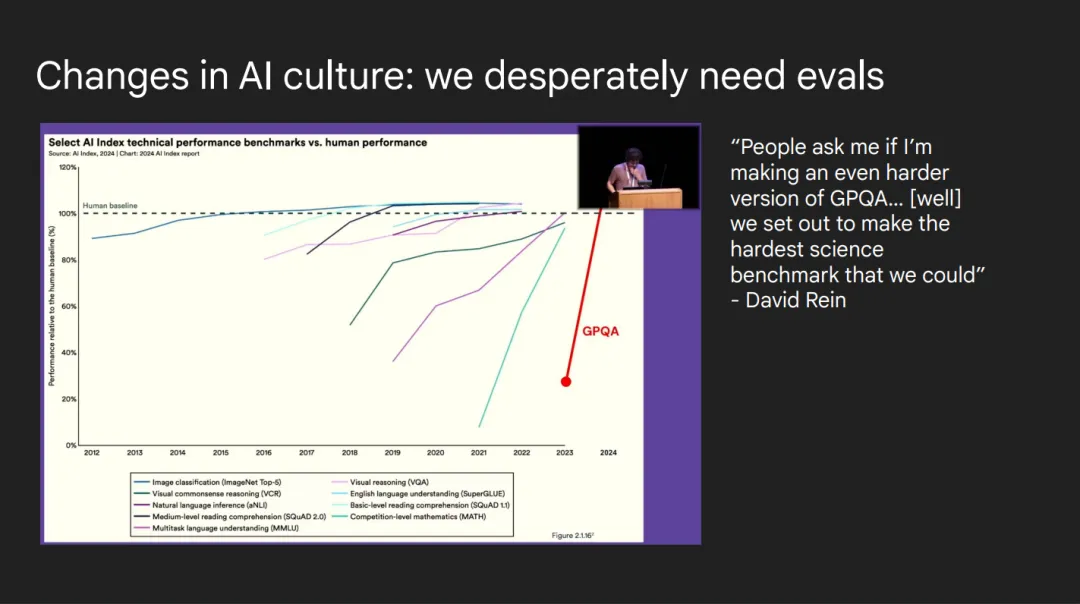

- 研究重點從改進算法轉向改進數據質量。

- 基準測試被「飽和」的速度太快。

- 從單任務模型朝著高度多任務模型(highly multi-task models)的方向轉變。

- 智能和用戶體驗是兩個可以分別改進的維度。

- 需要更大的團隊合作來推進 AI 發展。

五、未來展望

- AI 在科學和醫療健康方面的應用前景。

- 提高事實準確性,減少虛假信息。

- 發展多模態 AI 能力。

- 增強工具使用能力。

- 擴大 AI 應用范圍。

Jason Wei 強調,盡管 AI 在過去五年取得了巨大進步,但通過持續擴展,未來五年還會有更大的發展空間。他用「just keep scaling」(繼續擴展)作為演講的結束語,表達了對擴展策略的信心。

以下是 Jason Wei 的演講內容圖文版。

擴展是 AI 進步的引擎

并且還將發揮主導作用

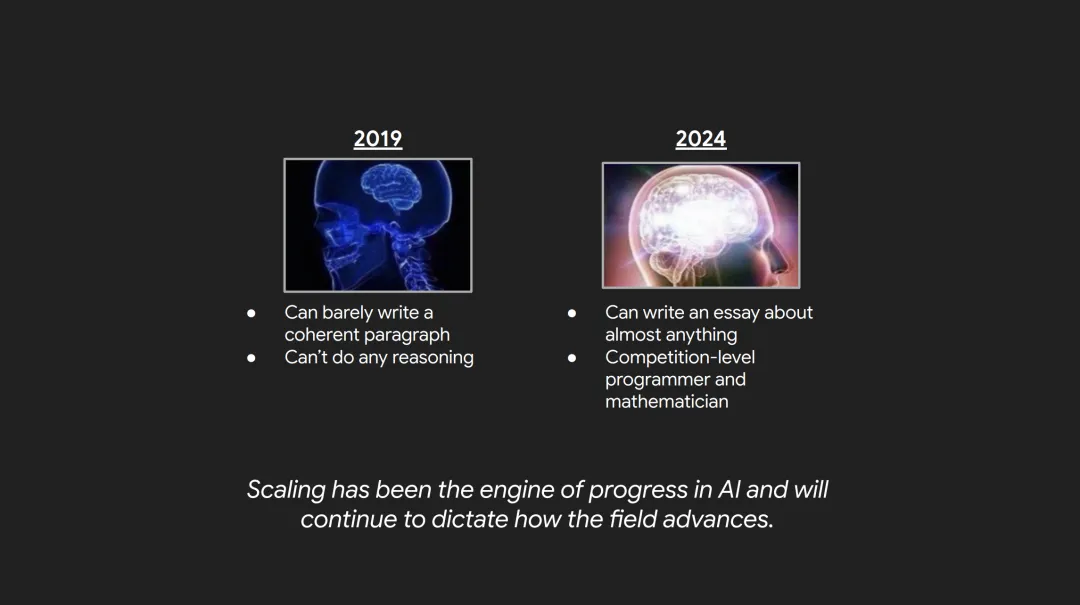

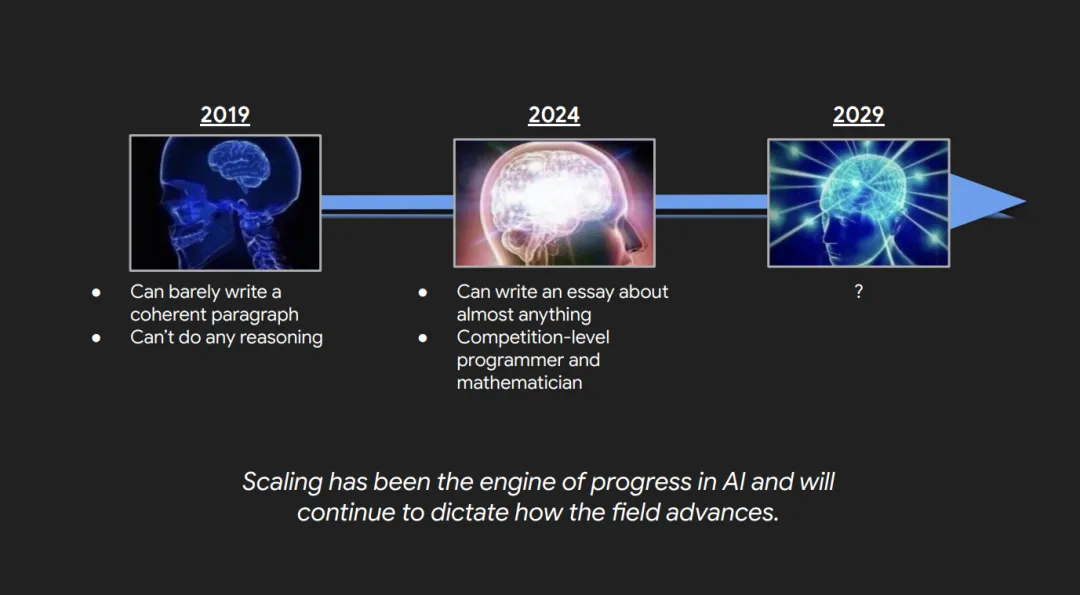

今天的主題是大型語言模型的擴展范式。首先我想說,在過去五年里,AI 取得了驚人的進步。就在 5 年前的 2019 年,AI 幾乎無法寫出連貫的段落,也無法進行任何推理。而今天,AI 可以寫出幾乎任何主題的文章,也成為了競賽級別的程序員和數學家。那么我們是如何如此快速地達到這一步的呢?

我今天要闡述的觀點是擴展一直是推動 AI 進步的引擎,并將繼續主導這個領域的發展方向。

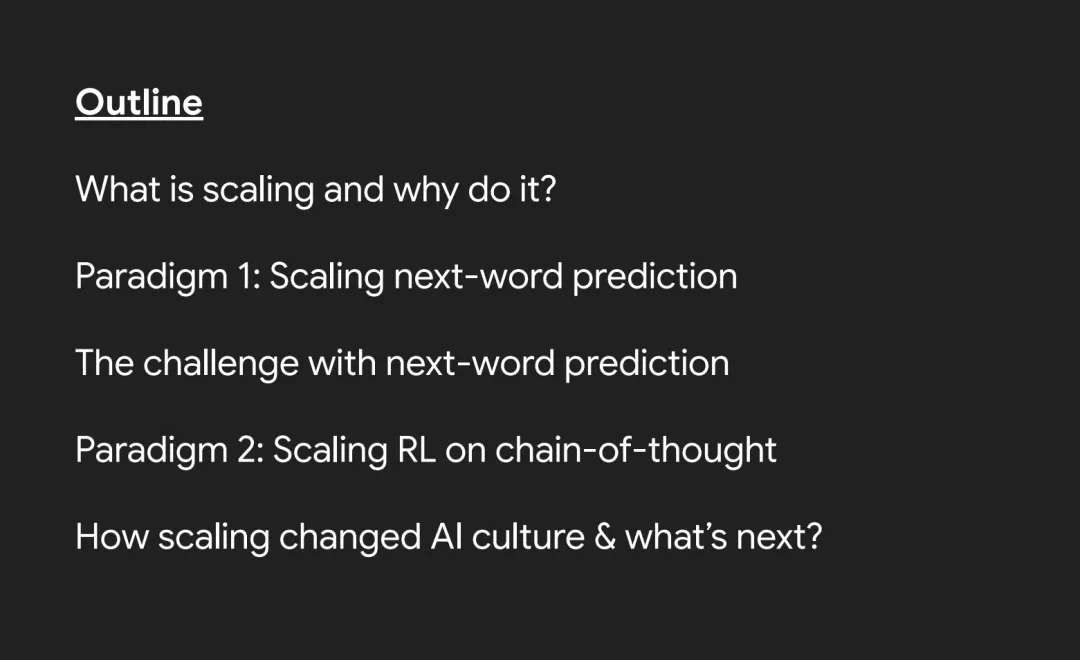

這里是一個簡短的大綱 —— 我會講大約 40 分鐘,之后很樂意回答問題。首先我會講什么是擴展以及為什么要做擴展。然后我會講第一個擴展范式,即下一詞預測。我會講這個范式面臨的挑戰。接著我會講我們最近進入的第二個范式,即在思維鏈上進行強化學習。最后我會總結 AI 文化是如何被擴展改變的,以及我們接下來想看到什么。

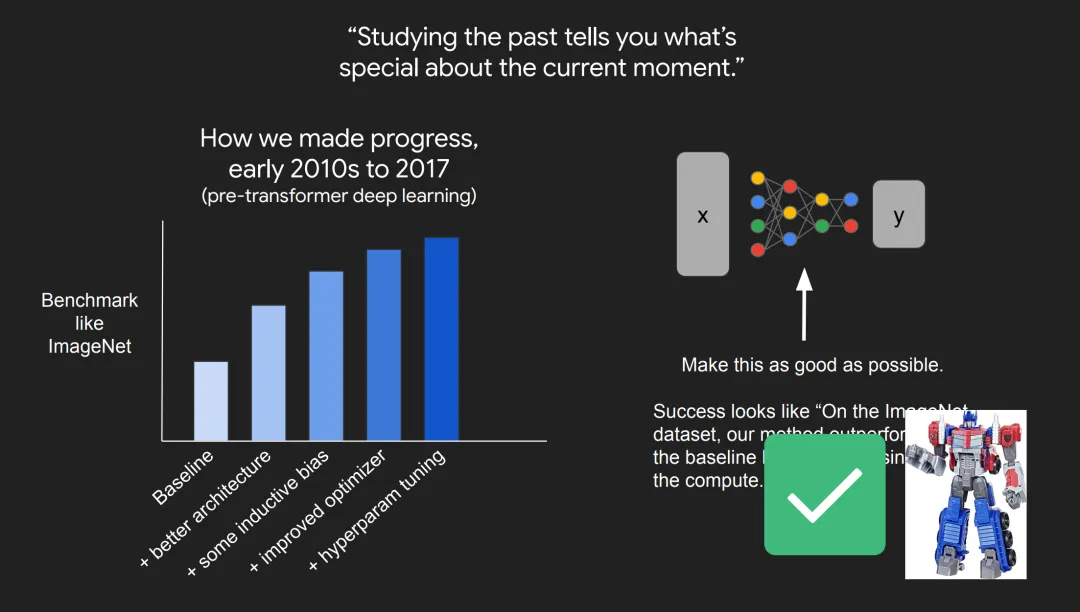

我想先花幾分鐘講講在第一個擴展范式之前我們在做什么。原因是,除非你研究過歷史,否則你可能不會意識到當前時刻有什么特別之處。

我認為從 2010 年到 2017 年,也就是在 Transformer 之前的深度學習時代,AI 進展是這樣的:你會有一個基準測試,比如 ImageNet,然后你會嘗試各種方法來改進基線表現。比如可能添加更好的架構,添加一些歸納偏置,構建更好的優化器,進行超參數調優。所有這些東西疊加在一起,讓你能夠提升在基準測試上的表現。

比如你有一些要學習的 XY 關系,目標就是盡可能好地學習這個關系。在 2017 年之前,我們可能這樣描述一項成功的研究:「在 ImageNet 數據集上,我們的方法用一半的計算量就把基線性能提升了 5%。」

但是隨著 Transformer 的出現,我們有了一個很好的方法來學習各種不同類型的 XY 關系。如果我們不再受限于學習本身,那我們該做什么呢?

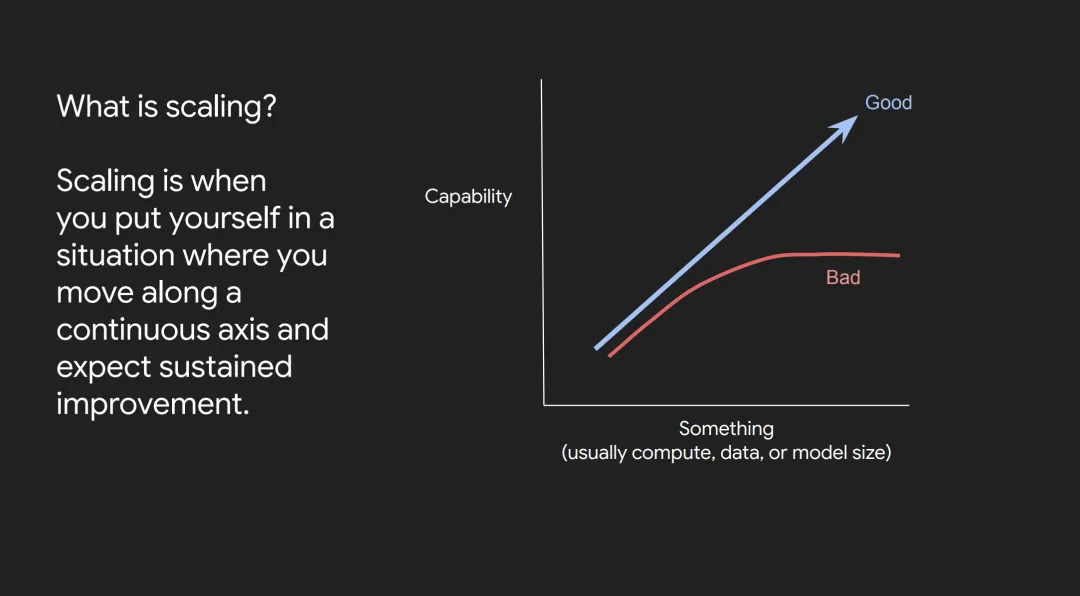

事實證明,答案就是擴展。擴展簡單來說就是訓練更大的模型,使用更多的數據和更多的 GPU。但我這里有一個更具體的定義:擴展就是你把自己放在一個可以沿著連續軸移動并期望獲得持續改進的情況下。

這個定義中有一個重要的部分,即擴展是一個主動的過程。你必須把自己放在這個情況下,這通常涉及解決一些瓶頸或了解你的設置的一些細節,才能真正讓擴展發揮作用。

這是一個典型的擴展圖表。你的 x 軸通常是計算量、數據量或模型大小,y 軸是你試圖改進的某種能力。你想看到的是這條藍線,隨著你沿 x 軸移動,性能持續提升。你想避免的是這條紅線,在 x 軸的某個閾值之后,性能就飽和了,不再提升。

簡單來說,就是這樣:

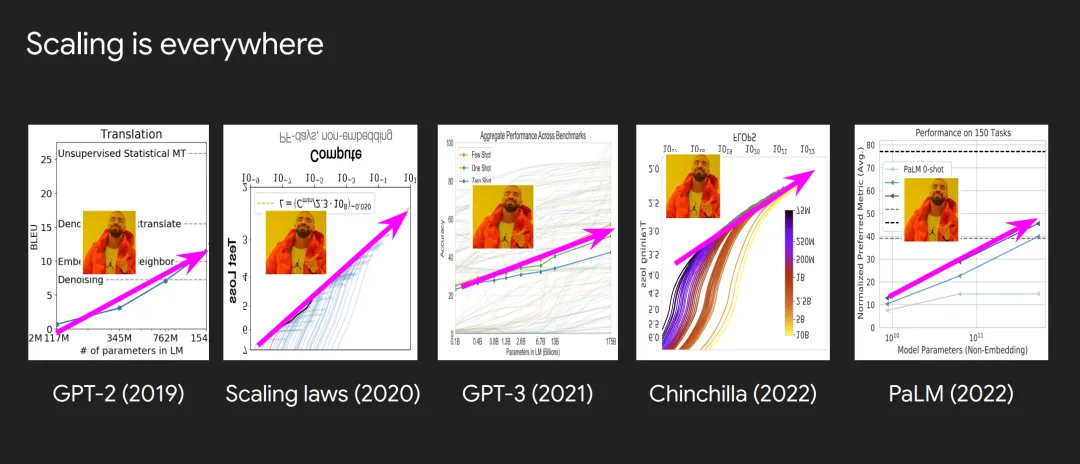

如果你看大語言模型領域的論文,你會發現擴展無處不在。這里有一些來自 OpenAI、Google Brain、DeepMind 的論文,你可以在這些不同的論文中找到這些擴展圖表。有時你需要把圖表上下翻轉才能找到它,因為畫的是損失而不是性能。這些圖表真的是擴展的標志,它們可以非常有力。至少在 OpenAI,如果你帶著這樣一個圖表走進會議室,會議結束時你會得到你想要的。

需要注意的是,我們現在把擴展范式視為理所當然,但在當時擴展是非常不明顯的。它之所以不明顯有很多原因。

首先是伴隨著規模而來的技術和運營挑戰。首先,分布式訓練需要大量專業知識,你需要雇傭很多基礎設施工程師來構建這個分布式訓練系統。其次,你需要機器學習研究人員來對抗可能出現的損失發散和硬件故障。第三點是計算非常昂貴。

除了技術挑戰之外,還有一些心理挑戰,這讓擴展在當時變得相當困難。一個心理挑戰是研究人員喜歡歸納偏置。對于如何改進算法有一個假設,然后真的看到任務性能提升,這其中有一種固有的快樂。所以研究人員喜歡做那種改變算法的工作。

第二,總是有一種論點說人類學習比擴展效率高得多。你知道,一個人不需要讀 GPT-3 訓練時讀過的那么多文本就能學會寫一段英語。所以有一個問題是:如果人類能做到,為什么機器需要從這么多數據中學習?

第三,長期以來,科學研究的激勵機制和擴展所需的工程工作并不完全匹配。你知道,當你向會議提交論文時,他們想看到一些「創新」,而不僅僅是你把數據集做得更大或者用了更多 GPU。

那么,既然擴展如此具有挑戰性,我們為什么要做擴展呢?

我想說,如果你不依賴擴展范式,那么幾乎每一個改進都需要新的創造力。你必須投入研究人員來實現模型的進步,而且不一定能成功,這需要一定程度的創造力。

第二個挑戰是,我們希望 AI 能做很多任務,如果你想在每個任務上單獨訓練 AI,那將是很大的挑戰。

而在以擴展為中心的 AI 中,從定義上來說,你有一個可靠的方法來提升模型的能力。現在重要的是要注意,這通常非常昂貴。你會看到很多擴展圖表中 x 軸是對數刻度的,所以提升性能實際上是極其昂貴的。但好消息是,如果你的能力度量(也就是 y 軸)非常通用,那么這種極端的財務投資通常可以證明是合理的。

當然,談到擴展就不能不提 Rich Sutton 的這篇文章《The Bitter Lesson》。如果你還沒讀過,我推薦閱讀,寫得非常好。文章的主要觀點是利用計算能力的通用方法是最有效的,能擴展的方法最終會勝出。

擴展范式一:預測下一詞

現在我想談談第一個擴展范式,也就是預測下一詞。這個范式始于 2018 年,我們今天仍在繼續,它非常簡單 —— 就是在預測下一詞方面變得非常非常擅長。

我認為要完全理解這一點并不簡單。問題是為什么僅僅通過預測下一詞就能得到這么多?我的答案是:預測下一詞實際上是一個大規模的多任務學習。

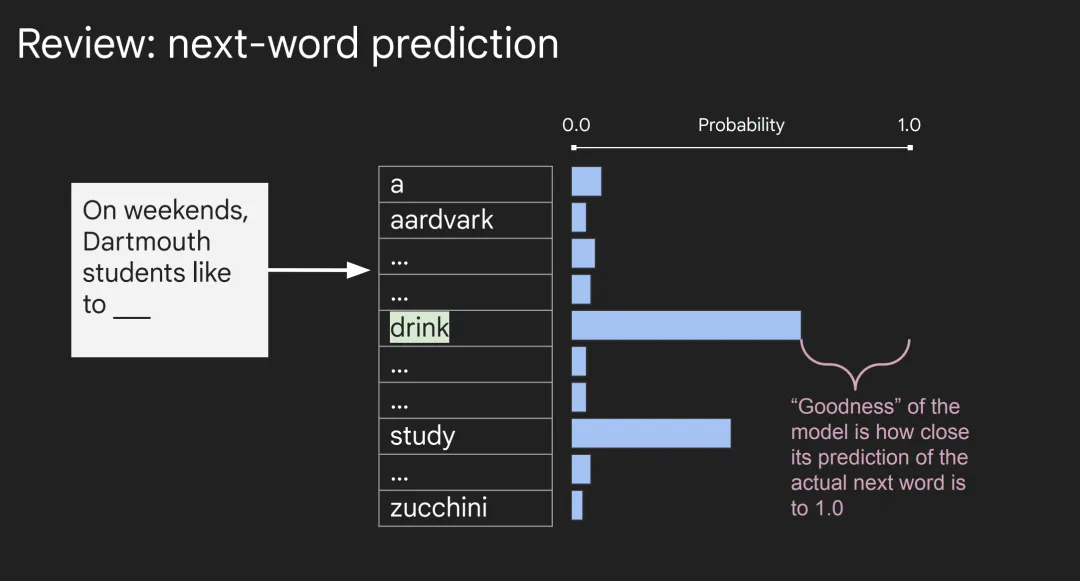

讓我們快速回顧一下下一詞預測是如何工作的。你有一個句子,比如「 On weekends, Dartmouth students like to ___ 」。然后語言模型對詞匯表中的每個詞 —— 從「a」、「aardvark」一直到「zucchini」—— 都分配一個概率。然后模型的好壞取決于其對實際下一詞的預測有多接近 1.0。

在這個例子中,假設「drink」是實際的下一詞。當語言模型從中學習時,它會試圖增加「drink」的概率,并降低其他所有詞的概率。

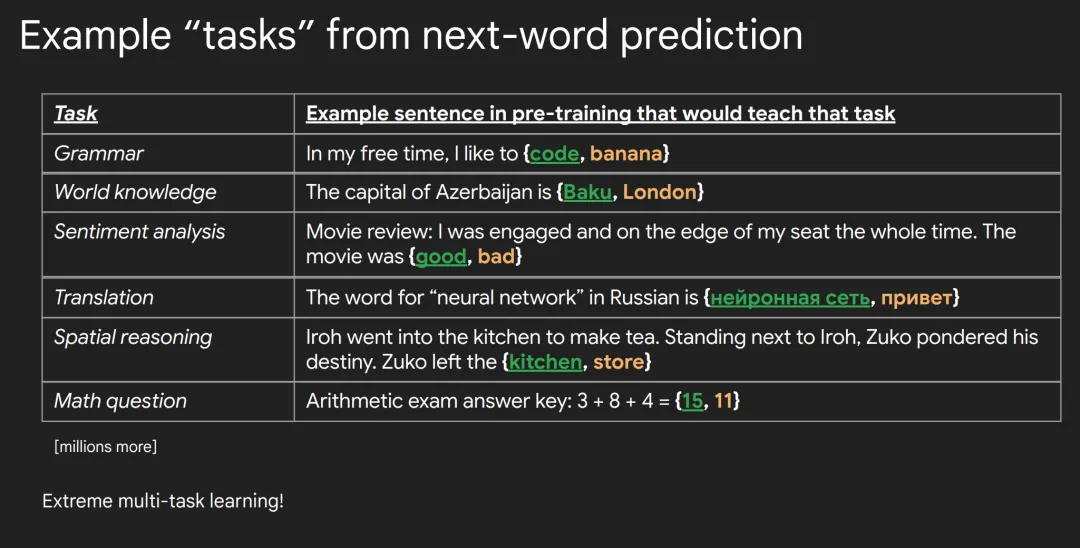

我想展示一些例子來說明僅僅通過在足夠大的數據庫上做下一詞預測就能學到什么。

首先,模型肯定會很好地學習語法。比如在預訓練數據中有一句話說「In my free time, I like to {code, banana} 」,下一詞是「code」而不是「banana」,所以語言模型學會了在這里動詞應該比名詞有更高的權重。

模型會學到世界知識。比如互聯網上可能有一句話說「The capital of Azerbaijan is {Baku, London} 」,然后模型學會了給「Baku」比「London」更高的權重,所以模型學到了一些關于這個世界的知識。

模型可以學習經典的自然語言處理任務,比如情感分析。互聯網上某處可能有一句話說「I was engaged and on the edge of my seat the whole time. The movie was {good, bad} 」,然后通過學會給「good」比「bad」更高的權重,語言模型學到了一些關于情感分析的東西。

模型可以學習如何翻譯。預訓練中可能有一句話說「The word for “neural network” in Russian is {нейронная сеть, привет} 」,然后通過給正確的俄語單詞更高的權重,模型學到了一些關于俄語的知識。

模型可以學習空間推理。互聯網上可能有一句話說「Iroh went into the kitchen to make tea. Standing next to Iroh, Zuko pondered his destiny. Zuko left the {kitchen, store} 」,然后通過給「kitchen」比「store」更高的權重,模型學到了一些關于 Zuko 在哪里的空間推理。

最后,模型甚至可以期望學習數學這樣的東西。訓練中可能有一句「Arithmetic exam answer key: 3 + 8 + 4 = {15, 11} 」,然后通過學會正確預測 15,模型學到了一些數學知識。

你可以想象,還有數百萬種類似的任務。通過在龐大的語料庫上僅訓練下一詞的預測,模型實際上是在進行極其大量的多任務學習。

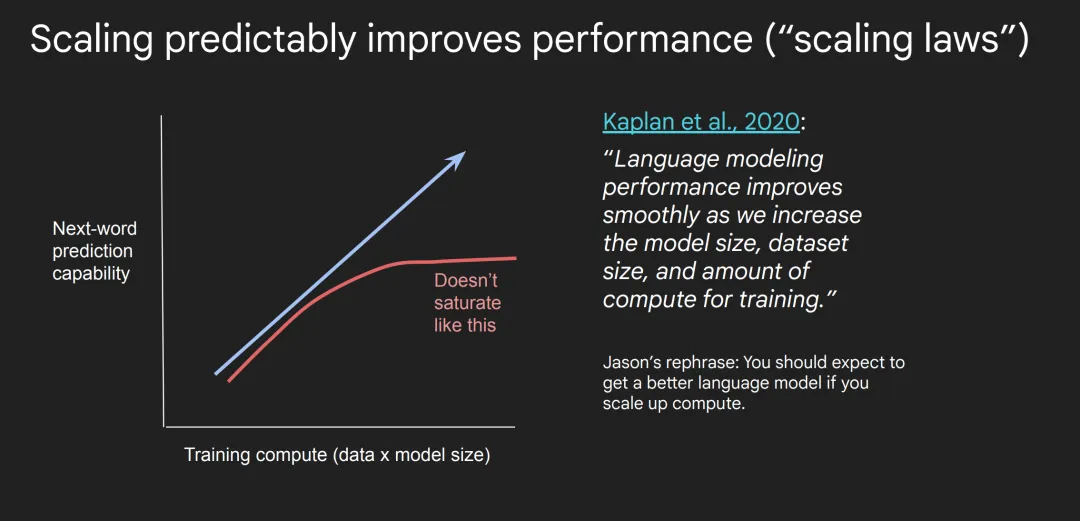

在 2020 年,Kaplan 等人發表的一篇論文普及了這種擴展范式。它普及了 scaling law 這個概念,這個概念主要是說,語言模型預測下一詞的能力或性能會隨著我們增加模型大小、數據集大小和訓練計算量而平滑提升。

這里 x 軸是訓練計算量,也就是你訓練的數據量乘以模型大小,你可以看到模型預測下一詞的能力在提升。

之所以稱之為 scaling law,是因為他們可以看到這個趨勢跨越了 7 個數量級。他們用 7 個數量級的計算量訓練語言模型,發現這個趨勢一直持續。

這里最重要的是它不會飽和。這點之所以重要,是因為如果你擴大計算量,你可以期望得到一個更好的語言模型。這某種程度上給了研究人員繼續擴大規模的信心。

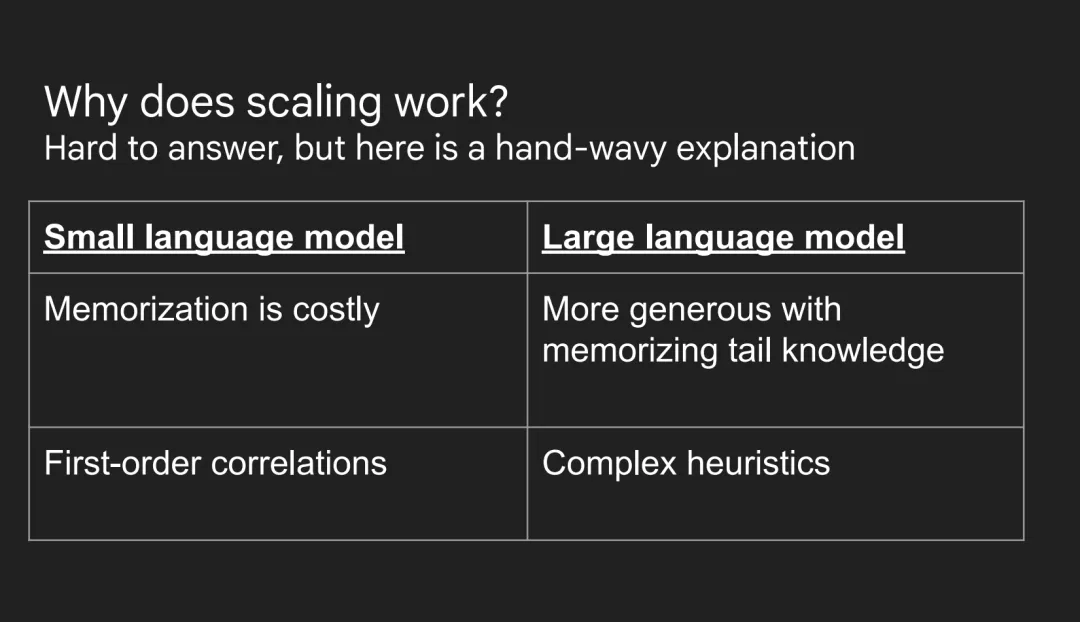

這里有一個自然的問題:為什么擴展效果這么好?作為一個領域,我認為我們還沒有一個很好的答案,但我可以給出一個大致的解釋,說明擴展可以帶來的兩個優勢。

首先,如果是一個小型語言模型,那它的記憶是非常昂貴的。因為參數很少,你必須非常謹慎地選擇要在參數中編碼什么樣的知識。而大型語言模型有很多參數,所以在學習長尾知識和記憶大量事實方面可以更慷慨。

其次,如果是一個小型語言模型,它在單次前向傳播中的能力要低得多。所以它可能主要學習一階相關性。而如果是一個大型語言模型,它在單次前向傳播中會獲得更多的計算能力,當它有額外的計算能力時,學習復雜性要容易得多。

現在你可能會說,如果 scaling law 如此可預測,為什么這么多人對 ChatGPT 在擴展范式中的成功感到驚訝?我的回答是,下一詞預測實際上是大規模的多任務處理,而且在不同任務上的性能提升速度各不相同,所以一些能力的涌現可能會讓人感到驚訝。

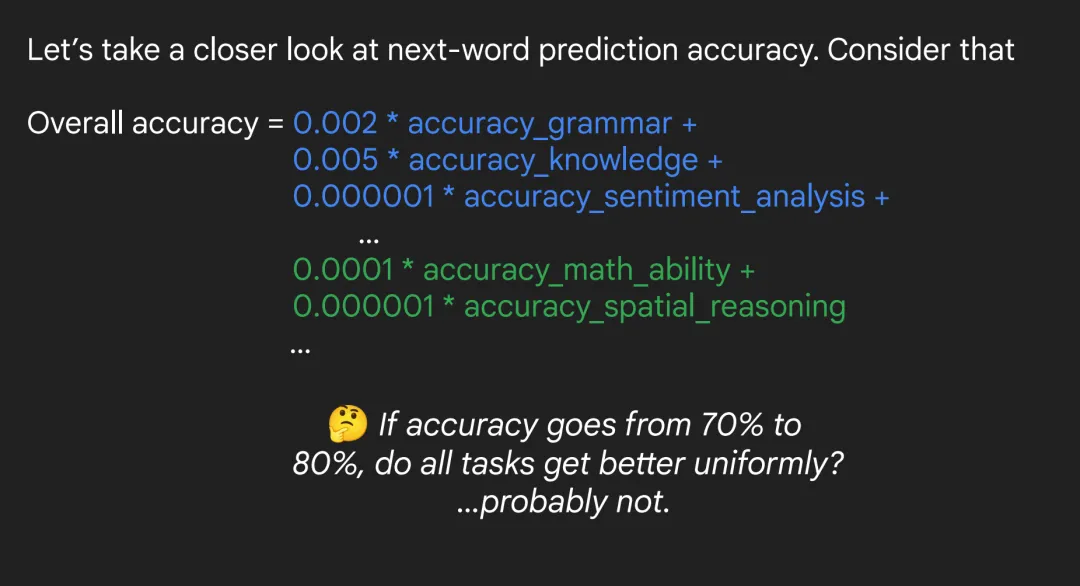

我建議你這樣看待下一詞預測的準確率:它是很多個體子任務的加權和。這些數字是我編的,但你可以把總體準確率計算為:某個小系數乘以語法準確率,加上某個小系數乘以世界知識準確率,加上情感分析、數學能力、推理等等。

當你這樣看時,你可以問自己這個問題:如果準確率從 70% 提升到比如 80%,是所有任務都均勻提升嗎?比如語法從 70 提升到 80,數學也從 70 提升到 80?

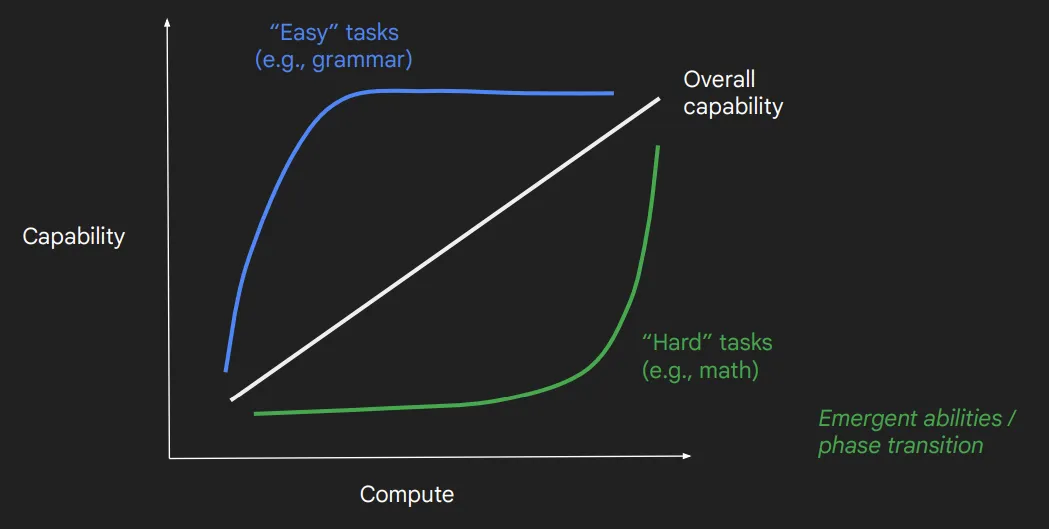

我認為可能不是這樣。你可以這樣看:總體能力在平滑提升。對于一些簡單的任務,在某個點之后你實際上并沒有提升性能。例如,GPT-3.5 基本上已經有完美的語法了,所以當你訓練 GPT-4 時,你可能實際上并沒有優化語法方面的損失。

另一方面,你可能有一些任務出現了能力的大幅提升。比如,你可以說 GPT-3 和 GPT-2 的數學能力都很差,甚至不能做算術,但 GPT-4 真的很擅長數學。所以你可能會看到數學能力以這種方式提升。

人們經常用「涌現能力」或「相變」這兩個術語來描述這種現象。

可以看到,這里有兩個階段:在閾值之前,模型的性能不佳或增長平緩;而一旦超過某個閾值,模型的性能就會迅速提升。下面展示了一個簡單示例。

這里的提示詞是想要把一句話翻譯成西班牙語。可以看到,圖中展示了三個模型的輸出結果。ada 和 babbage 只是重復了輸入,因為它們并不真正理解這里應該執行翻譯。而最大的模型 curie 突然就學會了完美地完成這個任務。

重點在于,如果你只訓練了 ada 和 babbage,并試圖預測 curie 能否完成這個任務,那么你可能會得到消極的答案,認為 curie 也無法做到。但實際情況卻并非如此。

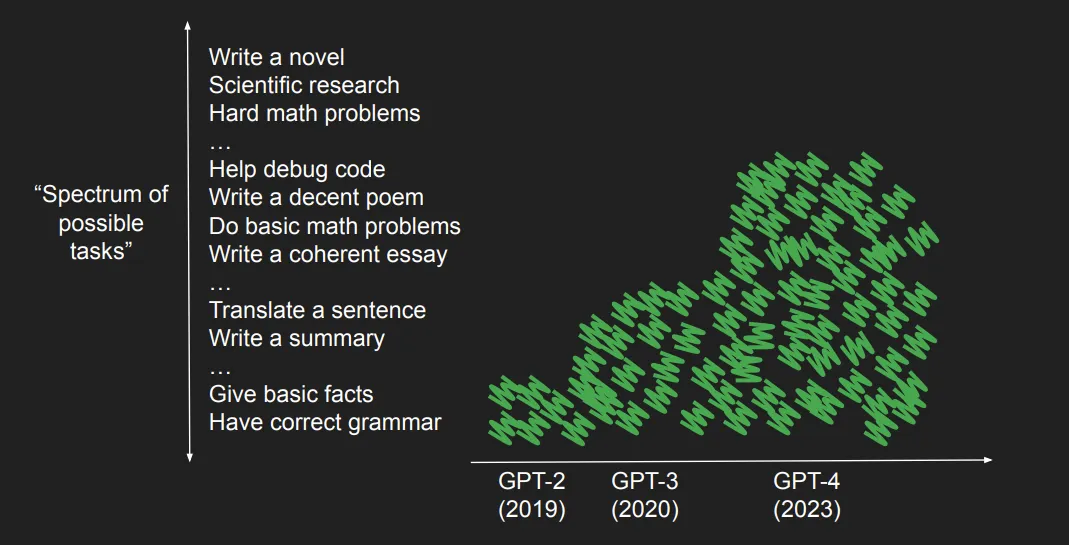

因此,我們可以繪制一張我們希望 AI 完成的任務圖譜。一開始是最基礎的任務(比如返回基本事實或保證語法正確),到翻譯、寫代碼和寫詩等中等難度任務,再到寫小說或做科研等最難的任務。

隨著模型增大,它們能完成的任務也越來越多,比如 GPT-2 只能做這些任務中的一小部分,GPT-3 能做更多任務,而 GPT-4 則涌現出了更多能力,比如調試代碼、寫詩等。

于是,問題來了:既然下一詞預測效果這么好,那么能否僅僅通過擴展下一詞預測就達到 AGI 呢?

我的回答是:也許可以,但會非常困難,我們需要繼續大量擴展。

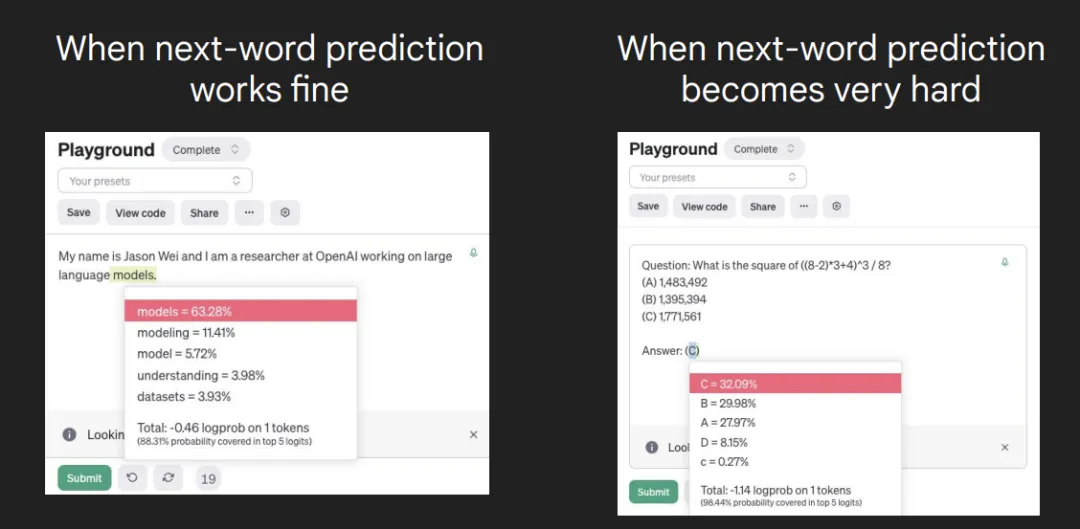

僅僅做下一詞預測確實存在一個根本性的瓶頸:有些詞非常難預測,需要大量工作。

比如下圖左側就給出了一個下一詞預測效果很好的例子,這里很容易預測出最后一個詞是 models。而對于右側的數學題,僅僅通過下一詞預測很難得到正確答案是 A、B、C 中的哪一個。

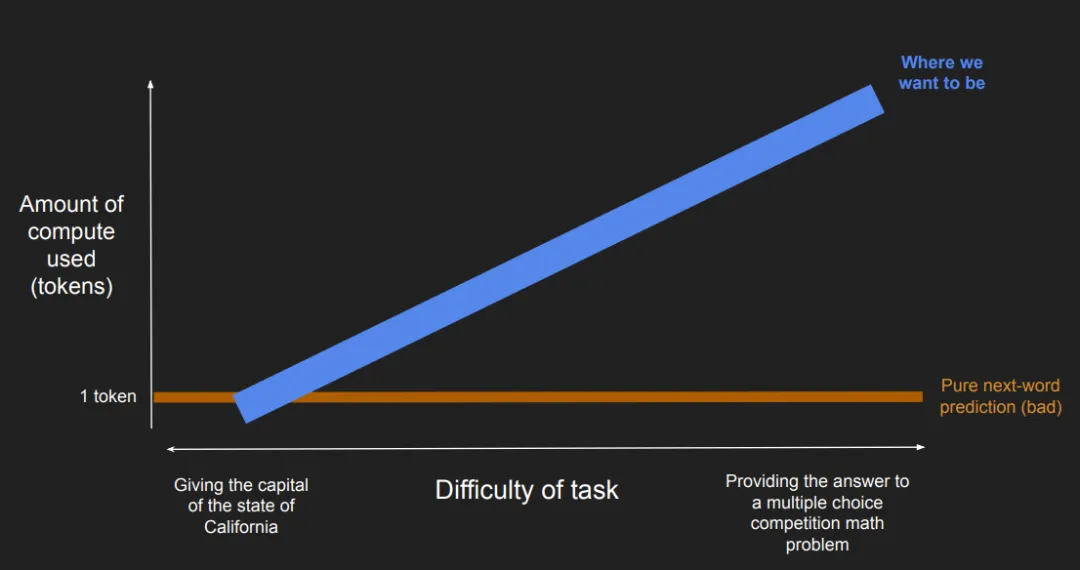

這里要強調的是,任務是有難度區分的。如果單純使用下一詞預測,那就是使用相同的計算量來解決非常簡單的任務和非常困難的任務。

而我們想要的實際上是:對于簡單的問題使用少量計算,對于困難的問題則使用大量計算(比如得到競賽數學多選題的答案)。

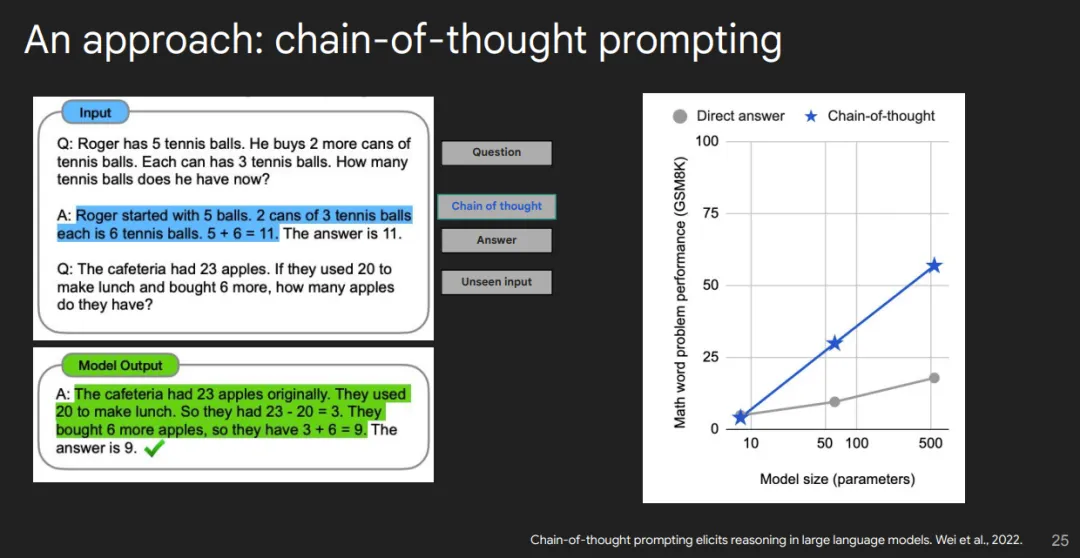

一個方法是思維鏈提示,這是我們在過去幾年一直在做的事情。這個方法很簡單:只需要提示語言模型給出推理鏈,就像你向老師展示你的解題過程一樣。然后語言模型就可以在給出最終答案之前實際輸出這個推理鏈。

事實證明該方法的效果相當不錯。如果你有一個數學應用題基準測試,你會看到如果使用思維鏈而不是直接回答,隨著模型增大,性能會有巨大的提升。

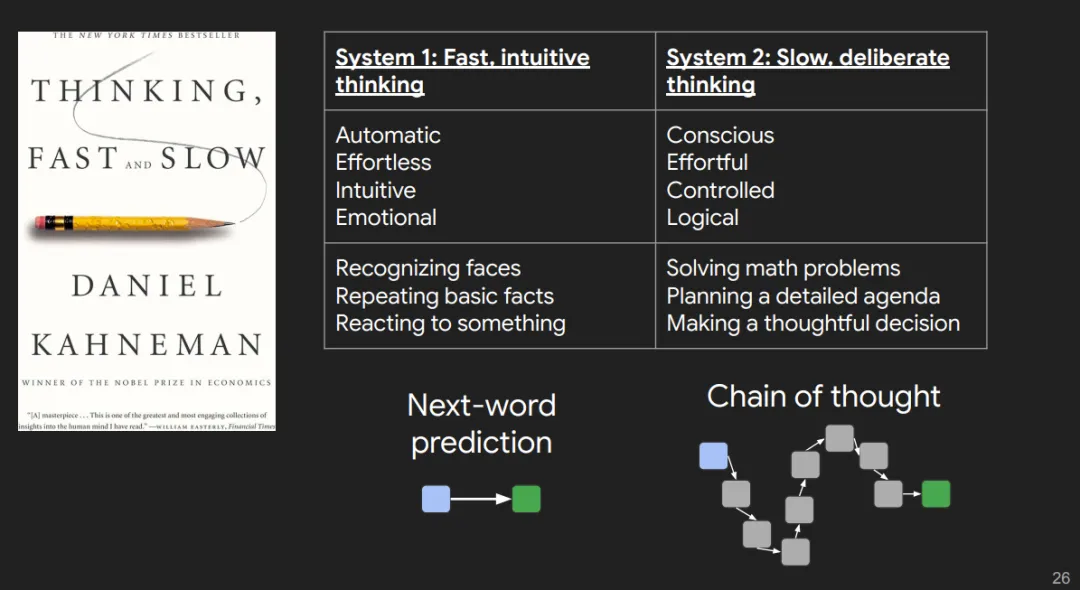

另一個角度是基于這本書《思考,快與慢》,其中分出了所謂的 System 1 和 System 2 思維。

System 1 思維就是下一詞預測,它是自動的、不費力的、直覺式的,比如重復一個基本事實或認出一張臉。

思維鏈則屬于 System 2 思維,這是有意識的、費力的、受控的。

不過,思維鏈提示也有一個關鍵問題:當你在大多數互聯網數據上訓練模型時,模型訓練的推理大多看起來是下圖左側這樣的。這個例子來自一個大學數學作業,你可以需要花一個小時做題,然后再用 10 分鐘將其轉錄成 LaTeX。格式上,可以看到,其一開始就給出了答案,之后是進行證明。所以這實際上是對內部推理過程的事后總結。

這是我的一個大學數學作業解答的例子。你會注意到,如果你想想這是從哪里來的,我可能花了一個小時在紙上做這個問題,然后花了 10 分鐘把它轉錄成 LaTeX。你可以看到,你知道,證明在開頭,答案在開頭等等。所以它實際上是對實際內部推理過程的事后總結。

但實際上,思維鏈是想要模型像我們的內心獨白一樣思考。如上右圖所示,我們希望模型說:「讓我們先看看應該采用什么方法;我要試試這個;這個實際上不對,我再試試別的……」

擴展范式二:基于思維鏈擴展強化學習

這就引出了第二個范式:基于思維鏈擴展強化學習。這種范式的思路是訓練語言模型,使之在給出答案之前會進行思考。

研究者發現,除了擴大訓練的計算規模之外(這是過去幾十年的主流做法),還有另一個可能性:延長語言模型在執行推理時的思考時間。

基于此思路,OpenAI 打造了 o1。其相關博客已經介紹了相關技術,值得一讀,這里總結了其中幾個關鍵點。

這篇博客展示了一些 o1 給出的思維鏈,從中我們可以學到不少東西。

如上圖所示,o1 正在解決一個化學問題。首先它會說:「讓我們理解一下問題是什么」,這是它在嘗試正確理解問題。然后它會嘗試確定有哪些離子以及哪些離子會對 pH 值產生影響。結果發現,其中既有弱酸,也有弱堿。于是 o1 又想出了一個策略,通過 Ka、Kb 值來計算 pH 值。然后它進行了一些回溯,發現使用 Kb 更好。它再繼續思考:正確的公式是什么,如何計算它。最后,它得到了最終答案。

思維鏈大有作用的另一類問題是存在驗證不對稱的問題,即驗證一個解比生成一個解容易得多的情況,比如填字游戲、數獨或寫一首符合某些約束條件的詩。下圖給出了一個填字游戲例子。

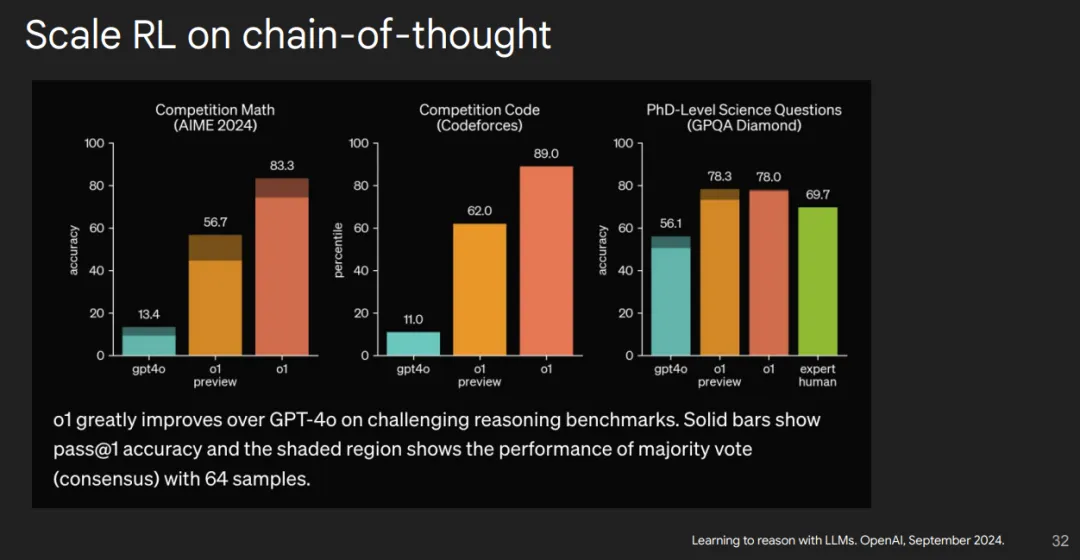

另外,如果有些問題需要大量思考,思維鏈也會很有用,比如競賽數學或競賽編程。事實上,思維鏈帶來的效果非常明顯,GPT-4o 在競賽數學和競賽編程上只能達到百分之十幾的水平,而 o1-preview 和 o1 能夠解決大部分問題。所以這是「基本上不能完成任務」與「能夠解決大多數問題」的差異。

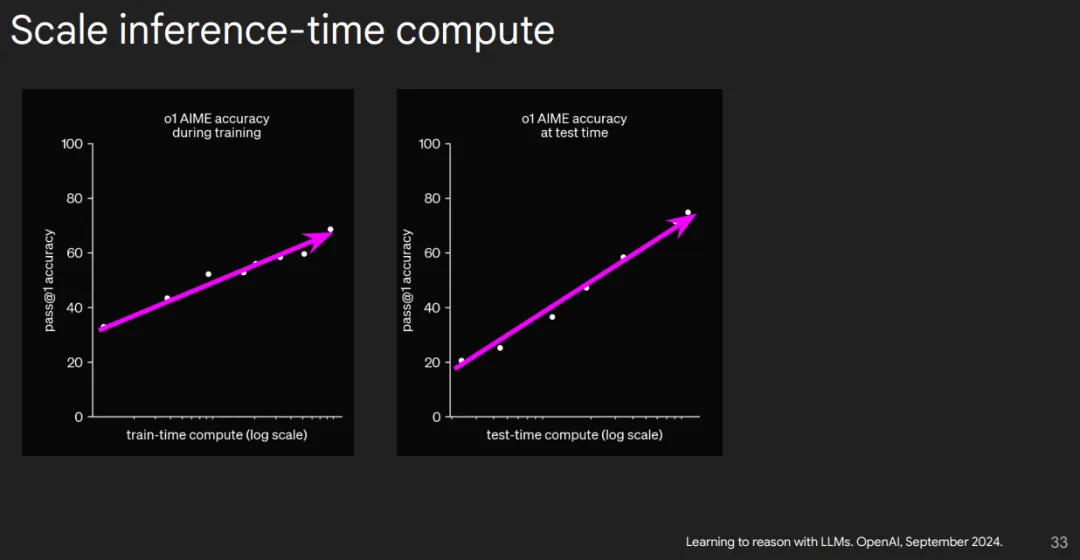

o1 博客中還提到了在競賽數學數據集上的一次通過準確率。隨著訓練計算量增多,一次通過準確率也會提升。而第二張圖表明,如果給模型更多時間思考推理,那么在數學基準測試上也能有一個正向的擴展趨勢。

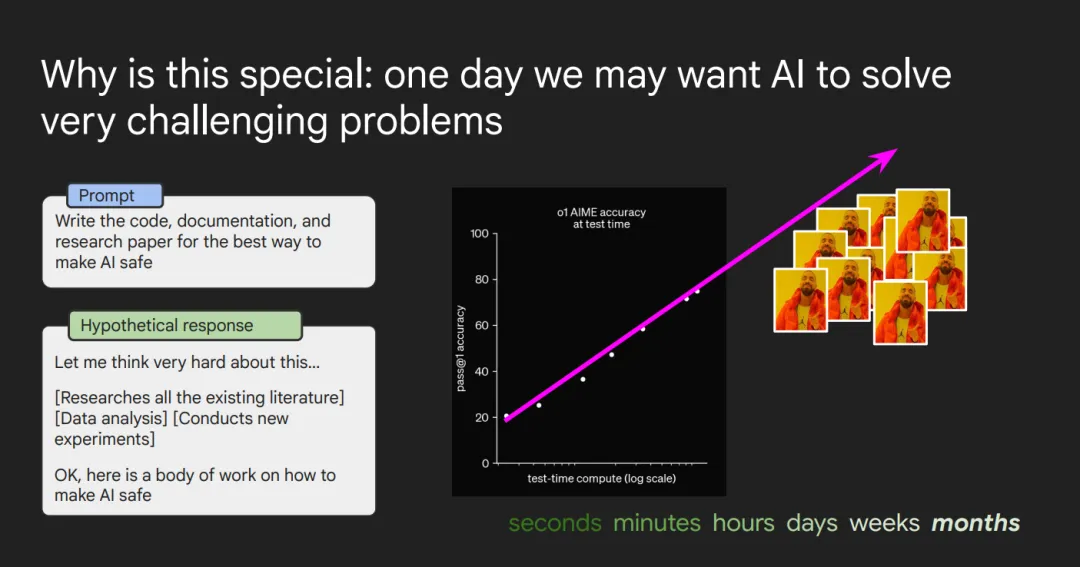

現在我想談談為什么這種范式如此特別。我認為,對許多人來說,我們對 AI 如此興奮的原因是,我們希望有一天 AI 能夠幫助我們解決人類面臨的最具挑戰性的問題,比如醫療、疾病、環境等等。

因此,理想情況下,未來的方向是:你可以提出一個非常具有挑戰性的問題(比如撰寫一篇關于如何制造 AI 的研究論文),然后語言模型可以在推理時花費大量的計算資源來嘗試解決這個問題。也許你提出問題后,成千上萬的 GPU 運行一個月,最終它會返回一個完整的答案,比如這是關于如何制造 AI 的一整套研究成果。

我們想要推斷的是,目前 AI 可能只能思考幾秒或幾分鐘,但最終我們希望 AI 能夠思考幾小時、幾天、幾周甚至幾個月,以幫助我們解決一些最具挑戰性的問題。

擴展如何改變了 AI 研究文化

接下來,我想談談擴展如何改變了 AI 研究文化。其中一個重要的轉變是對數據的重視。

過去,從 2010 年到 2017 年,甚至更早,目標是讓神經網絡盡可能好地學習某種 X 和 Y 的關系,也就是追求最佳的性能。而如今,目標變成了如何讓 X 和 Y 盡可能好,因為我們已經有了一種有效的學習方法。

總結來說,AI 的潛力在于它能夠通過大量的計算資源和時間來幫助我們解決復雜問題,而研究文化的轉變則體現在從單純優化模型轉向優化數據本身。這種變化正在推動 AI 向更深遠的方向發展。

這個例子很好地說明了現代機器學習研究重點的轉變。過去,研究人員通常會專注于在現有數據集(如 ImageNet)上訓練出最好的模型,以追求更高的評分(如準確率)。當時的目標是優化模型本身,而不是考慮擴展或改進數據集,比如將 ImageNet 擴大 10 倍,再訓練模型。

然而,如今的研究趨勢表明,通過改進數據集(X 和 Y)的質量或領域相關性,可以顯著提升模型的表現。一個典型的例子是 Google 兩年前發布的 Minerva 模型。Minerva 的研究團隊并沒有從頭設計一個新的模型,而是基于現有的語言模型,通過在大量數學相關數據(如 arXiv 上的論文)上繼續訓練,顯著提升了模型在數學任務上的表現。

AI 文化的另一個轉變是,我們某種程度上存在一種滯后現象,即我們沒有真正能夠捕捉到語言模型能力極限的評估標準。這是我從 David Ryan 的一次演講中提取的一張圖表。這張圖表基本上展示了基準測試被「飽和」的速度有多快。你可以看到,大約 8 年前,一個基準測試可能需要幾年時間才會被飽和。而最近一些具有挑戰性的基準測試,比如問答(QA),可能在大約 0.1 年(約 1 個月)內就被飽和了。當 David 被問到是否會設計一個更難的基準測試時,他的回答是,他正在著手設計一個最難的基準測試。這聽起來非常有趣。

此外,人工智能文化的另一個變化是朝著高度多任務模型(highly multi-task models)的方向發展。過去,每個 NLP 任務都需要一個單獨的模型。而現在,我們有一個單一的模型試圖完成許多不同的任務。這導致了一些奇怪的現象,比如模型可能是一個競賽級別的程序員和數學家,但當你問它 9.11 和 9.8 哪個更大時,它卻會說 9.11 更大。

這里的挑戰在于,我們需要從多個維度來衡量語言模型的表現。由于有如此多的評估基準和方法,模型的應用場景也非常廣泛,因此很難說一個模型是否嚴格優于另一個模型。通常情況下,沒有一個模型能在所有方面都嚴格優于其他模型。

有時候我聽到的一種觀點是,AI 無法做到某些事情,因此它沒有用。但我的看法是,AI 并不需要在所有方面都達到人類水平。它只需要在少數幾個用例中表現出色,就能對人類非常有用。

最后我想說的是,智能和用戶體驗是兩個可以分別改進的維度。通常,人們會嘗試通過讓語言模型在數學和編碼等方面表現更好來改進它,但這并不意味著你會得到一個用戶體驗更好的模型。

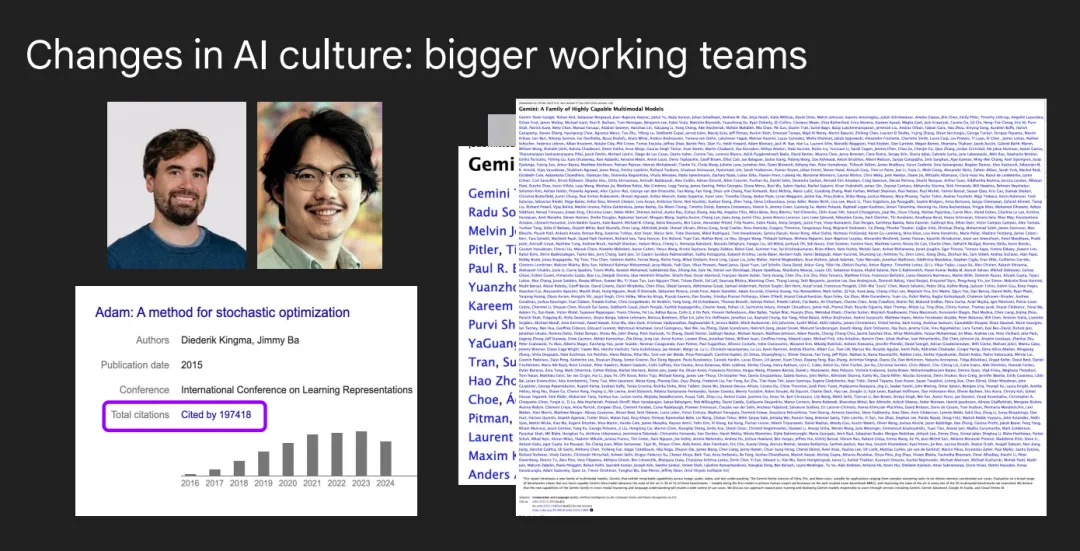

也許我們文化中的最后一個轉變是朝著更大規模的團隊合作發展。比如在 2015 年,兩個人可以寫出一篇開創性的論文,這篇論文甚至可能是被引用次數最多的之一。而如今,你需要一個團隊來完成這樣的工作。比如谷歌的 Gemini 開發團隊,人員名單就占滿了一整頁。

未來展望

接下來我來談談人工智能未來會繼續發展的方向。

其中一個讓我非常興奮的方向是 AI 在科學和醫療領域的應用。我認為,作為人類,我們在研究方面還算不錯,但我們有很多局限性。

比如,我們無法記住互聯網上的所有信息,我們會感到疲倦,會分心等等。我認為 AI 在科學和醫療創新方面確實有很大的潛力,因為它幾乎可以學習任何東西,而且不會感到疲倦,可以長時間工作,對吧?

另一個方向是更加注重事實的 AI。目前,像 ChatGPT 這樣的模型仍然會出現比我們預期更多的幻覺(即生成不準確或虛構的內容)。最終,我認為我們有可能開發出一種幾乎不會產生幻覺的模型,它非常擅長引用來源,并且非常精確。

總的來說,AI 在科學、醫療以及提高事實準確性方面的潛力巨大,這些領域將繼續推動 AI 技術的發展。

我認為我們將朝著多模態 AI 的方向發展。文本是一個非常好的學習媒介,因為它是對我們世界的高度壓縮表示。但我們將朝著更融入我們世界的 AI 發展,比如 Sora 和高級語音模式。

我認為工具使用也將成為另一個重要的方向。

目前,AI 更像是一個聊天助手,你可以向它提問并獲取答案。但我認為,最終我們希望達到的狀態是 AI 能夠代表用戶執行操作,并且能夠主動為用戶提供服務。

最后,我認為我們將看到許多 AI 應用落地。我感覺在技術的研究階段和實際部署之間總是存在一定的滯后。例如,Waymo 在舊金山這樣的復雜駕駛環境中已經運行得很好,但谷歌還沒有將 Waymo 推廣到全球大部分地區。另一個例子是,我覺得現在的 AI 已經足夠好,如在餐廳為你點餐,但這一應用還沒有被廣泛采用。

好的,接下來我將回到第一張圖,也就是 2019 年和 2024 年,下面我們加上一個五年預測。過去 AI 的能力非常有限,但如今它已經非常強大。我對未來五年 AI 的發展感到非常興奮,并鼓勵大家都去思考這個問題。

最后,我想用這句話結束:當《海底總動員》中的 Nemo 不知道下一步該做什么并陷入困境時,Dory 說:你只需要繼續游下去。我想說的是,你只需要繼續 Scaling。