終于把機器學習中的超參數調優搞懂了!!

今天給大家分享機器學習中一個重要的知識點,超參數調優。

超參數調優(Hyperparameter Tuning)是機器學習模型開發過程中一個關鍵步驟,旨在通過調整模型的超參數來優化模型的性能。

超參數不同于模型參數,后者是在訓練過程中通過數據學習得到的,而超參數是在訓練之前設定的,通常需要通過試驗和優化來確定。

什么是超參數

超參數是指在訓練機器學習模型之前需要人為設定的參數。

常見的超參數包括

- 學習率:控制模型在每一步梯度下降中權重更新的幅度。

- 正則化參數:如 L1、L2 正則化系數,用于防止模型過擬合。

- 網絡結構參數:如神經網絡的層數、每層的神經元數量、激活函數類型等。

- 優化算法的選擇:如SGD、Adam、RMSprop等。

選擇合適的超參數對于模型的性能有著顯著的影響,因此超參數調優是模型開發過程中不可或缺的一部分。

超參數調優的重要性

- 提升模型性能

合適的超參數組合可以顯著提高模型的準確性、泛化能力和穩定性。 - 防止過擬合或欠擬合

通過調整超參數,可以平衡模型的復雜度,避免模型在訓練數據上表現過好但在測試數據上表現差(過擬合),或在訓練數據和測試數據上都表現不佳(欠擬合)。 - 提高計算效率

合理的批量大小、學習率等設置可以顯著加快模型訓練的速度。

常見的超參數調優方法

以下是幾種常用的超參數調優方法,每種方法都有其優缺點和適用場景。

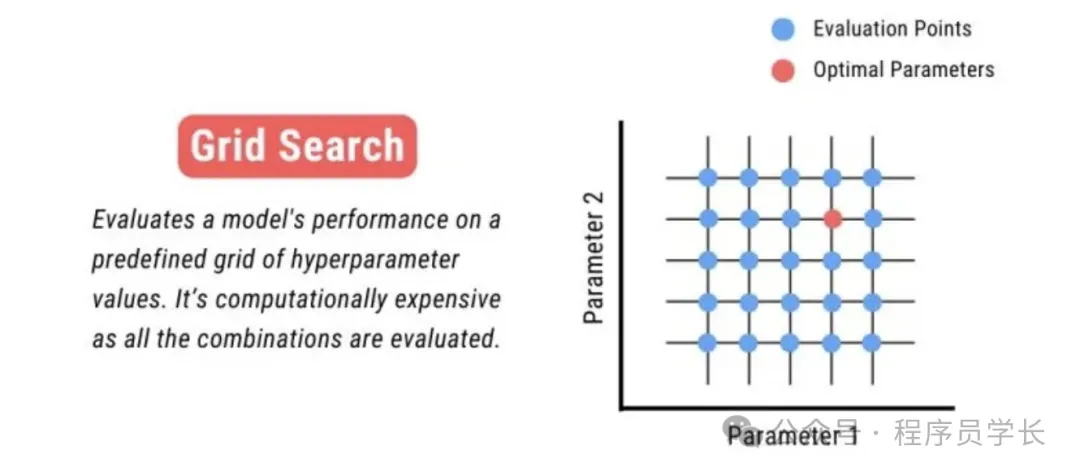

網格搜索

網格搜索是最簡單直觀的超參數調優方法。

它通過在預定義的超參數空間中,系統地遍歷所有可能的參數組合,并在每個組合上訓練和評估模型,最后選擇表現最佳的參數組合。

工作流程

- 定義超參數搜索空間:為每個超參數指定離散的取值范圍。

- 遍歷搜索空間的所有組合。

- 在驗證集上評估每個組合的性能。

- 返回驗證性能最好的超參數組合。

示例

假設有兩個超參數:

- 學習率:[0.01, 0.1, 1]

- 正則化系數:[0.001, 0.01]

網格搜索會評估以下 6 組組合

- (0.01, 0.001), (0.01, 0.01)

- (0.1, 0.001), (0.1, 0.01)

- (1, 0.001), (1, 0.01)

優缺點

優點

- 簡單直觀:易于理解和實現

- 全面性:對所有可能組合逐一嘗試,保證找到最佳超參數(在搜索空間內)。

缺點

- 計算開銷高:當搜索空間較大或超參數維度較高時,計算成本會指數級增長。

- 效率低下:即使某些超參數對模型性能影響較小,網格搜索仍會窮舉所有可能的組合,浪費計算資源。

適用場景

- 適用于超參數數量少且每個超參數的取值范圍有限的情況。

- 對模型性能要求高,且計算資源充足時。

以下是使用 Scikit-learn 進行網格搜索的示例代碼。

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

# 加載鳶尾花數據集

iris = load_iris()

X, y = iris.data, iris.target

# 拆分訓練集和測試集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 定義模型

model = RandomForestClassifier(random_state=42)

# 定義超參數搜索范圍

param_grid = {

'n_estimators': [10, 50, 100],

'max_depth': [3, 5, 10],

'min_samples_split': [2, 5]

}

# 網格搜索

grid_search = GridSearchCV(model, param_grid, cv=3, scoring='accuracy', verbose=1)

grid_search.fit(X_train, y_train)

# 輸出最佳參數和準確率

print("Grid Search Best Parameters:", grid_search.best_params_)

print("Grid Search Best Score:", grid_search.best_score_)隨機搜索

隨機搜索通過隨機采樣超參數搜索空間中的點來評估模型性能,而不是遍歷所有組合。

其核心思想是:在高維搜索空間中,隨機采樣往往比均勻搜索更有效,尤其是當部分超參數對性能影響較大時。

工作流程

- 定義超參數搜索空間:為每個超參數指定取值范圍,可以是離散集合或連續分布。

- 隨機采樣固定數量的超參數組合。

- 在驗證集上評估每組采樣的性能。

- 返回性能最好的超參數組合。

示例

假設有兩個超參數

- 學習率:[0.01, 0.1, 1]

- 正則化系數:[0.001, 0.01]

如果設置采樣次數為 4,則隨機搜索可能得到如下結果

(0.01, 0.001), (0.1, 0.01), (1, 0.01), (0.1, 0.001)

優缺點

優點

- 計算效率高:不需要遍歷所有組合,顯著減少計算成本。

- 高維搜索空間適用性強:能夠有效探索大范圍的高維空間。

- 靈活性:允許搜索空間是連續的分布,避免離散化的局限。

缺點

- 可能遺漏最佳參數:采樣次數不足時,可能錯過全局最優的參數組合。

- 不確定性:由于隨機性,不同運行結果可能不一致。

適用場景

- 適用于超參數數量較多或每個超參數的取值范圍較大的情況。

- 在計算資源有限的情況下,通過合理設置采樣次數,快速找到較優的超參數組合。

以下是使用 Scikit-learn 進行隨機搜索的示例代碼。

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import randint

# 定義模型

model = RandomForestClassifier(random_state=42)

# 定義超參數分布

param_distributions = {

'n_estimators': randint(10, 100),

'max_depth': randint(3, 10),

'min_samples_split': randint(2, 6)

}

# 隨機搜索

random_search = RandomizedSearchCV(

model, param_distributions, n_iter=20, cv=3, scoring='accuracy', random_state=42, verbose=1

)

random_search.fit(X_train, y_train)

# 輸出最佳參數和準確率

print("Random Search Best Parameters:", random_search.best_params_)

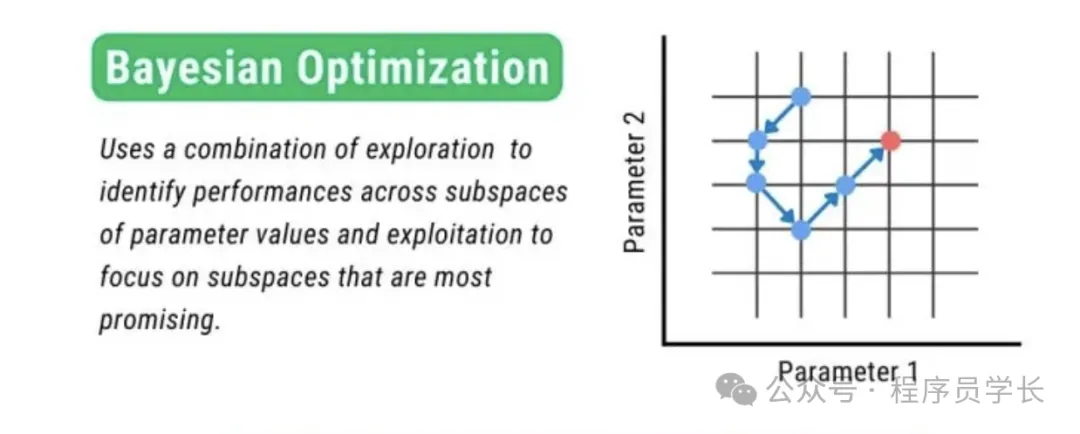

print("Random Search Best Score:", random_search.best_score_)貝葉斯優化

貝葉斯優化是一種基于概率模型的優化方法,通過構建目標函數的代理模型(通常是高斯過程),并結合采集函數(Acquisition Function),在每一步迭代中選擇最有潛力的超參數組合進行評估,從而高效地探索和利用超參數空間,找到最優的超參數組合。

工作原理

貝葉斯優化的過程包括以下幾個步驟。

- 初始化

隨機采樣幾組超參數,訓練模型并記錄性能。 - 構建代理模型

基于當前已采樣的點,構建超參數與性能的近似關系。 - 優化采集函數

基于代理模型,利用采集函數選擇下一個最有潛力的超參數組合。 - 更新模型

對選定的超參數組合進行模型訓練和評估,并更新代理模型。 - 重復迭代:

重復步驟2-4,直到達到預設的迭代次數或計算資源限制。 - 選擇最優組合

從所有評估過的超參數組合中選擇最佳的。

優缺點優點

- 高效性:相比網格搜索和隨機搜索,貝葉斯優化在較少的評估次數下能夠找到更優的超參數組合。

- 適用復雜目標函數:可以處理非線性、非凸的目標函數。

缺點

- 實現復雜:相較于網格搜索和隨機搜索,貝葉斯優化的實現更加復雜,需要選擇合適的代理模型和采集函數。

- 計算復雜度高:構建和更新代理模型(如高斯過程)在高維空間中計算成本較高。

適用場景

- 搜索空間復雜,評估單次超參數成本較高時(如深度學習)。

- 對調優效率要求高且資源有限時。

以下是使用 optuna 庫進行貝葉斯優化的示例代碼。

import optuna

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import cross_val_score

# 定義目標函數

def objective(trial):

# 定義超參數的搜索空間

n_estimators = trial.suggest_int('n_estimators', 10, 100)

max_depth = trial.suggest_int('max_depth', 3, 10)

min_samples_split = trial.suggest_int('min_samples_split', 2, 6)

# 創建模型

model = RandomForestClassifier(

n_estimators=n_estimators,

max_depth=max_depth,

min_samples_split=min_samples_split,

random_state=42

)

# 交叉驗證評估

score = cross_val_score(model, X_train, y_train, cv=3, scoring='accuracy').mean()

return score

# 開始貝葉斯優化

study = optuna.create_study(directinotallow='maximize')

study.optimize(objective, n_trials=20)

# 輸出最佳參數和準確率

print("Bayesian Optimization Best Parameters:", study.best_params)

print("Bayesian Optimization Best Score:", study.best_value)