多模態圖像生成模型Qwen2vl-Flux,利用Qwen2VL視覺語言能力增強FLUX,可集成ControlNet

作者:stable kirito

該模型將 Qwen2VL 的視覺語言功能集成到 FLUX 框架中,從而實現更精確、更具情境感知的圖像生成。

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

Qwen2vl-Flux 是一種先進的多模態圖像生成模型,它利用 Qwen2VL 的視覺語言理解能力增強了 FLUX。該模型擅長根據文本提示和視覺參考生成高質量圖像,提供卓越的多模態理解和控制。讓 FLUX 的多模態圖像理解和提示詞理解變得很強。

Qwen2vl-Flux有以下特點:

- 無文本圖像直接基于圖像生成圖像;

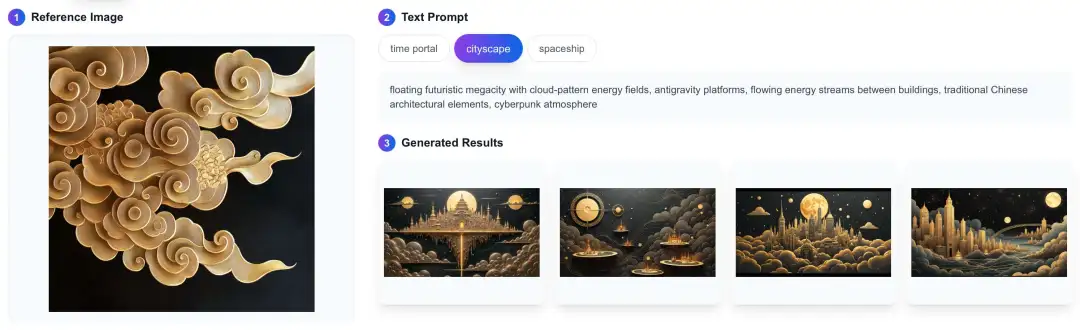

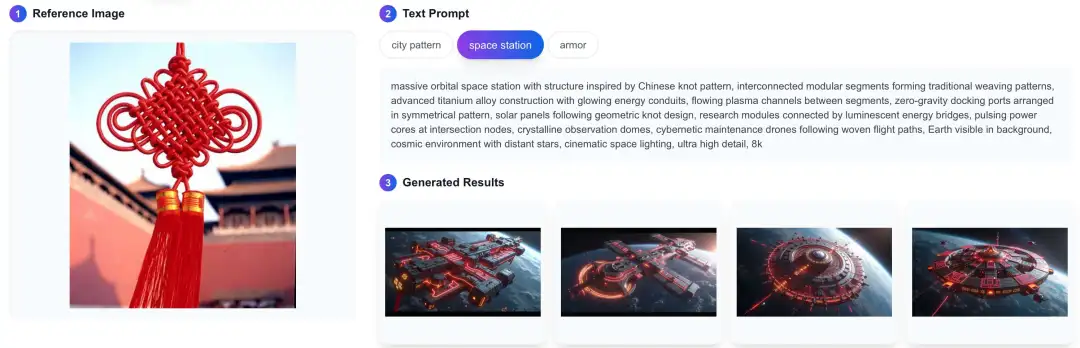

- 類似 IPA 將圖片和文字結合生成對應風格的圖片;

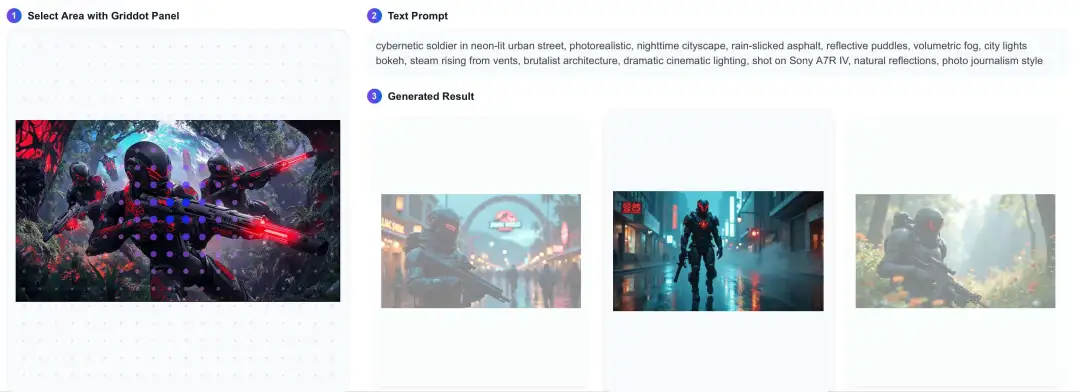

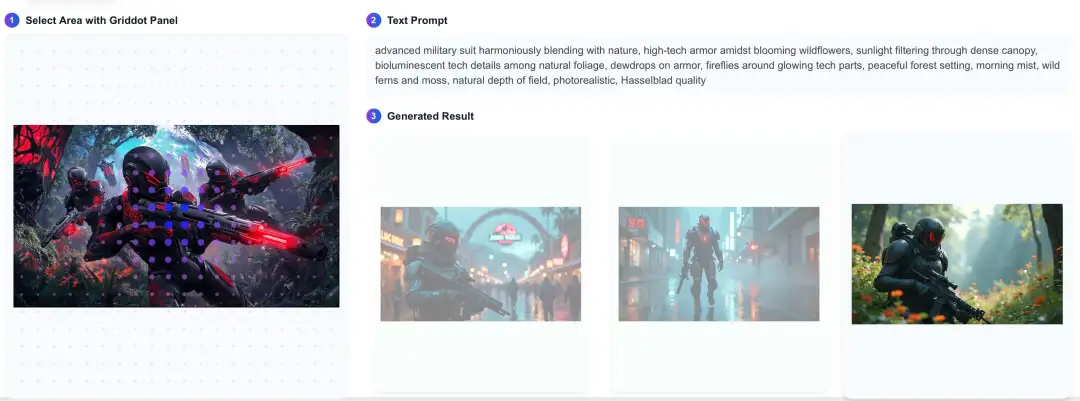

- GridDot控制面板,細致的風格提取;

- ControlNet 集成,支持 Depth 和 canny

相關鏈接

- 代碼:https://github.com/erwold/qwen2vl-flux

- 模型:https://huggingface.co/Djrango/Qwen2vl-Flux

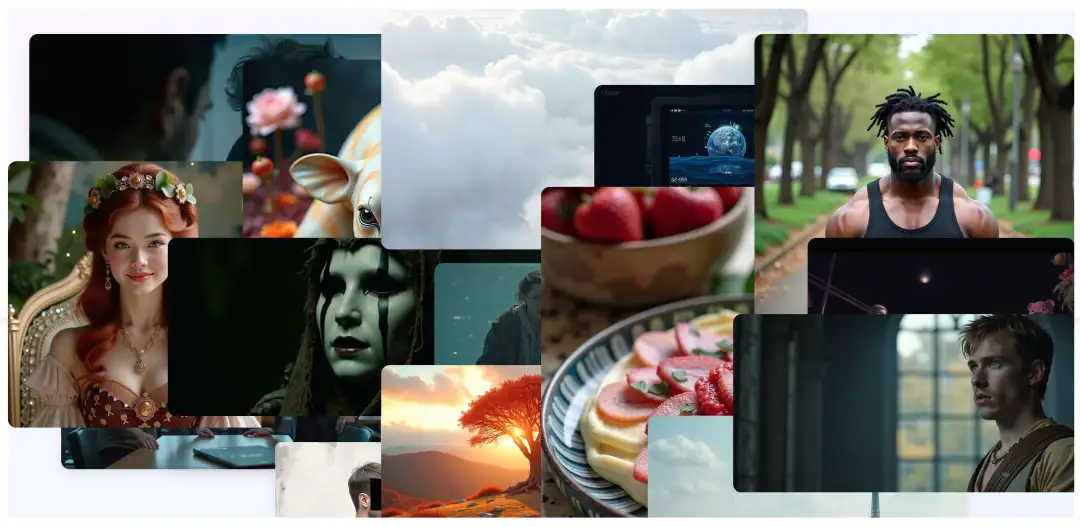

模型架構

該模型將 Qwen2VL 的視覺語言功能集成到 FLUX 框架中,從而實現更精確、更具情境感知的圖像生成。關鍵組件包括:

- 視覺語言理解模塊(Qwen2VL)

- 增強型 FLUX 主干

- 多模式生成管道

- 結構控制集成

特征

- 增強視覺語言理解:利用 Qwen2VL 實現卓越的多模式理解

- 多種生成模式:支持變異、img2img、修復和控制網引導生成

- 結構控制:集成深度估計和線路檢測,實現精確的結構引導

- 靈活的注意力機制:通過空間注意力控制支持焦點生成

- 高分辨率輸出:支持高達 1536x1024 的各種寬高比

生成示例

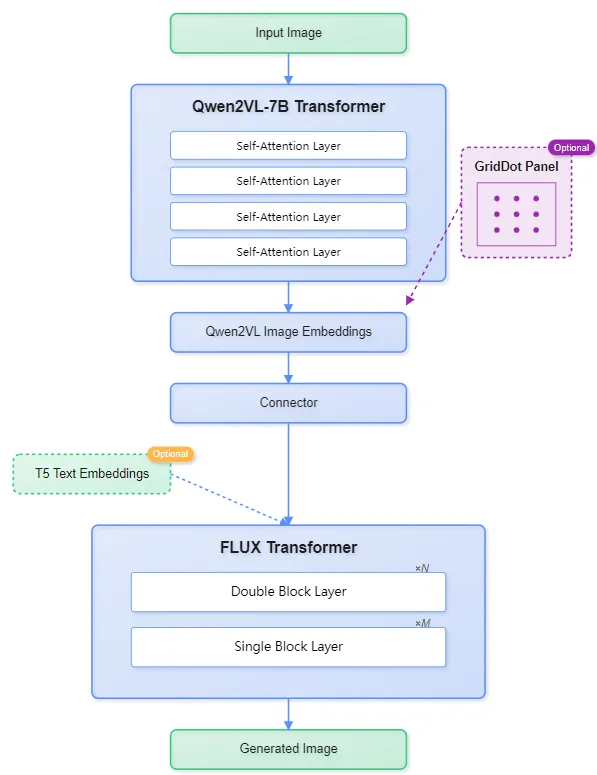

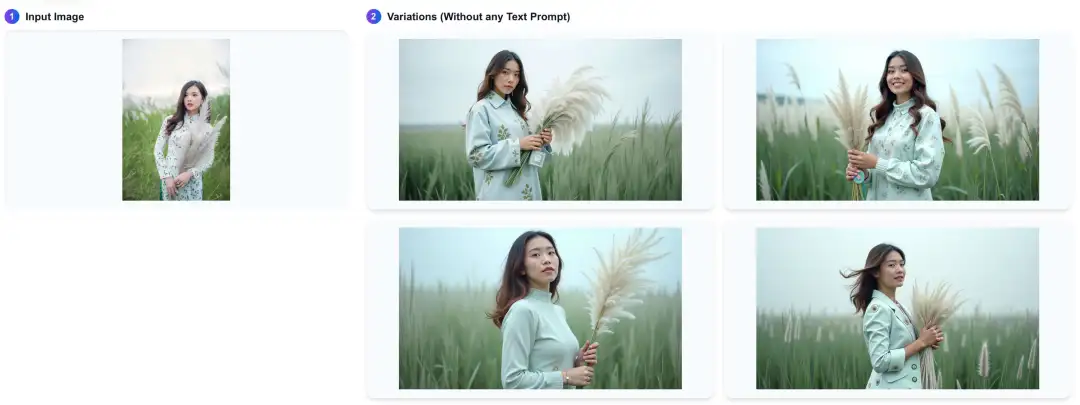

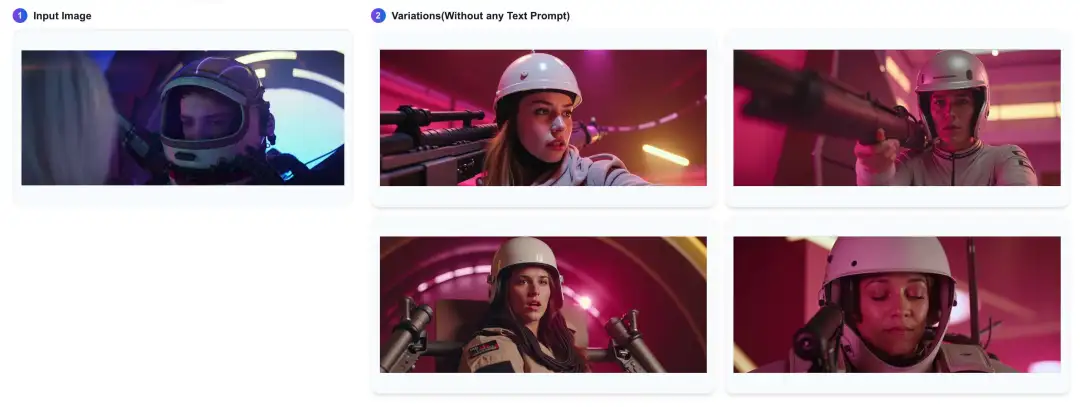

圖像變化

在保持原始圖像本質的同時,創造出多樣化的變化:

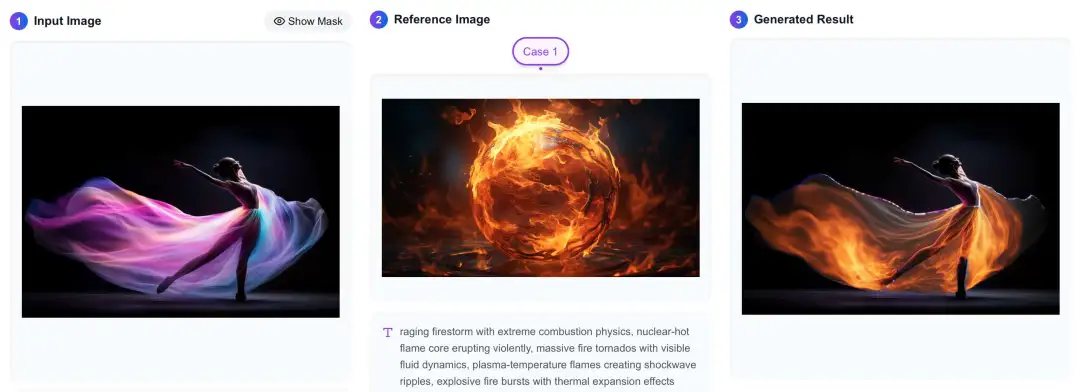

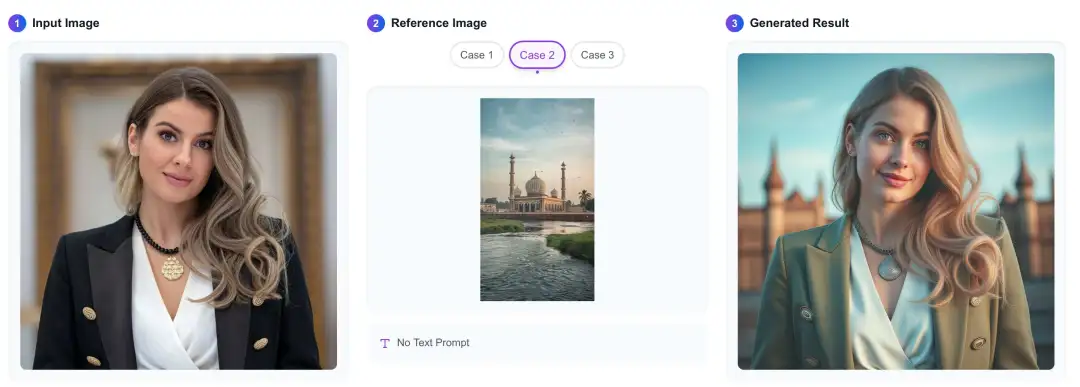

圖像混合

通過智能風格轉換無縫融合多幅圖像:

文本引導的圖像混合

通過文本提示控制圖像生成:

基于網格的風格遷移

應用網格注意力的細粒度樣式控制:

責任編輯:張燕妮

來源:

AIGC Studio