Transformer2要做「活」的AI模型,動態調整權重,像章魚一樣適應環境

在自然界,「適應」是一種非常普遍的現象。例如,章魚能夠迅速改變自身的膚色和紋理,以融入周圍環境,從而躲避天敵和捕捉獵物;人腦在受傷后能夠重新連接自身神經回路,使個體能夠恢復失去的功能并適應新的思維方式或行動方式。生物體展現出的適應能力使得生命能夠在不斷變化的環境中蓬勃發展。

在人工智能領域,適應的概念同樣具有巨大的吸引力。想象一個機器學習系統,它能夠動態地調整自身的權重以在陌生的環境中不斷學習、進化。與部署在環境中的靜態 AI 模型相比,這種有自適應能力的模型明顯學習效率更高,而且有望成為與現實世界動態本質始終保持一致的終生模型。

日本 AI 初創公司 Sakana AI 的一項成果就是對這一方向的探索。在論文中,他們提出了一種可以根據不同任務動態調整模型權重的機器學習系統 ——Transformer^2。

Transformer^2 這個名稱反映了它的兩步過程:首先,模型分析傳入的任務以了解其要求,然后應用特定于任務的調整來生成最佳結果。通過有選擇地調整模型權重的關鍵組成部分,該框架允許 LLM 實時動態地適應新任務。

Transformer^2 在各種任務(例如數學、編程、推理和視覺理解)上展示了顯著進步,在效率和特定于任務的性能方面優于 LoRA 等傳統靜態方法,同時需要的參數少得多。

作者表示,這項研究為人們提供了一個未來 AI 模型不再靜態的初步展望。這些系統將在測試時動態地調整其計算能力,以適應它們所遇到的任務的復雜性,體現出能夠持續變化和終生學習的「活」的智能。

有人就此展望說,「未來,『預訓練』和『后訓練』之間的界限將會消失,我們的模型和智能體將不斷適應和自我改進。像這樣的系統將為新一代自適應人工智能鋪平道路,這種人工智能能夠修改自身的權重和架構,以適應它們在環境中遇到的任務不斷變化的本質。」

- 論文標題:TRANSFORMER2 : SELF-ADAPTIVE LLMS

- 論文鏈接:https://arxiv.org/pdf/2501.06252

這篇論文共有三位共同一作,其中兩位是華人。Qi Sun 在東京工業大學擔任研究助理,同時在 Sakana AI 兼職,研究方向是視覺語言模型的訓練與評估、大規模合成數據生成等。Yujin Tang 曾在谷歌工作多年,現在是 Sakana AI 的研究科學家,研究方向是強化學習和機器人。

論文概覽

自適應大語言模型(LLM)將代表 AI 領域的一個重要進展,提供了一個使模型能夠實時適應不同任務和動態環境的框架。雖然組合性和可擴展性對于有效適應至關重要,但當前的 LLM 訓練方法難以同時實現這兩個特性。Sakana AI 的研究旨在提出一個開創性的解決方案來實現這一愿景并解決這些 gap。

傳統上,LLM 后訓練試圖在單次大規模訓練中優化模型的廣泛能力。雖然這種「一次性」微調框架從簡單性的角度來看是理想的,但在實踐中很難實現。例如,后訓練仍然非常消耗資源,導致巨大的計算成本和超長的訓練時間。此外,在引入額外數據廣度時往往存在明顯的性能權衡,這使得同時克服過擬合和任務干擾變得具有挑戰性。

相比之下,自適應模型提供了更靈活和高效的方法。與其試圖一次性訓練 LLM 完成所有任務,專家模塊可以離線開發并按需增強到基礎 LLM 中。這使模型能夠根據當前任務動態修改其行為,而無需不斷重新調整。除了具有獨立組件的好處外,這種模塊化還支持持續學習,使模型能夠隨時間增加新技能而不會出現災難性遺忘。此外,自適應 LLM 反映了神經科學和計算生物學中一個公認的原理,即大腦根據當前任務激活特定區域,并動態重組其功能網絡以響應不斷變化的任務需求。

原則上,實現自適應 LLM 的第一步可以通過開發專門的專家模塊來實現,每個模塊都通過 LoRA 等技術進行微調。然后這些專家模塊可以根據任務需求在運行時動態組合,這個過程可以通過 MoE 類系統高效管理。然而,要使這種方法既可擴展又具有組合性,需要解決幾個挑戰。首先,微調 LLM 以創建多個專家模塊顯著增加了需要訓練的參數數量。實際上,即使使用 LoRA 等參數高效的方法,這些模塊的累積大小也會快速增加,導致存儲和計算需求增加。其次,這些專家模塊往往容易過擬合,這種現象在較小數據集或窄任務領域訓練時尤為普遍。第三,這些專家模塊的靈活組合也帶來了目前尚未解決的挑戰。

為了克服這些限制,作者首先提出了奇異值微調(SVF),這是一種新的參數高效微調(PEFT)方法,用于獲得自適應的有效構建塊。SVF 通過僅提取和調整模型權重矩陣中的奇異值來工作。通過專注于這種原則性的參數化,他們提出的方法降低了過擬合風險,大幅減少了計算需求,并允許固有的組合性。他們證明這些特性使他們能夠通過在窄數據集上使用強化學習進行訓練來廉價地獲得一組有效的領域特定「專家」向量,直接優化各個主題的任務性能。

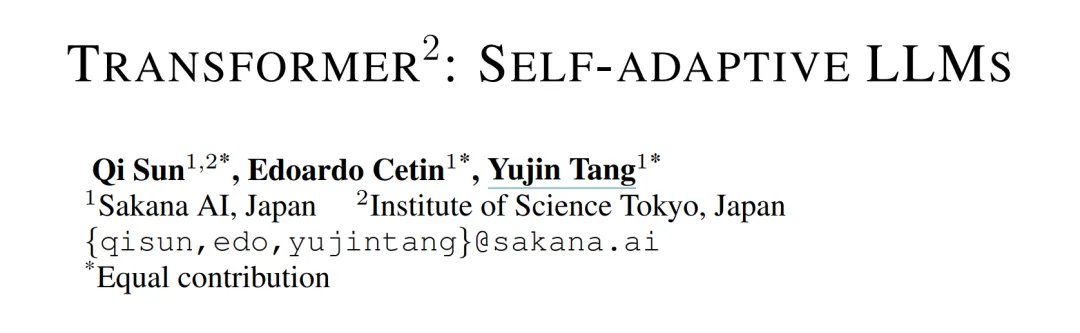

然后,作者引入了完整的 Transformer^2 框架,通過自適應的基本原則來增強 LLM。給定來自未知任務的提示,Transformer^2 采用兩階段推理機制,如圖 1 所示。

在第一階段,Transformer^2 執行模型并觀察其測試時行為,收集相關信息以理解解決當前問題所需的技能。在第二階段,Transformer^2 框架使用這些信息組合可用的專家向量,并對 LLM 的基礎權重提供專門針對其測試時條件的新修改。作者在 Transformer^2 中設計了三種不同的適應策略,并證明這些策略隨著對測試時條件的訪問增加而提供單調的性能提升。

作者通過在各種 LLM 和任務上的廣泛實驗評估了 SVF 和完整的 Transformer^2 框架。首先,在領域特定數據集上訓練時,他們展示了 SVF 始終優于傳統的高效微調策略(如 LoRA),同時參數量減少了數個數量級。然后,他們展示了 Transformer^2 能夠進一步提高性能,即使在完全分布外的應用(如視覺問答)中也能有效調整基礎模型的權重。最后,他們分析了新框架的特性,驗證了它在獲得更多當前測試時條件訪問權限時提供增量收益,甚至允許跨模型架構重用預訓練的 SVF 專家。

方法概覽

奇異值微調(SVF)

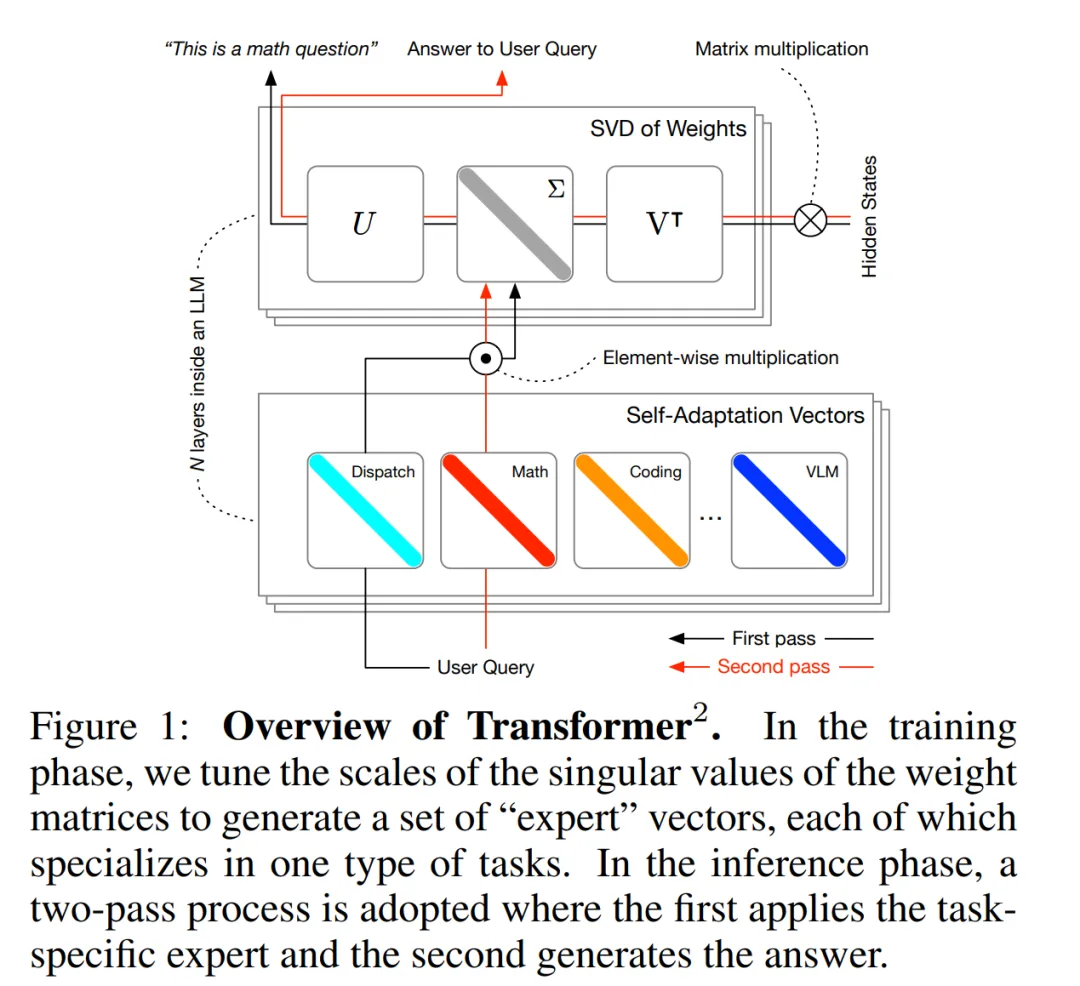

就像人類大腦通過互連的神經通路存儲知識和處理信息一樣,LLM 在其權重矩陣中存儲知識。這些矩陣是 LLM 的「大腦」,保存著它從訓練數據中學到的精髓。

要理解這個「大腦」并確保它能夠有效地適應新任務,需要仔細研究其內部結構。這就要使用奇異值分解(SVD),SVD 將存儲在 LLM 中龐大、復雜的知識分解成更小的、有意義的、獨立的部分(例如數學、語言理解等不同的組件)。

Transformer^2 的核心是能夠動態調整其權重矩陣的關鍵組件。在訓練時,該研究引入奇異值微調(SVF),這是一種使用強化學習來增強 / 抑制來自不同「大腦」組件的信號以用于各種下游任務的方法。在推理時,該研究采用三種不同的策略來檢測任務的身份并相應地調整模型的權重。

使用 SVF 和 RL 進行訓練

在訓練時,SVF 學習一組 z 向量,每個下游任務一個。每個 z 向量可以被視為任務的專家,是一個緊湊的表征,負責指定權重矩陣中每個組件的所需強度,形成一組「放大器」或「衰減器」來調節不同組件對模型行為的影響。

SVF 使用 RL 在預定義的下游任務集上學習這些 z 向量。學得的 z 向量使 Transformer^2 能夠適應各種新的下游任務,同時只引入最少量的額外參數(即 z 向量。

自適應

在推理時,該研究為框架設計了一個兩階段適應策略,以有效地組合任務特定的 z 向量集。在第一次推理時,給定任務或單個輸入提示,Transformer^2 使用以下三種適應方法之一分析其測試時條件:

- 基于提示的適應:專門設計的適應提示,對任務進行分類(例如數學、編程)并選擇預訓練的 z 向量。

- 基于分類器的適應:使用 SVF 訓練的任務分類器,在推理過程中識別任務并選擇合適的 z 向量。

- 少樣本適應:通過加權插值組合多個預訓練的 z 向量。簡單的優化算法根據少樣本評估集上的性能調整這些權重。

在第二次推理時,Transformer^2 通過組合 z 向量相應地調制權重,為其新設置產生最相關的最終響應。

實驗結果

SVF 性能

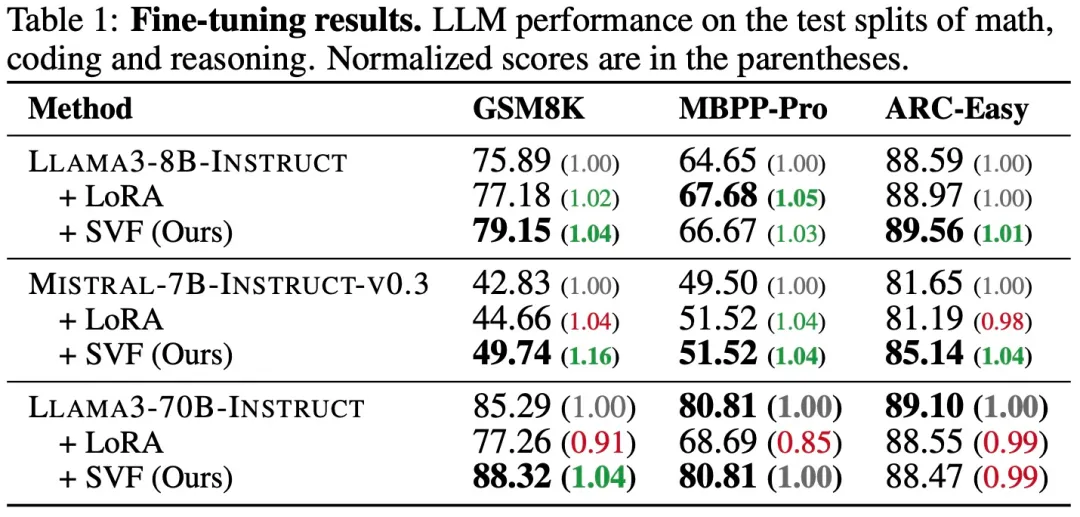

表 1 提供了在 LLAMA3-8B-INSTRUCT、MISTRAL-7B-INSTRUCT-V0.3 和 LLAMA3-70B-INSTRUCT 基礎模型上對每個任務進行訓練后的結果。

值得注意的是,SVF 在幾乎所有任務和基礎模型上都提供了顯著且一致的性能提升。相比之下,LoRA 專家產生的收益較小,甚至出現了零星的性能下降。

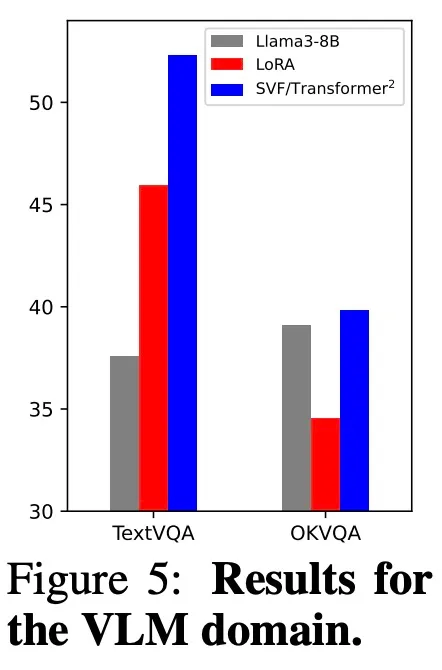

這種趨勢也可以擴展到視覺 - 語言領域,因為用 SVF 微調 LLAMA3-LLAVA-NEXT-8B 將基礎模型的性能提升了超過 39%(見圖 5)。

適應性能

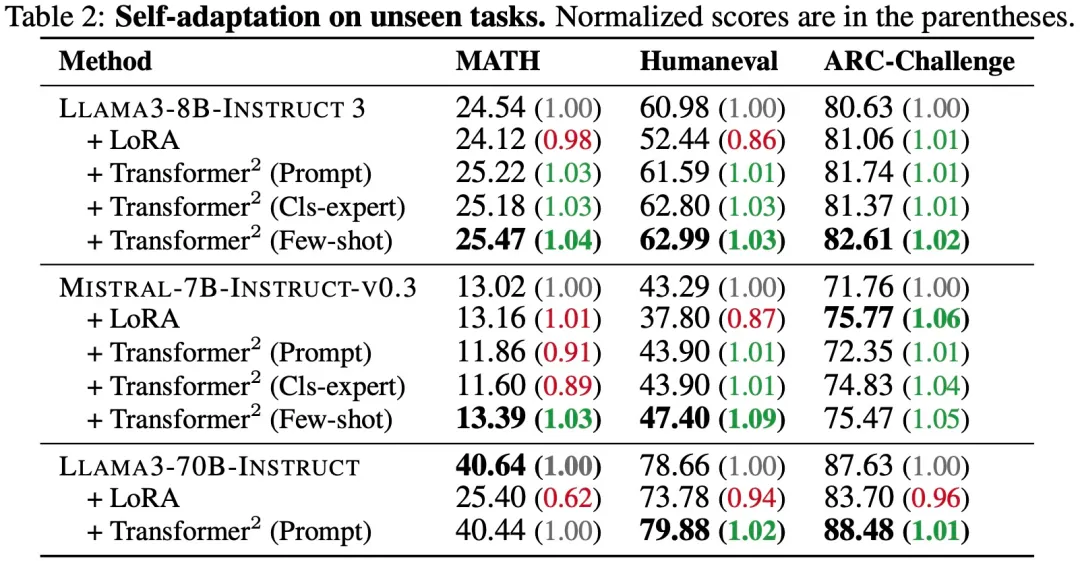

該研究使用 SVF 訓練的 z 向量評估了 Transformer^2 在未見任務上的自適應能力。

如表 2 所示,所有的 Transformer^2 適應策略都在 LLAMA3-8B-INSTRUCT 基礎模型的所有任務上表現出性能提升,在 MISTRAL-7B-INSTRUCT-V0.3 和 LLAMA3-70B-INSTRUCT 的三個任務中至少有兩個任務有所改進。相比之下,即使是最佳訓練 LoRA 也只在 ARC-Challenge 任務上提供了改進,在 MATH 和 Humaneval 上顯著降低了性能。

這種差異表明 LoRA 的參數化和優化可能特別容易過擬合,特別是在使用較小的 GSM8K 和 MBPP-Pro 數據集訓練時。

在圖 5 中,基礎 LLAMA3-LLAVA-NEXT-8B VLM 的性能僅在應用 Transformer^2 后得到改善。研究團隊注意到在這種設置中,Transformer^2 僅從 GSM8K、MBPP-Pro 和 ARC-Easy 的專家向量中進行自適應。因此,這一結果進一步強調了自適應的高度靈活性,基于語言任務的知識也可以遷移到不相關的基于視覺的問題上。

通過對三種適應策略的比較,作者發現了一個明顯的單調趨勢 —— 即隨著策略的增加和測試時間條件的增加,自適應的效果越來越明顯。特別是,具有少樣本自適應的 Transformer^2 幾乎總是得分最高的方法,在所有測試設置中都提供了顯著改進,除了 LLAMA3-70B-INSTRUCT @MATH。由于 GPU 資源有限,作者只對一半的層進行了 SVF 調優。這種趨勢表明,提供額外或不同類型的信息似乎對 Transformer^2 框架非常有益,表明 Transformer^2 可以為基礎模型提供在終身設置中部署時持續改進性能的新方法。

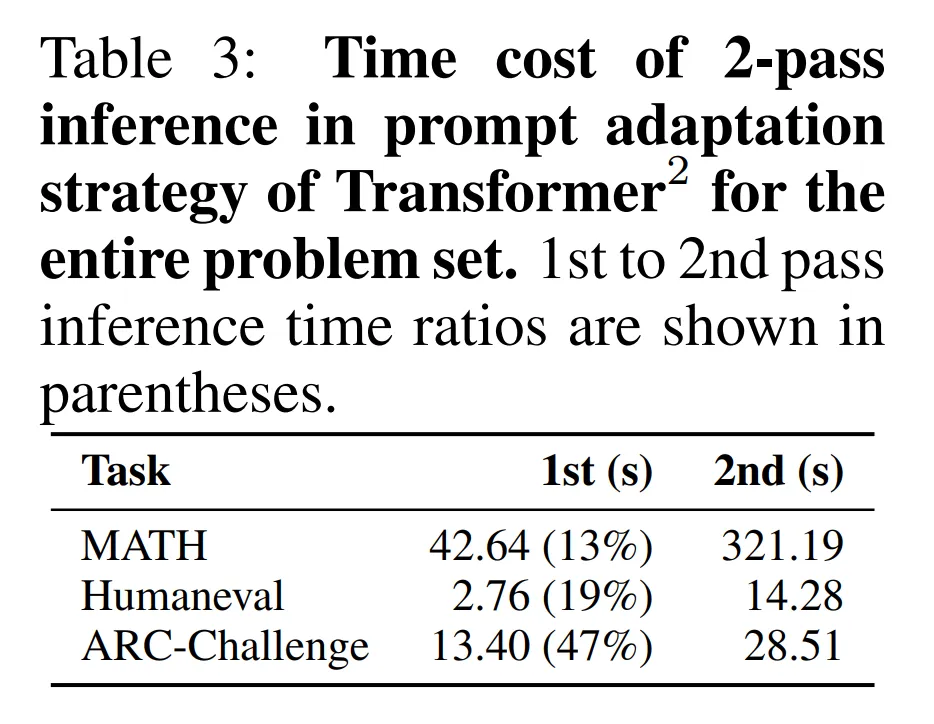

表 3 報告了 Transformer^2 的提示適應策略所需的推理時間,分別展示了第一階段和第二幾段解決整個問題集所花費的時間。注意,「2nd pass」推理時間是解決問題所花費的時間,「1st pass」推理時間是自適應的時間。括號中是「1st pass」占「2nd pass」推理時間的比率。雖然額外的推理階段可能看起來會使整體運行時間翻倍,但重要的是要注意推理時間主要取決于生成的 token 數量。在論文的設置中,它是 O (n),其中 n 是輸入的長度。ARC-challenge 括號中的數值較大,因為它們是單選題,因此「2nd pass」的成本也是 O (n)。在一般設置中,作者認為這個比率更接近 MATH 和 Humaneval 的比率是合理的。

更多內容請參見原論文。