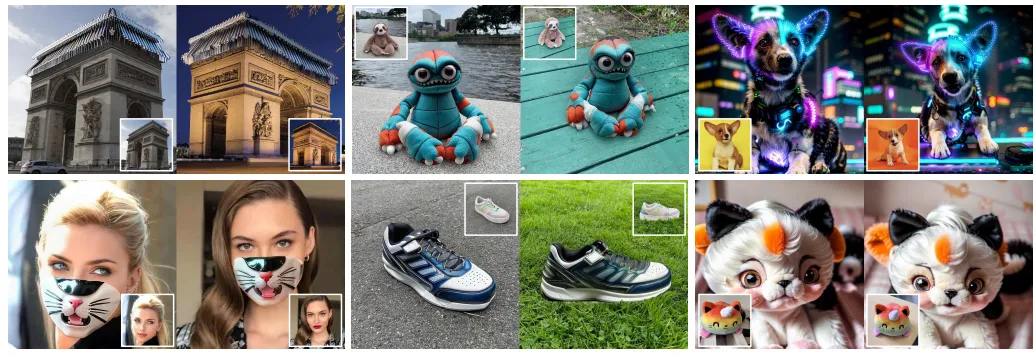

引領圖像編輯領域的新潮流!Edicho:實現跨圖像一致編輯的新方法(港科&螞蟻&斯坦福)

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

在圖像處理領域,如何實現跨圖像的一致編輯一直是技術挑戰。傳統方法往往局限于單張圖像的編輯,難以保證多張圖像間編輯效果的一致性。香港科技大學、螞蟻集團、斯坦福大學和香港中文大學聯合提出Edicho,這一難題迎來了全新的解決方案。 總結如下:

- 無訓練編輯方法:

- 核心創新:Edicho作為一種無訓練的圖像編輯方法,無需復雜的模型訓練過程,即可實現高效、一致的圖像編輯。

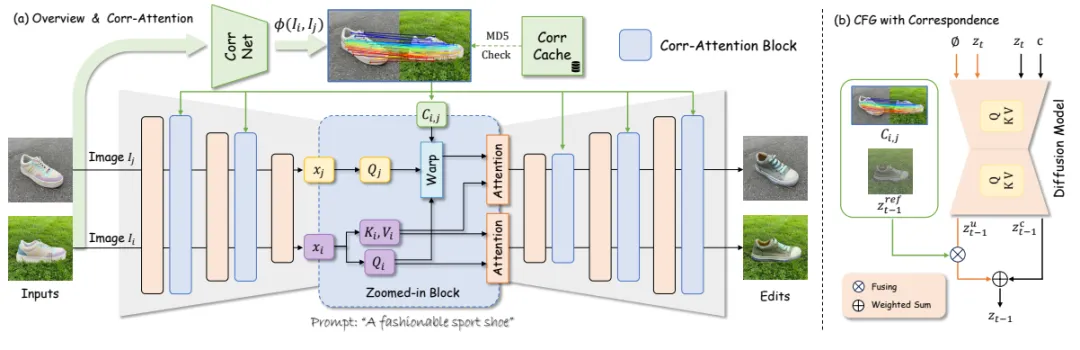

- 技術原理:該方法基于擴散模型,通過顯式對應關系來指導編輯過程,確保編輯效果在不同圖像間的一致性。

- 顯式對應關系:

- 關鍵組件:Edicho包括一個注意力操縱模塊和一個精細調整的分類器無關指導(CFG)去噪策略,兩者都考慮了預估對應關系。

- 優勢所在:通過顯式對應關系,Edicho能夠更準確地捕捉和轉移圖像間的特征,從而實現更自然、更一致的編輯效果。

- 廣泛適用性:

- 兼容性強:Edicho具有即插即用的特性,兼容大多數基于擴散的編輯方法,如ControlNet和BrushNet。

- 應用場景:該方法可廣泛應用于個性化內容生成、跨視角紋理應用等實用場景,為內容創作者提供了更多可能性。

Edicho的提出不僅解決了跨圖像一致編輯的技術難題,還為圖像處理領域帶來了全新的思路和方法。

相關鏈接

- 論文:http://arxiv.org/abs/2412.21079v2

- 主頁:https://ezioby.github.io/edicho/

Edicho:實現跨圖像一致編輯的新方法

一、引言

研究背景:在圖像編輯領域,確保編輯內容在不同圖像間的一致性是一個重要但具有挑戰性的任務。內容創作者常常希望能夠在多張照片上應用相同的編輯效果,如讓多張照片中的人物都擁有相似的妝容或服裝風格。

現有問題:以往的編輯方法往往基于單張圖像進行處理,這導致了在不同圖像間應用相同編輯時可能出現的不一致性和扭曲。

Edicho提出:本文介紹的Edicho方法通過引入顯式的對應關系預測,實現了跨圖像的一致編輯,大大提高了編輯效率和質量。

二、相關工作

擴散模型的應用:近年來,擴散模型在圖像生成和編輯領域取得了顯著成果。通過空間對齊中間特征和融合無條件嵌入,擴散模型能夠增強編輯的一致性。

基于范例的編輯:另一類工作是通過微調預訓練的擴散模型,使其能夠基于范例圖像和掩碼源圖像進行編輯。這類方法雖然有效,但在處理野生圖像時仍面臨挑戰。

三、方法概述

- 核心組件:Edicho方法主要包括兩個核心組件:注意力操控模塊和精心優化的無分類器指導(CFG)去噪策略。

- 注意力操控模塊:該模塊利用顯式的對應關系預測來增強自注意力機制,確保編輯效果在不同圖像間的一致性。

- CFG去噪策略:通過注入預計算的對應關系,指導兩個級別的去噪過程:注意力特征和噪聲潛變量。

- 顯式對應關系預測:與隱式對應關系預測相比,顯式對應關系更加準確和穩定,能夠更好地處理野生圖像間的內在變化。

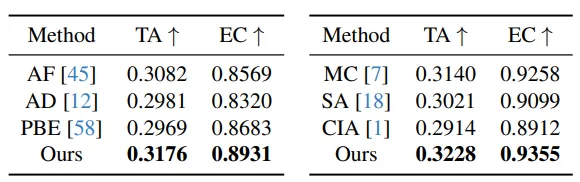

四、實驗驗證

數據集與評估指標:實驗采用了部分來自互聯網和部分來自DreamBooth及Custom Diffusion數據集的樣本,并使用CLIP模型進行文本對齊評估。

實驗結果:Edicho方法在多種修改場景下均保持了輸入圖像的完整性,包括衣物紋理、面具和領口外觀等。與基于隱式注意力的基線方法相比,Edicho在一致性和主題貼合度方面均表現出色。

五、應用示例

定制化生成:通過編輯,Edicho能夠生成更加一致的圖像集,這對于學習新穎概念的自定義模型和創建個性化內容具有重要價值。

新概念生成與編輯:通過引入低秩矩陣作為適應參數,微調后的生成模型能夠根據編輯生成與期望相符的圖像,從而實現新概念生成和編輯。

六、結論與展望

研究總結:本文提出的Edicho方法通過引入顯式的對應關系預測,實現了跨圖像的一致編輯。該方法增強了自注意力機制和無分類器指導計算,確保了編輯效果的一致性和高質量。

未來展望:隨著技術的不斷發展,Edicho方法有望在更多領域得到應用,如虛擬現實、增強現實以及圖像修復等。同時,我們也期待更多創新方法的出現,共同推動圖像編輯領域的發展。