50%優(yōu)勢,力壓OpenAI和DeepMind!清華DSAC系列算法全面解析

在當(dāng)今的人工智能浪潮中,如何讓機器獲得像人一樣的學(xué)習(xí)能力,是推動機器智能化水平不斷進化,最終實現(xiàn)具身智能甚至通用人工智能(AGI)的關(guān)鍵。

想象一下幼兒的成長過程,在不斷探索與試錯中積累經(jīng)驗、提升智慧。這正是強化學(xué)習(xí)的核心思想:通過與環(huán)境的互動,不斷調(diào)整策略以最大化長期回報。

從上世紀(jì)末期以來,強化學(xué)習(xí)技術(shù)快速發(fā)展,2016年AlphaGo擊敗圍棋世界冠軍李世石展示出這項技術(shù)解決復(fù)雜問題的巨大潛力。

然而,將強化學(xué)習(xí)應(yīng)用于機器人,在真實世界中產(chǎn)生智能,還面臨許多挑戰(zhàn),主要是因為真實世界的環(huán)境更加復(fù)雜多變,現(xiàn)有技術(shù)難以應(yīng)對這種復(fù)雜性,導(dǎo)致學(xué)習(xí)效果不穩(wěn)定。

清華大學(xué)深度強化學(xué)習(xí)實驗室長期深耕強化學(xué)習(xí)的基礎(chǔ)理論和應(yīng)用,于近期連續(xù)取得關(guān)鍵性技術(shù)突破!

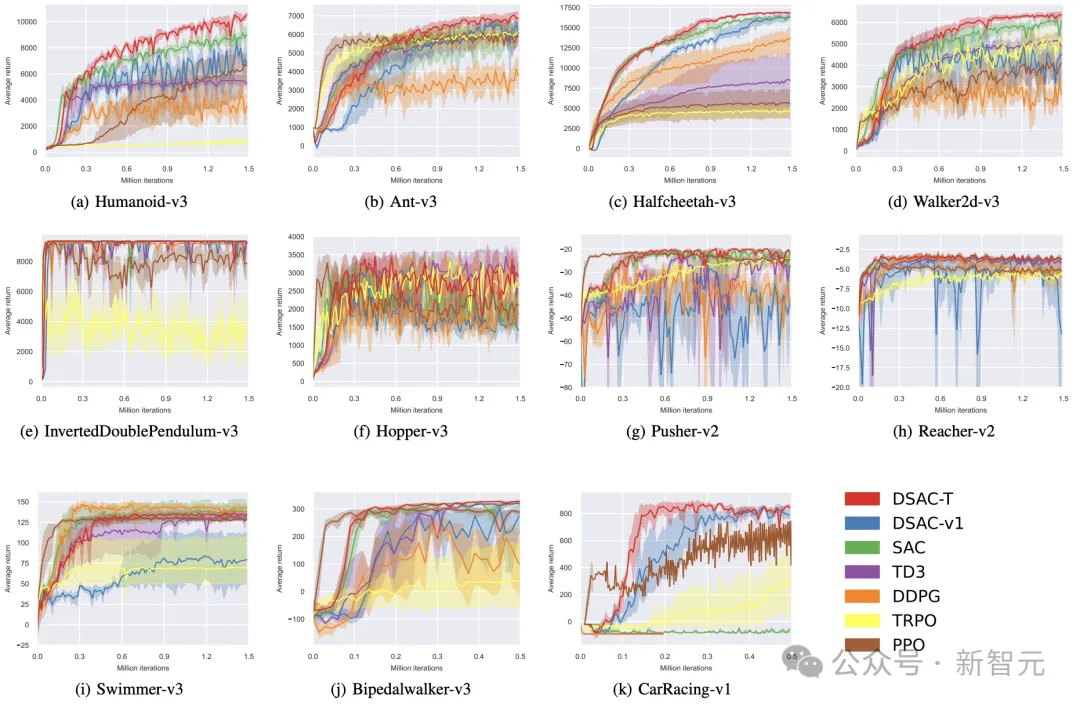

研究人員模擬人類對自然世界的真實感知模式,突破傳統(tǒng)強化學(xué)習(xí)依賴點估計處理連續(xù)動作空間的局限,構(gòu)建動作空間概率模型,在復(fù)雜環(huán)境中動態(tài)調(diào)整動作概率分布,開發(fā)出DSAC(Distributional Soft Actor-Critic)及DSAC-T系列算法。在基準(zhǔn)測試環(huán)境中,該系列算法取得了大幅的性能提升,并以50%以上的優(yōu)勢領(lǐng)先于OpenAI的PPO和Deepmind的DDPG算法。

在剛剛落幕的機器學(xué)習(xí)頂會NIPS2024中,團隊進一步將擴散模型與在線強化學(xué)習(xí)深度融合,發(fā)布了DACER算法。算法把擴散模型的反向過程定義為新策略近似函數(shù),利用其強大表示能力提升性能,再次刷新了強化學(xué)習(xí)性能的世界記錄。

不同基準(zhǔn)任務(wù)上的訓(xùn)練曲線

不同基準(zhǔn)任務(wù)上的訓(xùn)練曲線

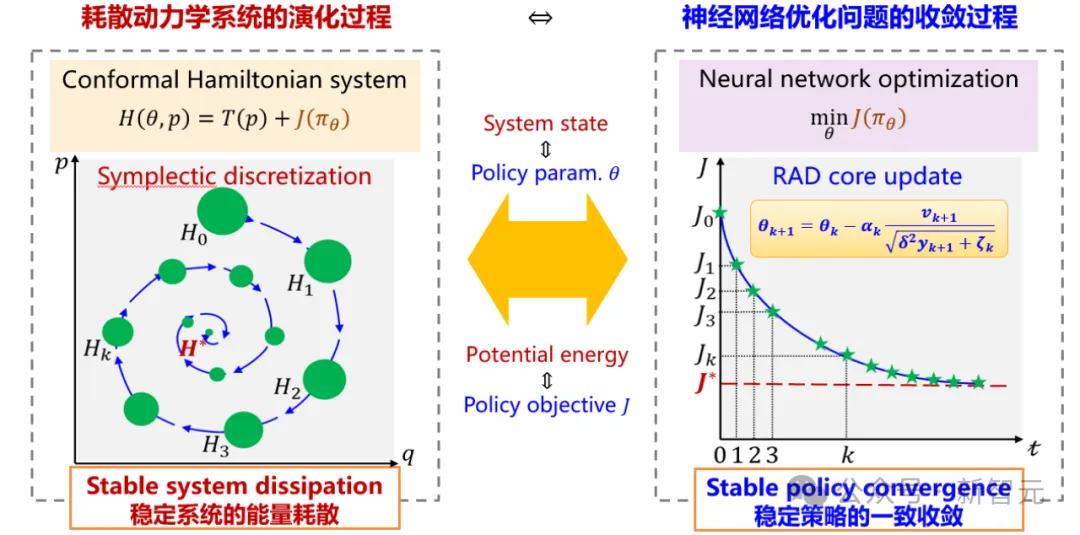

為保證強化學(xué)習(xí)訓(xùn)練效果的穩(wěn)定性,團隊提出了強化學(xué)習(xí)專用的神經(jīng)網(wǎng)絡(luò)優(yōu)化器RAD。該優(yōu)化器從動力學(xué)視角將神經(jīng)網(wǎng)絡(luò)參數(shù)優(yōu)化建模為多粒子相對論系統(tǒng)演化,賦予參數(shù)獨立自適應(yīng)能力,確保訓(xùn)練長時域穩(wěn)定與快速收斂。

相較于9個主流神經(jīng)網(wǎng)絡(luò)優(yōu)化器,RAD優(yōu)化器在12個測試環(huán)境及5種主流強化學(xué)習(xí)算法中綜合性能均排名第一。特別在圖像類標(biāo)準(zhǔn)測試環(huán)境Seaquest任務(wù)中,RAD性能達到當(dāng)前流行的Adam優(yōu)化器的2.5倍。

上述算法將逐步集成入團隊開源的最優(yōu)控制問題求解軟件GOPS中。該軟件以強化學(xué)習(xí)為核心理論,擁有完全自主知識產(chǎn)權(quán),兼容多種機器人和工業(yè)仿真環(huán)境,能夠有效地處理高維度、非線性、高動態(tài)等復(fù)雜場景的具身智能控制問題,目前已經(jīng)應(yīng)用于自動駕駛、物流機器人、特種作業(yè)機械臂、火箭回收等不同領(lǐng)域。

未來隨著GOPS軟件的進一步升級,現(xiàn)實世界的眾多機器將可能擁有像人一樣的智能,屆時將迎來一個全新的具身智能時代。

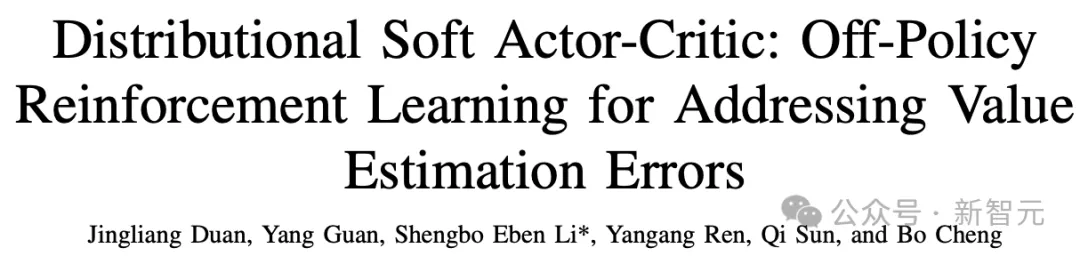

DSAC和DSAC-T系列算法解讀

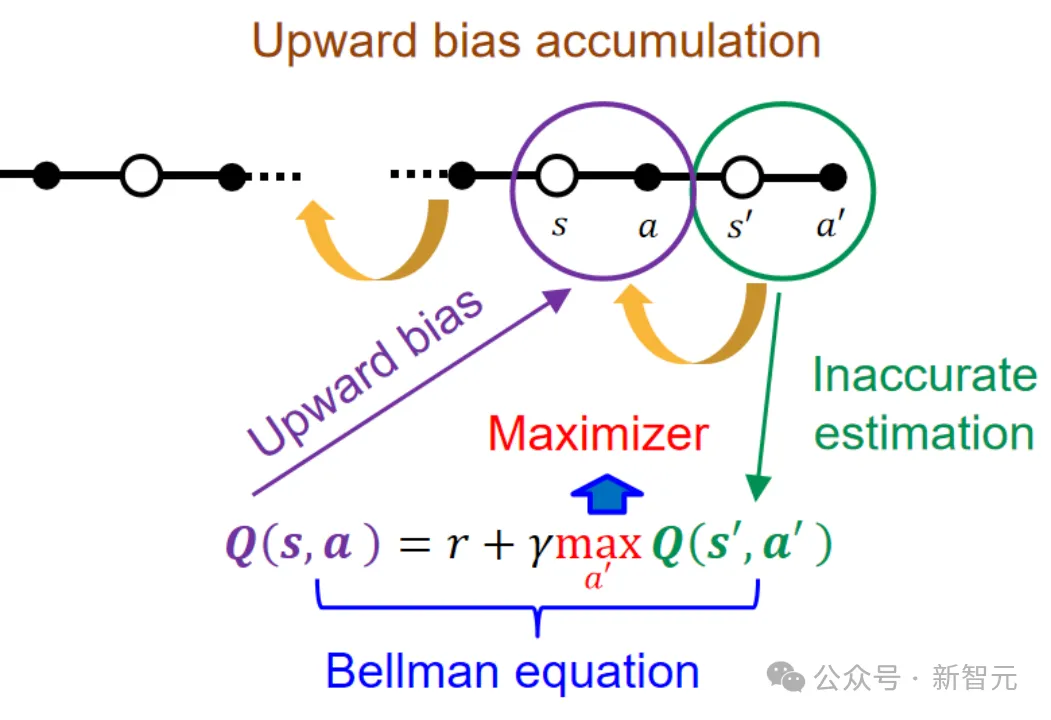

從Q-learning算法開始,不少研究者均發(fā)現(xiàn)強化學(xué)習(xí)存在嚴重的過估計問題。由于Q學(xué)習(xí)算法中不斷的對下?時刻的狀態(tài)值進?max操作,任何引起的Q值誤差的因素如環(huán)境中的噪聲、?絡(luò)的近似誤差都會導(dǎo)致對Q值的偏?的估計,即過估計。

?在時間差分學(xué)習(xí)中,這種估計誤差?會被進?步放?,因為后?狀態(tài)的過估計誤差在更新過程中?會進?步傳播到前?的狀態(tài)中。

過估計原理

過估計原理

為了解決過估計問題,研究者提出著名的Double DQN算法及諸多以其為基礎(chǔ)的變種,但是此類?法只能解決離散動作空間的問題。對于連續(xù)控制任務(wù),以Clipped Double Q-learning為基礎(chǔ)的TD3和SAC等算法則?臨著低估問題。DSAC?次從理論層?發(fā)現(xiàn)和論證了分布式回報函數(shù)的學(xué)習(xí)降低Q值過估計的原理,并將分布式回報學(xué)習(xí)嵌?到Maximum Entropy架構(gòu)中。

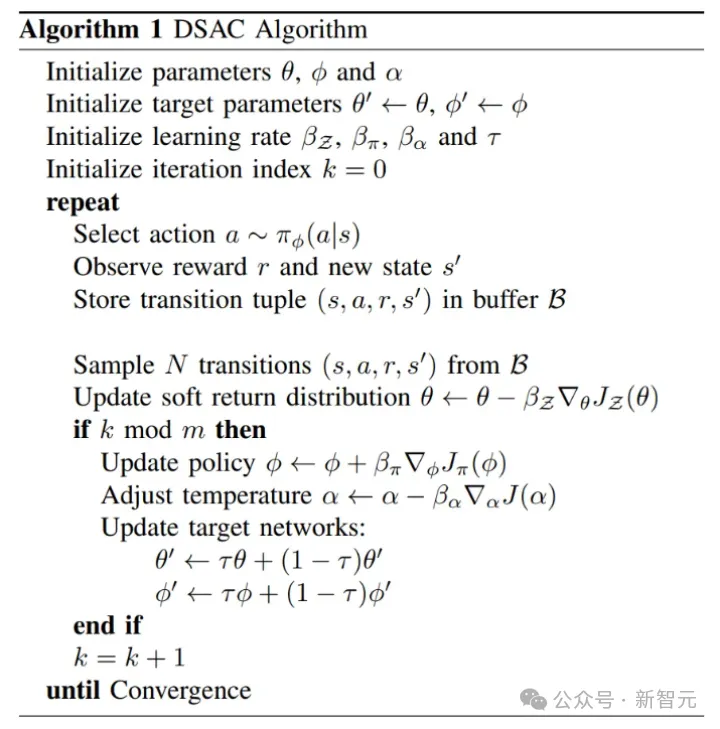

DSAC算法流程

DSAC算法流程

事實上,?類?腦給出的獎勵并不是?個單?的信號,?是基于某種概率分布,這也顯示了分布式回報機制設(shè)計的合理性和巨?潛?。同時,與現(xiàn)有Distributional RL算法(如C51,IQN,D4PG等)不同的是,DSAC可以直接學(xué)習(xí)?個連續(xù)型分布式值函數(shù),這避免了離散分布學(xué)習(xí)帶來的??設(shè)計分割區(qū)間需求。

圖片

圖片

論文鏈接:https://arxiv.org/pdf/2001.02811.pdf

論文代碼:https://github.com/Jingliang-Duan/Distributional-Soft-Actor-Critic

視頻鏈接:https://www.bilibili.com/video/BV1fa4y1h7Mo#reply3178996263

Wikipedia簡介:https://en.wikipedia.org/wiki/Distributional_Soft_Actor_Critic

DSAC算法是一種off-policy算法,可以通過學(xué)習(xí)連續(xù)的高斯值分布來有效提高值估計精度。然而DSAC算法也存在學(xué)習(xí)不穩(wěn)定、參數(shù)敏感等缺點。

針對該問題,團隊在DSAC算法的基礎(chǔ)上進一步提出了DSAC-T: Distributional Soft Actor-Critic with Three Refinements算法。相較于DSAC,DSAC-T算法主要做了三方面改進:Expected value substituting、Twin value distribution learning與Variance-based critic gradient adjusting。

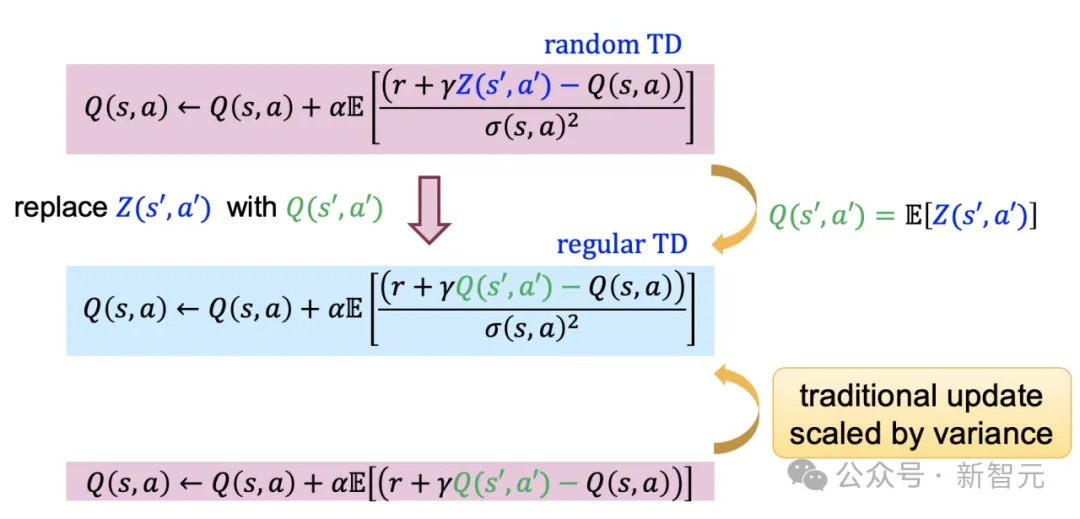

Expected value substituting:傳統(tǒng)RL算法在策略評估階段利用下一時刻的回報均值(即Q值)構(gòu)建TD error,而DSAC算法參與critic更新時利用隨機回報Z構(gòu)建TD error,增加了critic更新梯度隨機性,降低了學(xué)習(xí)穩(wěn)定性。為此,DSAC-T利用隨機回報Z和Q值的期望等價性,將值分布函數(shù)均值(即Q值)更新公式中下一時刻的隨機回報替換為其均值,實現(xiàn)了算法性能提升。

Expected value substituting

Expected value substituting

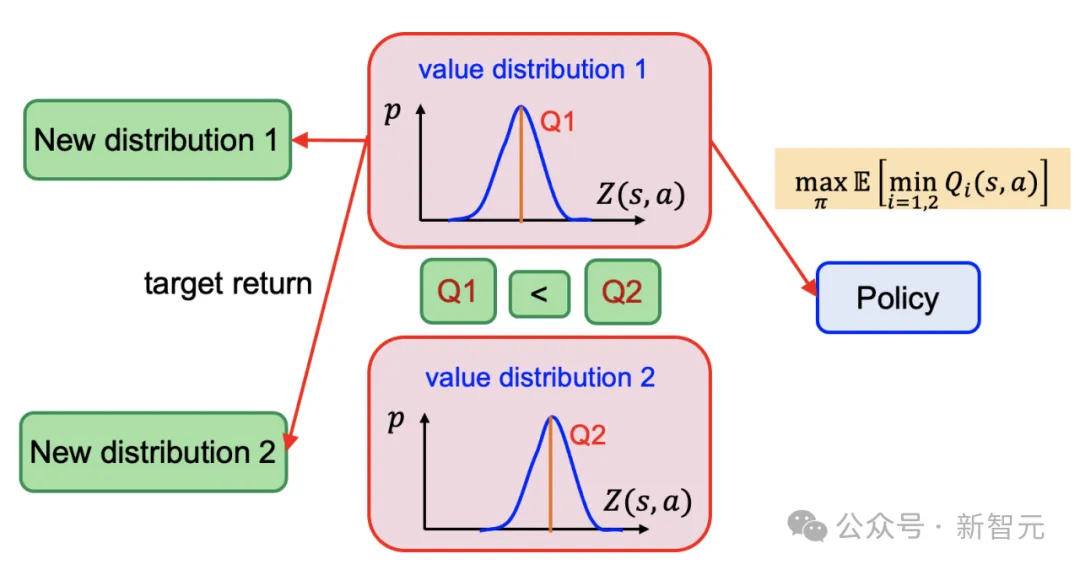

Twin value distribution learning:DSAC算法利用值分布學(xué)習(xí)極大抑制了過估計偏差,在此基礎(chǔ)上,為進一步減輕值函數(shù)過估計偏差,DSAC-T結(jié)合douple-Q learning,在已有的值分布網(wǎng)絡(luò)基礎(chǔ)上額外獨立訓(xùn)練了一個參數(shù)化的值分布網(wǎng)絡(luò)。在進行actor和critic的梯度更新時,選擇均值較小的值分布網(wǎng)絡(luò)構(gòu)建目標(biāo)。

Twin value distribution learning

Twin value distribution learning

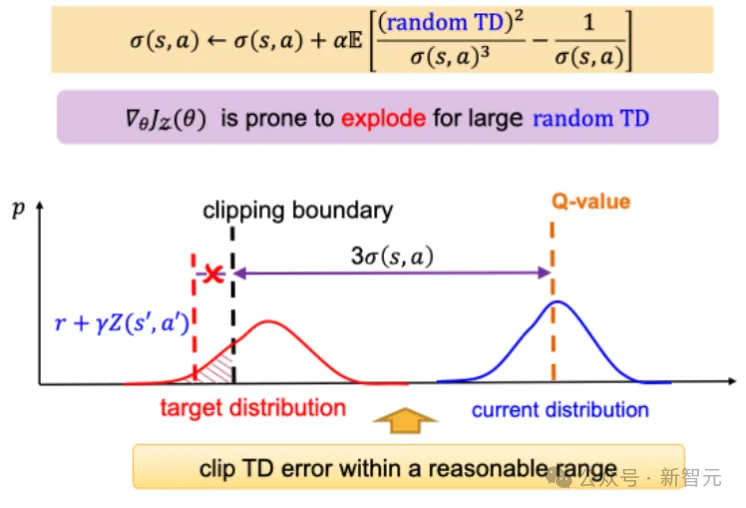

Variance-based critic gradient adjusting:為防止梯度爆炸,DSAC算法對隨機TD error設(shè)置了固定的clipping boundary,該參數(shù)對任務(wù)reward量級極為敏感,嚴重依賴reward scaling的人工調(diào)校。

針對該問題,DSAC-T引入了方差相關(guān)的動態(tài)clipping boundary,實現(xiàn)了TD error邊界的動態(tài)調(diào)節(jié)。此外,值分布函數(shù)更新梯度與值分布方差平方項/立方項成反比,導(dǎo)致了其學(xué)習(xí)過程對方差敏感。為此,DSAC-T引入gradient scaler降低方差變化對梯度的影響,進一步減小了算法對不同任務(wù)的參數(shù)敏感性。

Variance-based critic gradient adjusting

Variance-based critic gradient adjusting

論文鏈接:https://arxiv.org/abs/2310.05858

論文代碼:https://github.com/Jingliang-Duan/DSAC-v2

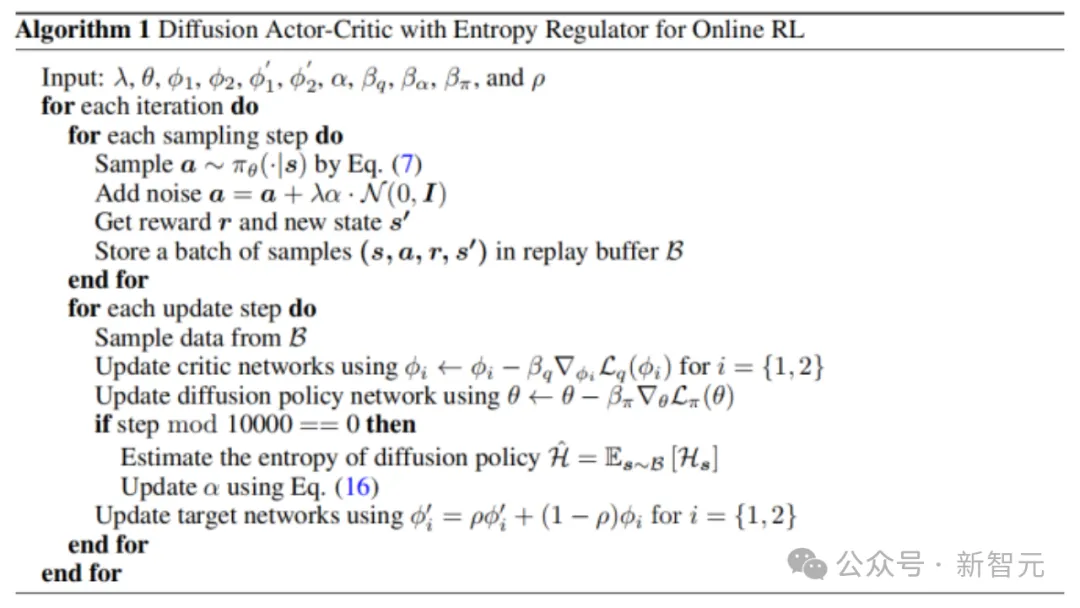

DACER算法解讀

在線強化學(xué)習(xí)(Online Reinforcement Learning, Online RL)作為人工智能領(lǐng)域解決復(fù)雜序列決策問題的核心方法之一,其應(yīng)用范圍持續(xù)擴展。擴散模型作為一種生成模型因其強大的擬合多模態(tài)分布能力而廣為人知。它通過逐步添加和移除噪聲來學(xué)習(xí)原始數(shù)據(jù)分布,在圖像和視頻生成領(lǐng)域表現(xiàn)出色。

然而,擴散模型直接用于Online RL可能遇到的問題包括:1. 擴散模型的損失函數(shù)項本質(zhì)上是一種模仿學(xué)習(xí)損失項,但與Offline RL不同,Online RL中并不存在可供模仿的數(shù)據(jù);2. 擴散模型的反向過程無法進行解析求熵,這使得其難以與最大熵強化學(xué)習(xí)框架相結(jié)合,從而導(dǎo)致算法收斂性能不佳。

為了解決上述的問題,DACER(Diffusion Actor-Critic with Entropy Regulator)建立在去噪擴散概率模型(DDPM)的基礎(chǔ)上。擴散模型的表示能力主要來源于反向擴散過程而非正向,因此將擴散模型的反向過程重新概念化為一種新的策略近似函數(shù),利用其強大的表示能力來提升RL算法的性能。這個新策略函數(shù)的優(yōu)化目標(biāo)是最大化期望Q值。

在RL中,最大化熵對于策略探索至關(guān)重要,但擴散策略的熵難以解析確定。因此,算法選擇在固定間隔處采樣動作,并使用高斯混合模型(GMM)來擬合動作分布,可計算每個狀態(tài)下策略的近似熵。這些熵的平均值之后被用作當(dāng)前擴散策略熵的近似。最后,算法使用估計的熵來平衡擴散策略在訓(xùn)練過程中的探索與利用。

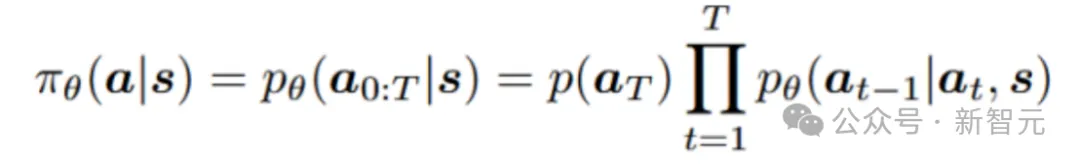

1. 擴散策略表征

將條件擴散模型的反向過程用作參數(shù)化策略

圖片

圖片

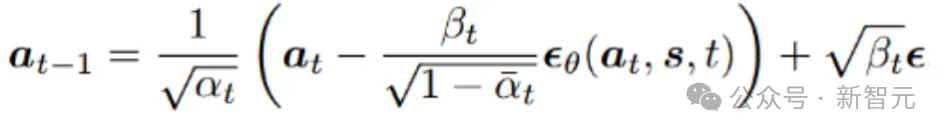

采樣過程可以重新表述為:

圖片

圖片

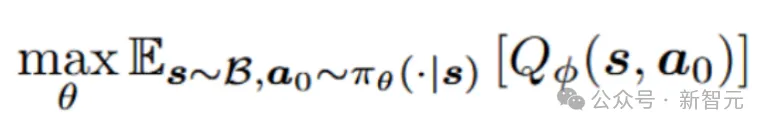

2. 擴散策略學(xué)習(xí)

在Online RL中,由于沒有可供模仿的數(shù)據(jù)集,算法放棄了行為克隆項和模仿學(xué)習(xí)框架。策略學(xué)習(xí)的目標(biāo)是最大化由擴散網(wǎng)絡(luò)在給定狀態(tài)下生成的動作的期望Q值:

圖片

圖片

此外,算法使用先前提出的分布式Q學(xué)習(xí)的方法來緩解值函數(shù)的過估計問題。然而,直接使用上述擴散策略學(xué)習(xí)方法進行訓(xùn)練時,會因策略動作過于確定性而導(dǎo)致性能不佳。

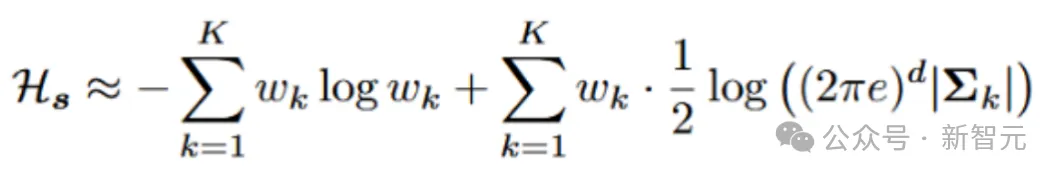

3. 擴散策略與熵調(diào)節(jié)器

對于每個狀態(tài),我們使用擴散策略來采樣N個動作,然后使用高斯混合模型(GMM)來擬合策略分布。可以通過以下方式估計對應(yīng)于該狀態(tài)的動作分布的熵:

圖片

圖片

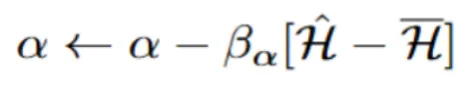

類似于最大化熵的RL,根據(jù)估計的熵學(xué)習(xí)一個參數(shù)α:

圖片

圖片

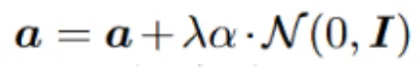

最終,使用下式在訓(xùn)練的采樣階段調(diào)整擴散策略的熵。熵調(diào)節(jié)機制是解鎖探索潛能的關(guān)鍵。

圖片

圖片

DACER算法整體流程如下:

DACER算法流程

DACER算法流程

圖片

圖片

論文鏈接:https://arxiv.org/pdf/2405.15177

論文代碼:https://github.com/happy-yan/DACER-Diffusion-with-Online-RL

RAD優(yōu)化器解讀

價值函數(shù)和策略函數(shù)是RL算法的關(guān)鍵部件,二者交替迭代更新是RL訓(xùn)練的核心步驟。當(dāng)前主要以深度神經(jīng)網(wǎng)絡(luò)作為價值函數(shù)和策略函數(shù)的載體,其訓(xùn)練過程通常依賴于神經(jīng)網(wǎng)絡(luò)優(yōu)化器以實現(xiàn)參數(shù)更新。

然而,目前主流的神經(jīng)網(wǎng)絡(luò)優(yōu)化器(如SGD-M、Adam和AdamW等)雖然在緩解局部最優(yōu)和加速收斂方面有所幫助,但其算法設(shè)計和參數(shù)選擇均依賴于人工經(jīng)驗和實用技巧,缺乏對優(yōu)化動態(tài)特性的解釋與分析,難以從理論上保障RL訓(xùn)練的穩(wěn)定性。

研究者從動力學(xué)視角出發(fā),將神經(jīng)網(wǎng)絡(luò)參數(shù)的優(yōu)化過程建模為多粒子相對論系統(tǒng)狀態(tài)的演化過程,通過引入狹義相對論的光速最大原理,抑制了網(wǎng)絡(luò)參數(shù)的異常更新速率,同時提供了各網(wǎng)絡(luò)參數(shù)的獨立自適應(yīng)調(diào)節(jié)能力,從理論上引入了對RL訓(xùn)練穩(wěn)定性和收斂性等動態(tài)特性的保障機制。

圖片

圖片

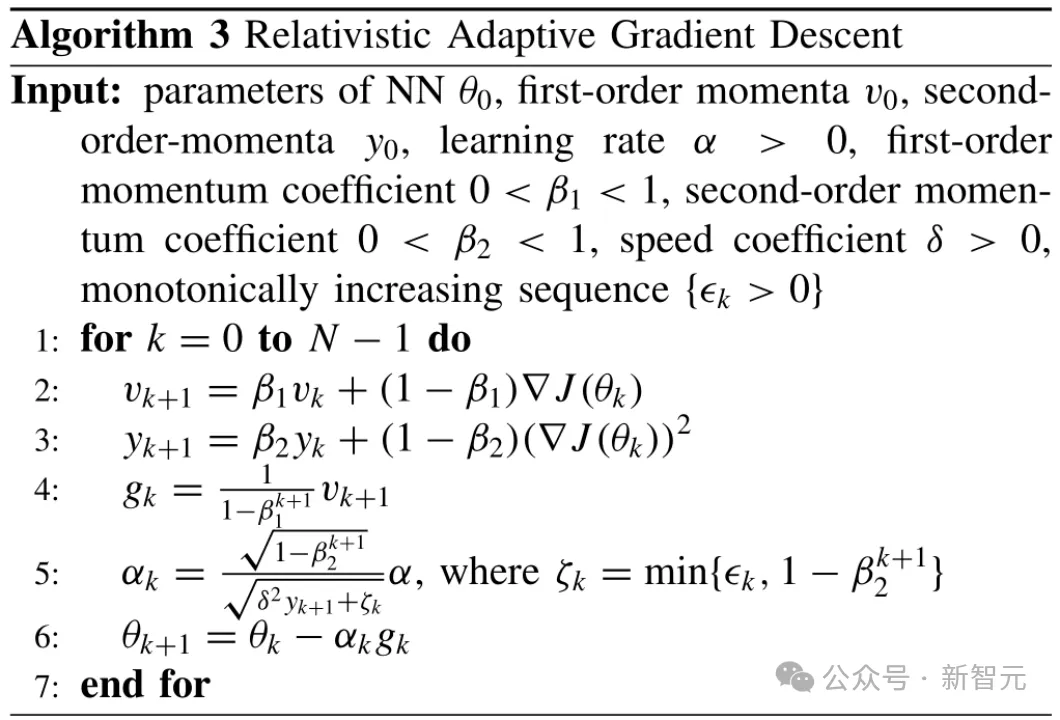

進而,研究者提出了既具備穩(wěn)定動力學(xué)特性又適用于深度神經(jīng)網(wǎng)絡(luò)非凸隨機優(yōu)化的RAD優(yōu)化器。特別的,當(dāng)速度系數(shù)δ設(shè)為1且保辛因子ζk固定為小常數(shù)ε時,RAD優(yōu)化器將退化為深度學(xué)習(xí)中廣泛采用的Adam優(yōu)化器。這一發(fā)現(xiàn)也為從動力學(xué)視角探究其他主流自適應(yīng)梯度優(yōu)化方法(如AdaGrad、NAdam、AdamW和Lion等)開辟了全新路徑。

RAD算法流程

RAD算法流程

圖片

圖片

論文地址:https://ieeexplore.ieee.org/document/10792938

代碼倉庫:https://github.com/TobiasLv/RAD